基于GAN生成流暢視頻,效果很能打:無紋理粘連、抖動緩解

近年來,基于生成對抗式網(wǎng)絡(luò)(Generative Adversarial Network, GAN)的圖片生成研究工作取得了顯著的進(jìn)展。除了能夠生成高分辨率、逼真的圖片之外,許多創(chuàng)新應(yīng)用也應(yīng)運(yùn)而生,諸如圖片個(gè)性化編輯、圖片動畫化等。然而,如何利用 GAN 進(jìn)行視頻生成仍然是一個(gè)頗有挑戰(zhàn)的問題。

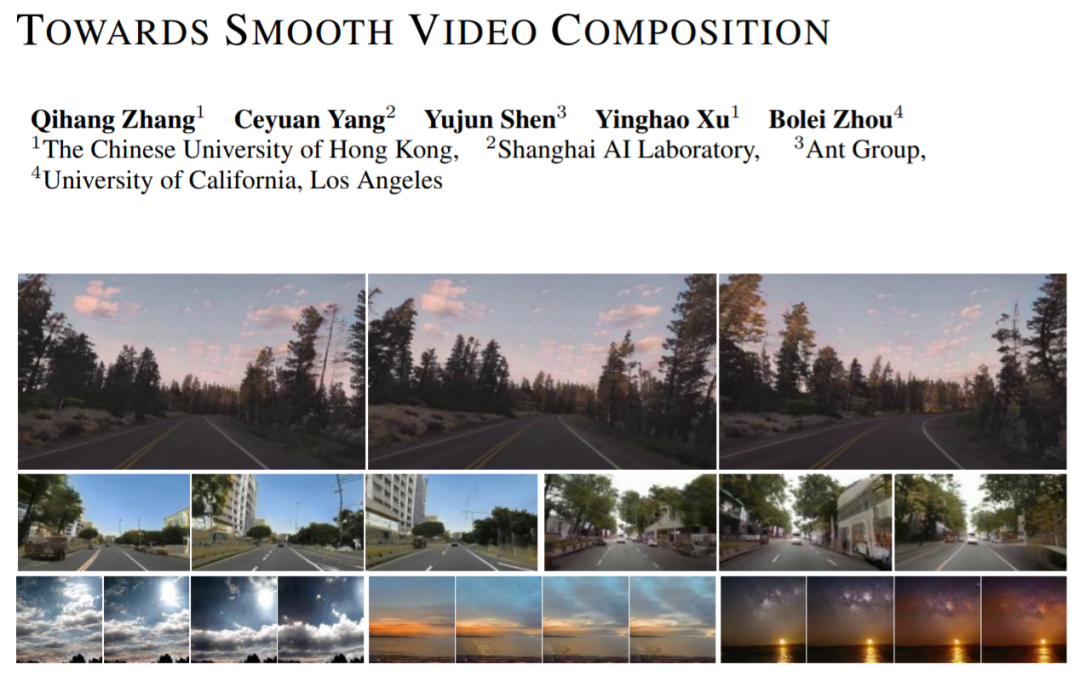

除了對單幀圖片的建模之外,視頻生成還需要學(xué)習(xí)復(fù)雜的時(shí)序關(guān)系。近來,來自香港中文大學(xué)、上海人工智能實(shí)驗(yàn)室、螞蟻技術(shù)研究院以及加州大學(xué)洛杉磯分校的研究者提出了一個(gè)新的視頻生成方法(Towards Smooth Video Composition)。文中,他們針對不同跨度(短時(shí)范圍、適中范圍、長范圍)的時(shí)序關(guān)系,分別進(jìn)行了細(xì)致的建模與改進(jìn),并在多個(gè)數(shù)據(jù)集上取得了相較于之前工作大幅度的提升。該工作為基于 GAN 的視頻生成方向提供了一個(gè)簡單且有效的新基準(zhǔn)。

- 論文地址:https://arxiv.org/pdf/2212.07413.pdf

- 項(xiàng)目代碼鏈接:https://github.com/genforce/StyleSV

模型架構(gòu)

基于 GAN 的圖像生成網(wǎng)絡(luò)可以表示為:I=G(Z),其中 Z 是隨機(jī)變量,G 是生成網(wǎng)絡(luò),I 是生成圖片。我們可以簡單地將此框架拓展到視頻生成范疇:I_i=G(z_i),i=[1,...,N],其中我們一次性采樣 N 個(gè)隨機(jī)變量 z_i,每一個(gè)隨機(jī)變量 z_i 對應(yīng)生成一幀圖片 I_i。將生成的圖片在時(shí)間維度堆疊起來就可以得到生成的視頻。

MoCoGAN, StyleGAN-V 等工作在此基礎(chǔ)上提出了一種解耦的表達(dá):I_i=G(u, v_i),i=[1,...,N],其中 u 表示控制內(nèi)容的隨機(jī)變量,v_i 表示控制動作的隨機(jī)變量。這種表達(dá)認(rèn)為,所有幀共享相同的內(nèi)容,并具有獨(dú)特的動作。通過這種解耦的表達(dá),我們可以更好地生成內(nèi)容風(fēng)格一致,同時(shí)具有多變真實(shí)的動作視頻。新工作采納了 StyleGAN-V 的設(shè)計(jì),并將其作為基準(zhǔn)。

視頻生成的難點(diǎn):如何有效并合理地建模時(shí)序關(guān)系?

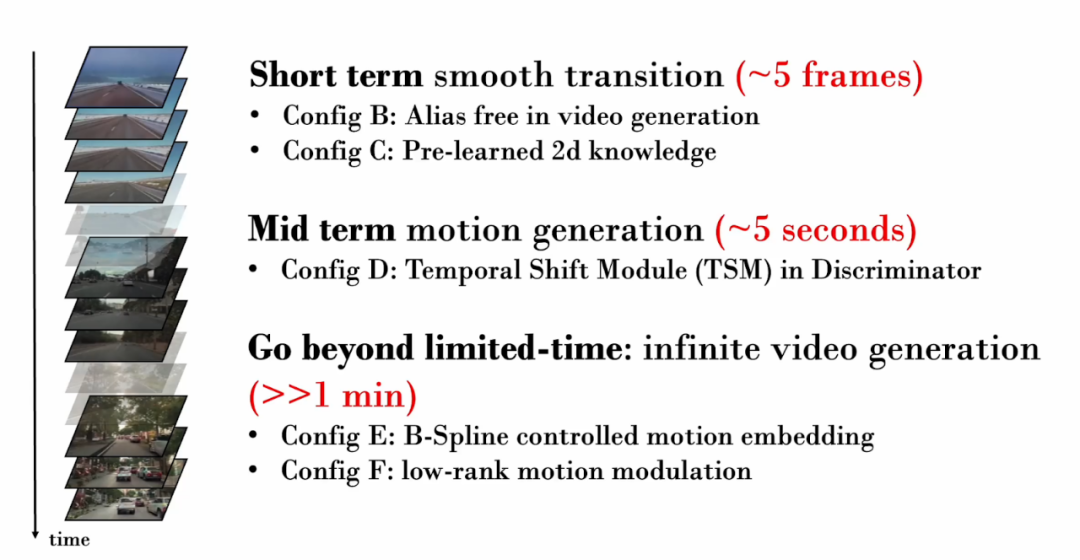

新工作著眼于不同跨度(短時(shí)范圍、適中范圍、長范圍)的時(shí)序關(guān)系,分別進(jìn)行了細(xì)致的建模與改進(jìn):

1. 短時(shí)間(~5 幀)時(shí)序關(guān)系

讓我們首先考慮僅有幾幀的視頻。這些短時(shí)間的視頻幀通常包含了非常相似的內(nèi)容,僅僅展示了非常細(xì)微的動作。因此,真實(shí)地生成幀間的細(xì)微動作至關(guān)重要。然而,StyleGAN-V 生成的視頻中出現(xiàn)了嚴(yán)重的紋理粘連(texture sticking)現(xiàn)象。

?

?

紋理粘連指的是生成的部分內(nèi)容對特定坐標(biāo)產(chǎn)生了依賴,造成了 “黏” 在固定區(qū)域上的現(xiàn)象。在圖像生成領(lǐng)域中,StyleGAN3 通過細(xì)致的信號處理、擴(kuò)大 padding 范圍等操作緩解了紋理粘連問題。本工作驗(yàn)證了同樣的技術(shù)對視頻生成仍然有效。

在下圖的可視化中,我們追蹤視頻每一幀中相同位置的像素。容易發(fā)現(xiàn),在 StyleGAN-V 的視頻中,有些內(nèi)容長期 “黏” 在固定坐標(biāo),并沒有隨著時(shí)間移動,因此在可視化中產(chǎn)生了“筆刷現(xiàn)象”。而在新工作生成的視頻中,所有像素都展示了自然的移動。

然而,研究員發(fā)現(xiàn),引用 StyleGAN3 的 backbone 會讓圖像生成質(zhì)量有所下降。為了緩解這個(gè)問題,他們引入了圖像層面的預(yù)訓(xùn)練。在預(yù)訓(xùn)練階段, 網(wǎng)絡(luò)僅需考慮視頻中某一幀的生成質(zhì)量,無需學(xué)習(xí)時(shí)序范圍的建模,從而更易學(xué)習(xí)有關(guān)圖像分布知識。

2. 中等長度(~5 秒)時(shí)序關(guān)系?

隨著生成的視頻擁有更多的幀數(shù),它將能夠展現(xiàn)更具體的動作。因此,確保生成的視頻中擁有真實(shí)的動作非常重要。例如,如果我們想要生成第一人稱開車的視頻,就應(yīng)該生成逐漸后退的地面、街景,臨車也應(yīng)當(dāng)遵循自然的駕駛軌跡。

在對抗訓(xùn)練中,為了確保生成網(wǎng)絡(luò)獲得足夠的訓(xùn)練監(jiān)督,判別網(wǎng)絡(luò)至關(guān)重要。因此在視頻生成中,為了確保生成網(wǎng)絡(luò)能夠生成真實(shí)的動作,判別網(wǎng)絡(luò)需要對多幀中的時(shí)序關(guān)系進(jìn)行建模,并捕獲生成的不真實(shí)的運(yùn)動。然而,在之前的工作中,判別網(wǎng)絡(luò)僅僅使用了簡單的拼接操作(concatenation operation)來進(jìn)行時(shí)序建模:y = cat (y_i),其中 y_i 表示單幀特征,y 表示時(shí)域融合后的特征。

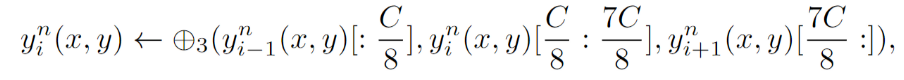

針對判別網(wǎng)絡(luò),新工作提出了一種顯式的時(shí)序建模,即在判別網(wǎng)絡(luò)的每一層,引入時(shí)序移位模塊(Temporal Shift Module,TSM)。TSM 來自動作識別領(lǐng)域,通過簡單的移位操作實(shí)現(xiàn)時(shí)序上的信息交換:

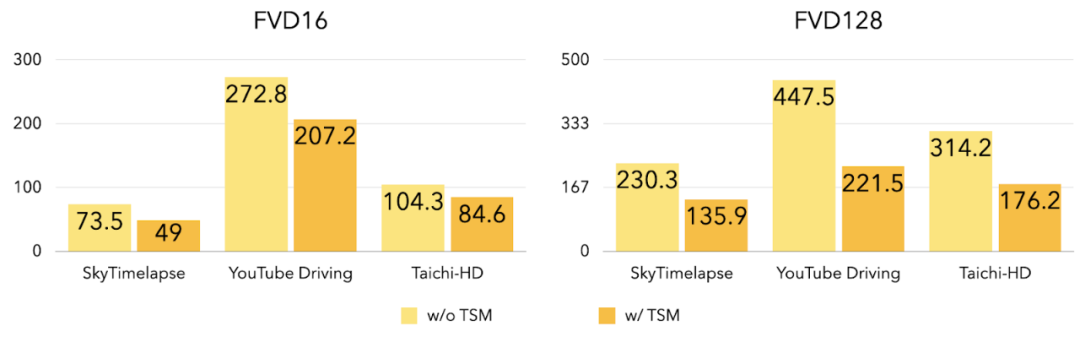

實(shí)驗(yàn)表明,在引入 TSM 之后,三個(gè)數(shù)據(jù)集上的 FVD16,F(xiàn)VD128 得到了很大程度的降低。

?

?

3. 無限長視頻生成?

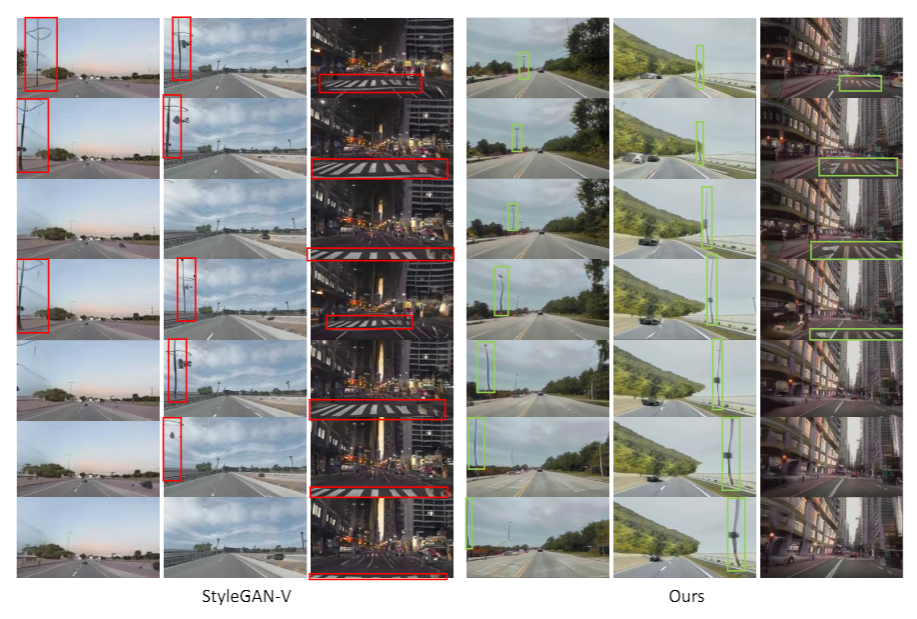

先前介紹的改進(jìn)主要圍繞短時(shí)和適中時(shí)間長度的視頻生成,新工作進(jìn)一步探索了如何生成高質(zhì)量的任意長度(包括無限長)的視頻。之前工作(StyleGAN-V)能夠生成無限長的視頻,然而視頻中卻包含著非常明顯的周期性抖動現(xiàn)象:

如圖所示,在 StyleGAN-V 生成的視頻中,隨著自車前進(jìn),斑馬線原本正常的后退,隨后卻突然改為向前運(yùn)動。本工作發(fā)現(xiàn),動作特征(motion embedding)的不連續(xù)性導(dǎo)致了此抖動現(xiàn)象。

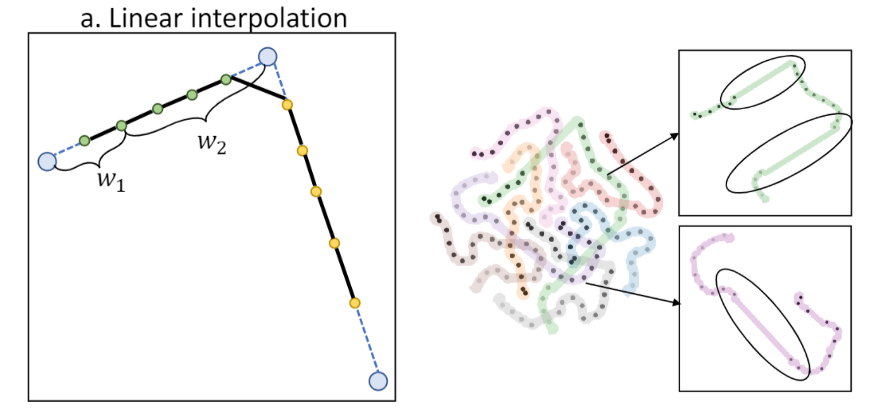

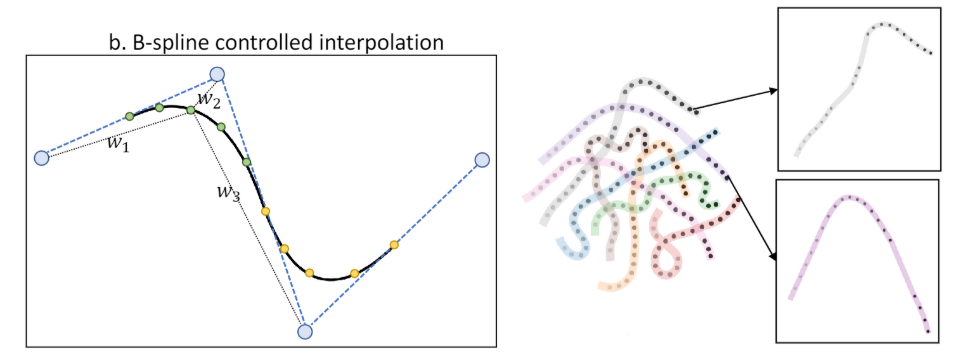

先前工作采用線性插值來計(jì)算動作特征,然而線性插值會導(dǎo)致一階不連續(xù)性,如下圖所示(左邊為插值示意圖,右圖為 T-SNE 特征可視化):

本工作提出了 B 樣條控制的動作特征(B-Spline based motion embedding)。通過 B 樣條進(jìn)行插值,能夠獲得關(guān)于時(shí)間更加平滑的動作特征,如圖所示(左邊為插值示意圖,右圖為 T-SNE 特征可視化):

通過引入 B 樣條控制的動作特征,新工作緩解了抖動現(xiàn)象:

如圖所示,StyleGAN-V 生成的視頻中,路燈、地面會突然改變運(yùn)動方向。而在新工作生成的視頻中,運(yùn)動的方向是一致、自然的。

同時(shí),新工作針對動作特征還提出了一個(gè)低秩(low rank)的約束,來進(jìn)一步緩解周期性重復(fù)內(nèi)容的出現(xiàn)。

實(shí)驗(yàn)

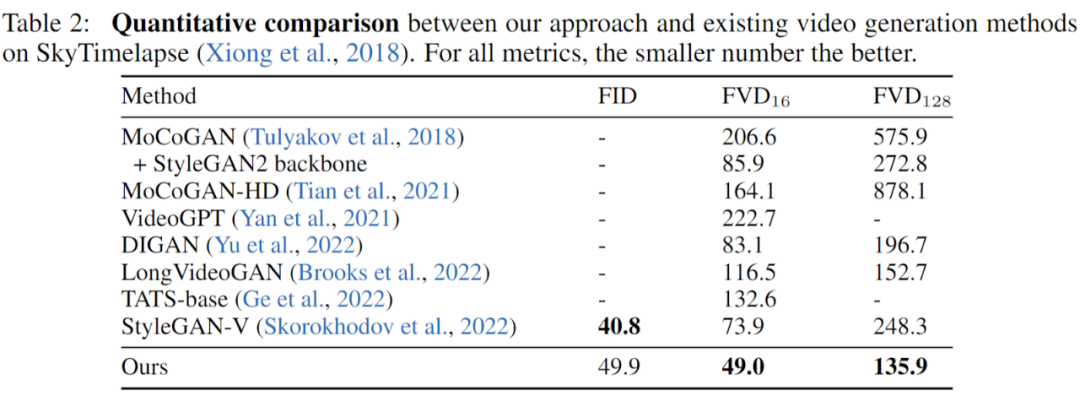

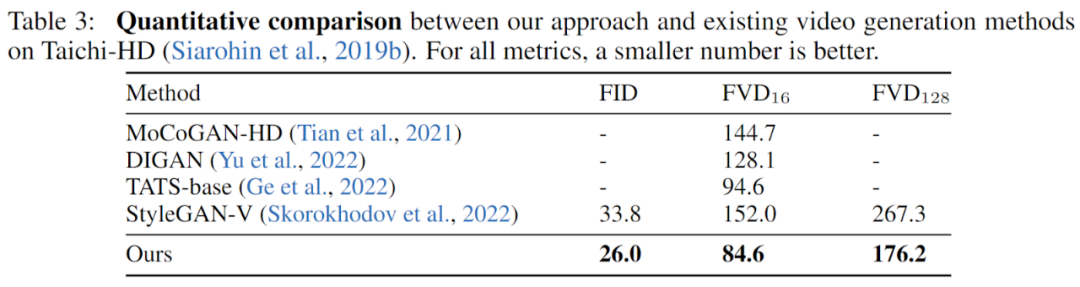

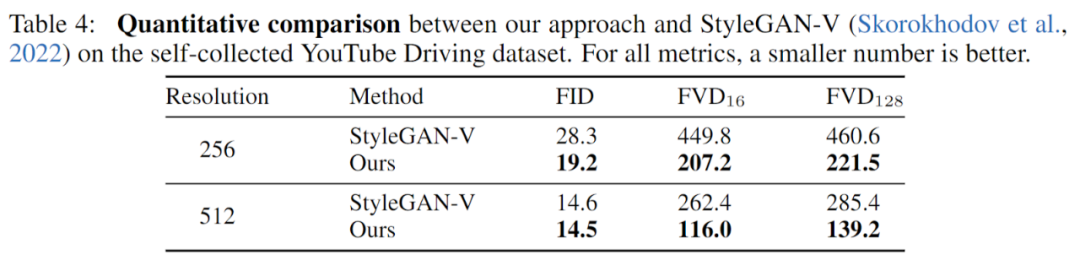

工作在三個(gè)數(shù)據(jù)集(YouTube Driving, Timelapse, Taichi-HD)上進(jìn)行了充分的實(shí)驗(yàn),并充分對比了先前的工作,結(jié)果顯示,新工作在圖片質(zhì)量(FID)以及視頻質(zhì)量(FVD)上,都取得了充分的提升。

SkyTimelapse 實(shí)驗(yàn)結(jié)果:?

?

?

Taichi-HD 實(shí)驗(yàn)結(jié)果:?

YouTube Driving 實(shí)驗(yàn)結(jié)果:?

?

?

總結(jié)

新工作基于 GAN 模型,提出了一個(gè)全新的視頻生成基準(zhǔn),從不同尺度的時(shí)序關(guān)系出發(fā),提出了新穎、有效地改進(jìn)。在多個(gè)數(shù)據(jù)集上的實(shí)驗(yàn)顯示,新工作成功取得了大幅度超越先前工作的視頻質(zhì)量。