具有生物啟發訓練方法的物理深度學習:物理硬件的無梯度方法

對人工智能不斷增長的需求推動了對基于物理設備的非常規計算的研究。雖然此類計算設備模仿了大腦啟發的模擬信息處理,但學習過程仍然依賴于為數字處理優化的方法,例如反向傳播,這不適合物理實現。

在這里,來自日本 NTT 設備技術實驗室(NTT Device Technology Labs)和東京大學的研究團隊通過擴展一種稱為直接反饋對齊(DFA)的受生物學啟發的訓練算法來展示物理深度學習。與原始算法不同,所提出的方法基于具有替代非線性激活的隨機投影。因此,可以在不了解物理系統及其梯度的情況下訓練物理神經網絡。此外,可以在可擴展的物理硬件上模擬此訓練的計算。

研究人員使用稱為深儲層計算機的光電遞歸神經網絡演示了概念驗證。證實了在基準測試中具有競爭性能的加速計算的潛力。研究結果為神經形態計算的訓練和加速提供了實用的解決方案。

該研究以「Physical deep learning with biologically inspired training method: gradient-free approach for physical hardware」為題,于 2022 年 12 月 26 日發布在《Nature Communications》上。

物理深度學習

基于人工神經網絡 (ANN) 的機器學習在圖像處理、語音識別、游戲等方面的破紀錄表現成功展示了其卓越的能力。盡管這些算法類似于人腦的工作方式,但它們基本上是使用傳統的馮諾依曼計算硬件在軟件層面上實現的。然而,這種基于數字計算的人工神經網絡面臨著能耗和處理速度方面的問題。這些問題促使使用替代物理平臺實現人工神經網絡。

有趣的是,即使是被動物理動力學也可以用作隨機連接的 ANN 中的計算資源。該框架被稱為物理儲層計算機(RC)或極限學習機(ELM),其易于實現極大地擴展了可實現材料的選擇及其應用范圍。這種物理實現的神經網絡 (PNN) 能夠將特定任務的計算負載外包給物理系統。

構建更深層次的物理網絡是進一步提高性能的一個有前途的方向,因為它們可以以指數方式擴展網絡表達能力。這激發了使用各種物理平臺的深度 PNN 的提議。他們的訓練基本上依賴于一種稱為反向傳播(BP)的方法,該方法在基于軟件的 ANN 中取得了巨大成功。但是,BP 在以下方面不適用于 PNN。首先,BP 操作的物理實現仍然復雜且不可擴展。其次,BP 需要對整個物理系統有準確的了解。此外,當我們將 BP 應用于 RC 時,這些要求破壞了物理 RC 的獨特特性,即我們需要準確地了解和模擬黑盒物理隨機網絡。

與 PNN 中的 BP 一樣,BP 在生物神經網絡中的操作難度也被腦科學界指出;BP 在大腦中的合理性一直受到質疑。這些考慮促使開發了生物學上合理的訓練算法。

近期一個有前途的方向是直接反饋對齊 (DFA)。在該算法中,采用最終輸出層誤差信號的固定隨機線性變換來代替反向誤差信號。因此,這種方法不需要誤差信號的逐層傳播或權重的知識。此外,據報道,DFA 可擴展到現代大型網絡模型。這種以生物學為動機的訓練的成功表明,有一種比 BP 更合適的方法來訓練 PNN。然而,DFA 仍然需要非線性函數 f(x) 的導數 f'(a) 進行訓練,這阻礙了 DFA 方法在物理系統中的應用。因此,DFA 的更大幅度擴展對于 PNN 應用很重要。

DFA 及其對物理深度學習的增強

在此,研究人員通過增強 DFA 算法來演示物理深度學習。在增強 DFA 中,用任意非線性 g(a) 替換標準 DFA 中物理非線性激活 f'(a) 的微分,并表明性能對 g(a) 的選擇具有穩健性。由于這種增強,不再需要準確地模擬 f'(a)。由于所提出的方法基于具有任意非線性激活的并行隨機投影,可以按照與物理 ELM 或 RC 概念相同的方式在物理系統上執行訓練計算。這使得推理和訓練的物理加速成為可能。

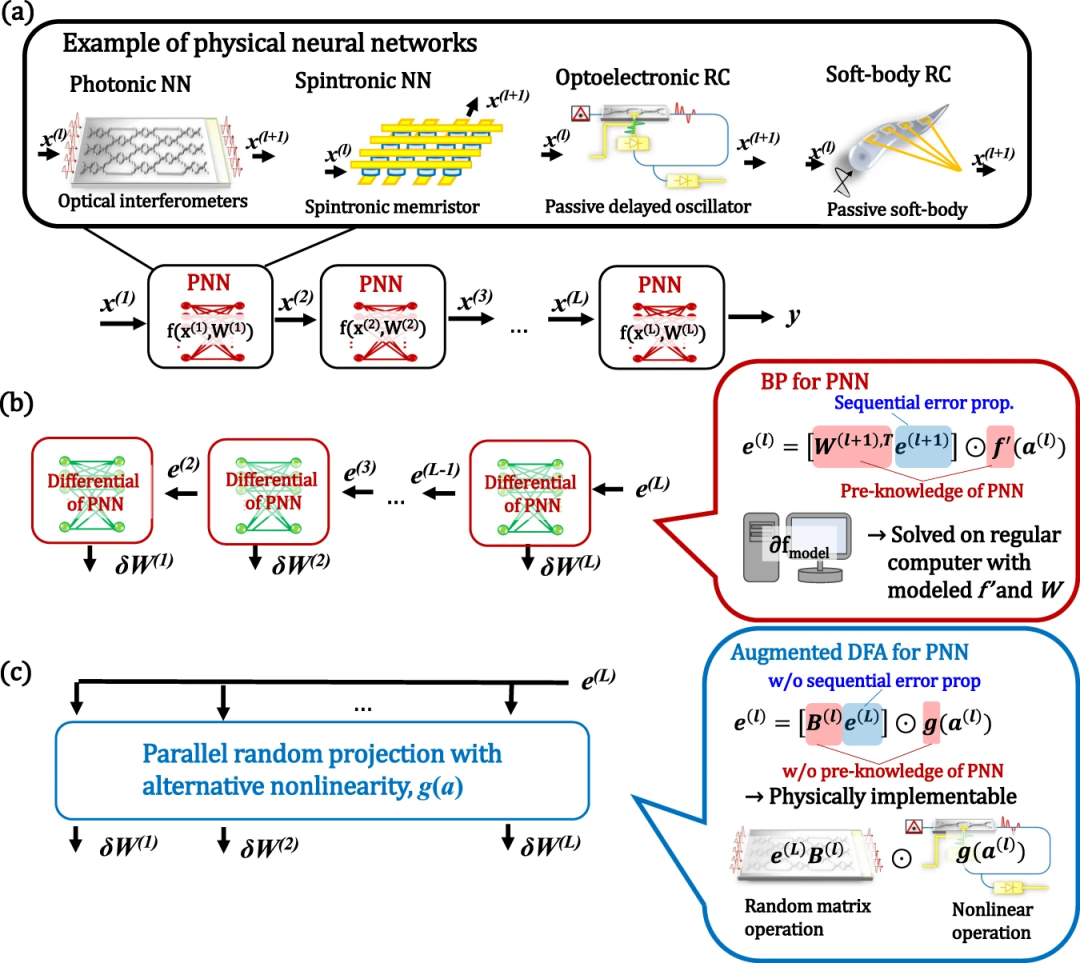

圖:PNN 的概念及其通過 BP 和增強 DFA 進行的訓練。(來源:論文)

為了演示概念驗證,研究人員構建了一個 FPGA 輔助的光電深度物理 RC 作為工作臺。盡管 benchtop 簡單易用,僅需軟件級更新即可應用于各種物理平臺,但實現了可與大型復雜的最先進系統相媲美的性能。

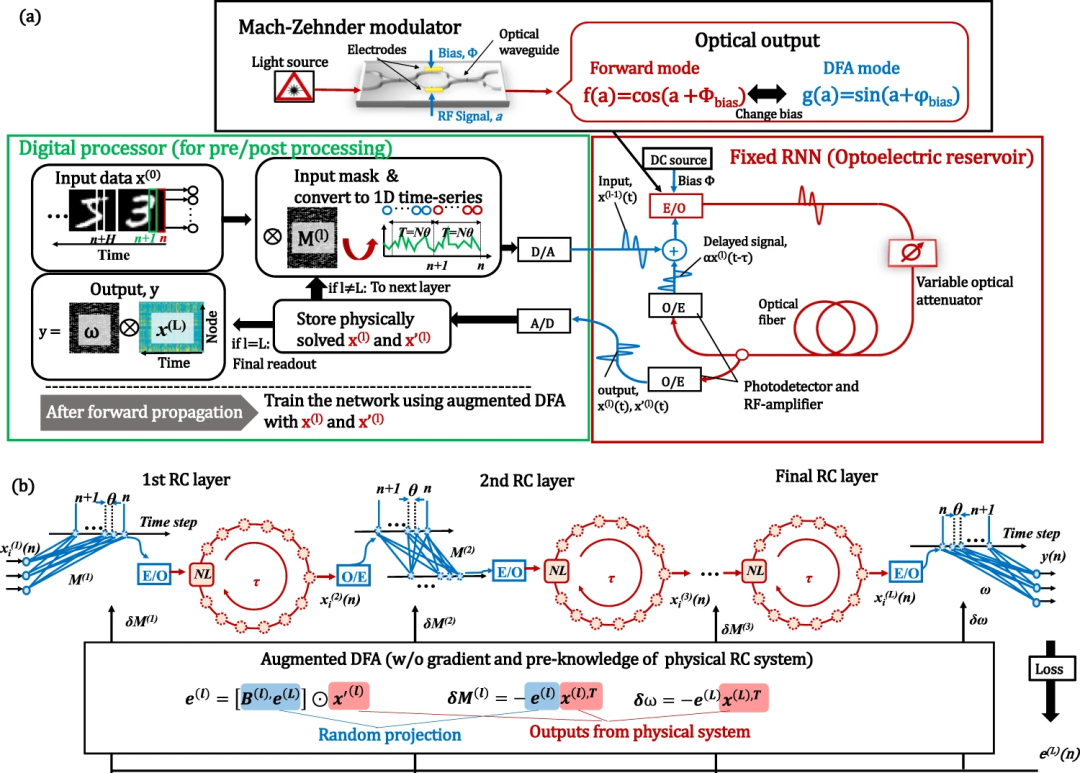

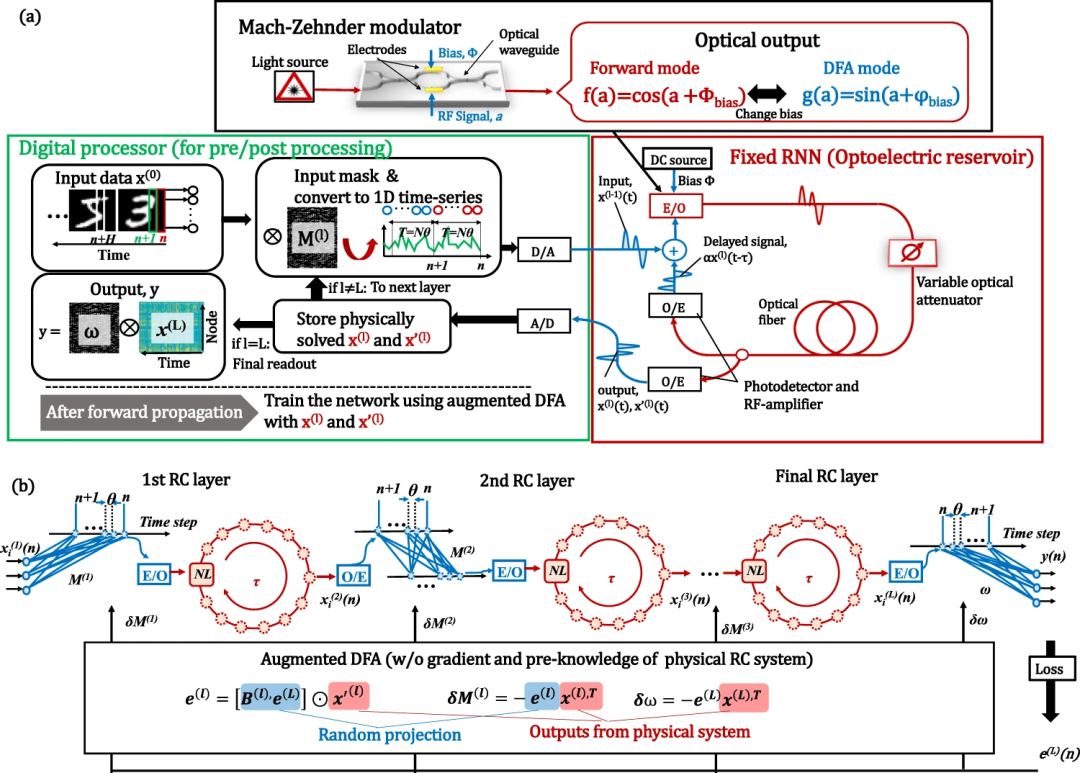

圖:具有增強 DFA 訓練的光電深度 RC 系統。(來源:論文)

此外,還比較了整個處理時間,包括數字處理的時間,發現了訓練過程物理加速的可能性。

圖:光電深 RC 系統的性能。(來源:論文)

RC 工作臺的處理時間預算細分如下:FPGA 處理(數據傳輸、內存分配和 DAC/ADC)約為 92%;約 8% 的數字處理用于預處理/后處理。因此,在當前階段,處理時間主要由 FPGA 和 CPU 上的數字計算決定。這是因為光電工作臺僅使用一條非線性延遲線實現了一個儲層;這些限制可以通過在未來使用完全并行和全光計算硬件來放寬。可以看出,CPU 和 GPU 上的計算針對節點數顯示了 O(N^2) 趨勢,而 benchtop 顯示了 O(N),這是由于數據傳輸瓶頸造成的。

對于 BP 和增強 DFA 算法,CPU 之外的物理加速度分別在 N ~5,000 和 ~12,000 處被觀察到。然而,就計算速度而言,由于 GPU 的內存限制,尚未直接觀察到針對 GPU 的有效性。通過推斷 GPU 趨勢,可以在 N ~80,000 時觀察到超過 GPU 的物理加速。據我們所知,這是對整個訓練過程的首次比較,也是首次使用 PNN 進行體能訓練加速演示。

為了研究所提方法對其他系統的適用性,使用廣泛研究的光子神經網絡進行了數值模擬。此外,實驗證明的基于延遲的 RC 被證明非常適合各種物理系統。關于物理系統的可擴展性,構建深度網絡的主要問題是其固有噪聲。通過數值模擬研究了噪聲的影響。發現該系統對噪聲具有穩健性。

所提出方法的可擴展性和局限性

在這里,考慮了基于 DFA 的方法對更現代模型的可擴展性。實際深度學習最常用的模型之一是深度連接的卷積神經網絡 (CNN)。然而,據報道,DFA 算法很難應用于標準 CNN。因此,所提出的方法可能難以以簡單的方式應用于卷積 PNN。

考慮到模擬硬件實現,對 SNN 的適用性也是一個重要主題。已經報道了基于 DFA 的訓練對 SNN 的適用性,這意味著該研究所提出的增強 DFA 可以使訓練更容易。

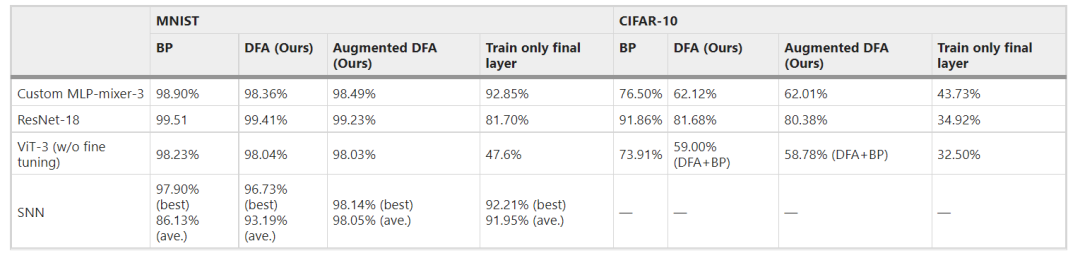

雖然基于 DFA 的算法有可能擴展到比簡單的 MLP 或 RC 更實用的模型,但將基于 DFA 的訓練應用于此類網絡的有效性仍然未知。在這里,作為這項研究的額外工作,研究了基于 DFA 的訓練(DFA 本身和增強的 DFA)對上述模型(MLP-Mixer、Vision transformer (ViT)、ResNet 和 SNN)的可擴展性。研究發現基于 DFA 的訓練即使對于探索的實用模型也是有效的。雖然基于 DFA 的訓練可達到的準確度基本上低于 BP 訓練,但對模型和/或算法進行一些調整可以提高性能。值得注意的是,對于所有探索的實驗設置,DFA 和增強 DFA 的準確性都具有可比性,這表明 DFA 本身的進一步改進將直接有助于改進增強 DFA。結果表明,該方法可擴展到未來對 PNN 的實用模型的實現,而不僅僅是簡單的 MLP 或 RC 模型。

表 1:增強 DFA 對實際網絡模型的適用性。(來源:論文)

物理硬件中的 BP 與 DFA

一般來說,BP 在物理硬件上實現起來非常困難,因為它需要計算圖中的所有信息。因此,物理硬件的訓練一直是通過計算模擬來完成的,這會產生大量的計算成本。此外,模型與實際系統之間的差異導致精度下降。相反,增強的 DFA 不需要關于物理系統的準確先驗知識。因此,在深度 PNN 中,基于 DFA 的方法在準確性方面比基于 BP 的方法更有效。此外,可以使用物理硬件加速計算。

此外,DFA 訓練不需要逐層計算的順序誤差傳播,這意味著每一層的訓練可以并行執行。因此,更優化和并行的 DFA 實現可能會帶來更顯著的加速。這些獨特的特征表明基于 DFA 的方法的有效性,特別是對于基于物理硬件的神經網絡。另一方面,增強 DFA 訓練的模型的準確性仍然不如 BP 訓練的模型。進一步提高基于 DFA 的訓練的準確性仍然是未來的工作。

進一步的物理加速

物理實現證實了具有大節點(large-node)數的 RC 循環處理的加速。但是,它的優勢仍然有限,需要進一步改進。當前原型的處理時間表示為 FPGA 的數據傳輸和內存分配。因此,將所有過程集成到 FPGA 中將大大提高性能,但會犧牲實驗靈活性。此外,將來,機載光學方法將大大降低傳輸成本。大規模光集成和片上集成將進一步提升光計算本身的性能。