利用多光照信息的單視角NeRF算法S^3-NeRF,可恢復(fù)場(chǎng)景幾何與材質(zhì)信息

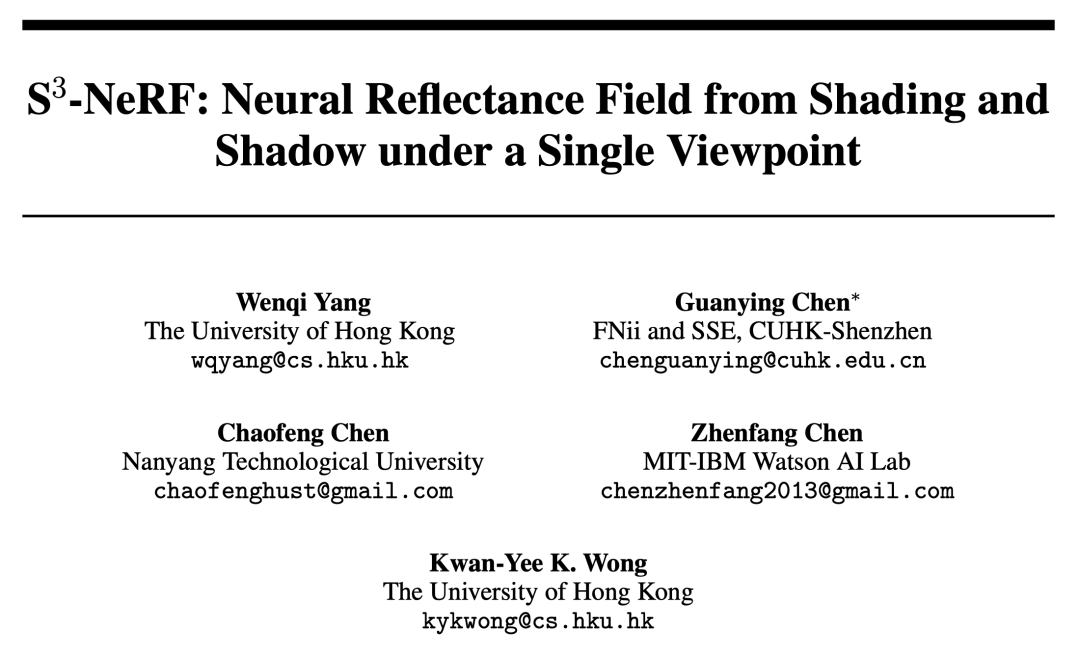

目前圖像 3D 重建工作通常采用恒定自然光照條件下從多個(gè)視點(diǎn)(multi-view)捕獲目標(biāo)場(chǎng)景的多視圖立體重建方法(Multi-view Stereo)。然而,這些方法通常假設(shè)朗伯表面,并且難以恢復(fù)高頻細(xì)節(jié)。

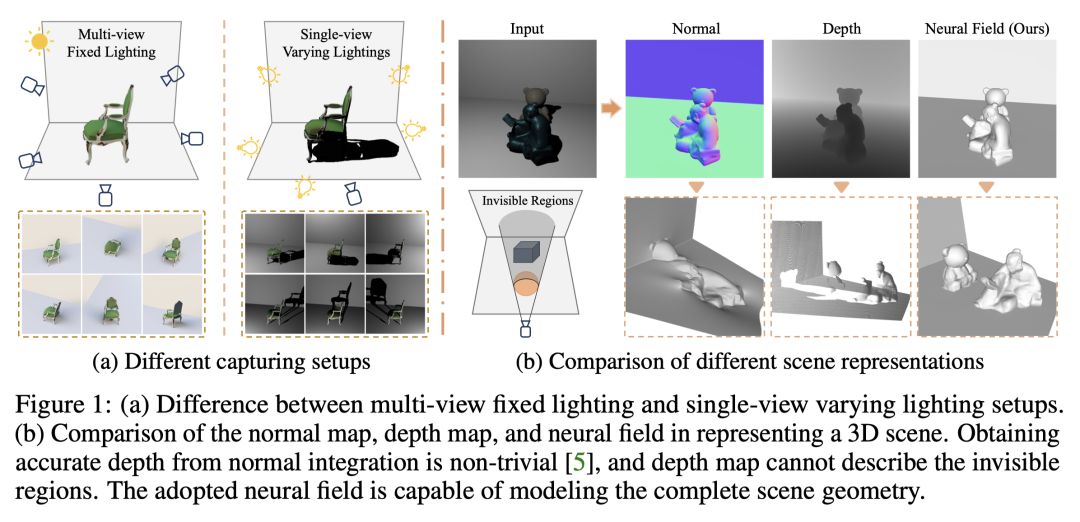

另一種場(chǎng)景重建方法是利用固定視點(diǎn)但不同點(diǎn)光源下捕獲的圖像。例如光度立體 (Photometric Stereo) 方法就采用這種設(shè)置并利用其 shading 信息來重建非朗伯物體的表面細(xì)節(jié)。然而,現(xiàn)有的單視圖方法通常采用法線貼圖(normal map)或深度圖(depth map)來表征可見表面,這使得它們無(wú)法描述物體背面和被遮擋的區(qū)域,只能重建 2.5D 場(chǎng)景幾何。此外,法線貼圖無(wú)法處理深度不連續(xù)的情況。

在最近的一項(xiàng)研究中,來自香港大學(xué)、香港中文大學(xué)(深圳)、南洋理工大學(xué)、MIT-IBM Waston AI Lab 的研究者們提出了通過利用單視圖多光源(single-view,multi-lights)圖像,重建完整 3D 場(chǎng)景的工作。

- 論文鏈接:https://arxiv.org/abs/2210.08936

- 論文主頁(yè):https://ywq.github.io/s3nerf/

- 代碼鏈接:https://github.com/ywq/s3nerf

與現(xiàn)有基于法線貼圖或深度圖的單視圖方法不同,S3-NeRF 基于神經(jīng)場(chǎng)景表征(neural scene representation),同時(shí)利用場(chǎng)景中的 shading 和 shadow 信息來重建整個(gè) 3D 場(chǎng)景(包括可見 / 不可見區(qū)域)。神經(jīng)場(chǎng)景表征方法使用多層感知器 (MLP)對(duì) 連續(xù) 3D 空間進(jìn)行建模,將 3D 點(diǎn)映射到如密度、顏色等的場(chǎng)景屬性。盡管神經(jīng)場(chǎng)景表征在多視圖重建和新視圖合成方面取得了重大進(jìn)展,但其在單視圖場(chǎng)景建模中的探索較少。與現(xiàn)有依賴多視圖照片一致性的基于神經(jīng)場(chǎng)景表征的方法不同,S3-NeRF 主要通過利用單視圖下的 shading 和 shadow 信息來優(yōu)化神經(jīng)場(chǎng)。

我們發(fā)現(xiàn)簡(jiǎn)單的在 NeRF 中直接引入光源位置信息作為輸入無(wú)法重建場(chǎng)景的幾何和外觀。為了更好地利用捕獲的光度立體圖像,我們使用反射場(chǎng)(reflectance field)對(duì)表面幾何和 BRDF 進(jìn)行顯式建模,并采用基于物理的渲染來計(jì)算場(chǎng)景 3D 點(diǎn)的顏色,并通過立體渲染得到該光線(ray)對(duì)應(yīng)的二維像素的顏色。同時(shí),我們對(duì)場(chǎng)景的可見度(visibility)進(jìn)行可微建模,通過追蹤 3D 點(diǎn)到光源之間的光線,計(jì)算該點(diǎn)的可見度。然而,考慮一條光線上所有采樣點(diǎn)的可見性計(jì)算成本較大,因此我們通過計(jì)算光線追蹤得到的表面點(diǎn)的可見性來優(yōu)化陰影建模。

基于神經(jīng)反射場(chǎng)的場(chǎng)景表征

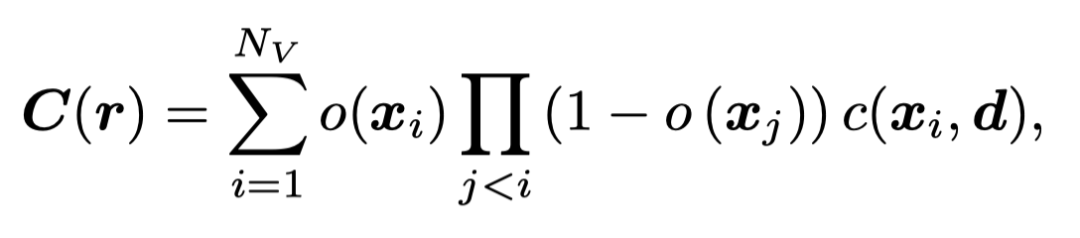

我們采用類似 UNISURF 的 occupancy field 來表征場(chǎng)景幾何。UNISURF 通過 MLP 將 3D 點(diǎn)坐標(biāo)及視線方向映射到該點(diǎn)的 occupancy 值和顏色,并通過立體渲染得到像素的顏色,

Nv為每條射線上采樣點(diǎn)的數(shù)量。

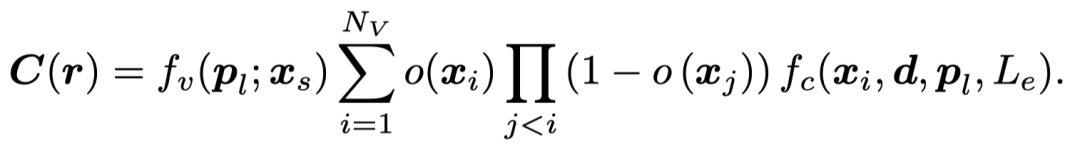

為了有效利用光度立體圖像中的 shading 信息,S3-NeRF 顯式地對(duì)場(chǎng)景的 BRDF 進(jìn)行了建模,并使用基于物理的渲染得到 3D 點(diǎn)的顏色。同時(shí)我們對(duì)場(chǎng)景 3D 點(diǎn)的光可見性進(jìn)行建模以利用圖像中豐富的陰影線索,并通過下式得到最后的像素值。

基于物理的渲染模型

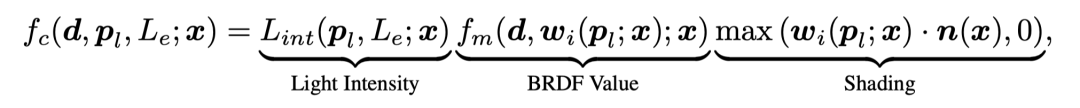

我們的方法考慮了非朗伯表面和空間變化的 BRDF。點(diǎn) x 在近場(chǎng)點(diǎn)光源(pl, Le)下從視線方向 d 觀測(cè)得到的值可以表示為

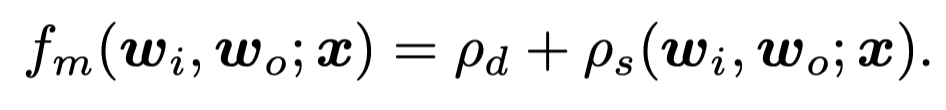

其中,我們考慮到點(diǎn)光源的光線衰減問題,通過光源 - 點(diǎn)之間的距離計(jì)算入射該點(diǎn)處的光照強(qiáng)度。我們采用考慮漫反射和鏡面反射的 BRDF 模型

通過球形高斯(Sphere Gaussian)基的加權(quán)組合來表示鏡面反射率

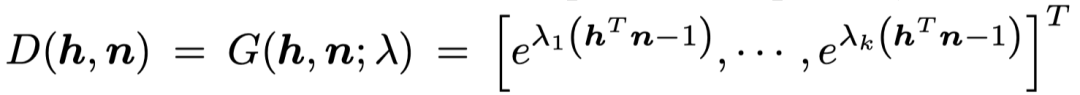

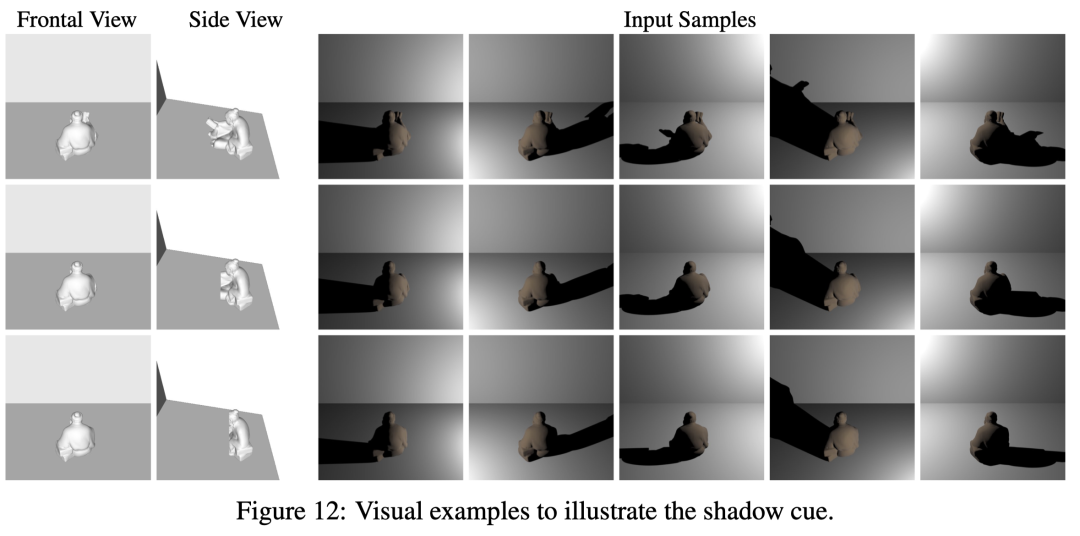

陰影建模

陰影在場(chǎng)景幾何重建中是至關(guān)重要的其中一個(gè)線索。圖中的三個(gè)物體在正視圖中具有相同的形狀和外觀,但其背面卻是形狀各異。通過不同光照下產(chǎn)生的陰影,我們可以觀察到其陰影的形狀各不相同,這些反應(yīng)了正視圖中不可見區(qū)域的幾何信息。光線通過映射在背景中的陰影對(duì)物體的背面輪廓產(chǎn)生了一定的約束。

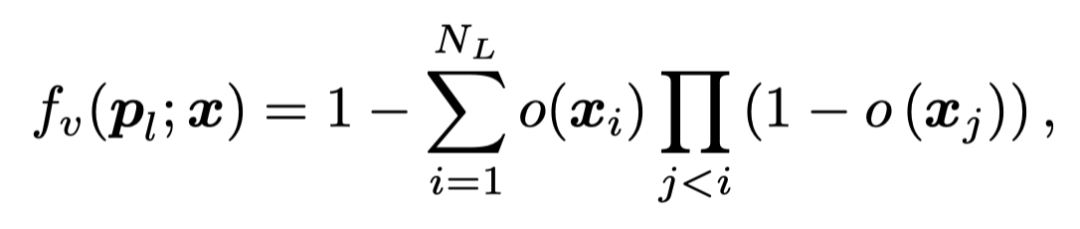

我們通過計(jì)算 3D 點(diǎn) - 光源之間的 occupancy 值來反映該點(diǎn)的光可見度

其中,NL是該點(diǎn) - 光源線段上采樣的點(diǎn)的數(shù)量。

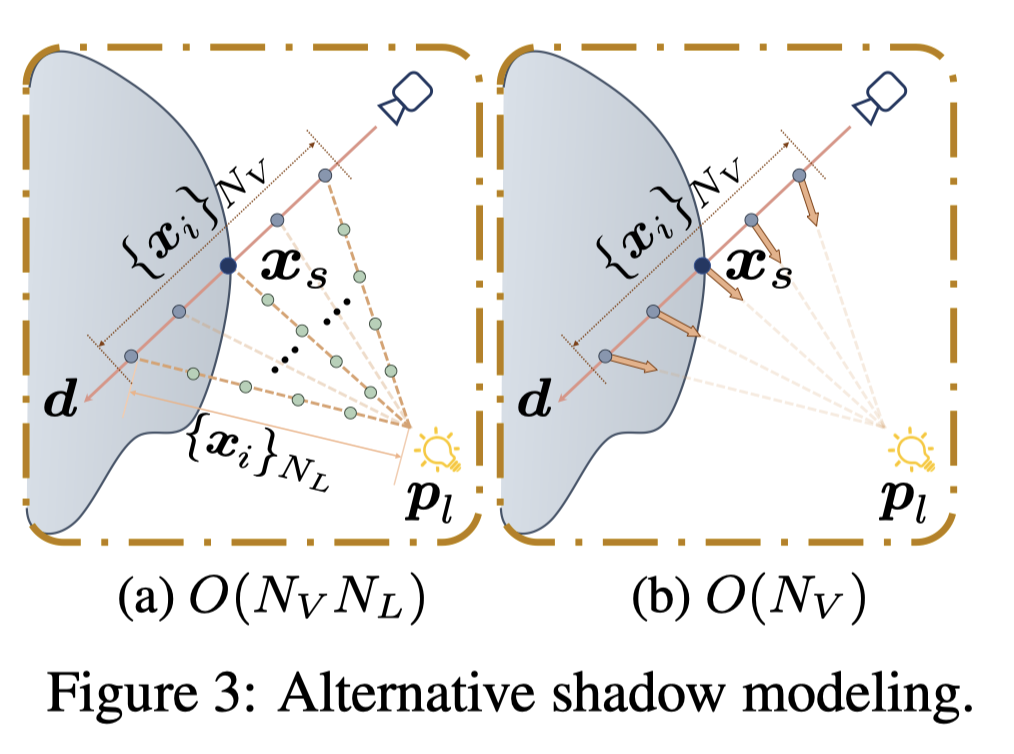

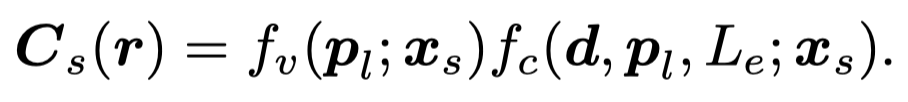

由于計(jì)算像素點(diǎn)沿光線采樣的所有 Nv 點(diǎn)的可見度計(jì)算成本較大(O (NvNL)),現(xiàn)有的方法有的采用 MLP 直接回歸點(diǎn)的可見度(O (Nv)),或是得到場(chǎng)景幾何后預(yù)先提取表面點(diǎn)(O (NL))。S3-NeRF 則通過 root-finding 定位的表面點(diǎn)以在線方式計(jì)算該像素的光可見度,并通過下式表示像素值。

場(chǎng)景優(yōu)化

我們的方法不需要對(duì)陰影進(jìn)行監(jiān)督,而是依靠圖像的重建 loss 來進(jìn)行優(yōu)化。考慮到單視角下沒有其他視角帶來的額外約束,如果采用類似 UNISURF 逐漸縮小采樣范圍的采樣策略,將會(huì)導(dǎo)致模型在采樣間隔減小后開始退化。因此,我們采用聯(lián)合立體渲染和表面渲染的策略,利用 root-finding 定位得到的表面點(diǎn)渲染顏色并計(jì)算 L1 loss。

實(shí)驗(yàn)結(jié)果

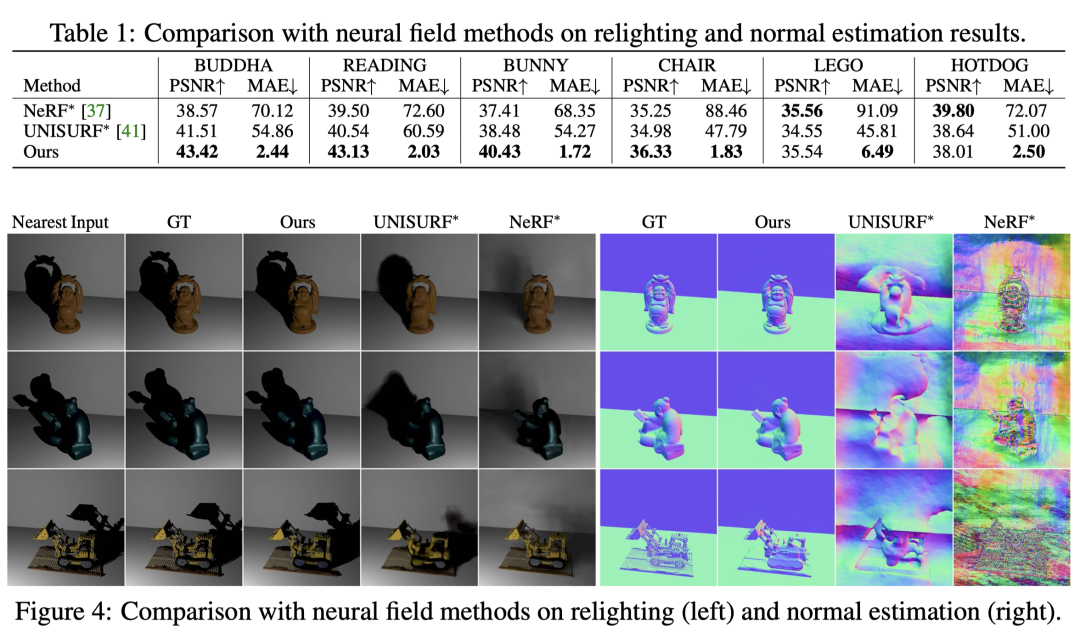

與神經(jīng)輻射場(chǎng)方法的比較

我們首先與基于神經(jīng)輻射場(chǎng)的兩個(gè) baseline 方法進(jìn)行比較(由于任務(wù)不同,我們?cè)谄漕伾?MLP 中引入光源信息)。可以看到它們無(wú)法重建場(chǎng)景幾何,也無(wú)法準(zhǔn)確生成新光照下的陰影。

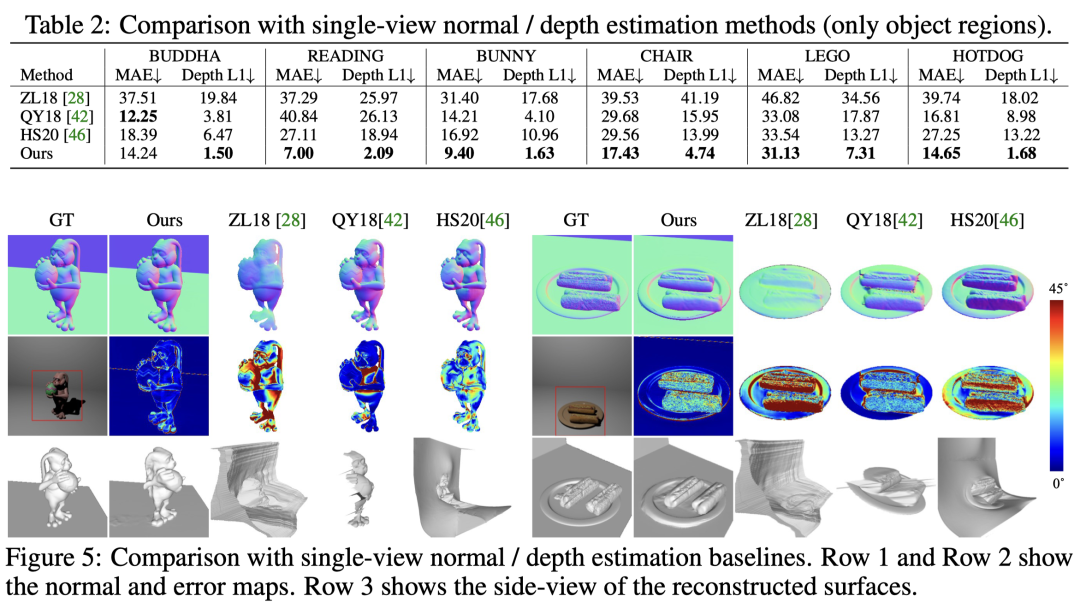

與單視角形狀估計(jì)方法的比較

在與現(xiàn)有單視圖法線 / 深度估計(jì)的方法比較中可以看到,我們的方法在法線估計(jì)和深度估計(jì)上都取得了最好的結(jié)果,并且能夠同時(shí)重建場(chǎng)景中可見與不可見的區(qū)域。

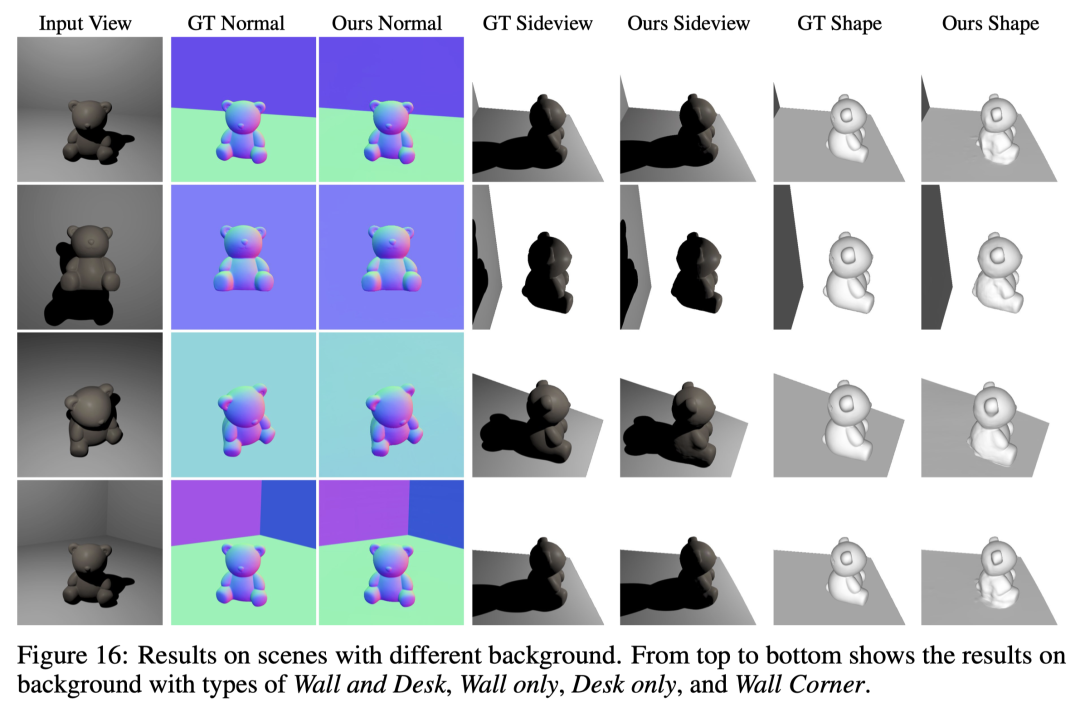

不同背景的場(chǎng)景重建

我們的方法適用于各種不同背景條件的場(chǎng)景。

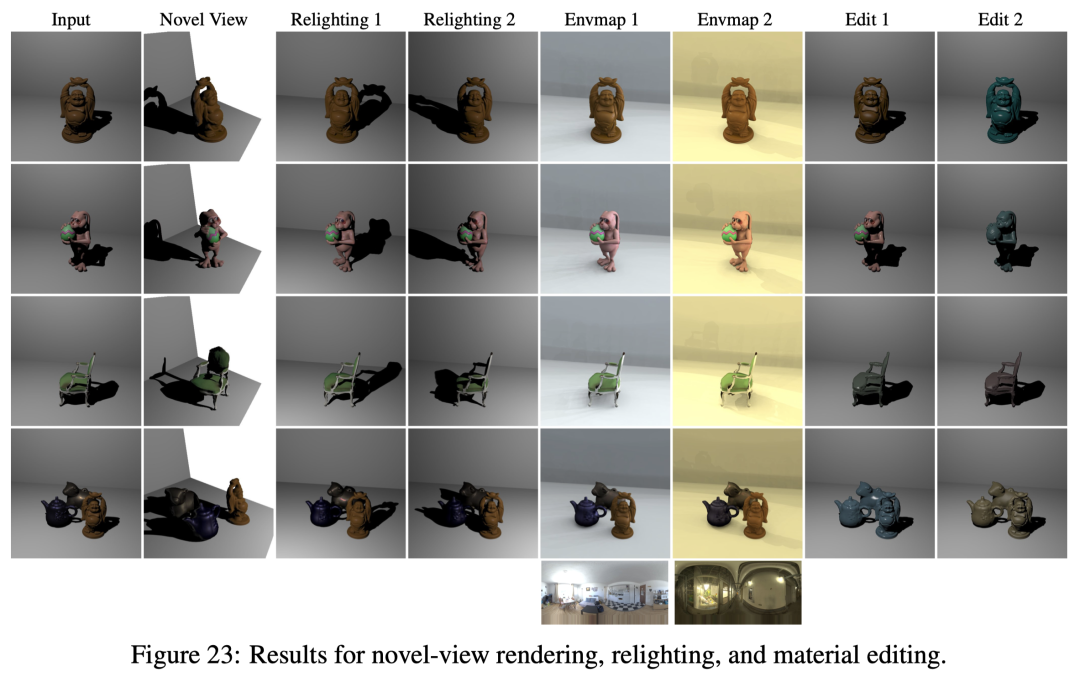

新視圖渲染、改變光照與材料編輯

基于神經(jīng)反射場(chǎng)的場(chǎng)景建模,我們成功解耦了場(chǎng)景的幾何 / 材質(zhì) / 光照等,因而可以應(yīng)用于新視圖渲染、改變場(chǎng)景光照、材料編輯等應(yīng)用。

真實(shí)拍攝場(chǎng)景的重建

我們拍攝了三個(gè)真實(shí)場(chǎng)景來探索其實(shí)用性。我們將相機(jī)位置固定,利用手機(jī)的手電筒作為點(diǎn)光源(環(huán)境光源關(guān)閉),手持手電筒隨機(jī)移動(dòng)以捕捉不同光源下的圖像。該設(shè)置無(wú)需光源校準(zhǔn),我們應(yīng)用 SDPS?Net 得到光源方向的粗略估計(jì),并粗略估計(jì)相機(jī) - 物體及光源 - 物體的相對(duì)距離來初始化光源位置。光源位置在訓(xùn)練過程中隨場(chǎng)景的幾何和 BRDF 聯(lián)合優(yōu)化。可以看到即便是較為隨意的數(shù)據(jù)捕捉設(shè)置(沒有對(duì)于光源的校準(zhǔn)),我們的方法仍能較好的重建 3D 場(chǎng)景幾何。

總結(jié)

- S3-NeRF 通過利用單視圖多個(gè)點(diǎn)光源下拍攝的圖像來優(yōu)化神經(jīng)反射場(chǎng)以重建 3D 場(chǎng)景幾何和材質(zhì)信息。

- 通過利用 shading 和 shadow 線索,S3-NeRF 能有效恢復(fù)場(chǎng)景中可見 / 不可見區(qū)域的幾何形狀,實(shí)現(xiàn)單目視角下完整場(chǎng)景幾何 / BRDF 的重建。

- 各項(xiàng)實(shí)驗(yàn)表明我們的方法能夠重建各種復(fù)雜幾何 / 材質(zhì)的場(chǎng)景,并能應(yīng)對(duì)各種幾何 / 材質(zhì)的背景以及不同的光照數(shù)量 / 光源分布。