UCSD、MIT等華人團(tuán)隊(duì)教機(jī)器狗感知3D世界!搭M1芯片,爬樓跨障無所不能

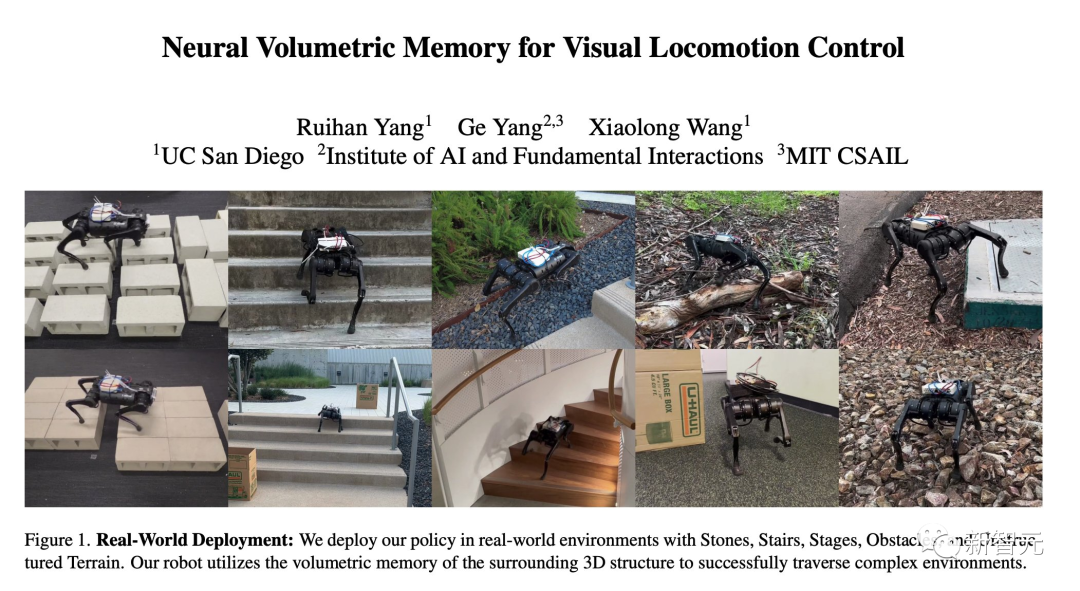

最近,來自UCSD、IAIFI和MIT機(jī)構(gòu)的研究人員,用一種全新的神經(jīng)體積記憶架構(gòu)(NVM),教會(huì)了一只機(jī)器狗感知三維世界。

利用這項(xiàng)技術(shù),機(jī)器狗可以通過單一的神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)爬樓梯、跨縫隙、翻障礙等等——完全自主,無需遙控。

不知道你有沒有注意到狗背上那個(gè)的白盒子?

里面搭載的是蘋果的M1芯片,負(fù)責(zé)運(yùn)行機(jī)器狗的視覺處理任務(wù)。而且,還是團(tuán)隊(duì)從一臺(tái)Mac上拆下來的。

不難看出,MIT的這只機(jī)器狗可以輕松地爬過了橫在自己面前一段樹枝,毫不費(fèi)力(基本上)。

長(zhǎng)了4條腿的MacBook?

眾所周知,對(duì)于機(jī)器狗,以及其他有腿的機(jī)器人來說,想要翻越不平整的道路,可謂是困難重重。

路面狀況越是復(fù)雜,就有越多的障礙無法被看到。

為了解決「部分可觀測(cè)環(huán)境」問題,目前SOTA的視覺-運(yùn)動(dòng)技術(shù)通過幀堆疊(frame-stacking),將圖像通道連接起來。

然而,這種簡(jiǎn)單的處理方法遠(yuǎn)遠(yuǎn)落后于現(xiàn)在的計(jì)算機(jī)視覺技術(shù)——后者可以明確地模擬光流和特定的3D幾何形狀。

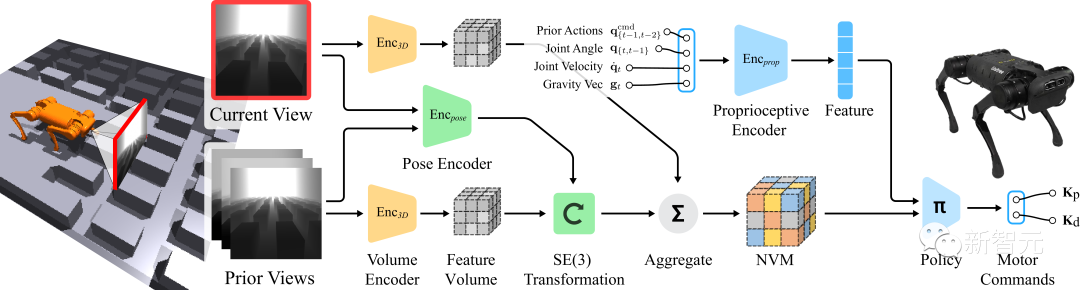

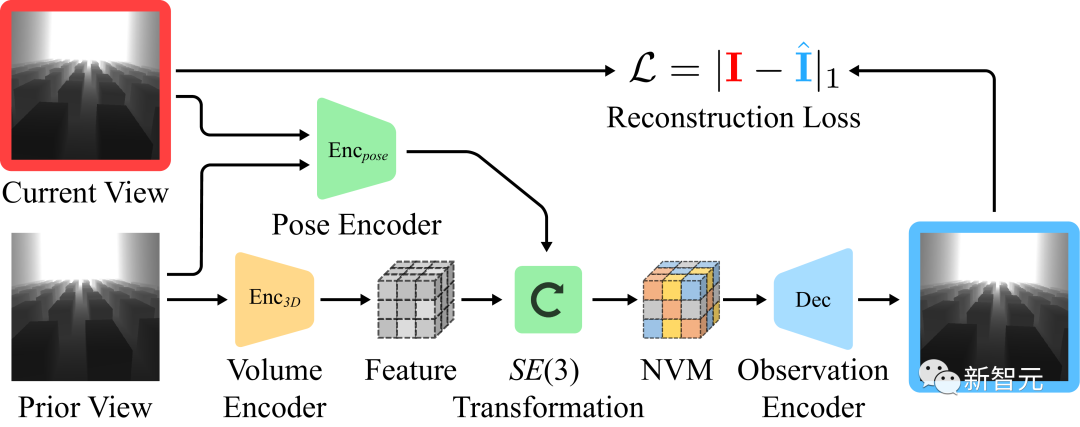

受此啟發(fā),團(tuán)隊(duì)提出了一種神經(jīng)體積記憶架構(gòu)(NVM),可以充分考慮到三維世界的SE(3)等變性(Equivalence)。

項(xiàng)目地址:https://rchalyang.github.io/NVM/

與以往的方法不同,NVM是一種體積格式。它可以將來自多個(gè)相機(jī)視圖的特征體積聚合到機(jī)器人的自我中心框架中,從而讓機(jī)器人能更好地理解周圍的環(huán)境。

測(cè)試的結(jié)果顯示,使用神經(jīng)體積記憶(NVM)對(duì)腿部運(yùn)動(dòng)進(jìn)行訓(xùn)練后,機(jī)器人在復(fù)雜的地形上的表現(xiàn)要明顯優(yōu)于之前的技術(shù)。

此外,消融實(shí)驗(yàn)的結(jié)果顯示,神經(jīng)體積記憶中存儲(chǔ)的內(nèi)容捕獲了足夠的幾何信息來重構(gòu)3D場(chǎng)景。

現(xiàn)實(shí)世界中的實(shí)驗(yàn)

為了在模擬之外的不同現(xiàn)實(shí)世界場(chǎng)景中進(jìn)行驗(yàn)證,團(tuán)隊(duì)在室內(nèi)和室外場(chǎng)景中都進(jìn)行了實(shí)驗(yàn) 。

當(dāng)機(jī)器狗發(fā)現(xiàn)有障礙物突然出現(xiàn)在自己面前時(shí),直接就會(huì)選擇繞開。

在滿是石頭的地面上,走起來好像也沒什么問題,雖然比在平地上還是要費(fèi)力一些的。

相對(duì)于自身來說比較大的障礙,努努力也還是可以翻過去的。

采用此前的識(shí)別控制技術(shù),小狗后腿對(duì)距離判斷明顯出現(xiàn)了誤差,一腳踩溝里翻車了,失敗。

采用MIT提出的NVM之后,小狗過溝,穩(wěn)穩(wěn)的幸福,成功!

采用此前的識(shí)別控制技術(shù),小狗第一腳就踩空了,狗頭搶地,失敗。

采用MIT提出的NVM之后,小狗四平八穩(wěn)地走過了矩陣。

腿部運(yùn)動(dòng)的體積記憶

使用以自我為中心的攝像機(jī)視角,本質(zhì)上是一個(gè)處理「部分可觀測(cè)環(huán)境」的問題(Partially-Observed)。

為了使控制問題具體化,機(jī)器人需要從先前的幀中收集信息,并正確推斷被遮擋的地形。

在運(yùn)動(dòng)過程中,直接安裝在機(jī)器人底盤上的攝像機(jī)發(fā)生劇烈和突然的位置變化。

這樣,在表征一連串的畫面的過程中,某單個(gè)幀能夠被放到正確的位置,就變得非常重要了。

為此,團(tuán)隊(duì)提出的神經(jīng)體積記憶(NVM)的概念,可以將輸入的一連串視覺信息,轉(zhuǎn)化為場(chǎng)景特征進(jìn)行3D描繪,進(jìn)而進(jìn)行輸出。

通過自監(jiān)督學(xué)習(xí)NVM

雖然「行為克隆目標(biāo)」足以產(chǎn)生一個(gè)好的策略,但針對(duì)平移和旋轉(zhuǎn)的等變性,自動(dòng)為神經(jīng)體積記憶提供了一個(gè)獨(dú)立的、自監(jiān)督的學(xué)習(xí)目標(biāo)。

自監(jiān)督學(xué)習(xí):研究團(tuán)隊(duì)訓(xùn)練了一個(gè)獨(dú)立的解碼器。讓它通過一段視覺觀察和兩個(gè)幀之間的預(yù)估轉(zhuǎn)換,來預(yù)測(cè)不同幀中的視覺觀察。

如上圖所示,可以假設(shè)在幀之間周圍的3D場(chǎng)景保持不變。由于相機(jī)是朝前看的,我們可以將先前幀的特征體積規(guī)范化,并用它來預(yù)測(cè)后續(xù)的圖像。

解碼器的視覺重建

第一幅圖顯示機(jī)器人在環(huán)境中移動(dòng),第二幅圖是輸入的視覺觀察結(jié)果,第三幅圖是使用3D特征體積和預(yù)估畫面合成的視覺觀察效果。

對(duì)于輸入的視覺觀察,研究團(tuán)隊(duì)對(duì)圖像應(yīng)用了大量的數(shù)據(jù)增強(qiáng)來提高模型的魯棒性。

作者介紹

Ruihan Yan

Ruihan Yan是加州大學(xué)圣地亞哥分校的二年級(jí)博士生。在此之前,他于2019年在南開大學(xué)獲得軟件工程學(xué)士學(xué)位

他的研究興趣是強(qiáng)化學(xué)習(xí)、機(jī)器學(xué)習(xí)、機(jī)器人等。具體來說,他想建立智能體,利用來自不同來源的信息進(jìn)行決策。

Ge Yang

Ge Yang本科畢業(yè)于耶魯大學(xué)物理和數(shù)學(xué)專業(yè),并在芝加哥大學(xué)獲得物理學(xué)博士學(xué)位。目前是美國(guó)國(guó)家科學(xué)基金會(huì)人工智能與基礎(chǔ)交互作用研究所(IAIFI)的博士后研究員。

Ge Yang的研究涉及兩組相關(guān)問題。第一組是通過重新審視我們?cè)谏窠?jīng)網(wǎng)絡(luò)中表征知識(shí)的方式,以及知識(shí)如何在分布中轉(zhuǎn)移,來改善學(xué)習(xí)。第二組是通過理論工具的視角來看待強(qiáng)化學(xué)習(xí),如神經(jīng)正切核、非歐幾里得幾何和哈密頓動(dòng)力學(xué)。

Xiaolong Wang

Xiaolong Wang是加州大學(xué)圣地亞哥分校ECE系的一名助理教授。他是TILOS國(guó)家科學(xué)基金會(huì)人工智能研究所的機(jī)器人團(tuán)隊(duì)的成員。

他在卡內(nèi)基梅隆大學(xué)獲得了機(jī)器人學(xué)的博士學(xué)位,并曾在加州大學(xué)伯克利分校做博士后研究。