劍橋、騰訊AI Lab等提出大語言模型PandaGPT:一個模型統一六種模態

來自劍橋、NAIST 和騰訊 AI Lab 的研究者近期發布了一項名為 PandaGPT 的研究成果,這是一種將大型語言模型與不同模態對齊、綁定以實現跨模態指令跟隨能力的技術。PandaGPT 可以完成諸如生成詳細的圖像描述、根據視頻編寫故事以及回答關于音頻的問題等復雜任務。它可以同時接收多模態輸入,并自然地組合它們的語義。

- 項目主頁: https://panda-gpt.github.io/

- 代碼: https://github.com/yxuansu/PandaGPT

- 論文: http://arxiv.org/abs/2305.16355

- 線上 Demo 展示: https://huggingface.co/spaces/GMFTBY/PandaGPT

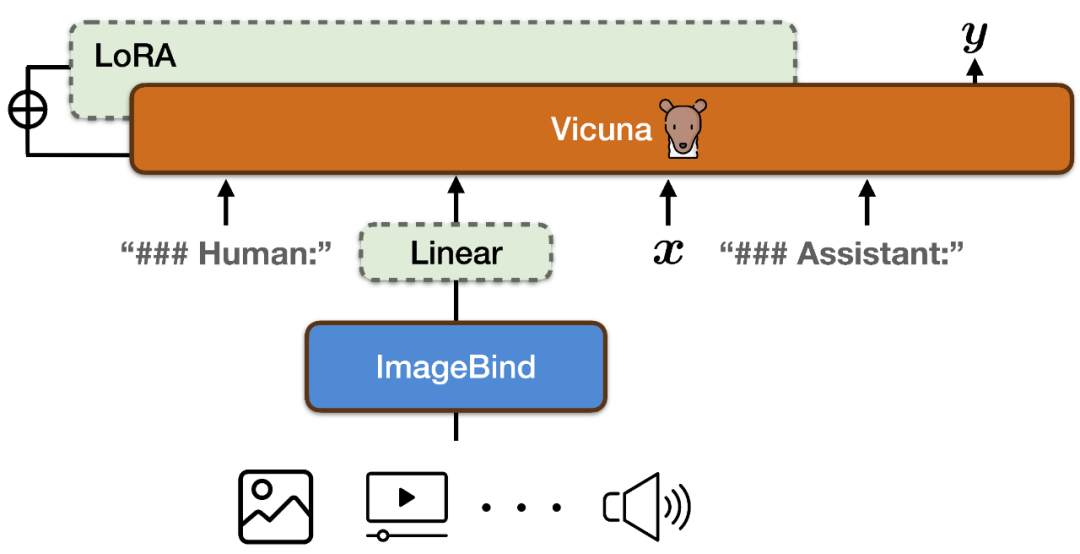

為了實現圖像 & 視頻、文本、音頻、熱力圖、深度圖、IMU 讀數六種模態下的指令跟隨能力,PandaGPT 將 ImageBind 的多模態編碼器與 Vicuna 大型語言模型相結合(如上圖所示)。

為了使 ImageBind 的多模態編碼器和 Vicuna 的大型語言模型的特征空間對齊,PandaGPT 使用了組合 LLaVa 和 Mini-GPT4 發布的共 160k 基于圖像的語言指令跟隨數據作為訓練數據。每個訓練實例包括一張圖像和相應一組多輪對話。

為了避免破壞 ImageBind 本身的多模態對齊性質和減少訓練成本,PandaGPT 只更新了以下模塊:

- 在 ImageBind 的編碼結果上新增一個線性投影矩陣,將 ImageBind 生成的表示轉換后插入到 Vicuna 的輸入序列中;

- 在 Vicuna 的注意力模塊上添加了額外的 LoRA 權重。兩者參數總數約占 Vicuna 參數的 0.4%。訓練函數為傳統的語言建模目標。值得注意的是,訓練過程中僅對模型輸出對應部分進行權重更新,不對用戶輸入部分進行計算。整個訓練過程在 8×A100 (40G) GPUs 上完成訓練需要約 7 小時。

值得強調的是,目前的 PandaGPT 版本只使用了對齊的圖像 - 文本數據進行訓練,但是繼承了 ImageBind 編碼器的六種模態理解能力(圖像 / 視頻、文本、音頻、深度度、熱量圖和 IMU)和它們之間的對齊屬性,從而具備在所有模態之間跨模態能力。

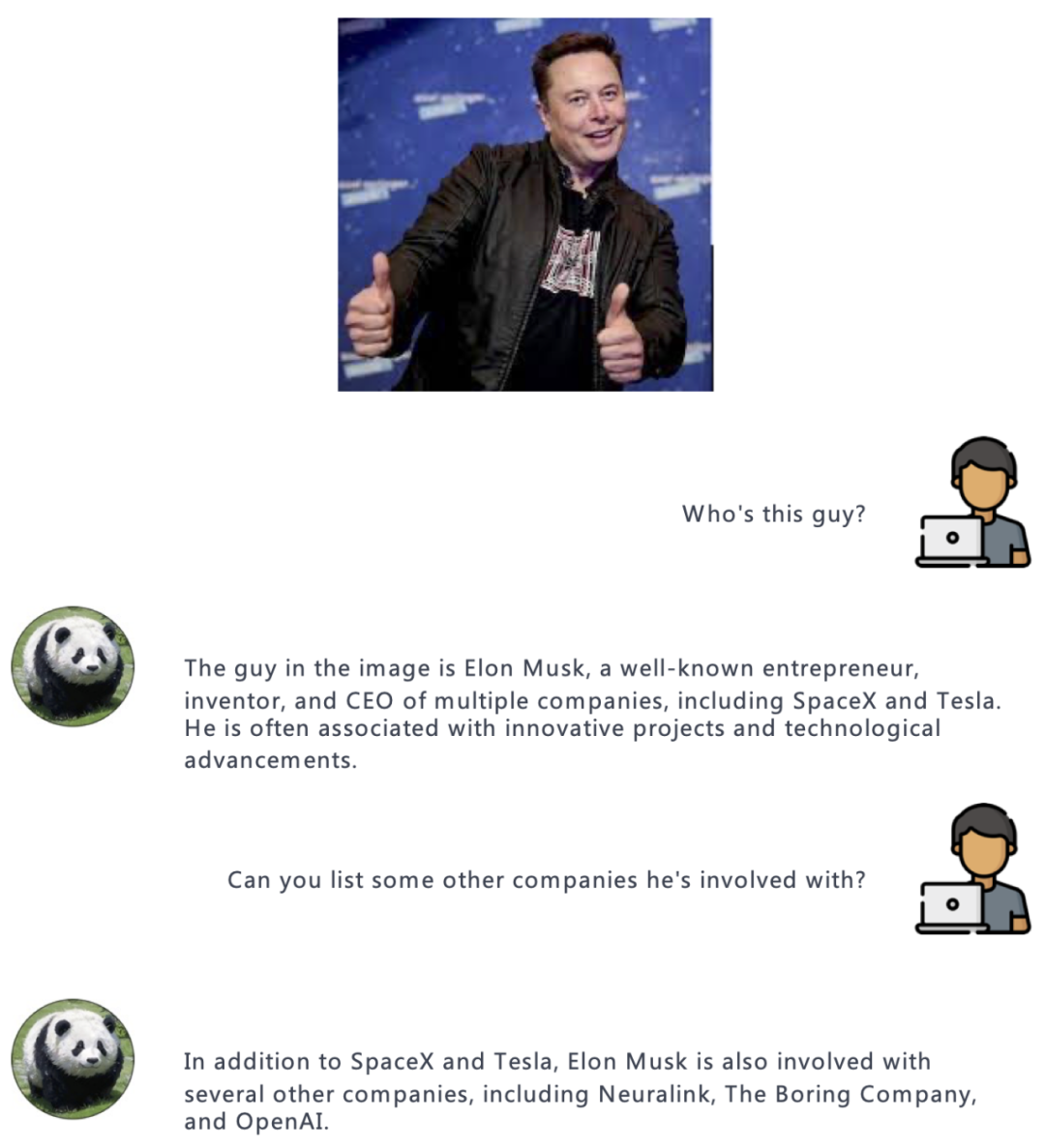

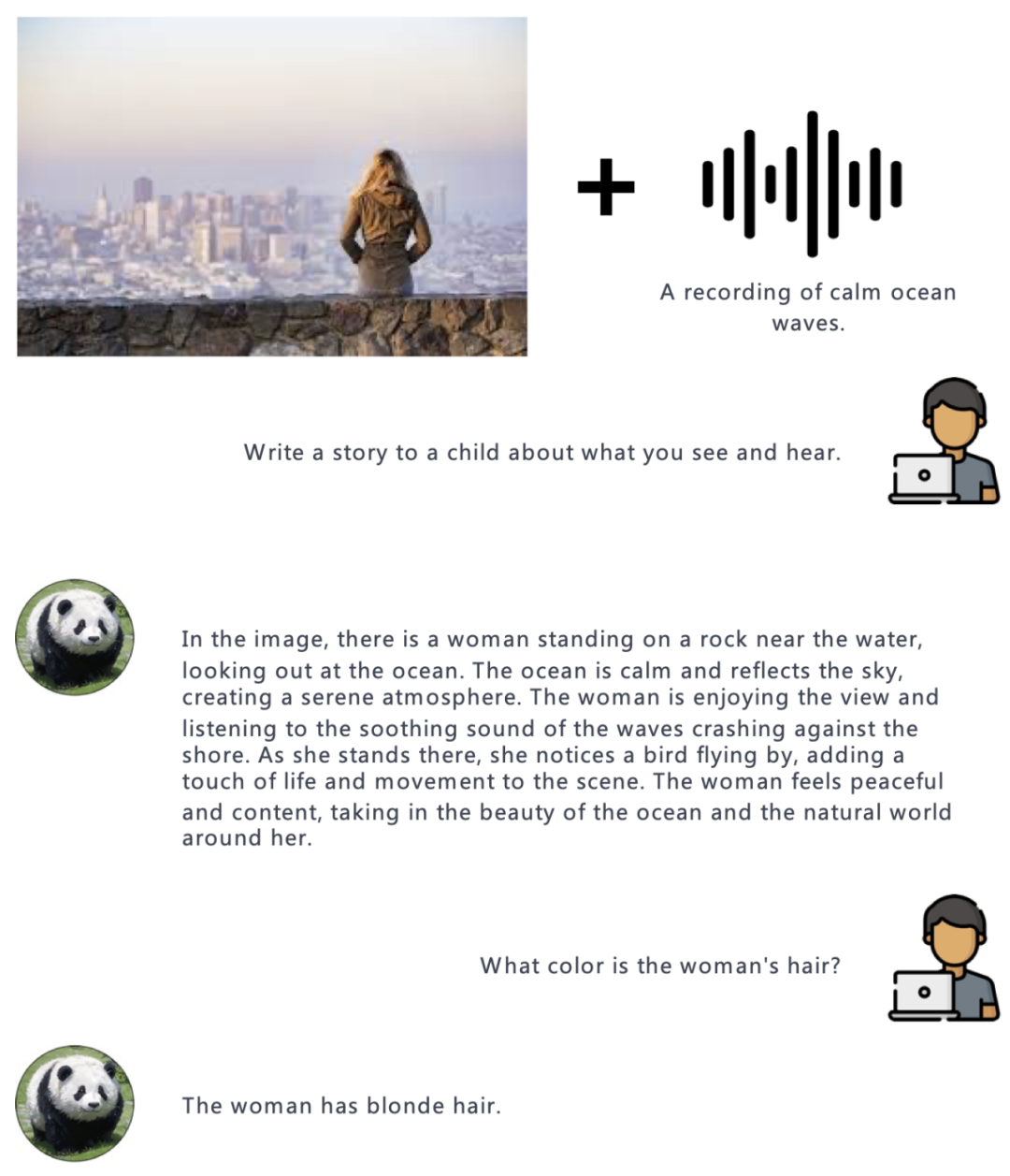

在實驗中,作者展示了 PandaGPT 對不同模態的理解能力,包括基于圖像 / 視頻的問答,基于圖像 / 視頻的創意寫作,基于視覺和聽覺信息的推理等等,下面是一些例子:

圖像:

音頻:

視頻:

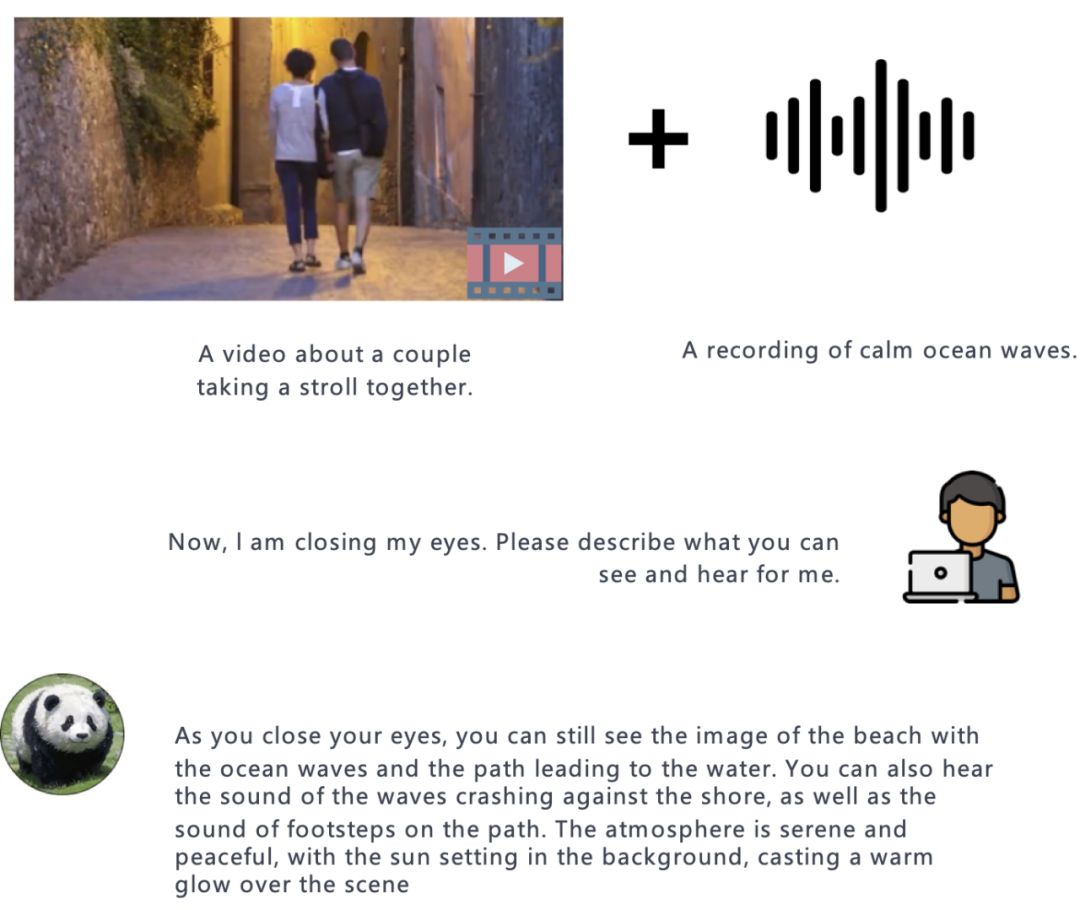

與其他多模態語言模型相比,PandaGPT 最突出的特點是它能夠理解并將不同模態的信息自然地組合在一起。

視頻 + 音頻:

圖像 + 音頻:

總結

作者們也總結了目前 PandaGPT 的諸多問題以及未來的發展方向。盡管 PandaGPT 在處理多種模態及其組合方面具有驚人的能力,但仍有多種方法可以極大程度的提升 PandaGPT 的性能。

- PandaGPT 可以通過使用其他模態對齊數據來進一步提升圖像以外模態的理解能力,例如利用 ASR 和 TTS 數據來進行音頻 - 文本模態的模態理解和指令跟隨能力。

- 文本以外的其他模態僅僅使用了一個 embedding 向量進行表示,導致語言模型無法理解文本之外模型的細粒度信息。更多關于細粒度特征提取的研究,如跨模態注意力機制,可能有助于提高性能。

- PandaGPT 目前僅允許將文本之外的模態信息用作輸入。未來該模型有潛力將整個 AIGC 統一到同一個模型之中,即一個模型同時完成圖像 & 視頻生成、語音合成、文本生成等任務。

- 需要新的基準測試來評估多模態輸入的組合能力。

- PandaGPT 還可能表現出現有語言模型的一些常見缺陷,包括幻覺、毒性和刻板印象。

最后,作者們強調,PandaGPT 僅僅是一個研究原型,暫時還不足以直接應用于生產環境。