統一SAM2和LLaVA!字節豆包提出Dense Video多模態大模型Sa2VA

在最近的一篇論文中,來自字節跳動、北京大學等機構的研究者提出了 Sa2VA。市面上第一個結合 SAM-2 和 LLaVA-like 的視頻多模態大模型,結合了 SAM-2 和 LLaVA 的優勢,實現了時空細粒度的理解。

- 論文地址:https://arxiv.org/pdf/2501.04001

- 項目主頁:https://lxtgh.github.io/project/sa2va/

- GitHub 地址:https://github.com/magic-research/Sa2VA

具體來說,研究者設計了一套統一的指令微調格式 (Instruction Tuning Pipeline),整合了五種不同的任務,超過 20 個數據集一起進行聯合訓練。該模型在多個視頻理解和圖像理解,視頻指代分割和圖像指代分割的任務上均取得了領先的效果。

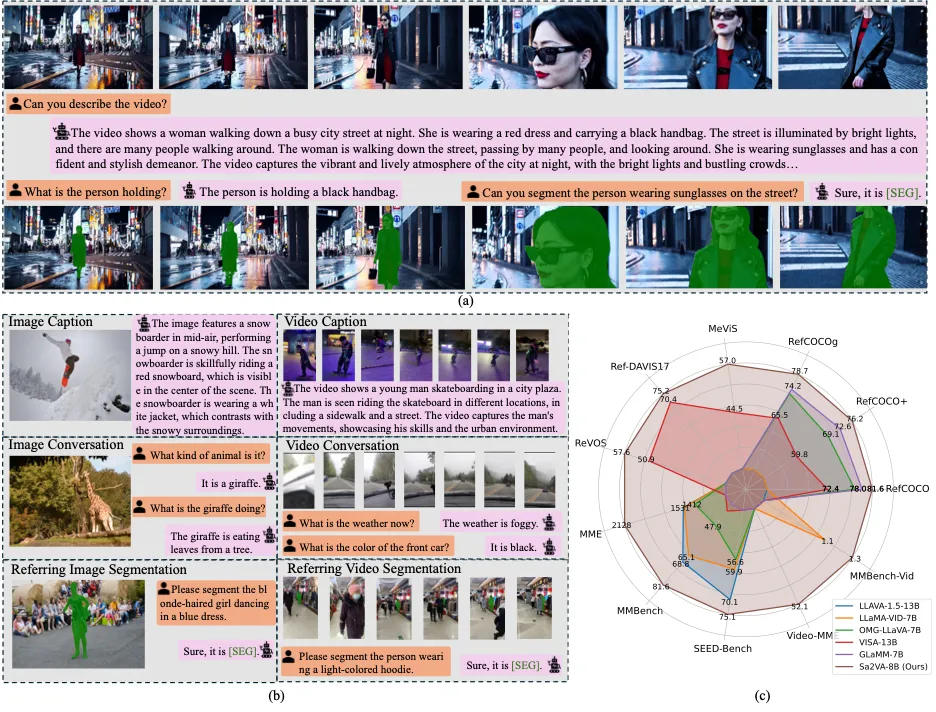

圖 1 Sa2VA 的能力。(a) 給定一個視頻, Sa2VA 能夠分割所指的對象并理解整個場景。(b) Sa2VA 在單詞指令追隨訓練的情況下,支持圖像對話、視頻對話、圖像引用分割、視頻引用分割以及物體描述生成。(c) 與現有的 MLLM(例如 GLaMM 和 OMG-LLaVA)相比,Sa2VA 在多圖像、視頻引用分割和對話上取得了較好的表現(相比于之前的方法,我們的 model 可以在多個不同的視頻和圖像多模態任務上取得領先效果。)。

研究背景和動機

近年來,多模態大語言模型有了很大的進展。多模態大語言模型現在支持圖像對話、視頻對話、圖像分析等多種任務。這些模型整合不同模態的數據,展現了強大的泛化能力和應用潛力。在實際應用中,多模態大語言模型已經能夠實現圖像或視頻級別的各種復雜任務。通過人類輸入各種不同的指令,這些模型能夠根據具體任務生成精準的響應。例如,在視頻對話任務中,多模態大語言模型可以識別圖像中的關鍵要素,回答有關物體、場景的問題。

在這些應用中,我們主要關注細粒度的圖像和視頻理解。也就是給出自然語言或者視覺的指令,讓大語言模型輸出用戶關注的細粒度內容。這樣人類就可以在視頻播放的過程中和多模態大語言模型進行交互,而不是僅僅輸出一般的結果。然而,現有的感知模型或者多模態大語言模型都沒有辦法很好的完成這個任務。感知模型缺乏開放世界的自然語言推理能力。例如 SAM-2 可以很好的從視覺提示出發對物體進行分割,但無法對物體就行描述。而多模態大語言模型往往缺乏感知能力,尤其是缺乏視頻的分割能力。本工作旨在利用兩者的優勢構建一個統一的支持圖像、視頻細粒度感知以及對話、分析等任務的模型。

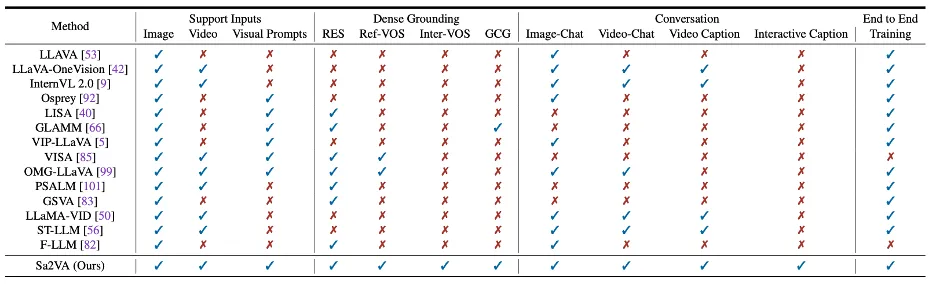

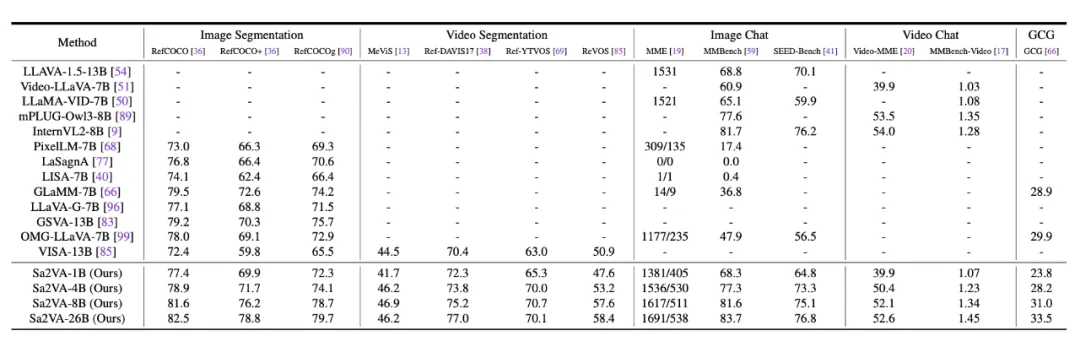

表格 1 Sa2VA 與之前模型的能力比較。Sa2VA 支持各種任務和模態。

在本工作中,我們提出了 Sa2VA,首次結合了 SAM-2 的感知能力和多模態大語言模型的推理能力來構建統一的模型,并使用新的訓練數據來使得整個模型具有額外的能力。我們將各種任務整合成一個單次的指令追隨訓練。這些任務包括圖像和視頻 Referring Expression Segmentation (RES), Visual Question Answering (VQA), Grounded Conversation Generation (GCG) 等任務。我們的方法還支持視覺提示輸入來指定物體。我們的核心觀點是將所有的圖像、視頻、文字或指令輸入統一成令牌而不分別進行設計。這種方式可以讓 Sa2VA 支持上述所有任務的聯合訓練。通過單次的指令追隨訓練,我們的 Sa2VA 可以僅僅使用一種參數來來實現上述所有任務。

方法設計

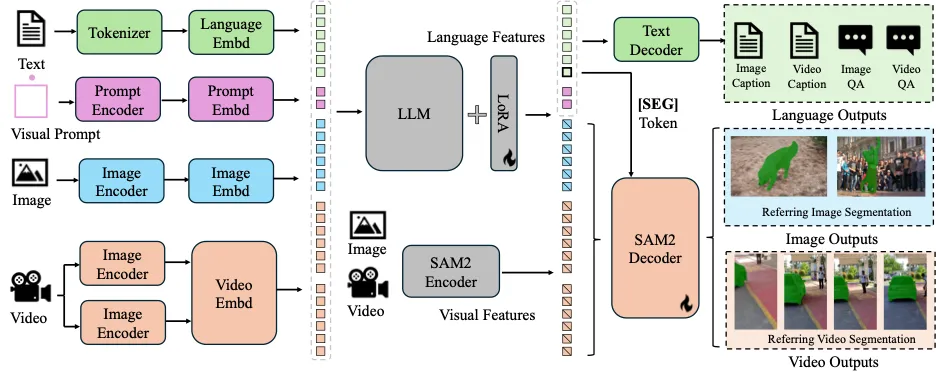

圖 2 Sa2VA 的模型結構。Sa2VA 首先將輸入的文本、視覺提示、圖像和視頻編碼為令牌嵌入。然后通過大型語言模型 (LLM) 處理這些令牌。輸出的文本令牌用于生成 [SEG] 令牌和相關的語言輸出。SAM-2 解碼器從 SAM-2 編碼器接收圖像和視頻特征以及 [SEG] 令牌,以生成相應的圖像和視頻分割結果。

Sa2VA 模型具體實現

Sa2VA 主要包括兩部分,第一部分是多模態大語言模型,第二部分是 SAM-2 模型。

Sa2VA 的多模態大語言模型部分使用了已經經過預訓練的模型。主要包括一個視覺編碼器,來對圖片、視頻或部分圖片進行編碼獲得視覺特征。通過一個投影層,可以將視覺特征轉換成維度和大語言模型一致的視覺令牌。這些視覺令牌和輸入的自然語言令牌一起作為大語言模型的輸入來進行推理。整個過程使用了和 LLaVA、Qwen 等多模態大語言模型類似的處理多模態數據的方法。

Sa2VA 使用了多模態大語言模型和分割模型分離的設計,將預訓練后的 SAM-2 模型和多模態大語言模型放在一起分別處理不同的特征,而不是將 SAM-2 模型的輸出送入多模態大語言模型。這種設計主要有三方面的考慮。第一,我們想讓整個模型盡可能的簡單,而非引入過多的計算開銷。第二,如果將 SAM-2 模型的輸出送入多模態語言大模型,將會引入更多的多模態大語言模型的輸入令牌,意味著更多的訓練開銷。第三,分離的設計可以更方便的使用不同種類的基礎模型,進而使得基礎模型的進展可以更方便的遷移到本工作。

Sa2VA 通過微調 “[SEG]” 令牌的方式來連接多模態大語言模型和 SAM-2 模型。“[SEG]” 令牌對應的隱藏狀態將作為 SAM-2 模型的一種新的提示詞。這種新的提示詞擁有對于時間和空間的理解。在 SAM-2 模型的解碼器中,“[SEG]” 令牌對應的時空提示詞可以用來生成對應的圖像或者視頻的分割結果。在訓練的過程中 SAM-2 模型的解碼器可以被微調來理解 “[SEG]” 令牌對應的提示詞。與此同時,梯度也會通過 “[SEG]” 令牌對應的隱藏狀態傳遞到大語言模型中來使得大語言模型擁有生成時空提示詞的能力。

對于指代視頻物體分割任務,Sa2VA 使用一個簡單的框架來通過 SAM-2 的能力取得較強的跟蹤和分割能力。整個過程從提取關鍵幀開始。我們提取整個視頻中的前五幀作為關鍵幀。這些關鍵幀對應的視覺令牌作為多模態大語言模型的輸入來生成 “[SEG]” 令牌。“[SEG]” 令牌對應的提示詞可以直接用來生成關鍵幀的分割結果。使用這些分割結果,結合 SAM-2 模型中經過預訓練的記憶編碼器一起來生成剩余幀的分割結果。

Sa2VA 模型的訓練方法

Sa2VA 將不同的任務統一成相同的表示以進行建模。

(a)對于指代圖像物體分割,給定一段文本描述和圖像,模型將圖像轉換為視覺令牌,將文本轉換為文本令牌,模型最終輸出分割結果。(b)對于指代視頻物體分割任務,給定一段文本描述和對應的視頻,模型將視頻中的關鍵幀轉換為視覺令牌,將文本轉換為文本令牌,模型最終輸出每一幀的分割結果。(c)對于視頻和圖像對話以及關聯式圖像文字描述生成,模型將圖像或視頻轉換為視覺令牌,并將用戶輸入的文字轉換為文本令牌,模型最終輸出回答文本。對于關聯式描述生成,模型還將輸出和回答文本關聯的分割結果。(d) 對于視覺提示理解任務,除了文本令牌和視覺令牌之外,模型進一步將視覺提示轉換為視覺提示令牌。模型最終輸出回答文本,以及對應的分割結果。

在有了對于不同任務的統一表示之后,借助于多模態大語言模型的靈活性,就可以將上述任務統一成一個單次的指令微調。多模態大語言模型將視覺將文本令牌、圖像或視頻的視覺令牌以及視覺提示令牌一起作為輸入,就可以生成文本輸出。在文本輸出中的 “[SEG]” 令牌對應的提示詞就可以使用 SAM-2 模型輸出對應的分割結果。

Sa2VA 在多個數據集上面進行聯合訓練。并對不同的任務使用不同的損失函數進行監督。對于 VQA 任務,我們使用和之前多模態大語言模型相同的文本回歸損失函數。對于分割任務,我們使用逐像素的交叉熵損失函數和 DICE 損失函數。由于已經使用了預訓練之后的多模態大語言模型,Sa2VA 無需進行像之前工作一樣的預訓練階段。

Ref-SAM-v Benchmark

此外,本文還提出了一個新的 Benchmark, Ref-SAM-2v 以及對應的訓練數據集。

對于掩碼數據,我們是基于 SAM2 的中的開源掩碼標注,利用現有的領先的多模態大模型,去對每個跟蹤后的掩碼做目標級別的描述信息生成。具體的數據集生成過程,可以參考我們的論文。

此外,我們的測試 benchmark 相比于之前的 Ref-VOS 數據,更具有挑戰性。具體的數值結果可以參考我們的論文。

數值結果對比

從這個表格中,可以看到,我們的方法可以在 5 個不同的任務上取得領先的結果 (13 個公開數據集)。

我們的方法在我們提出的 Ref-SAM-v 上也取得領先的結果,并大幅度領先現有的工作(zs 代表 zero-shot 測試)。

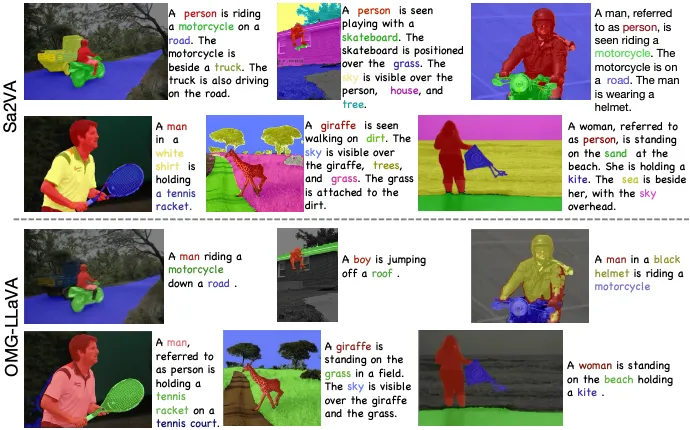

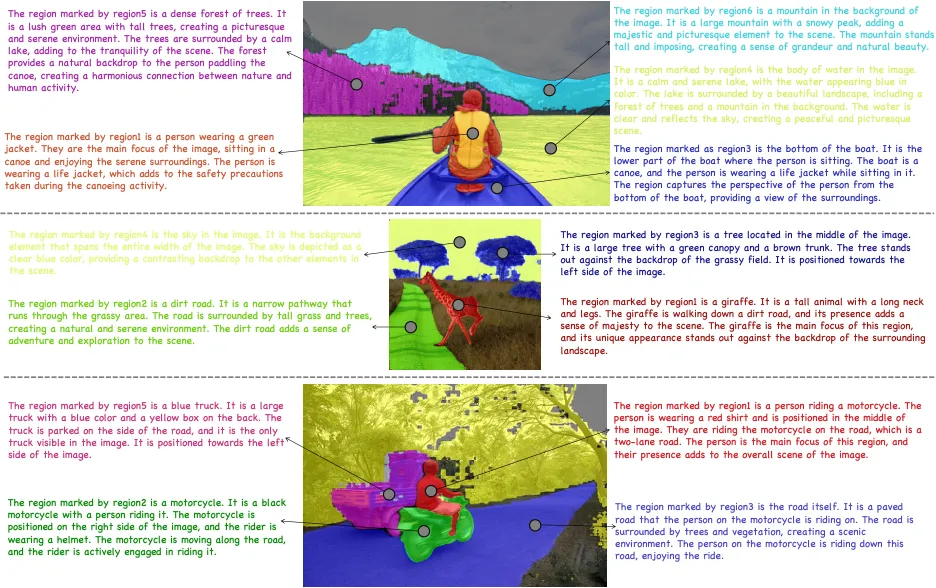

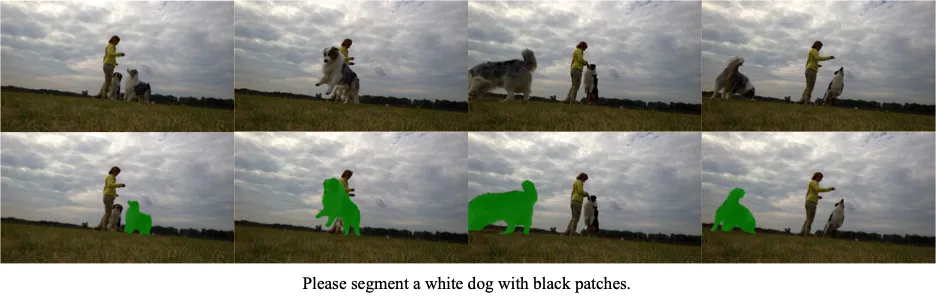

可視化結果展示

Sa2VA 可以實現多種任務,包括圖像和視頻的 caption 生成、對話、指代對象分割、GCG、視覺指代物體 caption 等,下面是一些效果展示:

GCG 任務:

圖像指代分割:

視覺指令輸入的理解:

視頻指代分割:

開集結果測試

同時 Sa2VA 還可以很好的擴展到開放場景中,下面是一些開放場景下的電影或網絡視頻的效果展示。

左邊是輸入視頻,右邊是具體的結果,下側是文字相關的回答。

1、樸彩英 APT APT MV video

Question:Please segment the person wearing sunglasses.

Question:Please segment the singing girl.

2、新寶島,猛男舞團 Demo (Form 嗶哩嗶哩)

Question: Please locate and segment the man in center.

Question: What are these guys doing?

Answer: The guys in the video are dancing together in a group. They are performing a choreographed routine, moving in sync with each other.

3、愛樂之城 (La La Land, 2016)電影片段

Question: Please segment the girl wearing the yellow dress

Question: Please segment the main character.

4、教父 (The Godfathe, 1972)電影片段

Question: What is the atmosphere of the scene?

Answer: The scene has a dark and mysterious atmosphere, with the men dressed in suits and ties, and the dimly lit room.

Selected Frame:

Question: Can you describe what this man holding the cat is doing and how he feels?

Answer: The man in the image is holding a cat in his arms while sitting in a chair. He appears to be looking at the cat with a smile on his face, suggesting that he is enjoying the company of the cat and feeling happy.

Selected Frame:

Question: Can you describe what this man holding the cat is doing and how he feels?

Answer: The man holding the cat is sitting at a desk, and he appears to be in a state of distress. He is holding the cat in his hands, which suggests that he may be trying to comfort or soothe the animal. The man's facial expression and body language indicate that he is experiencing some level of emotional turmoil or discomfort. It is possible that he is feeling overwhelmed, anxious, or even angry. The fact that he is holding the cat in his hands suggests that he may be seeking solace or support from the animal. Overall, the image conveys a sense of tension and unease, as the man struggles to cope with his emotions while holding the cat.

Question: How are people feeling now?

Answer: The people are feeling happy and excited as they watch the band play music on stage.