像GPT-4一樣能看懂圖文,李飛飛等人的具身AI給機(jī)器人造了個(gè)多模態(tài)對話框

是時(shí)候給大模型造個(gè)身體了,這是多家頂級研究機(jī)構(gòu)在今年的 ICML 大會(huì)上向社區(qū)傳遞的一個(gè)重要信號。

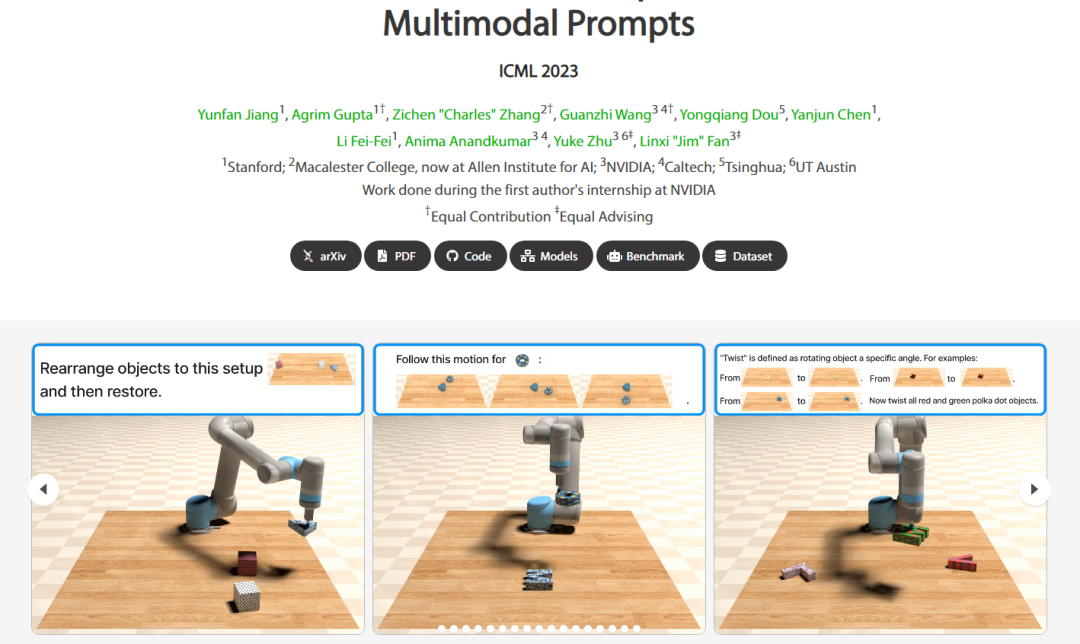

在這次大會(huì)上,谷歌打造的 PaLM-E 和斯坦福大學(xué)李飛飛教授、英偉達(dá)高級研究科學(xué)家 Linxi "Jim" Fan(范麟熙,師從李飛飛)參與打造的 VIMA 機(jī)器人智能體悉數(shù)亮相,展示了具身智能領(lǐng)域的頂尖研究成果。

圖片

圖片

PaLM-E 誕生于今年 3 月份,是一個(gè)參數(shù)量達(dá) 5620 億的具身多模態(tài)語言模型,集成了參數(shù)量 540B 的 PaLM 和參數(shù)量 22B 的視覺 Transformer(ViT),是目前已知的最大的視覺 - 語言模型。利用這個(gè)大模型控制機(jī)器人,谷歌把具身智能玩出了新高度。它能讓機(jī)器人聽懂人類指令,并自動(dòng)將其分解為若干步驟并執(zhí)行,越來越貼近人類對于智能機(jī)器人的期待和想象(更多細(xì)節(jié)參見:《5620 億參數(shù),最大多模態(tài)模型控制機(jī)器人,谷歌把具身智能玩出新高度》)。

VIMA 則誕生于 2022 年 10 月,是一個(gè)基于 Transformer 架構(gòu)的(仿真)機(jī)器人智能體,由來自斯坦福大學(xué)、瑪卡萊斯特學(xué)院、英偉達(dá)、加州理工學(xué)院、清華大學(xué)、德克薩斯大學(xué)奧斯汀分校的多位研究者合作完成。論文一作 Yunfan Jiang 是斯坦福大學(xué)即將入學(xué)的計(jì)算機(jī)科學(xué)博士研究生,曾在英偉達(dá)實(shí)習(xí),與 Linxi "Jim" Fan 等人合作。

- 論文地址:https://arxiv.org/pdf/2210.03094.pdf

- 論文主頁:https://vimalabs.github.io/

- Github 地址:https://github.com/vimalabs/VIMA

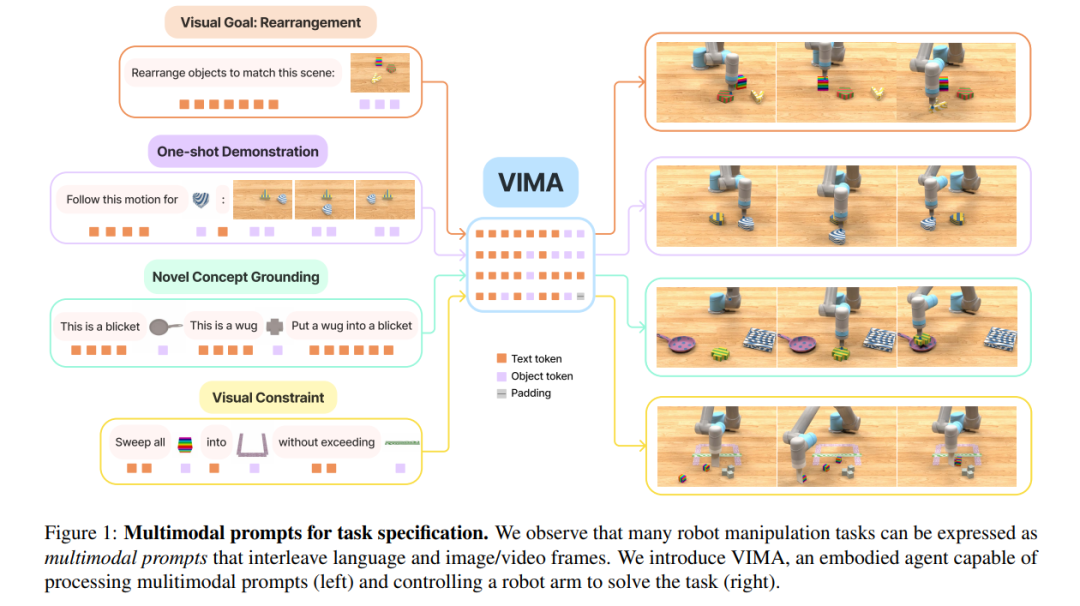

VIMA 智能體能像 GPT-4 一樣接受 Prompt 輸入,而且輸入可以是多模態(tài)的(文本、圖像、視頻或它們的混合),然后輸出動(dòng)作,完成指定任務(wù)。

比如,我們可以要求它把積木按照圖片所示擺好再還原:

讓它按照視頻幀的順序完成一系列動(dòng)作:

給出一些圖示讓它學(xué)習(xí)新概念:

通過圖文混合提示對它施加一些限制:

為什么要研發(fā)這樣的機(jī)器人智能體?作者在論文中寫道:

在 GPT-3 等大模型中,基于 Prompt 的學(xué)習(xí)為將自然語言理解任務(wù)傳達(dá)給通用模型提供了一種便捷靈活的接口。因此,他們設(shè)想,一臺通用機(jī)器人也應(yīng)該具備類似的直觀且富有表現(xiàn)力的任務(wù)規(guī)范接口。

以家務(wù)機(jī)器人為例,我們可以通過簡單的自然語言指令要求機(jī)器人給我們拿一杯水。如果有更具體(但語言難以準(zhǔn)確描述)的需求,我們可以把指令改為語言 + 圖像(給機(jī)器人指令的同時(shí)再給他一張參考圖像,比如某個(gè)水杯的照片)。如果需要機(jī)器人學(xué)習(xí)新技能,機(jī)器人應(yīng)該能夠借助幾個(gè)視頻來自學(xué)、適應(yīng)。需要與不熟悉的物體交互時(shí),我們應(yīng)該能通過幾張簡單的圖像示例來教會(huì)機(jī)器人新的基本概念。最后,為了確保安全部署,我們可以進(jìn)一步指定視覺約束,如「不要進(jìn)入房間」。

為了讓一個(gè)機(jī)器人智能體具備所有這些能力,作者在這項(xiàng)工作中做出了三個(gè)關(guān)鍵貢獻(xiàn):

1、提出了一種新的多模態(tài) prompting 形式,將各種各樣的機(jī)器人操作任務(wù)轉(zhuǎn)換為一個(gè)序列建模問題;

2、構(gòu)建了一個(gè)大型基準(zhǔn),包含多樣化的任務(wù),以系統(tǒng)評估智能體的可擴(kuò)展性和泛化能力;

3、開發(fā)了一個(gè)支持多模態(tài) prompt 的機(jī)器人智能體,能夠進(jìn)行多任務(wù)學(xué)習(xí)和零樣本泛化。

他們從以下觀察開始:許多機(jī)器人操作任務(wù)可以通過語言、圖像、視頻的交織多模態(tài) prompt 來描述(見圖 1)。例如在重新排列任務(wù)中,我們可以給機(jī)器人輸入以下圖文 prompt:「請重新排列物品,使其與 {某場景圖} 相一致」;在少樣本仿真中,prompt 可以寫成「遵循積木的運(yùn)動(dòng)軌跡:{視頻幀 1}, {視頻幀 2}, {視頻幀 3}, {視頻幀 4}」。

圖片

圖片

多模態(tài) prompt 不僅比單個(gè)模態(tài)有更強(qiáng)的表達(dá)能力,還為訓(xùn)練通用型機(jī)器人提供了統(tǒng)一的序列 IO 接口。以前,不同的機(jī)器人操作任務(wù)需要不同的策略架構(gòu)、目標(biāo)函數(shù)、數(shù)據(jù)處理流程和訓(xùn)練過程,導(dǎo)致孤立的機(jī)器人系統(tǒng)無法輕易地結(jié)合多樣的用例。相反,作者在論文中提出的多模態(tài) prompt 接口使他們能夠利用最新的大型 Transformer 模型進(jìn)展,開發(fā)可擴(kuò)展的多任務(wù)機(jī)器人學(xué)習(xí)器。

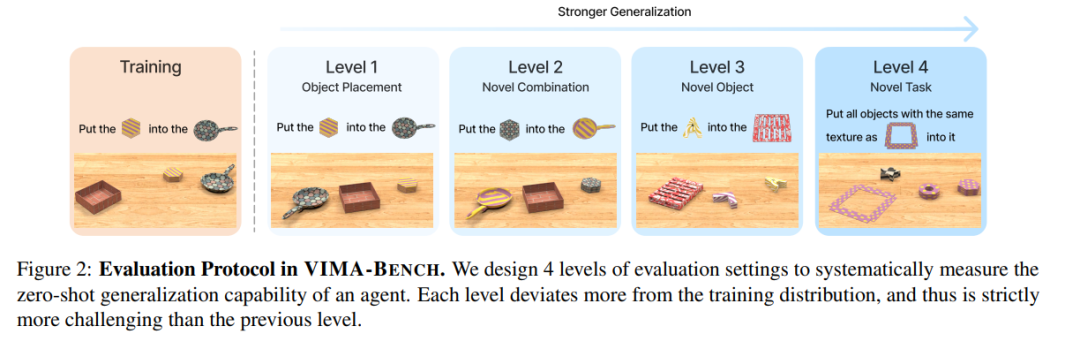

為了系統(tǒng)評估使用多模態(tài) prompt 的智能體,他們開發(fā)了一個(gè)名為 VIMA-BENCH 的新基準(zhǔn)測試,該基準(zhǔn)構(gòu)建在 Ravens 模擬器上。他們提供了 17 個(gè)具有多模態(tài) prompt 模板的代表性任務(wù)。每個(gè)任務(wù)可以通過不同紋理和桌面物體的各種組合進(jìn)行程序化實(shí)例化,產(chǎn)生數(shù)千個(gè)實(shí)例。VIMA-BENCH 建立了一個(gè)四級協(xié)議,逐步評估智能體的泛化能力,如圖 2 所示。

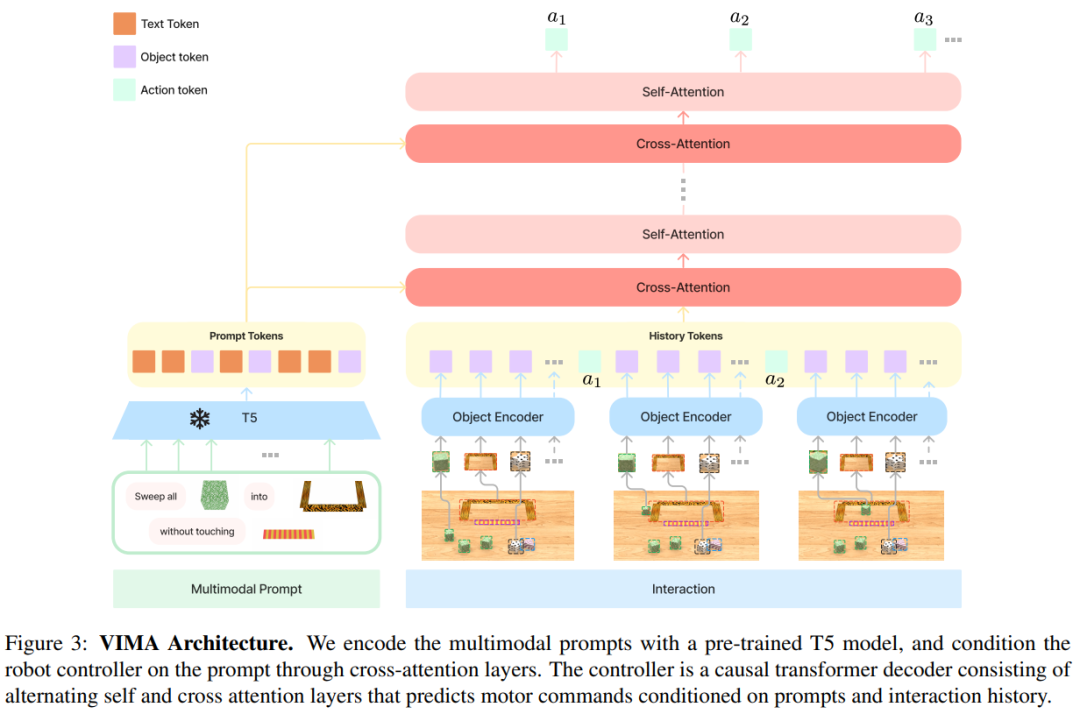

該研究引入了 VIMA(VisuoMotor Attention agent)來從多模態(tài) prompt 中學(xué)習(xí)機(jī)器人操作。模型架構(gòu)遵循編碼器 - 解碼器 transformer 設(shè)計(jì),這種設(shè)計(jì)在 NLP 中被證明是有效的并且是可擴(kuò)展的。

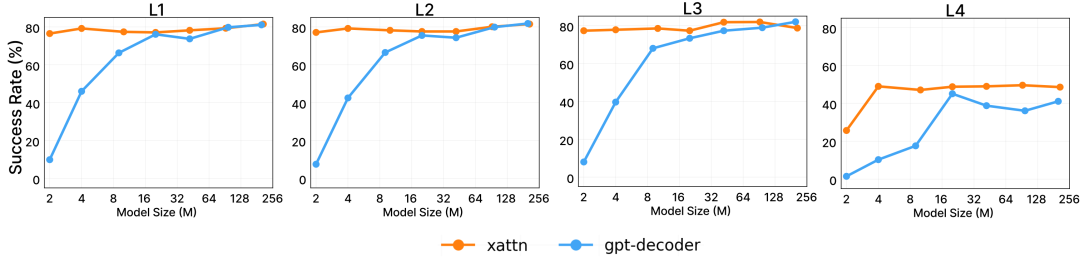

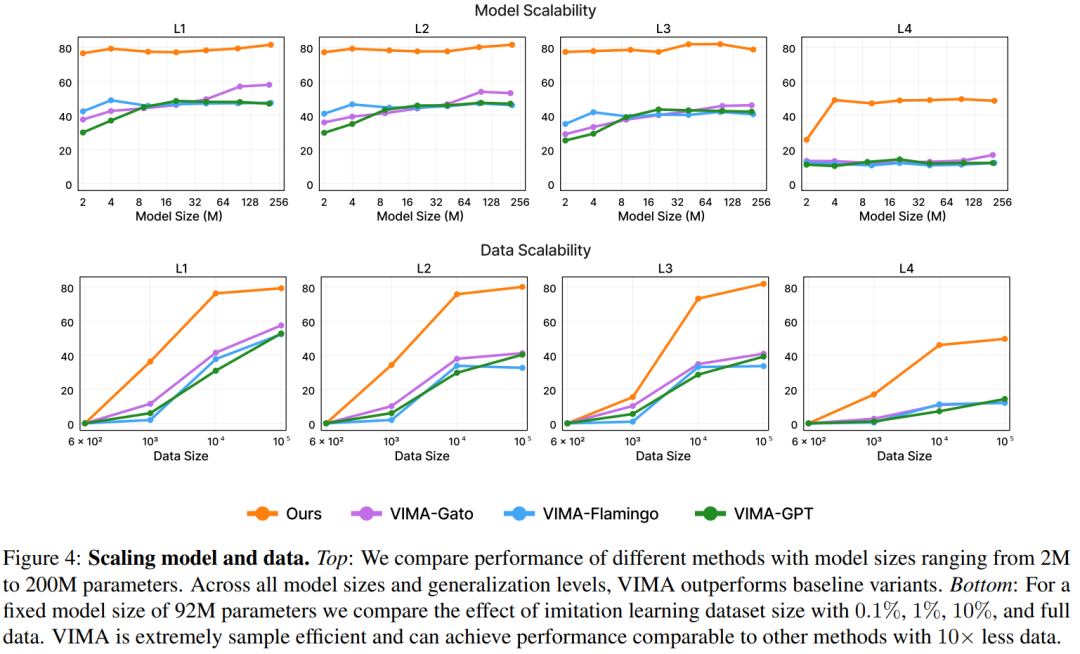

為了證明 VIMA 具有可擴(kuò)展性,該研究訓(xùn)練了 7 個(gè)模型,參數(shù)范圍從 2M 到 200M 不等。結(jié)果表明本文方法優(yōu)于其他設(shè)計(jì)方案,比如圖像 patch token、圖像感知器和僅解碼器條件化(decoder-only conditioning)。在四個(gè)零樣本泛化級別和所有模型容量上,VIMA 都獲得了一致的性能提升,有些情況下提升幅度很大,例如在相同的訓(xùn)練數(shù)據(jù)量下,VIMA 任務(wù)成功率提高到最多 2.9 倍,在數(shù)據(jù)量減少 10 倍的情況下,VIMA 性能提高到 2.7 倍。

為了確保可復(fù)現(xiàn)性并促進(jìn)社區(qū)未來的研究工作,該研究還開源了仿真環(huán)境、訓(xùn)練數(shù)據(jù)集、算法代碼和預(yù)訓(xùn)練模型的 checkpoint。

方法介紹

本文旨在構(gòu)建一個(gè)機(jī)器人智能體,該智能體可以執(zhí)行多模態(tài) prompt 任務(wù)。本文提出的 VIMA 兼具多任務(wù)編碼器 - 解碼器架構(gòu)以及以對象為中心的設(shè)計(jì)。VIMA 的架構(gòu)圖如下:

VIMA 完整的演示流程:

具體到細(xì)節(jié),首先是輸入 prompt,VIMA 包含 3 種格式:文本、包含單個(gè)對象的圖像、包含全場景的圖像。

- 對于輸入文本,該研究使用預(yù)訓(xùn)練的 T5 tokenizer 和詞嵌入來獲取詞 token;

- 對于全場景圖像,該研究首先使用領(lǐng)域微調(diào) Mask R-CNN 提取單個(gè)對象。每個(gè)對象通過 bounding box 和裁剪的圖像來表示,之后分別使用 bounding box 編碼器和 ViT 對它們進(jìn)行編碼,從而得到對象 token;

- 對于單個(gè)對象的圖像,除了使用虛擬 bounding box,該研究以相同的方式獲得 token。

然后,該研究遵循 Tsimpoukelli 等人的做法,通過預(yù)訓(xùn)練的 T5 編碼器對 prompt 進(jìn)行編碼。由于 T5 已在大規(guī)模文本語料庫上進(jìn)行了預(yù)訓(xùn)練,因而 VIMA 繼承了語義理解能力和穩(wěn)健性質(zhì)。為了適應(yīng)來自新模態(tài)的 token,該研究在非文本 token 和 T5 之間插入了 MLP(多層感知機(jī))層。

接著是機(jī)器人控制器。如上圖 3 所示,機(jī)器人控制器(解碼器)通過在 prompt 序列 P 和軌跡歷史序列 H 之間使用一系列交叉注意力層來對其進(jìn)行條件化。

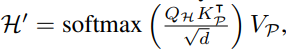

該研究按照 Raffel 等人中的編碼器 - 解碼器約定,從 prompt 中計(jì)算關(guān)鍵鍵序列 K_P 和值序列 V_P,同時(shí)從軌跡歷史中查詢 Q_H。然后,每個(gè)交叉注意力層生成一個(gè)輸出序列 ,其中 d 是嵌入維度。為了將高層與輸入的軌跡歷史序列相連接,該研究還添加了殘差連接。

,其中 d 是嵌入維度。為了將高層與輸入的軌跡歷史序列相連接,該研究還添加了殘差連接。

研究中還用到了交叉注意力層,其具有三個(gè)優(yōu)勢:1)加強(qiáng)與 prompt 的連接;2)保持原始 prompt token 的完整和深入流動(dòng);3)更好的計(jì)算效率。VIMA 解碼器由 L 個(gè)交替的交叉注意力層和自注意力層組成。最后,該研究遵循 Baker 等人的做法,將預(yù)測的動(dòng)作 token 映射到機(jī)械臂離散姿態(tài)。

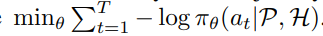

最后是訓(xùn)練。該研究采用行為克隆(behavioral cloning)訓(xùn)練模型。具體而言,對于一個(gè)包含 T 個(gè)步驟的軌跡,研究者需要優(yōu)化函數(shù) 。整個(gè)訓(xùn)練過程在一個(gè)離線數(shù)據(jù)集上進(jìn)行,期間沒有訪問仿真器。為了使 VIMA 更具魯棒性,該研究采用了對象增強(qiáng)技術(shù),即隨機(jī)注入 false-positive 檢測輸出。訓(xùn)練完成后,該研究選擇模型 checkpoint 進(jìn)行評估。

。整個(gè)訓(xùn)練過程在一個(gè)離線數(shù)據(jù)集上進(jìn)行,期間沒有訪問仿真器。為了使 VIMA 更具魯棒性,該研究采用了對象增強(qiáng)技術(shù),即隨機(jī)注入 false-positive 檢測輸出。訓(xùn)練完成后,該研究選擇模型 checkpoint 進(jìn)行評估。

實(shí)驗(yàn)

實(shí)驗(yàn)旨在回答以下三個(gè)問題:

- 基于多模態(tài) prompt,構(gòu)建多任務(wù)的、基于 transformer 的機(jī)器人智能體的最佳方案是什么?

- 本文方法在模型容量和數(shù)據(jù)大小方面的縮放特性是什么?

- 不同的組件,如視覺 tokenizers、prompt 條件和 prompt 編碼,如何影響機(jī)器人的性能?

下圖(上部)比較了不同模型大小(參數(shù)范圍從 2M 到 200M)的性能,結(jié)果表明,VIMA 在性能上明顯優(yōu)于其他方法。盡管像 VIMA-Gato 和 VIMA-Flamingo 這樣的模型在較大的模型大小下表現(xiàn)有所提升,但 VIMA 在所有模型大小上始終表現(xiàn)出優(yōu)異的性能。

下圖(底部)固定模型大小為 92M,比較了不同數(shù)據(jù)集大小(0.1%、1%、10% 和完整數(shù)據(jù))帶來的影響。結(jié)果表明,VIMA 具有極高的樣本效率,可以在數(shù)據(jù)為原來 1/10 的情況下實(shí)現(xiàn)與其他方法相當(dāng)?shù)男阅堋?/span>

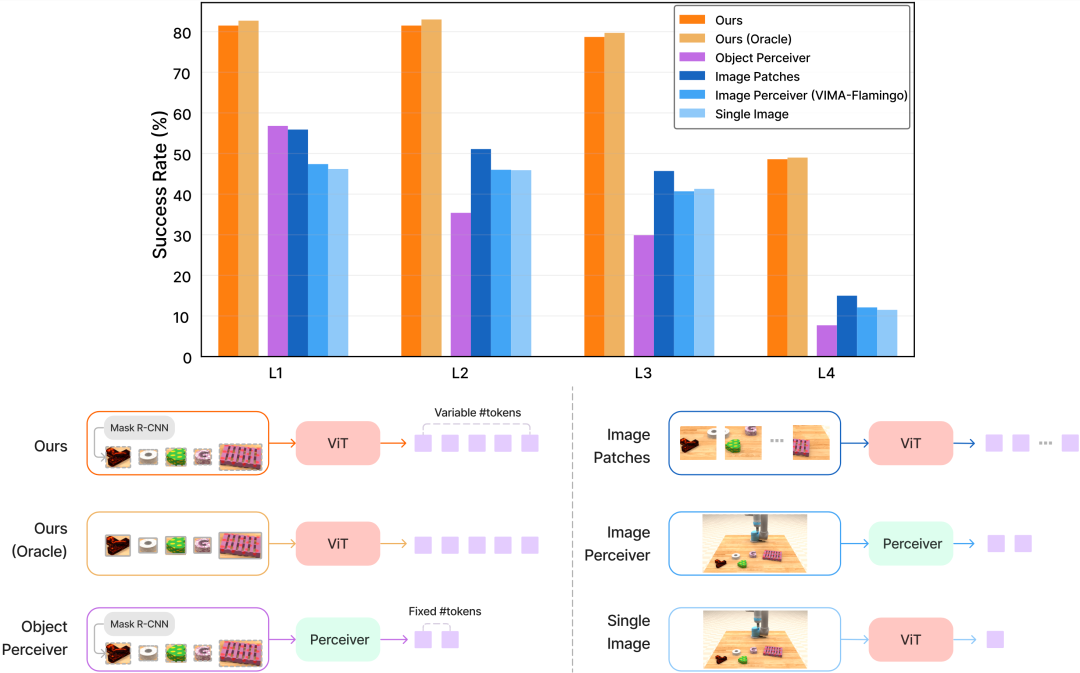

對視覺 tokenizer 的消融研究:下圖比較了 VIMA-200M 模型在不同視覺 tokenizer 上的性能。結(jié)果表明,本文提出的對象 token 優(yōu)于所有直接從原始像素學(xué)習(xí)的方法,此外,這種方法還優(yōu)于 Object Perceiver 方法。

下圖表明,交叉注意力在低參數(shù)狀態(tài)和較難的泛化任務(wù)中特別有用。