賈佳亞團隊提出LISA大模型:理解人話「分割一切」,在線可玩

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯(lián)系出處。

分割一切這事,又有一項重磅研究入局。

香港中文大學終身教授賈佳亞團隊,最新提出LISA大模型——理解人話,精準分割。

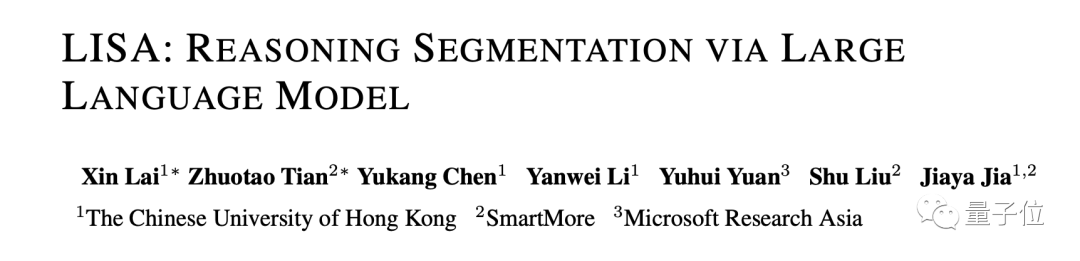

例如讓AI看一張早餐圖,要識別“哪個是橙子”是比較容易的,但若是問一句“哪個食物維他命C最高”呢?

畢竟這不是一個簡單分割的任務了,而是需要先認清圖中的每個食物,還要對它們的成分有所了解。

但現(xiàn)在,對于這種人類復雜的自然語言指令,AI已經是沒有在怕的了,來看下LISA的表現(xiàn):

不難看出,LISA精準無誤的將橘子分割了出來。

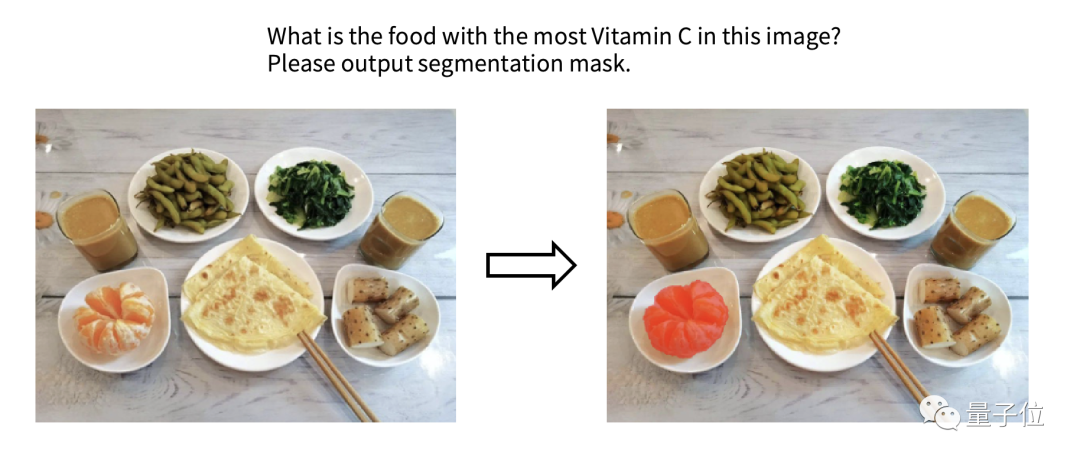

再“投喂”LISA一張圖并提問:

是什么讓這位女士站的更高?請把它分割出來并解釋原因。

從結果上來看,LISA不僅識別出來了“梯”,而且也對問題做出了解釋。

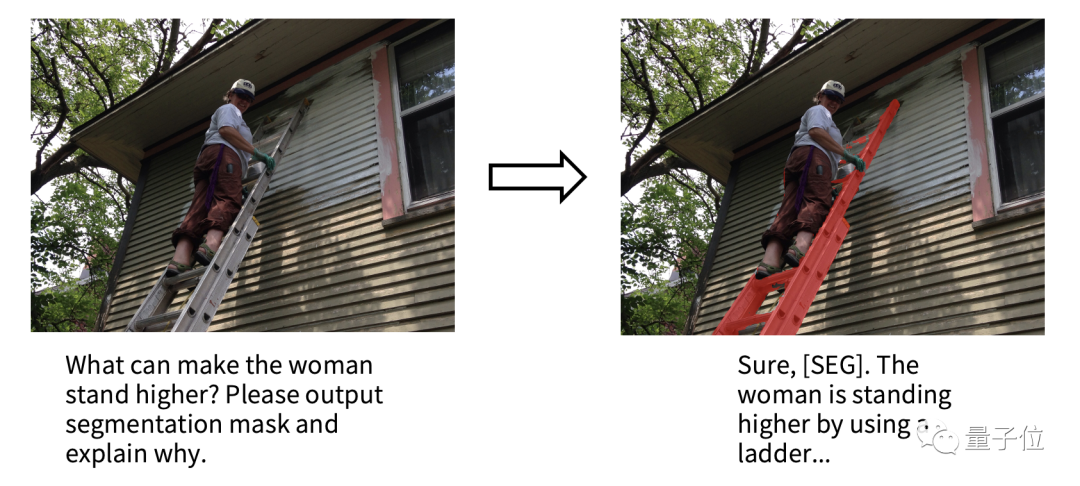

還有一個更有意思的例子。

許多朋友在看到這個大模型的名字,或許會聯(lián)想到女子組合BLACK PINK里的Lisa。

賈佳亞團隊還真拿她們的照片做了個測試——讓LISA找Lisa:

不得不說,會玩!

基于LISA,復雜分割任務拿下SOTA

根據(jù)發(fā)布的論文來看,LISA是一個多模態(tài)大模型,它在這次研究中主攻的任務便是推理分割(Reasoning Segmentation)。

這個任務要求模型能夠處理復雜的自然語言指令,并給出精細的分割結果。

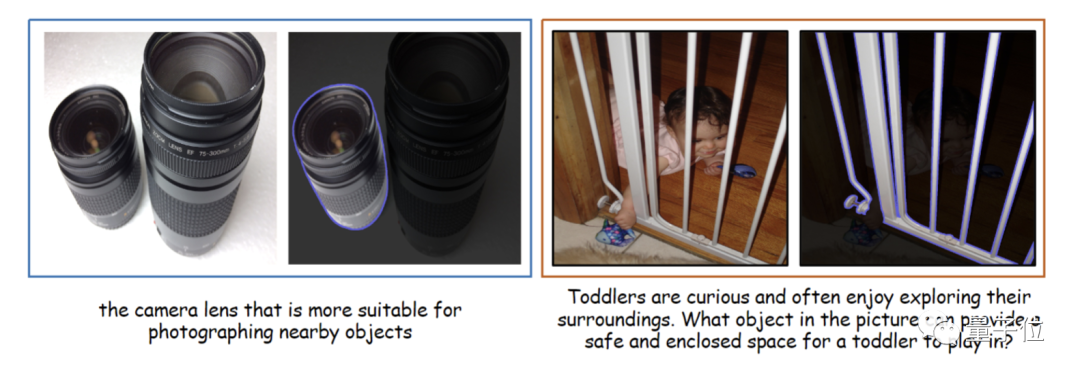

如上圖所示,推理分割任務具有很大的挑戰(zhàn)性,可能需要借鑒世界知識(例如,左圖需要了解“短鏡頭更適合拍攝近物體”),或進行復雜圖文推理(如右圖需要分析圖像和文本語義,才能理解圖中“柵欄保護嬰兒”的含義),才能獲得最終理想的分割結果。

盡管當前多模態(tài)大模型(例如Flamingo[1], BLIP-2[2], LLaVA[3], miniGPT-4[4], Otter[5])使得AI能夠根據(jù)圖像內容推理用戶的復雜問題,并給出相應的文本分析和回答,但仍無法像視覺感知系統(tǒng)那樣在圖像上精確定位指令對應的目標區(qū)域。

因此,LISA通過引入一個<SEG>標記來擴展初始大型模型的詞匯表,并采用Embedding-as-Mask的方式賦予現(xiàn)有多模態(tài)大型模型分割功能,最終展現(xiàn)出強大的零樣本泛化能力。

同時,這項工作還創(chuàng)建了ReasonSeg數(shù)據(jù)集,其中包含上千張高質量圖像及相應的推理指令和分割標注。

那么LISA這種精準理解人話的分割能力,具體是如何實現(xiàn)的呢?

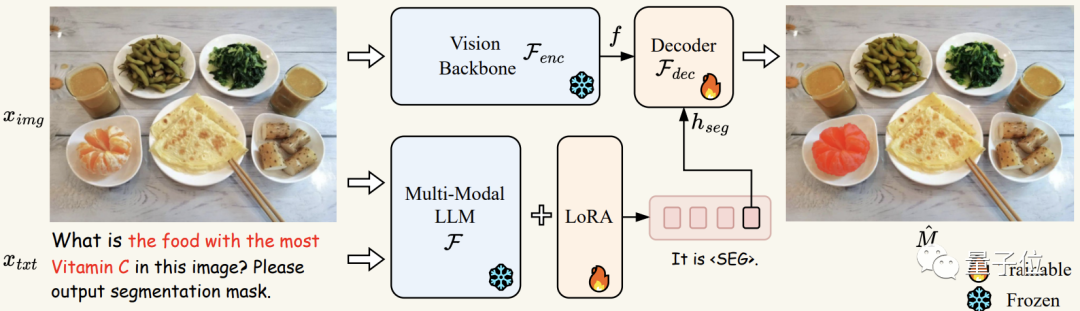

首先將圖像ximg和文本xtxt送到多模態(tài)-大語言模型F(在實驗中即LLaVA),得到輸出的文本結果,如果此時文本結果包含<SEG>標記,則表示需要通過輸出分割預測來解決當前問題。反之,若不包含<SEG>標記,則無分割結果輸出。

如果存在標記,則將<SEG>標記在多模態(tài)大模型F最后一層對應的embedding經過一個MLP層得到hseg,并將其與分割視覺特征f一起傳遞給解碼器Fdec(其中分割視覺特征f由輸入編碼器Fenc對圖像ximg進行編碼得到)。

最終,F(xiàn)dec根據(jù)生成最終的分割結果M。

LISA在訓練過程中使用了自回歸交叉熵損失函數(shù),以及對分割結果監(jiān)督的BCE和DICE損失函數(shù)。

實驗證明,在訓練過程中僅使用不包含復雜推理的分割數(shù)據(jù)(通過將現(xiàn)有的語義分割數(shù)據(jù)如ADE20K[6],COCO-Stuff[7]以及現(xiàn)有指代分割數(shù)據(jù)refCOCO系列[8]中的每條數(shù)據(jù)轉換成“圖像-指令-分割Mask”三元組) ,LISA能在推理分割任務上展現(xiàn)出優(yōu)異的零樣本泛化能力。

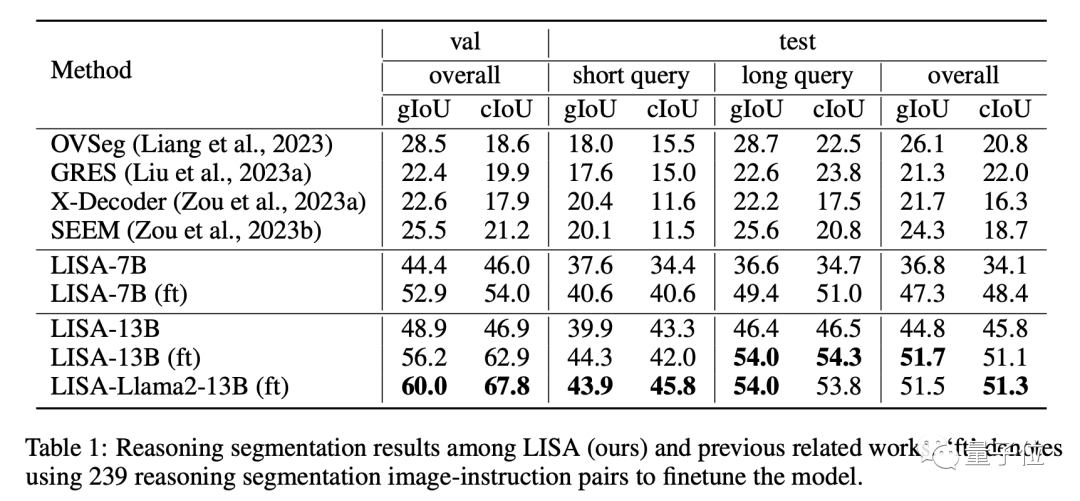

此外,進一步使用239個推理分割數(shù)據(jù)進行微調訓練還能顯著提升LISA在推理分割任務上的性能。而且LISA還表現(xiàn)出高效的訓練特性,只需在8張具有24GB顯存的3090顯卡上進行10,000次訓練迭代,即可完成7B模型的訓練。

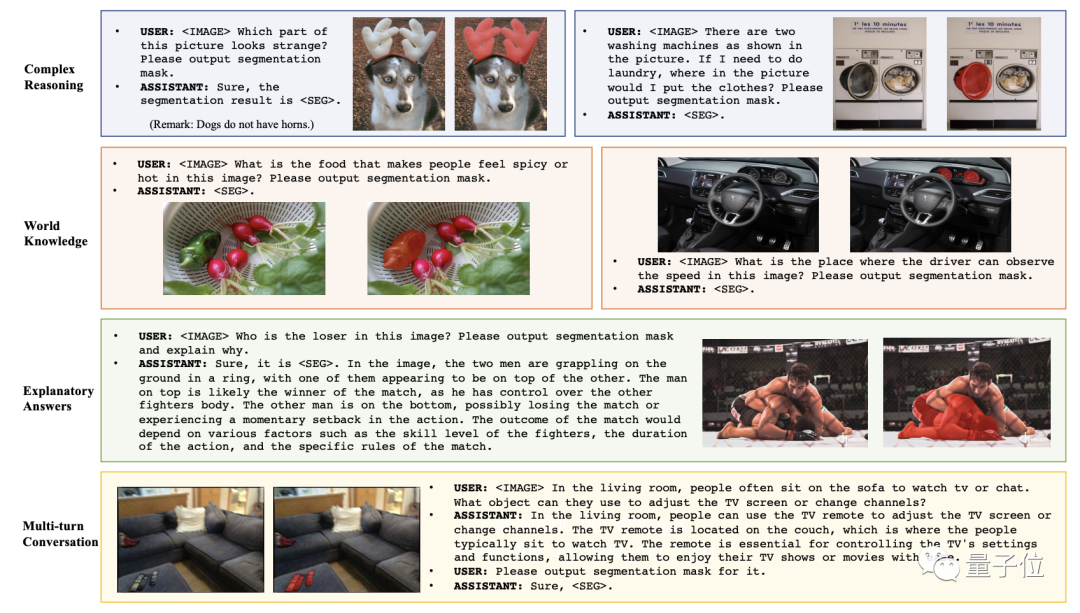

最終,LISA不僅在傳統(tǒng)的語言-圖像分割指標(refCOCO、refCOCO+和refCOCOg)上展現(xiàn)出優(yōu)異性能,還能處理以下分割任務情景:⑴復雜推理;⑵聯(lián)系世界知識;⑶解釋分割結果以及⑷多輪對話。

在有復雜情景的ReasonSeg數(shù)據(jù)集上,LISA顯著領先于其他相關工作,進一步證明其出色的推理分割能力。

在線可玩

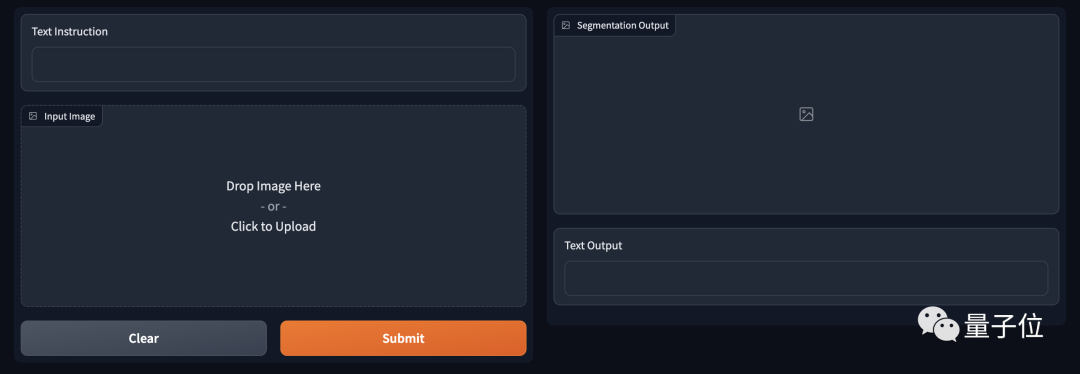

值得一提的是,LISA的推理分割能力已經出了demo,可以在線體驗的那種。

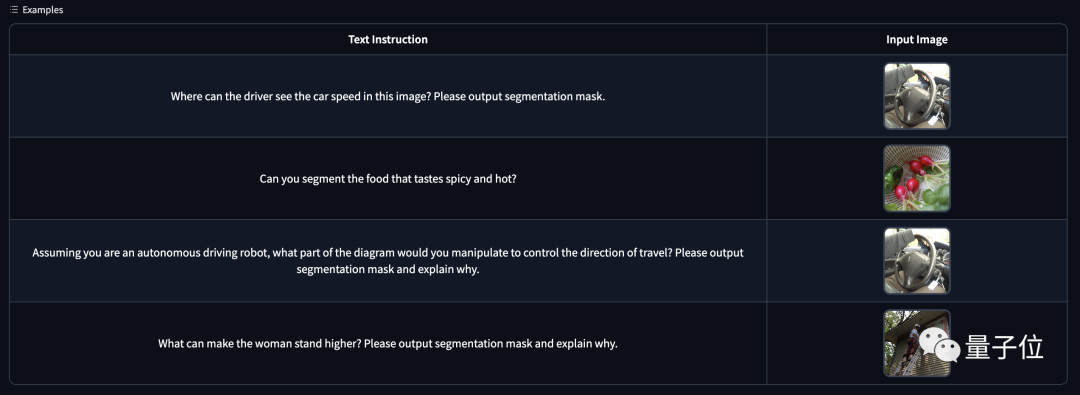

操作也極其簡單,只需填寫“指令”,然后上傳要處理的圖像即可。

若是不會描述指令,Demo下方也給出了一些示例,小伙伴們也可以參照一下。

GitHub地址:https://github.com/dvlab-research/LISA

論文地址:https://arxiv.org/pdf/2308.00692.pdf

Demo地址:http://103.170.5.190:7860/