剛剛,Meta開源「分割一切」2.0模型,視頻也能分割了

還記得 Meta 的「分割一切模型」嗎?這個模型在去年 4 月發布,被很多人認為是顛覆傳統 CV 任務的研究。

時隔一年多,剛剛,Meta 在 SIGGRAPH 上重磅宣布 Segment Anything Model 2 (SAM 2) 來了。在其前身的基礎上,SAM 2 的誕生代表了領域內的一次重大進步 —— 為靜態圖像和動態視頻內容提供實時、可提示的對象分割,將圖像和視頻分割功能統一到一個強大的系統中。

SAM 2 可以分割任何視頻或圖像中的任何對象 —— 甚至是它以前沒有見過的對象和視覺域,從而支持各種不同的用例,而無需自定義適配。

在與黃仁勛的對話中,扎克伯格提到了 SAM 2:「能夠在視頻中做到這一點,而且是在零樣本的前提下,告訴它你想要什么,這非常酷。」

Meta 多次強調了最新模型 SAM 2 是首個用于實時、可提示的圖像和視頻對象分割的統一模型,它使視頻分割體驗發生了重大變化,并可在圖像和視頻應用程序中無縫使用。SAM 2 在圖像分割準確率方面超越了之前的功能,并且實現了比現有工作更好的視頻分割性能,同時所需的交互時間為原來的 1/3。

該模型的架構采用創新的流式內存(streaming memory)設計,使其能夠按順序處理視頻幀。這種方法使 SAM 2 特別適合實時應用,為各個行業開辟了新的可能性。

當然,處理視頻對算力的要求要高得多。SAM 2 仍然是一個龐大的模型,也只有像 Meta 這樣的能提供強大硬件的巨頭才能運行,但這種進步還是說明了一些問題:一年前,這種快速、靈活的分割幾乎是不可能的。SAM 2 可以在不借助數據中心的情況下運行,證明了整個行業在計算效率方面的進步。

模型需要大量的數據來訓練,Meta 還發布了一個大型帶注釋數據庫,包括大約 51,000 個真實世界視頻和超過 600,000 個 masklets。與現有最大的視頻分割數據集相比,其視頻數量多 4.5 倍,注釋多 53 倍,Meta 根據 CC BY 4.0 許可分享 SA-V。在 SAM 2 的論文中,另一個包含超過 100,000 個「內部可用」視頻的數據庫也用于訓練,但沒有公開。

與 SAM 一樣,SAM 2 也會開源并免費使用,并在 Amazon SageMaker 等平臺上托管。為了履行對開源 AI 的承諾,Meta 使用寬松的 Apache 2.0 協議共享代碼和模型權重,并根據 BSD-3 許可分享 SAM 2 評估代碼。

目前,Meta 已經提供了一個 Web 的演示體驗地址:https://sam2.metademolab.com/demo

正如扎克伯格上周在一封公開信中指出的那樣,開源人工智能比任何其他現代技術都更具有潛力,可以提高人類的生產力、創造力和生活質量,同時還能加速經濟增長并推動突破性的醫學和科學研究。人工智能社區利用 SAM 取得的進展給我們留下了深刻的印象, SAM 2 必將釋放更多令人興奮的可能性。

SAM 2 可立即應用于各種各樣的實際用例 - 例如,跟蹤對象(左)或分割顯微鏡捕獲的視頻中的移動細胞以輔助科學研究(右)。

未來,SAM 2 可以作為更大型 AI 系統的一部分,通過 AR 眼鏡識別日常物品,并向用戶提供提醒和說明。

SAM 2 前腳剛上線,大家就迫不及待的用起來了:「在 Meta 未提供的測試視頻上試用 SAM 2。效果好得令人瞠目結舌。」

來源:https://x.com/BenjaminDEKR/status/1818066956173664710

還有網友認為,SAM 2 的出現可能會使其他相關技術黯然失色。

如何構建 SAM 2?

SAM 能夠了解圖像中對象的一般概念。然而,圖像只是動態現實世界的靜態快照。許多重要的現實用例需要在視頻數據中進行準確的對象分割,例如混合現實、機器人、自動駕駛車輛和視頻編輯。Meta 認為通用的分割模型應該適用于圖像和視頻。

圖像可以被視為具有單幀的非常短的視頻。Meta 基于這個觀點開發了一個統一的模型,無縫支持圖像和視頻輸入。處理視頻的唯一區別是,模型需要依靠內存來調用該視頻之前處理的信息,以便在當前時間步準確地分割對象。

視頻中對象的成功分割需要了解實體在空間和時間上的位置。與圖像分割相比,視頻提出了重大的新挑戰。對象運動、變形、遮擋、光照變化和其他因素可能會因幀而異。由于攝像機運動、模糊和分辨率較低,視頻的質量通常低于圖像,這增加了難度。因此,現有的視頻分割模型和數據集在為視頻提供可比的「分割任何內容」功能方面存在不足。

Meta 構建 SAM 2 和新 SA-V 數據集來解決這些挑戰。

與用于 SAM 的方法類似,Meta 對視頻分割功能的研究涉及設計新任務、模型和數據集。

研究團隊首先開發了可提示的(promptable)視覺分割任務并設計了一個能夠執行該任務的模型 ——SAM 2。

然后,研究團隊使用 SAM 2 來幫助創建視頻對象分割數據集 ——SA-V,該數據集比當前存在的任何數據集大一個數量級。研究團隊使用它來訓練 SAM 2 以實現 SOTA 性能。

可提示的視覺分割

研究團隊設計了一個可提示的視覺分割任務,將圖像分割任務推廣到視頻領域。SAM 經過訓練,以圖像中的輸入點、框或掩碼來定義目標對象并預測分割掩碼。該研究訓練 SAM 2 在視頻的任何幀中獲取輸入提示來定義要預測的時空掩碼(即「masklet」)。

SAM 2 根據輸入提示立即預測當前幀上的掩碼,并將其臨時傳播(temporally propagate)以生成跨所有視頻幀的目標對象的 masklet。一旦預測出初始 masklet,就可以通過在任何幀中向 SAM 2 提供附加提示來迭代完善它。這可以根據需要重復多次,直到獲得所需的 masklet。

統一架構中的圖像和視頻分割

SAM 2 架構可以看作是 SAM 從圖像領域到視頻領域的推廣。

SAM 2 可以通過點擊、邊界框或掩碼被提示,以定義給定幀中對象的范圍。輕量級掩碼解碼器采用當前幀的圖像嵌入和編碼提示來輸出該幀的分割掩碼。在視頻設置中,SAM 2 將此掩碼預測傳播到所有視頻幀以生成 masklet,然后在任何后續幀上迭代添加提示以細化 masklet 預測。

為了準確預測所有視頻幀的掩碼,研究團隊引入了一種由記憶編碼器、記憶庫(memory bank)和記憶注意力模塊組成的記憶機制。當應用于圖像時,內存組件為空,模型的行為類似于 SAM。對于視頻,記憶組件能夠存儲關于該會話中的對象和先前用戶交互的信息,從而允許 SAM 2 在整個視頻中生成 masklet 預測。如果在其他幀上提供了額外的提示,SAM 2 可以根據對象存儲的記憶上下文有效地糾正其預測。

幀的記憶由記憶編碼器根據當前掩碼預測創建,并放置在記憶庫中以用于分割后續幀。記憶庫由先前幀和提示幀的記憶組成。記憶注意力操作從圖像編碼器獲取每幀嵌入,并根據記憶庫進行調整以產生嵌入,然后將其傳遞到掩碼解碼器以生成該幀的掩碼預測。對于所有后續幀重復此操作。

Meta 采用流式架構,這是 SAM 在視頻領域的自然推廣,一次處理一個視頻幀并將有關分割對象的信息存儲在記憶中。在每個新處理的幀上,SAM 2 使用記憶注意力模塊來關注目標對象之前的記憶。這種設計允許實時處理任意長的視頻,這不僅對于 SA-V 數據集的注釋收集效率很重要,而且對于現實世界的應用(例如在機器人領域)也很重要。

當圖像中被分割的對象存在模糊性時,SAM 會輸出多個有效掩碼。例如,當一個人點擊自行車輪胎時,模型可以將這次點擊解釋為僅指輪胎或整個自行車,并輸出多個預測。在視頻中,這種模糊性可能會擴展到視頻幀中。例如,如果在一幀中只有輪胎可見,則輪胎上的點擊可能僅與輪胎相關,或者隨著自行車的更多部分在后續幀中變得可見,這種點擊可能是針對整個自行車的。為了處理這種模糊性,SAM 2 在視頻的每個步驟創建多個掩碼。如果進一步的提示不能解決歧義,模型會選擇置信度最高的掩碼,以便在視頻中進一步傳播。

在圖像分割任務中,在給定積極提示的情況下,幀中始終存在可分割的有效對象。在視頻中,特定幀上可能不存在有效對象,例如由于對象被遮擋或從視圖中消失。為了解釋這種新的輸出模式,研究團隊添加了一個額外的模型輸出(「遮擋 head(occlusion head)」),用于預測當前幀中是否存在感興趣的對象。這使得 SAM 2 能夠有效地處理遮擋。

SA-V:Meta 構建了最大的視頻分割數據集

來自 SA-V 數據集的視頻和掩碼注釋。

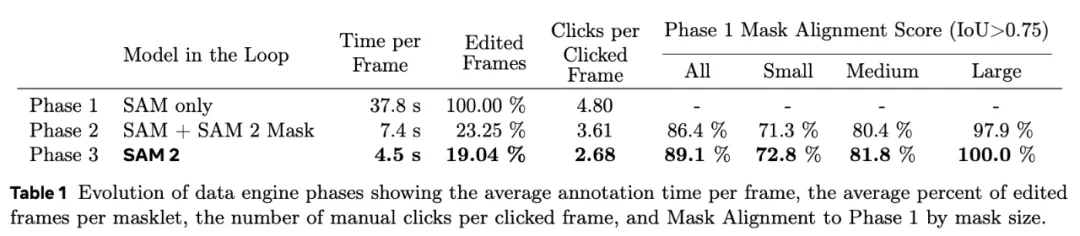

為了收集一個大型且多樣化的視頻分割數據集,Meta 建立了一個數據引擎,其中注釋員使用 SAM 2 交互地在視頻中注釋 masklet,然后將新注釋的數據用于更新 SAM 2。他們多次重復這一循環,以迭代地改進模型和數據集。與 SAM 類似,Meta 不對注釋的 masklet 施加語義約束,注重的是完整的物體(如人)和物體的部分(如人的帽子)。

借助 SAM 2,收集新的視頻對象分割掩碼比以往更快,比每幀使用 SAM 快約 8.4 倍。此外,Meta 發布的 SA-V 數據集的注釋數量是現有視頻對象分割數據集的十倍以上,視頻數量大約是其 4.5 倍。

總結而言,SA-V 數據集的亮點包括:

- 在大約 51,000 個視頻中有超過 600,000 個 masklet 注釋;

- 視頻展示了地理上不同的真實場景,收集自 47 個國家;

- 覆蓋整個對象、對象中的一部分,以及在物體被遮擋、消失和重新出現的情況下具有挑戰性的實例。

結果

下方兩個模型都是用第一幀中的 T 恤蒙版初始化的。對于 baseline,Meta 使用來自 SAM 的蒙版,問題是過度分割并包括人的頭部,而不是僅跟蹤 T 恤。相比之下,SAM 2 能夠在整個視頻中準確跟蹤對象部分。

為了創建統一的圖像和視頻分割模型,Meta 將圖像視為單幀視頻,在圖像和視頻數據上聯合訓練 SAM 2。團隊利用了去年作為 Segment Anything 項目的一部分發布的 SA-1B 圖像數據集、SA-V 數據集以及額外的內部許可視頻數據集。

SAM 2(右)提高了 SAM(左)圖像中的對象分割精度。

SAM 2 論文也展示了該模型的多項提升:

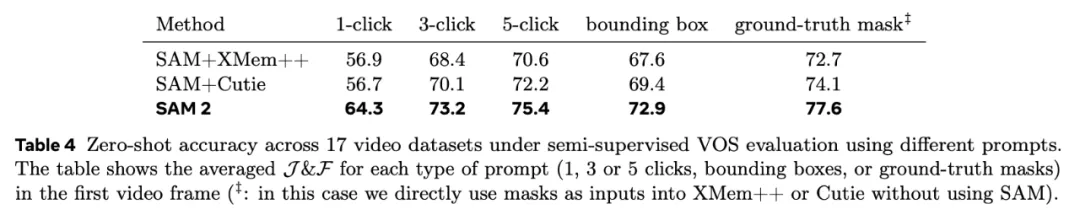

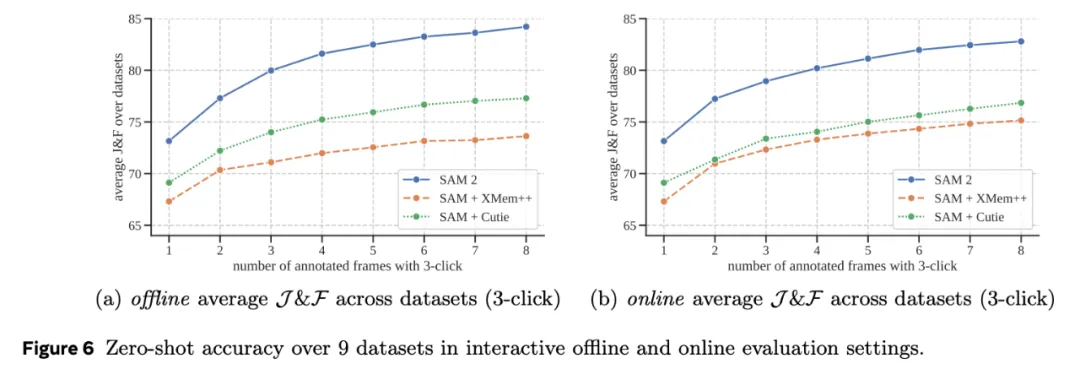

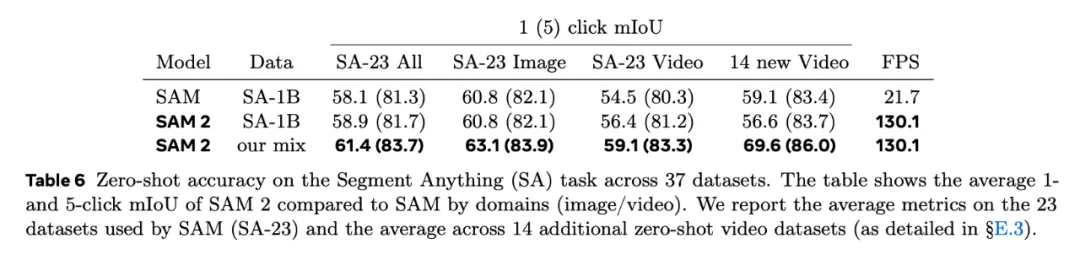

SAM 2 在 17 個零樣本視頻數據集的交互式視頻分割方面表現明顯優于以前的方法,并且所需的人機交互減少了大約三倍。

SAM 2 在 23 個數據集零樣本基準測試套件上的表現優于 SAM,而且速度快了六倍。

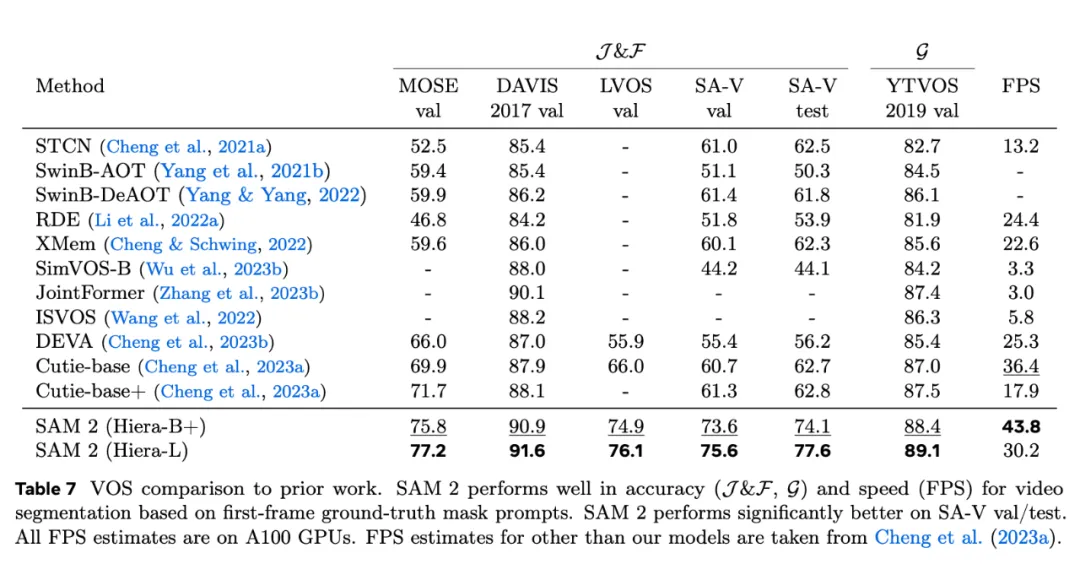

與之前的最先進模型相比,SAM 2 在現有的視頻對象分割基準(DAVIS、MOSE、LVOS、YouTube-VOS)上表現出色。

使用 SAM 2 進行推理感覺很實時,速度大約為每秒 44 幀。

循環中使用 SAM 2 進行視頻分割注釋的速度比使用 SAM 進行手動每幀注釋快 8.4 倍。

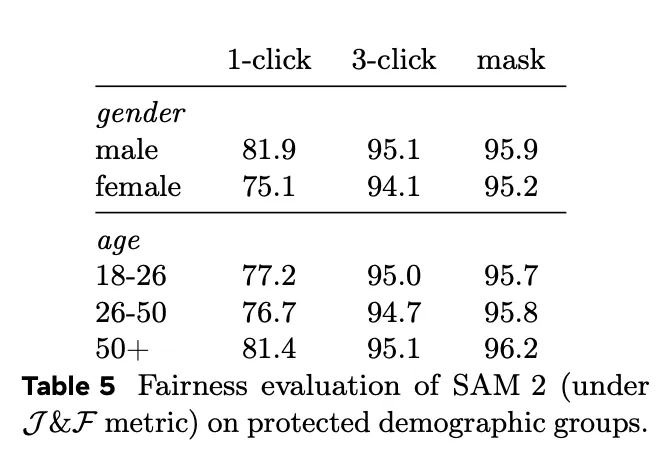

為了衡量 SAM 2 的公平性,Meta 對特定人群的模型性能進行了評估。結果表明,在感知性別和 18-25 歲、26-50 歲和 50 歲以上三個感知年齡組評估中,模型顯示的差異很小。

更多結果,請查看論文。

論文地址:https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/453323338_287900751050452_6064535069828837026_n.pdf?_nc_cat=107&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=TnvI-AaGawoQ7kNvgFJPdfC&_nc_ht=scontent-sjc3-1.xx&oh=00_AYAlCBmHCcIEnDo-YzzCScg8NZPgTQlwjE9FVlniLRw5JQ&oe=66AE2179

局限性

雖然 SAM 2 在分割圖像和短視頻中的對象方面表現出色,但仍然會遇到諸多挑戰。

SAM 2 可能會在攝像機視角發生劇烈變化、長時間遮擋、擁擠的場景或較長的視頻中失去對對象的追蹤。

在實際應用中,Meta 設計了交互式模型來緩解這一問題,并通過在任意幀中點擊校正來實現人工干預,從而恢復目標對象。

在擁擠的場景中,SAM 2 有時會混淆多個外觀相似的對象。

當目標對象只在一幀中指定時,SAM 2 有時會混淆對象,無法正確分割目標,如上述視頻中的馬匹所示。在許多情況下,通過在未來幀中進行額外的細化提示,這一問題可以完全解決,并在整個視頻中獲得正確的 masklet。

雖然 SAM 2 支持同時分割多個單獨對象的功能,但模型的效率卻大大降低。實際上,SAM 2 對每個對象進行單獨處理,只利用共享的每幀嵌入,不進行對象間通信。雖然這簡化了模型,但納入共享的對象級上下文信息有助于提高效率。

SAM 2 的預測可能會錯過快速移動對象的細節。

對于復雜的快速運動對象,SAM 2 有時會漏掉一些細節,而且預測結果在幀之間可能不穩定,如上文騎自行車者的視頻所示。

在同一幀或其他幀中添加進一步的提示來優化預測只能部分緩解此問題。在訓練過程中,如果模型預測在幀間抖動,不會對其進行任何懲罰,因此無法保證時間上的平滑性。提高這種能力可以促進需要對精細結構進行詳細定位的實際應用。

雖然 Meta 的數據引擎在循環中使用了 SAM 2,且在自動 masklet 生成方面也取得了長足進步,但仍然依賴人工注釋來完成一些步驟,例如驗證 masklet 質量和選擇需要校正的幀。

因此,未來的發展需要進一步自動化這個數據注釋過程,以提高效率。要推動這項研究,還有很多工作要做。

參考鏈接:

https://ai.meta.com/blog/segment-anything-2-video/。

https://techcrunch.com/2024/07/29/zuckerberg-touts-metas-latest-video-vision-ai-with-nvidia-ceo-jensen-huang/。