3000多條數據里選出200條效果反而更好,MiniGPT-4被配置相同的模型超越了

在生成細節豐富和精確的圖像描述方面,GPT-4 已經展現出了強大超凡的能力,其標志著一個語言和視覺處理新時代的到來。

因此,類似于 GPT-4 的多模態大型語言模型(MLLM)近來異軍突起,成為了一個炙手可熱的新興研究領域,其研究核心是將強大的 LLM 用作執行多模態任務的認知框架。MLLM 出人意料的卓越表現不僅超越了傳統方法,更使其成為了實現通用人工智能的潛在途徑之一。

為了創造出好用的 MLLM,需要使用大規模的配對的圖像 - 文本數據以及視覺 - 語言微調數據來訓練凍結的 LLM(如 LLaMA 和 Vicuna)與視覺表征(如 CLIP 和 BLIP-2)之間的連接器(如 MiniGPT-4、LLaVA 和 LLaMA-Adapter)。

MLLM 的訓練通常分為兩個階段:預訓練階段和微調階段。預訓練的目的是讓 MLLM 獲得大量知識,而微調則是為了教會模型更好地理解人類意圖并生成準確的響應。

為了增強 MLLM 理解視覺 - 語言和遵循指令的能力,近期出現了一種名為指令微調(instruction tuning)的強大微調技術。該技術有助于將模型與人類偏好對齊,從而讓模型在各種不同的指令下都能生成人類期望的結果。在開發指令微調技術方面,一個頗具建設性的方向是在微調階段引入圖像標注、視覺問答(VQA)和視覺推理數據集。InstructBLIP 和 Otter 等之前的技術的做法是使用一系列視覺 - 語言數據集來進行視覺指令微調,也得到了頗具潛力的結果。

但是,人們已經觀察到:常用的多模態指令微調數據集包含大量低質量實例,即其中的響應是不正確或不相關的。這樣的數據具有誤導性,并會對模型的性能表現造成負面影響。

這一問題促使研究人員開始探究這一可能性:能否使用少量高質量的遵循指令數據來獲得穩健的性能表現?

近期的一些研究得到了鼓舞人心的成果,表明這個方向是有潛力的。比如 Zhou et al. 提出了 LIMA ,這是一個使用人類專家精挑細選出的高質量數據微調得到的語言模型。該研究表明,即使使用數量有限的高質量遵循指令數據,大型語言模型也可以得到讓人滿意的結果。所以,研究人員得出結論:在對齊方面,少即是多(Less is More)。然而,對于如何為微調多模態語言模型選擇合適的高質量數據集,之前還沒有一個清晰的指導方針。

上海交通大學清源研究院和里海大學的一個研究團隊填補了這一空白,提出了一個穩健有效的數據選擇器。這個數據選擇器能夠自動識別并過濾低質量視覺 - 語言數據,從而確保模型訓練所使用的都是最相關和信息最豐富的樣本。

論文地址:https://arxiv.org/abs/2308.12067

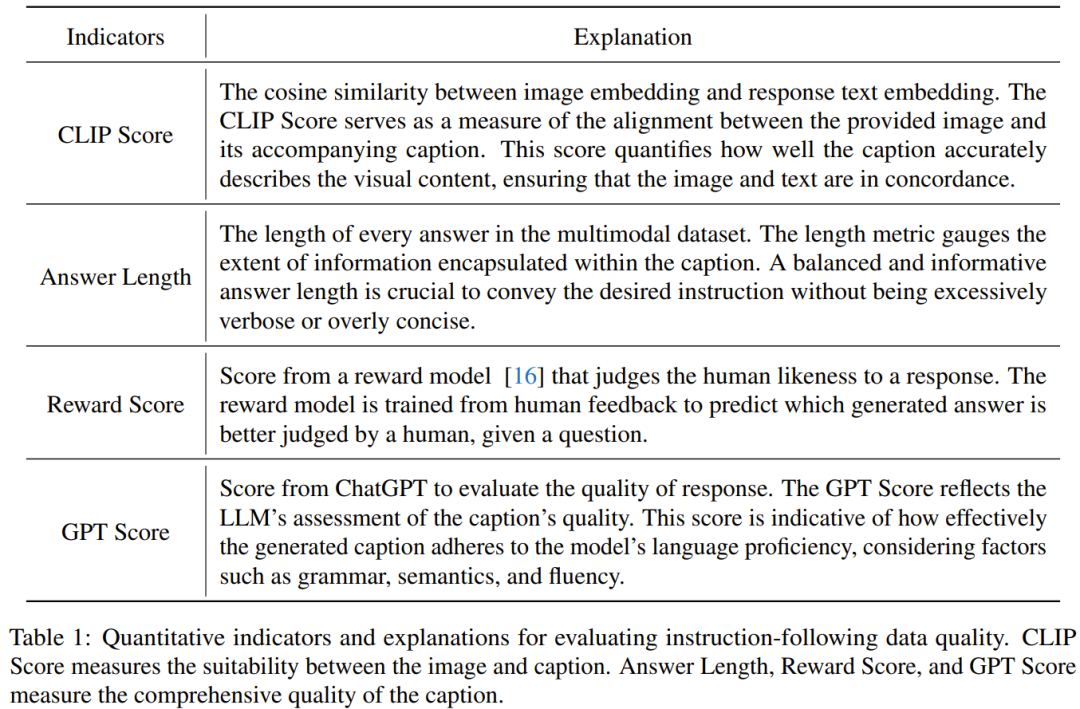

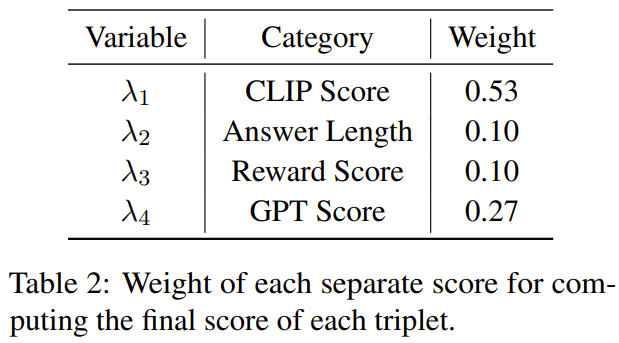

研究者表示,這項研究關注的重點是探索少量但優質的指令微調數據對微調多模態大型語言模型的功效。除此之外,這篇論文還引入了幾個專為評估多模態指令數據的質量而設計的新指標。在圖像上執行譜聚類之后,數據選擇器會計算一個加權分數,其組合了 CLIP 分數、GPT 分數、獎勵分數和每個視覺 - 語言數據的答案長度。

通過在用于微調 MiniGPT-4 所用的 3400 個原始數據上使用該選擇器,研究者發現這些數據大部分都有低質量的問題。使用這個數據選擇器,研究者得到了一個小得多的精選數據子集 —— 僅有 200 個數據,只有原始數據集的 6%。然后他們使用 MiniGPT-4 一樣的訓練配置,微調得到了一個新模型:InstructionGPT-4。

研究者表示這是一個激動人心的發現,因為其表明:在視覺 - 語言指令微調中,數據的質量比數量更重要。此外,這種更加強調數據質量的變革提供了一個能提升 MLLM 微調的更有效的新范式。

研究者進行了嚴格的實驗,對已微調 MLLM 的實驗評估集中于七個多樣化且復雜的開放域多模態數據集,包括 Flick-30k、ScienceQA、 VSR 等。他們在不同的多模態任務上比較了使用不同數據集選取方法(使用數據選擇器、對數據集隨機采樣、使用完整數據集)而微調得到的模型的推理性能,結果展現了 InstructionGPT-4 的優越性。

此外還需說明:研究者用于評估的評價者是 GPT-4。具體而言,研究者使用了 prompt 將 GPT-4 變成了評價者,其可以使用 LLaVA-Bench 中的測試集來比較 InstructionGPT-4 和原始 MiniGPT-4 的響應結果。

結果發現,盡管與 MiniGPT-4 所用的原始指令遵循數據相比,InstructionGPT-4 使用的微調數據僅有 6% 那么一點點,但后者在 73% 的情況下給出的響應都相同或更好。

這篇論文的主要貢獻包括:

- 通過選擇 200 個(約 6%)高質量的指令遵循數據來訓練 InstructionGPT-4,研究者表明可以為多模態大型語言模型使用更少的指令數據來實現更好的對齊。

- 文中提出了一種數據選擇器,其使用了一種可解釋的簡單原則來選取用于微調的高質量多模態指令遵循數據。這種方法力求在數據子集的評估和調整中實現有效性和可移植性。

- 研究者通過實驗表明這種簡單技術能夠很好地應對不同任務。相比于原始的 MiniGPT-4,僅使用 6% 已過濾數據微調得到的 InstructionGPT-4 在多種任務上都取得了更優表現。

方法

這項研究的目標是提出一種簡單且可移植的數據選擇器,使其能自動從原始微調數據集中精選出一個子集。為此,研究者定義了一個選取原則,該原則關注的重點是多模態數據集的多樣化和質量。下面將簡單介紹一下。

選取原則

為了有效地訓練 MLLM,選取有用的多模態指令數據是至關重要的。而為了選出最優的指令數據,研究者提出了兩大關鍵原則:多樣性和質量。對于多樣性,研究者采用的方法是對圖像嵌入進行聚類,以將數據分成不同的組別。為了評估質量,研究者采用了一些用于高效評估多模態數據的關鍵指標。

數據選擇器

給定一個視覺 - 語言指令數據集和一個預訓練 MLLM(如 MiniGPT-4 和 LLaVA),數據選擇器的最終目標是識別出一個用于微調的子集并且使得該子集能為預訓練 MLLM 帶來提升。

為了選出這個子集并確保其多樣性,研究者首先是使用一個聚類算法將原始數據集分成多個類別。

為了確保所選出的多模態指令數據的質量,研究者制定了一套用于評估的指標,如下表 1 所示。

表 2 則給出了在計算最終分數時,每個不同分數的權重。

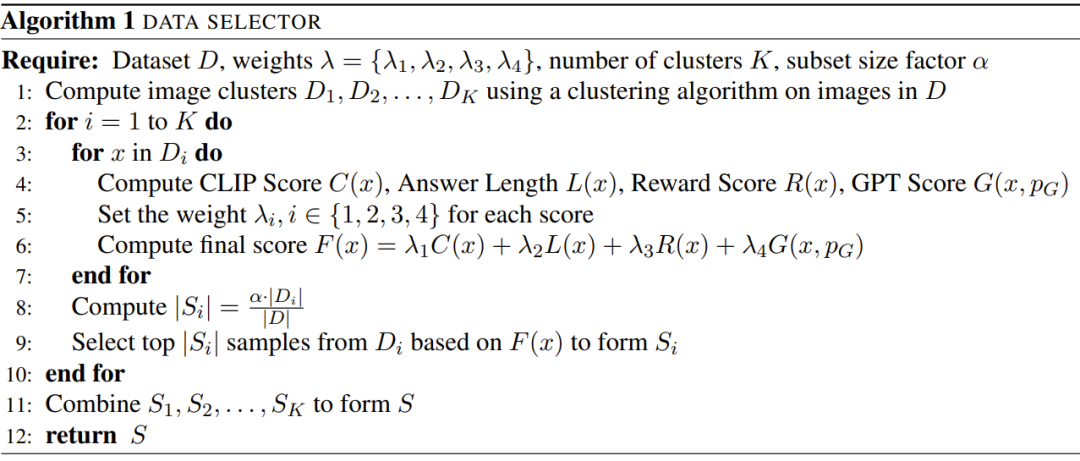

算法 1 展示了數據選擇器的整個工作流程。

實驗

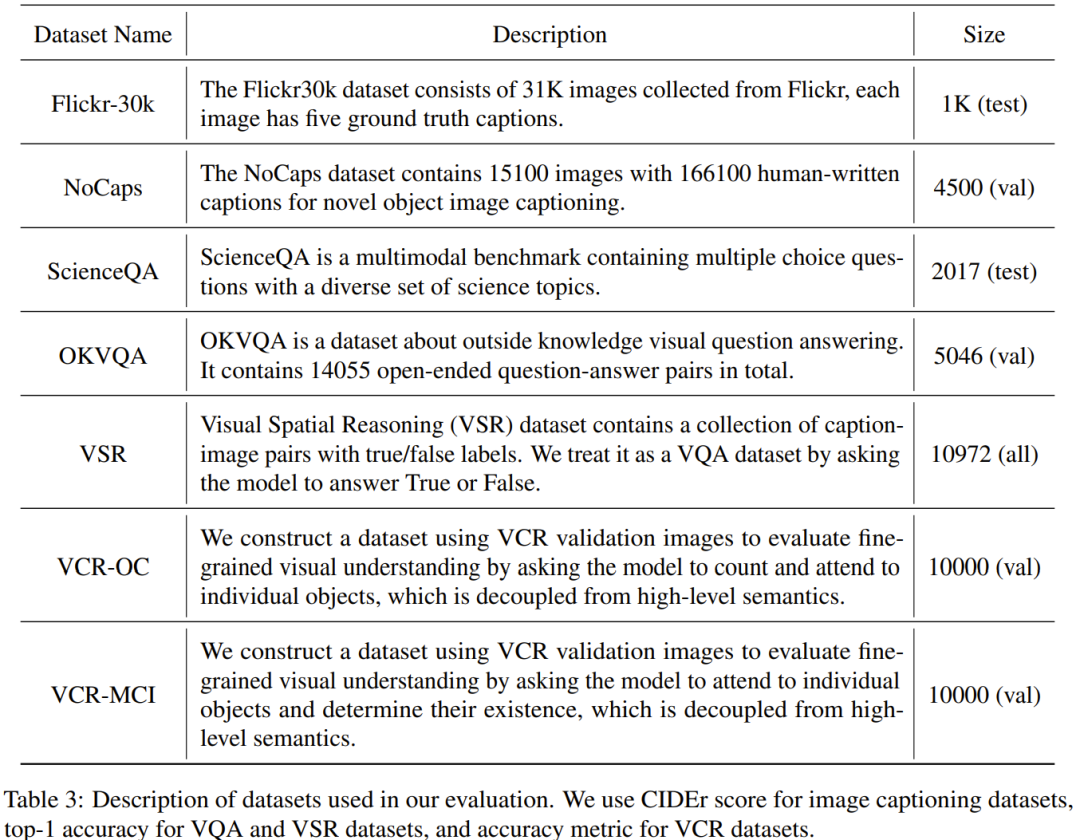

實驗評估中所使用的數據集如下表 3 所示。

基準分數

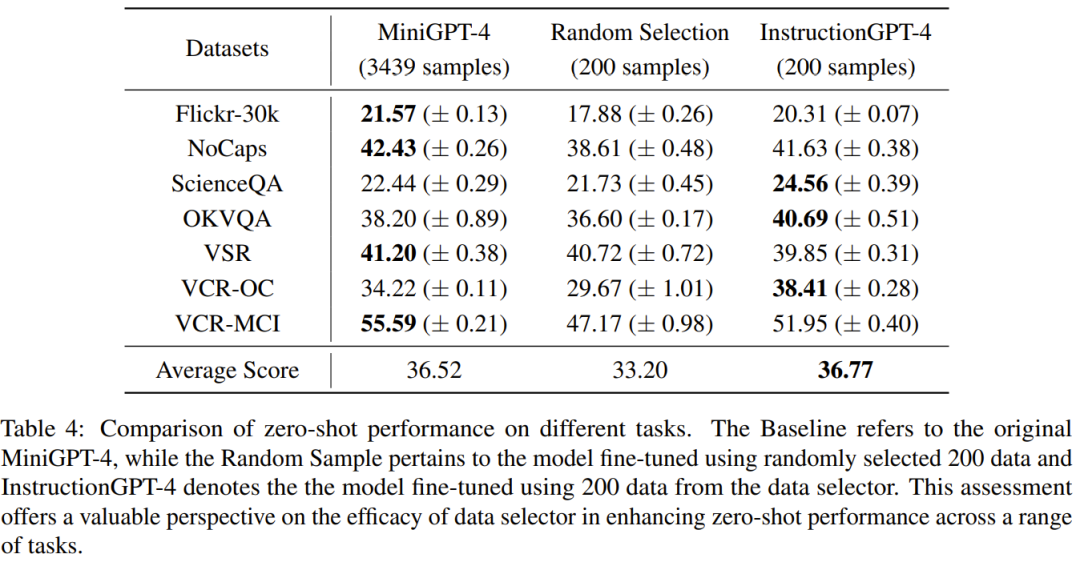

表 4 比較了 MiniGPT-4 基準模型、使用隨機采樣的數據微調得到的 MiniGPT-4 以及使用數據選擇器微調得到的 InstructionGPT-4 的表現。

可以觀察到,InstructionGPT-4 的平均表現是最好的。具體來說,InstructionGPT-4 在 ScienceQA 的表現超過基準模型 2.12%,在 OKVQA 和 VCR-OC 上則分別超過基準模型 2.49% 和 4.19%。

此外,InstructionGPT-4 在除 VSR 之外的所有其它任務上都優于用隨機樣本訓練的模型。通過在一系列任務上評估和對比這些模型,可以辨別出它們各自的能力,并確定新提出的數據選擇器的效能 —— 數據選擇器能有效識別高質量數據。

這樣的全面分析表明:明智的數據選擇可以提升模型在各種不同任務上的零樣本性能。

GPT-4 評估

LLM 本身存在固有的位置偏見,對此可參閱機器之心文章《語言模型悄悄偷懶?新研究:上下文太長,模型會略過中間不看》。因此研究者采取了措施來解決這一問題,具體來說就是同時使用兩種排布響應的順序來執行評估,即將 InstructionGPT-4 生成的響應放在 MiniGPT-4 生成的響應之前或之后。為了制定明確的評判標準,他們采用了「贏-平-輸」(Win-Tie-Lose)框架:

1) 贏:InstructionGPT-4 在兩種情況下都贏或贏一次平一次;

2) 平:InstructionGPT-4 與 MiniGPT-4 平局兩次或贏一次輸一次;

3) 輸:InstructionGPT-4 輸兩次或輸一次平一次。

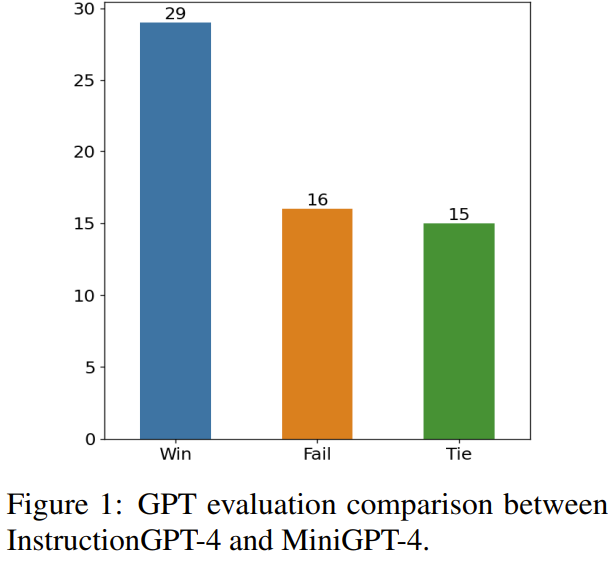

圖 1 展示了這種評估方法的結果。

在 60 個問題上,InstructionGPT-4 贏 29 局,輸 16 局,其余 15 局平局。這足以證明在響應質量上,InstructionGPT-4 明顯優于 MiniGPT-4。

消融研究

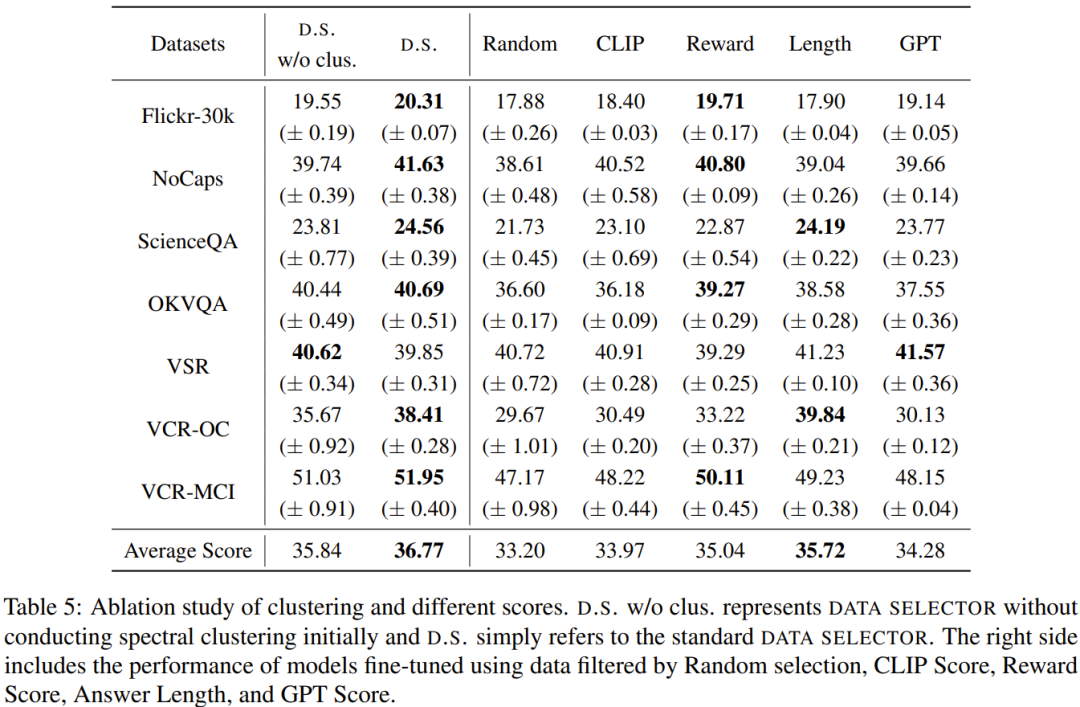

表 5 給出了消融實驗的分析結果,從中可以看出聚類算法和各種評估分數的重要性。

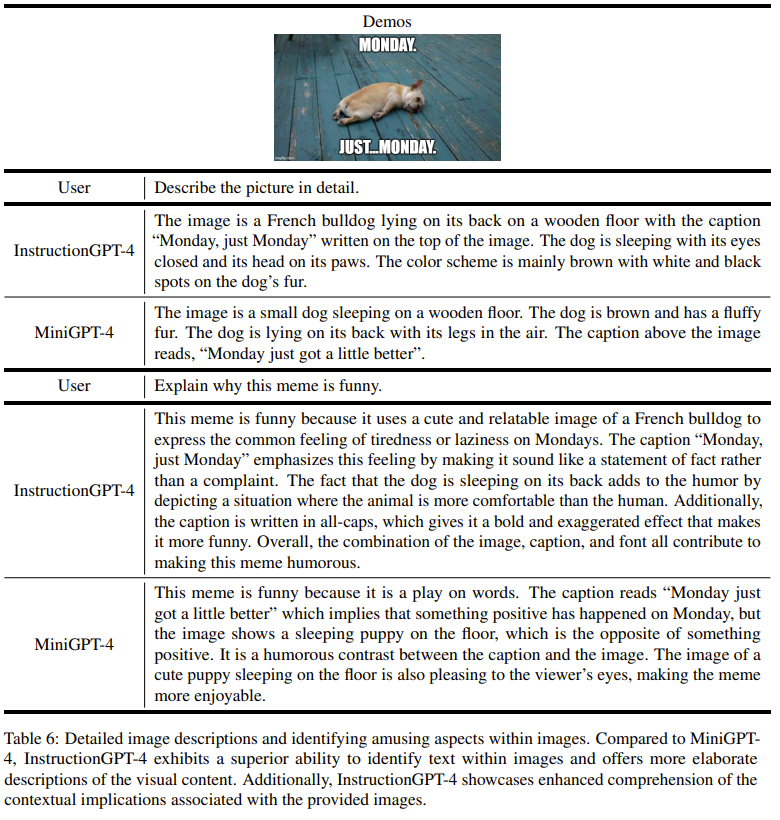

演示

為了深入了解 InstructionGPT-4 在理解視覺輸入和生成合理響應方面的能力,研究者還對 InstructionGPT-4 和 MiniGPT-4 的圖像理解和對話能力進行了對比評估。該分析基于一個顯眼的實例,涉及到對圖像的描述以及進一步的理解,結果見表 6。

InstructionGPT-4 更擅長提供全面的圖像描述和識別圖像中有趣的方面。與 MiniGPT-4 相比,InstructionGPT-4 更有能力識別圖像中存在的文本。在這里,InstructionGPT-4 能夠正確指出圖像中有一個短語:Monday, just Monday.

更多細節請參見原論文。