Meta AI 多語言閱讀理解數據集 Belebele,涵蓋 122 種語言變體

Meta AI 宣布推出一款涵蓋 122 種語言變體的多語言閱讀理解數據集,名為 Belebele。“我們希望這項工作能夠引發圍繞 LLM 多語言性的新討論”。

BELEBELE 是首個跨語言并行數據集,可以直接比較所有語言的模型性能。該數據集涵蓋了 29 種腳本和 27 個語系中不同類型的高、中、低資源語言。此外,還有 7 種語言包含在兩種不同的腳本中,從而為印地語、烏爾都語、孟加拉語、尼泊爾語和僧伽羅語的羅馬化變體制定了首個 NLP 基準。

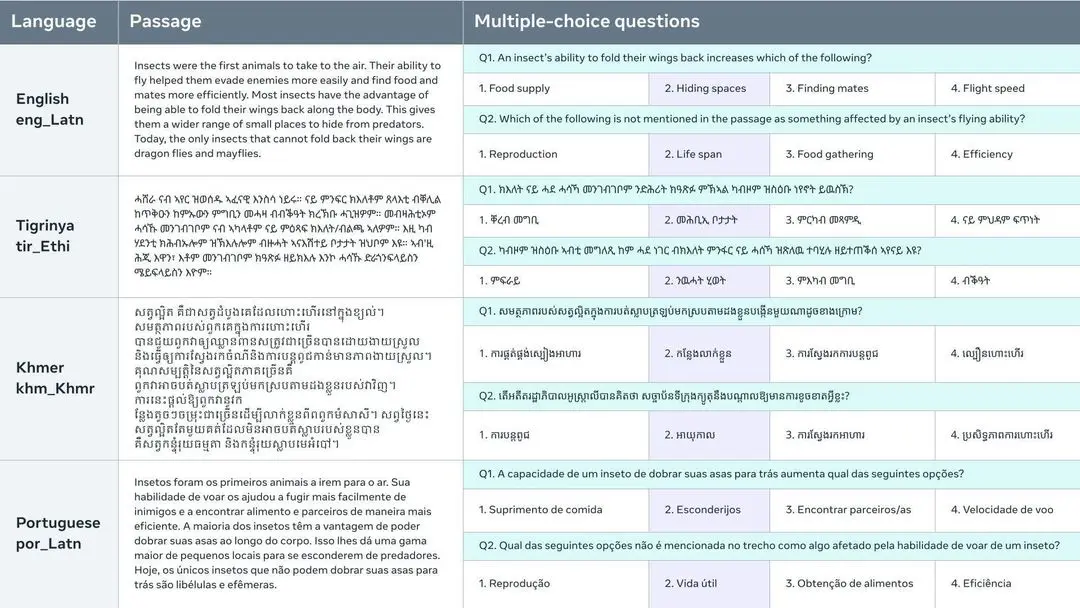

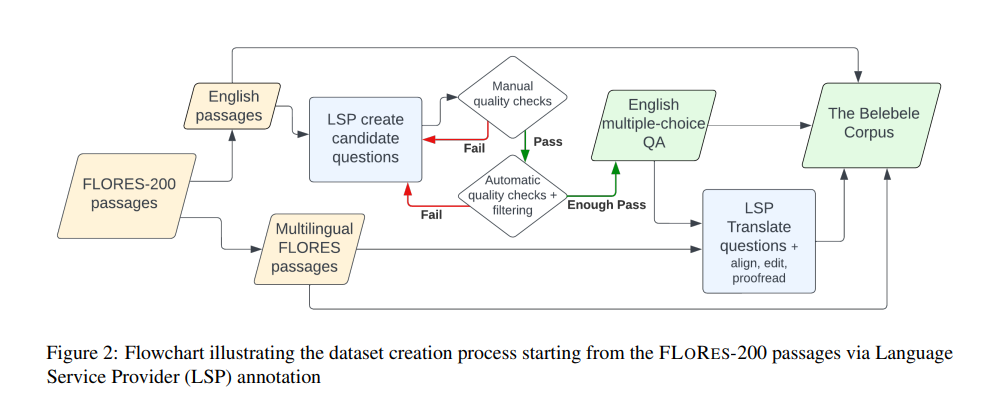

該數據集可對單語和多語模型進行評估,但其并行性也可在一些跨語言環境中對跨語言文本表征進行評估。通過從相關質量保證數據集中收集訓練集,可以對任務進行全面微調評估。每個問題都基于 Flores-200 數據集中的一段短文,并有四個多項選擇答案。這些問題經過精心設計,以區分具有不同一般語言理解水平的模型。

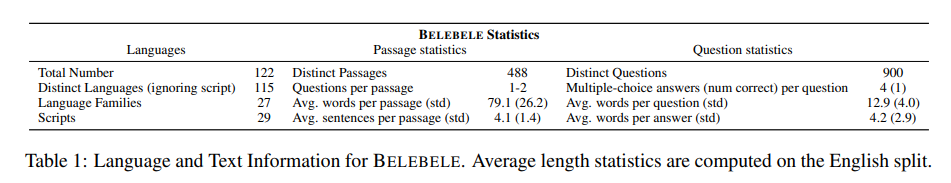

- 每種語言有 900 道題

- 488 個不同段落,每個段落有 1-2 道相關問題。

- 每道題有 4 個選擇答案,其中只有一個是正確的。

- 122 種語言 / 語言變體(包括英語)。

- 900 x 122 = 109,800 個問題。

研究人員利用這個數據集評估了多語言屏蔽語言模型(MLM)和大語言模型(LLM)的能力。結果表明,盡管以英語為中心的 LLM 有顯著的跨語言遷移能力,但在平衡的多語言數據上經過預訓練的更小的 MLM 仍然能理解更多的語言。且詞匯量越大、越有意識地構建詞匯,在低資源語言上的表現就越好。