最強LLaMA突然來襲!只改一個超參數,實現上下文3.2萬token,多個任務打敗ChatGPT、Claude 2

悄無聲息,羊駝家族“最強版”來了!

與GPT-4持平,上下文長度達3.2萬token的LLaMA 2 Long,正式登場。

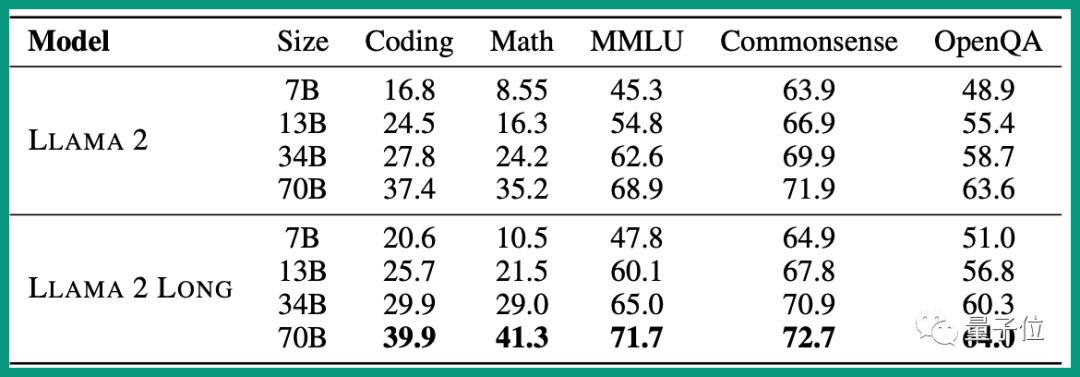

在性能上全面超越LLaMA 2。

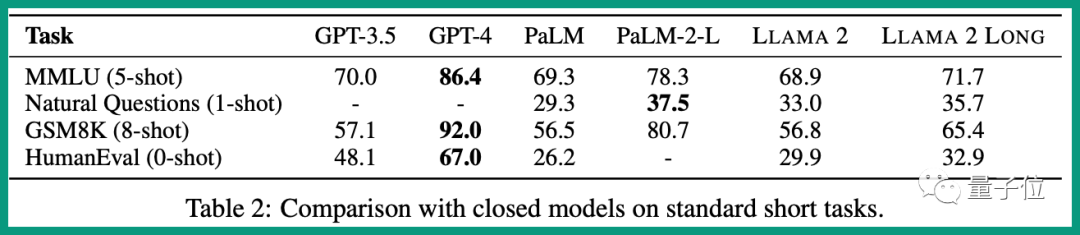

和競爭對手相比,在指令微調MMLU (5-shot)等測試集上,表現超過ChatGPT。

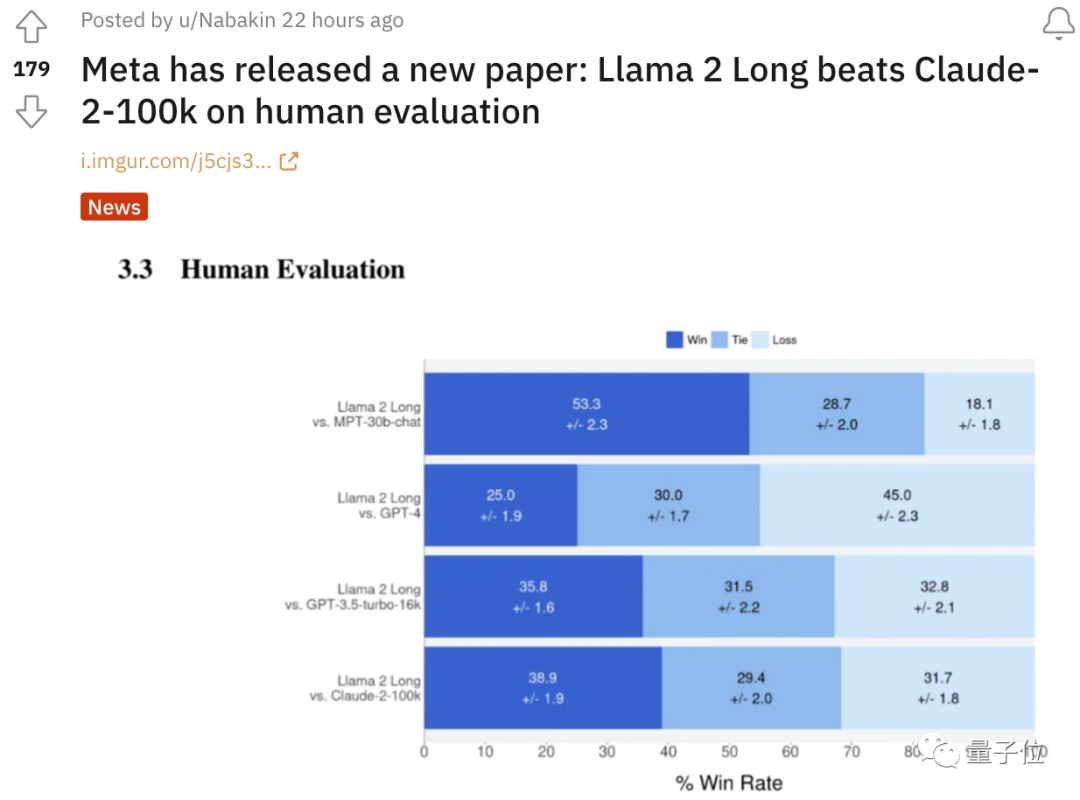

在人類評估(human evaluation)上甚至優于10萬token的Claude 2,這個話題還在Reddit上引發了討論。

要知道,這些對比版本中,LLaMA 2 Long使用的最大版本也只有70B,遠小于其他大模型。

這讓人不禁感慨:Meta確實還是有兩下子的。

也有人覺得,這才是最近Meta發布會的最大新聞啊,比Meta版ChatGPT要更令人興奮。

論文介紹,LLaMA 2 Long使用了4000億token語料加持下,并進行位置編碼修改。

所以LLaMA 2 Long究竟是如何誕生的?

只對位置編碼進行了一個非常小的改動

與LLaMA 2相比,LLaMA 2 Long的變化并不多。

一是訓練參數上,采用了高達4000億token的數據源。

——相反,原始LLaMA 2包含多個變體,但最多的版本也只有700億。

二是架構上,與LLaMA 2保持不變,但對位置編碼進行了一個非常小的必要修改,以此完成高達3.2億token的上下文窗口支持。

在LLaMA 2中,它的位置編碼采用的是旋轉編碼RoPE方法。

它是目前大模型中應用最廣的一種相對位置編碼,通過旋轉矩陣來實現位置編碼的外推。

本質上來說,RoPE就是將表示單詞、數字等信息的token embeddings映射到3D圖表上,給出它們相對于其他token的位置——即使在旋轉時也如此。

這就能夠使模型產生準確且有效的響應,并且比其他方法需要的信息更少,因此占用的計算存儲也更小。

在此,Meta的研究人員通過對70億規模的LLaMA 2進行實驗,確定了LLaMA 2中的RoPE方法的一個關鍵限制:

即,阻止注意力模塊聚集遠處token的信息。

為此,Meta想出了一個非常簡單的破解辦法:

減少每個維度的旋轉角度。

具體而言就是將超參數“基頻(base frequency) b”從10000增加到500000。

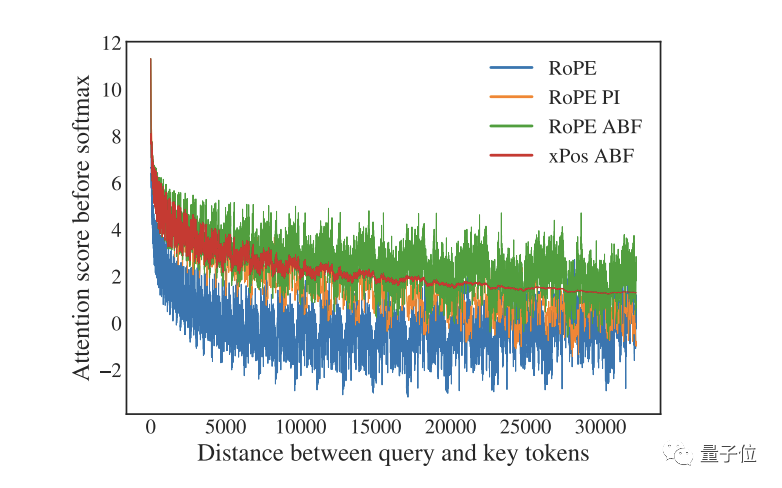

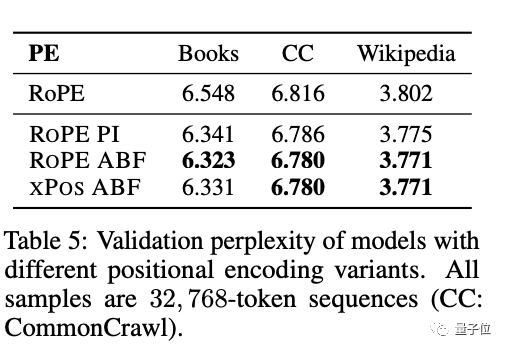

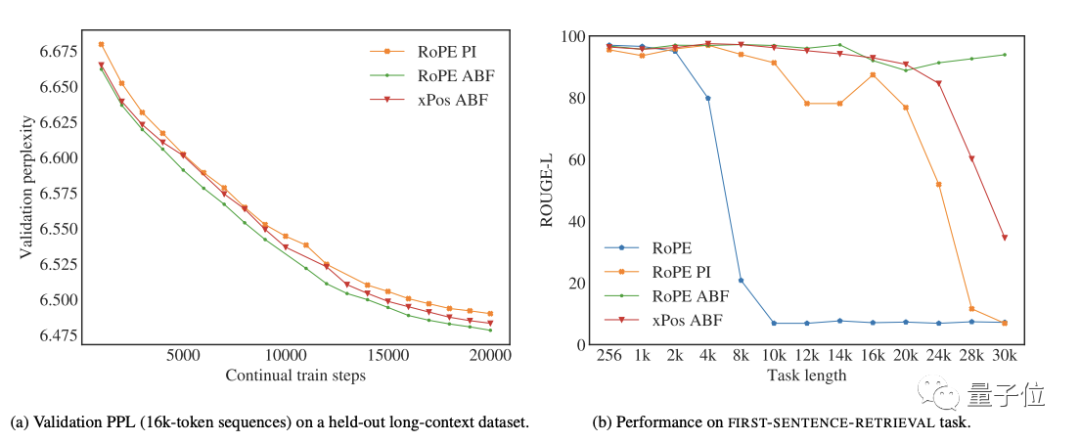

這一改動立刻奏效,縮小了RoPE對遠端token的衰減效應,并且在擴展LLAMA的上下文長度上優于一項類似的名為“位置插值”的方法(如下圖所示,RoPE PI,衰減效果較為“隱含”)。

Ps. 圖中RoPE表示基線方法,RoPE ABF為Meta此次發明的新方法,xPos是另一種應用了該方法的旋轉編碼變體。

一個問題是,通過上面這個可視化結果,Meta觀察到RoPE在長程區域出現了較大的“振蕩”,這對于語言建模來說可能不是個好消息。

不過,通過報告幾種方法在長序列困惑度和FIRST-SENTENCE-RETRIEVAL兩個任務上的表現來看,問題不大。

而且,尤其在后者任務上,他們提出的RoPE ABF是唯一一個可以始終保持性能的變體。

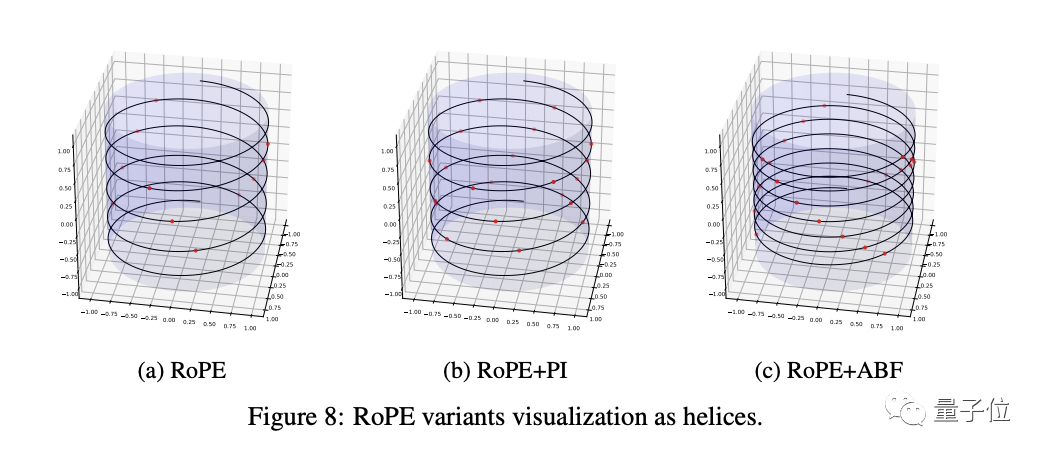

在附錄中,Meta還通過可視化為螺旋圖這一非常有趣的方式,將RoPE ABF與RoPE PI的差異進行了理論分析。

結果是,與RoPE PI相比,RoPE ABF的優勢主要體現在它能以更大的粒度分配嵌入向量(the embedded vectors),從而使模型更容易區分位置。

此外,他們還觀察到,嵌入向量之間的相對距離既對RoPE PI的關鍵參數有線性依賴性,也對RoPE ABF的關鍵參數也有對數依賴性。

這也就是為什么我們可以很容易地對基頻這一超參數“下手”。

最終,LLaMA 2 Long憑借著這一改動,達成了3.2萬的上下文token,并通過長下文連續預訓練的共同作用,獲得了開頭所示的好成績:

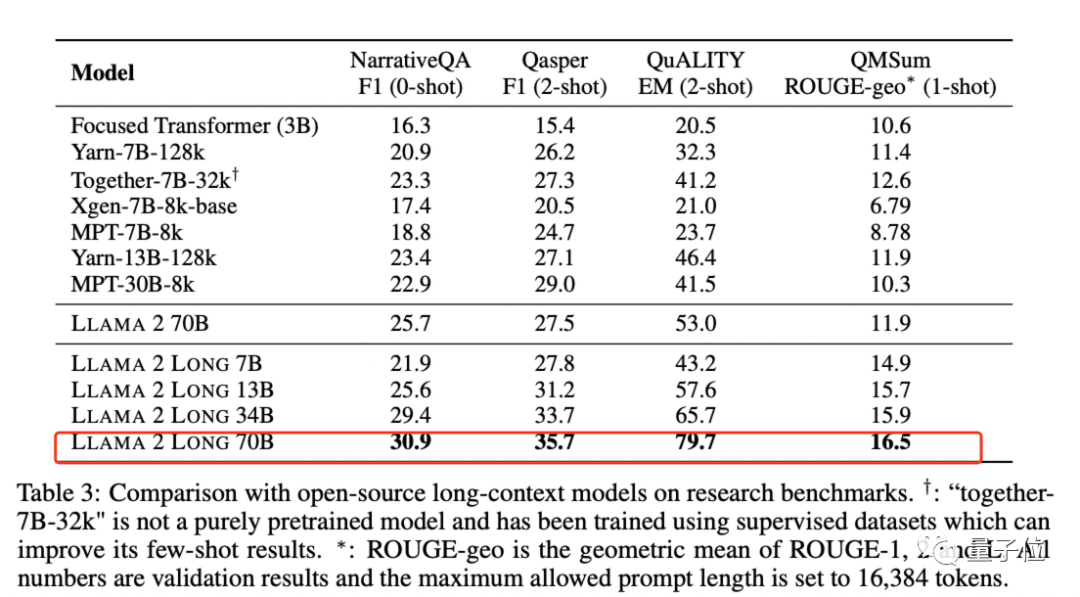

除了全面超越LLaMA 2、在特定任務上超越Claude 2和ChatGPT,Meta也給出了它和一些開源長下文模型的對比。

結果也相當不賴。

One More Thing

值得一提的是,這個最新的版本,是用LLaMA2生成的文本內容來進行訓練的。

官方會不會正式發布這一版本,現在還沒有更明確的消息,模型的網址也還沒有找到。

不過已經有人提前興奮起來了:

這對可商用微調大模型來說太有用了!

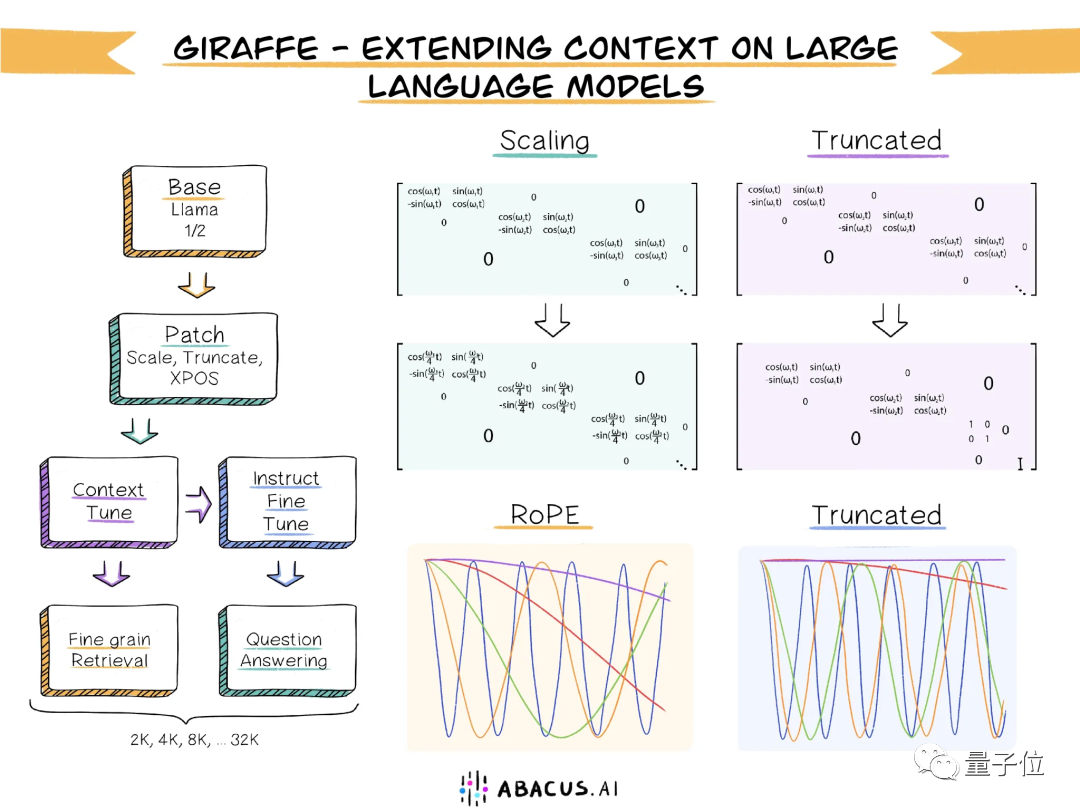

而在此之前,已經有非官方版本實現了3.2萬token上下文,也是開源可商用。

“長頸鹿(Giraffe)”基于13B版本的LLaMA2打造。

研究團隊提出了一種稱為“截斷(truncation)”的方法,對原始RoPE編碼進行變換。

llama-2-7b-32k-instruct也可以支持3.2萬上下文,模型規模是7B。

論文:https://arxiv.org/pdf/2309.16039.pdf。

參考鏈接:

[1]https://venturebeat.com/ai/meta-quietly-releases-llama-2-long-ai-that-outperforms-gpt-3-5-and-claude-2-on-some-tasks/。

[2]https://twitter.com/_akhaliq/status/1707569241191285207。

[3]https://www.reddit.com/r/LocalLLaMA/comments/16v0onb/meta_has_released_a_new_paper_llama_2_long_beats/。

[4]https://news.ycombinator.com/item?id=37698604。