基于全景圖視覺自注意力模型的室內框架估計方法

一、研究背景

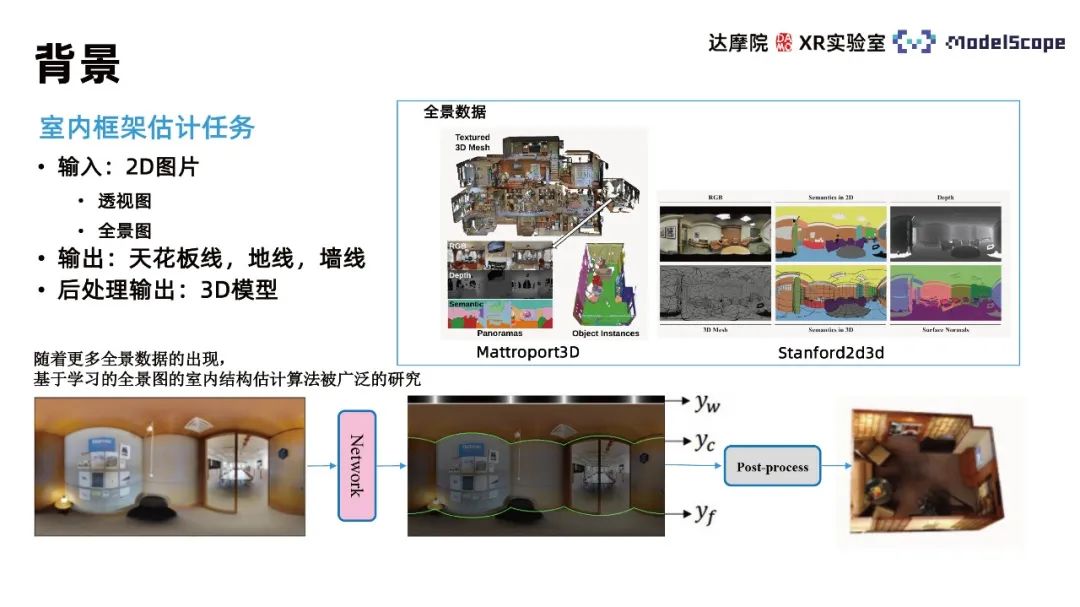

此方法主要關注室內框架估計(indoor estimation layout estimation)任務,任務輸入2D圖片,輸出圖片所描述場景的三維模型。考慮到直接輸出三維模型的復雜性,該任務一般被拆解為輸出2D圖像中的墻線、天花板線、地線三種線的信息,再根據線的信息通過后處理操作重建房間的三維模型。該三維模型可在后期進一步用于室內場景復刻、VR看房等具體應用場景。區別于深度估計方法,該方法基于對室內墻線的估計來恢復空間幾何結構,優勢在于可使墻面的幾何結構較為平整;劣勢則在于無法恢復室內場景沙發、椅子等細節物品的幾何信息。

根據輸入圖像的不同,一般可分為基于透視圖和基于全景圖的方法,相較于透視圖,全景圖具有視角較大、圖像信息豐富的特點。由于全景采集設備的普及,全景數據日益豐富,因此目前基于全景圖進行室內框架估計的算法被廣泛研究。

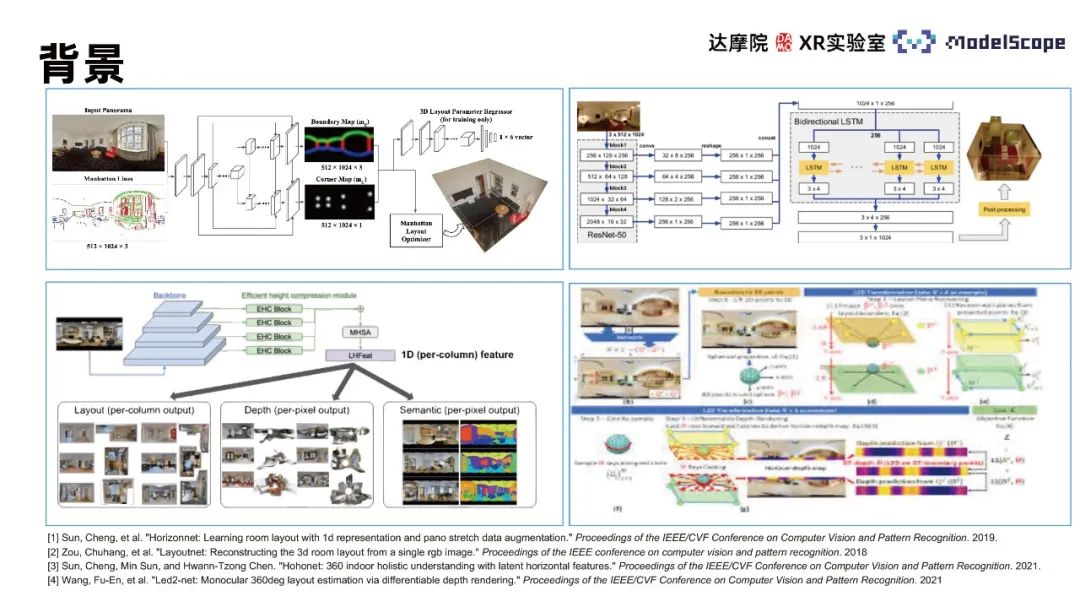

相關算法主要包括LayoutNet、HorizonNet、HohoNet及Led2-Net等,這些方法大多基于卷積神經網絡,在結構復雜的位置墻線預測效果較差,如有噪聲干擾、自遮擋等位置會出現墻線不連續、墻線位置錯誤等預測結果。在墻線位置估計任務中,僅關注局部特征信息會導致該類錯誤的發生,需利用全景圖中的全局信息考慮整條墻線的位置分布來估計。CNN方法在提取局部特征任務中表現更優,Transformer方法更擅長捕捉全局信息,因此可將Transformer方法應用于室內框架估計任務以提升任務表現。

由于訓練數據依賴性,單獨應用基于透視圖預訓練的Transformer估計全景圖室內框架效果并不理想。PanoViT模型預先將全景圖映射到的特征空間,使用Transformer學習全景圖在特征空間的全局信息,同時考慮全景圖的表觀結構信息完成室內框架估計任務。

二、方法介紹與結果展示

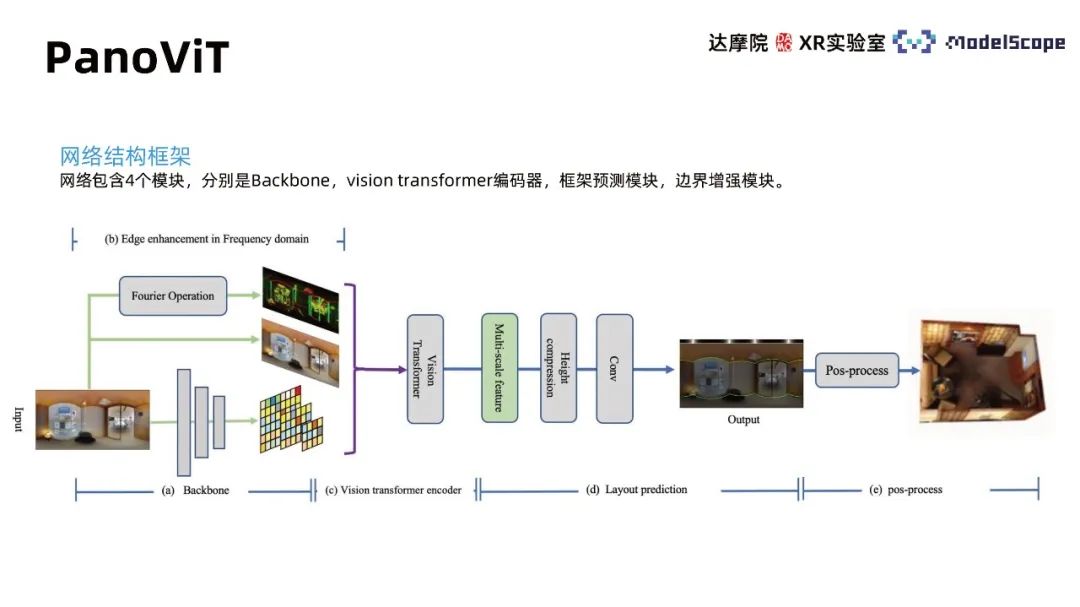

1、PanoViT

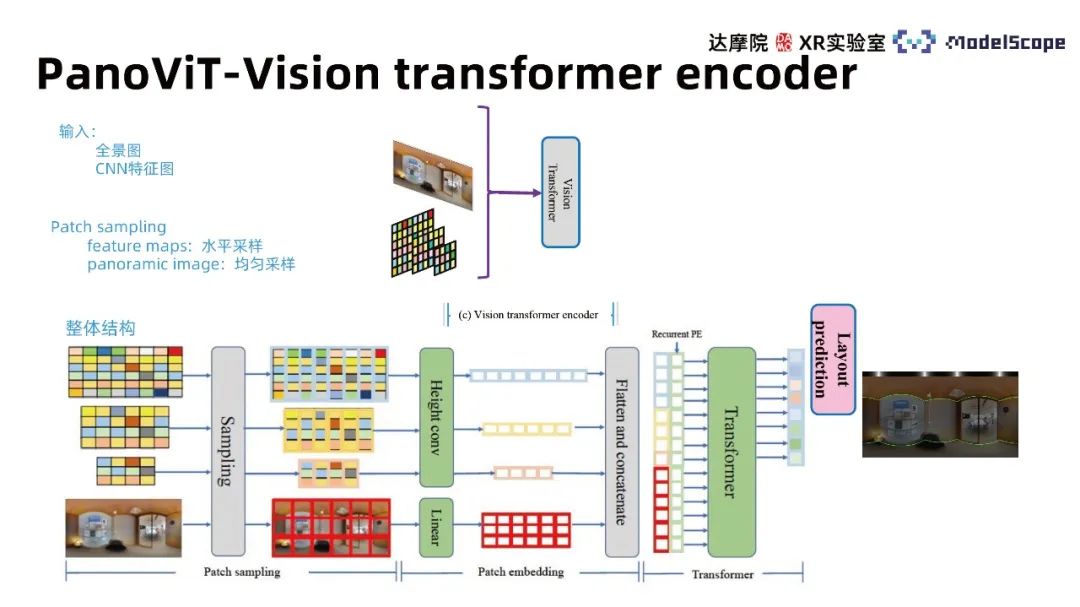

網絡結構框架包含4個模塊,分別是Backbone,vision transformer解碼器,框架預測模塊,邊界增強模塊。Backbone模塊將全景圖映射至特征空間,vison transformer編碼器在特征空間中學習全局關聯,框架預測模塊將特征轉化為墻線、天花板線、地線信息,后處理可進一步得到房間的三維模型,邊界增強模塊突出全景圖中邊界信息對于室內框架估計的作用。

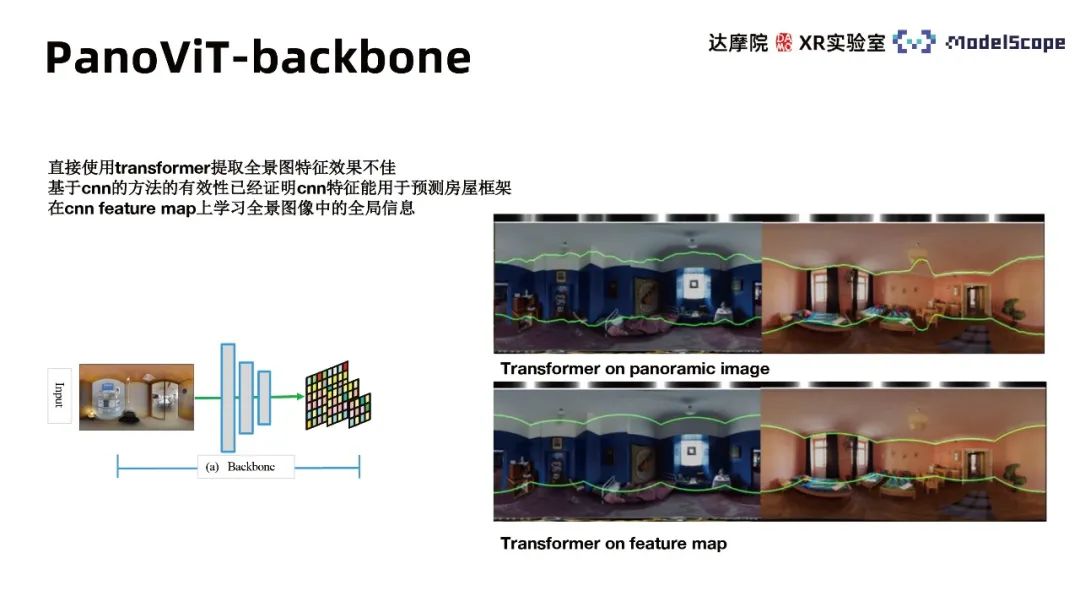

① Backbone模塊

由于直接使用transformer提取全景圖特征效果不佳,基于CNN的方法的有效性已經證明CNN特征可用于預測房屋框架。因此,使用CNN的backbone提取全景圖不同尺度feature map并在feature map中學習全景圖像的全局信息。實驗結果表明在特征空間中使用transformer的表現大大優于直接在全景圖上應用。

② Vision transformer encoder模塊

Transformer主體架構可主要分為三個模塊,包括patch sampling、patch embedding和transformer的multi-head attention。輸入同時考慮全景圖像特征圖與原始圖像并針對不同輸入采用不同patch sampling方法。原圖使用均勻采樣方法,特征圖采用水平采樣方法。來自HorizonNet的結論認為在墻線估計任務中水平方向特征具有更高重要性,參考此結論,embedding過程中對于特征圖特征進行豎直方向壓縮。采用Recurrent PE方法組合不同尺度的特征并在multi-head attention的transformer模型中進行學習,得到與原圖水平方向等長的特征向量,通過不同的decoder head可獲得對應的墻線分布。

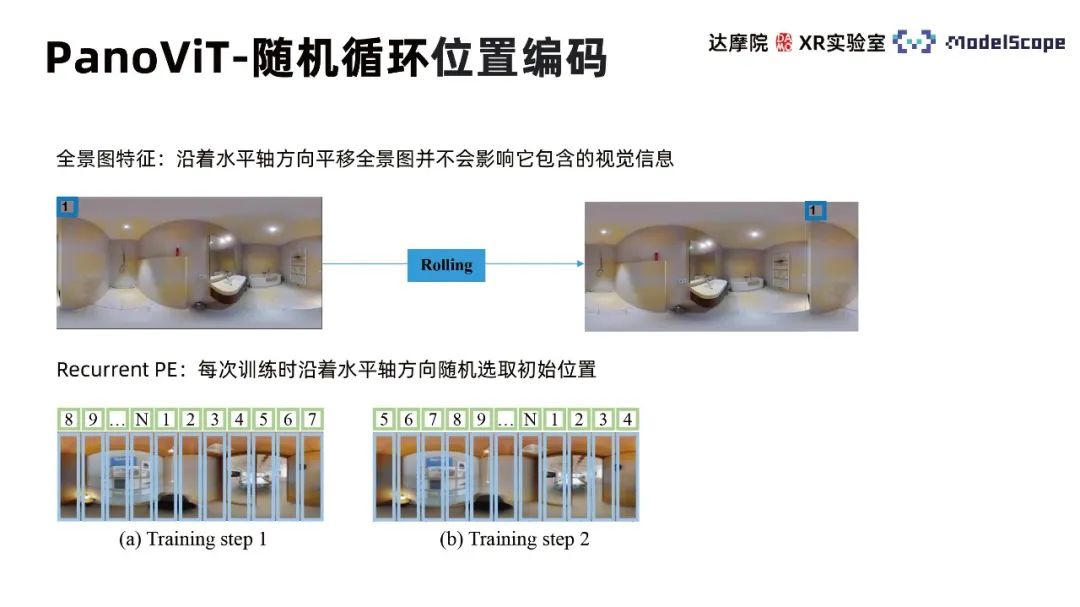

隨機循環位置編碼(Recurrent Position Embedding)考慮到全景圖沿水平方向位移不改變圖像視覺信息的特征,因此每次訓練時沿著水平軸方向隨機選取初始位置,使得訓練過程更關注不同patch之間的相對位置而非絕對位置。

③ 全景圖的幾何信息

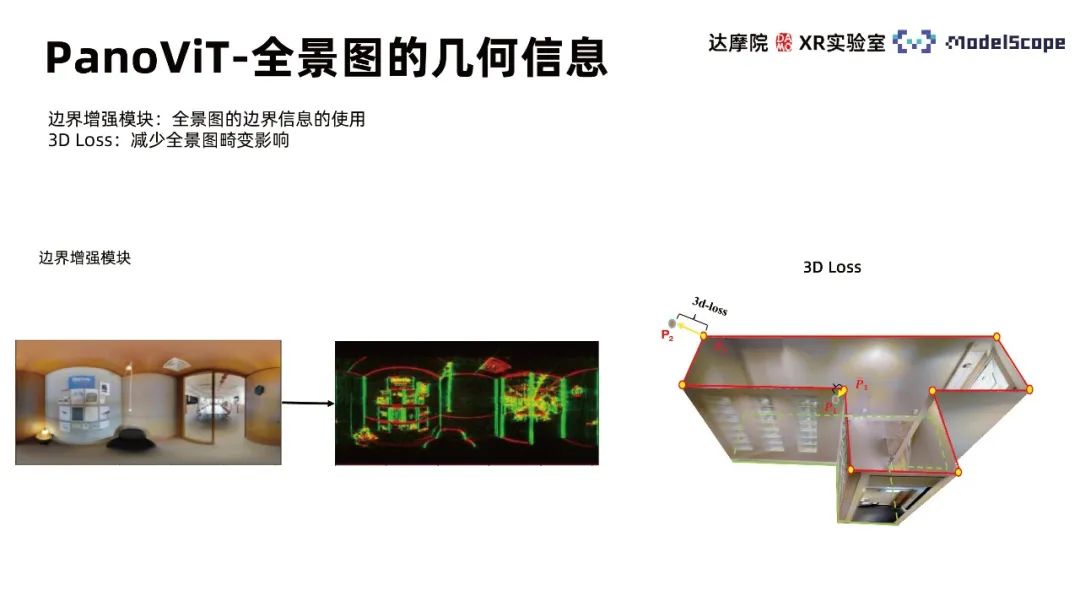

全景圖中幾何信息的充分利用可有助于室內框架估計任務表現的提升。PanoViT模型中的邊界增強模塊強調如何使用全景圖中的邊界信息,3D Loss則幫助減少全景圖畸變影響。

邊界增強模塊考慮到墻線檢測任務中墻線的線狀特征,圖像中的線條信息重要性突出,因此需要突出邊界信息使得網絡了解圖像中線的分布。使用頻域中邊界增強方法突出全景圖邊界信息,基于快速傅里葉變換得到圖像頻域表示,使用掩膜在頻域空間中進行采樣,基于傅里葉反變換變換回邊界信息被突出的圖像。模塊核心在于掩膜設計,考慮到邊界對應高頻信息,掩膜首先選用高通濾波器;并根據不同線的不同走向方向采樣不同的頻域方向。該方法相對傳統LSD方法實施簡單且效率更高。

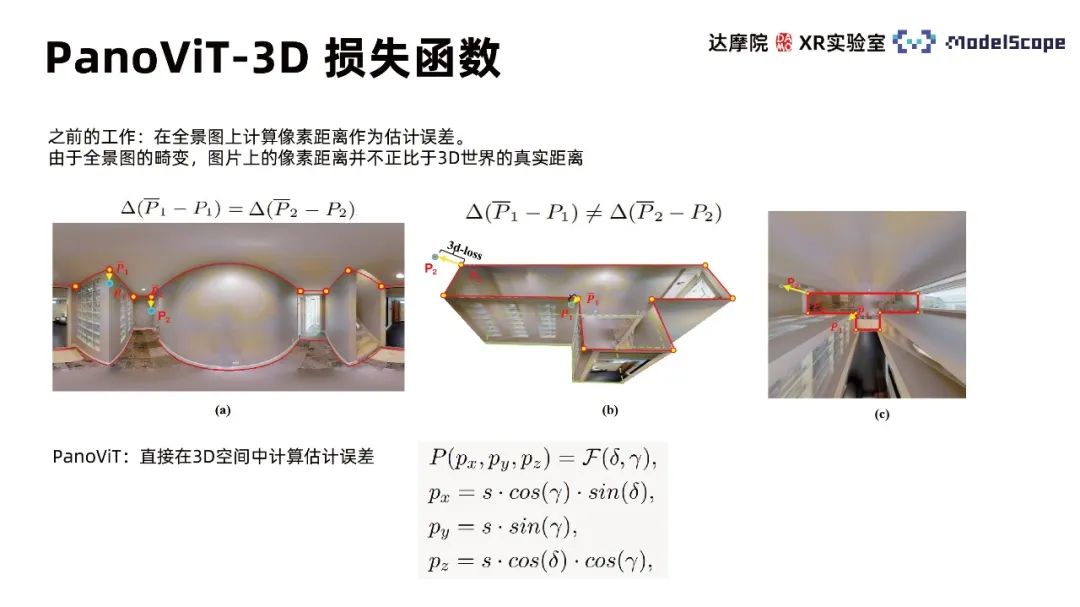

之前工作在全景圖上計算像素距離作為估計誤差,由于全景圖畸變,圖片上的像素距離并不正比于3D世界的真實距離。PanoViT使用3D損失函數,直接在3D空間中計算估計誤差。

2、模型結果

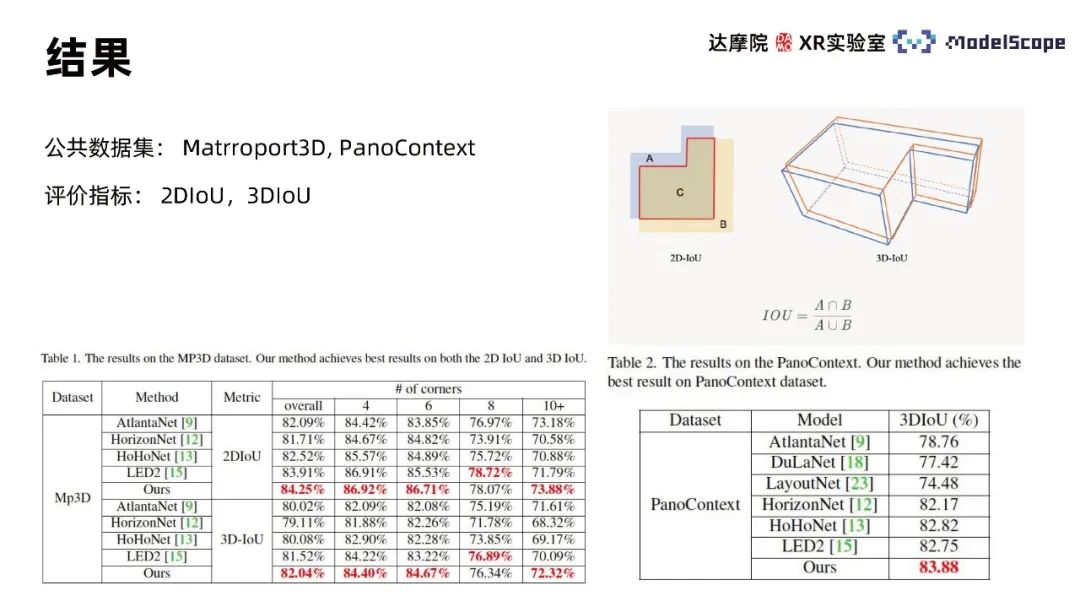

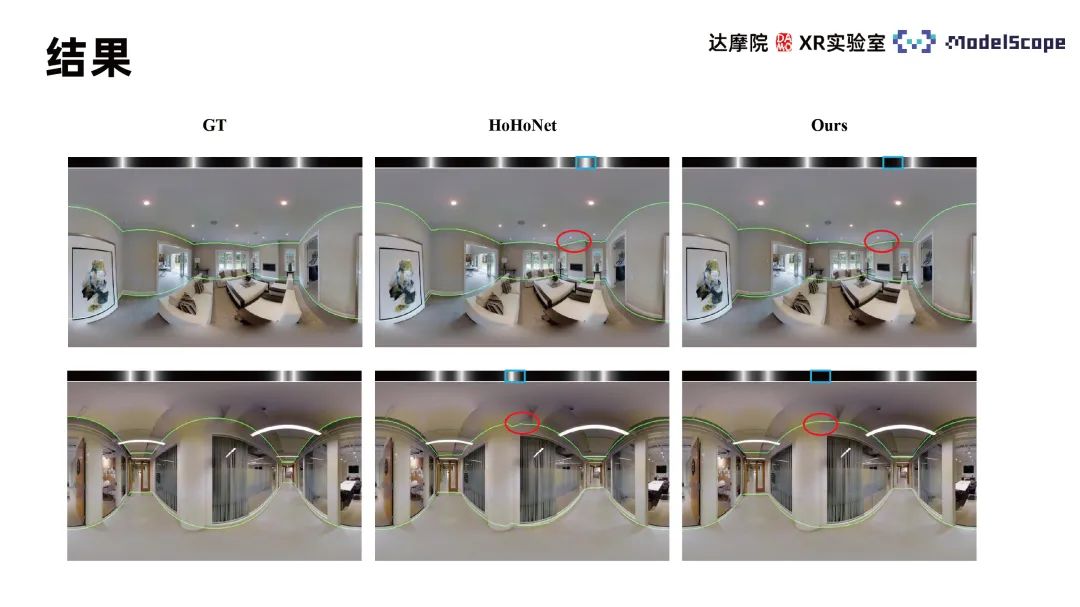

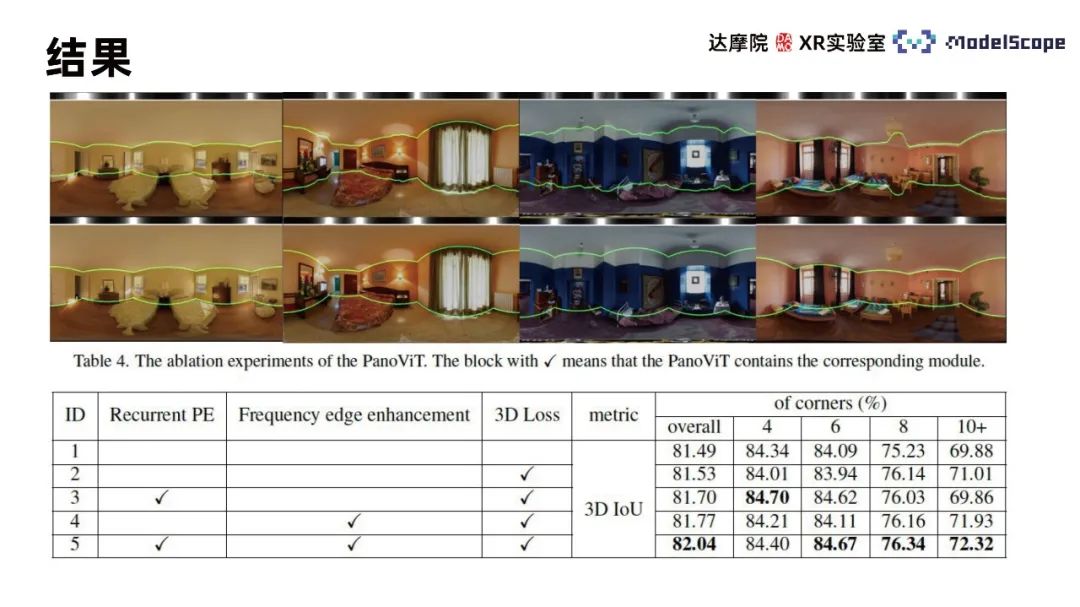

使用Martroport3D、PanoContext公共數據集進行實驗,使用2DIoU和3DIoU作為評價指標,并與SOTA方法進行對比。結果顯示PanoViT在兩個數據集中的模型評價指標基本達到最優,在特定指標中略遜于LED2。模型可視化結果與Hohonet比較可發現,PanoViT可正確識別復雜場景下的墻線走向。在消融實驗中兩兩對比Recurrent PE、邊界增強與3D Loss模塊,可驗證模塊有效性。

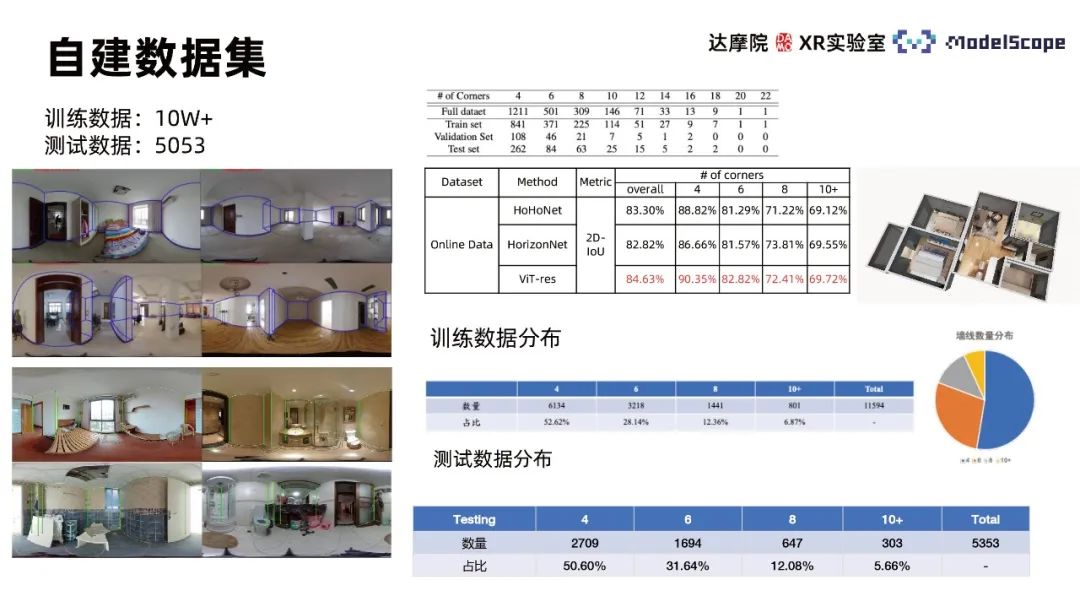

為了達到更好的模型數據集,收集十萬多張室內全景圖像自建全景圖像數據集,包含各類復雜室內場景,并基于自定規則進行標注,從中選取5053張圖像作為測試數據集。在自建數據集上測試PanoViT模型與SOTA模型方法表現,發現隨著數據量增大,PanoViT模型性能提升顯著。

三、如何在ModelScope中使用

- 打開modelscope官網:https://modelscope.cn/home。

- 搜索“全景圖室內框架估計”。

- 點擊快速使用-在線環境使用-快速體驗,打開notebook。

- 輸入主頁示例代碼,上傳1024*512的全景圖片,修改圖片加載路徑,運行輸出墻線預測結果。