超火迷你GPT-4視覺(jué)能力暴漲,GitHub兩萬(wàn)星,華人團(tuán)隊(duì)出品

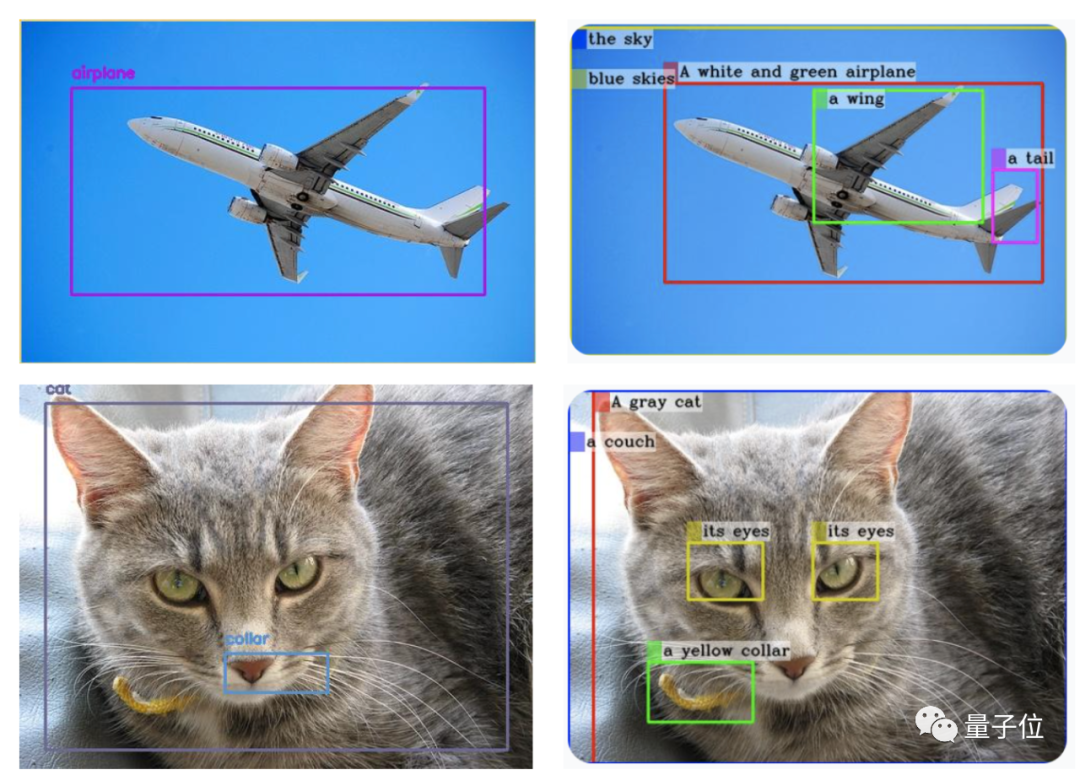

GPT-4V來(lái)做目標(biāo)檢測(cè)?網(wǎng)友實(shí)測(cè):還沒(méi)有準(zhǔn)備好。

雖然檢測(cè)到的類別沒(méi)問(wèn)題,但大多數(shù)邊界框都錯(cuò)放了。

沒(méi)關(guān)系,有人會(huì)出手!

那個(gè)搶跑GPT-4看圖能力幾個(gè)月的迷你GPT-4升級(jí)啦——MiniGPT-v2。

△(左邊為GPT-4V生成,右邊為MiniGPT-v2生成)

而且只是一句簡(jiǎn)單指令:[grounding] describe this image in detail就實(shí)現(xiàn)的結(jié)果。

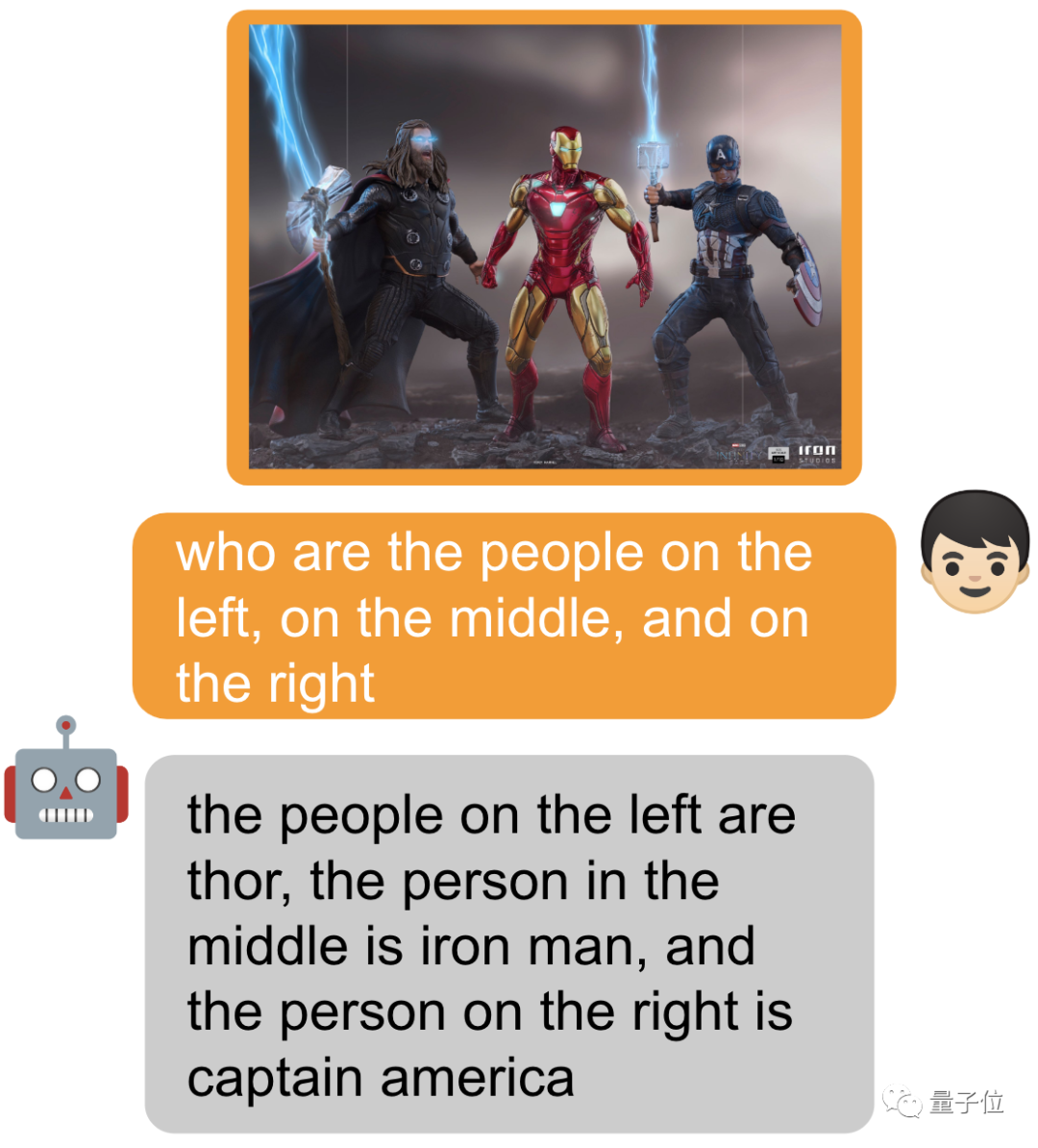

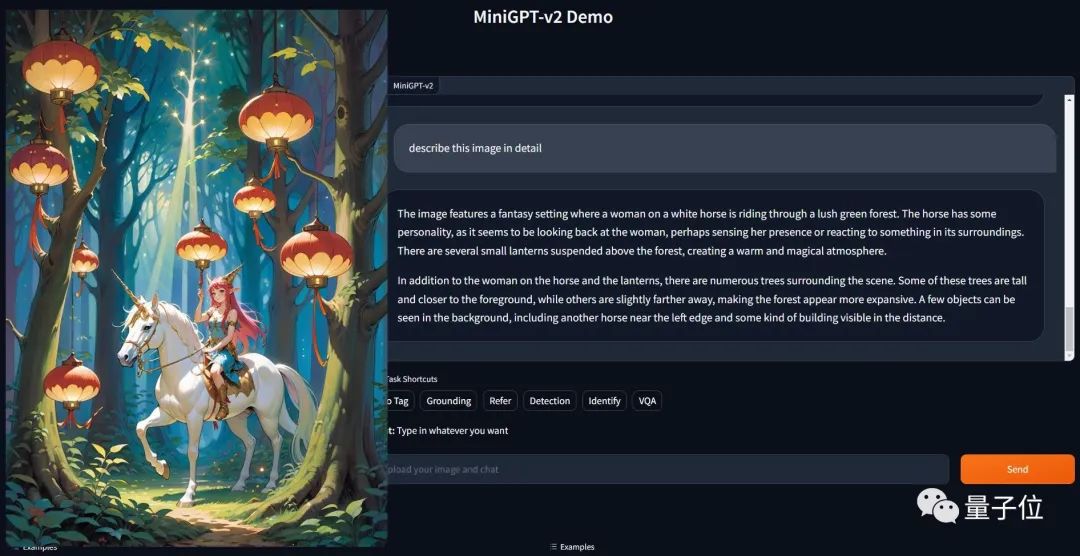

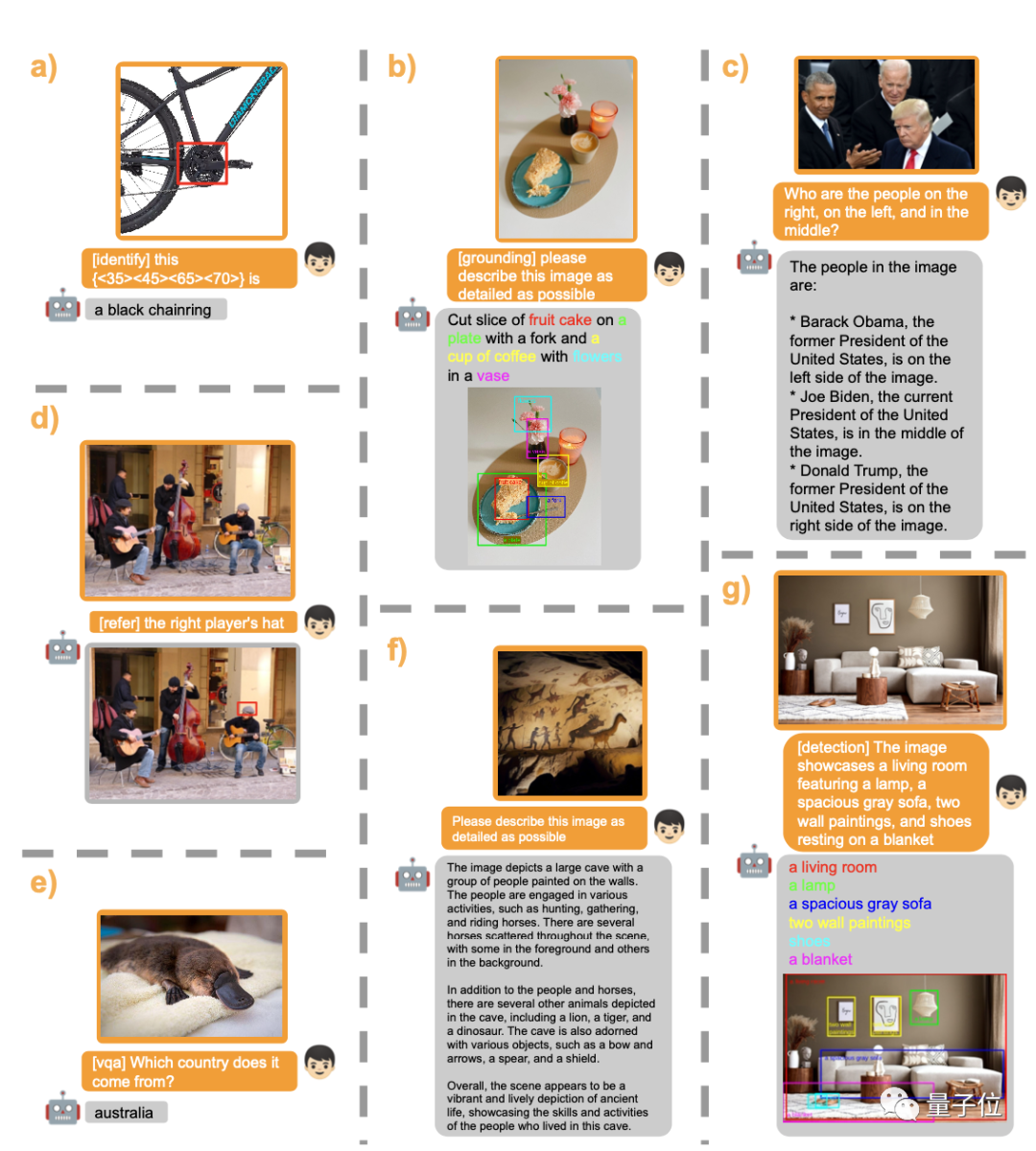

不僅如此,還輕松處理各類視覺(jué)任務(wù)。

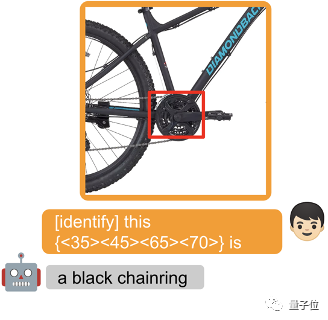

圈出一個(gè)物體,提示詞前面加個(gè) [identify] 可讓模型直接識(shí)別出來(lái)物體的名字。

當(dāng)然也可以什么都不加,直接問(wèn)~

MiniGPT-v2由來(lái)自MiniGPT-4的原班人馬(KAUST沙特阿卜杜拉國(guó)王科技大學(xué))以及Meta的五位研究員共同開(kāi)發(fā)。

上次MiniGPT-4剛出來(lái)就引發(fā)巨大關(guān)注,一時(shí)間服務(wù)器被擠爆,如今GItHub項(xiàng)目已超22000+星。

此番升級(jí),已經(jīng)有網(wǎng)友開(kāi)始用上了~

多視覺(jué)任務(wù)的通用界面

大模型作為各文本應(yīng)用的通用界面,大家已經(jīng)司空見(jiàn)慣了。受此靈感,研究團(tuán)隊(duì)想要建立一個(gè)可用于多種視覺(jué)任務(wù)的統(tǒng)一界面,比如圖像描述、視覺(jué)問(wèn)題解答等。

「如何在單一模型的條件下,使用簡(jiǎn)單多模態(tài)指令來(lái)高效完成各類任務(wù)?」成為團(tuán)隊(duì)需要解決的難題。

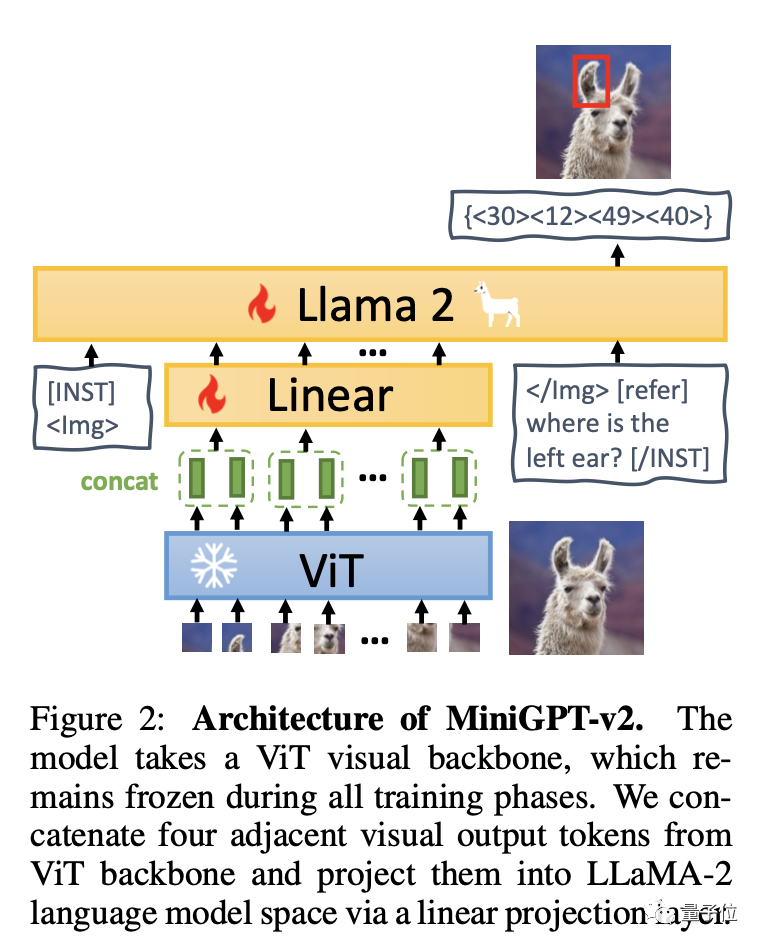

簡(jiǎn)單來(lái)說(shuō),MiniGPT-v2由三個(gè)部分組成:視覺(jué)主干、線性層和大型語(yǔ)言模型。

該模型以ViT視覺(jué)主干為基礎(chǔ),所有訓(xùn)練階段都保持不變。從ViT中歸納出四個(gè)相鄰的視覺(jué)輸出標(biāo)記,并通過(guò)線性層將它們投影到 LLaMA-2語(yǔ)言模型空間中。

團(tuán)隊(duì)建議在訓(xùn)練模型為不同任務(wù)使用獨(dú)特的標(biāo)識(shí)符,這樣一來(lái)大模型就能輕松分辨出每個(gè)任務(wù)指令,還能提高每個(gè)任務(wù)的學(xué)習(xí)效率。

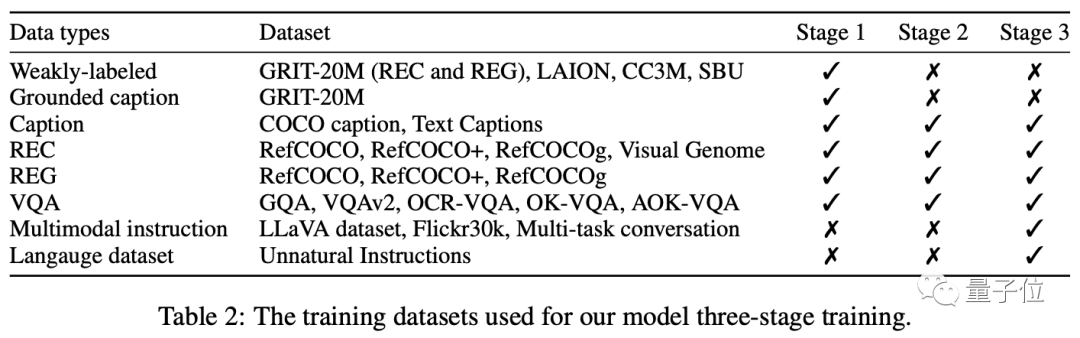

訓(xùn)練主要分為三個(gè)階段:預(yù)訓(xùn)練——多任務(wù)訓(xùn)練——多模式指令調(diào)整。

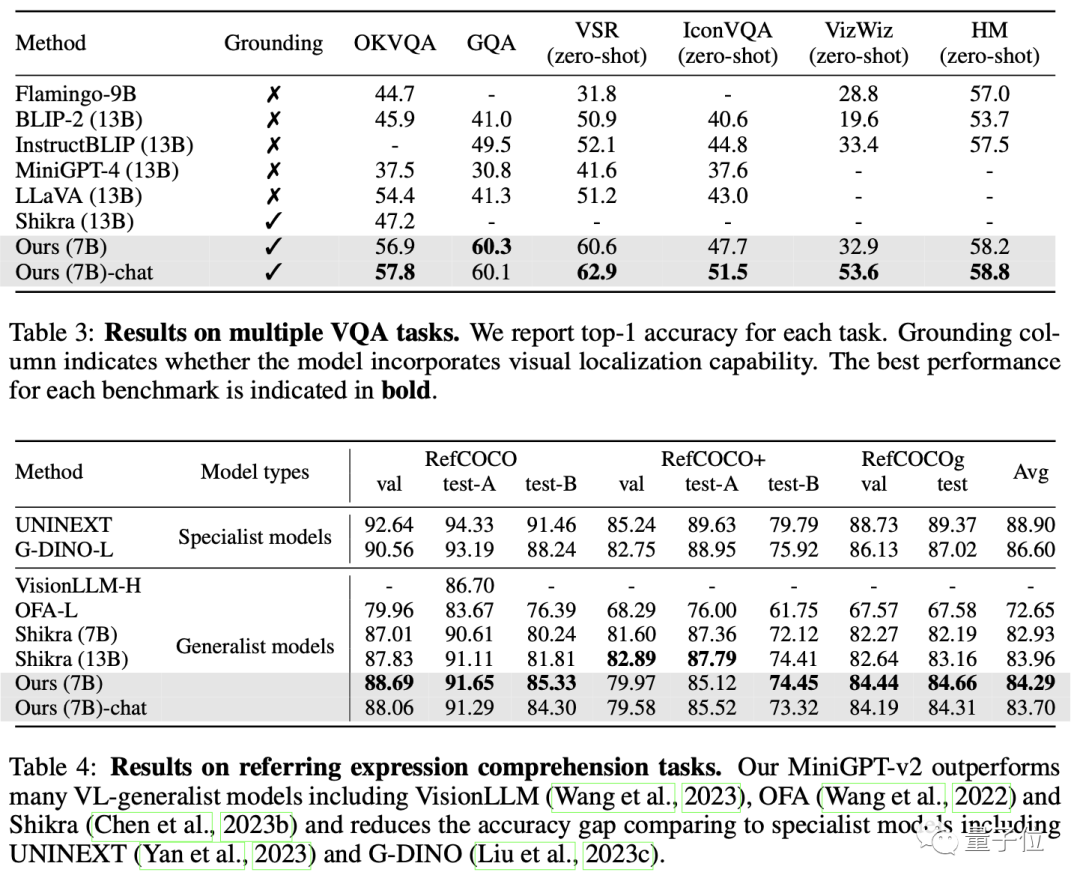

最終,MiniGPT-v2 在許多視覺(jué)問(wèn)題解答和視覺(jué)接地基準(zhǔn)測(cè)試中,成績(jī)都優(yōu)于其他視覺(jué)語(yǔ)言通用模型。

最終這個(gè)模型可以完成多種視覺(jué)任務(wù),比如目標(biāo)對(duì)象描述、視覺(jué)定位、圖像說(shuō)明、視覺(jué)問(wèn)題解答以及從給定的輸入文本中直接解析圖片對(duì)象。

感興趣的朋友,可戳下方Demo鏈接體驗(yàn):

https://minigpt-v2.github.io/

https://huggingface.co/spaces/Vision-CAIR/MiniGPT-v2

論文鏈接:https://arxiv.org/abs/2310.09478

GitHub鏈接:https://github.com/Vision-CAIR/MiniGPT-4