我的眼睛就是尺!80億參數OtterHD帶你「清明上河圖」數駱駝!南洋理工華人團隊打造

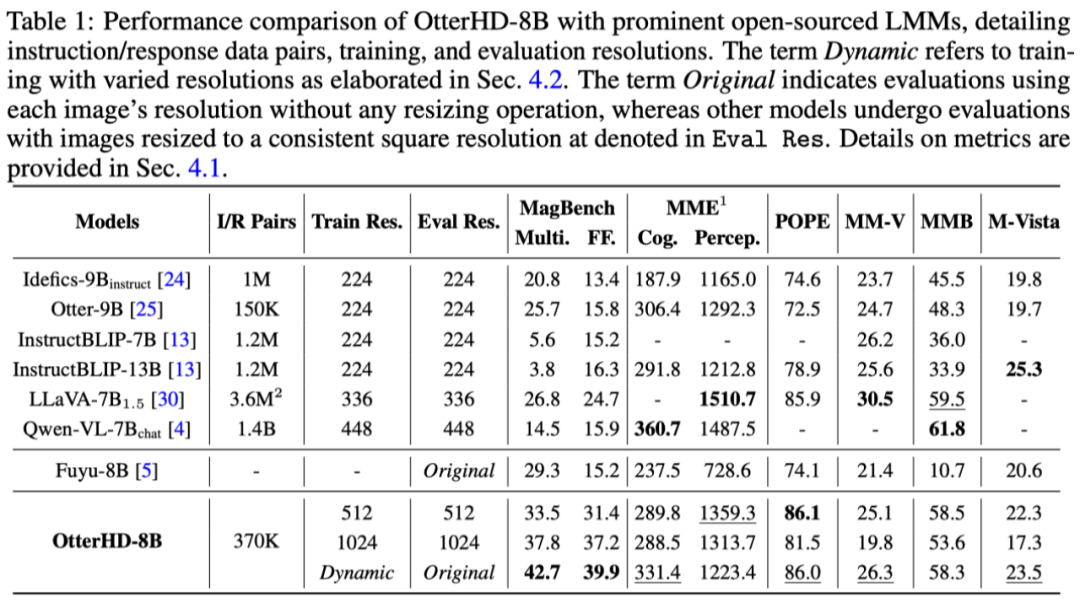

想知道《清明上河圖》里面有多少頭駱駝嗎?來看看這個支持超高清輸入的多模態模型吧。

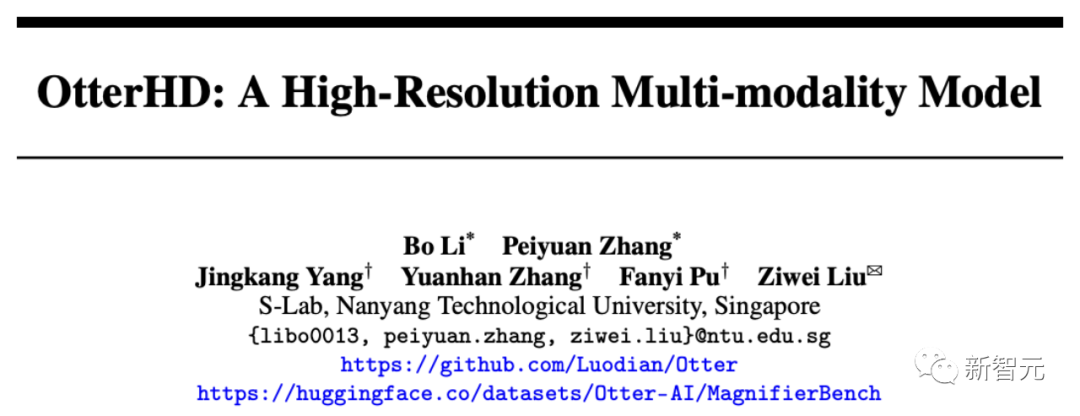

最近,來自南洋理工的華人團隊基于Fuyu-8B打造出了80億參數的多模態大模型OtterHD。

論文地址:https://arxiv.org/abs/2311.04219

與受限于固定尺寸視覺編碼器的傳統模型不同,OtterHD-8B具有處理靈活輸入尺寸的能力,確保了其在各種推理需求下的通用性。

同時,團隊還提出了一個全新的基準測試MagnifierBench,可以細致地評測LLM辨別大尺寸圖像中物體的微小細節和空間關系的能力。

結果顯示,OtterHD-8B的表現,尤其是在直接處理高分辨率輸入時,遠遠優于同類模型。

效果演示

如下圖中,詢問清明上河圖(局部)中有多少只駱駝,圖片輸入達到了2446x1766像素,模型也能成功對答。

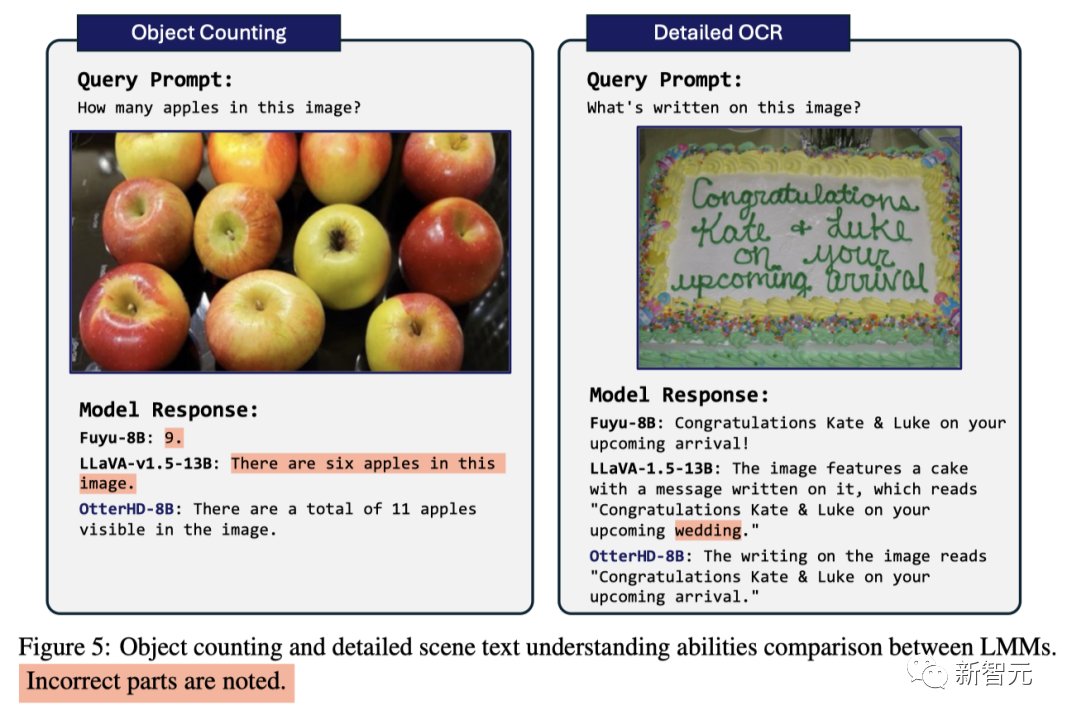

面對曾讓GPT4-V發愁的數蘋果問題,模型也成功的數出了其中包含11個蘋果。

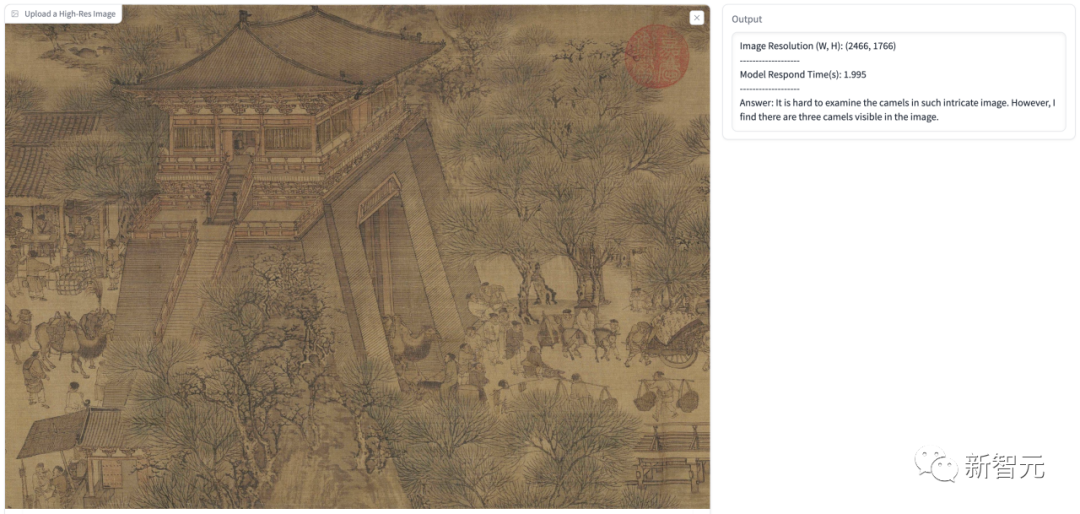

除了論文中展示的高清輸入的例子,我們也進行了一些測試,下圖我們讓模型假設用戶是一個劍橋大學的PhD,解釋這個圖是什么意思。

其中模型的回答中準確的識別出圖片中的Black Hole和White Hole等信息,并且識別出其是一個tunnel-like structure,然后給出了詳細的解釋。

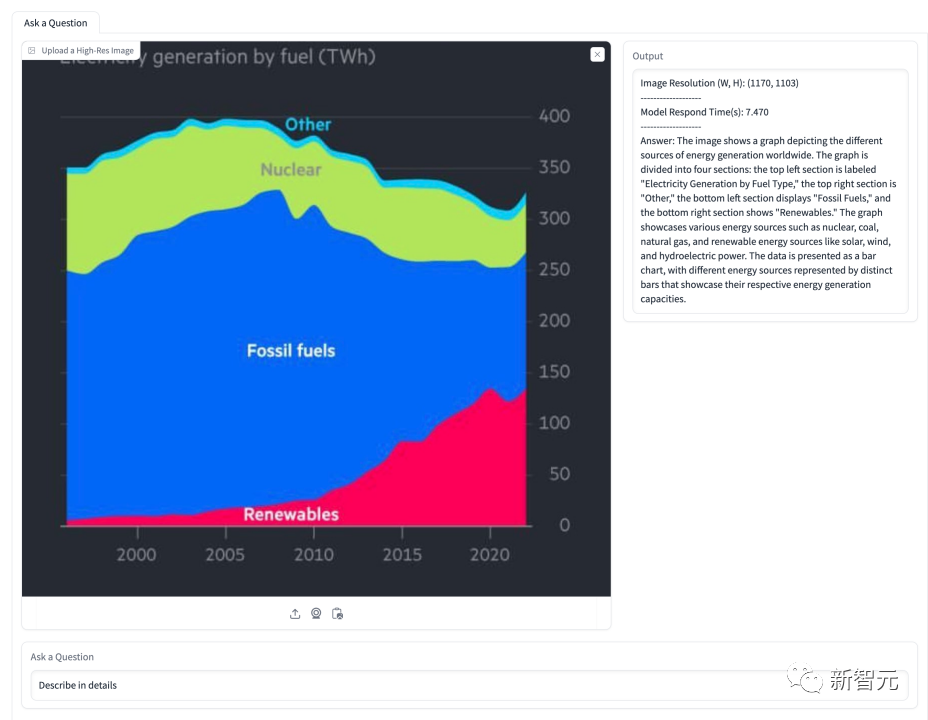

下圖中,讓模型解釋圖中關于能源占比的情況,模型準確識別了圖中的幾類能源以及其占比隨時間變化的情況。

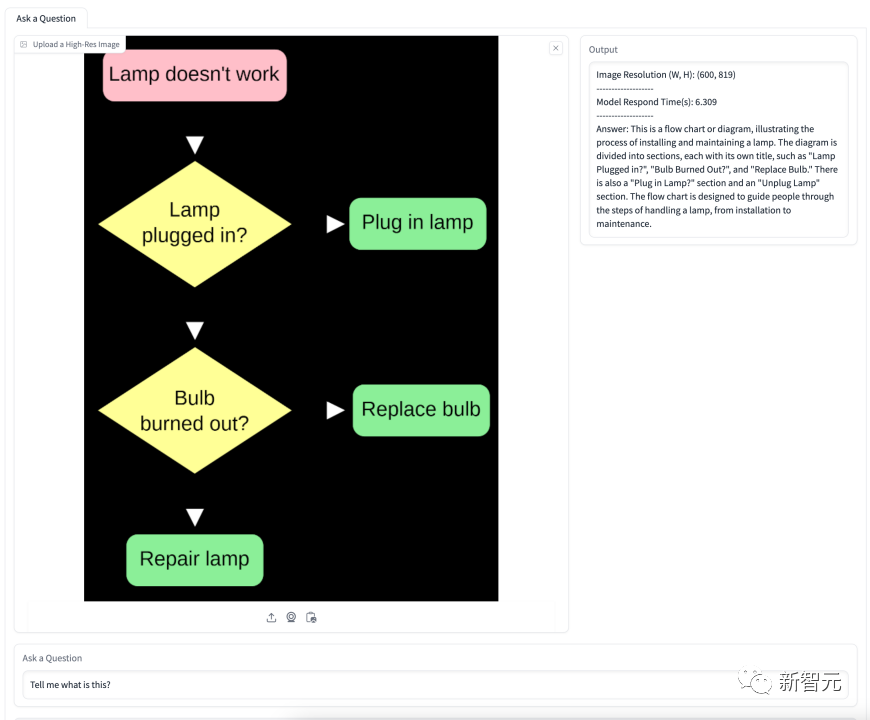

下圖關于換燈泡的流程圖,模型準確理解了流程圖的含義并且給出了一步一步的詳細指導。

80億參數指令微調OtterHD-8B

值得注意的是,基于Fuyu-8B的OtterHD-8B是第一個在最大1024×1024輸入上進行訓練的開源指令微調大語言模型。

此外,在推理過程中,它還能進一步擴展到更大的分辨率(如1440×1440)。

訓練細節

在初步實驗中團隊發現,Fuyu在響應某些基準測試中的特定指令時表現不佳,這導致模型在MME和MMBench上的性能非常弱。

為了解決這些問題,團隊基于370K條混合數據對Fuyu模型進行指令微調,并參考 LLaVA-1.5使用了相似的指令模板來規范模型回答的格式。

在訓練階段,所有數據集都被組織成指令/應答對,匯總到統一的 dataloader中,并進行統一采樣,以確保代表性的完整性。

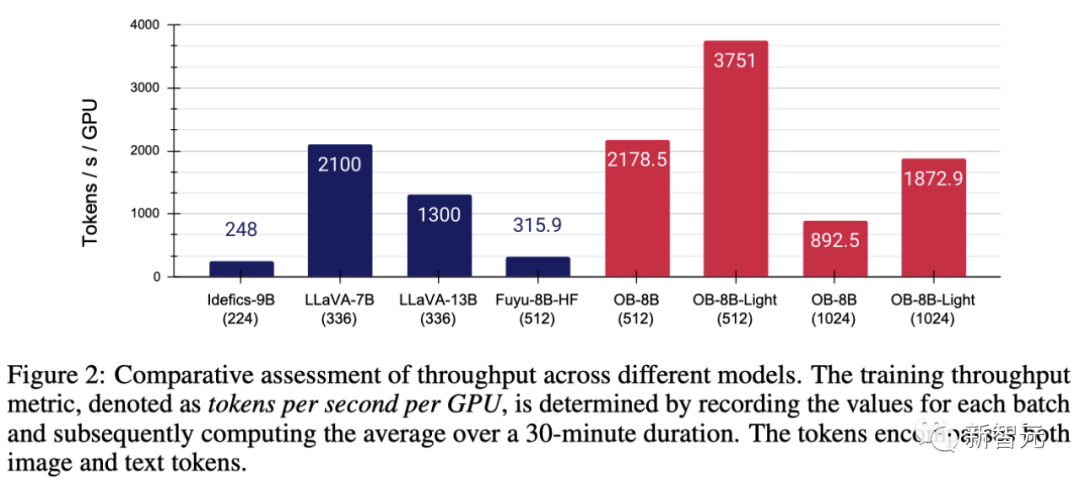

為了增強建模代碼,團隊使用了FlashAttention-2和FlashAttention資源庫中的算子融合技術。

得益于Fuyu簡化的架構,如圖2所示,這些修改大大提高了GPU的利用率和吞吐量。

具體來說,團隊提出的方法可以在8×A100 GPU上以3小時/epoch的速度完成全參數訓練,而LoRA微調后每epoch只需1小時。

在使用AdamW優化器訓練模型時,批大小為64,學習率設置為1×10^-5,權重衰減為0.1。

超精細評測基準MagnifierBench

人類視覺系統可以自然地感知視野內物體的細節,但目前用于測試LMM的基準并沒有特別側重于評估這方面的能力。

隨著Fuyu和OtterHD模型的出現,我們第一次將輸入圖像的分辨率擴展到了更大的范圍。

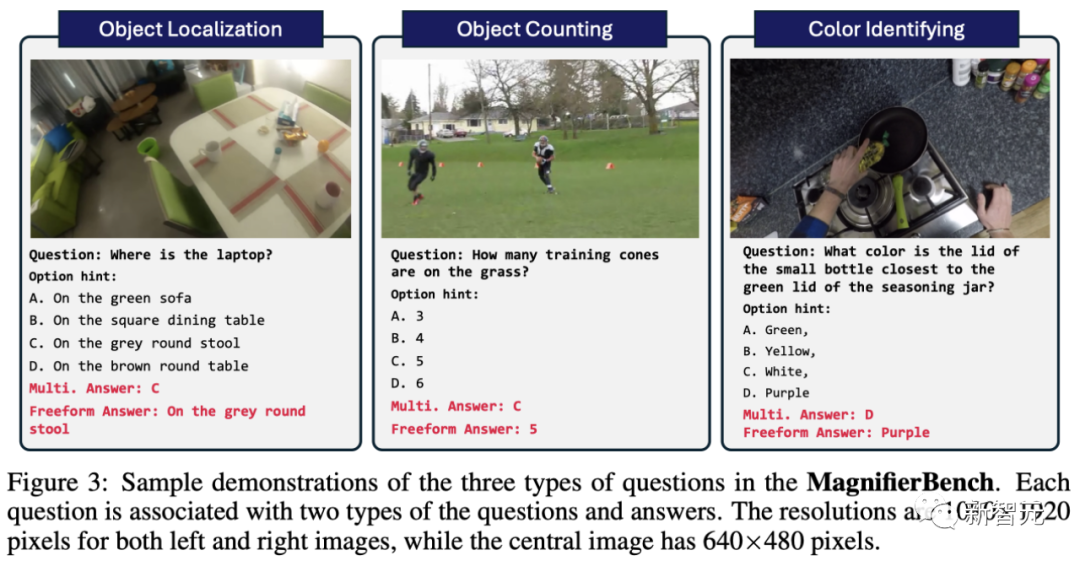

為此,團隊基于Panoptic Scene Graph Generation(PVSG)數據集,制作了一個涵蓋166幅圖像共283組問題的全新測試基準MagnifierBench。

PVSG數據集由視頻數據組成,其中包含大量雜亂無章的復雜場景,尤其是第一人稱的家務視頻。

在標注階段,團隊仔細檢查了數據集中的每個問題-答案對,剔除了那些涉及大型物體,或者很容易用常識性知識回答的問題。例如,遙控器大多都是黑的,很容易猜到,而紅黃等顏色則不在此列。

如圖3所示,MagnifierBench設計的問題類型包括識別、數字、顏色相關問題等。該數據集的一個重要標準是,問題必須足夠復雜,就連標注者都必須在全屏模式下,甚至放大圖像才能準確回答。

與簡短的回答相比,LMM更擅長在對話環境中生成擴展的回答。

- 多選題

這里模型面對的是一個問題和多個答案選項。為了引導模型以單個字母(如 A、B、C)作答,團隊在指令「答案」前直接加上給定選項中的字母作為問題前的提示。在這種情況下,只有完全符合正確選項的答案才被視為準確答案。

- 開放題

多個選項會簡化任務,因為隨機猜測有25%的正確率。此外,這并不能反映聊天助手所面臨的真實場景,因為用戶通常不會向模型提供預定義的選項。為了消除這種潛在的偏差,團隊還以直截了當、不設任何提示選項的開放式方式向模型提出問題。

實驗分析

研究結果表明,雖然很多模型在MME和POPE等既定基準上取得了高分,但它們在MagnifierBench上的表現卻往往不盡如人意。另一方面,OtterHD-8B在MagnifierBench上表現出色。

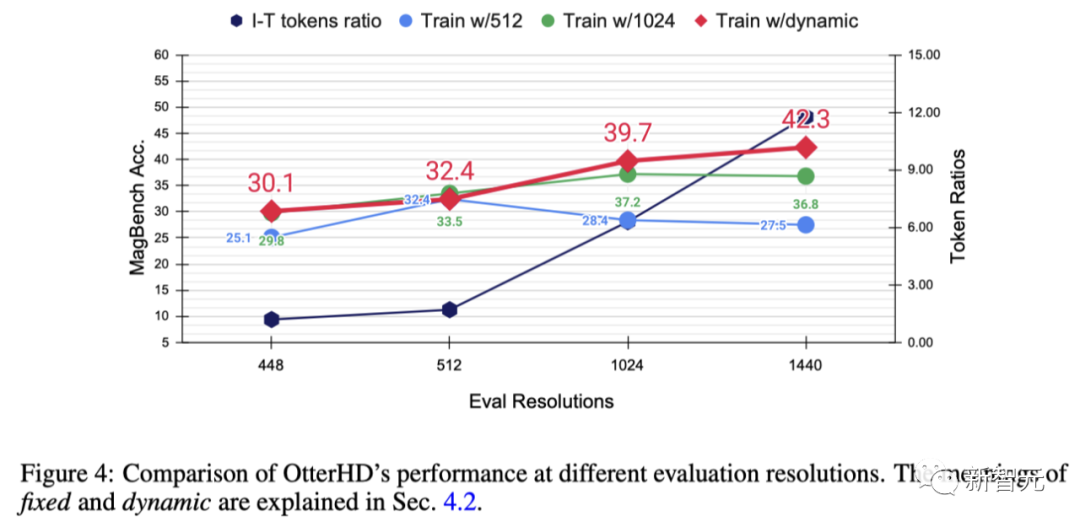

為了進一步探索提高分辨率的效果以及OtterHD對不同、可能更大分辨率的泛化能力,團隊使用固定或動態分辨率對Otter8B進行了訓練。

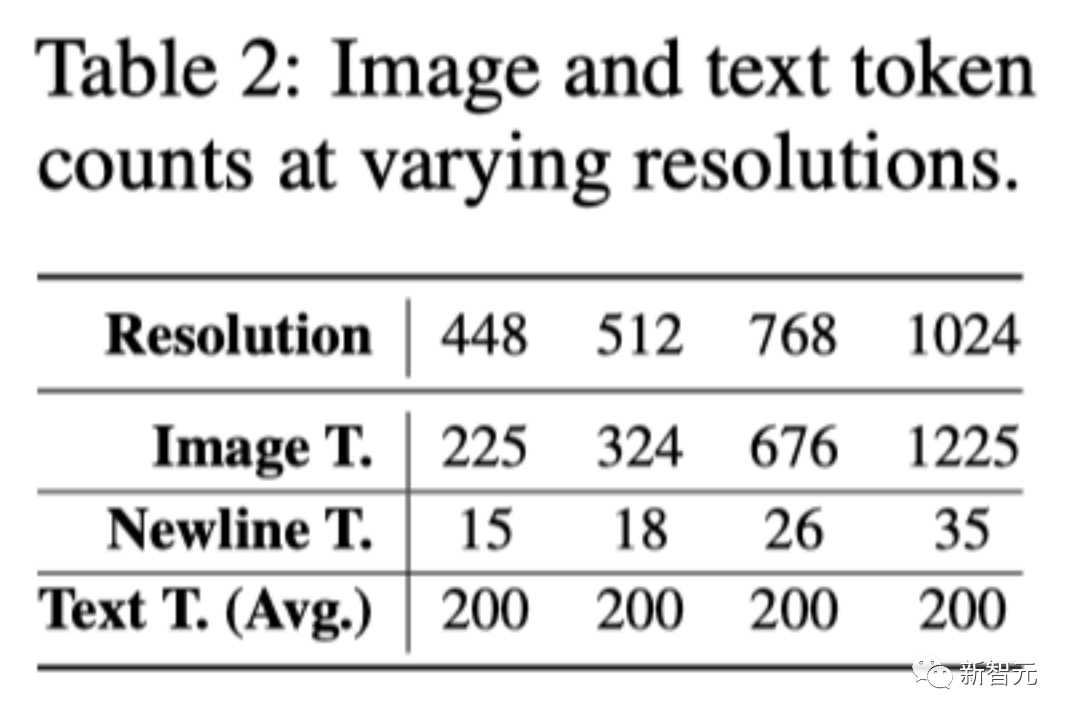

x軸表明,隨著分辨率的提高,會有更多的圖像token被發送到語言解碼器,從而提供了更多的圖像細節。

結果表明,分辨率越高,MagnifierBench的性能越好。

由于平均文本token數保持不變,因此隨著分辨率的增加,圖像與文本token數的比例也逐漸增大。

這一變化突出了LMM分辨率的重要性,尤其是對于需要復雜視覺關聯的任務。

此外,固定訓練方法和動態訓練方法之間的性能差異凸顯了動態調整大小的優勢,尤其是防止特定分辨率的過擬合。

而且,動態策略還可以讓模型泛化到訓練期間未見的更大分辨率(1440)。

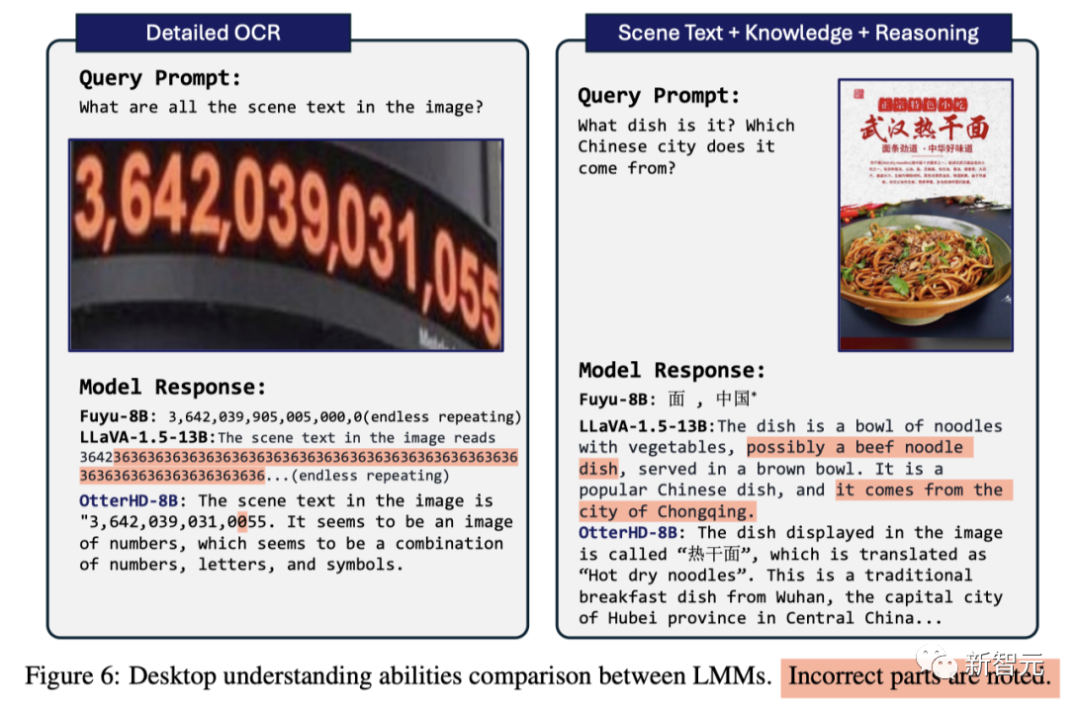

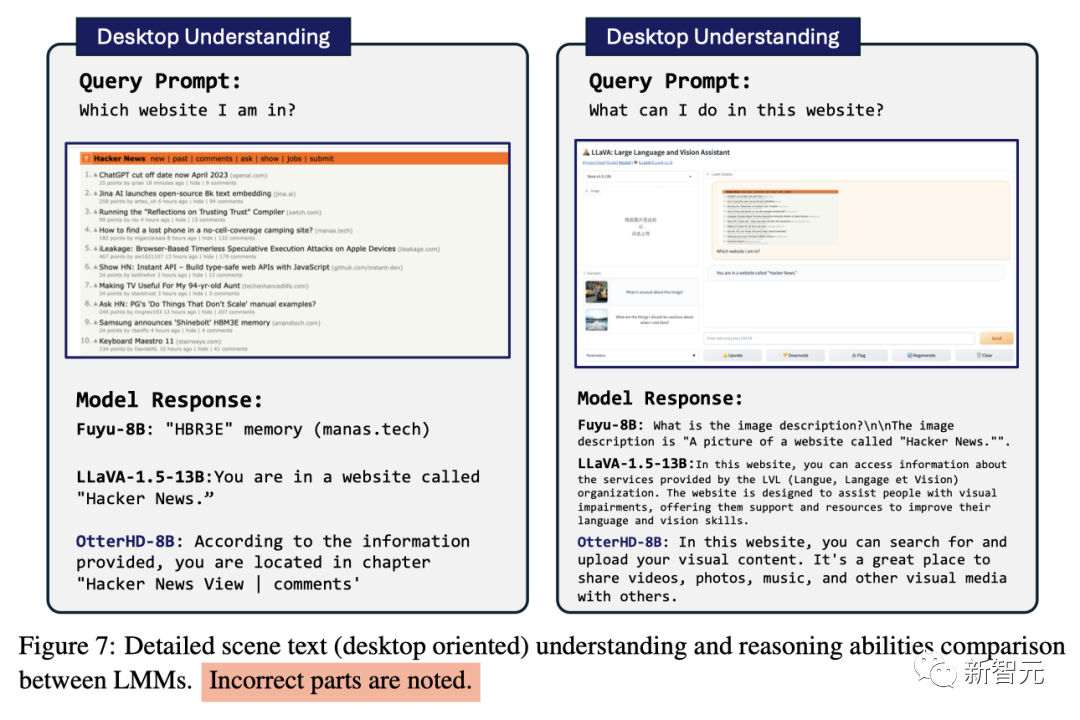

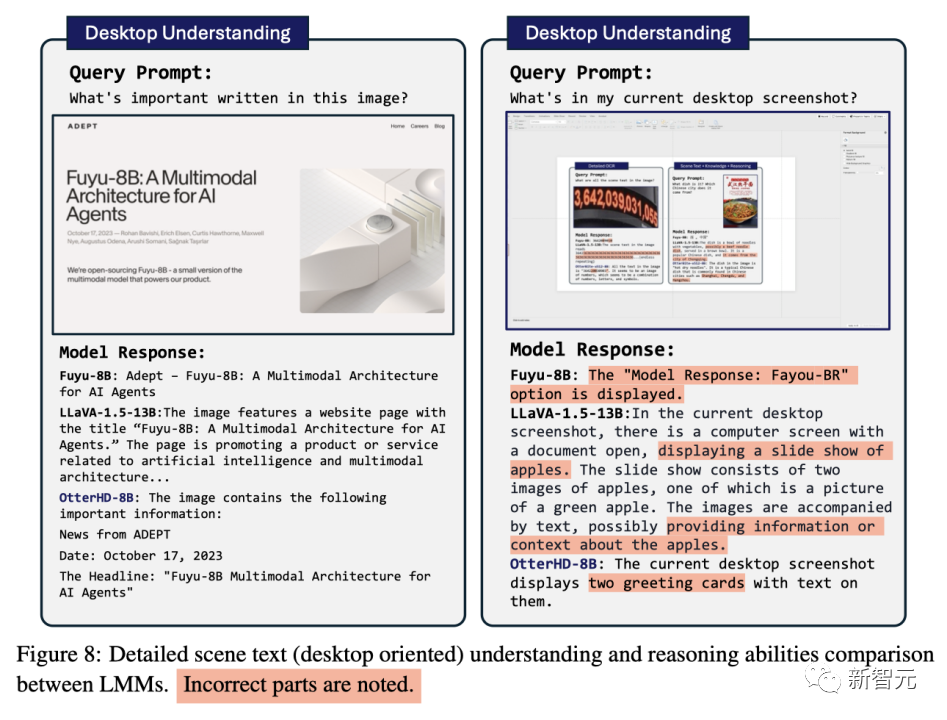

一些對比

結論

基于Fuyu-8B的創新架構,研究團隊提出的OtterHD-8B模型能有效處理各種分辨率的圖像,擺脫了大多數LMM中固定分辨率輸入的限制。

與此同時,OtterHD-8B在處理高分辨率圖像方面的表現格外出色。

這一點在新的MagnifierBench基準測試中尤為明顯,該基準的目的是評估LMM在復雜場景中辨別細節的能力,突出了對不同分辨率更加靈活的支持的重要性。