OpenAI最強競品訓練AI拆解LLM黑箱,意外窺見大模型「靈魂」

為了拆開大模型的「黑箱」,Anthropic可解釋性團隊發表了一篇論文,講述了他們通過訓練一個新的模型去理解一個簡單的模型的方法。

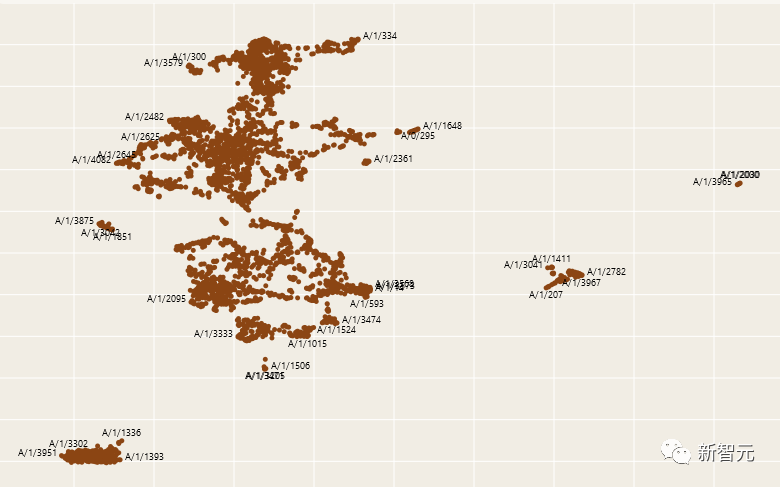

Anthropic發表的一項研究聲稱能夠看到了人工智能的靈魂。它看起來像這樣:

圖片

圖片

圖片

圖片

論文地址:https://transformer-circuits.pub/2023/monosemantic-features/index.html#phenomenology-fsa

在研究者看來,這個新的模型能準確地預測和理解原本模型中神經元的工作原理和組成機制。

Anthropic的可解釋性團隊最近宣布他們成功分解了一個模擬AI系統中的抽象高維特征空間。

創建一個可解釋的AI去理解「AI黑盒」

研究人員首先訓練了一個非常簡單的512神經元AI來預測文本,然后訓練了另一個名為「自動編碼器」的AI來預測第一個AI的激活模式。

自動編碼器被要求構建一組特征(對應更高維度AI中的神經元數量),并預測這些特征如何映射到真實AI中的神經元。

結果發現,盡管原始AI中的神經元本身不易理解,但是新的AI中的這些模擬神經元(也就是「特征」)是單義的,每特征都表示一個指定的概念或功能。

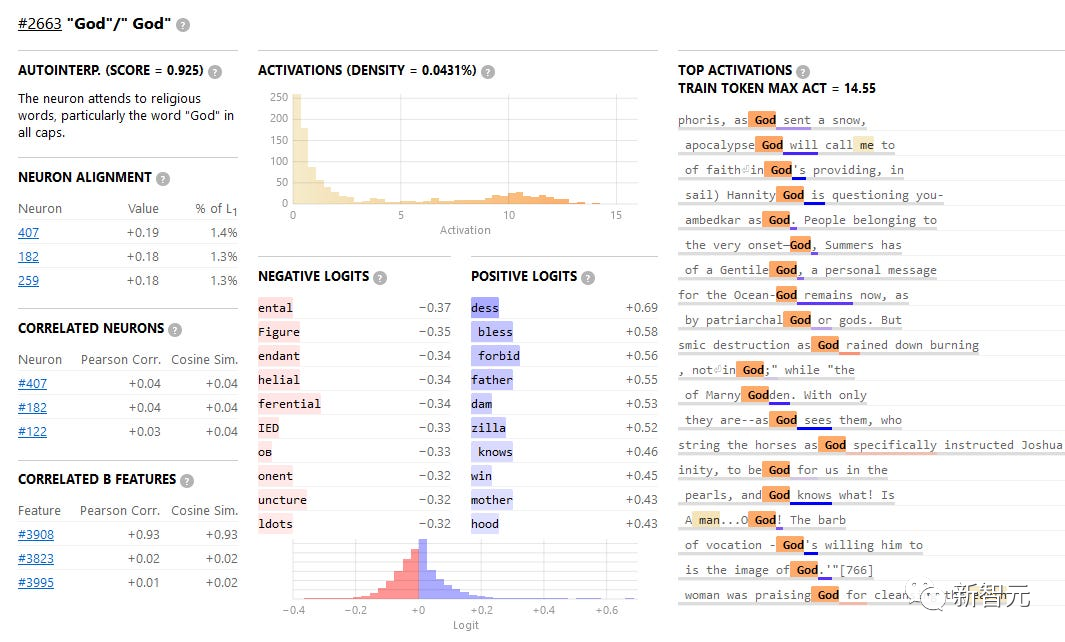

例如,特征#2663代表「God」這個概念。

圖片

圖片

激活它的訓練語句中最強的一條來自「Josephus」的記錄中「當God降下暴雪時,他前往Sepphoris」。

可以看到頂端的激活都是關于「God」的不同用法。

這個模擬神經元似乎是由一組真實神經元(包括407,182和259)組成的。

這些真實神經元本身與「God」沒有太大關系,例如神經元407主要對非英語(尤其是重音拉丁字母)和非標準文本(如HTML標簽)有響應。

但是在特征層面,一切都是井井有條的,當特征2663被激活時,它會增加文本中出現「bless」、「forbid」、「damn」或「-zilla」的概率。

這個AI并沒有將「God」這個概念與怪獸名字中的「God」區分開來。這可能是因為這個簡易AI沒有足夠的神經元資源來專門處理這個事。

但隨著AI具備的特征數量增加,這種情況會發生改變:

圖片

圖片

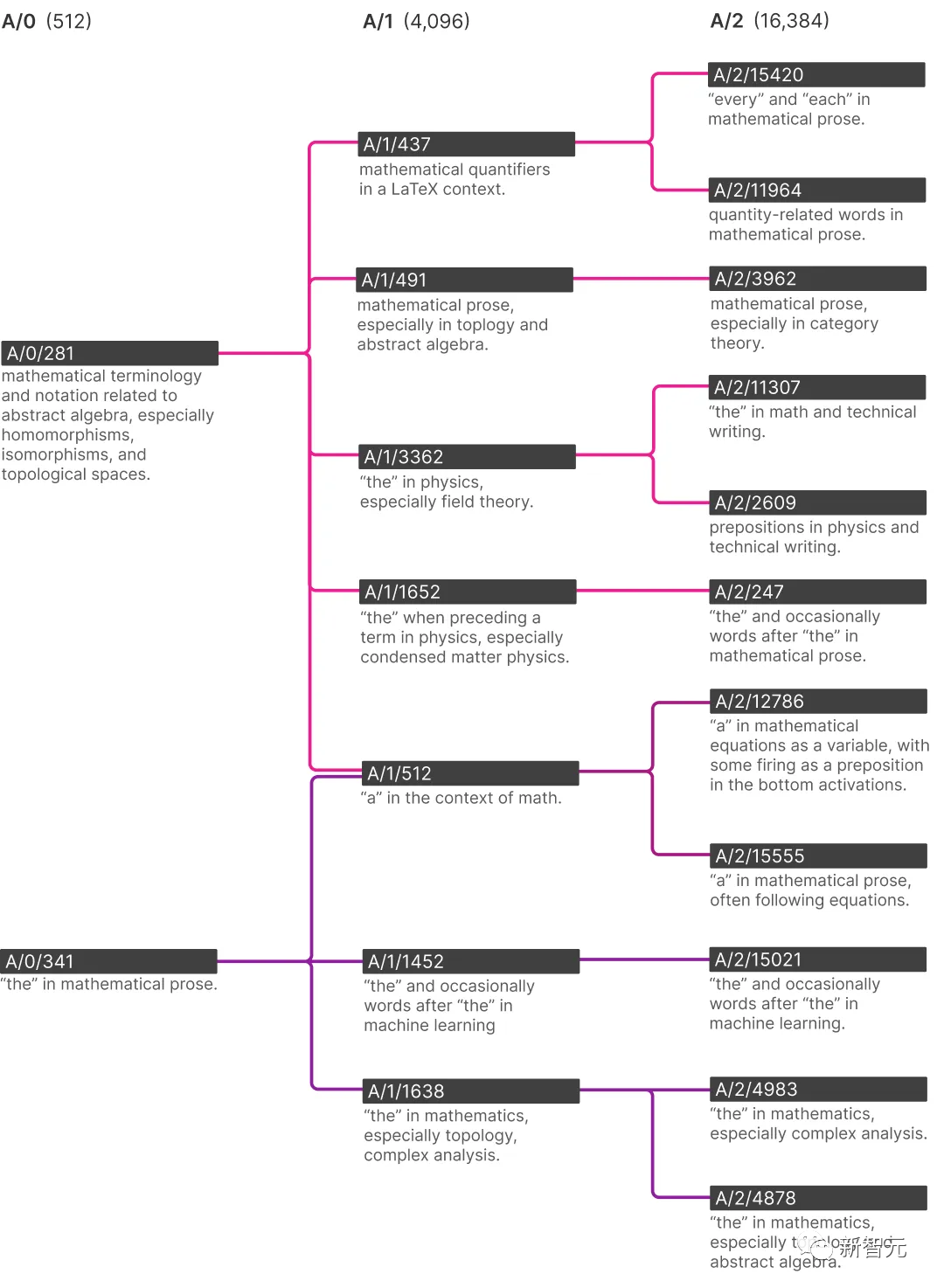

在這棵樹的底部,你可以看到當這個AI具有越來越多的特征時,它在數學術語中對「the」的理解是如何變化的。

首先,為什么會有一個數學術語中「the」的特定特征?這很可能是由于AI的預測需求——知道某些特定的「the」之后應該會跟隨一些數學詞匯,比如「numerator」或者「cosine」。

在研究人員訓練的最小的那個只有512個特征的AI中,只有一個表示「the」的特征,而在具有16384個特征的最大AI中,這個特征已經分支出了一個表示機器學習中「the」的特征,一個表示復分析中「the」的特征,以及一個表示拓撲學和抽象代數中「the」的特征。

因此,如果能將系統升級到一個具有更多模擬神經元的AI,那表示「God」的特征很可能會分裂成兩個——一個表示宗教中「God」的含義,另一個表示怪獸名字中「God」的含義。

后來,可能會有基督教中的God、猶太教中的God、哲學中的God等等。

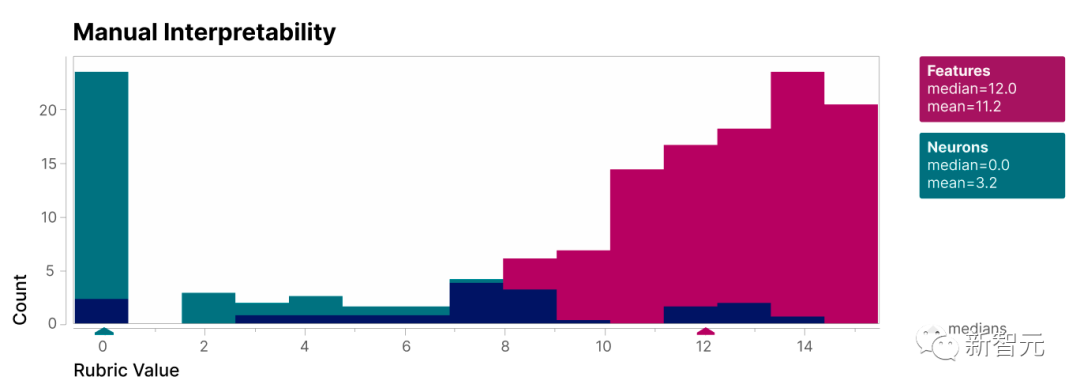

研究小組對412組真實神經元和相應的模擬神經元進行了主觀可解釋性評估,發現模擬神經元的可解釋性整體上比較好:

圖片

圖片

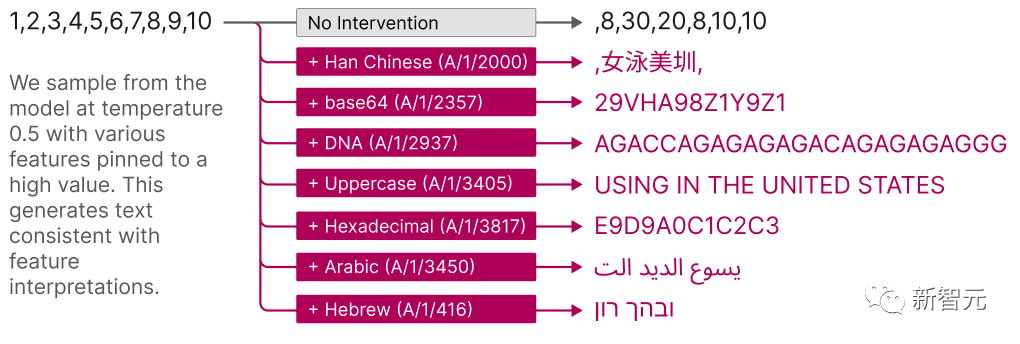

一些特征,比如表示「God」的特征,是用于特定概念的。

許多其他高度可解釋的特征,包括一些最可解釋的,是用于表示文本的「格式」,比如大寫或小寫字母、英語或其他字母表等。

圖片

圖片

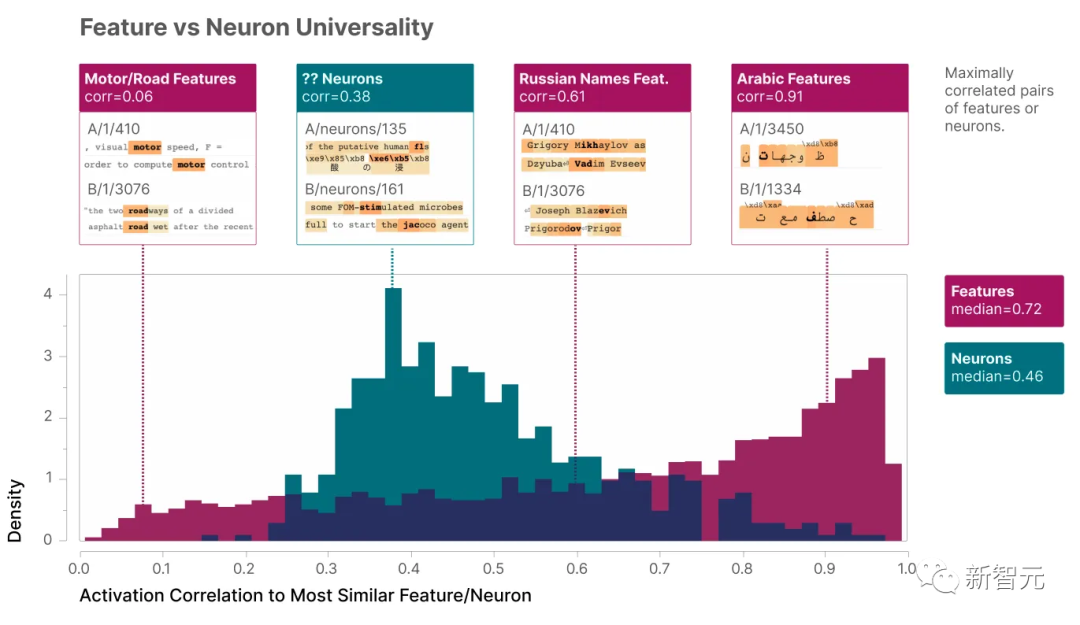

這些特征有多常見呢?也就是說,如果你在相同的文本數據上訓練兩個不同的4096個特征的AI,它們會有大部分相同的4096個特征嗎? 它們會都有某些代表「God」的特征嗎?

或者第一個AI會將「God」和「哥斯拉」放在一起,而第二個AI會將它們分開?第二個AI是否就完全不會有表示「God」的特征,而是用那個空間存儲一些第一個AI不可能理解的其他概念?

研究小組進行了測試,發現他們的兩個AI模型是非常相似的!

平均而言,如果第一個模型中有一個特征,第二個模型中最相似的特征會有0.72的中值相關性。

圖片

圖片

看到了AI的靈魂

后續的工作將是什么呢?

今年五月,OpenAI試圖讓GPT-4(非常大)理解GPT-2(非常小)。他們讓GPT-4檢查了GPT-2的個307200個神經元,并報告它發現的內容。

GPT-4找到了一系列有趣的結果和一堆隨機廢話,因為他們還沒有掌握將真實神經元投射到模擬神經元并分析模擬神經元的技巧。

盡管結果效果不明顯,但這確實是非常雄心勃勃的嘗試。

與Anthropic可解釋性文章中的這個AI不同,GPT-2是一個真實的(盡管非常小)AI,曾經也給大眾留下了深刻印象。

但是研究的最終目的是要能夠解釋主流的AI系統。

Anthropic的可解釋性團隊承認他們還沒有做到這一點,主要基于以下幾個原因:

首先,擴大自動編碼器的規模是一個很困難的事情。為了解釋GPT-4(或Anthropic的等效系統Claude)這樣的系統,你需要一個差不多同樣大小的解釋器AI。

但是訓練這樣規模的AI需要巨大的算力和資金支持。

其次,解釋的可擴展性也是一個問題。

即使我們找到了所有關于God、哥斯拉以及其他一切的模擬神經元,并畫出它們之間如何相連的巨大關系圖。

研究人員任然需要回答一些更復雜的問題,解決這些問題需要涉及成百上千萬的特征和連接的復雜交互。

所以需要一些自動化的流程,也就是某種更大規模的「讓GPT-4告訴我們GPT-2在做什么」。

最后,所有這些對理解人類大腦有什么啟發?

人類也使用神經網絡進行推理和處理概念。

人類大腦中有很多神經元,這一點和GPT-4是一樣的。

人類獲得的數據也非常稀疏——有很多概念(如烏賊)在日常生活中很少出現。

我們是否也在模擬一個更大的大腦?

目前這還是一個非常新的研究領域,但已經有一些初步的發現,表明人類視覺皮層中的神經元確實以某種超定位的方式編碼特征,與AI模型中觀察到的模式相似。

參考資料:https://transformer-circuits.pub/2023/monosemantic-features/index.html#phenomenology-fsa