一張照片生成視頻,張嘴、點(diǎn)頭、喜怒哀樂(lè),都可以打字控制

視頻 PS 可以靈活到什么程度?最近,微軟的一項(xiàng)研究提供了答案。

在這項(xiàng)研究中,你只要給 AI 一張照片,它就能生成照片中人物的視頻,而且人物的表情、動(dòng)作都是可以通過(guò)文字進(jìn)行控制的。比如,如果你給的指令是「張嘴」,視頻中的人物就會(huì)真的張開(kāi)嘴。

如果你給的指令是「?jìng)摹梗蜁?huì)做出傷心的表情和頭部動(dòng)作。

當(dāng)給出指令「驚訝」,虛擬人物的抬頭紋都擠到一起了。

此外,你還可以給定一段語(yǔ)音,讓虛擬人物的嘴型、動(dòng)作都和語(yǔ)音對(duì)上。或者給定一段真人視頻讓虛擬人物去模仿。

如果你對(duì)虛擬人物動(dòng)作有更多的自定義編輯需求,比如讓他們點(diǎn)頭、轉(zhuǎn)頭或歪頭,這項(xiàng)技術(shù)也是支持的。

這項(xiàng)研究名叫 GAIA(Generative AI for Avatar,用于虛擬形象的生成式 AI),其 demo 已經(jīng)開(kāi)始在社交媒體傳播。不少人對(duì)其效果表示贊嘆,并希望用它來(lái)「復(fù)活」逝者。

但也有人擔(dān)心,這些技術(shù)的持續(xù)進(jìn)化會(huì)讓網(wǎng)絡(luò)視頻變得更加真假難辨,或者被不法分子用于詐騙。看來(lái),反詐手段要繼續(xù)升級(jí)了。

GAIA 有什么創(chuàng)新點(diǎn)?

會(huì)說(shuō)話的虛擬人物生成旨在根據(jù)語(yǔ)音合成自然視頻,生成的嘴型、表情和頭部姿勢(shì)應(yīng)與語(yǔ)音內(nèi)容一致。以往的研究通過(guò)實(shí)施特定虛擬人物訓(xùn)練(即為每個(gè)虛擬人物訓(xùn)練或調(diào)整特定模型),或在推理過(guò)程中利用模板視頻實(shí)現(xiàn)了高質(zhì)量的結(jié)果。最近,人們致力于設(shè)計(jì)和改進(jìn)零樣本會(huì)說(shuō)話的虛擬人物的生成方法(即僅有一張目標(biāo)虛擬人物的肖像圖片可以用于外貌參考)。不過(guò),這些方法通過(guò)采用基于 warping 的運(yùn)動(dòng)表示、3D Morphable Model(3DMM)等領(lǐng)域先驗(yàn)來(lái)降低任務(wù)難度。這些啟發(fā)式方法雖然有效,但卻阻礙了從數(shù)據(jù)分布中直接學(xué)習(xí),并可能導(dǎo)致不自然的結(jié)果和有限的多樣性。

本文中,來(lái)自微軟的研究者提出了 GAIA(Generative AI for Avatar),其能夠從語(yǔ)音和單張肖像圖片合成自然的會(huì)說(shuō)話的虛擬人物視頻,在生成過(guò)程中消除了領(lǐng)域先驗(yàn)。

項(xiàng)目地址:https://microsoft.github.io/GAIA/

論文地址:https://arxiv.org/pdf/2311.15230.pdf

GAIA 揭示了兩個(gè)關(guān)鍵洞見(jiàn):

- 用語(yǔ)音來(lái)驅(qū)動(dòng)虛擬人物運(yùn)動(dòng),而虛擬人物的背景和外貌(appearance)在整個(gè)視頻中保持不變。受此啟發(fā),本文將每一幀的運(yùn)動(dòng)和外貌分開(kāi),其中外貌在幀之間共享,而運(yùn)動(dòng)對(duì)每一幀都是唯一的。為了根據(jù)語(yǔ)音預(yù)測(cè)運(yùn)動(dòng),本文將運(yùn)動(dòng)序列編碼為運(yùn)動(dòng)潛在序列,并使用以輸入語(yǔ)音為條件的擴(kuò)散模型來(lái)預(yù)測(cè)潛在序列;

- 當(dāng)一個(gè)人在說(shuō)出給定的內(nèi)容時(shí),表情和頭部姿態(tài)存在巨大的多樣性,這需要一個(gè)大規(guī)模和多樣化的數(shù)據(jù)集。因此,該研究收集了一個(gè)高質(zhì)量的能說(shuō)話的虛擬人物數(shù)據(jù)集,該數(shù)據(jù)集由 16K 個(gè)不同年齡、性別、皮膚類型和說(shuō)話風(fēng)格的獨(dú)特說(shuō)話者組成,使生成結(jié)果自然且多樣化。

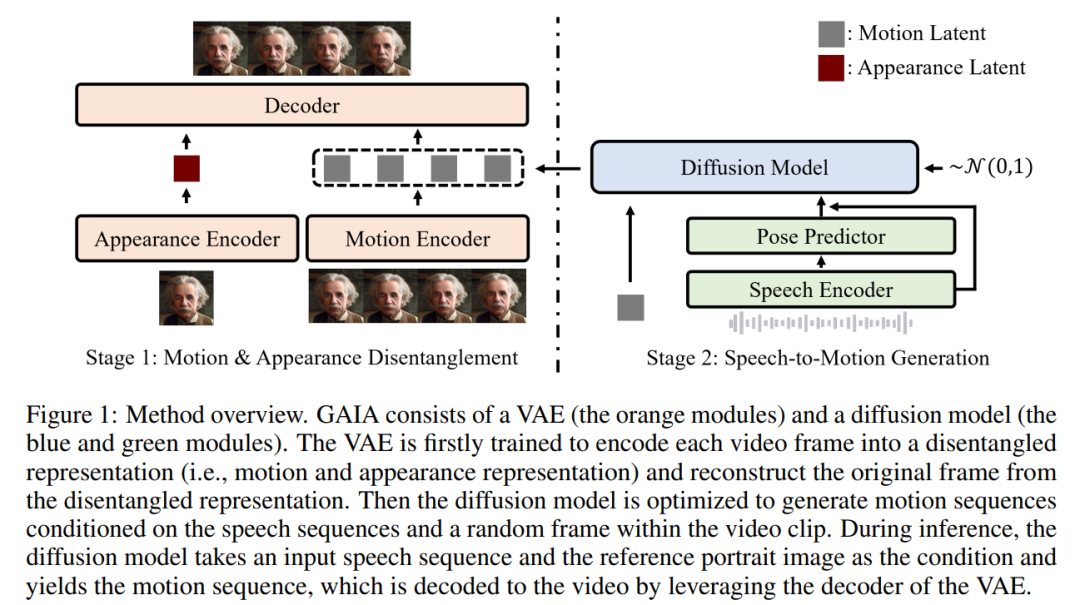

根據(jù)上述兩個(gè)洞見(jiàn),本文提出了 GAIA 框架,其由變分自編碼器 (VAE)(橙色模塊)和擴(kuò)散模型(藍(lán)色和綠色模塊)組成。

VAE 主要用來(lái)分解運(yùn)動(dòng)和外貌,其包含兩個(gè)編碼器(即運(yùn)動(dòng)編碼器和外貌編碼器)和一個(gè)解碼器。在訓(xùn)練過(guò)程中,運(yùn)動(dòng)編碼器的輸入是當(dāng)前幀的面部關(guān)鍵點(diǎn)(landmarks),而外貌編碼器的輸入是當(dāng)前視頻剪輯中的隨機(jī)采樣的幀。

隨后根據(jù)這兩個(gè)編碼器的輸出,優(yōu)化解碼器以重建當(dāng)前幀。在獲得了訓(xùn)練好的 VAE 后,就得到了所有訓(xùn)練數(shù)據(jù)的潛在運(yùn)動(dòng)(即運(yùn)動(dòng)編碼器的輸出)。

接著,本文訓(xùn)練了一個(gè)擴(kuò)散模型來(lái)預(yù)測(cè)以語(yǔ)音和視頻剪輯中的一個(gè)隨機(jī)采樣幀為條件的運(yùn)動(dòng)潛在序列,這為生成過(guò)程提供了外貌信息。

在推理過(guò)程中,給定目標(biāo)虛擬人物的參考肖像圖像,擴(kuò)散模型將圖像和輸入語(yǔ)音序列作為條件,生成符合語(yǔ)音內(nèi)容的運(yùn)動(dòng)潛在序列。然后,生成的運(yùn)動(dòng)潛在序列和參考肖像圖像經(jīng)過(guò) VAE 解碼器合成說(shuō)話視頻輸出。

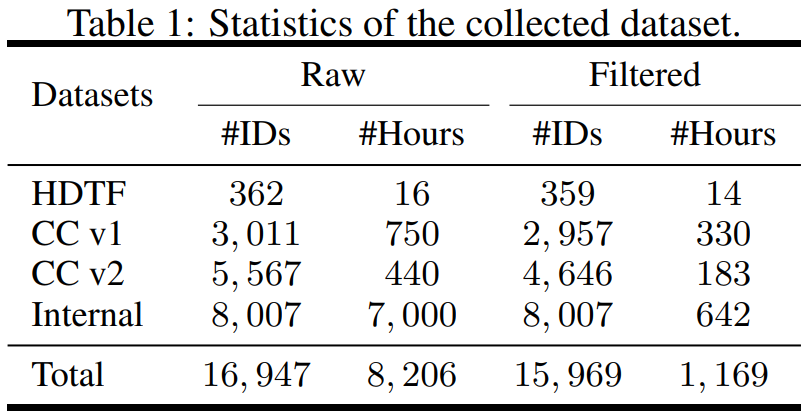

在數(shù)據(jù)方面。該研究從不同的來(lái)源構(gòu)建數(shù)據(jù)集,他們收集的數(shù)據(jù)集包括 HighDefinition Talking Face Dataset (HDTF) 和 Casual Conversation datasets v1&v2 (CC v1&v2) 。除了這三個(gè)數(shù)據(jù)集之外,該研究還收集了一個(gè)大規(guī)模的內(nèi)部說(shuō)話虛擬人物(internal talking avatar)數(shù)據(jù)集,其中包含 7K 小時(shí)的視頻和 8K 說(shuō)話者 ID。數(shù)據(jù)集統(tǒng)計(jì)的概述如表 1 所示。

為了能夠從數(shù)據(jù)中學(xué)習(xí)到所需的信息,本文還提出了幾種自動(dòng)過(guò)濾策略來(lái)確保訓(xùn)練數(shù)據(jù)的質(zhì)量:

- 為了使嘴唇運(yùn)動(dòng)可見(jiàn),頭像的正面方向應(yīng)朝向相機(jī);

- 為了保證穩(wěn)定性,視頻中的面部動(dòng)作要流暢,不能出現(xiàn)快速晃動(dòng);

- 為了過(guò)濾掉嘴唇動(dòng)作和言語(yǔ)不一致的極端情況,應(yīng)該刪除頭像戴口罩或保持沉默的幀。

本文在過(guò)濾后的數(shù)據(jù)上訓(xùn)練 VAE 和擴(kuò)散模型。從實(shí)驗(yàn)結(jié)果來(lái)看,本文得到了三個(gè)關(guān)鍵結(jié)論:

- GAIA 能夠進(jìn)行零樣本說(shuō)話虛擬人物生成,在自然度、多樣性、口型同步質(zhì)量和視覺(jué)質(zhì)量方面具有優(yōu)越的性能。根據(jù)研究者的主觀評(píng)價(jià),GAIA 顯著超越了所有基線方法;

- 訓(xùn)練模型的大小從 150M 到 2B 不等,結(jié)果表明,GAIA 具有可擴(kuò)展性,因?yàn)檩^大的模型會(huì)產(chǎn)生更好的結(jié)果;

- GAIA 是一個(gè)通用且靈活的框架,可實(shí)現(xiàn)不同的應(yīng)用,包括可控的說(shuō)話虛擬人物生成和文本 - 指令虛擬人物生成。

GAIA 效果怎么樣?

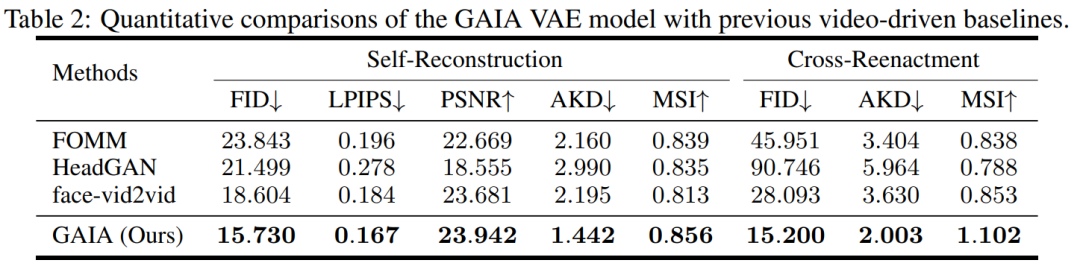

實(shí)驗(yàn)過(guò)程中,該研究將 GAIA 與三個(gè)強(qiáng)大的基線進(jìn)行比較,包括 FOMM、HeadGAN 和 Face-vid2vid。結(jié)果如表 2 所示:GAIA 中的 VAE 比以前的視頻驅(qū)動(dòng)基線實(shí)現(xiàn)了持續(xù)的改進(jìn),這說(shuō)明 GAIA 成功地分解了外貌和運(yùn)動(dòng)表示。

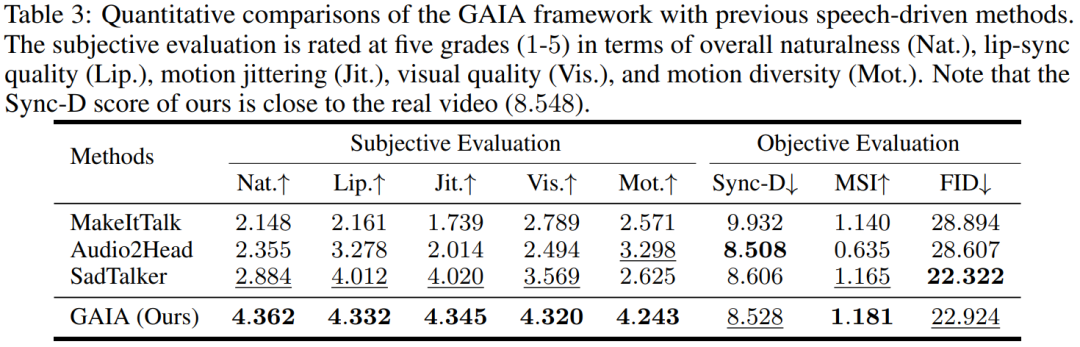

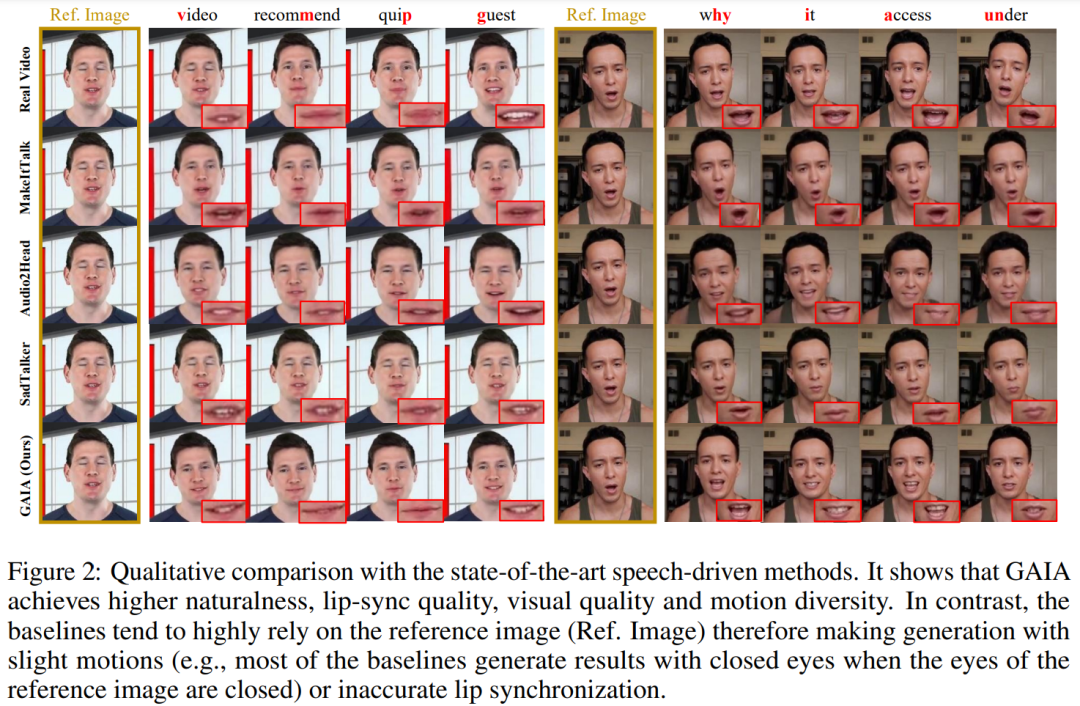

語(yǔ)音驅(qū)動(dòng)結(jié)果。用語(yǔ)音驅(qū)動(dòng)說(shuō)話虛擬人物生成是通過(guò)從語(yǔ)音預(yù)測(cè)運(yùn)動(dòng)實(shí)現(xiàn)的。表 3 和圖 2 提供了 GAIA 與 MakeItTalk、Audio2Head 和 SadTalker 方法的定量和定性比較。

可以看出,GAIA 在主觀評(píng)價(jià)方面大幅超越了所有基線。更具體地說(shuō),如圖 2 所示,即使參考圖像是閉著眼睛或不尋常的頭部姿態(tài)給出的,基線方法的生成往往高度依賴于參考圖像,相比之下,GAIA 對(duì)各種參考圖像具有魯棒性,并生成具有更高自然度、口型高度同步、視覺(jué)質(zhì)量更好以及運(yùn)動(dòng)多樣性的結(jié)果。

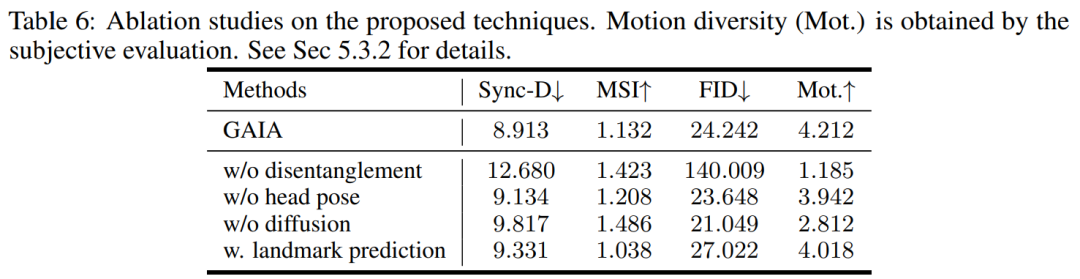

如表 3 所示,最佳 MSI 分?jǐn)?shù)表明 GAIA 生成的視頻具有出色的運(yùn)動(dòng)穩(wěn)定性。Sync-D 得分為 8.528,接近真實(shí)視頻的得分 (8.548),說(shuō)明生成的視頻具有出色的唇形同步性。該研究獲得了與基線相當(dāng)?shù)?FID 分?jǐn)?shù),這可能是受到了不同頭部姿態(tài)的影響,因?yàn)樵撗芯堪l(fā)現(xiàn)未經(jīng)擴(kuò)散訓(xùn)練的模型在表中實(shí)現(xiàn)了更好的 FID 分?jǐn)?shù),如表 6 所示。