word2vec作者曝與Ilya等十年積怨:seq2seq也是我的想法

里程碑式論文word2vec獲得NeurIPS時間檢驗獎,可謂實至名歸。

但一作Tomas Mikolov在Facebook上發表的長篇獲獎感言,卻充滿了失望和不滿。

圖片

圖片

論文最初被ICLR拒稿都算小事了,他還暗諷了OpenAI首席科學家Ilya Sutskever(當時兩人都在谷歌):

我們當然生活在激動人心的時代,但不要對那些“想要壟斷基于數十上百位科學家辛勤工作的技術、同時聲稱這一切都是為了人類利益的人”抱有太多信心。

圖片

圖片

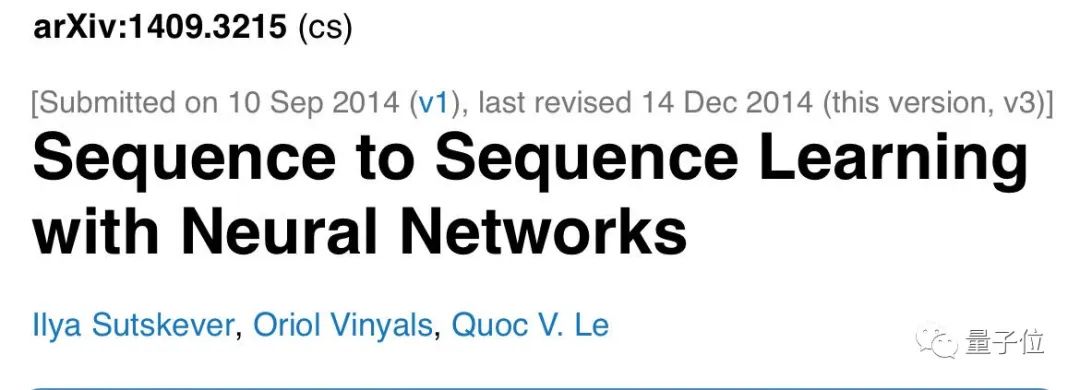

Mikolov話中所指的是word2vec之后又一個里程碑式研究seq2seq,發表于2014年,不出意外的話也將會獲得2024年的NeurIPS時間檢驗獎。

Tomas Mikolov聲稱seq2seq的想法最初來自于他,在谷歌大腦工作期間與Quoc Le和Ilya有過多次討論。

但他跳槽到Facebook后,很驚訝看到最終發表的成果中自己沒有成為共同作者。

圖片

圖片

這正是金錢大量流入AI領域的時候,每個想法都價值連城。

看到深度學習社區迅速變成某種權力的游戲,我很悲哀。金錢和權力確實會腐蝕人心……

從word2vec到seq2seq

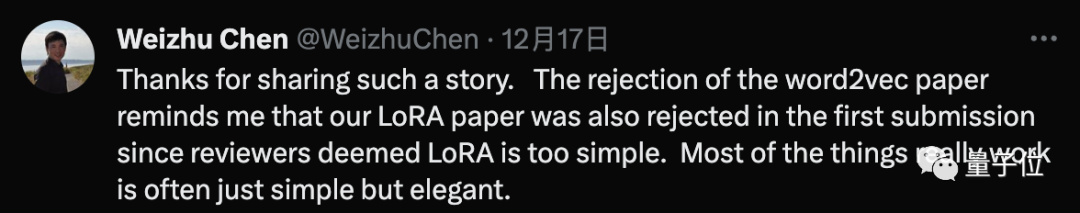

最初word2vec論文投稿到首屆ICLR會議(當時還只是一個workshop),盡管接受率高達70%,但還是被據搞了。

這讓Mikolov感慨,審稿人想要預測一篇論文未來的影響是多么困難。

不少研究者都有同感,如今在大模型與AI繪畫都大量應用的LoRA作者微軟Weizhu Chen透露,當初第一次投稿時也被拒了,因為審稿人認為太簡單。

大多數真正有效的事情往往都是簡單而優雅的。

圖片

圖片

Mikolov這些年聽到了很多對word2vec的評論,正面負面都有,但并沒有真正在網絡上回應過。

不知何故,研究界不斷被某些人的公關式宣傳淹沒,他們用這種方式博取引用數和別人的注意力,我不想成為其中一份子。

借著這次獲獎加10周年的機會,Mikolov分享了一些這篇經典論文的背后故事。

首先是很多人抱怨word2vec的代碼很難理解,甚至有人以為Mikolov是故意讓大家看不懂的。

現在他澄清了“不,我還沒那么邪惡”,只是在等待被批準發布代碼的幾個月中試圖讓它更短、更快,最終代碼被過度優化了。

現在回想起來,如果谷歌大腦團隊中沒有Greg Corrado和Jeff Dean,我懷疑是否會獲得批準——我認為word2vec可能是谷歌開源的第一個廣為人知的AI項目。

盡管word2vec是Mikolov被引用次數最高的論文,但他卻從未認為這是自己最有影響力的項目。

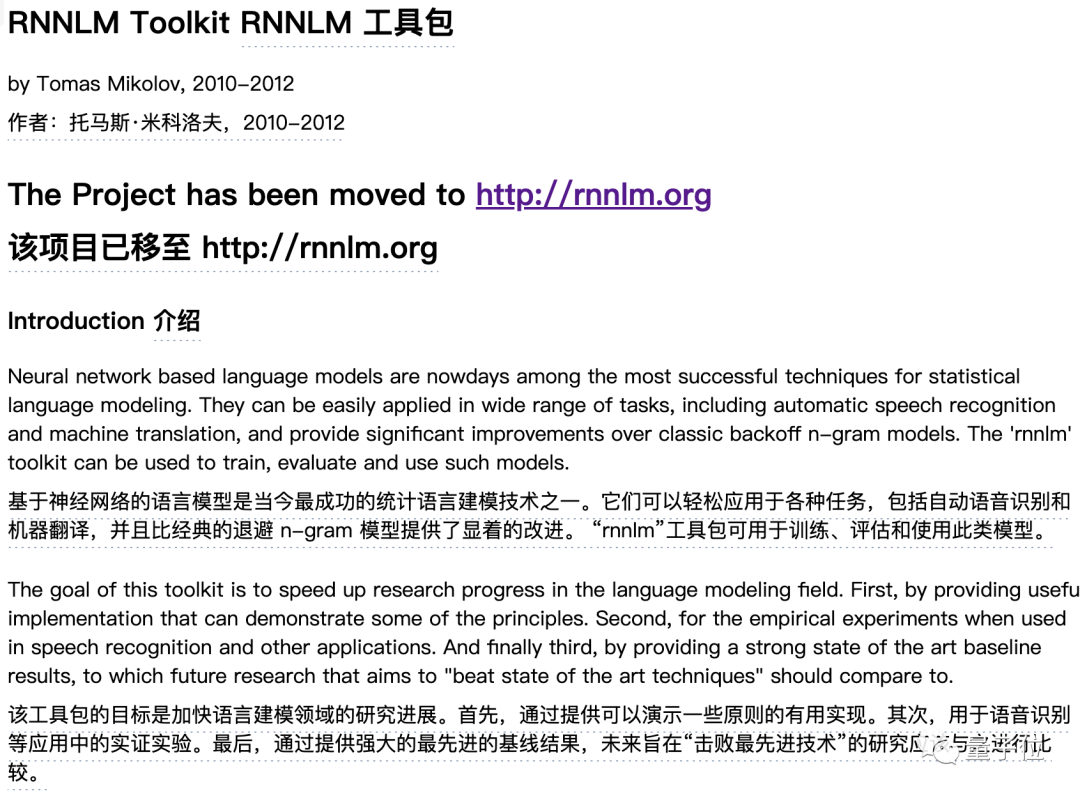

實際上word2vec最初是他的RNNLM項目中一個子集,這個項目很快被人們遺忘了。

在我看來,它至少和AlexNet一樣具有顛覆性。

RNNLM開始于2010年,深度學習還處在黑暗時代,Mikolov列舉了其中首次展示的想法:

- 循環神經網絡的可擴展訓練,他提出了梯度裁剪(Gradient Clipping)

- 神經語言模型首次生成文本,他從2007年開始就展示這樣的例子

- 動態評估

- 字符和子詞級的神經語言建模

- 神經語言模型適應,現在被稱為微調

- 第一個公開可用的語言模型評測基準,也就是修改后的Penn Treebank數據集

圖片

圖片

2012年,Mikolov從捷克布爾諾理工大學博士畢業后加入了谷歌大腦。

他表示自己很幸運,那里有大量神經網絡的信徒,允許自己研究word2vec、展示其潛力,但他不想給人們留下一切都很完美的印象。

在word2vec之后,Mikolov想通過改進谷歌翻譯來普及神經語言模型。開始與Franz Och的團隊合作,期間提出了幾個可以補充甚至取代當時機器翻譯的模型。

核心想法在他加入谷歌大腦之前就已經提出,也就是在不同語言句子對上訓練,然后使用生成模型翻譯看到的第一句話。

當時在短句子上效果很好,較長句子效果還不佳。他與谷歌大腦中的其他人(主要是Quoc Le和Ilya Sutskever)多次討論過這個項目,他們在自己跳槽到Facebook后接手。

當他們最終以現在著名的“seq2seq”發表我的想法時,我感到非常驚訝,不僅沒有提到我作為合著者,而且我的老朋友們也忘記在論文致謝部分提到我,他們感謝了谷歌大腦中除了我之外的每一個人。

……

大家看到Mikolov的長篇感言,也是百感交集。

圖片

圖片

康奈爾大學助理教授Volodymyr Kuleshov借word2vec被拒稿的故事,鼓勵大家不要因論文同行評議過程而灰心,“好的想法終會得到應有的認可”。

圖片

圖片

也有人認為,Mikolov指出的貢獻分配、引用數量和影響力等問題,不光是NLP的問題,而是整個AI領域都存在。

圖片

圖片

參考鏈接:

[1]https://www.facebook.com/tomas.mikolov/posts/pfbid0avhBpB2WULd3KNtAieyiDCFpP9MQggxW1xSh6RXZDjWF6sGzgpYa638KMAyF75JSl[2]https://twitter.com/AravSrinivas/status/1736090919718605169[3]https://www.fit.vutbr.cz/~imikolov/rnnlm/