14秒就能重建視頻,還能變換角色,Meta讓視頻合成提速44倍

就今天的人工智能發展水平來說,文生圖、圖生視頻、圖像/視頻風格遷移都已經不算什么難事。

生成式 AI 天賦異稟,能夠毫不費力地創建或修改內容。尤其是圖像編輯,在以十億規模數據集為基礎預訓練的文本到圖像擴散模型的推動下,經歷了重大發展。這股浪潮催生了大量圖像編輯和內容創建應用。

基于圖像的生成模型所取得的成就基礎上,下一個挑戰的領域必然是為其增加「時間維度」,從而實現輕松而富有創意的視頻編輯。

一種直接策略是使用圖像模型逐幀處理視頻,然而,生成式圖像編輯本身就具有高變異性—即使根據相同的文本提示,也存在無數種編輯給定圖像的方法。如果每一幀都獨立編輯,很難保持時間上的一致性。

在最近的一篇論文中,來自Meta GenAI團隊的研究者提出了 Fairy——通過對圖像編輯擴散模型進行「簡單的改編」,大大增強了AI在視頻編輯上的表現。

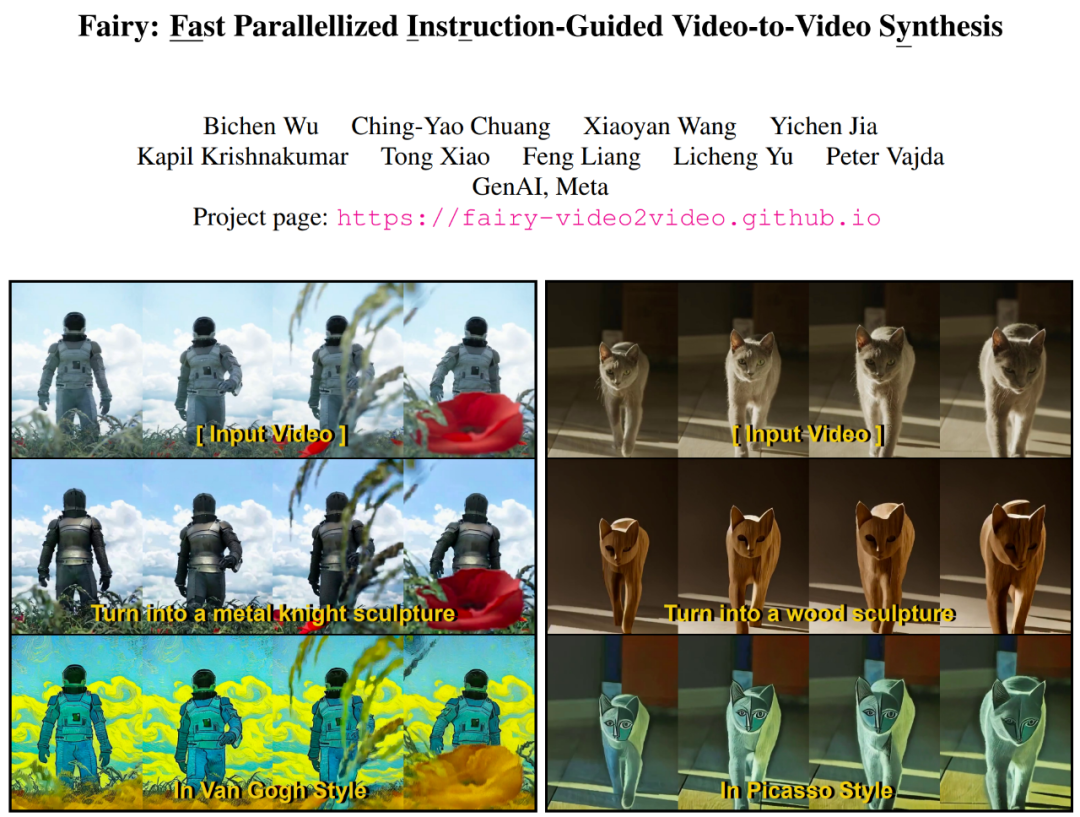

以下是Fairy的編輯視頻效果展示:

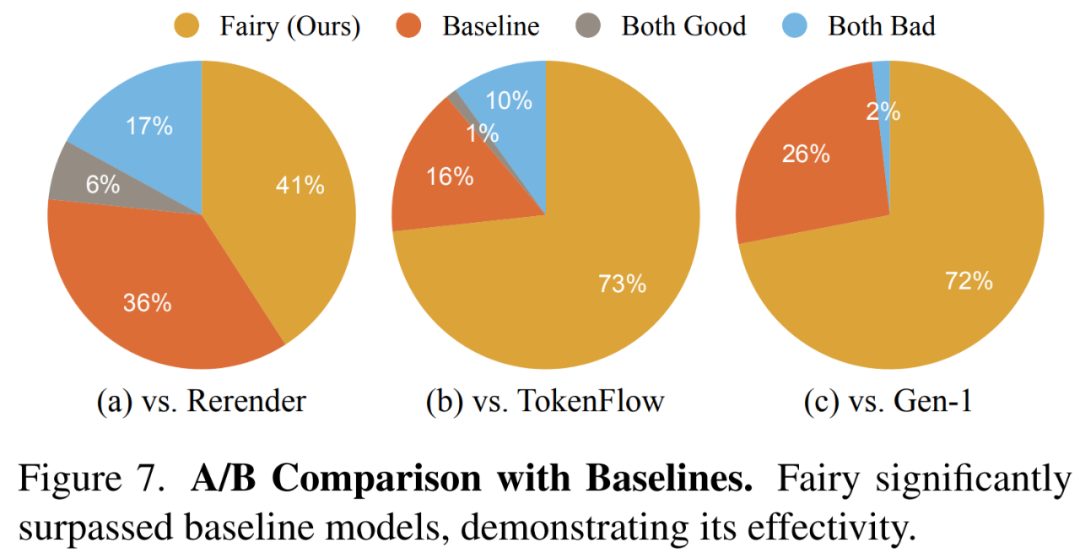

Fairy 生成 120 幀 512×384 視頻(4 秒時長,30 FPS)的時間僅為 14 秒,比之前的方法至少快 44 倍。一項涉及 1000 個生成樣本的全面用戶研究證實,該方法生成質量上乘,明顯優于現有方法。

怎么做到的?

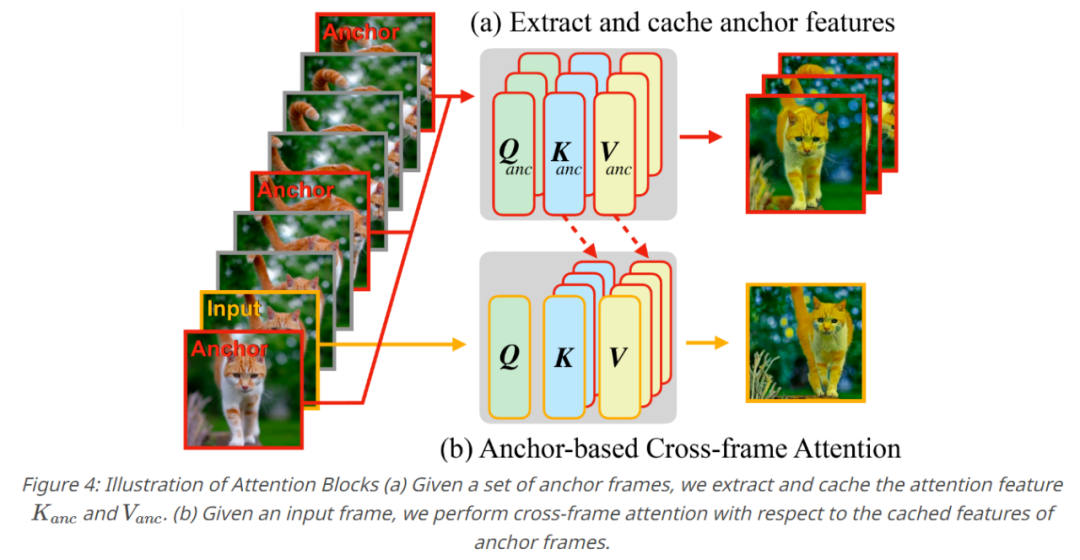

據論文介紹,Fairy以基于錨點的跨幀注意力概念為核心,這種機制可隱性地跨幀傳播擴散特征,確保了時間一致和高保真的合成效果。Fairy 不僅解決了以往模型在內存和處理速度等方面的局限性,還通過獨特的數據增強策略提高了時間一致性,這種策略使模型等價于源圖像和目標圖像的仿射變換。

- 論文地址:https://arxiv.org/pdf/2312.13834.pdf

- 項目主頁:https://fairy-video2video.github.io/

方法

Fairy在擴散模型特征的背景下對以前的跟蹤-傳播(tracking-and-propagation)范式進行了重新審視。特別是,該研究用對應估計( correspondence estimation)架起了跨幀注意之間的橋梁,使得模型在擴散模型內可以跟蹤和傳播中間特征。

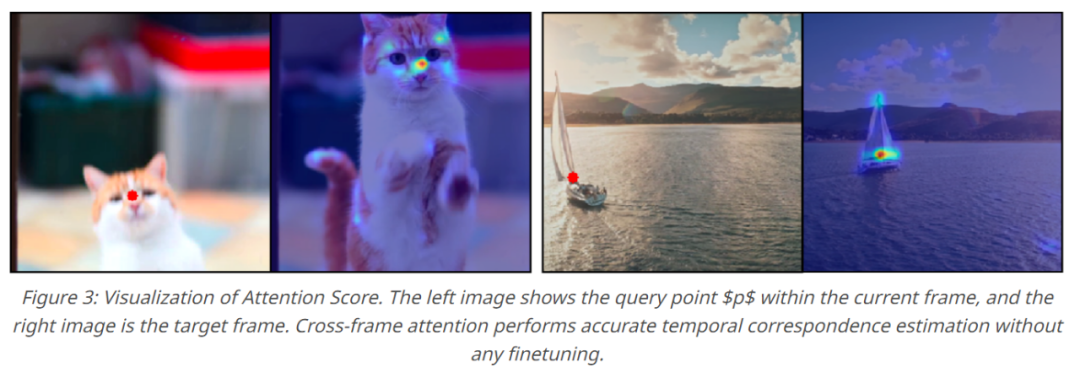

跨幀的注意力圖可以解釋為一種相似性度量,用來評估各個幀中token之間的對應關系,其中一個語義區域的特征會將更高的注意力分配給其他幀中的相似語義區域,如下圖3所示 。

因此,當前的特征表示通過注意力幀間相似區域的加權和進行細化和傳播,從而有效地最小化幀之間的特征差異。

一系列操作下來產生了基于錨點的模型,這是 Fairy 的核心組件。

為了確保生成視頻的時間一致性,該研究采樣了K個錨點幀,從而提取擴散特征,并且提取的特征被定義為一組要傳播到連續幀的全局特征。當生成每個新幀時,該研究針對錨點幀的緩存特征將自注意力層替換為跨幀注意力。通過跨幀注意力,每個幀中的 token都采用錨點幀中表現出類似語義內容的特征,從而增強一致性。

實驗評估

在實驗部分,研究者主要基于指令型圖像編輯模型來實現Fairy,并使用跨幀注意力替換模型的自注意力。他們將錨幀的數量設置為3。模型可以接受不同長寬比的輸入,并將較長尺寸的輸入分辨率重新擴展為512,并保持長寬比不變。研究者對輸入視頻的所有幀進行編輯,而不進行下采樣。所有計算在8塊A100 GPU上分配完成。

定性評估

研究者首先展示了Fairy的定性結果,如下圖5所示,Fairy可以對不同的主題進行編輯。

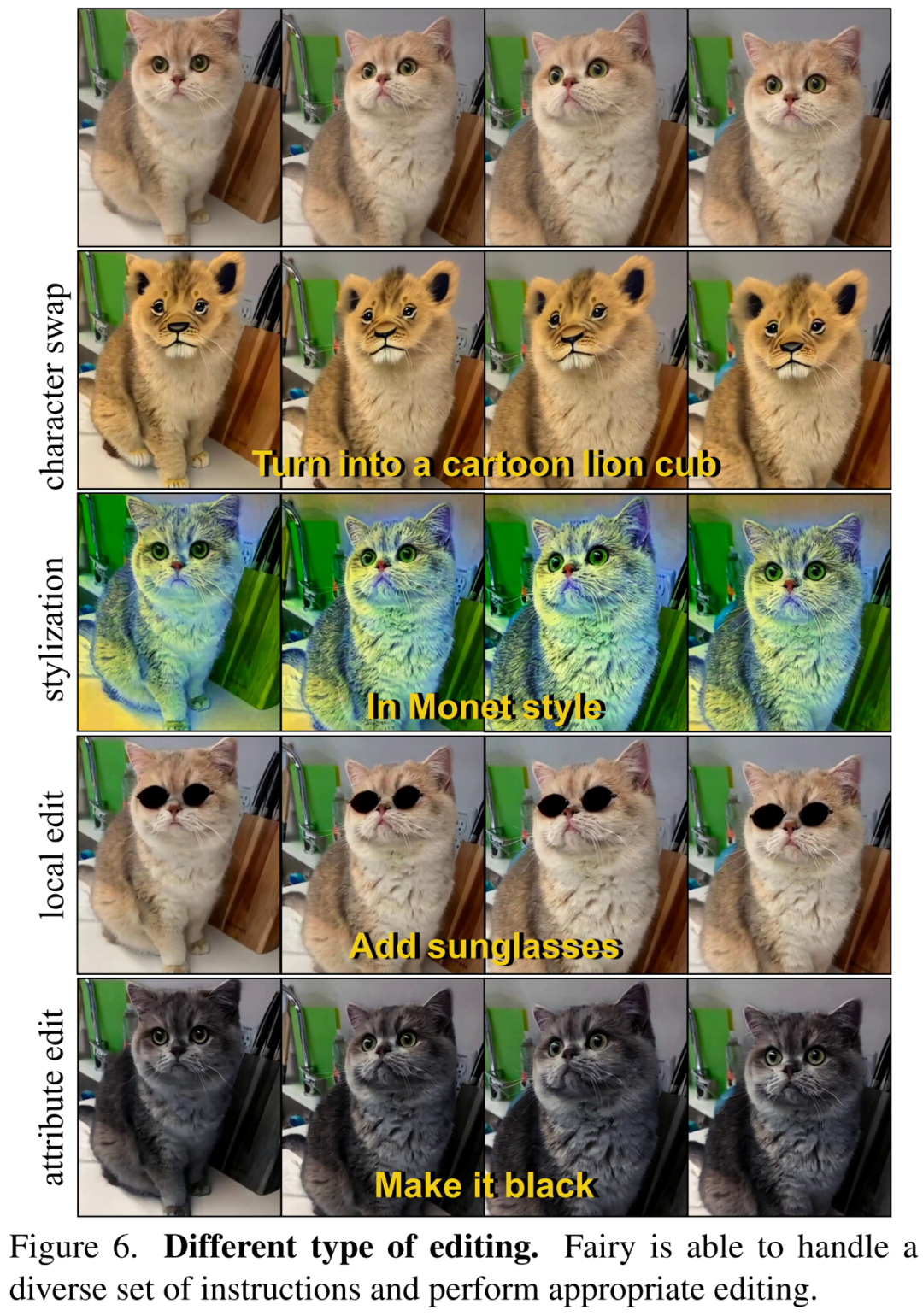

在下圖6中,研究者展示了Fairy可以按照文本指令來進行不同類型的編輯,包括風格化、角色變化、局部編輯、屬性編輯等。

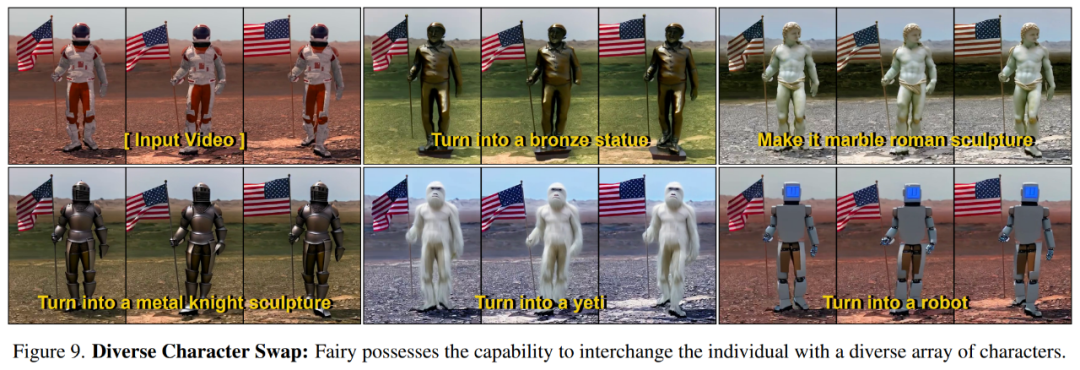

下圖9展示了Fairy可以根據指令將源角色轉換為不同的目標角色。

定量評估

研究者在下圖7中展示了整體質量比較結果,其中Fairy生成的視頻更受歡迎。

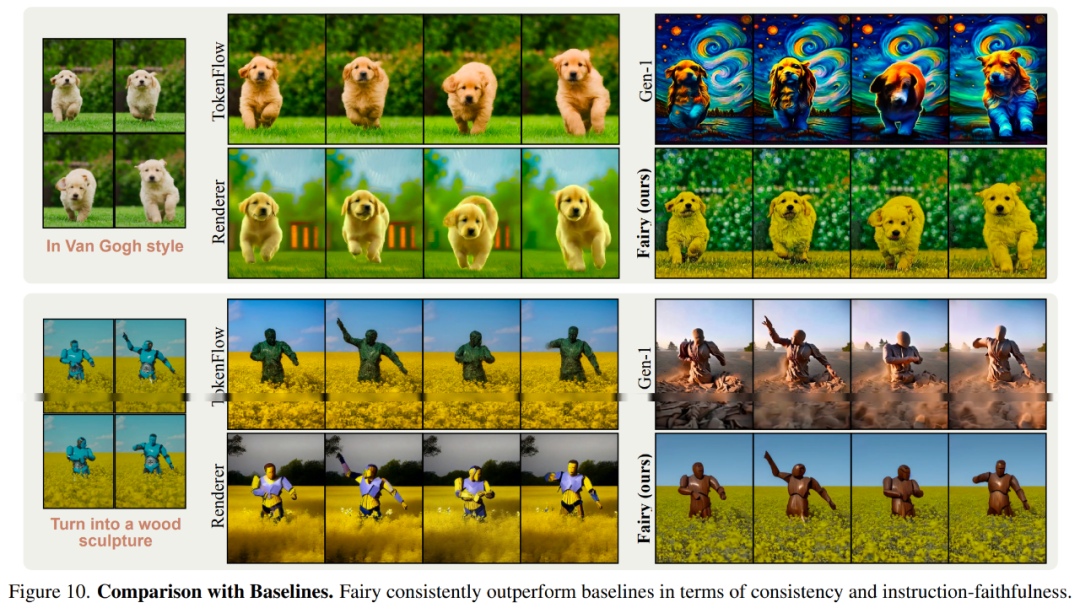

下圖10展示了與基線模型的視覺比較結果。

更多技術細節和實驗結果參閱原論文。