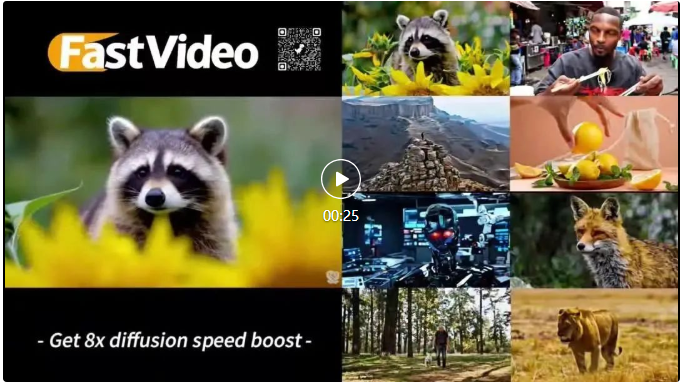

騰訊版Sora開源后,被提速八倍!官方點贊并預告:下月上新圖生視頻

提速8倍!

速度更快、效果更好的混元視頻模型——FastHunyuan來了!

新模型僅用1分鐘就能生成5秒長的視頻,比之前提速8倍,步驟也從50步減少到了6步,甚至畫面細節(jié)也更逼真了。

和普通速度的混元對比一下,原來50步才能生成1條視頻,而現在新模型在相同的時間里可以生成8條:

再來看看和Sora的畫面對比,可以看到Fast-Hunyuan和Sora兩者的效果都更逼真一些,衣服、水果和山峰的細節(jié)也非常清晰。

甚至在一些物理細節(jié)的理解上,Fast-Hunyuan比Sora還強,比如下面拿取檸檬的視頻:

更重要的是,Fast-Hunyuan的代碼也開源了,這下不用為Sora的訂閱費和限額發(fā)愁了。

研究團隊來自加州大學圣地亞哥分校(UCSD)的Hao AI實驗室,他們主要專注機器學習算法和分布式系統的研究。

混元官方賬號還特意發(fā)博感謝了他們:

有網友看完后直呼,混元才是最好的開源視頻模型。

開創(chuàng)性的視頻DiT蒸餾配方

團隊是如何做到8倍提速的情況下還能提升視頻清晰度呢?

下面就一起來看一下Fast-Hunyuan的技術原理——

首先,他們開發(fā)了全新的視頻DiT蒸餾配方。

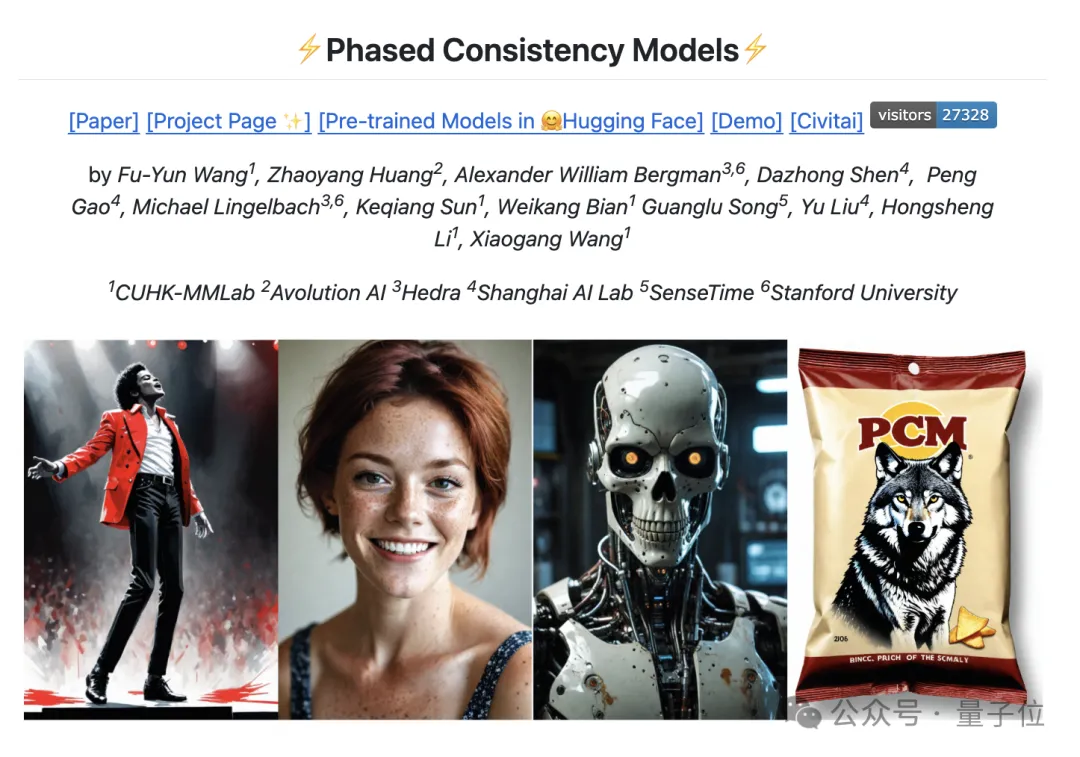

具體來說,他們的蒸餾配方基于階段一致性(Phased Consistency Model, PCM)模型。

在嘗試使用多階段蒸餾后發(fā)現效果沒有顯著改進,最終他們選擇保持單階段設置,與原始PCM模型的配置相似。

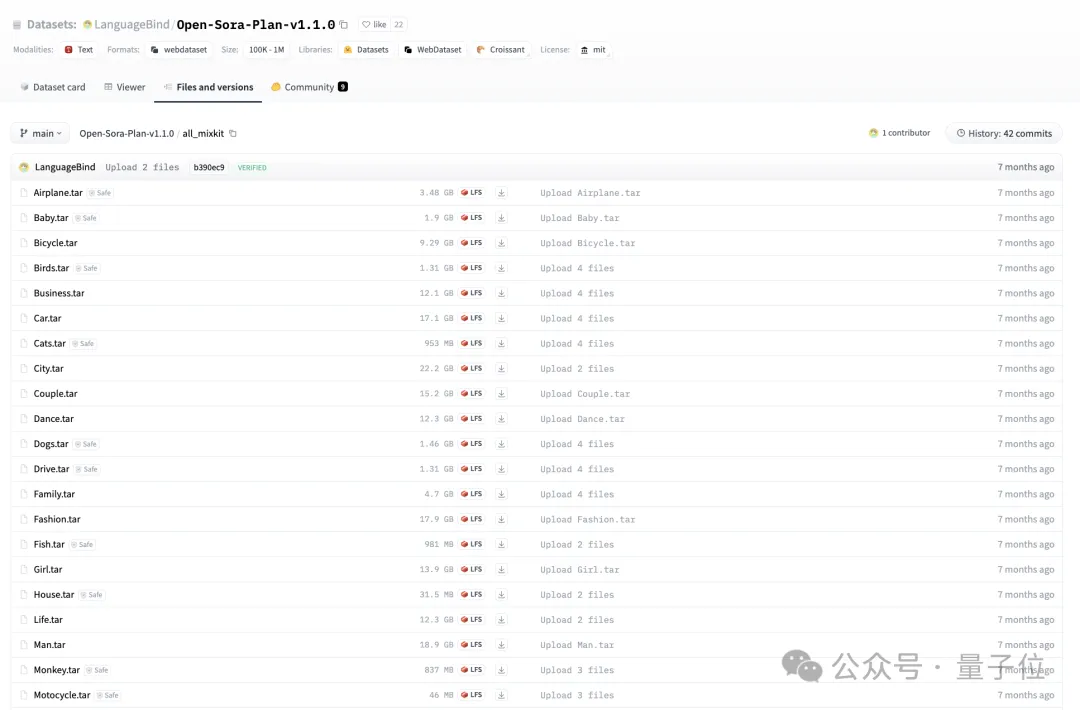

其次,團隊使用了OpenSoraPlan中的MixKit數據集進行了蒸餾。

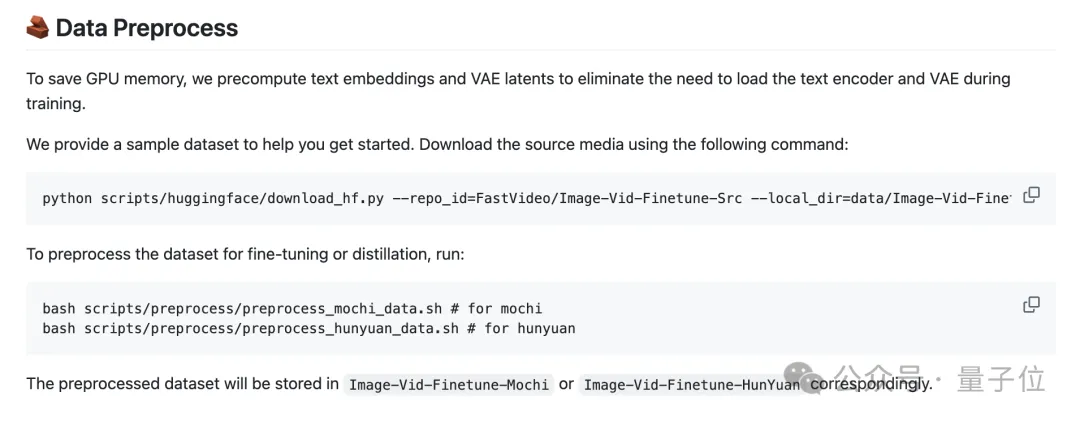

為了避免在訓練過程中運行文本編碼器和VAE,團隊還預處理了所有數據,用來生成文本嵌入和VAE潛在變量。

在推理階段,用戶可以通過FSDP、序列并行和選擇性激活檢查點進行可擴展訓練,模型可以近乎線性擴展到64個GPU。測試代碼在Python 3.10.0、CUDA 12.1和H100上運行。

官方推薦使用80GB內存的GPU,不同模型有相應的下載權重和推理命令。

最低硬件要求如下:

- 40 GB GPU 內存,每個 GPU 配備 lora

- 30 GB GPU 內存,每 2 個 GPU 配備 CPU 卸載和 LoRa。

在模型微調方面,Fast-Hunyuan提供了全微調(需準備符合格式的數據,提供了一些可下載的預處理數據及對應命令)和LoRA 微調(即將上線)兩種方式。

此外,他們還結合了預計算潛變量和預計算文本嵌入,用戶可以根據自己的硬件條件選擇不同的微調方式來執(zhí)行命令,也支持圖像和視頻的混合微調。

模型已于2024年12月17日發(fā)布了v0.1版本。

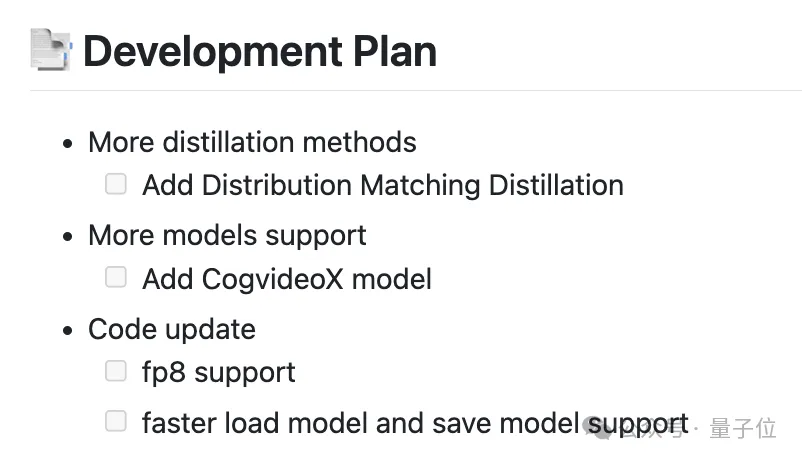

未來的開發(fā)計劃還包括添加更多蒸餾方法(如分布匹配蒸餾)、支持更多模型(如CogvideoX模型)以及代碼更新(如fp8支持、更快的加載和保存模型支持)等等。

One More Thing

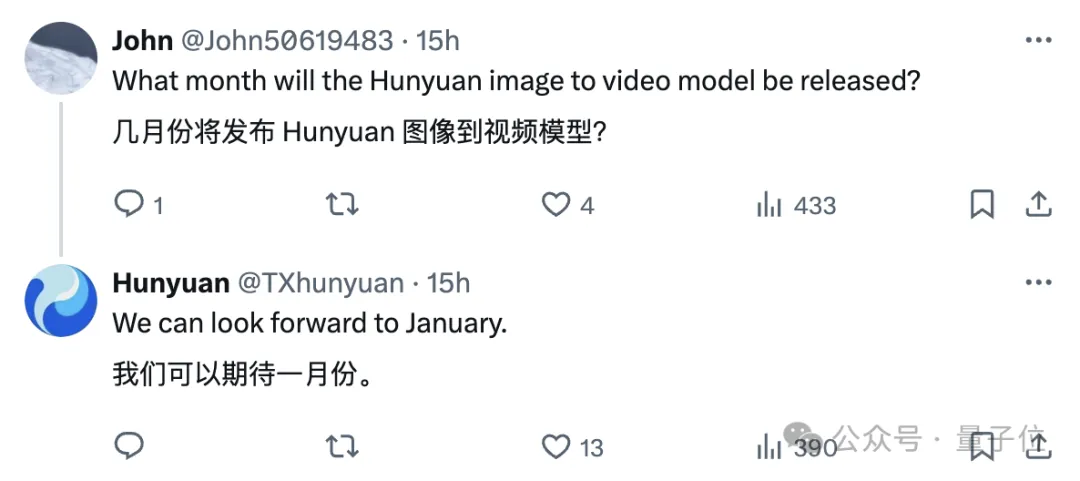

除了加速模型,混元還預告了大家都非常期待的圖像到視頻生成功能。

最快1月份,也就是下個月就可以看到!期待住了。

GitHub:https://github.com/hao-ai-lab/FastVideo。

HuggingFace:https://huggingface.co/FastVideo/FastHunyuan。

參考鏈接:

[1]https://x.com/TXhunyuan/status/1869282002786292097。