小紅書搜索團隊提出全新框架:驗證負樣本對大模型蒸餾的價值

大語言模型(LLMs)在各種推理任務上表現優異,但其黑盒屬性和龐大參數量阻礙了它在實踐中的廣泛應用。特別是在處理復雜的數學問題時,LLMs 有時會產生錯誤的推理鏈。傳統研究方法僅從正樣本中遷移知識,而忽略了那些帶有錯誤答案的合成數據。

在 AAAI 2024 上,小紅書搜索算法團隊提出了一個創新框架,在蒸餾大模型推理能力的過程中充分利用負樣本知識。負樣本,即那些在推理過程中未能得出正確答案的數據,雖常被視為無用,實則蘊含著寶貴的信息。

論文提出并驗證了負樣本在大模型蒸餾過程中的價值,構建一個模型專業化框架:除了使用正樣本外,還充分利用負樣本來提煉 LLM 的知識。該框架包括三個序列化步驟,包括負向協助訓練(NAT)、負向校準增強(NCE)和動態自洽性(ASC),涵蓋從訓練到推理的全階段過程。通過一系列廣泛的實驗,我們展示了負向數據在 LLM 知識蒸餾中的關鍵作用。

一、背景

如今,在思維鏈(CoT)提示的幫助下,大語言模型(LLMs)展現出強大的推理能力。然而,思維鏈已被證明是千億級參數模型才具有的涌現能力。這些模型的繁重計算需求和高推理成本,阻礙了它們在資源受限場景中的應用。因此,我們研究的目標是使小模型能夠進行復雜的算術推理,以便在實際應用中進行大規模部署。

知識蒸餾提供了一種有效的方法,可以將 LLMs 的特定能力遷移到更小的模型中。這個過程也被稱為模型專業化(model specialization),它強制小模型專注于某些能力。先前的研究利用 LLMs 的上下文學習(ICL)來生成數學問題的推理路徑,將其作為訓練數據,有助于小模型獲得復雜推理能力。然而,這些研究只使用了生成的具有正確答案的推理路徑(即正樣本)作為訓練樣本,忽略了在錯誤答案(即負樣本)的推理步驟中有價值的知識。

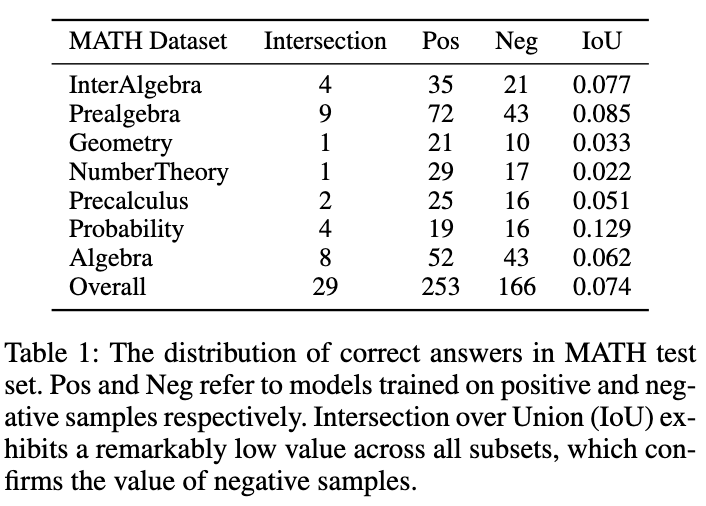

如圖所示,表 1 展示了一個有趣的現象:分別在正、負樣本數據上訓練的模型,在 MATH 測試集上的準確答案重疊非常小。盡管負樣本訓練的模型準確性較低,但它能夠解決一些正樣本模型無法正確回答的問題,這證實了負樣本中包含著寶貴的知識。此外,負樣本中的錯誤鏈路能夠幫助模型避免犯類似錯誤。另一個我們應該利用負樣本的原因是 OpenAI 基于 token 的定價策略。即使是 GPT-4,在 MATH 數據集上的準確性也低于 50%,這意味著如果僅利用正樣本知識,大量的 token 會被浪費。因此,我們提出:相比于直接丟棄負樣本,更好的方式是從中提取和利用有價值的知識,以增強小模型的專業化。

模型專業化過程一般可以概括為三個步驟:

1)思維鏈蒸餾(Chain-of-Thought Distillation),使用 LLMs 生成的推理鏈訓練小模型。

2)自我增強(Self-Enhancement),進行自蒸餾或數據自擴充,以進一步優化模型。

3)自洽性(Self-Consistency)被廣泛用作一種有效的解碼策略,以提高推理任務中的模型性能。

在這項工作中,我們提出了一種新的模型專業化框架,該框架可以全方位利用負樣本,促進從 LLMs 提取復雜推理能力。

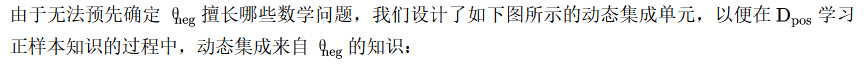

- 我們首先設計了負向協助訓練(NAT)方法,其中 dual-LoRA 結構被設計用于從正向、負向兩方面獲取知識。作為一個輔助模塊,負向 LoRA 的知識可以通過校正注意力機制,動態地整合到正向 LoRA 的訓練過程中。

- 對于自我增強,我們設計了負向校準增強(NCE),它將負向輸出作為基線,以加強關鍵正向推理鏈路的蒸餾。

- 除了訓練階段,我們還在推理過程中利用負向信息。傳統的自洽性方法將相等或基于概率的權重分配給所有候選輸出,導致投票出一些不可靠的答案。為了緩解該問題,提出了動態自洽性(ASC)方法,在投票前進行排序,其中排序模型在正負樣本上進行訓練的。

二、方法

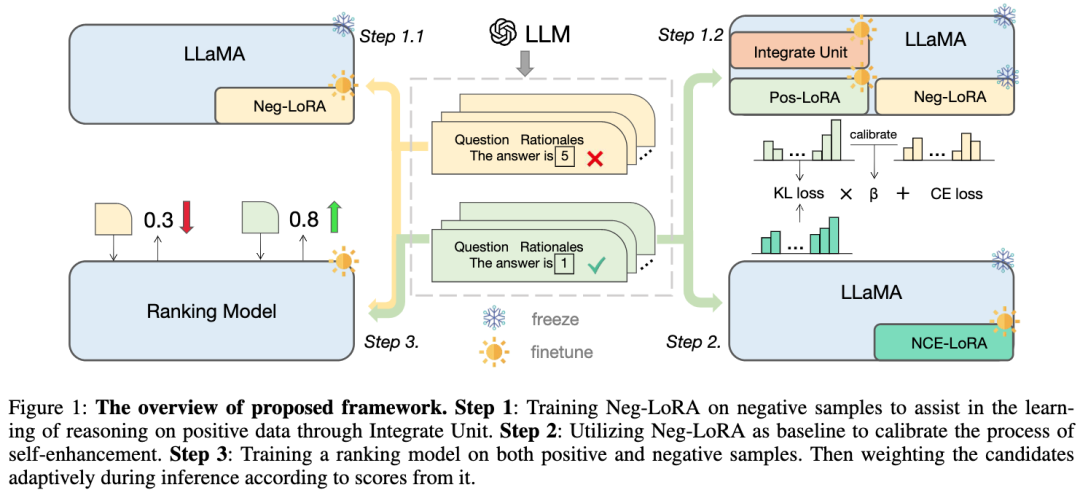

我們提出的框架以 LLaMA 為基礎模型,主要包含三個部分,如圖所示:

- 步驟 1 :對負向 LoRA 進行訓練,通過合并單元幫助學習正樣本的推理知識;

- 步驟 2 :利用負向 LoRA 作為基線來校準自我增強的過程;

- 步驟 3 :在正樣本和負樣本上訓練排名模型,在推理過程中根據其得分,自適應地對候選推理鏈路進行加權。

圖片

圖片

2.1 負向協助訓練(NAT)

我們提出了一個兩階段的負向協助訓練(NAT)范式,分為負向知識吸收與動態集成單元兩部分:

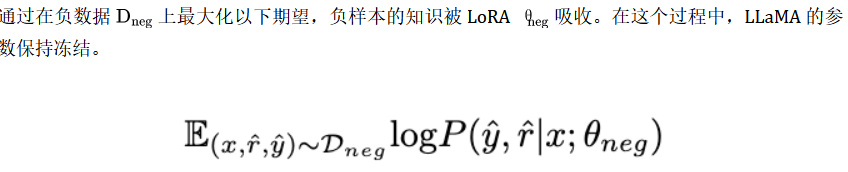

2.1.1 負向知識吸收

2.1.2 動態集成單元

2.2 負向校準增強(NCE)

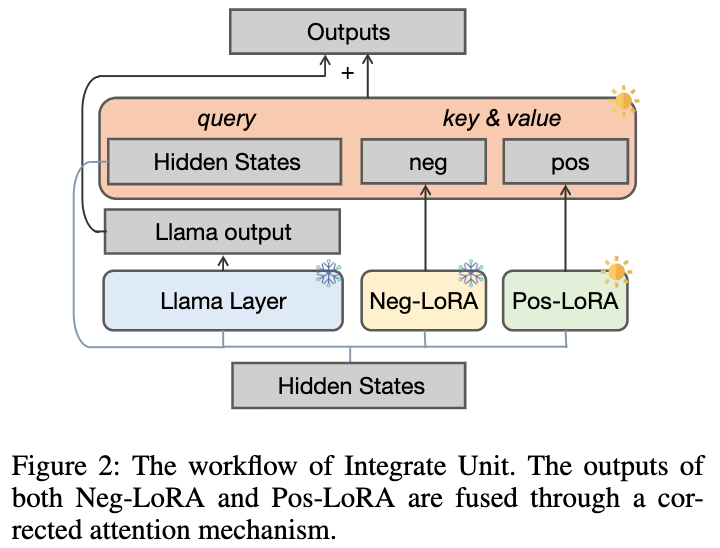

為了進一步增強模型的推理能力,我們提出了負校準增強(NCE),它使用負知識來幫助自我增強過程。我們首先使用 NAT 為中的每個問題生成對作為擴充樣本,并將它們補充到訓練數據集中。對于自蒸餾部分,我們注意到一些樣本可能包含更關鍵的推理步驟,對提升模型的推理能力至關重要。我們的主要目標是確定這些關鍵的推理步驟,并在自蒸餾過程中加強對它們的學習。

β 值越大,表示兩者之間的差異越大,意味著該樣本包含更多關鍵知識。通過引入 β 來調整不同樣本的損失權重,NCE 將能夠選擇性地學習并增強 NAT 中嵌入的知識。

2.3 動態自洽性(ASC)

自洽性(SC)對于進一步提高模型在復雜推理中的表現是有效的。然而,當前的方法要么為每個候選者分配相等的權重,要么簡單地基于生成概率分配權重。這些策略無法在投票階段根據 (r?, y?) 的質量調整候選權重,這可能會使正確候選項不易被選出。為此,我們提出了動態自洽性方法(ASC),它利用正負數據來訓練排序模型,可以自適應地重新配權候選推理鏈路。

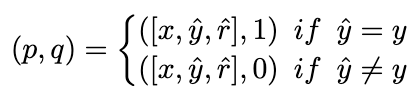

2.3.1 排序模型訓練

理想情況下,我們希望排序模型為得出正確答案的推理鏈路分配更高的權重,反之亦然。因此,我們用以下方式構造訓練樣本:

圖片

圖片

并使用 MSE loss 去訓練排序模型:

圖片

圖片

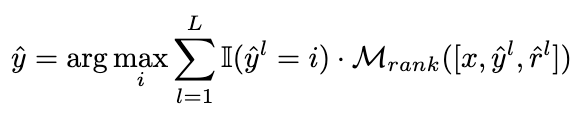

2.3.2 加權策略

我們將投票策略修改為以下公式,以實現自適應地重新加權候選推理鏈路的目標:

圖片

圖片

下圖展示了 ASC 策略的流程:

圖片

圖片

從知識遷移的角度來看,ASC 實現了對來自 LLMs 的知識(正向和負向)的進一步利用,以幫助小模型獲得更好的性能。

三、實驗

本研究專注于具有挑戰性的數學推理數據集 MATH,該數據集共有 12500 個問題,涉及七個不同的科目。此外,我們還引入了以下四個數據集來評估所提出的框架對分布外(OOD)數據的泛化能力:GSM8K、ASDiv、MultiArith和SVAMP。

對于教師模型,我們使用 Open AI 的 gpt-3.5-turbo 和 gpt-4 API來生成推理鏈。對于學生模型,我們選擇 LLaMA-7b。

在我們的研究中有兩種主要類型的基線:一種為大語言模型(LLMs),另一種則基于 LLaMA-7b。對于 LLMs,我們將其與兩種流行的模型進行比較:GPT3 和 PaLM。對于 LLaMA-7b,我們首先提供我們的方法與三種設置進行比較:Few-shot、Fine-tune(在原始訓練樣本上)、CoT KD(思維鏈蒸餾)。在從負向角度學習方面,還將包括四種基線方法:MIX(直接用正向和負向數據的混合物訓練 LLaMA)、CL(對比學習)、NT(負訓練)和 UL(非似然損失)。

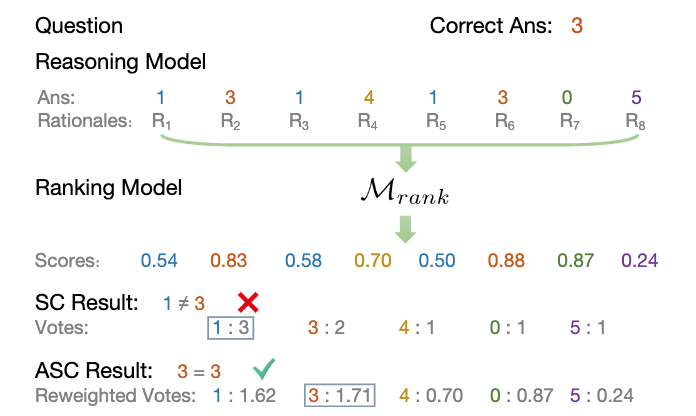

3.1 NAT 實驗結果

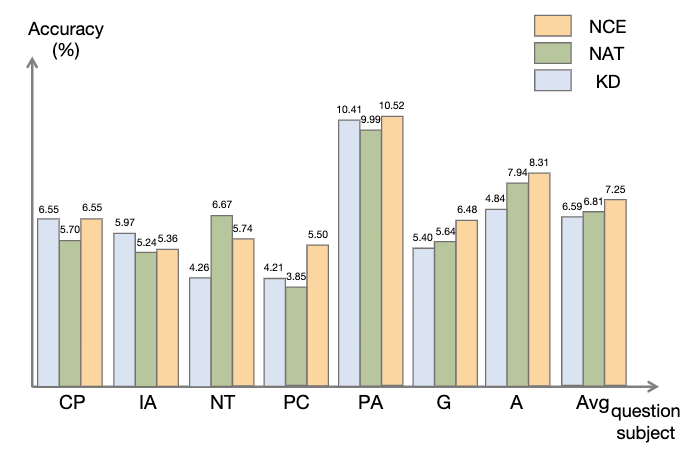

所有的方法都使用了貪婪搜索(即溫度 = 0),NAT 的實驗結果如圖所示,表明所提出的 NAT 方法在所有基線上都提高了任務準確性。

從 GPT3 和 PaLM 的低值可以看出,MATH 是一個非常困難的數學數據集,但 NAT 仍然能夠在參數極少的情況下表現突出。與在原始數據上進行微調相比,NAT 在兩種不同的 CoT 來源下實現了約 75.75% 的提升。與 CoT KD 在正樣本上的比較,NAT 也顯著提高了準確性,展示了負樣本的價值。

對于利用負向信息基線,MIX 的低性能表明直接訓練負樣本會使模型效果很差。其他方法也大多不如 NAT,這表明在復雜推理任務中僅在負方向上使用負樣本是不夠的。

圖片

圖片

3.2 NCE 實驗結果

如圖所示,與知識蒸餾(KD)相比,NCE 實現了平均 10%(0.66) 的進步,這證明了利用負樣本提供的校準信息進行蒸餾的有效性。與 NAT 相比,盡管 NCE 減少了一些參數,但它依然有 6.5% 的進步,實現壓縮模型并提高性能的目的。

圖片

圖片

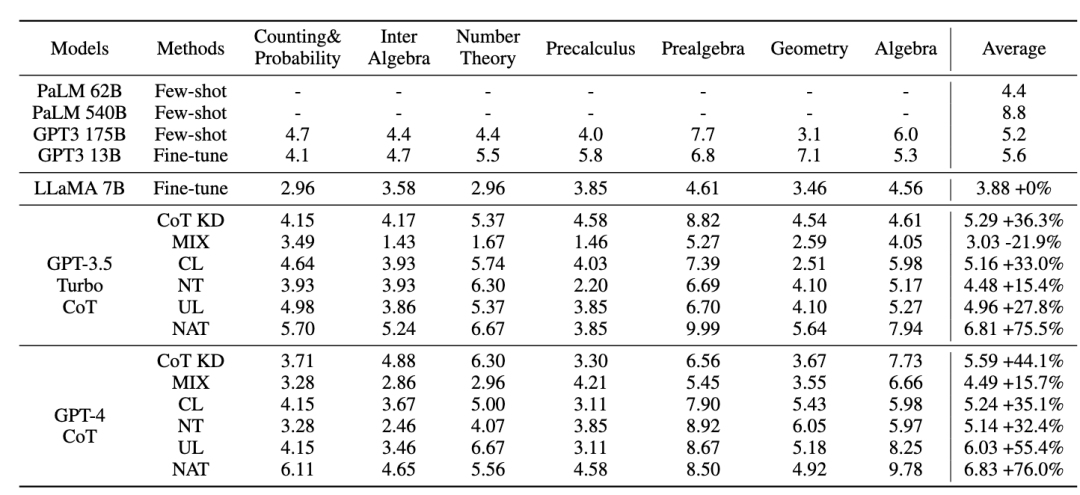

3.3 ASC 實驗結果

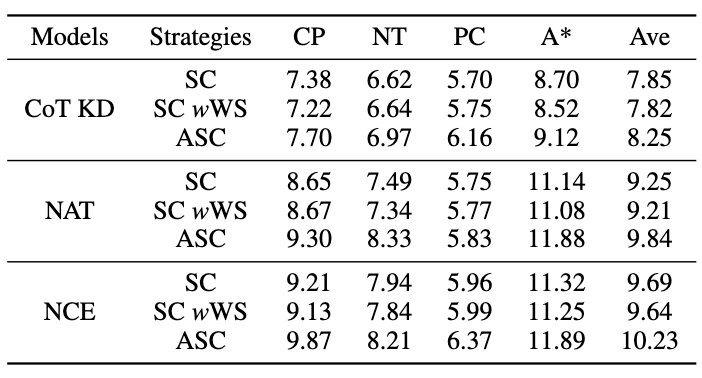

為了評估 ASC,我們將其與基礎 SC 和 加權(WS)SC 進行比較,使用采樣溫度 T = 1 生成了 16 個樣本。如圖所示,結果表明,ASC 從不同樣本聚合答案,是一種更有前景的策略。

圖片

圖片

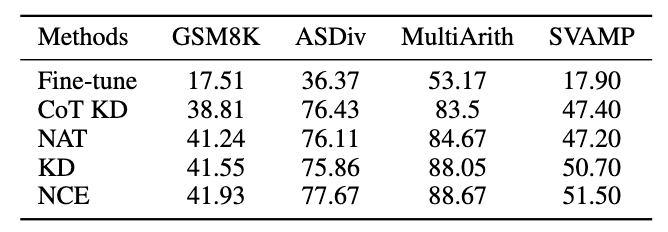

3.4 泛化性實驗結果

除了 MATH 數據集,我們評估了框架在其他數學推理任務上的泛化能力,實驗結果如下。

圖片

圖片

四、結語

本項工作探討了利用負樣本從大語言模型中提煉復雜推理能力,遷移到專業化小模型的有效性。小紅書搜索算法團隊提出了一個全新的框架,由三個序列化步驟組成,并在模型專業化的整個過程中充分利用負向信息。負向協助訓練(NAT)可以從兩個角度提供更全面地利用負向信息的方法。負向校準增強(NCE)能夠校準自蒸餾過程,使其更有針對性地掌握關鍵知識。基于兩種觀點訓練的排序模型可以為答案聚合分配更適當的權重,以實現動態自洽性(ASC)。大量實驗表明,我們的框架可以通過生成的負樣本來提高提煉推理能力的有效性。

論文地址:https://arxiv.org/abs/2312.12832

五、作者簡介

李易為:

現博士就讀于北京理工大學,小紅書社區搜索實習生,在 AAAI、ACL、EMNLP、NAACL、NeurIPS、KBS 等機器學習、自然語言處理領域頂級會議/期刊上發表數篇論文,主要研究方向為大語言模型蒸餾與推理、開放域對話生成等。

袁沛文:

現博士就讀于北京理工大學,小紅書社區搜索實習生,在 NeurIPS、AAAI 等發表多篇一作論文,曾獲 DSTC11 Track 4 第二名。主要研究方向為大語言模型推理與評測。

馮少雄:

負責小紅書社區搜索向量召回。在 AAAI、EMNLP、ACL、NAACL、KBS 等機器學習、自然語言處理領域頂級會議/期刊上發表數篇論文。

道玄(潘博遠):

小紅書交易搜索負責人。在NeurIPS、ICML、ACL 等機器學習和自然語言處理領域頂級會議上發表數篇一作論文,在斯坦福機器閱讀競賽 SQuAD 排行榜上獲得第二名,在斯坦福自然語言推理排行榜上獲得第一名。

曾書(曾書書):

小紅書社區搜索語義理解與召回方向負責人。碩士畢業于清華大學電子系,在互聯網領域先后從事自然語言處理、推薦、搜索等相關方向的算法工作。