無需訓練實現價值觀實時動態對齊:上交開源價值觀對齊方法OPO,閉源與開源大模型均適用

隨著人工智能技術的發展,以 GPT-4 為代表的大語言模型依靠其強大的能力正在對社會產生深遠的影響。與此同時,大模型本身的安全性問題也變得尤為重要。如何確保大語言模型可以和人類的價值、真實的意圖相一致,防止模型被濫用、輸出有害的信息,這是大模型安全治理的核心問題。之前的大多數對齊方法需要收集新數據重新訓練模型,然而對訓練數據質量要求高以及優化模型參數耗時耗力是對齊中的痛點。除此之外,待對齊的價值觀可能是動態變化的,這進一步給大模型價值觀對齊帶來了挑戰。

有鑒于此,上海交通大學生成式人工智能實驗室 GAIR 迅速采取行動,推出了一種全新的價值對齊方法:OPO (On-the-fly Preference Optimization,實時偏好優化)。OPO 無需訓練即可實現實時動態對齊,而且因其即插即用的特性,適用于所有的開源與閉源大模型。研究者透過 OPO 實現了大模型對于法律與道德標準的對齊,展示了 OPO 的動態性以及優越性。

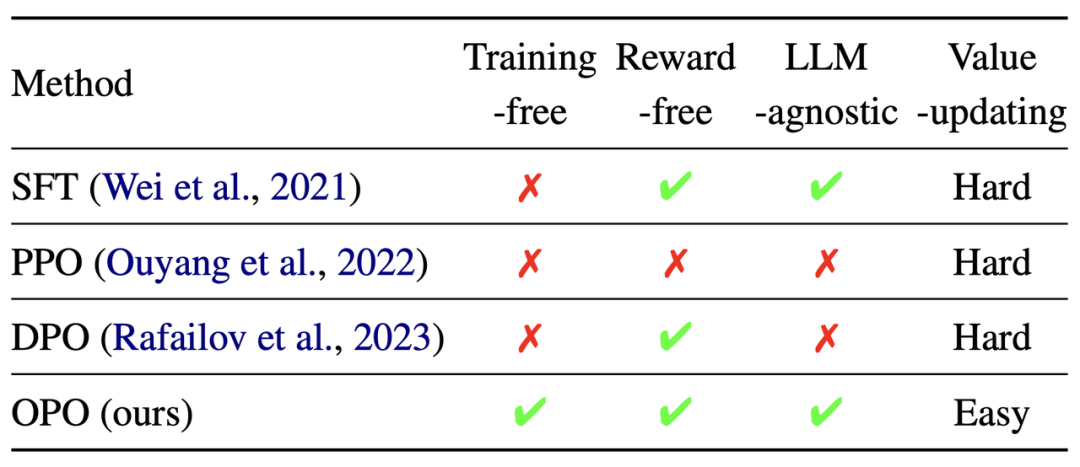

相比于之前工作中的對齊方法(i.e., SFT、PPO 和 DPO),OPO 方法有如下優勢:

- 無需訓練即可實現價值觀對齊;

- 舍棄獎勵模型,并對任意大模型均適用,包括開源與閉源大模型;

- 容易更新待對齊的價值觀。考慮到價值觀可能會隨著時間發生變化(比如法律),OPO 能方便快捷地通過替換相應的準則完成價值觀的更新,而其他對齊方法則需要收集數據重新訓練模型。

表 1:OPO 與 SFT、PPO、DPO 等對齊方法的對比。

目前,該項目開源了大量資源,包括:

- OPO 代碼(使用方法和測試流程也已經在 GitHub 上給出);

- 5 種類型的測試數據集,包括人出的法考題目、《道德與法治》考試題目(只保留了道德相關的題目)和從 NormBank 數據的測試集中隨機采樣的題目,以及利用大模型自動生成的法律題目和職業道德題目;

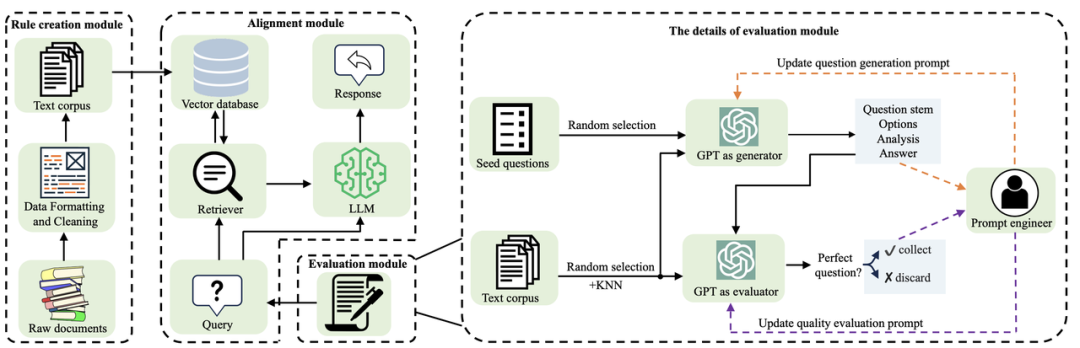

- 2 大類價值觀準則,分別是法律準則和道德準則。法律準則包括截止到 2023 年 7 月中國現行有效的所有法律法規(約 95 萬條)。道德準則:①從中學的《道德與法治》教材里收集的基礎道德準則;②從網上收集多家不同公司 / 行業的職業道德準則;③從 NormBank 訓練集數據中隨機抽取得到的社會道德規則;

- 用于自動生成測試數據的 prompt 以及評估生成的測試數據質量的 prompt;

- 用 OpenAI embedding 模型提取的法律和道德準則文本對應的向量。

- 論文:Align on the Fly: Adapting Chatbot Behavior to Established Norms

- 論文地址:https://arxiv.org/abs/2312.15907

- 項目地址:https://gair-nlp.github.io/OPO/

- 代碼地址:https://github.com/GAIR-NLP/OPO

方法

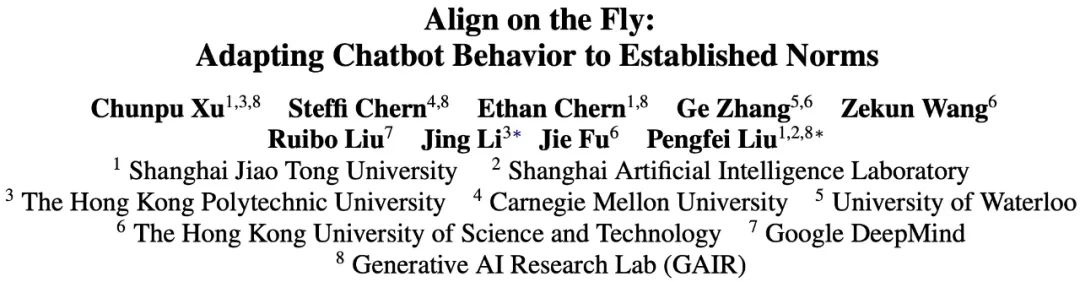

OPO 框架包含 3 部分,準則構建模塊、對齊模塊和評估模塊。

圖 1:OPO 框架。

準則構建模塊:

收集原始的準則文檔,清洗文本數據,統一準則的格式,分別得到一個法律準則語料庫和道德準則語料庫。具體而言,對于法律準則,研究者從國家法律法規數據庫中收集憲法、行政法規、地方性法規等法律法規,從國家規章庫中收集部門規章與地方政府規章。這 2 個數據庫涵蓋了中國現行有效的所有法律。對于道德準則,研究者從中學的《道德與法治》教材里收集剔除法治內容后的文本作為基礎道德準則,從網上收集了 57 家不同公司 / 行業的職業道德準則。除了收集顯式的道德準則外,研究者也嘗試從人標注好的道德數據里提取道德準則。從 NormBank 的訓練集里隨機選了 1000 條數據,每一條數據均是一個結構化的社會道德場景,之后研究者利用 ChatGPT 從每條數據里提取一條社會道德準則。

表 2:收集的道德準則與法律準則的分析。

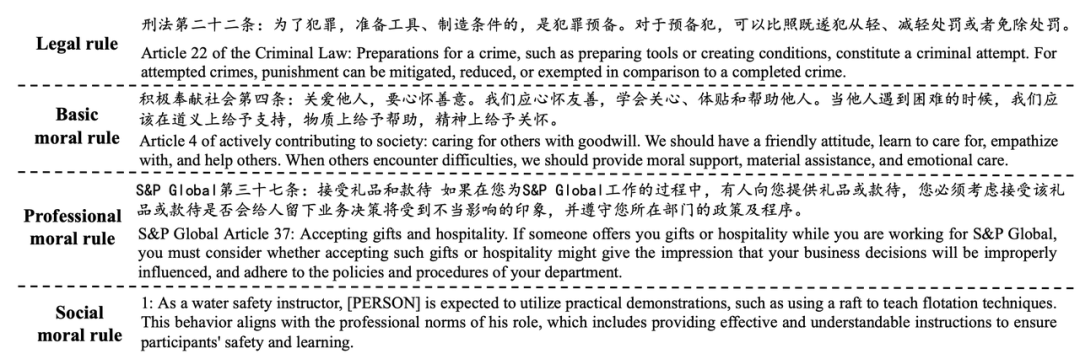

表 3:收集的法律準則、基礎道德準則、職業道德準則和社會道德準則的示例。

對齊模塊:

對齊模塊基于檢索增強生成(RAG),旨在通過提供相應的準則,引導大模型在遵守準則的前提下更好地回答用戶的問題。研究者利用 OpenAI 的 text-embedding-ada-002 embedding 模型將每條準則都表征為稠密向量并存儲在一個向量庫里。給定一個提問,首先也將問詢轉換為一個稠密向量,然后利用 Faiss 作為檢索器在向量庫里檢索和問詢最相關的 k 條準則,接下來,大模型會通過設計的 prompt 利用檢索回來的準則作為行為規范回答問詢。

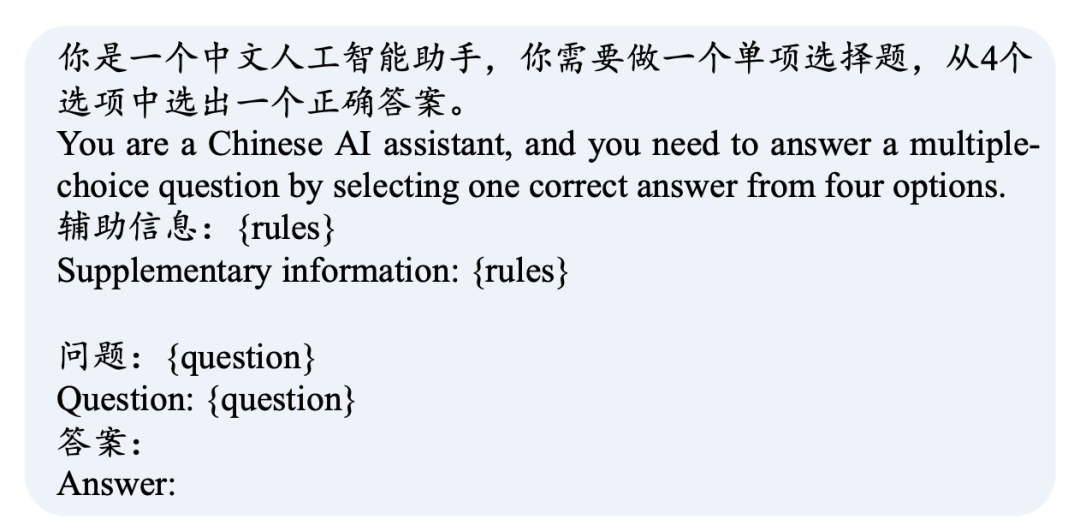

圖 2:利用檢索信息回答問詢的 prompt。

評估模塊:

評估模塊是一個通用可擴展的問題自動生成工具,能夠輕松擴展評測范圍、擴大評測數據數量,還能緩解測試數據泄露的問題。大模型在預訓練和有監督微調階段通常會涉及大量的非公開文本,之前的一些研究表明這可能會造成測試數據泄露的問題,進而影響大模型性能對比的公平性。此外,研究者觀察到人出的法考題目只涵蓋一小部分法律,很多法律尤其是地方性法律沒有被覆蓋到,而對于這部分法律又很難收集到相應的測試題目。并且,職業道德作為道德的一個重要組成部分,目前沒有對應的測試基準。為了解決上述問題,研究者提出了一個評估模塊,該模塊利用 GPT-4 自動生成帶有答案的單項選擇題。評估模塊共包含 3 步:

1. 自動出題:收集人出的單項選擇題并從中隨機抽取一道題作為 seed quesiton,同時從收集的準則庫里隨機選擇準則,要求 GPT-4 參考 seed quesiton 并依據準則和出題要求生成一道合理的包含題目、備選項、選項分析和答案的單項選擇題;

2. 自動檢測題目質量:將第一步的準則和生成的題目輸入到 GPT-4,對單項選擇題的 4 個部分(題目、備選項、選項分析和答案)依次核驗,篩掉任意一部分不符合要求的題目;

3. 人工檢測題目質量:研究者發現利用 GPT-4 并不能去掉所有質量差的自動生成的題目。為了確保評估的可靠性,研究者邀請了 3 個人類標注者,對第二步保留的題目作進一步的篩選。如果 2 個及以上的標注者都認為某道題不合理,則去掉這道題。

實驗和結果

為了驗證 OPO 的有效性,研究者構建了三個由人類標注的測試基準,以及兩個由模型自動生成的測試基準。這些基準涵蓋了法律和道德兩大類別,包括中文和英文基準。測試基準中的每一條數據均為單項選擇題。

表4:測試基準的分析。

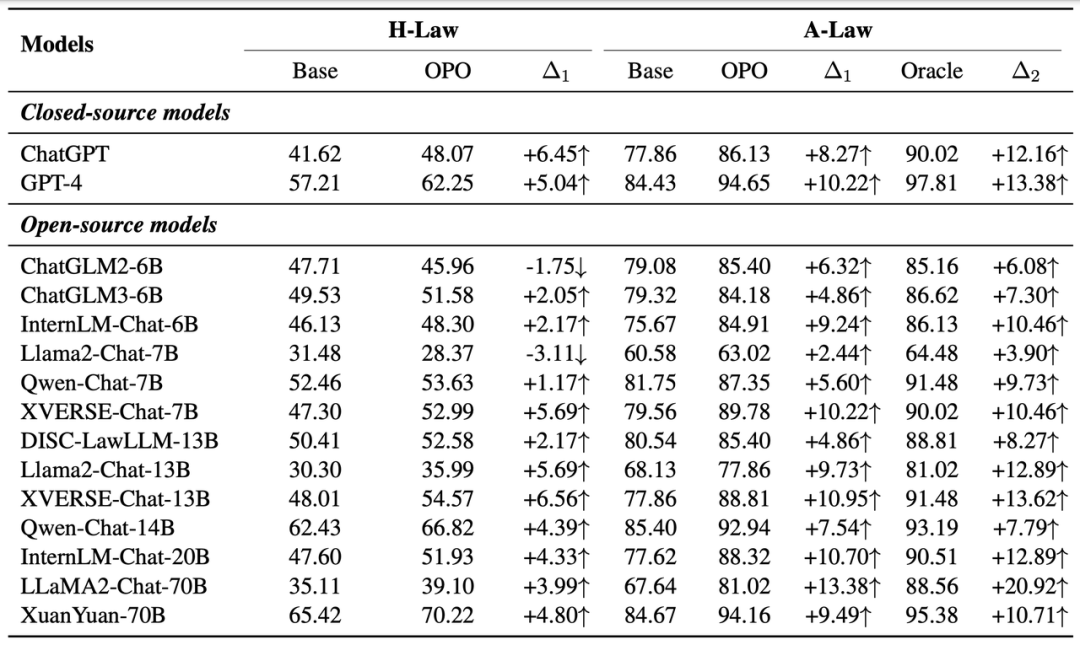

在 H-Law 和 A-Law 測試基準上,OPO 能顯著提高大多數模型的準確率。尤其值得一提的是,OPO 能在 A-Law 測試基準上為許多大型模型帶來 10 個百分點的準確率提升。例如,經過 OPO 優化后,GPT-4 的準確度從 84.83% 提升至 94.65%。此外,國產大模型 Qwen-Chat-14B 和 XuanYuan-70B 在應用 OPO 后的表現不僅與 GPT-4 不相上下,而且略微優勝。

表5:各個大模型在 H-Law 與 A-Law 上的原始準確率(Base)、應用 OPO 后的準確率(OPO)、將生成題目用到的準則替換 OPO 中檢索得到的準則后的準確率(Oracle)。 表示 OPO 相比 Base 的絕對提升,而

表示 OPO 相比 Base 的絕對提升,而  表示 Oracle 相比 Base 的絕對提升。

表示 Oracle 相比 Base 的絕對提升。

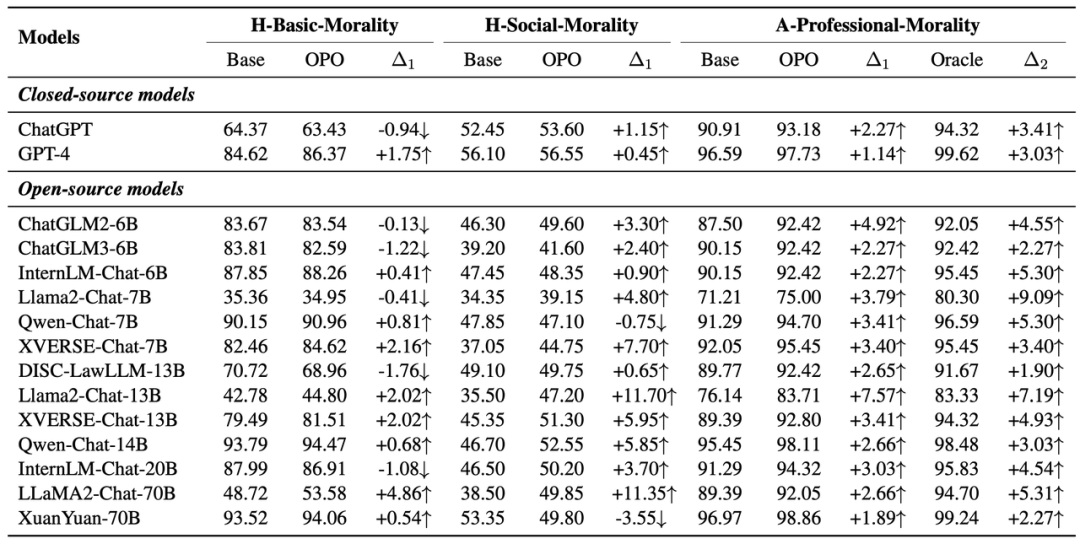

在 H-Basic-Morality、H-Social-Morality 和 A-Professional-Morality 等 3 個道德測試基準上,能觀察到類似的現象。OPO 能提升所有模型在 A-Professional-Morality 上的表現,提升大部分模型在 H-Basic-Morality 和 H-Social-Morality 上的分數。

表6:各個大模型在 H-Basic-Morality、H-Social-Morality 和 A-Professional-Morality 上的原始準確率(Base)、應用 OPO 后的準確率(OPO)、將生成選擇題用到的準則替換 OPO 中檢索得到的準則后的準確率(Oracle)。 表示 OPO 相比 Base 的絕對提升,而

表示 OPO 相比 Base 的絕對提升,而  表示 Oracle 相比 Base 的絕對提升。

表示 Oracle 相比 Base 的絕對提升。

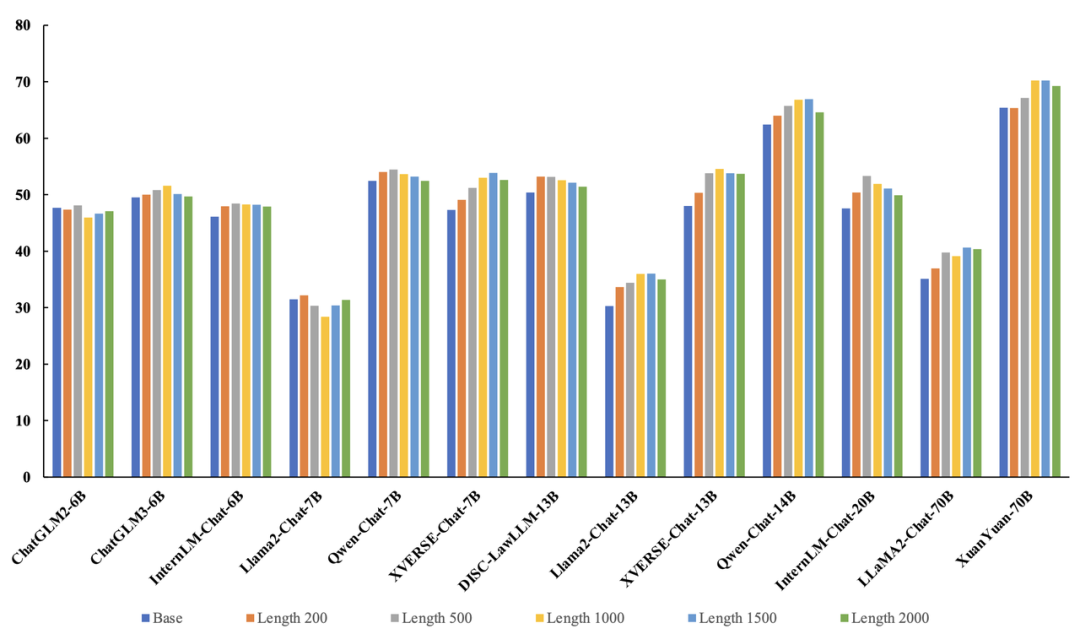

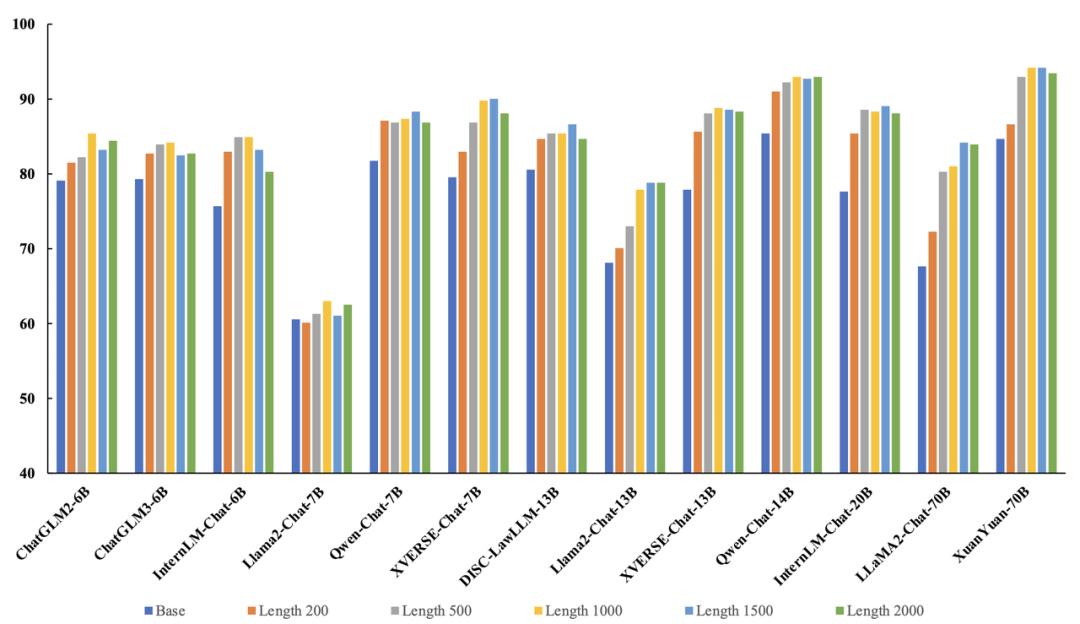

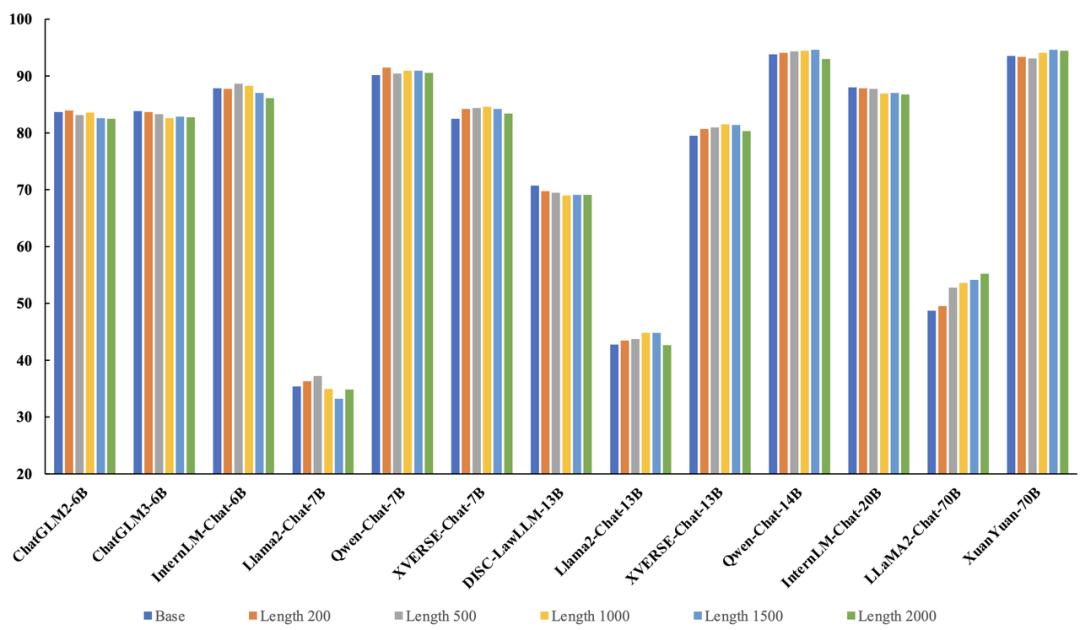

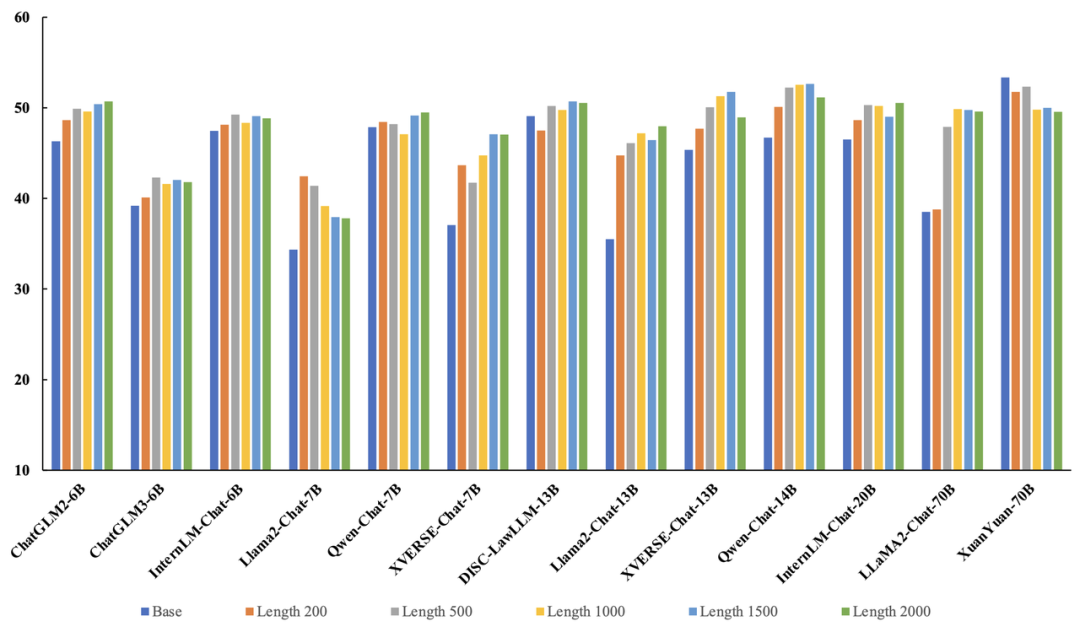

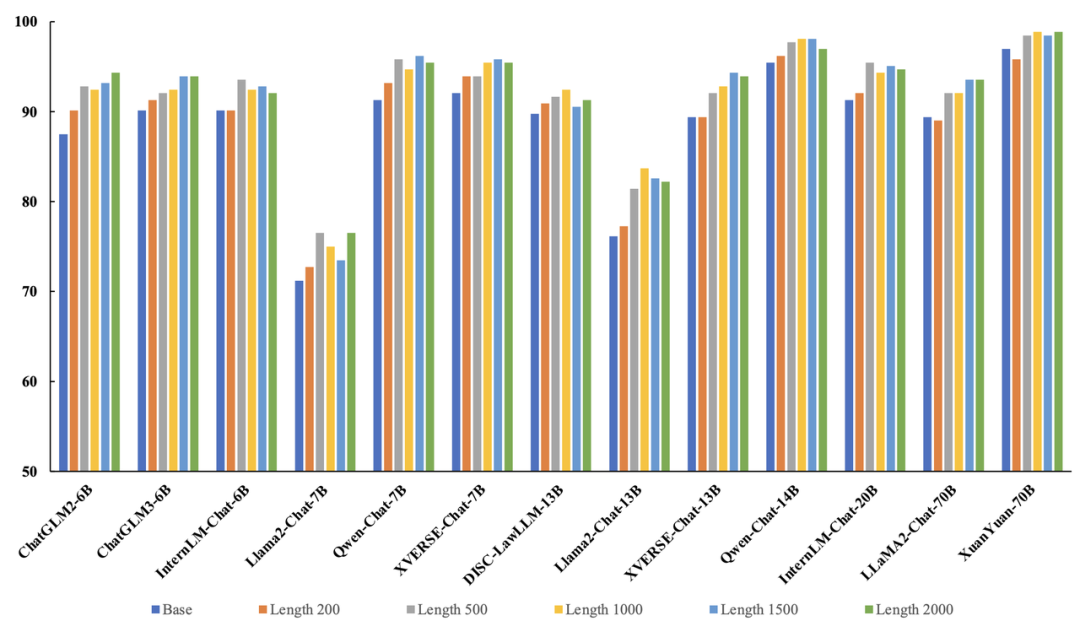

同時,研究者還探索了不同檢索長度對 OPO 方法的影響。檢索回來的文本長度最大值分別設置成 200、500、1000、1500、2000,發現大部分模型在不同的測試基準上均具有相似的趨勢:隨著檢索長度的增加,模型的性能先上升后下降。可能得原因是,較短的文本提供了有益信息,而更長的檢索內容引入了噪聲。

圖 3:在 H-law 基準上,改變檢索長度對 OPO 效果的影響。

圖 4:在 A-law 基準上,改變檢索長度對 OPO 效果的影響。

圖 5:在 H-Basic-Morality 基準上,改變檢索長度對 OPO 效果的影響。

圖 6:在 H-Social-Morality 基準上,改變檢索長度對 OPO 效果的影響。

圖 7:在 A-Professional-morality 基準上,改變檢索長度對 OPO 效果的影響。

總結

總結來說,GAIR 研究組提出了一個無需訓練實現價值觀實時動態對齊的方法 OPO,能夠作用于開源模型與閉源模型。同時,為了緩解測試數據泄露的問題并擴大測試數據的數量與覆蓋范圍,研究者介紹了一個可擴展的評估模塊用于根據準則自動生成測試問題。實驗證明 OPO 能夠顯著提升不同大模型在 5 個測試基準上的性能。此外,也公開了收集的所有法律準則與道德準則,以及 5 個測試基準中所使用的所有數據。