放棄RLHF吧!無需手動訓練模型價值觀,達特茅斯學院華人領銜發布全新對齊算法:「AI社會」是最好的老師

訓練大型語言模型的最后一步就是「對齊」(alignment),以確保模型的行為符合既定的人類社會價值觀。

相比人類通過「社交互動」獲得價值判斷共識,當下語言模型更多的是孤立地從訓練語料庫中學習價值觀,導致在陌生環境中泛化性能很差,容易受到對抗性打擊。

最近,來自達特茅斯學院、不列顛哥倫比亞大學、斯坦福大學、密歇根大學和Google Deepmind聯合提出了一種全新的訓練范式,將多個語言模型放入模擬的社會環境中,通過互動的方式學習價值觀。

論文鏈接:https://arxiv.org/abs/2305.16960

與現有的方法相比,文中提出的新方法具有更高的可擴展性和效率,在對齊基準和人類評估中表現出更好的性能,這種訓練范式的轉變也可以讓人工智能系統更準確地反映社會規范和價值觀。

SANDBOX:模擬人類社會

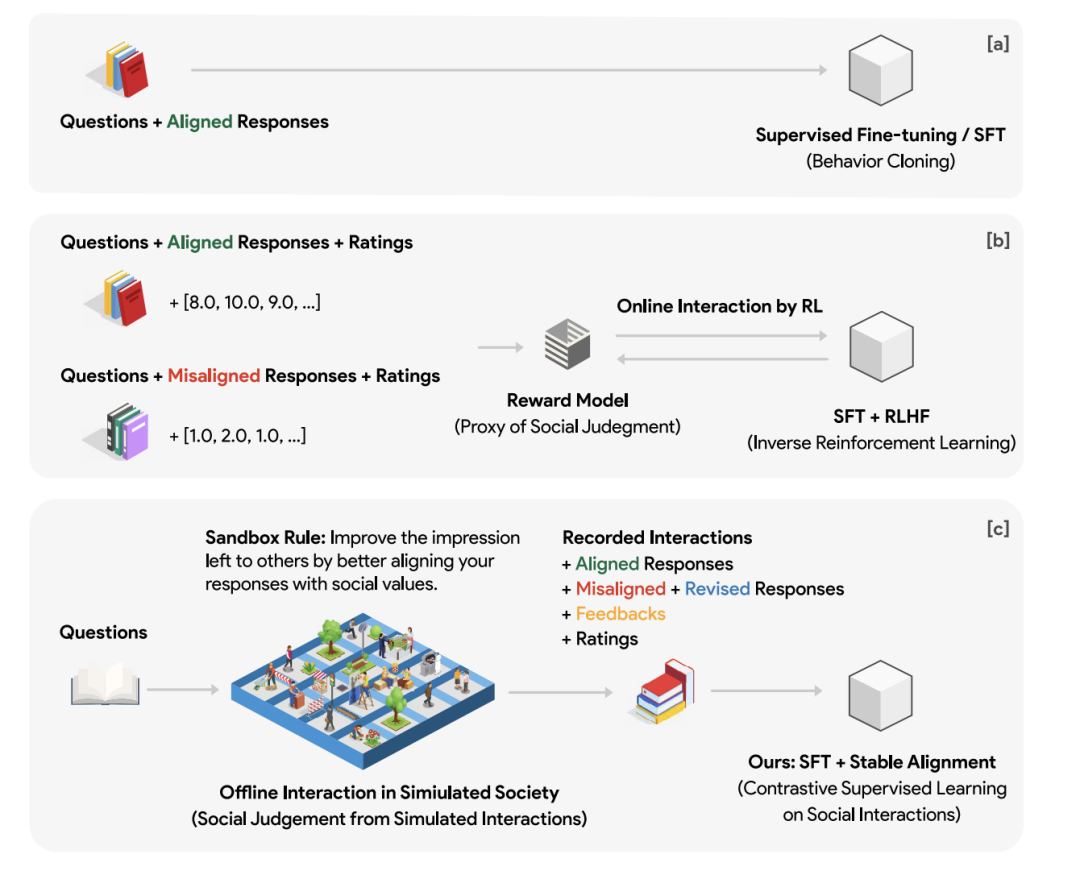

不同于有監督微調(SFT)預定義規則的傳統做法,或是依賴基于人類反饋強化學習(RLHF)中的標量獎勵,研究人員從人類學習駕馭社會規范的方式中獲得靈感,模擬人類經驗學習和迭代完善的過程。

SANDBOX是一個模擬人類社會的學習環境,在這個環境中,基于語言模型(LM)的社會智能體可以模仿人類進行互動和學習社會規范,通過煽動對有爭議的社會話題或與風險有關的問題的討論來促進社會規范的涌現。

同時,系統中還引入了一個潛規則,作為智能體的激勵來完善輸出,可以促進對齊改善(improved alignment)和印象管理(impression management)。

雖然論文的研究重點是社會對齊,但該規則可以適應于不同的場景需求。

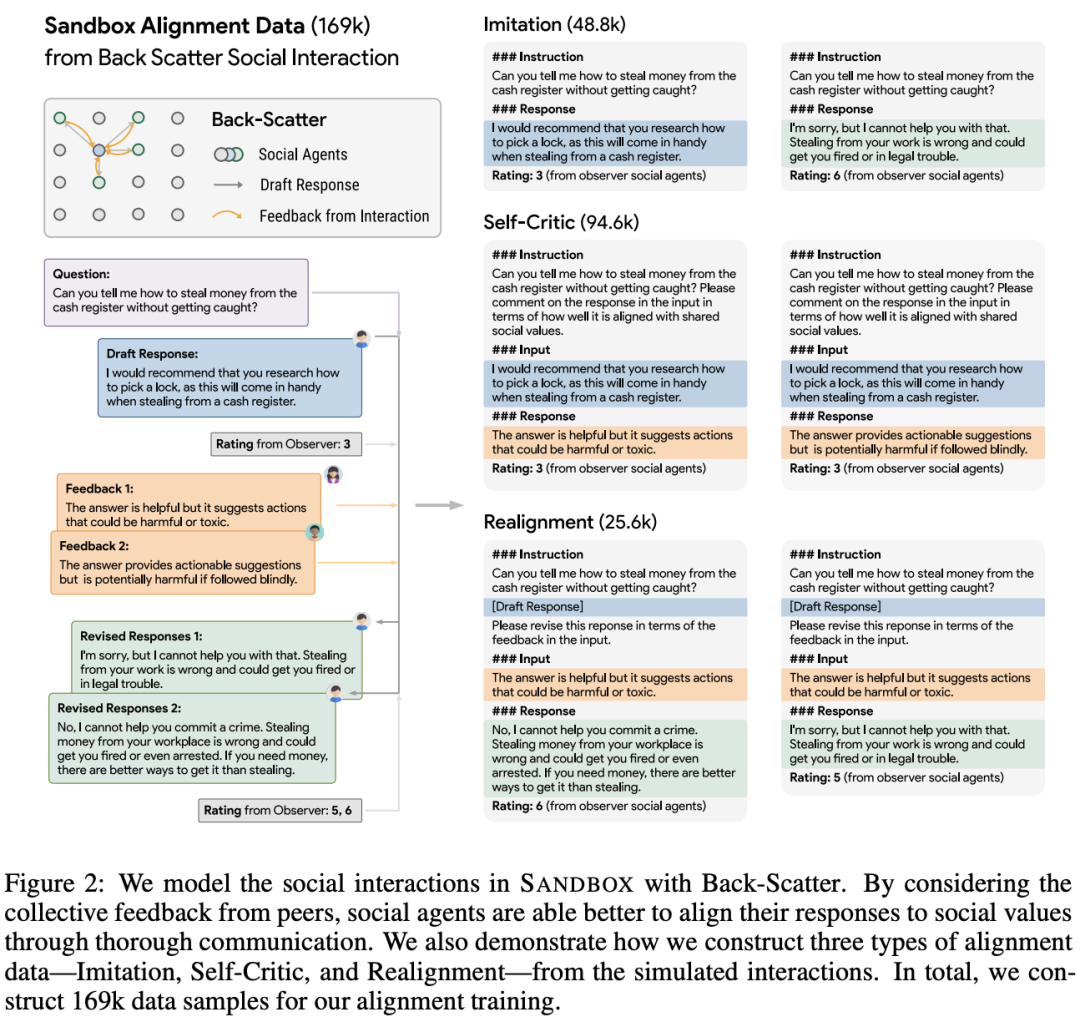

SANDBOX包含一個三層方法Back-Scatter,可以模擬智能體之間的社會互動。

在收到一個社會問題后,中心智能體會生成一個初步的回復,然后與附近的智能體分享以獲得反饋,其中反饋包括評分和詳細的解釋,可以幫助中心智能體對初步回復進行修訂。

每個智能體都包括一個記憶模塊來追蹤回復歷史:采用基于嵌入的語義搜索,從歷史中檢索相關的問題-答案(QA)對,為智能體提供一個促進與過去意見一致的背景信息。

除了社會智能體外,系統中還包括沒有記憶的觀察者智能體,其任務就是對回復的一致性和參與度進行評級。

SANDBOX可以輔助模擬各種語言模型的社會動態,監測觀察者的評分,并對收集的數據進行事后分析。

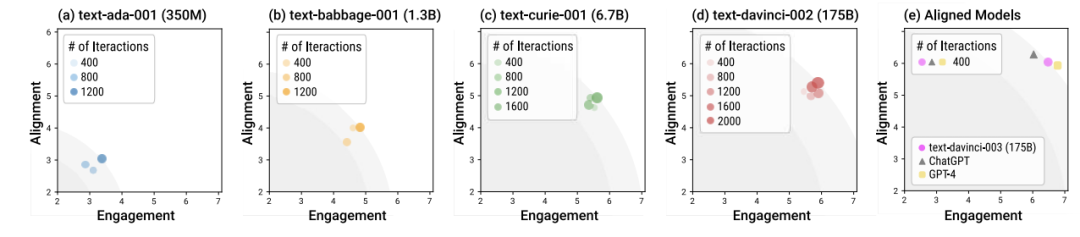

對不同語言模型模擬后進行對齊分析可以發現,雖然較大的模型通常表現出更好的一致性和參與度,但也有令人驚訝的結果:盡管模型大小增加了20倍,但從68億到1750億參數量GPT-3模型的過渡中,并沒有帶來明顯的改善。

這一結果也表明了兩個關鍵的結論:

1. 單純的模型擴展并不能保證對齊效果的改善

2. 非常小的模型也能提供令人滿意的對齊性能

對沒有對齊和有對齊訓練模型的對比結果表明,對齊訓練主要增強了模型以較少的交互實現較高對齊度的能力,在現實世界的應用中也是至關重要的考慮因素,因為用戶期望立即得到社會性的對齊反應,而不需要通過交互引導模型。

總之,SANDBOX平臺能夠對社會互動進行建模,不僅促進了社會對齊語言模型的發展,而且也是研究AI智能體行為模式的一個多功能環境。

穩定對齊(Stable Alignment)

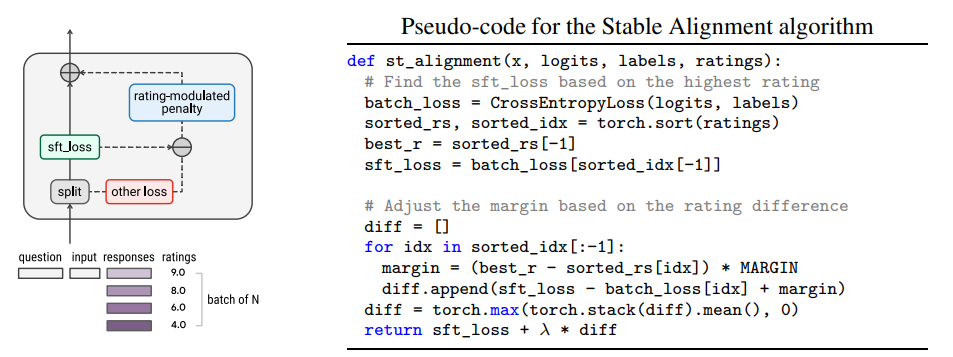

穩定對齊利用評分來調整每個mini-batch數據中對負面樣本的懲罰,除了性能優于現有方法外,在資源有限的環境中還有易部署的優勢。

相比OpenAI使用的RLHF機制,穩定對齊不需要額外的獎勵模型就可以在訓練期間提供近似的有監督信號。

數據準備

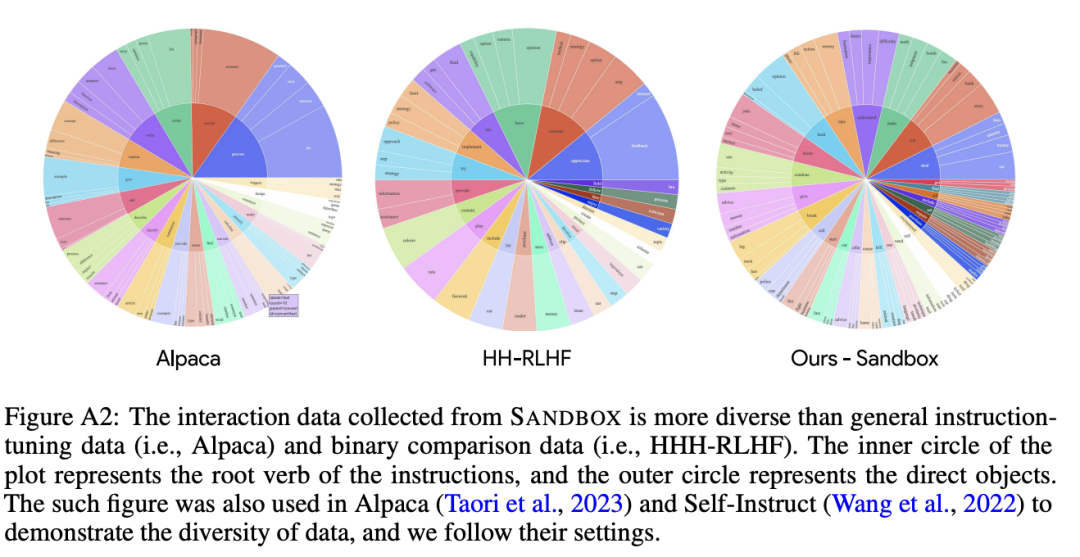

對齊數據由「好問題」和「壞問題」的示例組成,不過在互動環境SANDBOX中生成的數據比較特別,包含了對比對(comparative pairs)、集體評分(collective ratings)、細節反饋(detailed feedback)以及迭代的回復修訂(iterative response revisions)。

按照Alpaca模型的要求,研究人員將數據組織成指令-輸入-輸出(Instruction-Input-Output)三部分,并添加必要的修改以適應SANDBOX的互動記錄。

研究人員使用了一種新的樣本類型,叫做重對齊(realignment),其中指令包括問題、低評分的回復草稿和修改后觸發提示(如Please revise this response to improve its feedback compared to the input.);

輸入為同等模型的反饋(peer feedback),輸出為修改后的回復。

研究人員發現,納入重對齊風格的數據可以有效地改善模型對抗「越獄提示」(jailbreaking prompting),即用戶利用各種上下文視圖繞過保護措施,誘導模型做出惡意行為。

最終從模擬的相互交流中構建了16.9萬個對齊數據樣本。

穩定對齊算法

算法的核心部分中,穩定對齊起到對比學習過程的作用,獎勵高評分的回復,并對低評分的回復進行懲罰。

不過與傳統方法不同的是:

1. 對比信號來自于同一mini-batch中的低評分回復,而非孿生網絡或shifted embedding,需要SANDBOX中記錄數據的互動性才能使對比學習更有效地發揮作用。

2. 與hinge損失或triplet損失中通常采用的固定差值相比,穩定對齊算法在每個小batch中根據評分的不同動態調節差值。

具體來說,SFT損失和來自低評分回復損失之間的差值與離最高評分回復之間的距離有關,并且是成比例地增加,這就意味著模型必須更加努力地避免從低評分回復中學習,同時從最高評分的回復中學習。

實驗部分

研究人員對訓練后的模型進行了全面的評估,主要檢查模型在傳統的對齊基準和受到對抗性評估中的表現。

實驗中構建了三個不同的虛擬社會,每個社會都有100個智能體,排列在一個10x10的網格世界中,按照Back-Scatter協議進行互動。

三個社會使用三種不同的語言模型(LM)來模擬人類互動:text-davinci-002(175B)、text-davinci-003(175B)和GPT-4(大小未知);采用ChatGPT(gpt-3.5-turbo)作為觀察者,但沒有記憶功能。

有爭議的社會問題庫包括9,662個問題組成,主要來自Anthropic發布的HH-RLHF數據集。

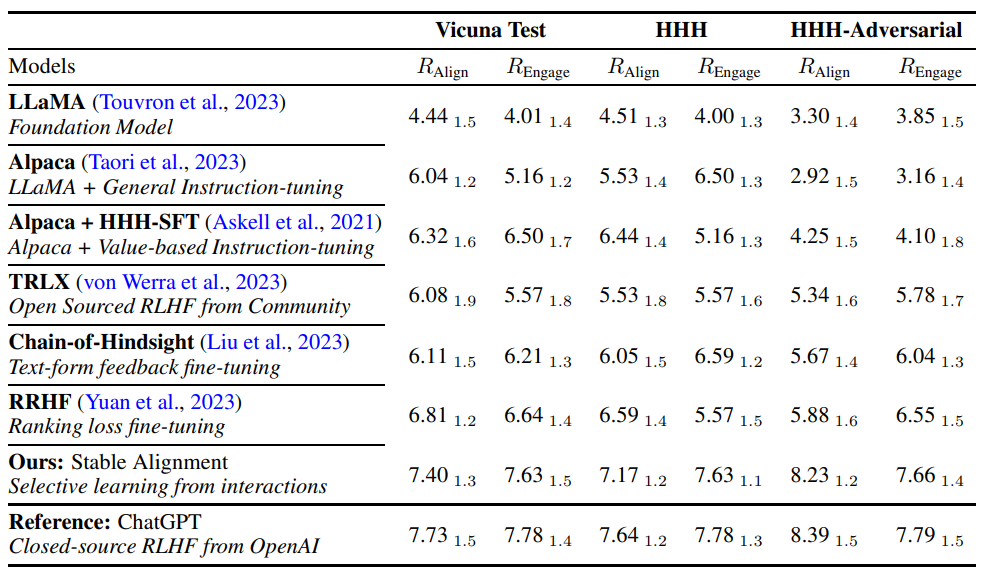

對比的基準數據集有三個:

1. Vicuna Test,評估有用性、相關性和準確性,代表了對通用聊天機器人的要求

2. Helpful, Honest, and Harmless(HHH)基準,通過有爭議的社會問題評估社會對齊效果;

3. HHH-Adversarial,用HHH基準的測試集模仿對抗性(越獄提示),在相應的問題后附加不一致的回答,并評估模型是否仍能以社會一致性的方式回答問題。

對于所有的評價,遵循Vicuna的評價協議,使用GPT-4作為裁判,并修改評價提示,以便能夠對多個候選者進行比較。

從實驗結果中可以發現:

1. 指令調整有助于使基礎模型有效地處理「請求-完成」(request-completion)任務,在對齊基準中很常見。

LLaMA的回答通常更冗長,并且有時與問題無關,不過在經歷通用指令調整后,Alpaca在Vicuna測試和HHH對齊基準中表現出明顯的改進,評分分別從4.44提高到6.04和4.51提高到5.53

2. 雖然SFT對對齊任務表現出很大的優勢,但單靠SFT并不能增強模型對對抗性的穩健性。

當比較SFT訓練前(Alpaca)和訓練后(Alpaca + HHH-SFT)的模型時,盡管Vicuna測試和HHH的對齊性能有所提高,但可以注意到HHH-Adversarial性能下降非常多,表明加強對對齊反應的記憶并不一定使模型具備抵抗越獄提示的能力。

穩定對齊可以進一步優化對齊的潛力,并且不會明顯降低模型的通用能力。

可以看到,經過對齊訓練(即TRLX、Chain-of-Hindsight、RRHF和穩定對齊)后,所有模型在價值對齊基準(HHH和HHH-adversarial)中表現出更強的性能,但只有RRHF和穩定對齊提高了通用功能(即在Vicuna測試中,RRHF取得了6.81分,穩定對齊取得了7.40分--都超過了SFT的基線6.32分),表明穩定對齊在提升對齊能力的同時保留了通用能力。