國內(nèi)高校打造類Sora模型VDT,通用視頻擴(kuò)散Transformer被ICLR 2024接收

2 月 16 日,OpenAI Sora 的發(fā)布無疑標(biāo)志著視頻生成領(lǐng)域的一次重大突破。Sora 基于 Diffusion Transformer 架構(gòu),和市面上大部分主流方法(由 2D Stable Diffusion 擴(kuò)展)并不相同。

為什么 Sora 堅(jiān)持使用 Diffusion Transformer,其中的原因從同時(shí)期發(fā)表在 ICLR 2024(VDT: General-purpose Video Diffusion Transformers via Mask Modeling)的論文可以窺見一二。

這項(xiàng)工作由中國人民大學(xué)研究團(tuán)隊(duì)主導(dǎo),并與加州大學(xué)伯克利分校、香港大學(xué)等進(jìn)行了合作,最早于 2023 年 5 月公開在 arXiv 網(wǎng)站。研究團(tuán)隊(duì)提出了基于 Transformer 的 Video 統(tǒng)一生成框架 - Video Diffusion Transformer (VDT),并對(duì)采用 Transformer 架構(gòu)的原因給出了詳細(xì)的解釋。

- 論文標(biāo)題:VDT: General-purpose Video Diffusion Transformers via Mask Modeling

- 文章地址:Openreview: https://openreview.net/pdf?id=Un0rgm9f04

- arXiv地址: https://arxiv.org/abs/2305.13311

- 項(xiàng)目地址:VDT: General-purpose Video Diffusion Transformers via Mask Modeling

- 代碼地址:https://github.com/RERV/VDT

1.VDT 的優(yōu)越性與創(chuàng)新之處

研究者表示,采用 Transformer 架構(gòu)的 VDT 模型,在視頻生成領(lǐng)域的優(yōu)越性體現(xiàn)在:

- 與主要為圖像設(shè)計(jì)的 U-Net 不同,Transformer 能夠借助其強(qiáng)大的 token 化和注意力機(jī)制,捕捉長(zhǎng)期或不規(guī)則的時(shí)間依賴性,從而更好地處理時(shí)間維度。

- 只有當(dāng)模型學(xué)習(xí)(或記憶)了世界知識(shí)(例如空間時(shí)間關(guān)系和物理法則)時(shí),才能生成與現(xiàn)實(shí)世界相符的視頻。因此,模型的容量成為視頻擴(kuò)散的一個(gè)關(guān)鍵組成部分。Transformer 已經(jīng)被證明具有高度的可擴(kuò)展性,比如 PaLM 模型就擁有高達(dá) 540B 的參數(shù),而當(dāng)時(shí)最大的 2D U-Net 模型大小僅 2.6B 參數(shù)(SDXL),這使得 Transformer 比 3D U-Net 更適合應(yīng)對(duì)視頻生成的挑戰(zhàn)。

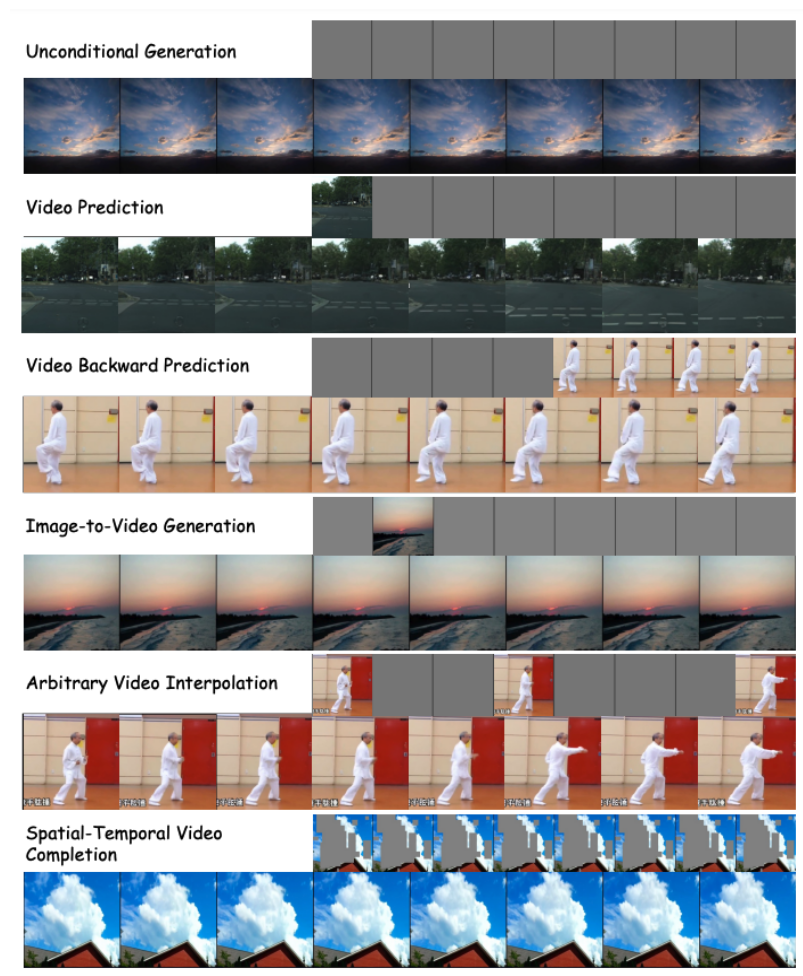

- 視頻生成領(lǐng)域涵蓋了包括無條件生成、視頻預(yù)測(cè)、插值和文本到圖像生成等多項(xiàng)任務(wù)。以往的研究往往聚焦于單一任務(wù),常常需要為下游任務(wù)引入專門的模塊進(jìn)行微調(diào)。此外,這些任務(wù)涉及多種多樣的條件信息,這些信息在不同幀和模態(tài)之間可能有所不同,這就需要一個(gè)能夠處理不同輸入長(zhǎng)度和模態(tài)的強(qiáng)大架構(gòu)。Transformer 的引入能夠?qū)崿F(xiàn)這些任務(wù)的統(tǒng)一。

VDT 的創(chuàng)新之處,主要包括如下幾個(gè)方面:

- 將 Transformer 技術(shù)應(yīng)用于基于擴(kuò)散的視頻生成,展現(xiàn)了 Transformer 在視頻生成領(lǐng)域的巨大潛力。VDT 的優(yōu)勢(shì)在于其出色的時(shí)間依賴性捕獲能力,能夠生成時(shí)間上連貫的視頻幀,包括模擬三維對(duì)象隨時(shí)間的物理動(dòng)態(tài)。

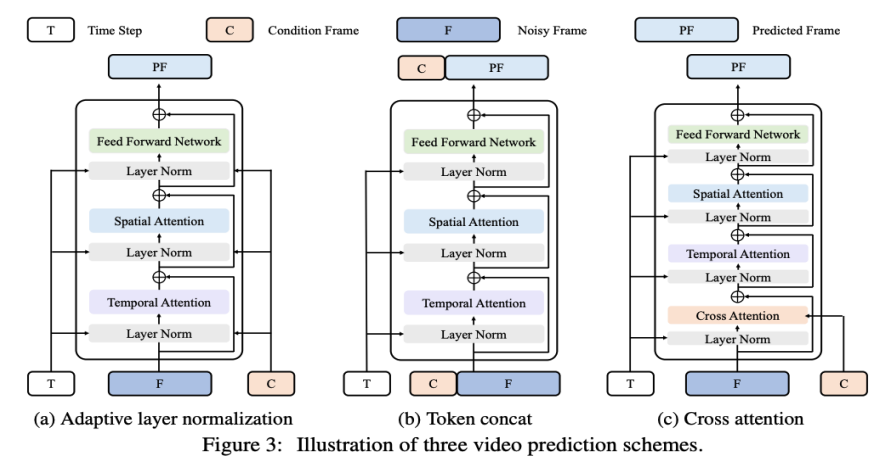

- 提出統(tǒng)一的時(shí)空掩碼建模機(jī)制,使 VDT 能夠處理多種視頻生成任務(wù),實(shí)現(xiàn)了技術(shù)的廣泛應(yīng)用。VDT 靈活的條件信息處理方式,如簡(jiǎn)單的 token 空間拼接,有效地統(tǒng)一了不同長(zhǎng)度和模態(tài)的信息。同時(shí),通過與該工作提出的時(shí)空掩碼建模機(jī)制結(jié)合,VDT 成為了一個(gè)通用的視頻擴(kuò)散工具,在不修改模型結(jié)構(gòu)的情況下可以應(yīng)用于無條件生成、視頻后續(xù)幀預(yù)測(cè)、插幀、圖生視頻、視頻畫面補(bǔ)全等多種視頻生成任務(wù)。

2.VDT 的網(wǎng)絡(luò)架構(gòu)詳細(xì)解讀

VDT 框架與 Sora 的框架非常相似,包括以下幾部分:

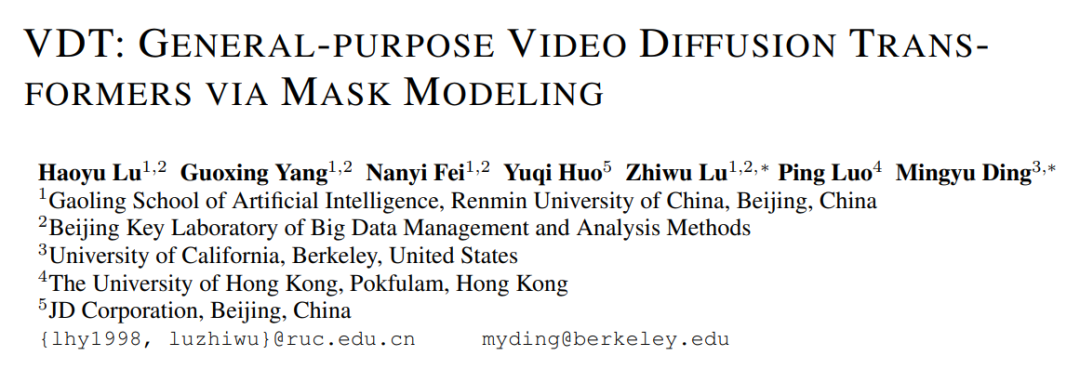

輸入 / 輸出特征。VDT 的目標(biāo)是生成一個(gè) F×H×W×3 的視頻片段,由 F 幀大小為 H×W 的視頻組成。然而,如果使用原始像素作為 VDT 的輸入,尤其是當(dāng) F 很大時(shí),將導(dǎo)致計(jì)算量極大。為解決這個(gè)問題,受潛在擴(kuò)散模型(LDM)的啟發(fā),VDT 使用預(yù)訓(xùn)練的 VAE tokenizer 將視頻投影到潛在空間中。將輸入和輸出的向量維度減少到潛在特征 / 噪聲的 F×H/8×W/8×C,加速了 VDT 的訓(xùn)練和推理速度,其中 F 幀潛在特征的大小為 H/8×W/8。這里的 8 是 VAE tokenizer 的下采樣率,C 表示潛在特征維度。

線性嵌入。遵循 Vision Transformer 的方法,VDT 將潛在視頻特征表示劃分為大小為 N×N 的非重疊 Patch。

時(shí)空 Transformer Block。受到視頻建模中時(shí)空自注意力成功的啟發(fā),VDT 在 Transformer Block 中插入了一個(gè)時(shí)間注意力層,以獲得時(shí)間維度的建模能力。具體來說,每個(gè) Transformer Block 由一個(gè)多頭時(shí)間注意力、一個(gè)多頭空間注意力和一個(gè)全連接前饋網(wǎng)絡(luò)組成,如上圖所示。

對(duì)比 Sora 最新發(fā)布的技術(shù)報(bào)告,可以看到 VDT 和 Sora 在實(shí)現(xiàn)細(xì)節(jié)上僅存在一些細(xì)微差別。

首先,VDT 采用的是在時(shí)空維度上分別進(jìn)行注意力機(jī)制處理的方法,而 Sora 則是將時(shí)間和空間維度合并,通過單一的注意力機(jī)制來處理。這種分離注意力的做法在視頻領(lǐng)域已經(jīng)相當(dāng)常見,通常被視為在顯存限制下的一種妥協(xié)選擇。VDT 選擇采用分離注意力也是出于計(jì)算資源有限的考慮。Sora 強(qiáng)大的視頻動(dòng)態(tài)能力可能來自于時(shí)空整體的注意力機(jī)制。

其次,不同于 VDT,Sora 還考慮了文本條件的融合。之前也有基于 Transformer 進(jìn)行文本條件融合的研究(如 DiT),這里猜測(cè) Sora 可能在其模塊中進(jìn)一步加入了交叉注意力機(jī)制,當(dāng)然,直接將文本和噪聲拼接作為條件輸入的形式也是一種潛在的可能。

在 VDT 的研究進(jìn)程中,研究者將 U-Net 這個(gè)常用的基礎(chǔ)骨干網(wǎng)絡(luò)替換為 Transformer。這不僅驗(yàn)證了 Transformer 在視頻擴(kuò)散任務(wù)中的有效性,展現(xiàn)了便于擴(kuò)展和增強(qiáng)連續(xù)性的優(yōu)勢(shì),也引發(fā)了他們對(duì)于其潛在價(jià)值的進(jìn)一步思考。

隨著 GPT 模型的成功和自回歸(AR)模型的流行,研究者開始探索 Transformer 在視頻生成領(lǐng)域的更深層次應(yīng)用,思考其是否能為實(shí)現(xiàn)視覺智能提供新的途徑。視頻生成領(lǐng)域有一個(gè)與之密切相關(guān)的任務(wù) —— 視頻預(yù)測(cè)。將預(yù)測(cè)下一個(gè)視頻幀作為通往視覺智能的路徑這一想法看似簡(jiǎn)單,但它實(shí)際上是許多研究者共同關(guān)注的問題。

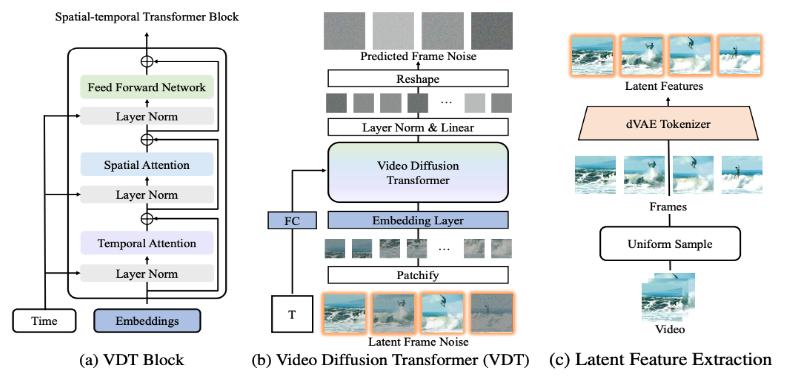

基于這一考慮,研究者希望在視頻預(yù)測(cè)任務(wù)上進(jìn)一步適配和優(yōu)化他們的模型。視頻預(yù)測(cè)任務(wù)也可以視為條件生成,這里給定的條件幀是視頻的前幾幀。VDT 主要考慮了以下三種條件生成方式:

自適應(yīng)層歸一化。實(shí)現(xiàn)視頻預(yù)測(cè)的一種直接方法是將條件幀特征整合到 VDT Block 的層歸一化中,類似于我們?nèi)绾螌r(shí)間信息整合到擴(kuò)散過程中。

交叉注意力。研究者還探索了使用交叉注意力作為視頻預(yù)測(cè)方案,其中條件幀用作鍵和值,而噪聲幀作為查詢。這允許將條件信息與噪聲幀融合。在進(jìn)入交叉注意力層之前,使用 VAE tokenizer 提取條件幀的特征并 Patch 化。同時(shí),還添加了空間和時(shí)間位置嵌入,以幫助我們的 VDT 學(xué)習(xí)條件幀中的對(duì)應(yīng)信息。

Token 拼接。VDT 模型采用純粹的 Transformer 架構(gòu),因此,直接使用條件幀作為輸入 token 對(duì) VDT 來說是更直觀的方法。研究者通過在 token 級(jí)別拼接條件幀(潛在特征)和噪聲幀來實(shí)現(xiàn)這一點(diǎn),然后將其輸入到 VDT 中。接下來,他們將 VDT 的輸出幀序列分割,并使用預(yù)測(cè)的幀進(jìn)行擴(kuò)散過程,如圖 3 (b) 所示。研究者發(fā)現(xiàn),這種方案展示了最快的收斂速度,與前兩種方法相比,在最終結(jié)果上提供了更優(yōu)的表現(xiàn)。此外,研究者發(fā)現(xiàn)即使在訓(xùn)練過程中使用固定長(zhǎng)度的條件幀,VDT 仍然可以接受任意長(zhǎng)度的條件幀作為輸入,并輸出一致的預(yù)測(cè)特征。

在 VDT 的框架下,為了實(shí)現(xiàn)視頻預(yù)測(cè)任務(wù),不需要對(duì)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行任何修改,僅需改變模型的輸入即可。這一發(fā)現(xiàn)引出了一個(gè)直觀的問題:我們能否進(jìn)一步利用這種可擴(kuò)展性,將 VDT 擴(kuò)展到更多樣化的視頻生成任務(wù)上 —— 例如圖片生成視頻 —— 而無需引入任何額外的模塊或參數(shù)。

通過回顧 VDT 在無條件生成和視頻預(yù)測(cè)中的功能,唯一的區(qū)別在于輸入特征的類型。具體來說,輸入可以是純?cè)肼暆撛谔卣鳎蛘呤菞l件和噪聲潛在特征的拼接。然后,研究者引入了 Unified Spatial-Temporal Mask Modeling 來統(tǒng)一條件輸入,如下圖 4 所示:

3.VDT 的性能評(píng)測(cè)

通過上述方法,VDT 模型不僅可以無縫地處理無條件視頻生成和視頻預(yù)測(cè)任務(wù),還能夠通過簡(jiǎn)單地調(diào)整輸入特征,擴(kuò)展到更廣泛的視頻生成領(lǐng)域,如視頻幀插值等。這種靈活性和可擴(kuò)展性的體現(xiàn),展示了 VDT 框架的強(qiáng)大潛力,為未來的視頻生成技術(shù)提供了新的方向和可能性。

有趣的是,除 text-to-video 外,OpenAI 也展示了 Sora 非常驚艷的其他任務(wù),包括基于 image 生成,前后 video predict 以及不同 video clip 相融合的例子等,和研究者提出的 Unified Spatial-Temporal Mask Modeling 所支持的下游任務(wù)非常相似;同時(shí)在參考文獻(xiàn)中也引用了 kaiming 的 MAE。所以,這里猜測(cè) Sora 大概率底層也使用了類 MAE 的訓(xùn)練方法。

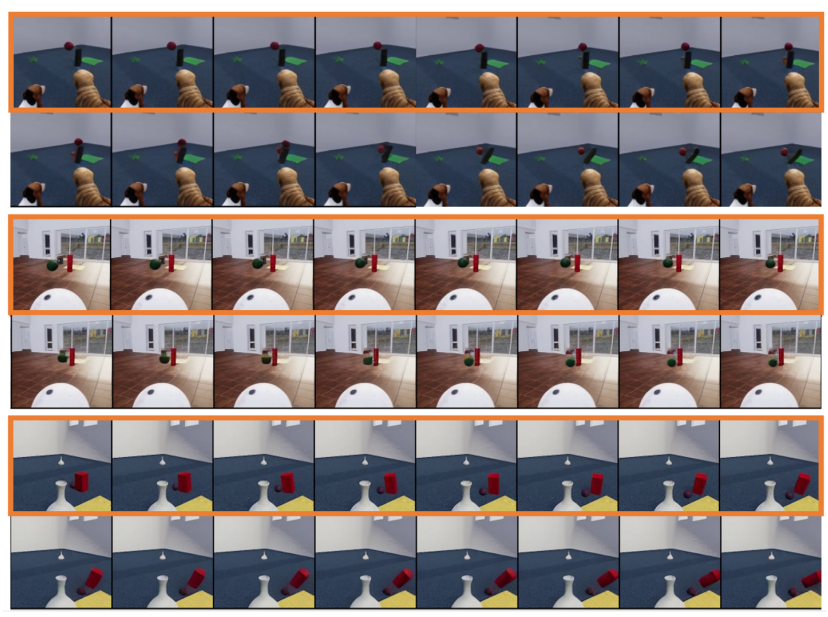

研究者同時(shí)探索了生成模型 VDT 對(duì)簡(jiǎn)單物理規(guī)律的模擬。他們?cè)?Physion 數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),VDT 使用前 8 幀作為條件幀,并預(yù)測(cè)接下來的 8 幀。在第一個(gè)示例(頂部?jī)尚校┖偷谌齻€(gè)示例(底部?jī)尚校┲校琕DT 成功模擬了物理過程,包括一個(gè)沿拋物線軌跡運(yùn)動(dòng)的球和一個(gè)在平面上滾動(dòng)并與圓柱體碰撞的球。在第二個(gè)示例(中間兩行)中,VDT 捕捉到了球的速度 / 動(dòng)量,因?yàn)榍蛟谂鲎矆A柱體前停了下來。這證明了 Transformer 架構(gòu)是可以學(xué)習(xí)到一定的物理規(guī)律。

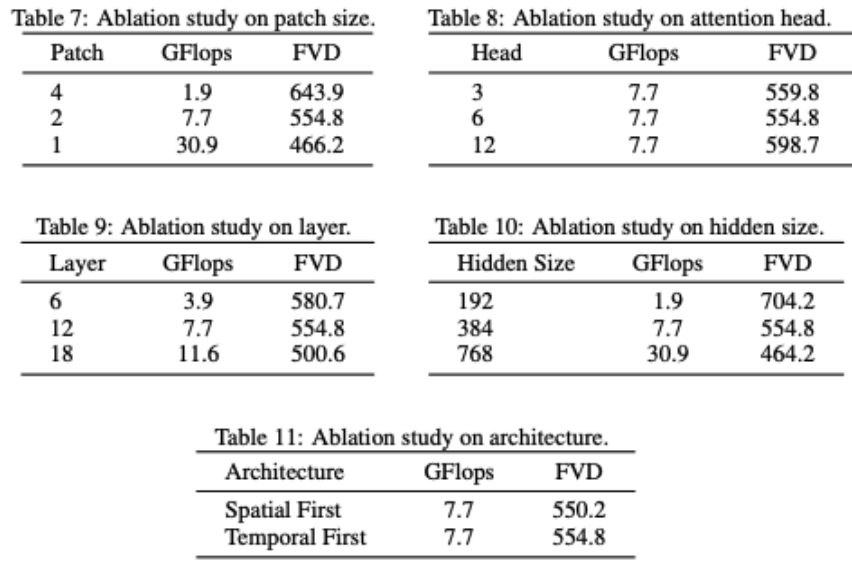

VDT 對(duì)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行部分消融。可以發(fā)現(xiàn)模型性能和 GFlops 強(qiáng)相關(guān),模型結(jié)構(gòu)本身的一些細(xì)節(jié)反而影響不是很大,這個(gè)和 DiT 的發(fā)現(xiàn)也是一致的。

研究者還對(duì) VDT 模型進(jìn)行了一些結(jié)構(gòu)上的消融研究。結(jié)果表明,減小 Patchsize、增加 Layers 的數(shù)量以及增大 Hidden Size 都可以進(jìn)一步提高模型的性能。Temporal 和 Spatial 注意力的位置以及注意力頭的數(shù)量對(duì)模型的結(jié)果影響不大。在保持相同 GFlops 的情況下,需要一些設(shè)計(jì)上的權(quán)衡,總體而言,模型的性能沒有顯著差異。但是,GFlops 的增加會(huì)帶來更好的結(jié)果,這展示了 VDT 或者 Transformer 架構(gòu)的可擴(kuò)展性。

VDT 的測(cè)試結(jié)果證明了 Transformer 架構(gòu)在處理視頻數(shù)據(jù)生成方面的有效性和靈活性。由于計(jì)算資源的限制,VDT 只在部分小型學(xué)術(shù)數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn)。我們期待未來研究能夠在 VDT 的基礎(chǔ)上,進(jìn)一步探索視頻生成技術(shù)的新方向和應(yīng)用,也期待中國公司能早日推出國產(chǎn) Sora 模型。