LeCun怒斥Sora是世界模型,自回歸LLM太簡化了

最近幾天,Sora 成為了全世界關注的焦點。與之相關的一切,都被放大到極致。

Sora 如此出圈,不僅在于它能輸出高質量的視頻,更在于 OpenAI 將其定義為一個「世界模擬器」(world simulators)。

英偉達高級研究科學家 Jim Fan 甚至斷言:「Sora 是一個數據驅動的物理引擎」,「是一個可學習的模擬器,或『世界模型』」。

「Sora 是世界模型」這種觀點,讓一直將「世界模型」作為研究重心的圖靈獎得主 Yann LeCun 有些坐不住了。在 LeCun 看來,僅僅根據 prompt 生成逼真視頻并不能代表一個模型理解了物理世界,生成視頻的過程與基于世界模型的因果預測完全不同。

圖源:https://twitter.com/ylecun/status/1758740106955952191

雖然 Sora 的發布讓整個 AI 界為之瘋狂,但 LeCun 并不看好。他不止一次的公開表達過對自回歸和 LLM 的批評,而自回歸模型是包括 Sora 等在內的 GPT 系列 LLM 模型所依賴的學習范式,也就是說,從 ChatGPT 到 Sora,OpenAI 都是采用的自回歸生成式路線。

然而 LeCun 多次唱衰這種技術路線,他曾表達過一些不滿,比如「從現在起 5 年內,沒有哪個頭腦正常的人會使用自回歸模型。」「自回歸生成模型弱爆了!(Auto-Regressive Generative Models suck!)」「LLM 對世界的理解非常膚淺。」等言論。

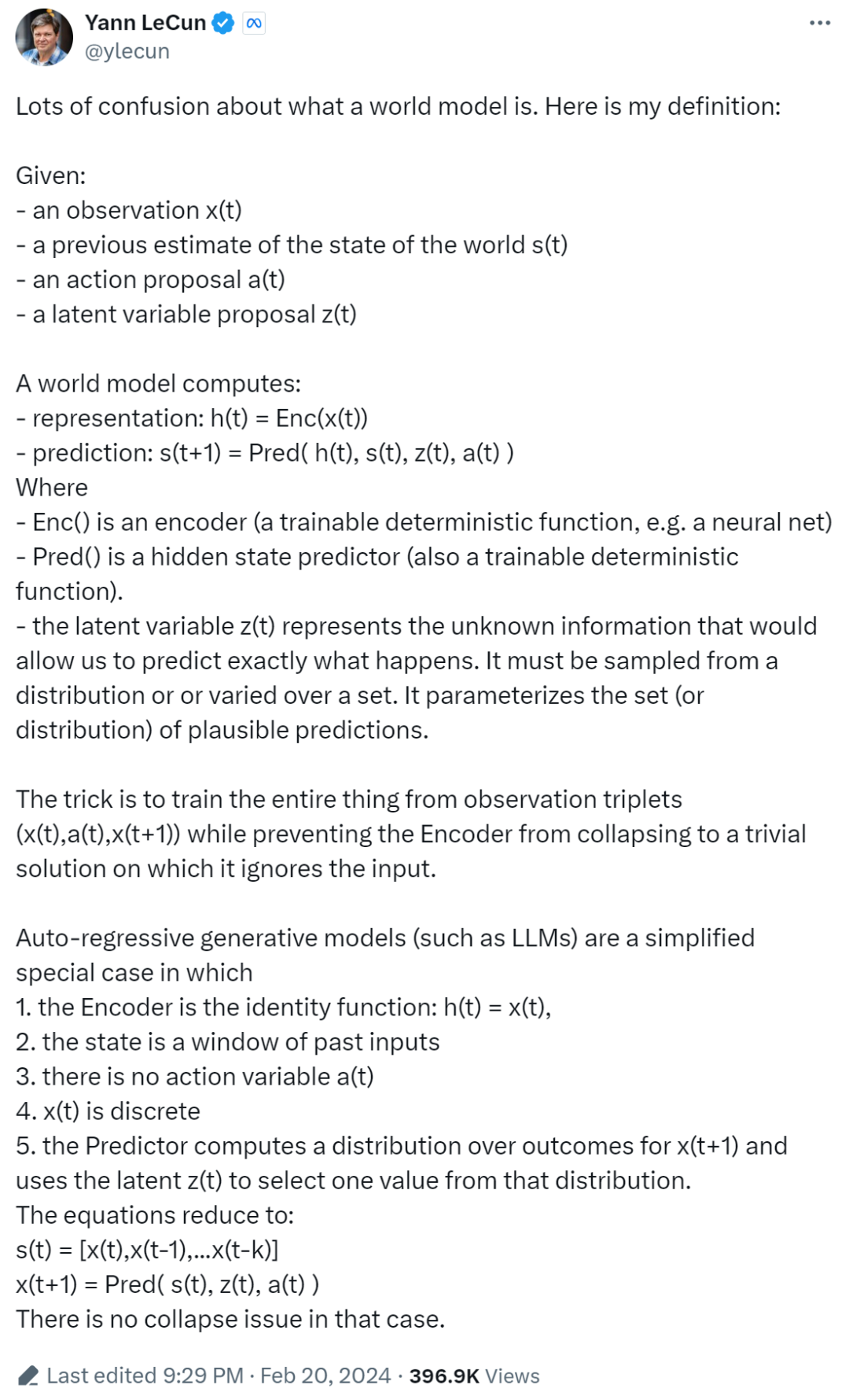

世界模型和自回歸 LLM 到底該如何定義?身為全球知名的 AI 研究學者,LeCun 自然不是一位全然的批評家,最近,他給出了世界模型的新定義。在他看來,自回歸生成模型僅僅是世界模型的一種簡化的特殊情況。與大家在互聯網上看到的動不動就是長篇大論的科普不同,LeCun 以一種簡單直白的方式給出了世界模型的定義。

圖源:https://twitter.com/ylecun/status/1759933365241921817

對于給定的:

- 觀察值 x (t);

- 對世界狀態的先前估計 s (t);

- 動作建議 a (t);

- 潛在變量建議 z (t)。

世界模型需要計算出:

- 表征:h (t) = Enc (x (t));

- 給出預測:s (t+1) = Pred ( h (t), s (t), z (t), a (t) )。

其中,

- Enc () 是一個編碼器(我們可以理解為一個可訓練的確定性函數,例如神經網絡);

- Pred () 是一個隱藏狀態預測器(也是一個可訓練的確定性函數);

- 潛在變量 z (t) 代表未知信息,可以準確預測將來會發生什么。z (t) 變量必須從一個分布中進行采樣,或者在一組中變化。它參數化了(或分布)一系列可能的預測。換句話說,變量 z (t) 定義了一個可能性空間,我們根據這個空間來預測未來可能發生的情況。

訣竅是通過觀察三元組 (x (t),a (t),x (t+1)) 來訓練整個模型,同時防止 Encoder 坍縮。

自回歸生成模型(例如 LLM,Sora 就是這種路線)是一種簡化的特殊情況,原因在于:

1. Encoder 是恒等函數:h (t) = x (t);

2. 狀態是過去輸入的窗口;

3. 沒有動作變量 a (t);

4. x (t) 是離散的;

5. 預測器計算 x (t+1) 結果的分布,并使用潛在 z (t) 從該分布中選擇一個值。

方程簡化為:

s (t) = [x (t),x (t-1),...x (t-k)]

x (t+1) = Pred ( s (t), z (t), a (t) )

在這種情況下不存在坍縮問題。

這可能就是 LeCun 極力反對 Sora 是世界模型這種說法的一個重要原因 —— 它只是世界模型中一種簡化的特殊情況。

不過話說回來,Jim Fan 又在 LeCun 的這條推文下方留言,他堅持道:「Sora 本質上是一種無操作(no-op)的世界模型。你可以設置世界的初始狀態,在潛在空間中運行模擬,并被動地觀察會發生什么。現在沒有辦法進行積極干預。」

至于 Sora 到底是不是世界模型我們暫且不議,混淆大家多時的「世界模型」的定義,現在終于被 LeCun 講明白了。