谷歌發布最新「讀屏」AI!PaLM 2-S自動生成數據,多項理解任務刷新SOTA

每個人想要的大模型,是真·智能的那種......

這不,谷歌團隊就做出來了一個強大的「讀屏」AI。

研究人員將其稱為ScreenAI,是一種理解用戶界面和信息圖表的全新視覺語言模型。

論文地址:https://arxiv.org/pdf/2402.04615.pdf

ScreenAI的核心是一種新的屏幕截圖文本表示方法,可以識別UI元素的類型和位置。

值得一提的是,研究人員使用谷歌語言模型PaLM 2-S生成了合成訓練數據,以訓練模型回答關屏幕信息、屏幕導航和屏幕內容摘要的問題。

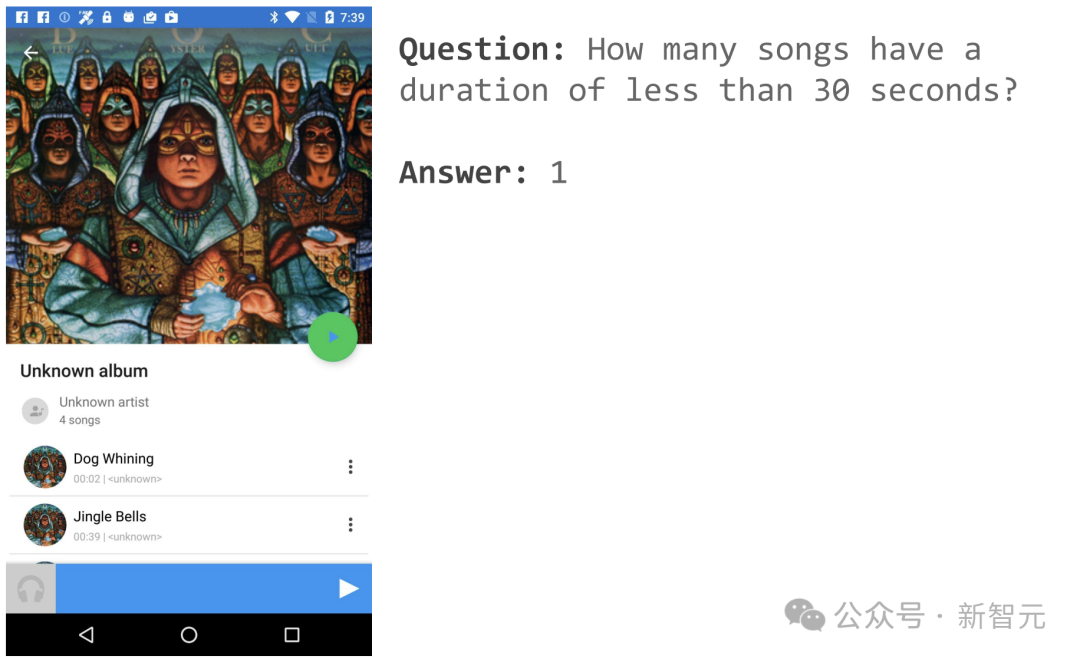

舉個栗子,比如打開一音樂APP頁面,可以詢問「有幾首歌時長少于30秒」?

ScreenAI便給出了簡單的答案:1。

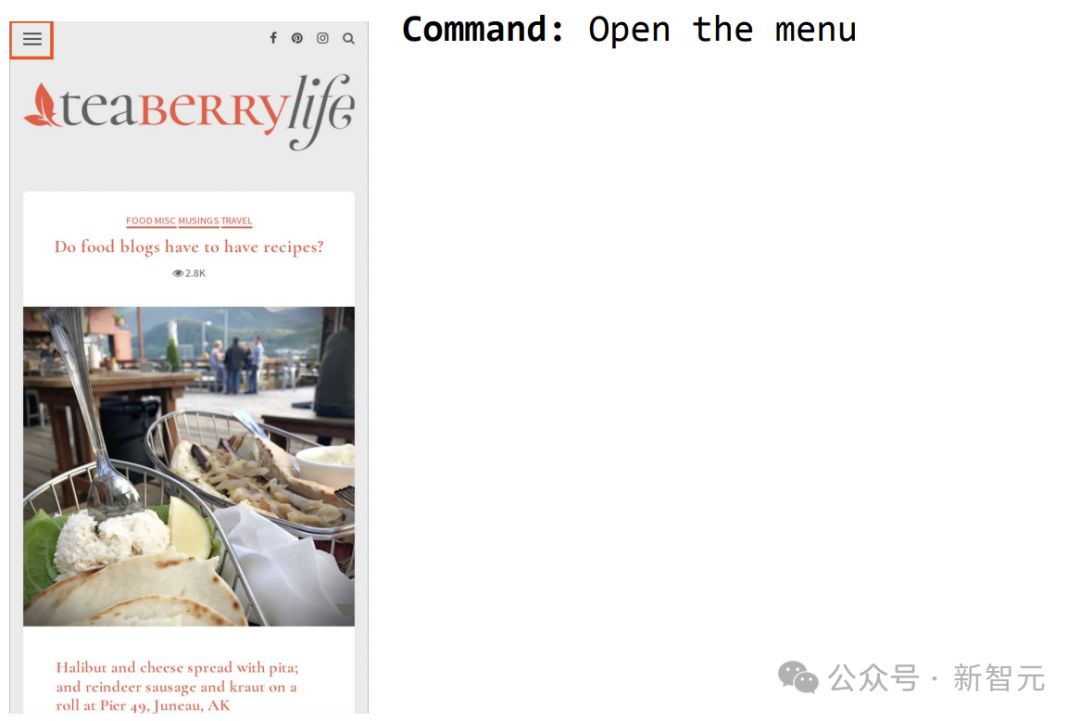

再比如命令ScreenAI打開菜單,就可以選中。

架構靈感來源——PaLI

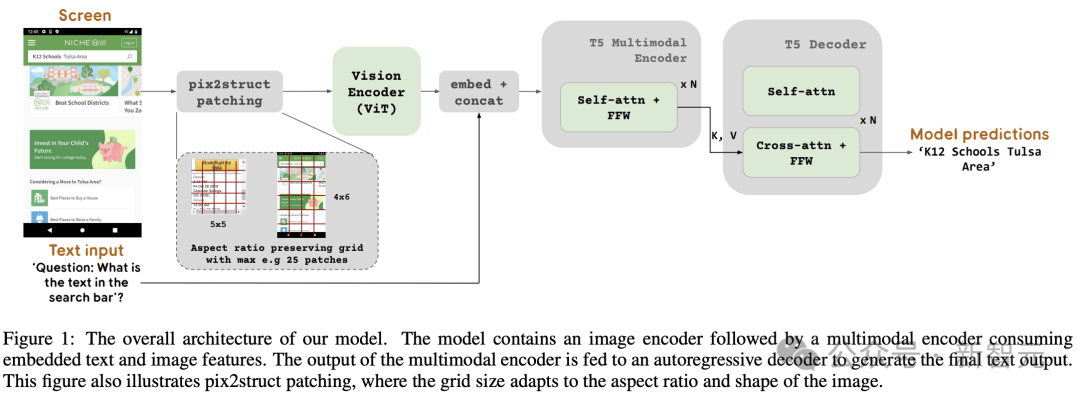

圖1中展示了ScreenAI模型架構。研究人員受到了PaLI系列模型架構(由一個多模態編碼器塊組成)的啟發。

該編碼器塊包含一個類似ViT的視覺編碼器和一個消費圖像(consuming image)和文本輸入的mT5語言編碼器,后接一個自回歸解碼器。

輸入圖像通過視覺編碼器轉化為一系列嵌入,這些嵌入與輸入文本嵌入結合,一起輸入mT5語言編碼器。

編碼器的輸出傳遞給解碼器,生成文本輸出。

這種泛化公式能夠使用相同的模型架構,解決各種視覺和多模態任務。這些任務可以重新表述為文本+圖像(輸入)到文本(輸出)的問題。

與文本輸入相比,圖像嵌入構成了多模態編碼器輸入長度的重要部分。

簡而言之,該模型采用圖像編碼器和語言編碼器提取圖像與文本特征,將二者融合后輸入解碼器生成文本。

這種構建方式可以廣泛適用于圖像理解等多模態任務。

另外,研究人員還進一步擴展了PaLI的編碼器-解碼器架構,以接受各種圖像分塊模式。

原始的PaLI架構只接受固定網格模式的圖像塊來處理輸入圖像。然而,研究人員在屏幕相關領域遇到的數據,跨越了各種各樣的分辨率和寬高比。

為了使單個模型能夠適應所有屏幕形狀,有必要使用一種適用于各種形狀圖像的分塊策略。

為此,谷歌團隊借鑒了Pix2Struct中引入的一種技術,允許根據輸入圖像形狀和預定義的最大塊數,生成任意網格形狀的圖像塊,如圖1所示。

這樣能夠適應各種格式和寬高比的輸入圖像,而無需對圖像進行填充或拉伸以固定其形狀,從而使模型更通用,能夠同時處理移動設備(即縱向)和臺式機(即橫向)的圖像格式。

模型配置

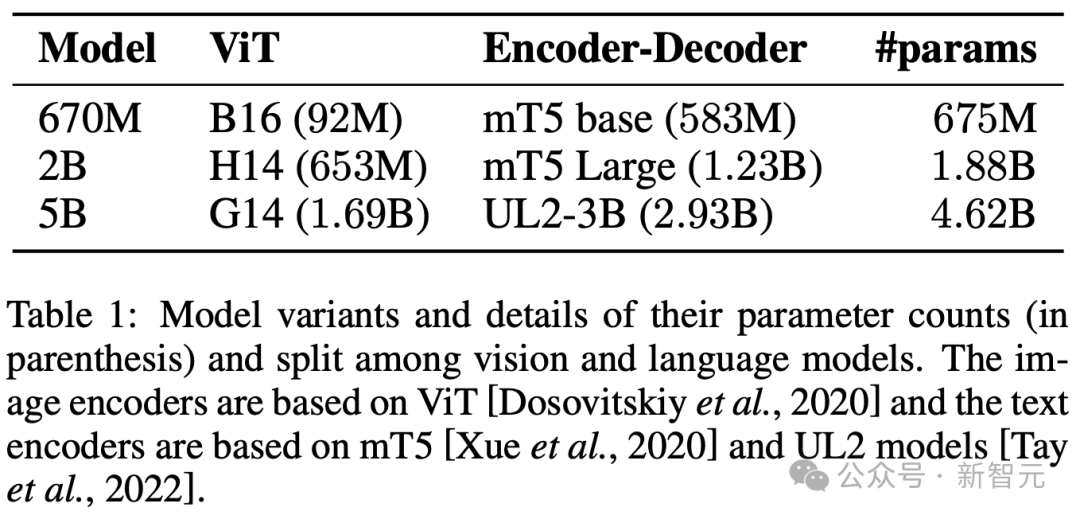

研究人員訓練了3種不同大小的模型,包含670M、2B和5B參數。

對于670M和2B參數模型,研究人員從視覺編碼器和編碼器-解碼器語言模型的預訓練單峰檢查點開始。

對于5B參數模型,從 PaLI-3的多模態預訓練檢查點開始,其中ViT與基于UL2的編碼器-解碼器語言模型一起訓練。

表1中可以看到視覺和語言模型之間的參數分布情況。

自動數據生成

研究人員稱,模型開發的預訓練階段很大程度上,取決于對龐大且多樣化的數據集的訪問。

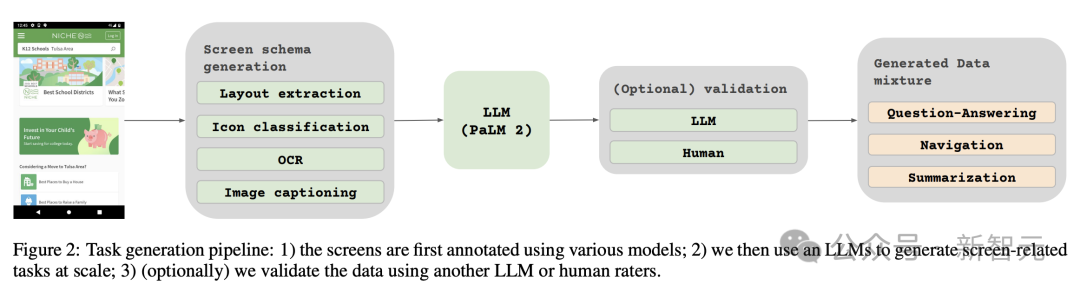

然而手動標注廣泛的數據集是不切實際的,因此谷歌團隊的策略是——自動數據生成。

這種方法利用專門的小模型,每個模型都擅長高效且高精度地生成和標記數據。

與手動標注相比,這種自動化方法不僅高效且可擴展,而且還確保了一定程度的數據多樣性和復雜性。

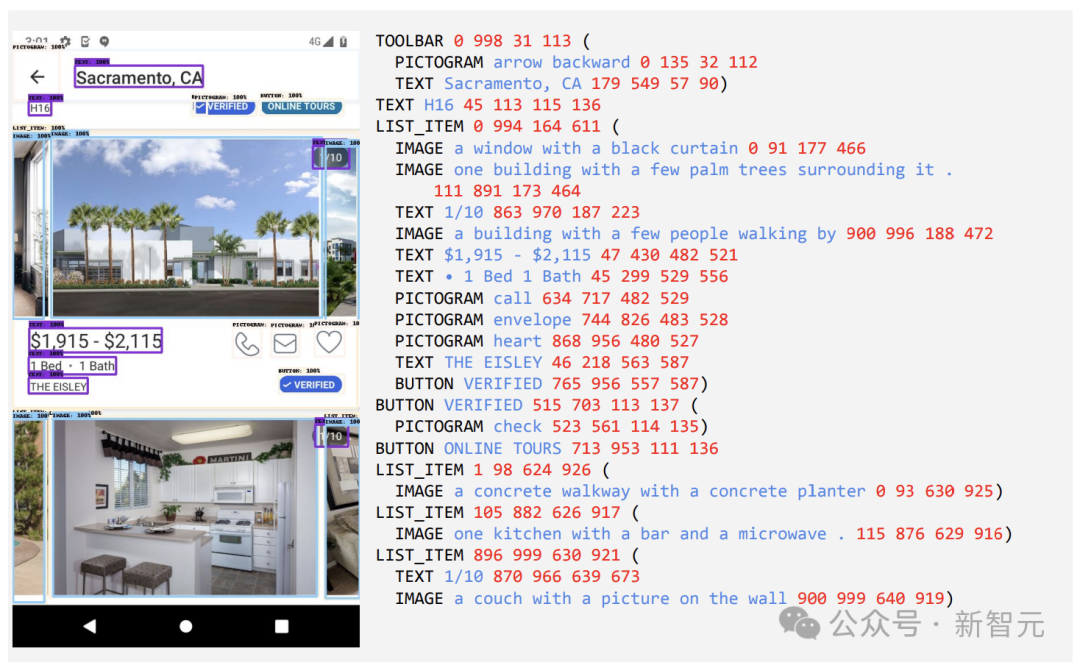

第一步是讓模型全面了解文本元素、各種屏幕組件及其整體結構和層次結構。這種基礎理解對于模型準確解釋各種用戶界面并與之交互的能力至關重要。

這里,研究人員通過爬蟲應用程序和網頁,從各種設備(包括臺式機、移動設備和平板電腦)收集了大量屏幕截圖。

然后,這些屏幕截圖會使用詳細的標簽進行標注,這些標簽描述了UI 元素、它們的空間關系以及其他描述性信息。

此外,為了給預訓練數據注入更大的多樣性,研究人員還利用語言模型的能力,特別是PaLM 2-S分兩個階段生成QA對。

首先生成之前描述的屏幕模式。隨后,作者設計一個包含屏幕模式的提示,指導語言模型生成合成數據。

經過幾次迭代后,可以確定一個有效生成所需任務的提示,如附錄C所示。

為了評估這些生成響應的質量,研究人員對數據的一個子集進行了人工驗證,以確保達到預定的質量要求。

該方法在圖2中進行了描述,大大提升預訓練數據集的深度與廣度。

通過利用這些模型的自然語言處理能力,結合結構化的屏幕模式,便可以模擬各種用戶交互和情景。

兩組不同任務

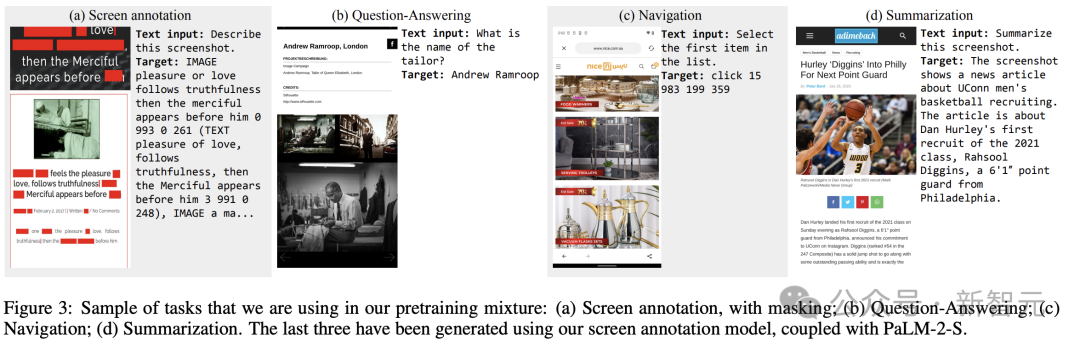

接下來,研究人員為模型定義了兩組不同的任務:一組初始的預訓練任務和一組后續的微調任務。

這兩組的區別主要在于兩個方面:

- 真實數據的來源:對于微調任務,標記由人類評估者提供或驗證。對于預訓練任務,標記是使用自監督學習方法推斷的或使用其他模型生成的。

- 數據集的大小:通常預訓練任務包含大量的樣本,因此,這些任務用于通過更擴展的一系列步驟來訓練模型。

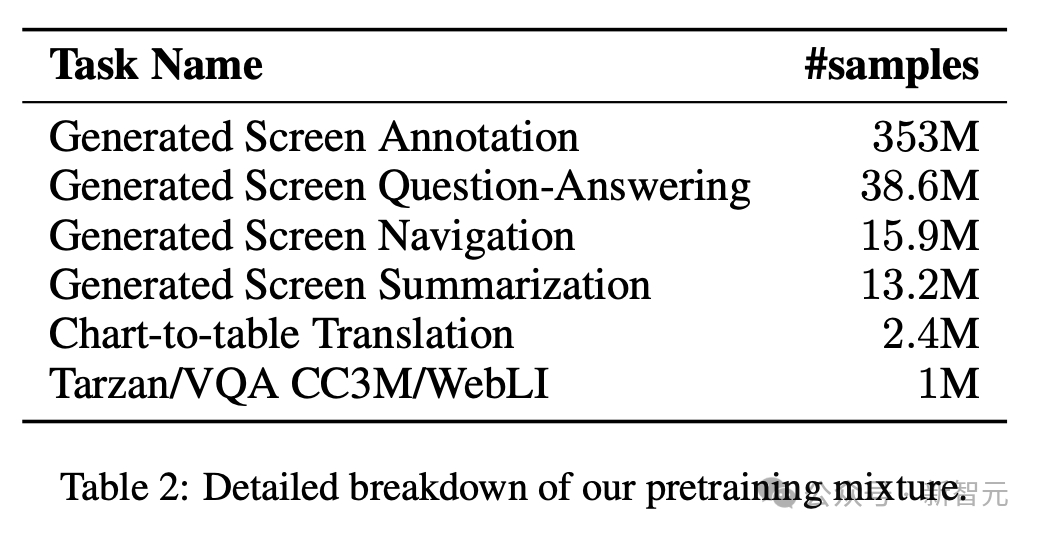

表2顯示所有預訓練任務的摘要。

在混合數據中,數據集按其大小按比例加權,每個任務允許的最大權重。

將多模態源納入多任務訓練中,從語言處理到視覺理解和網頁內容分析,使模型能夠有效處理不同的場景,并增強其整體多功能性和性能。

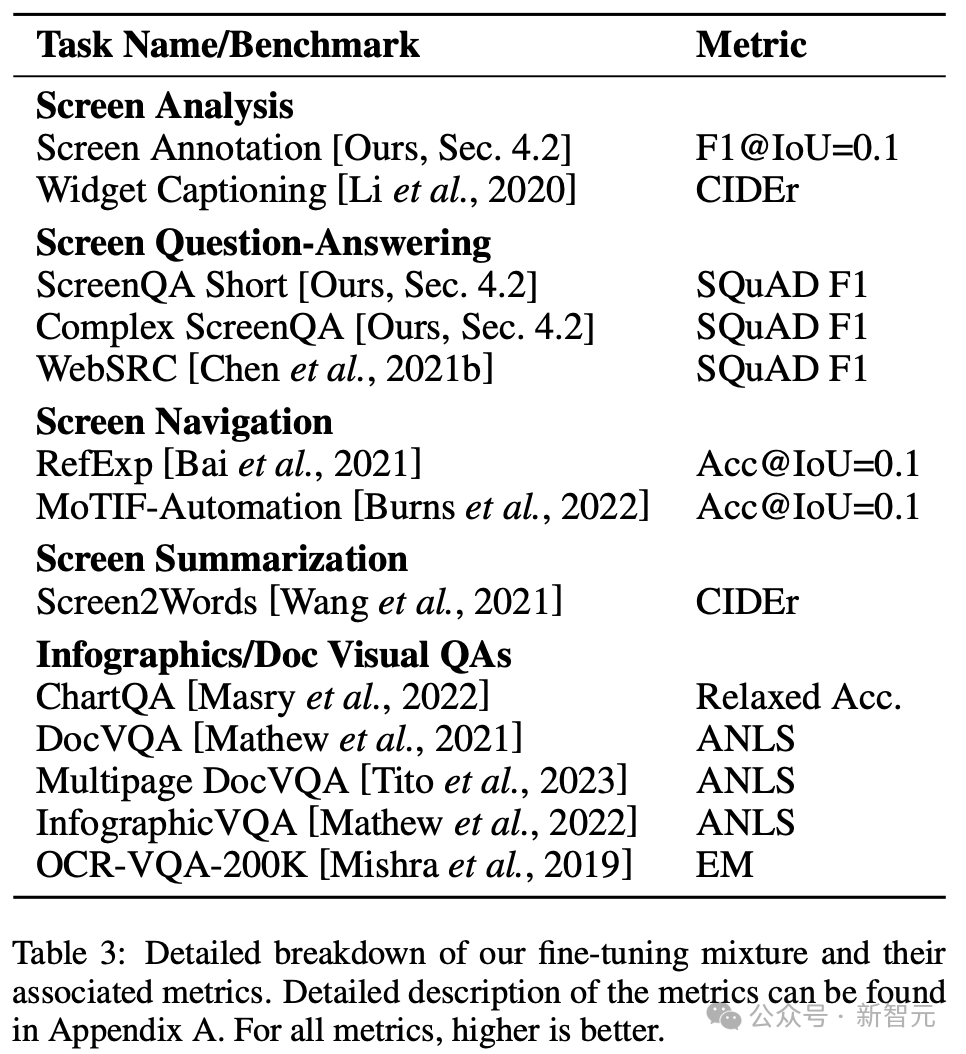

研究人員在微調期間使用各種任務和基準來估計模型的質量。表3總結了這些基準,包括現有的主要屏幕、信息圖表和文檔理解基準。

實驗結果

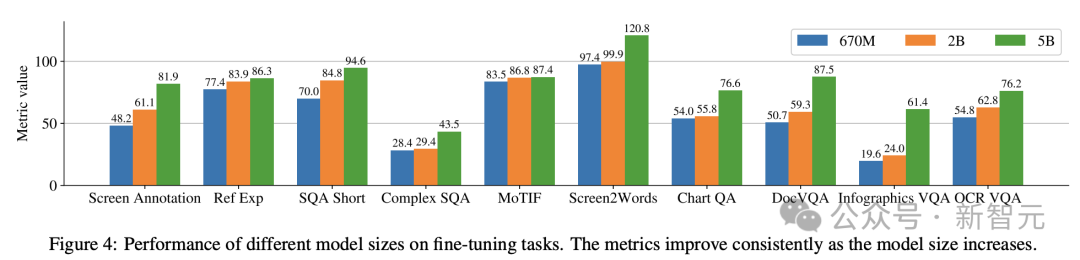

圖4顯示了ScreenAI模型的性能,并將其與各種與屏幕和信息圖形相關的任務上的最新SOT結果進行了比較。

可以看到,ScreenAI在不同任務上取得的領先性能。

在表4中,研究人員呈現了使用OCR數據的單任務微調結果。

對于QA任務,添加OCR可以提高性能(例如Complex ScreenQA、MPDocVQA和InfoVQA上高達4.5%)。

然而,使用OCR會稍微增加輸入長度,從而導致整體訓練速度更慢。它還需要在推理時獲取OCR結果。

另外,研究人員使用以下模型規模進行了單任務實驗:6.7億參數、20億參數和50億參數。

在圖4中可以觀察到,對于所有任務,增加模型規模都可以改進性能,在最大規模下的改進還沒有飽和。

對于需要更復雜的視覺文本和算術推理的任務(例如InfoVQA、ChartQA和Complex ScreenQA),20億參數模型和50億參數模型之間的改進明顯大于6.7億參數模型和20億參數模型。

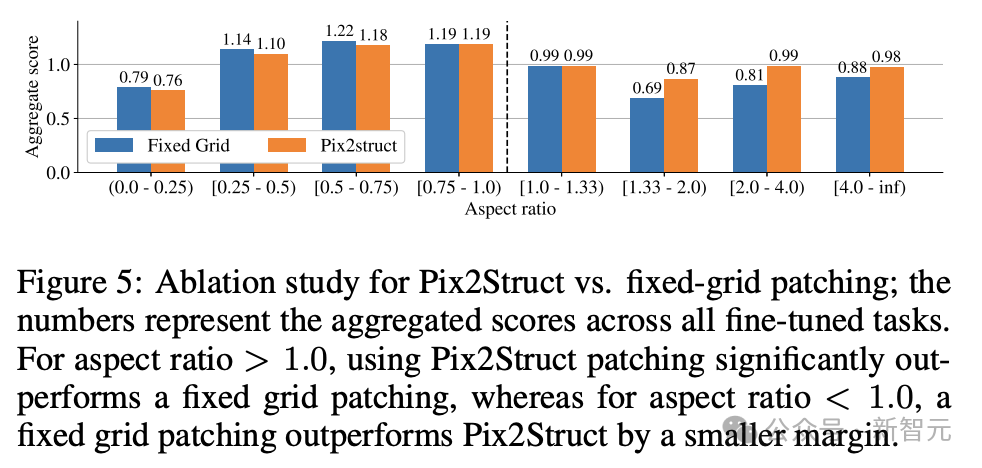

最后,圖5顯示了,對于長寬比>1.0的圖像(橫向模式圖像),pix2struct分割策略明顯優于固定網格分割。

對于縱向模式圖像,趨勢相反,但固定網格分割僅稍微好一些。

鑒于研究人員希望ScreenAI模型能夠在不同長寬比的圖像上使用,因此選擇使用pix2struct分割策略。

谷歌研究人員表示,ScreenAI模型還需要在一些任務上進行更多研究,以縮小與GPT-4和Gemini等更大模型的差距。