LLM數(shù)學(xué)性能暴漲168%,微軟14人團(tuán)隊(duì)力作!合成數(shù)據(jù)2.0秘訣曝光,智能體生成教學(xué)

全世界高質(zhì)量數(shù)據(jù)幾乎枯竭。

AI科學(xué)家們?yōu)榱私鉀Q這一難題,可謂是絞盡腦汁。

目前來(lái)看,合成數(shù)據(jù)或許就是大模型的未來(lái),也成為業(yè)界公認(rèn)的解決之法。

就連英偉達(dá)科學(xué)家Jim Fan曾發(fā)文表示,合成數(shù)據(jù)將提供下一萬(wàn)億個(gè)高質(zhì)量的訓(xùn)練token。

但是,用合成數(shù)據(jù),并非完全對(duì)LLM訓(xùn)練有幫助。

前段時(shí)間,Nature封面研究顯示,合成數(shù)據(jù)迭代9次后,會(huì)讓大模型崩潰。而且,類似的研究比比皆是。

那么,我們?cè)撛趺崔k呢?

最近,微軟團(tuán)隊(duì)提出了可擴(kuò)展的智能體框架——AgentInstruct,可自動(dòng)創(chuàng)建大量多樣化、高質(zhì)量的合成數(shù)據(jù)。

它最大的優(yōu)勢(shì)在于,僅只用原始數(shù)據(jù)源,就能創(chuàng)建完整的提示和回應(yīng)。

論文地址:https://arxiv.org/pdf/2407.03502

對(duì)此,研究人員使用AgentInstruct,創(chuàng)建了2500萬(wàn)對(duì)「后訓(xùn)練」數(shù)據(jù)集,涵蓋了多種使用技能,如文本編輯、創(chuàng)意寫作、工具使用、編碼、閱讀理解等。

然后,他們利用這些數(shù)據(jù)對(duì)Mistral-7b進(jìn)行后訓(xùn)練,得到了Orca-3模型。

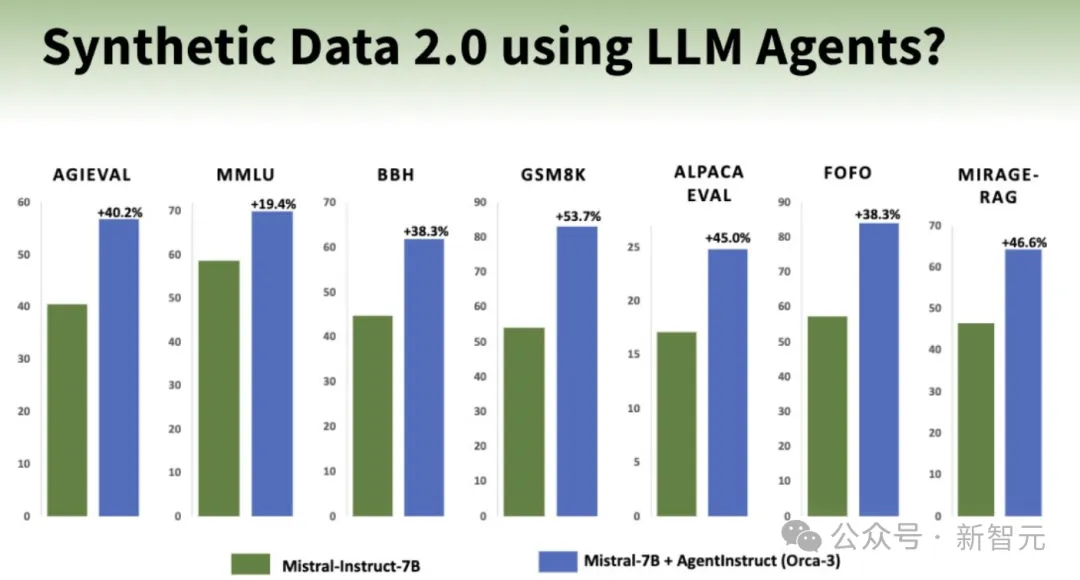

與原始的Mistral-7b-Instruct相比,Orca-3在多個(gè)基準(zhǔn)測(cè)試中,都顯示出顯著的性能提升。

而在數(shù)學(xué)方面上的表現(xiàn),性能直接暴漲168%。

當(dāng)「合成數(shù)據(jù)」遇上智能體

過(guò)去一年,我們見證了智能體的興起。

智能體可以生成高質(zhì)量的數(shù)據(jù),通過(guò)反思和迭代,其能力反超了底層基礎(chǔ)大模型。

在這個(gè)過(guò)程中,智能體可以回顧解決方案,自我批評(píng),并改進(jìn)解決方案。它們甚至可以利用工具,如搜索API、計(jì)算器、代碼解釋,來(lái)擴(kuò)展大模型的能力。

此外,多智能體還可以帶來(lái)更多的優(yōu)勢(shì),比如模擬場(chǎng)景,同時(shí)生成新的提示和響應(yīng)。

它們還可以實(shí)現(xiàn)數(shù)據(jù)生成工作流的自動(dòng)化,減少或消除某些任務(wù)對(duì)人工干預(yù)的需求。

論文中,作者提出了「生成式教學(xué)」的概念。

這是說(shuō),使用合成數(shù)據(jù)進(jìn)行后訓(xùn)練,特別是通過(guò)強(qiáng)大的模型創(chuàng)建數(shù)據(jù),來(lái)教另一個(gè)模型新技能或行為。

AgentInstruct是生成式教學(xué)的一個(gè)智能體解決方案。

總而言之,AgentInstruct可以創(chuàng)建:

- 高質(zhì)量數(shù)據(jù):使用強(qiáng)大的模型如GPT-4,結(jié)合搜索和代碼解釋器等工具。

- 多樣化數(shù)據(jù):AgentInstruct同時(shí)生成提示和回應(yīng)。它使用多智能體(配備強(qiáng)大的LLM、工具和反思流程)和一個(gè)包含100多個(gè)子類別的分類法,來(lái)創(chuàng)建多樣化和高質(zhì)量的提示和回應(yīng)。

- 大量數(shù)據(jù):AgentInstruct可以自主運(yùn)行,并可以應(yīng)用驗(yàn)證和數(shù)據(jù)過(guò)濾的流程。它不需要種子提示,而是使用原始文檔作為種子。

生成式教學(xué):AgentInstruct

我們?nèi)绾蝿?chuàng)建海量數(shù)據(jù)?如何保證生成的數(shù)據(jù)具有多樣性?如何生成復(fù)雜或微妙的數(shù)據(jù)?

為此,研究人員概述了解決這些挑戰(zhàn)的結(jié)構(gòu)化方法:

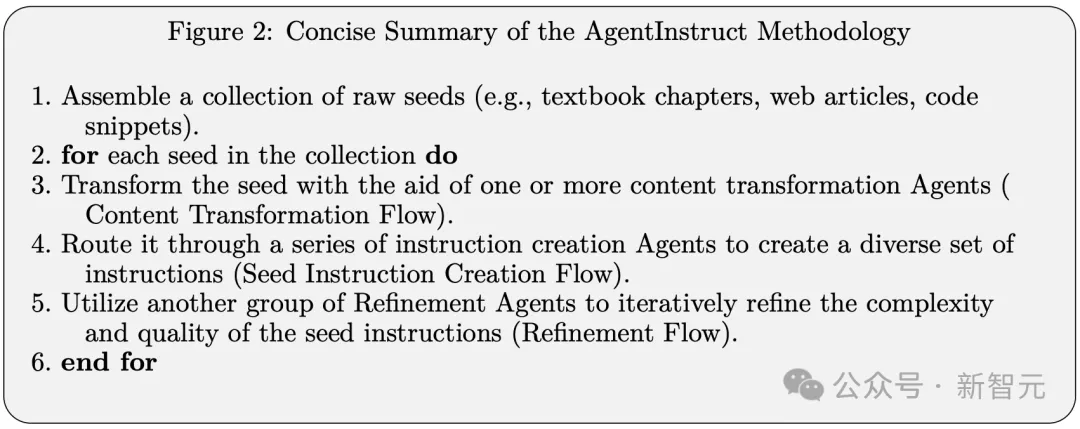

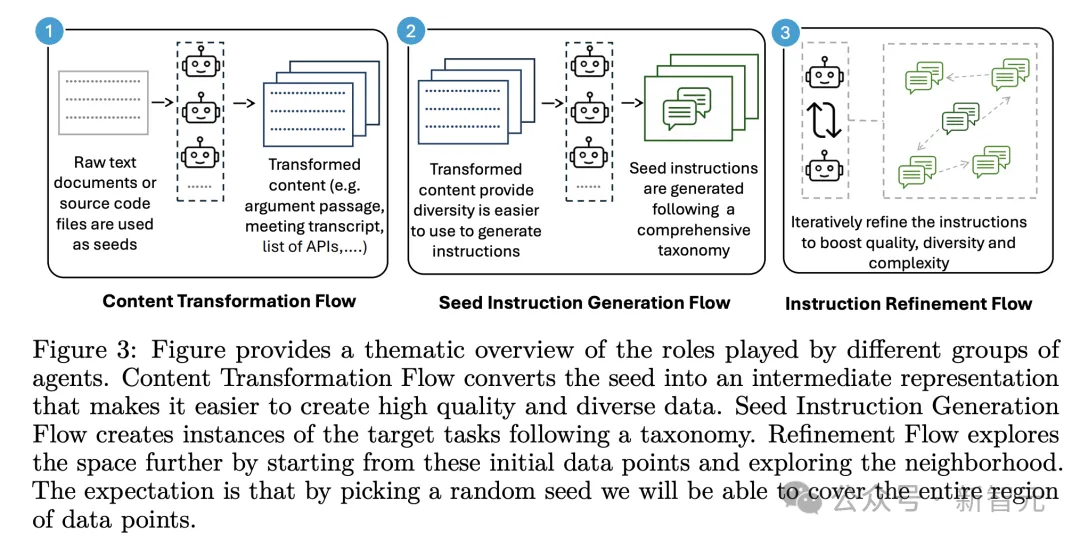

具體來(lái)說(shuō),AgentInstruct定義了三種不同的自動(dòng)化生成流程:

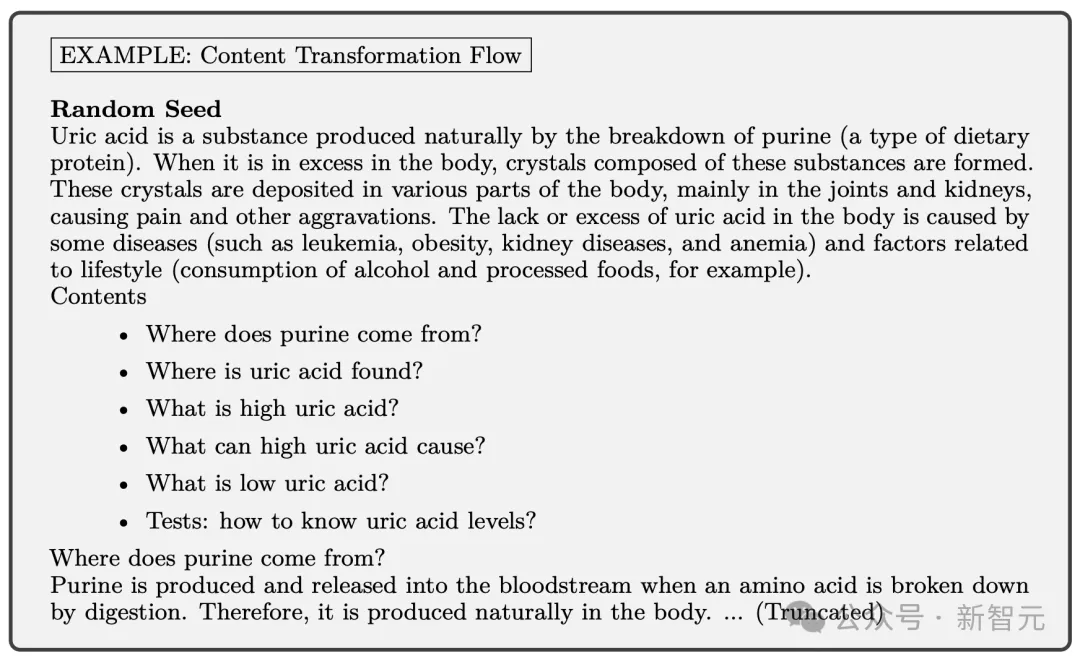

內(nèi)容轉(zhuǎn)換流程:將原始種子轉(zhuǎn)換為中間表示,簡(jiǎn)化了針對(duì)特定目標(biāo)創(chuàng)建指令的過(guò)程。

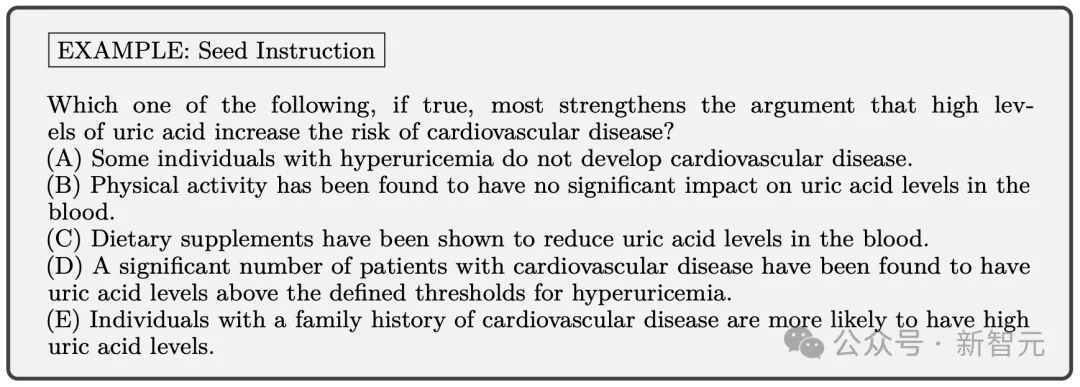

種子指令生成流程:由多個(gè)智能體組成,以內(nèi)容轉(zhuǎn)換流程的轉(zhuǎn)換后種子為輸入,生成一組多樣化的指令。

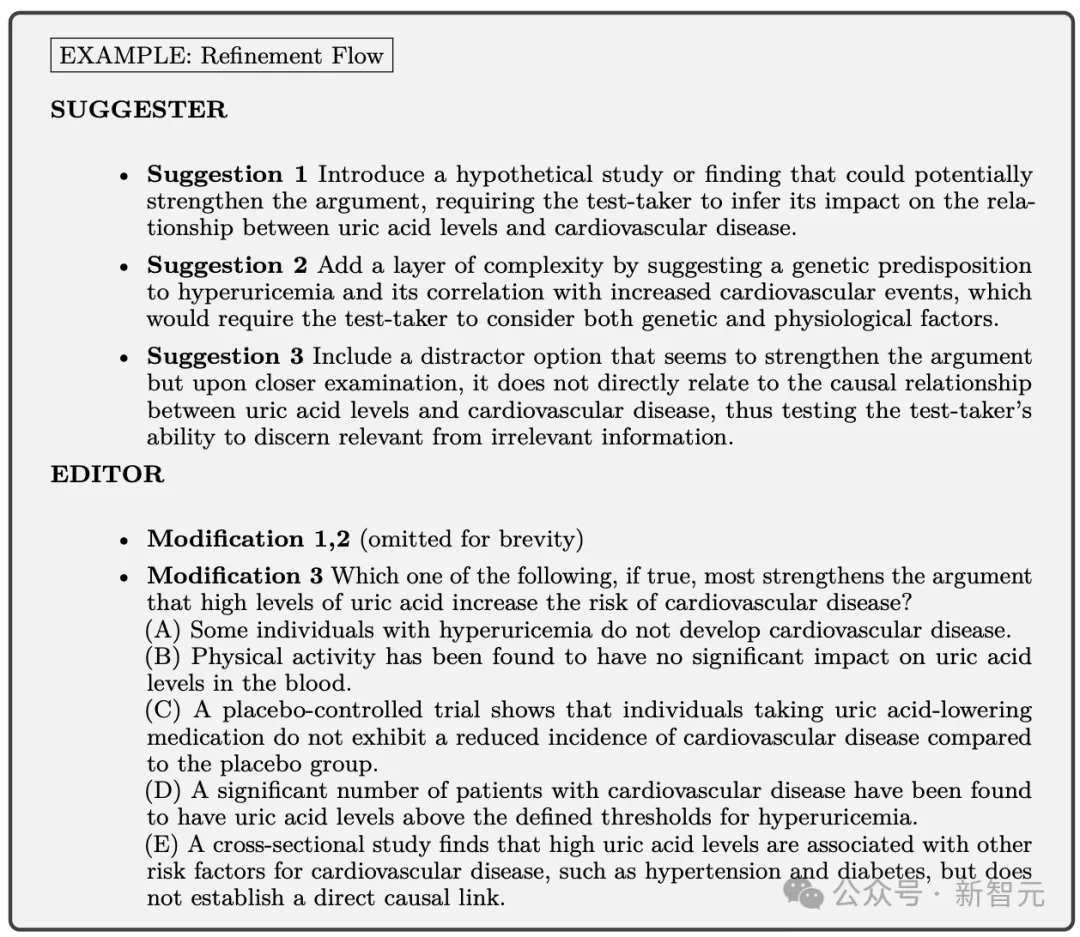

指令改進(jìn)流程:以種子指令流程的指令為輸入,迭代地提升其復(fù)雜性和質(zhì)量。

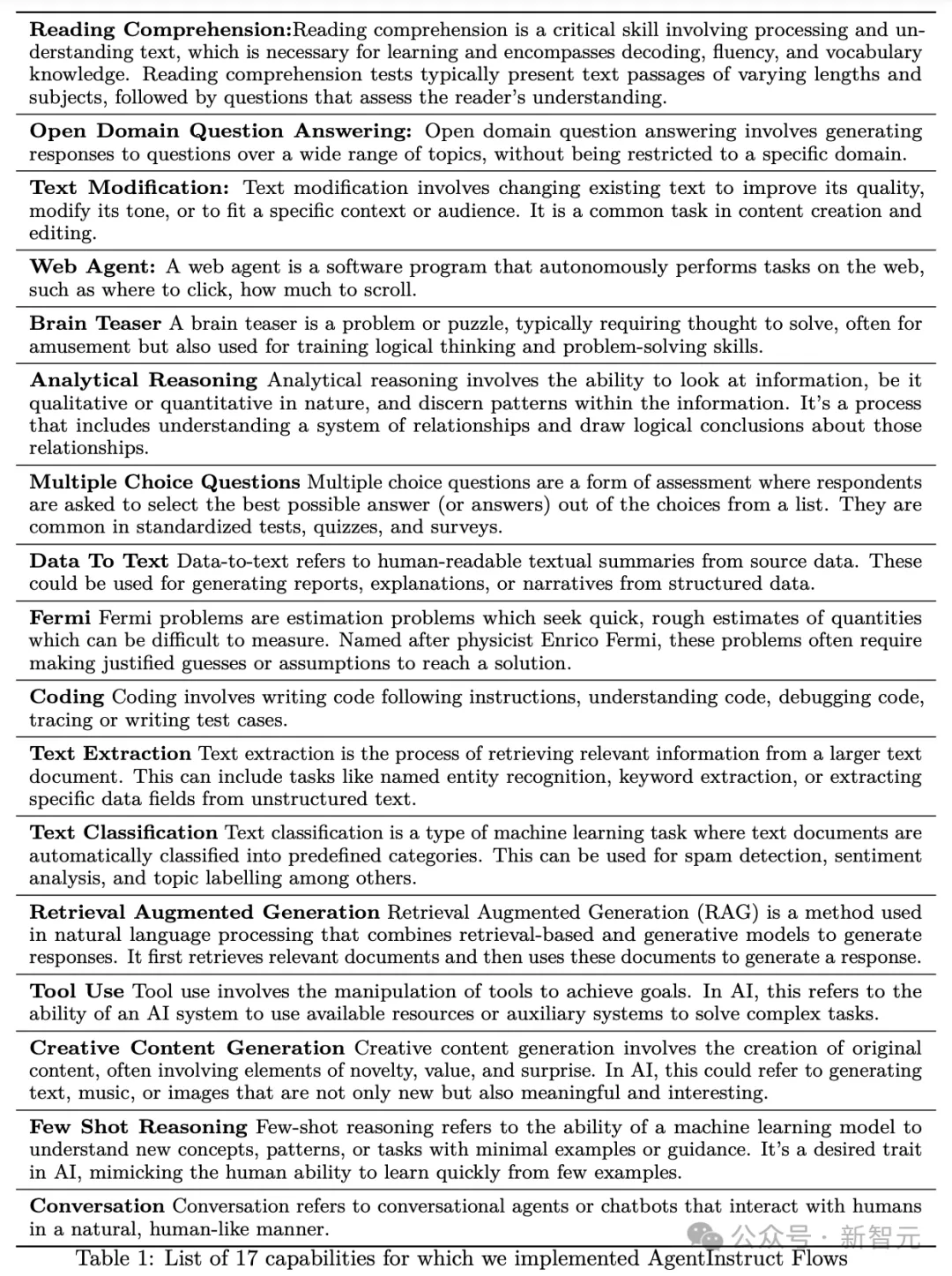

接下來(lái),研究人員為為17種不同的技能實(shí)現(xiàn)了這些流程,每種技能都有多個(gè)子類別。

這些技能包括閱讀理解、問(wèn)答、編碼、檢索增強(qiáng)生成、創(chuàng)意寫作、工具/API使用和網(wǎng)絡(luò)控制。

完整列表,如下表1中所示。

接下來(lái),研究人員通過(guò)以下三種技能的案例研究,來(lái)解釋這些工作流是如何運(yùn)作的。

實(shí)驗(yàn)結(jié)果

正如開頭所述,研究人員使用2580萬(wàn)對(duì)指令,微調(diào)Mistral-7b-v0.1模型,然后得到Orca-3。

那么經(jīng)過(guò)使用AgentInstruct數(shù)據(jù)訓(xùn)練Orca-3,性能究竟如何?

AgentInstruct的目標(biāo)是合成一個(gè)大型且多樣化的數(shù)據(jù)集,其中包含不同難度級(jí)別的數(shù)據(jù)。

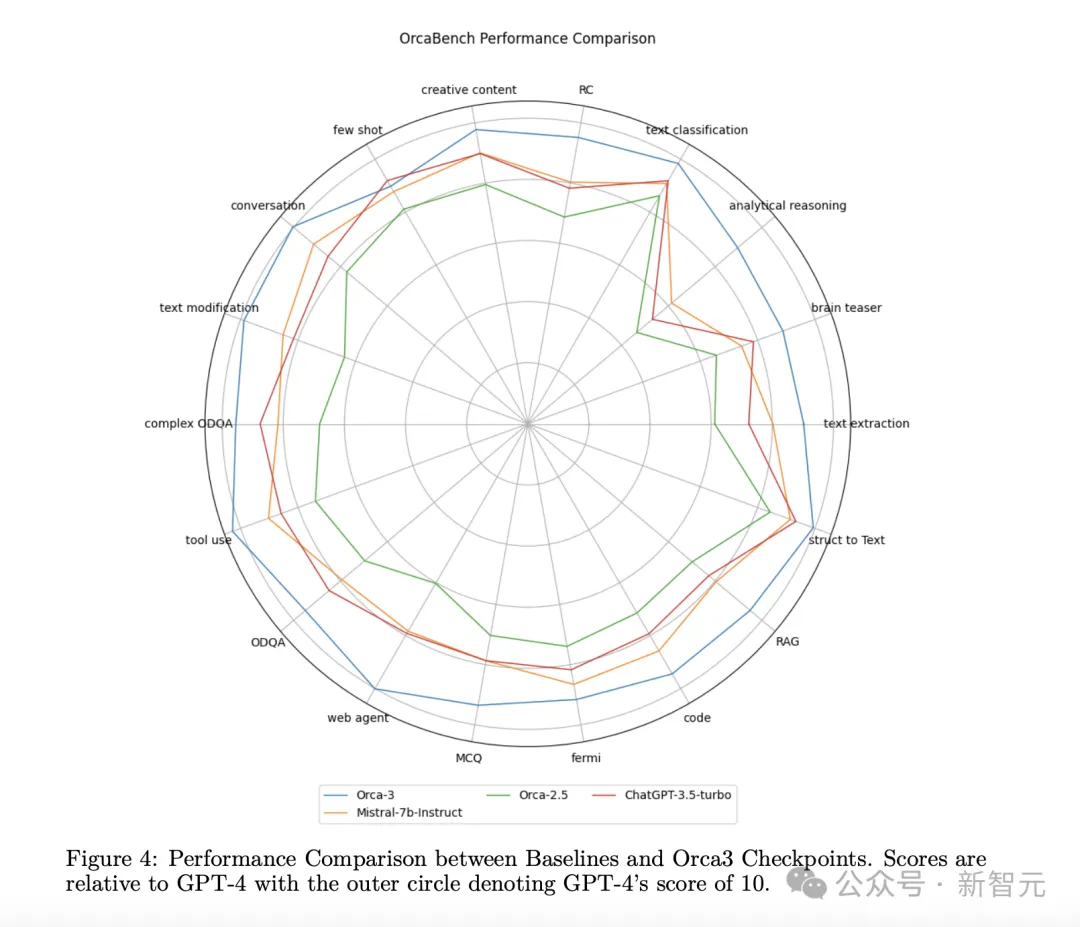

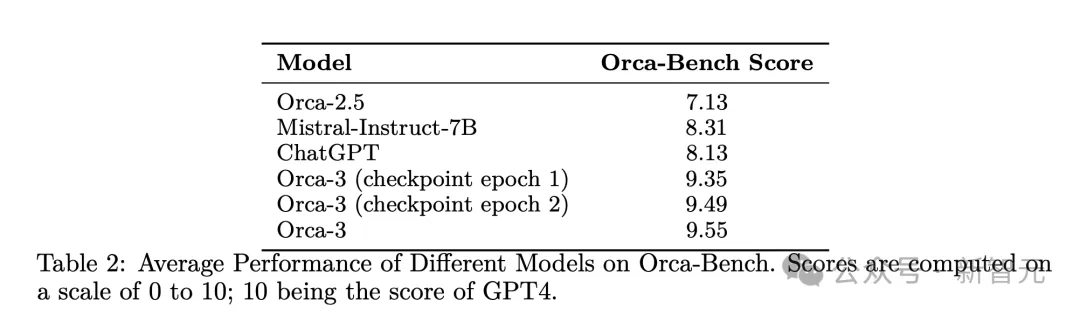

在這個(gè)數(shù)據(jù)集上,像Orca-2.5、Mistral-Instruct-7b和ChatGPT這樣的基準(zhǔn)模型得分遠(yuǎn)低于10分,顯示出它們相對(duì)于GPT-4(被指定為基準(zhǔn),得分為10)的劣勢(shì)。

圖4中描繪的性能比較展示了基準(zhǔn)模型與Orca-3之間的對(duì)比分析。

這個(gè)圖顯示了在AgentInstruct數(shù)據(jù)的支持下,后訓(xùn)練過(guò)程中各種能力的顯著提升。

表2概括了所有評(píng)估維度的平均得分。

平均而言,包括每輪訓(xùn)練輪后的Orca-3,AgentInstruct數(shù)據(jù)的引入使性能相比Orca 2.5基準(zhǔn)提高了33.94%,相比Mistral-Instruct-7B提高了14.92%。

刷新多項(xiàng)基準(zhǔn)SOTA

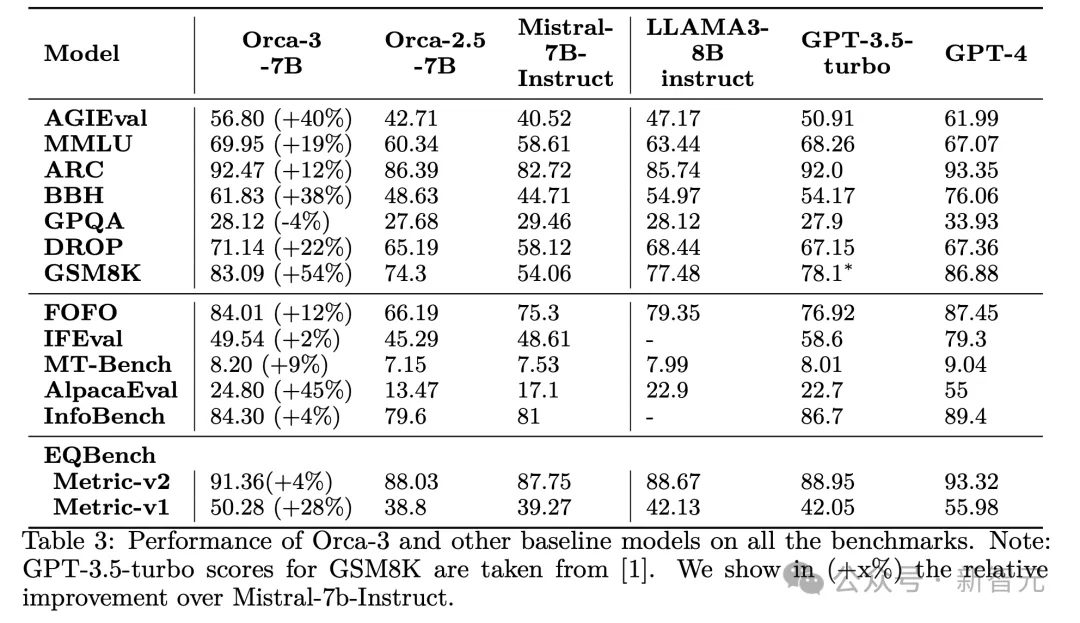

表3中給出了每個(gè)基準(zhǔn)的所有基線的結(jié)果。

比如,在AGIEval提升40%,在MMLU上提升19%,在GSM8K上提升54%,在BBH上提升38%,在AlpacaEval上提升45%。

此外,它在性能上持續(xù)超過(guò)其他模型,如LLAMA-8B-instruct和GPT-3.5-turbo。

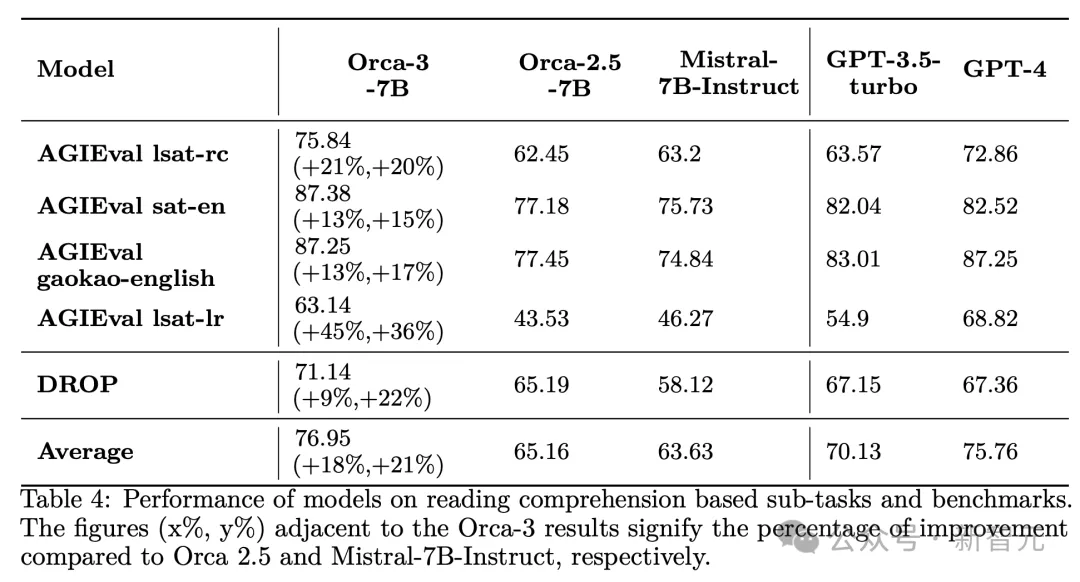

就閱讀理解任務(wù)來(lái)說(shuō),對(duì)于LLM至關(guān)重要。對(duì)于小模型來(lái)說(shuō),也更為重要。

通過(guò)使用AgentInstruct進(jìn)行針對(duì)性訓(xùn)練,可以觀察到Mistral的閱讀理解能力有了實(shí)質(zhì)性的提升(見表4)——相比Orca 2.5提高了18%,相對(duì)于Mistral-Instruct-7b提高了21%。

此外,通過(guò)利用這種數(shù)據(jù)驅(qū)動(dòng)的方法,研究人員將一個(gè)7B參數(shù)的模型在LSATs的閱讀理解部分的表現(xiàn),提升到了與GPT-4相匹配的水平。

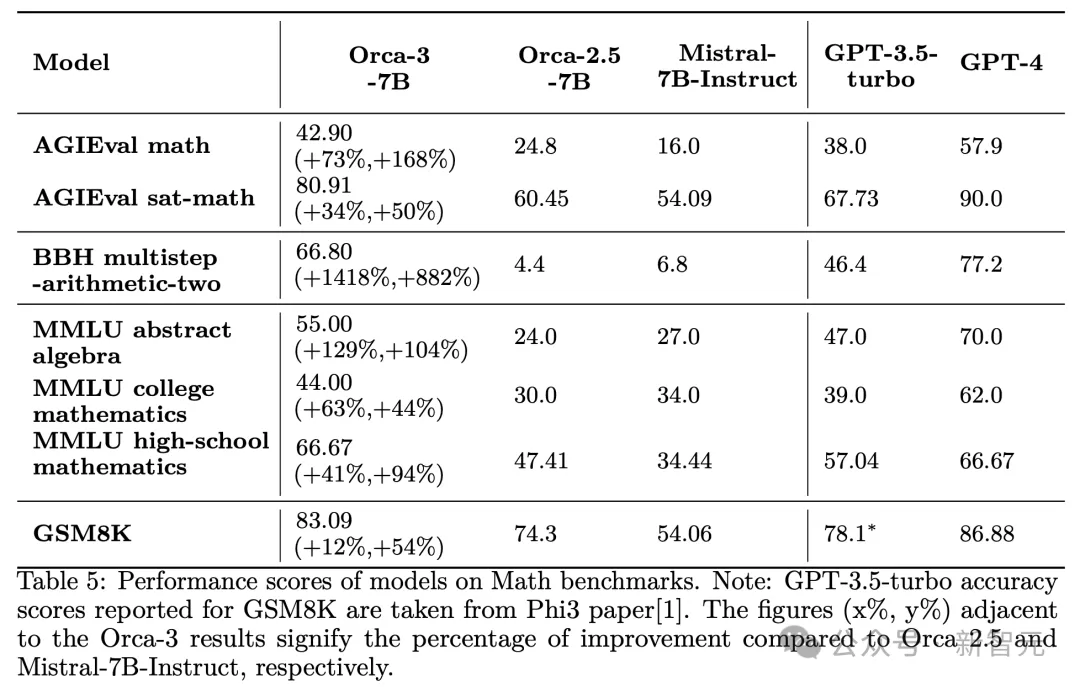

再拿數(shù)學(xué)來(lái)說(shuō),通過(guò)AgentInstruct,成功提升了Mistral在從小學(xué)到大學(xué)水平的各種難度數(shù)學(xué)問(wèn)題上的熟練程度,如下表5所示。

在各種流行的數(shù)學(xué)基準(zhǔn)測(cè)試上,改進(jìn)幅度從44%-168%不等。

應(yīng)當(dāng)強(qiáng)調(diào)的是,生成式教學(xué)的目標(biāo)是教授一種技能,而不是生成數(shù)據(jù)來(lái)滿足特定的基準(zhǔn)測(cè)試。AgentInstruct在生成式教學(xué)方面的有效性通過(guò)在各種數(shù)學(xué)數(shù)據(jù)集上的顯著改進(jìn)得到了證明。

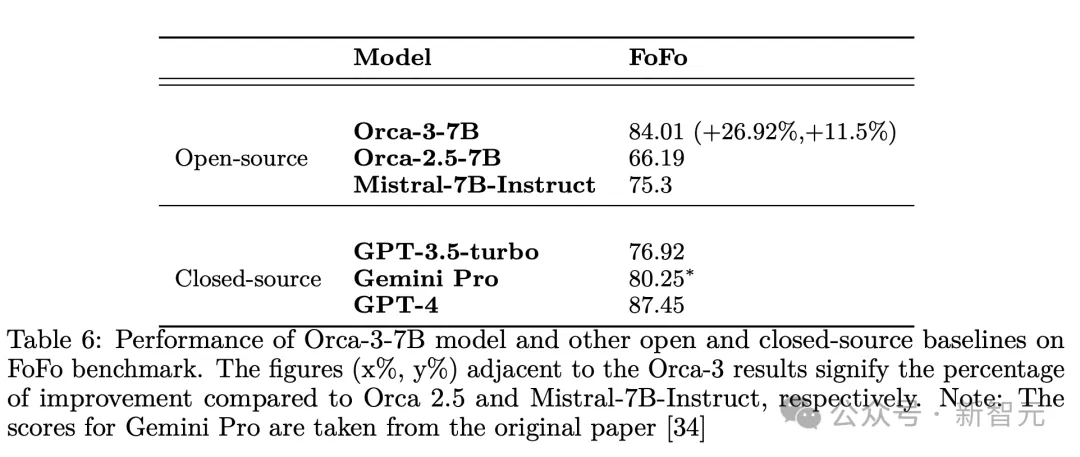

表6顯示了,Orca-3-7B模型和FoFo基準(zhǔn)上,其他開源和閉源基準(zhǔn)的性能。

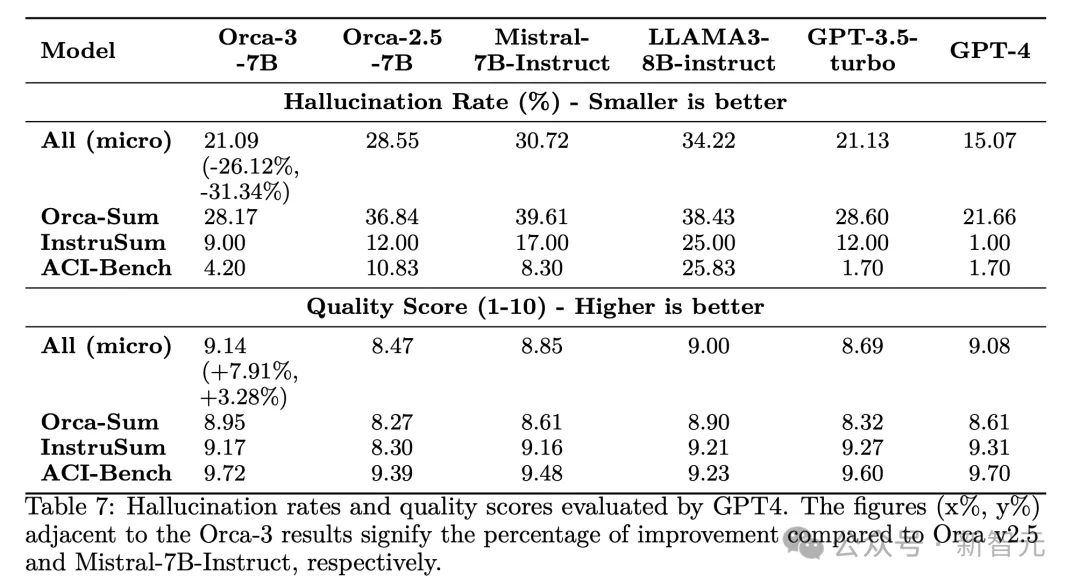

另外,通過(guò) AgentInstruct 方法,成功地將模型幻覺(jué)減少31.34%,同時(shí)達(dá)到了與GPT-4(教師)相當(dāng)?shù)馁|(zhì)量水平。

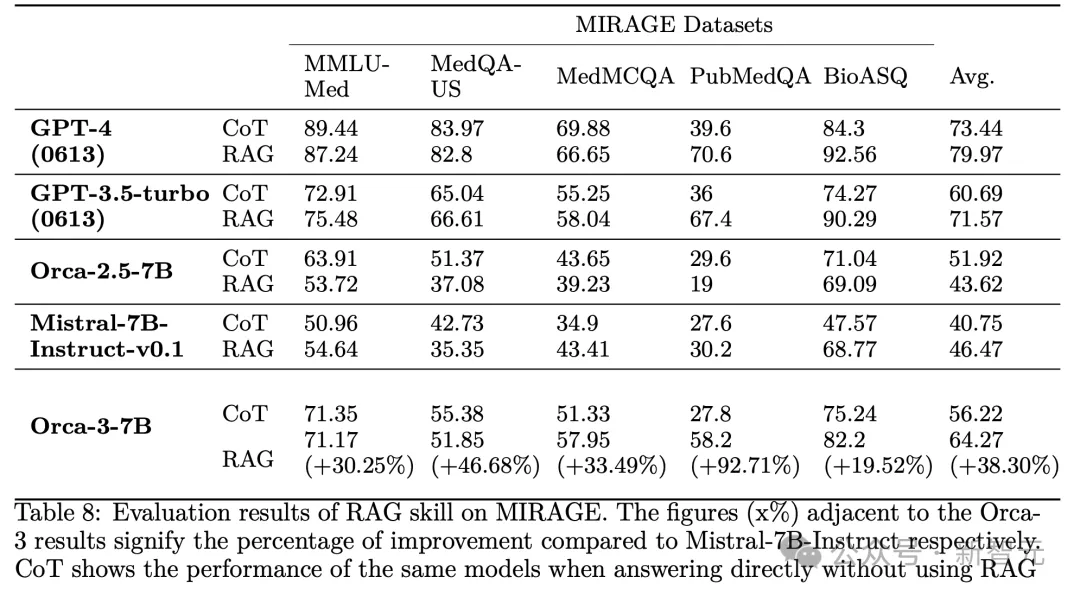

表8顯示了使用/不使用RAG的MIRAGE上所有模型的結(jié)果。

總之,AgentInstruct生成教學(xué)方法,為模型后訓(xùn)練生成大量多樣化和高質(zhì)量數(shù)據(jù)的挑戰(zhàn),提供了一個(gè)有前途的解決方案。