Transformer技術的過去、現在與未來

2017年春季,八位谷歌研究人員發表了里程碑式論文《Attention is All You Need》,臨近論文發表七周年,這篇論文及其介紹的Transformers架構已經成為AI領域的傳奇。Transformers改變了從神經網絡技術到生成類似外星智能輸出的數字系統的轉變,成為了ChatGPT、Dall-E和Midjourney等AI產品的核心。

在人工智能的發展史上,Transformer技術無疑是一次革命性的突破。它不僅改變了機器學習模型處理數據的方式,更為自然語言處理(NLP)領域帶來了前所未有的進步。Transformer的核心創新——自注意力(Self-Attention)機制,使得模型能夠在處理序列數據時更加高效和準確,這一點在文本翻譯、語音識別以及文本生成等多個領域已被廣泛證實。

Transformer技術的出現,標志著從規則和統計方法向深度學習模型轉變的重要里程碑。它的設計哲學和架構已經成為了后續眾多創新模型的基石,包括著名的GPT和BERT模型。這些基于Transformer的模型不僅在學術界引起了轟動,更在商業應用中展現了巨大的潛力和價值。

Transformer模型是如何從一個有前途的想法發展成為AI領域的一個重要工具,以及團隊成員如何通過合作和創新克服挑戰,最終取得成功。它也突顯了科技發展中的一個常見現象:創新往往需要時間才能被廣泛接受和應用。Transformer模型的成功證明了持續探索和實驗的重要性,以及團隊合作在解決復雜問題中的價值。

起源與發展

Transformer技術的誕生背景可以追溯到2011年,當時蘋果公司推出了Siri——一種革命性的語音助手,它能夠理解和回應用戶的自然語言指令。這一創新引起了谷歌的關注,因為他們擔心Siri可能會威脅到他們在搜索領域的主導地位。為了應對這一挑戰,谷歌開始探索新的方法來改進其搜索技術,特別是在自然語言理解方面。

在這一背景下Transformer架構應運而生。它是由谷歌的研究團隊開發的,旨在處理序列數據,如文本或語音,比傳統的循環神經網絡(RNN)和長短期記憶網絡(LSTM)更有效。Transformer的核心創新是自注意力機制,它允許模型在處理序列數據時,更好地理解數據中的每個元素與其他元素之間的關系。

Transformer團隊由一群多元化的研究人員組成,他們來自不同的國家和背景,共同致力于開發這項突破性技術。團隊成員包括Illia Polosukhin、Ashish Vaswani、Noam Shazeer、Llion Jones等,他們各自在自然語言處理和機器學習領域有著深厚的研究基礎。通過跨學科合作,這個團隊成功地將自注意力機制應用到了神經網絡模型中,從而創造了Transformer。

NOAM SHAZEER,Character AI 公司聯合創始人兼 CEO

NOAM SHAZEER,Character AI 公司聯合創始人兼 CEO

Llion Jones,SAKANA AI 公司聯合創始人

Llion Jones,SAKANA AI 公司聯合創始人

團隊開始構建一個自注意力模型,用于語言翻譯,并使用BLEU基準來衡量其性能。盡管模型最初并不比現有的長短期記憶模型更好,但Noam Shazeer的加入帶來了轉機。他的貢獻推動了模型的發展,使其性能大幅提升。

在緊張的截止日期前,團隊進行了密集的工作和測試,最終提交了論文。他們的工作在谷歌內部并未立即受到重視,但在學術界引起了轟動。盡管Shazeer曾建議谷歌放棄搜索索引并完全采用Transformer模型,這個想法當時被認為是荒謬的,但現在看來,這只是時間問題。

Transformer論文《Attention is All You Need》于2017年發布,迅速在學術界引起了廣泛關注。這篇論文不僅詳細描述了Transformer架構的工作原理,還展示了它在機器翻譯等任務中的優越性能。論文的發布標志著自然語言處理領域的一個重要轉折點,因為它提供了一種全新的方法來處理語言數據,這種方法不僅更加高效,而且在許多任務中都取得了最先進的結果。

Transformer技術的發展和應用,推動了整個人工智能領域的進步。它不僅在學術研究中產生了深遠影響,還促進了包括谷歌、OpenAI在內的多家公司在自然語言處理和相關領域的商業應用。Transformer架構及其衍生模型如GPT和BERT,已經成為當今最強大的AI模型之一,它們在文本生成、語言理解、機器翻譯等多個方面都展現了卓越的能力。

技術突破與應用

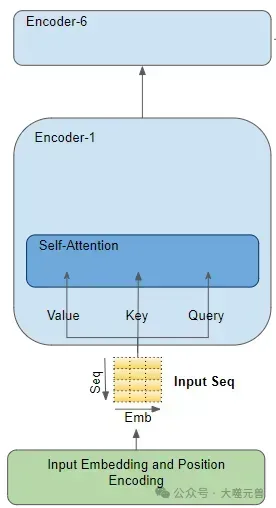

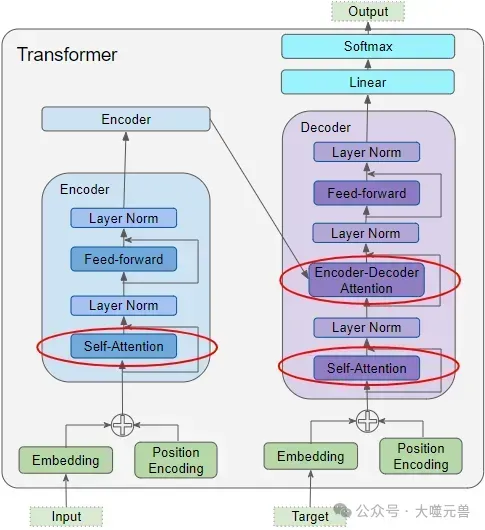

Transformer技術的核心在于其獨特的自注意力機制,這一機制使得模型能夠在處理序列數據時,更加高效地捕捉到各個元素之間的關系。不同于傳統的循環神經網絡(RNN)和長短期記憶網絡(LSTM),Transformer不需要按順序逐步處理數據,而是可以并行處理,大幅提高了計算效率。自注意力機制通過計算序列中每個元素對其他元素的“注意力”,能夠讓模型更好地理解文本的上下文,這對于理解長距離依賴關系尤為重要。

圖片

圖片

注意力模塊(Attention module)存在于每個 Encoder 及 Decoder 中,放大編碼器的注意力。

Transformer 中共有三處使用到了注意力機制:

1. Encoder 中的自注意力機制:源序列與自身的注意力計算;

2. Decoder 中的自注意力機制:目標序列與自身的注意力計算;

3. Encoder-Decoder 中的注意力機制:目標序列對原序列的注意力計算。

圖片

圖片

在機器翻譯領域,Transformer模型已經成為新的標準。它能夠更準確地捕捉語言之間的細微差別,提供更流暢、更自然的翻譯結果。例如,谷歌翻譯在引入基于Transformer的模型后,其翻譯質量得到了顯著提升。自然語言處理(NLP)領域也受益匪淺,Transformer被用于文本分類、情感分析、問答系統等多種應用,每次都能推動模型性能的新突破。

OpenAI等公司通過采用和改進Transformer技術,開發出了如GPT系列等強大的語言模型。這些模型不僅在學術界取得了巨大成功,而且在商業應用中展現出了巨大潛力。例如,GPT-3模型憑借其強大的生成能力,被廣泛應用于內容創作、編程輔助、自動化客服等領域,極大地拓寬了AI的應用范圍。

Transformer技術的出現,不僅是NLP領域的一次技術革命,更是推動了整個AI行業向前發展的關鍵力量。隨著技術的不斷進步和應用的不斷拓展,我們有理由相信,Transformer及其衍生技術將繼續在未來的AI領域中發揮重要作用,帶來更多創新和變革。

谷歌的挑戰與錯失

作為谷歌的研究團隊的Transformer技術先驅,他們在2017年發表的論文《Attention is All You Need》中首次介紹了這一架構時,谷歌認識到了自注意力機制在處理大規模數據時的潛力,并開始將其集成到自己的產品和服務中,如谷歌翻譯。然而,盡管谷歌在技術開發上取得了初步的成功,但在將其商業化和規模化方面卻遇到了挑戰。

谷歌未能在大模型競爭中保持領先地位的原因,我們可以從幾個方面來看。首先,谷歌在內部推動創新的過程中存在瓶頸,高層的決策并不總是支持大膽的技術革新。例如,盡管有團隊成員建議使用Transformer架構來重構谷歌的搜索引擎,但這一建議并未得到采納。其次,谷歌在組織結構上較為復雜,這可能導致了決策的遲緩和執行力的不足。此外,谷歌在AI領域的多元化戰略也可能分散了對Transformer技術的專注和投入。谷歌開始轉變,從一個以創新為中心的公司變成了一個以底線為中心的官僚體制。盡管谷歌在2018年開始將Transformer集成到其產品中,如翻譯工具和BERT語言模型,但這些變化與微軟大膽地將基于Transformer的系統整合到其產品線中相比,顯得較為保守。

當Transformer原創團隊成員離開谷歌后,他們各自創業的故事也非常引人注目。這些成員利用在谷歌積累的經驗和知識,創立了各自的公司,如Character.AI、Cohere、Inceptive等,這些公司都在AI領域取得了顯著的成就。他們的成功不僅證明了Transformer技術的潛力,也反映了在更靈活、更具創新精神的環境中,這些技術能夠得到更好的發展。

谷歌在Transformer技術上的挑戰與錯失,反映了一個大型科技公司在面對快速發展的技術革新時可能遇到的困境。這些經歷為整個行業提供了寶貴的經驗教訓,即在AI領域,持續的創新、敏捷的決策和對新技術的大膽投入是保持領先地位的關鍵。同時這也展示了AI領域的巨大潛力和未來的無限可能。

OpenAI的崛起

谷歌在2019年或2020年就有機會推出GPT-3或GPT-3.5級別的模型,但沒有采取行動。相比之下,OpenAI的首席科學家Ilya Sutskever在論文發表當天就意識到了Transformer的潛力,并開始研究。這導致了OpenAI在大模型技術上的領先。在競賽中,OpenAI憑借其GPT系列產品的開發,成為了最重要的力量。這一成就的背后是Transformer技術的強大支撐。OpenAI利用Transformer架構的自注意力機制,開發出了GPT(Generative Pre-trained Transformer)系列產品,這些產品在自然語言理解和生成方面展現出了驚人的能力。從GPT到GPT-3,每一代產品都在性能上有了顯著的提升,尤其是在文本生成、語言翻譯、問答系統等任務中,GPT模型展現出了卓越的性能。

Transformer技術在OpenAI的戰略規劃中占據了核心地位。它不僅是GPT系列產品的基礎,也是OpenAI未來發展的關鍵。Q*項目作為OpenAI的一個神秘項目,雖然細節不為外界所知,但可以推測它將進一步擴展Transformer技術的應用范圍,或許在多模態AI、自動化決策等領域探索新的可能。

Transformer的成功關鍵在于其能夠在數據和算力上進行擴展。谷歌缺乏頂層設計和推動,導致其在大模型競爭中落后。OpenAI則擁有自下而上的靈活性和自上而下的專注,使其能夠在這方面走得更遠。在與谷歌的競爭中,OpenAI展現出了不同的戰略思路。谷歌作為一個全球性的科技巨頭,擁有強大的資源和廣泛的業務范圍,但在AI領域的某些方面,OpenAI通過專注和創新,展現出了強大的競爭力。特別是在大模型的研究和應用上,OpenAI的GPT系列產品已經成為了行業的標桿。

OpenAI的崛起和Transformer技術的成功應用,為AI領域帶來了新的活力和創新的思路。未來,OpenAI與谷歌之間的競爭將可能推動整個行業向更高的目標邁進,無論是在技術進步、產品創新,還是在解決現實世界問題的能力上。

Transformer的未來

Transformer技術已經證明了其革命性的影響力,未來的發展方向預計將更加多元和深遠。我們可以預見,Transformer技術將進一步優化,以更高效地處理更復雜的數據類型,如視頻和音頻,實現真正的多模態學習。此外,隨著硬件技術的進步,Transformer模型將能夠在更大規模上訓練,提供更精準的預測和分析。

Transformer技術的未來發展方向是多元化的,涉及自然語言處理、計算機視覺、音頻處理等多個人工智能領域。

架構改進:未來的Transformer可能會包含更高效的注意力機制,如稀疏注意力和線性化注意力,以提高處理長序列的效率并降低計算復雜度。

模型泛化:為了在小規模數據上進行有效訓練,可能會引入結構偏差或正則化,或對大規模未標記數據進行預訓練。

模型適配:Transformer將繼續適應特定的下游任務和應用程序,可能會有更多針對性的變體出現。

跨領域應用:除了在語言相關的應用之外,Transformer也將被更廣泛地應用于計算機視覺、音頻處理甚至其他學科。

技術融合:可能會看到Transformer與其他AI技術如卷積神經網絡(CNN)的融合,以利用各自的優勢解決更復雜的問題。

社會影響:隨著技術的發展,Transformer可能會在教育、醫療、工作等多個領域帶來深遠的社會變革。

大模型和Transformer技術可能會帶來深刻的社會變革。在教育領域,個性化學習將成為可能,學生可以通過與AI助教互動獲得定制化的教學內容。在醫療領域,Transformer技術有望提高疾病診斷的準確性和速度,甚至在藥物研發中發揮關鍵作用。在工作場所,自動化和AI輔助決策將提高效率,但也可能引發對職業安全和技能要求的重新評估。

這些趨勢反映了Transformer技術的不斷進步和其在AI領域中的重要性。隨著研究的深入,我們可以期待Transformer技術將繼續推動人工智能的邊界,并在未來的技術革命中扮演關鍵角色。

結語

Transformer技術的出現,標志著人工智能領域的一個新紀元。它不僅推動了自然語言處理技術的飛躍發展,更為機器學習模型的設計和應用開辟了新的道路。Transformer的成功,證明了開放創新文化的重要性——一個鼓勵跨界合作、快速迭代和大膽實驗的環境,是科技進步的肥沃土壤。展望未來,Transformer技術將繼續引領AI領域的探索與創新,激發無限可能。

Transformer的誕生與發展是一個充滿創新和變革的故事,它不僅僅是技術進步的見證,更是人類智慧探索的縮影。隨著人工智能技術的不斷發展,Transformer及其衍生技術將繼續在未來的AI領域扮演重要角色,引領新一輪的技術革命。

我們應強調持續創新的重要性。AI技術的進步不僅僅是技術層面的突破,更是推動社會進步的關鍵力量。我們對未來技術進步的樂觀態度,基于對人類智慧和創造力的信心。盡管面臨挑戰,但我們有理由相信,通過不斷的探索和創新,AI技術將使我們的世界變得更加美好。

參考資料:

1. https://www.wired.com/story/eight-google-employees-invented-modern-ai-transformers-paper/