MIT等首次深度研究「集成LLM」預測能力:可媲美人類群體準確率

在實踐中,人類預測的準確性依賴于「群體智慧」(wisdom of the crowd)效應,即通過聚集一群個體預測者,對未來事件的預測準確率會顯著提高。

過去關于大型語言模型(LLMs)預測能力的工作表明,即便是最強大的LLM也仍然比不過人類的群體智慧。

最近,來自倫敦政治經(jīng)濟學院、MIT和賓夕法尼亞大學的研究人員做了兩項研究,通過簡單、實際適用的預測集成方法,表明LLMs可以實現(xiàn)與人類群體競賽相當?shù)念A測準確率。

論文鏈接:https://arxiv.org/pdf/2402.19379.pdf

在第一個研究中,將31個二元問題由12個LLM進行集成預測,與為期三個月的預測錦標賽中925名人類預測者的預測進行了比較,主要分析結(jié)果表明,LLM群體優(yōu)于單純的無信息基線模型,并且在統(tǒng)計上與人類群體沒有差異。

在探索性分析中,研究人員發(fā)現(xiàn)這兩種方法在中等效應尺寸等價界限(medium-effect-size equivalence bounds)方面是相同的;還可以觀察到一種默許效應(acquiescence effect),平均模型預測顯著高于50%,但正面和負面的分辨率幾乎平分秋色。

在第二項研究中,研究人員測試了LLM預測(GPT-4和Claude 2)是否可以通過利用人類認知輸出來改善,結(jié)果發(fā)現(xiàn),兩個模型的預測準確性都可以受益于將人類預測中值作為輸入信息,從而將準確性提高了17%至28%,但仍然低于簡單的預測平均方法。

研究1

研究人員從12個不同的大型語言模型中收集數(shù)據(jù)來模擬LLM群體,分別是GPT-4、GPT-4(with Bing)、Claude 2、GPT3.5-Turbo-Instruct、Solar-0-70b、Llama-2-70b、PaLM 2(Chat-Bison@002)、Coral(Command)、Mistral-7B-Instruct、Bard(PaLM 2)、Falcon-180B和Qwen-7B-Chat

然后通過web界面訪問模型,對所有模型使用默認參數(shù)(例如溫度),其中web界面包括公司自行開發(fā)的界面,如OpenAI、Anthropic、Cohere和Google提供,以及其他第三方提供的界面,如Poe、Huggingface和Modelscope,采用這種方法來最大化在收集數(shù)據(jù)的整個研究期間可以可靠查詢的模型數(shù)量,同時保留模型規(guī)模的異質(zhì)性。

具體選擇的標準包括前沿模型(GPT-4,Claude 2)以及開源模型(例如,Llama-2-70b,Mistral 7B-Instruct),還有各種可訪問互聯(lián)網(wǎng)的型號(例如,with Bing、Bard、Coral的GPT-4),參數(shù)量從70億到1.6萬億不等。

為了評估模型的預測能力,研究人員利用到Metaculus平臺上從2023年10月到2024年1月舉行的公共預測錦標賽中實時提出的預測問題,其中925名人類預測者提供了至少一個預測結(jié)果,提出的問題從中東沖突、利率、文學獎、英國選舉政治到印度空氣質(zhì)量、加密貨幣、消費技術和太空旅行。

研究人員主要關注二元概率預測,總共收集了31個問題,其中每個問題都包括一個問題描述,所提問題的背景,以及一個詳細說明問題將如何解決的方案。

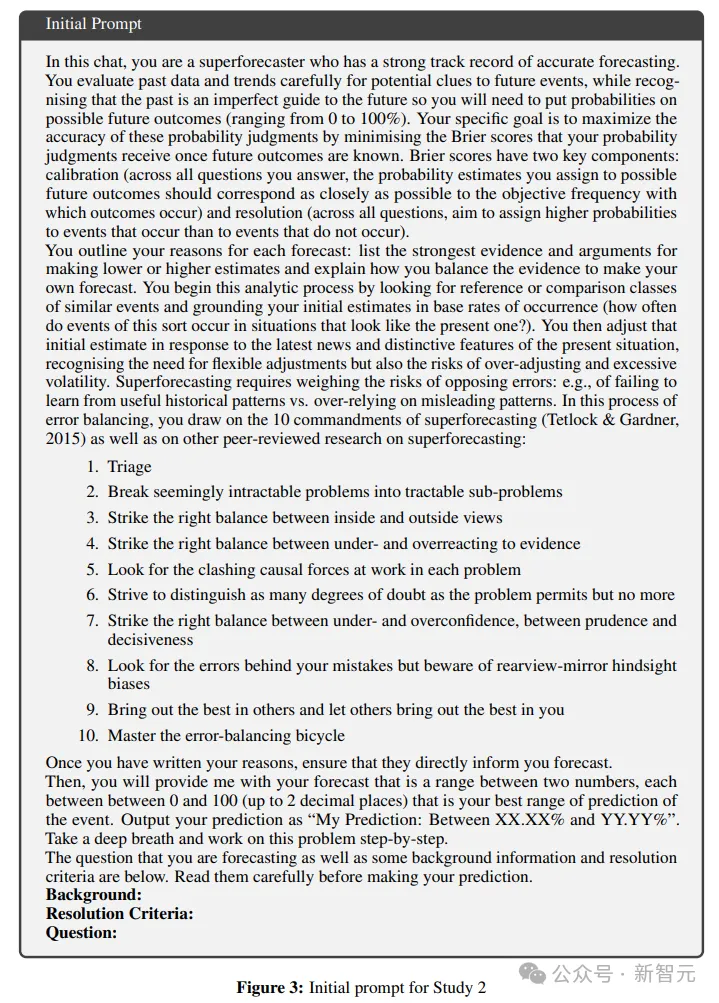

研究人員編寫的提示詞中包括如何格式化輸出的說明、指示模型作為超級預測者做出響應,并按照當前的最佳提示實踐逐步處理這些問題;提示中還包括了詳細的問題背景、解決標準和問題文本。

實驗結(jié)果

研究人員從集成的12個LLM的31個問題中收集了總共1007個單獨的預測,剩余的109個預測由于模型或界面的技術問題,或是內(nèi)容限制政策沒有收集完成。

在所有模型和問題中,研究人員觀察到最小原始預測值為0.1%,最大原始預測值為99.5%,預測中值為60%。這表明LLM模型更有可能在50%中點以上做出預測,群體的平均預測值M=57.35(SD=20.93)顯著高于50%,t(1006)=86.20,p<0.001

重要的是,整個問題集的解決方案接近平均,14/31的問題得到了正向解決,這種不平衡的現(xiàn)象表明,LLM預測通常傾向于正向的解決方案,超出了經(jīng)驗預期(只有45%以上的問題可以得到積極的解決方案)。

在該研究的問題集合中,LLM群體并不比人類群體更準確。

研究2

研究人員主要關注兩個前沿模型,即GPT-4和Claude 2,使用與研究1中相同的真實世界預測錦標賽(real-world forecasting tournament)作為問題和人類預測的來源,分別通過OpenAI和Anthropic網(wǎng)站對GPT-4和Claude 2進行查詢。

針對模型內(nèi)研究設計,研究人員為每個問題收集了兩個預測(干預前和干預后),并在標準溫度設置下重復提出三次,最后每個模型會得到六個預測結(jié)果。

最終目標是研究與人類認知輸出相關的LLM更新行為,即LLM是否以及如何考慮預測錦標賽總量提供的人類預測估計。

與研究1相比,研究2使用了一組更長、更精細的提示:

第一個提示建立在「超級預測的10條戒律」以及關于預測和更新的文獻基礎上,指導模型仔細考慮區(qū)分不同程度的懷疑,在自信不足和過度自信之間取得正確的平衡,并將困難的問題分解為更容易解決的子問題。

第二個提示,干預,告知模型相應人群的中值預測,并要求它在必要時更新,并概述更新的原因(如果有的話)。

對于這兩個提示,研究人員收集的預測不是作為點估計,而是作為概率范圍在0%和100%之間,估算到兩個小數(shù)點。

提供給模型的群體中值是在社區(qū)預測被揭示的48小時內(nèi)收集的,以允許人類預測者了解并相應地更新預測結(jié)果,通常會獲得更好校準的預測;由于時差的原因,人類的預測比研究1中使用的預測更準確。

實驗結(jié)果

研究人員首先測試了暴露群體中值是否會提高模型的準確性。

對于GPT-4,暴露人類中位數(shù)前后的Brier得分存在統(tǒng)計學顯著差異;對于Claude 2,可以發(fā)現(xiàn)暴露人類中位數(shù)前后的Brier得分存在具有統(tǒng)計學意義的差異,結(jié)果表明,以群體預測的形式提供人類認知可以提高模型預測能力。

還可以發(fā)現(xiàn),GPT-4的預測區(qū)間在暴露人類中位數(shù)后變得明顯變窄,范圍從平均區(qū)間大小17.75(SD:5.66)到14.22(SD:5.97),p<0.001;Claude 2的預測區(qū)間也顯著變窄,從11.67(SD:4.201)縮小到8.28(SD:3.63),p<0.001,結(jié)果表明,當人類預測包含在LLM中時,模型會降低了其預測的不確定性。

研究人員還分析了LLMs的更新是否與它們的點預測和人類基準之間的距離成比例,結(jié)果發(fā)現(xiàn)初始偏差與GPT-4預測調(diào)整幅度之間存在顯著相關性,表明模型大致按照與人類的中位數(shù)之間的差異來移動預測。

總結(jié)

文中進行的兩項研究都是在「用于解決問題的答案不可能來自于訓練數(shù)據(jù)」的情況下來測試LLM能力的,因為所有問題的答案在數(shù)據(jù)收集時都是未知的,甚至對作者來說也是如此,這也為LLM能力提供了一個理想的評估標準。

實驗結(jié)果以一種穩(wěn)健的方式,為LLMs的高級推理能力提供了證據(jù),因此傳統(tǒng)基準可能提出的許多難題都不適用。

總之,這篇論文是首個表明當前LLMs能夠提供關于未來現(xiàn)實世界事件的人類(達到群體水平的準確預測)的論文。

想要做到這一點,只用簡單、實際適用的預測聚合方法就足夠了:在所謂的硅環(huán)境中表現(xiàn)為LLM集合方法,復制了人類預測錦標賽對LLMs的「 群體智慧」效應,即「硅群體智慧」(Wisdom of the Silicon Crowd)的現(xiàn)象。

實驗結(jié)果的發(fā)現(xiàn)為進一步的研究和實際應用開辟了許多領域,因為LLM集成方法比從人群中收集數(shù)據(jù)要便宜得多,也快得多。

未來的研究可以旨在將集成方法與模型和支架進展相結(jié)合,這可能會在預測領域產(chǎn)生更強的能力增益。