斯坦福20億參數端測多模態AI Agent模型大升級,手機汽車機器人都能用

全球首個超小型多模態AI Agent模型Octopus V3,來自斯坦福大學的NEXA AI團隊,讓Agent更加智能、快速、能耗及成本降低。

今年四月份初,NEXA AI推出了備受矚目的Octopus V2,該模型在函數調用性能上超越了GPT-4,減少了95%的推理時所需的文本量,為端側AI應用帶來了新的可能性。其專利性核心技術“functional token”通過創新的函數調用方式顯著減少推理時所需的文本長度。

這種方法使得模型能夠在只有20億參數的情況下實現高效訓練,并在精度和延遲方面超越了GPT-4,適應了各種端設備的部署需求。

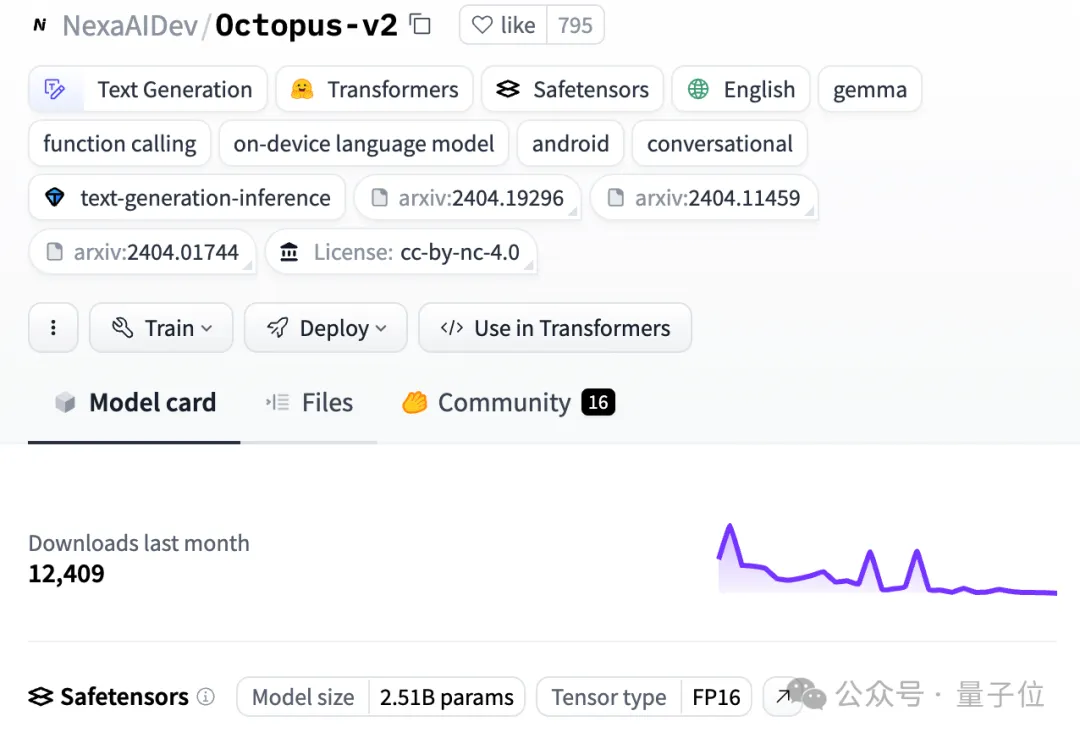

發布以來,Octopus V2在LLM社區獲得了廣泛關注,受到了AI領域大量前沿技術專家及研究者的贊賞,如Hugging Face的CTO Julien Chaumond、知名AI Newsletter Rundown AI的創始人 Rowan Cheung以及Figure AI的創始人Brett Adcock、OPPO邊緣人工智能團隊負責人Manoj Kumar,稱其“開創了端側AI技術新紀元”。

在知名開源AI平臺Hugging Face上,Octopus V2下載量已經超過12000次。

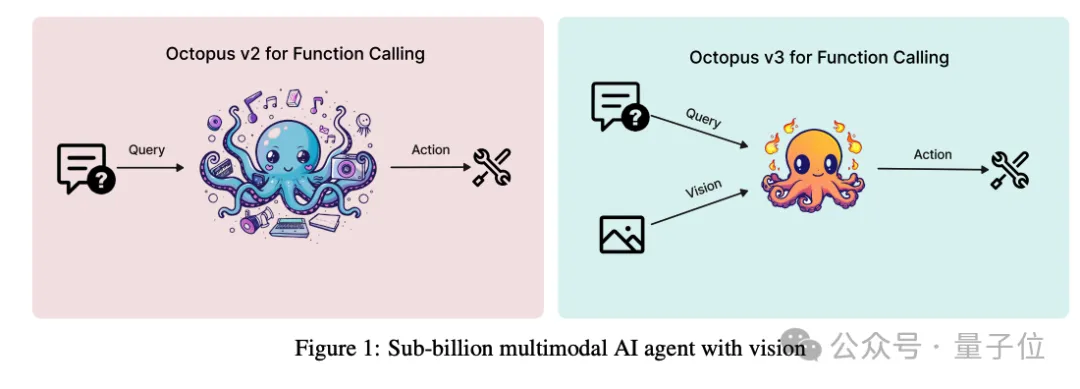

在不到一個月的時間里,NEXA AI團隊發布下一代多模態AI Agent模型Octopus V3,展現進一步突破:具有圖像處理和多語言文本處理能力,為智能手機等端側設備真正走向AI時代鋪平了道路。

首個參數量小于10億的多模態AI Agent模型

Octopus V3不僅擁有多模態能力,在函數調用性能上遠超同類模型,可媲美GPT-4V+GPT4;而且模型參數量不到10億,具有多語言能力。

也就是說,相比傳統的大型語言模型,它體積更小,能耗更低,能夠更加輕松地在各種小型端設備上運行,比如樹莓派,并做到高速且準確的函數調用。

這意味著,未來AI Agent能夠廣泛應用于智能手機、AR/VR、機器人、智能汽車等端側設備,為用戶交互體驗更加流暢、智能。

另一方面,由于V3具有多模態處理能力,可同時處理文本和圖像輸入,再加上多語言能力,也將讓用戶體驗更加豐富。

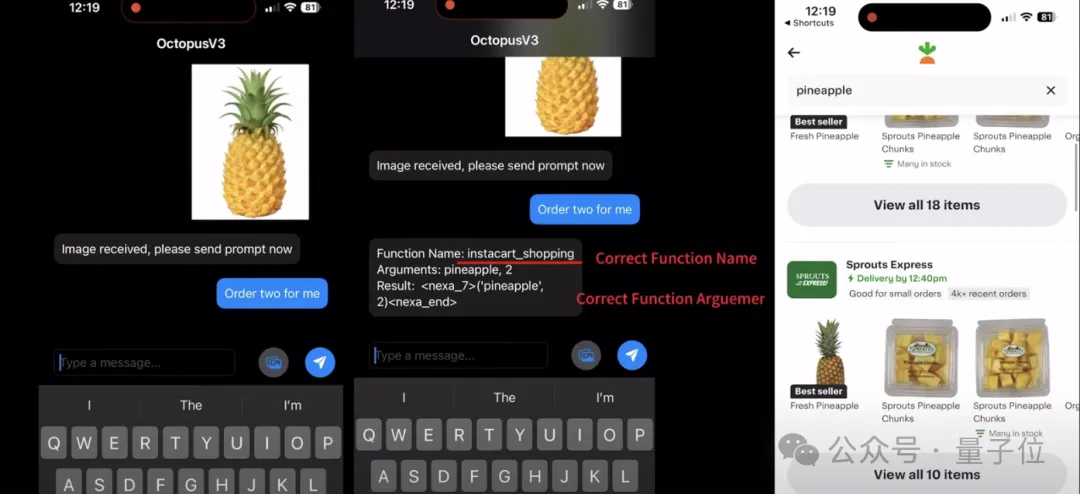

例如,在Instacart購物應用中,用戶可以通過一張菠蘿的圖片及簡單的對話指令,讓AI Agent自動為他們搜索商品,提高了效率和用戶的體驗。

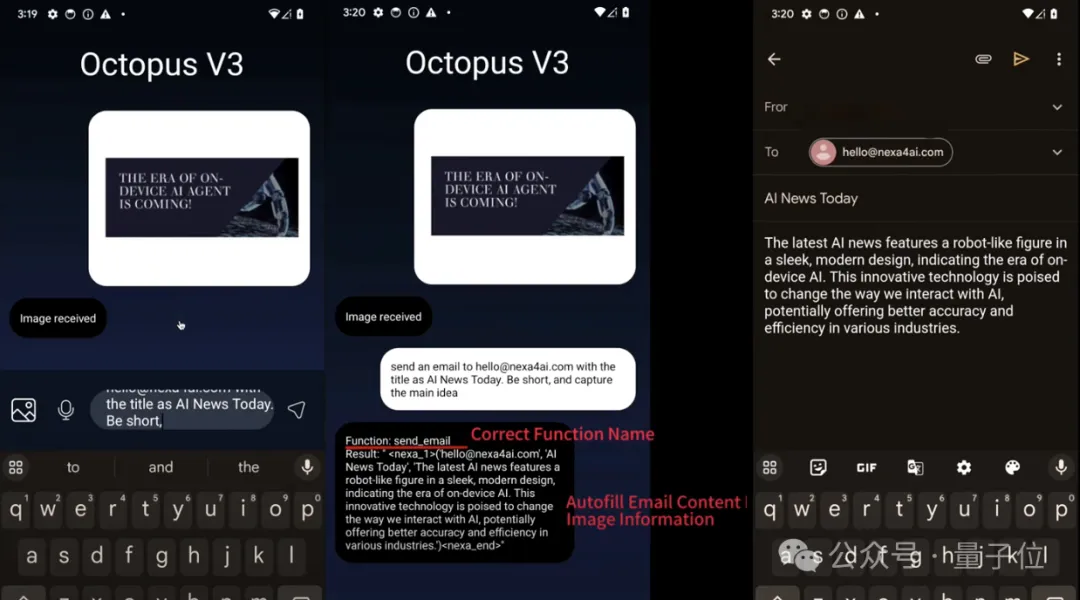

再比如,在發送郵件等場景中,Octopus V3可以根據一張具有文字的圖像,自動提取信息并填寫郵件內容,為用戶提供更加智能、便捷的服務。

從軟件交互到智能汽車,端側AI潛力巨大

基于這些特性,Octopus V2及V3的應用場景豐富多樣,具有廣泛的應用前景。

除上文提到的手機場景,當Octopus V2應用在智能汽車上時,也能帶來新的交互體驗。目前的語音助手往往難以幫助車主完成較為復雜的任務,如在駕駛途中臨時改變目的地、加入額外停靠點等。應用Octopus V3后,AI助手能夠基于較為模糊簡單的指令快速、精準地完成相應任務。

結合V2、V3的能力,從信息檢索、到基于指令完成設計,用戶可以在虛擬場景下獲得流暢的AI體驗:在一個社區用戶的VR場景demo中,輸入簡單的語音指令后,AI Agent能夠幫助用戶快速完成一個客廳設計,在彈指間替換沙發、改變顏色燈光等。在用戶輸入旅行指令后,用戶快速來到了日本,而AI Agent同樣可以在簡單的對話式交流中幫助用戶搜索相應景點,提供豐富的信息。

數據顯示,全球大型語言模型市場規模正在快速增長。Granview Research報告顯示,全球大型語言模型市場規模估計為43.5億美元,并預計從2024年到2030年的復合年增長率為35.9%。同樣,邊緣人工智能市場也呈現出蓬勃發展的勢頭——預計從2023年到2030年,全球邊緣人工智能市場的復合年增長率為21.0%,到2030年將達到664.78億美元。

NEXA AI團隊由斯坦福大學的杰出研究人員創立。

創始人兼首席科學家Alex Chen(陳偉)正在攻讀斯坦福大學的博士學位,擁有豐富的人工智能研究經驗,并且曾擔任斯坦福華人創業協會(Stanford Chinese Entrepreneurs Organization)的主席。

聯合創始人兼首席技術官Zack Li(李志遠)也是斯坦福大學的畢業生,并在Google和Amazon Lab126實驗室擁有4年端側AI的一線研發經驗,同樣曾經擔任斯坦福華人創業協會的主席。

斯坦福大學副教授、斯坦福技術創業項目副主任Charles (Chuck) Eesley擔任顧問,為團隊提供指導和支持。

△左:李志遠;右:陳偉

△左:李志遠;右:陳偉

目前,NEXA AI的獨創性技術已申請專利保護。

NEXA AI的創始團隊表示,他們將繼續致力于推動端側AI技術的發展,通過開源模型提升其創新技術的影響力,為用戶創造更智能、高效的未來生活。

論文地址:https://arxiv.org/abs/2404.11459