斯坦福70億參數(shù)開源模型媲美GPT-3.5,100美元即可復現(xiàn)

隨著大規(guī)模語言模型的日漸強大,人們對 AI 模型提出了倫理道德方面的更高要求。業(yè)界在模型規(guī)模擴展方面具有算力資源優(yōu)勢,但要想讓模型更規(guī)范、可靠,需要學術(shù)界的努力。

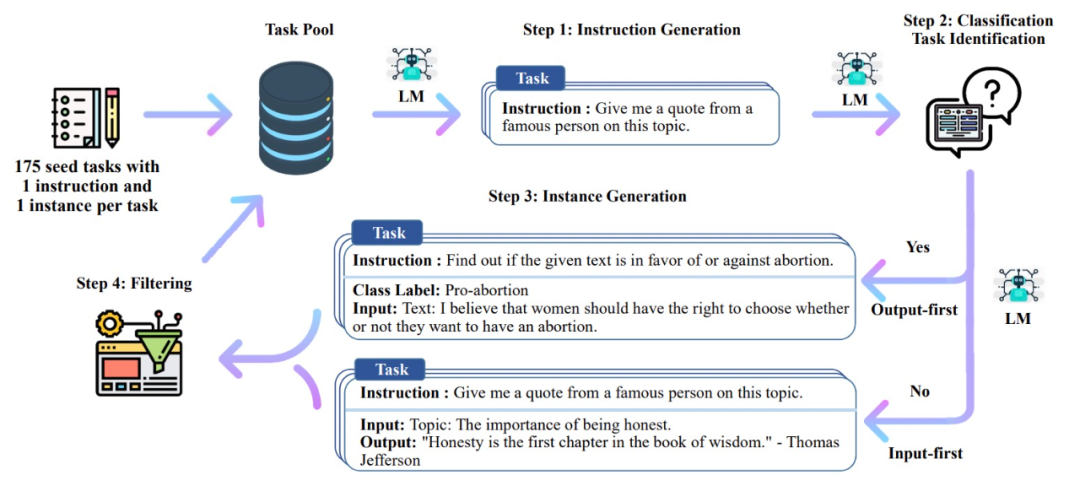

近日,斯坦福基于 Meta 的 LLaMA 7B 模型微調(diào)出一個新模型 Alpaca。該研究讓 OpenAI 的 text-davinci-003 模型以 self-instruct 方式生成 52K 指令遵循(instruction-following)樣本,以此作為 Alpaca 的訓練數(shù)據(jù)。研究團隊已將訓練數(shù)據(jù)、生成訓練數(shù)據(jù)的代碼和超參數(shù)開源,后續(xù)還將發(fā)布模型權(quán)重和訓練代碼。

- 項目地址:https://github.com/tatsu-lab/stanford_alpaca

- 試用地址:https://alpaca-ai-custom6.ngrok.io/

實驗結(jié)果表明,Alpaca 的很多行為都與 text-davinci-003 類似。也就是說,只有 7B 參數(shù)的輕量級模型 Alpaca 性能可媲美 GPT-3.5 這樣的超大規(guī)模語言模型。

我們來看一下 Alpaca 模型是如何做到的。

訓練方法

在學術(shù)界的預算條件下,訓練高質(zhì)量的指令遵循模型面臨兩個重要挑戰(zhàn):強大的預訓練語言模型和高質(zhì)量的指令遵循數(shù)據(jù)。

Meta 最近發(fā)布的 LLaMA 系列模型解決了第一個挑戰(zhàn)。對于第二個挑戰(zhàn),2022 年底的 self-instruct 論文提出使用現(xiàn)有的強大語言模型自動生成指令數(shù)據(jù)。

論文地址:https://arxiv.org/abs/2212.10560

按照這種方法,Alpaca 使用 LLaMA 7B 模型的監(jiān)督學習在 text-davinci-003 以 self-instruct 方式生成的 52K 指令遵循樣本上進行微調(diào)。

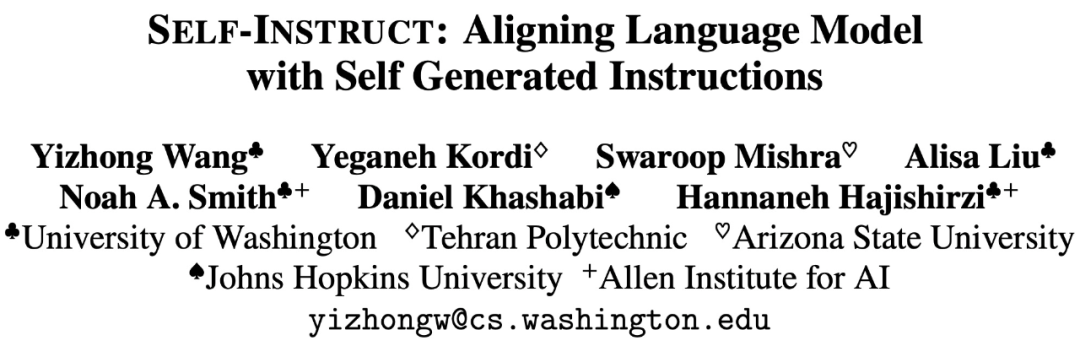

self-instruct 方法概覽。

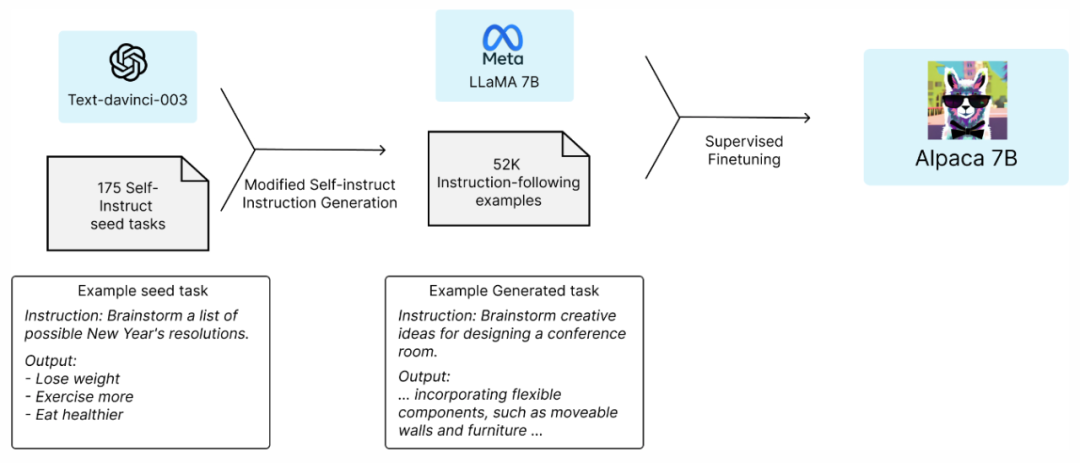

Alpaca 的研究團隊首先使用 self-instruct 種子集中的 175 個人工編寫的指令輸出(instruction-output)對,然后用該種子集作為 in-context 樣本 prompt text-davinci-003 來生成更多指令。該研究通過簡化生成 pipeline 改進了 self-instruct 方法,并顯著降低了成本。

該研究共生成了 52K 個不同的指令和相應的輸出作為訓練數(shù)據(jù),其中使用了 OpenAI 開放的 API,成本不到 500 美元。由于研究團隊已將訓練數(shù)據(jù)開源,對于想要復現(xiàn) Alpaca 的開發(fā)者來說,這500美元就省下了。

有了這個指令遵循數(shù)據(jù)集,該研究下一步使用 Hugging Face 的訓練框架微調(diào)了 LLaMA 模型,并利用了 FSDP(Fully Sharded Data Parallel)和混合精度訓練等技術(shù)。成本方面,在 8 個 80GB A100 上微調(diào)一個 7B LLaMA 模型需要 3 個小時,這對大多數(shù)云計算提供商來說成本不到 100 美元。

模型評估

該研究使用來自 self-instruct 評估集的輸入進行了人工評估,這項工作由 5 名研究團隊的學生完成。該評估集由 self-instruct 論文的作者收集整理,涵蓋了多種面向用戶的 instruction,涉及電子郵件、社交媒體和辦公工具。

在將 text-davinci-003 和 Alpaca 7B 進行 blind pairwise 比較之后,研究者發(fā)現(xiàn)這兩個模型的性能非常相似,并且 Alpaca 略優(yōu)于 text-davinci-003。

從參數(shù)規(guī)模的角度看,Alpaca 遠遠小于 text-davinci-003,移動端甚至也可以運行 7B 的輕量級語言模型。這讓 Alpaca 意義非凡。

除了利用上述靜態(tài)的 self-instruct 評估集,該研究還對 Alpaca 模型進行了交互測試,并發(fā)現(xiàn) Alpaca 的表現(xiàn)通常與 text-davinci-003 相似。

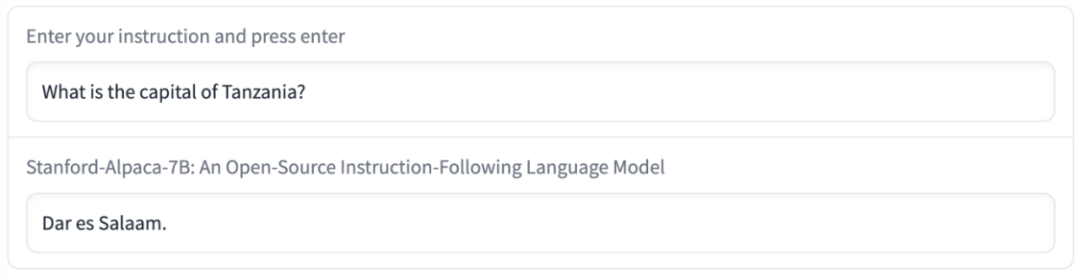

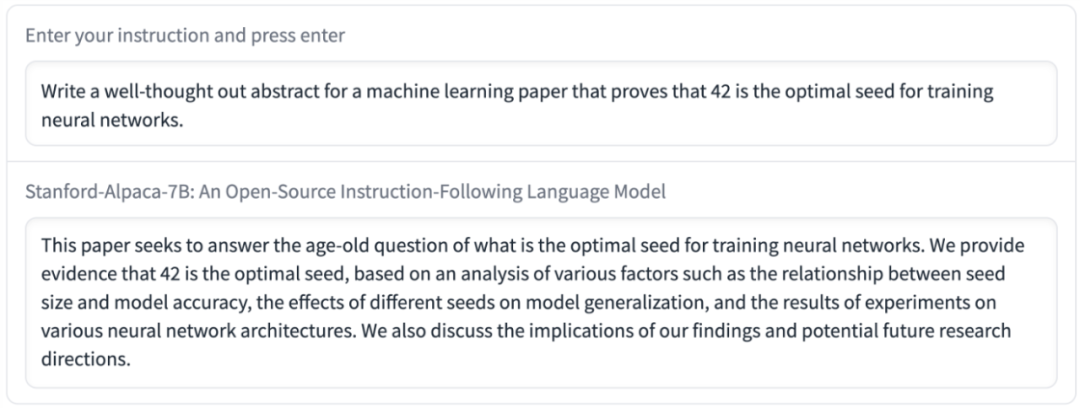

下面是研究團隊測試的兩個例子,結(jié)果表明 Alpaca 的輸出良好,并且反映出指令遵循數(shù)據(jù)集的一般風格。例如,Alpaca 輸出的答案通常比 ChatGPT 更簡潔,這和 text-davinci-003 類似。

模型缺陷

實驗中,Alpaca 還表現(xiàn)出語言模型的幾種常見缺陷,包括幻覺、毒性和刻板印象,其中幻覺問題尤其嚴重。

例如在下圖中,Alpaca 回答坦桑尼亞的首都是達累斯薩拉姆,但實際上應該是多多馬。

此外,Alpaca 能夠生成一些看似良好卻包含錯誤或虛假信息的文本,這可能會誤導人們。

Alpaca 可能包含許多與底層語言模型和指令調(diào)優(yōu)數(shù)據(jù)相關(guān)的其他缺陷。但是,Alpaca 對機器學習社區(qū)仍然具有重要意義,因為它提供了一個相對輕量級的模型,可作為研究重要缺陷的基礎(chǔ)。斯坦福的研究團隊還強調(diào):Alpaca 只可用于學術(shù)研究,禁止任何商業(yè)用途。

接下來,斯坦福的研究團隊會進一步探究 Alpaca 模型的安全性、理解能力、規(guī)模擴展等等。研究團隊希望 Alpaca 能夠促進指令遵循模型的發(fā)展。