AI大牛karpathy點贊SEAL榜單,LLM評估的狀況過去是非常糟糕的!

lmsys.org的一個嚴肅的競爭對手已經加入了對LLMs(大型語言模型)評估的討論中:SEAL Leaderboards——對領先前沿模型進行的私密、專家評估。

SEAL Leaderboards的設計原則:

??私密 + 無法被利用。在評估上不會過度擬合!

??領域專家評估

??持續更新,包含新數據和模型

https://x.com/karpathy/status/179587366648140201

https://x.com/karpathy/status/179587366648140201

Andrej Karpathy(原OpenAI的創始成員和研究科學家,也是特斯拉人工智能和自動駕駛部門(Autopilot)原負責人)的一些觀點:

- LLM評估正在改進,但不久前它們的狀況非常糟糕,因為定性體驗經常與定量排名不符。

- 好的評估很難構建——在特斯拉,Karpathy可能花了1/3的時間在數據上,1/3在評估上,還有1/3在其他所有事情上。它們必須全面、代表性強、質量高,并測量梯度信號(即不要太容易,也不要太困難),在定性和定量評估一致之前,有很多細節需要考慮和正確處理。

- 任何公開(非私有)的測試數據集不可避免地會滲透到訓練集中。這是人們強烈直覺上懷疑的事情,也是為什么最近的GSM1k引起了轟動。https://arxiv.org/html/2405.00332。

- 即使LLM開發者盡了最大努力,防止測試集滲透到訓練集中(以及答案被記住)也是困難的。當然,你可以盡力過濾掉完全匹配的項。你也可以過濾掉近似匹配的項,比如使用n-gram重疊等。但是你如何過濾掉合成數據重寫,或者有關數據的相關在線討論呢?一旦我們開始常規地訓練多模態模型,你如何過濾掉數據的圖像/截圖?你如何防止開發者,例如,向量嵌入測試集,并特別針對與測試集在嵌入空間中高度一致的數據進行訓練?

- 大家關心的并非所有LLM任務都可以自動評估(例如,想想摘要等),在這種情況下,你希望涉及人類。當你這樣做時,你如何控制所有涉及的變量,比如人們有多關注實際答案,或者長度,或者風格,或者如何處理拒絕等。

- 好的評估出人意料地困難,工作量巨大,但非常重要。

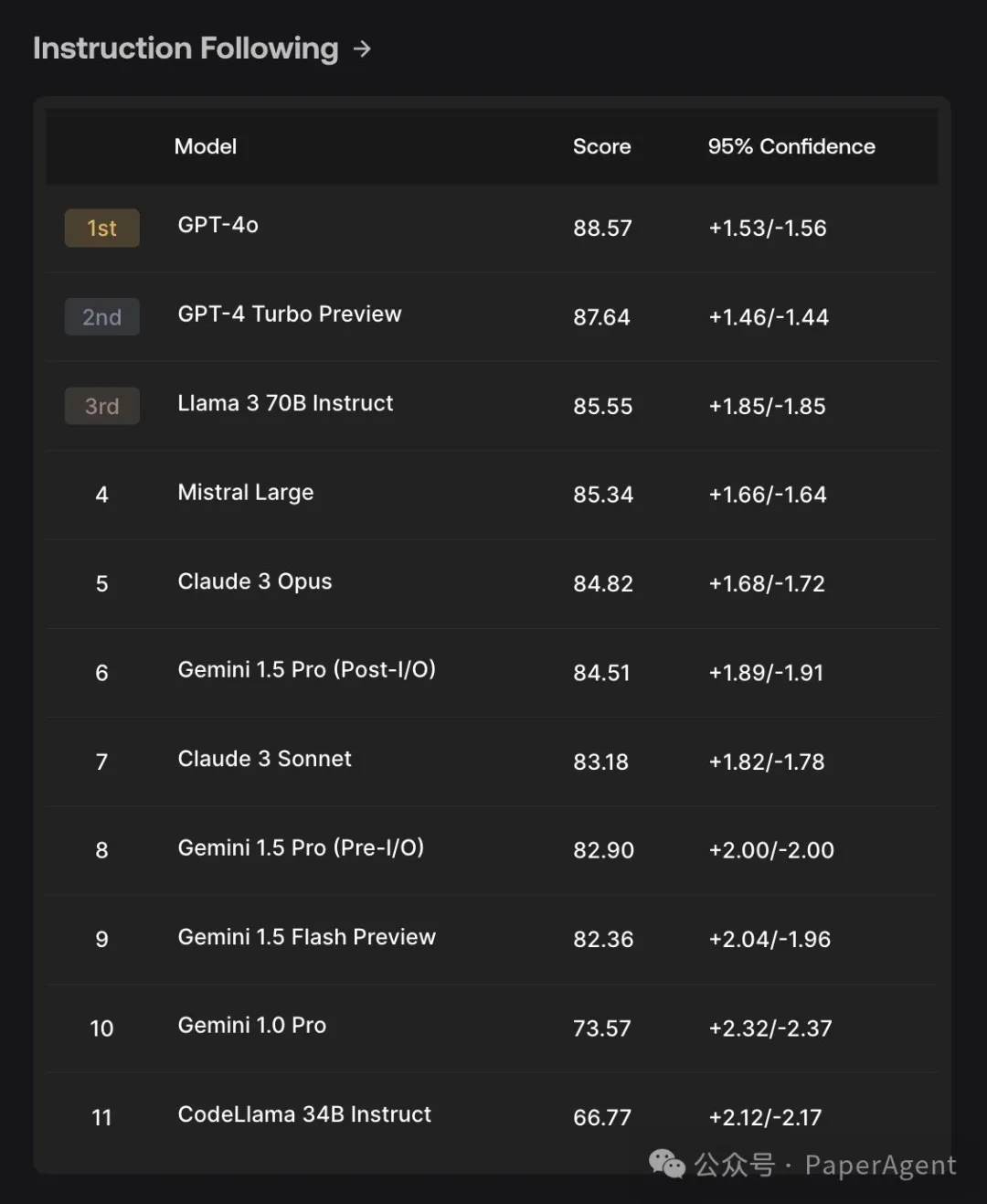

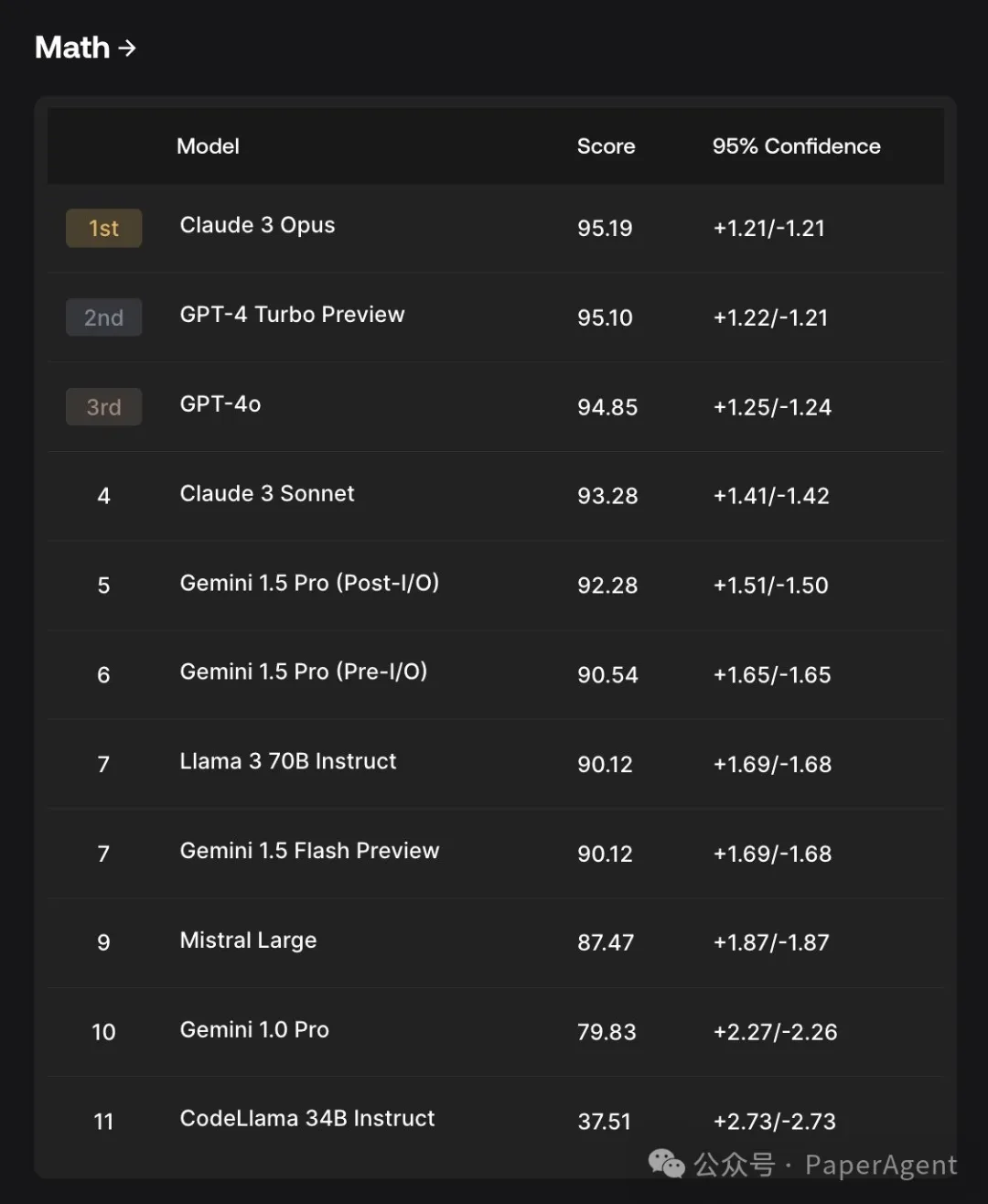

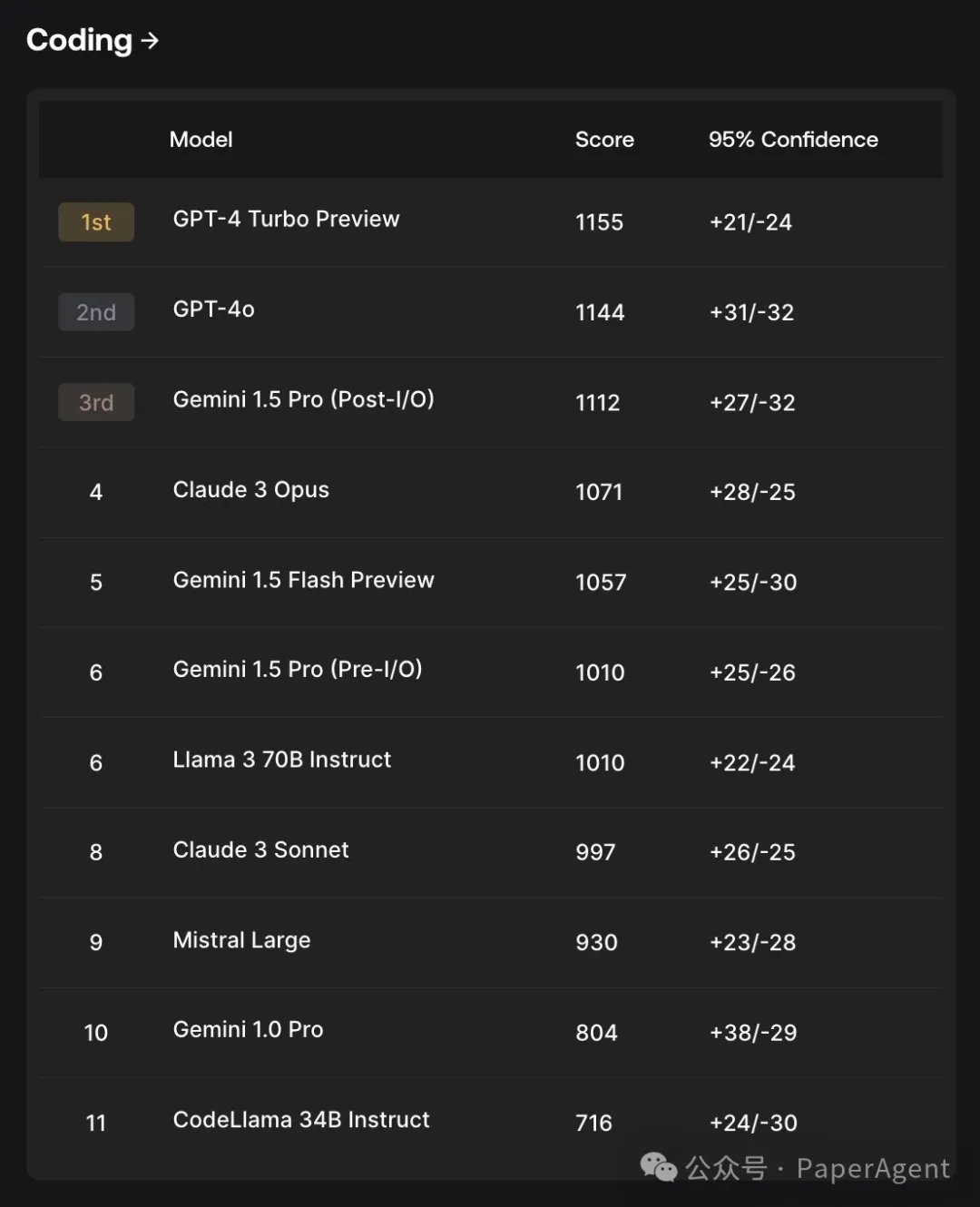

SEAL Leaderboards一些大模型評估結果,包括一些領先大模型:

- GPT-4o - GPT-4 Turbo - Claude 3 Opus - Gemini 1.5 Pro - Gemini 1.5 Flash - Llama3 - Mistral Large

圖片

圖片

圖片

圖片

圖片

圖片

SEAL Leaderboards https://scale.com/leaderboard