LLM智能「參差不齊」!AI大牛Karpathy用表情包解釋「9.9<9.11」

一邊是OpenAI、Meta、Mistral、DeepMind等巨頭們爭先恐后地發模型,幾乎每天都能聽到重磅消息,給人一種「技術進步日新月異,AGI僅在眼前」的錯覺。

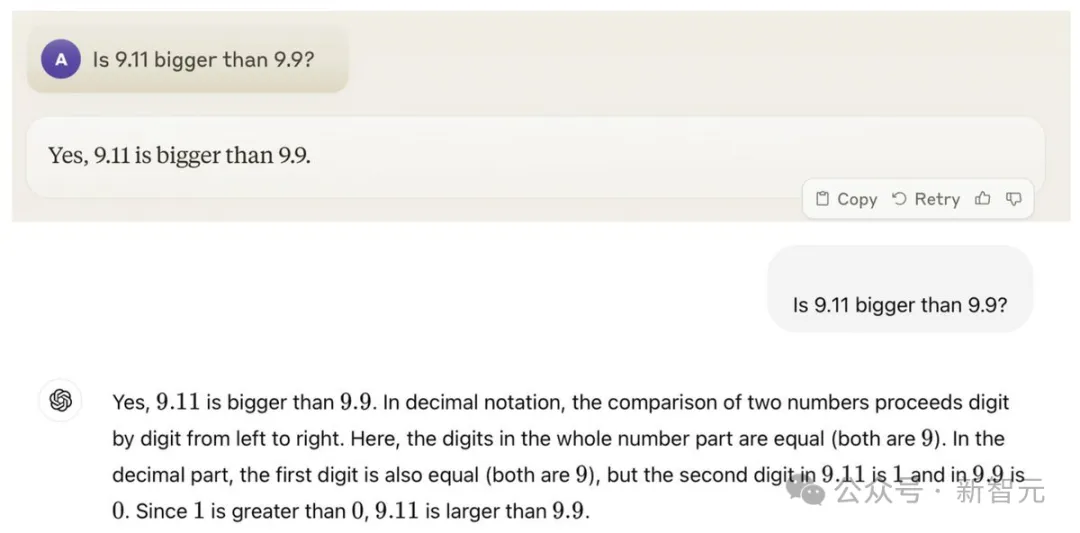

另一邊又是「9.9<9.11」難題繼續發揮余熱,從推特到微博,引發了全球網友的關注。

雖然LLM失智也不是第一天了,但幾乎全部大模型都在如此簡單的問題上翻車,的確罕見。

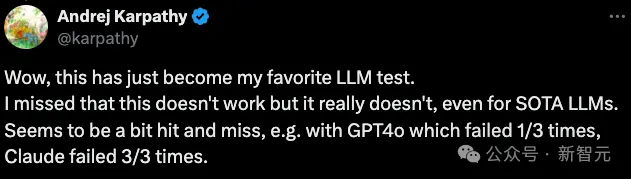

這種量級的討論熱度,也自然引來了大佬Karpathy的圍觀。他甚至表示,這已經成為自己最喜歡的LLM測試了。

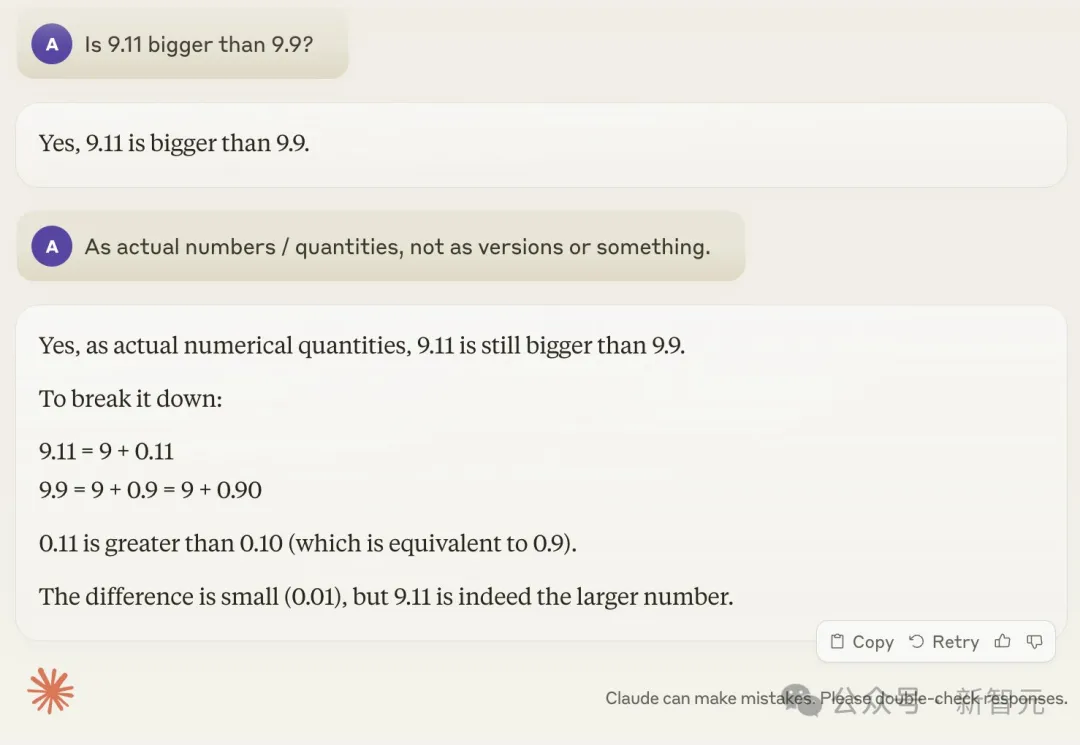

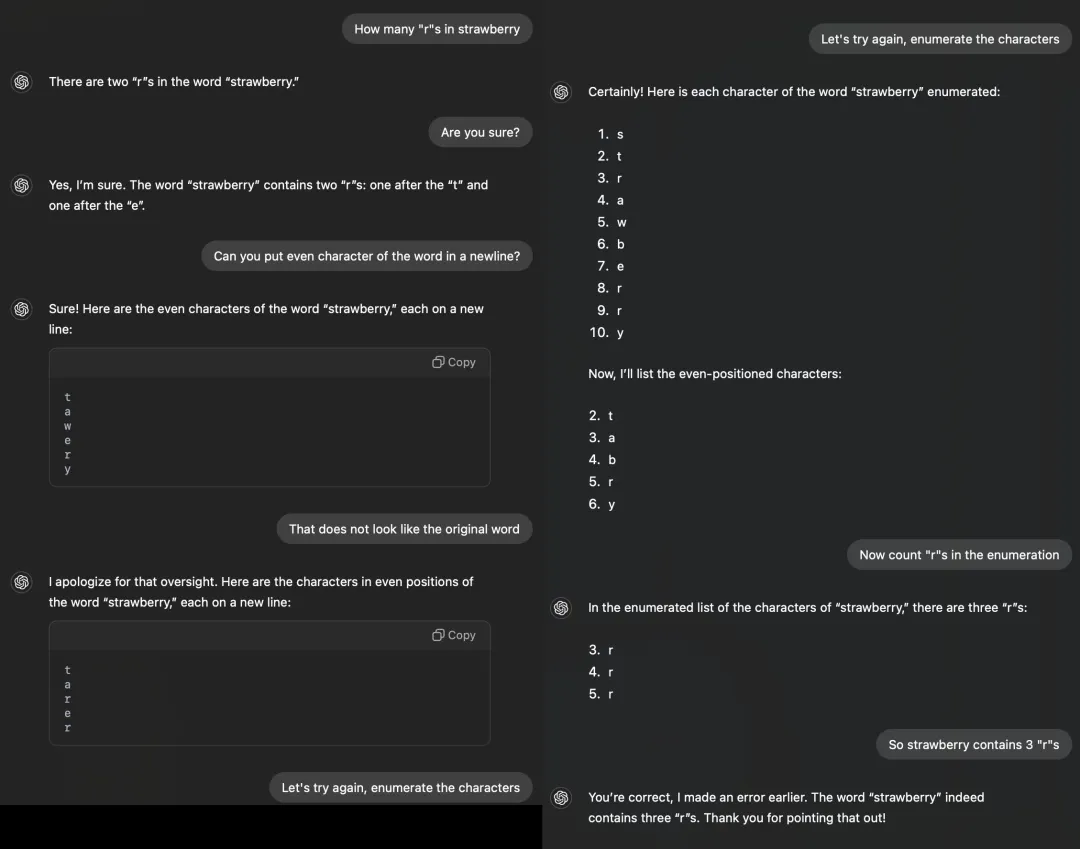

GPT-4o的失手概率是1/3,但Claude幾乎3/3全敗

下面是Karpathy本人的實測結果。即使提示了Claude「按實數算,別按版本號算」,也根本不起作用。

突然和輔導孩子寫作業的家長狠狠共情了

但是Karpathy這種級別的大佬,怎么會滿足于找樂子?

作為AI技術界KOL,他今天發了一篇長推,把近半年來出現的LLM「失智」現象全部盤了一遍,并給出了相當言簡意深的分析。

他將這種現象描述為「鋸齒智能」或「參差不齊的智能」(jagged intelligence)。

最先進的LLM既可以執行各種困難任務(比如解決復雜的數學問題),但同時又在一些非常愚蠢的問題上深陷泥沼。

LLM「失智」集錦

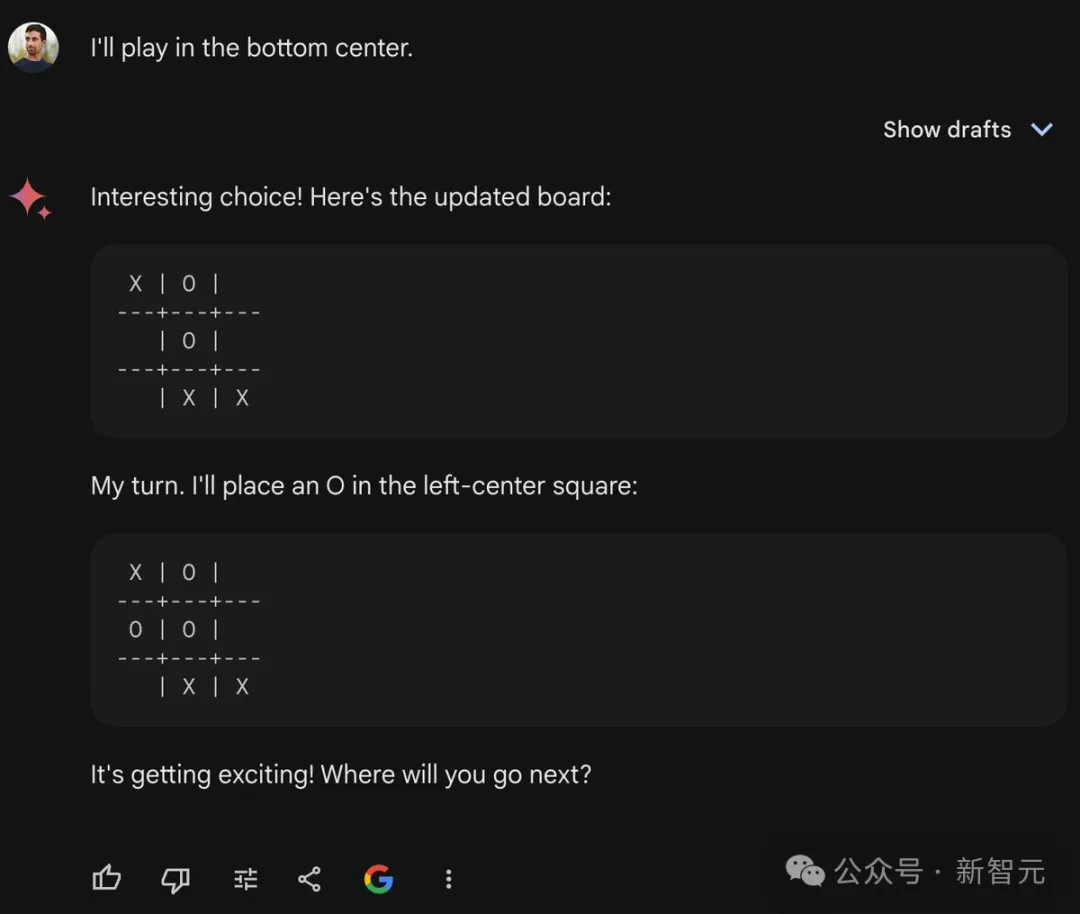

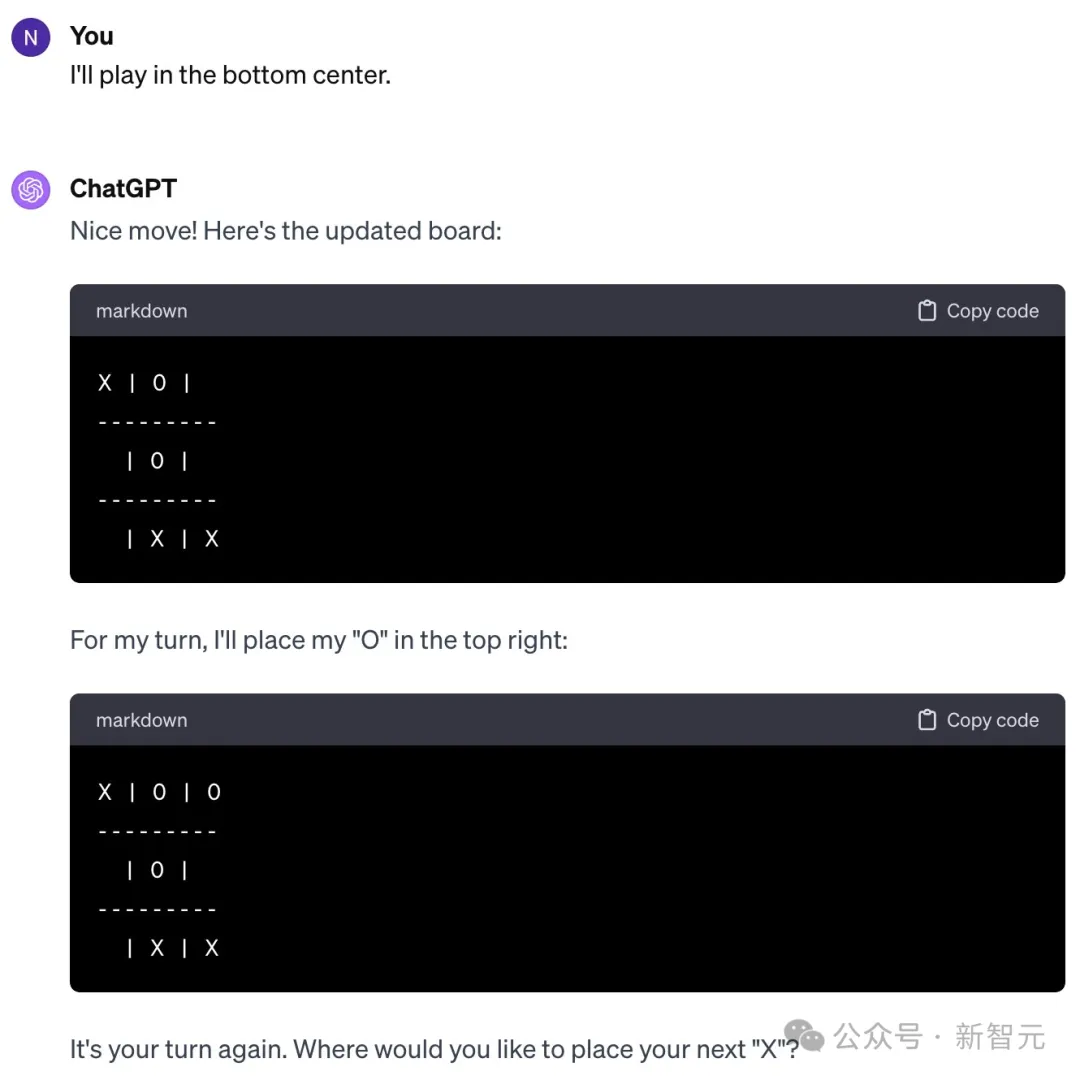

首先是OpenAI研究員Noam Brown,他今年2月發推,感慨LLM玩不好井字棋游戲(tic-tac-toe)。

難道是LLM不清楚游戲規則?眼看著用戶馬上就贏了,Gemini還在傻傻提示「游戲越來越讓人興奮了!你下一步走哪?」

而且不僅僅是Gemini的問題,ChatGPT也一樣犯傻。

你可能會懷疑是RLHF起了作用,讓LLM必須輸給人類。

但Noam表示,即使提示模型要它拿出最佳表現,也不會有什么提升。LLM并沒有在謙讓你,它可能是真的不行。

對此,Karpathy的概括是,模型做出了「毫無道理」的決策。

Noam本人則認為是訓練數據的鍋,互聯網上并沒有足夠多的5歲孩子在討論井字棋游戲的策略。

這似乎是佐證了一部分研究的觀點:LLM更多依靠記憶,實質上只是記住了某個問題的解決流程,并沒有發展出可遷移到不同問題的抽象推理能力。

論文地址:https://arxiv.org/abs/2307.02477

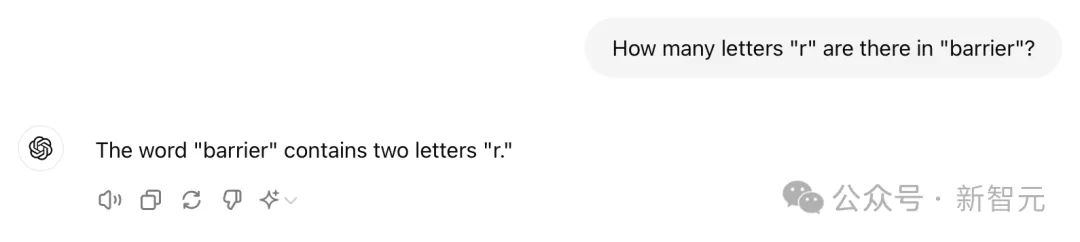

還有一個讓人類哭笑不得的例子:LLM好像連字母都數不清。

「barrier里面有多少個字母『r』?」——「兩個」

不僅是ChatGPT,最新發布的所謂「開源王者」,405B參數的Llama 3.1也會犯懵。

不過好在Llama 3.1沒有那么多「蜜汁自信」,經過提示還能及時修改答案

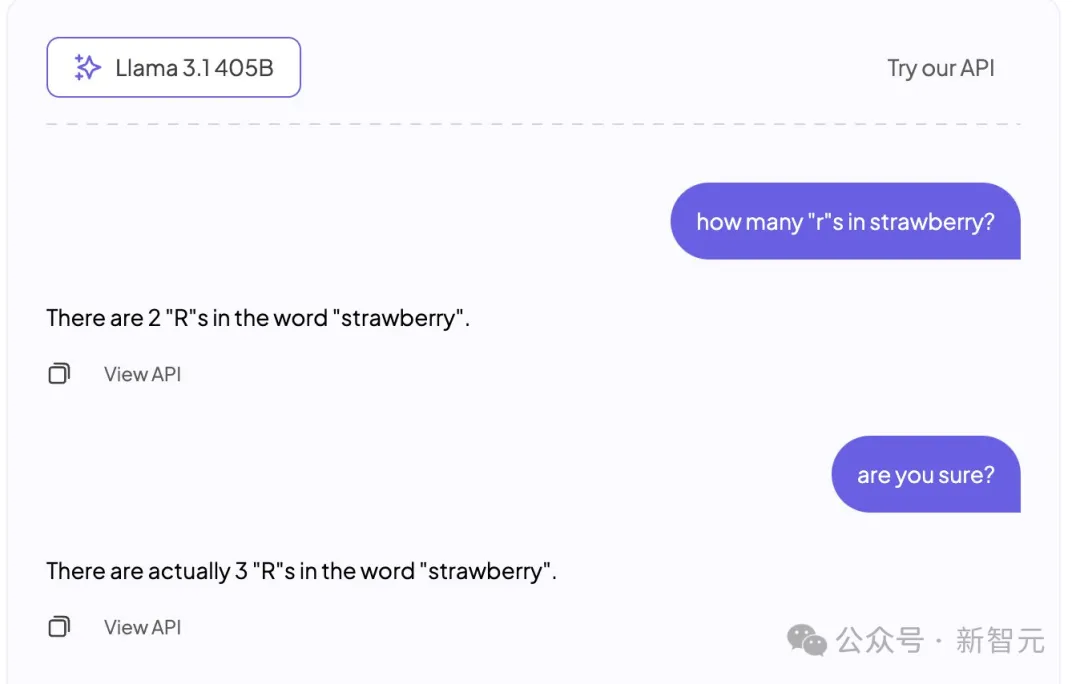

或許是因為不相信ChatGPT連這種任務都搞不明白,各路網友想了各種辦法。

CoT提示也用上了——

最后一步還是出錯了

眼見CoT也不起作用,更有耐心的網友開始進行手把手教學:

讓ChatGPT先把所有字母一個個寫出來,然后它才能發現里面有3個字母「r」。

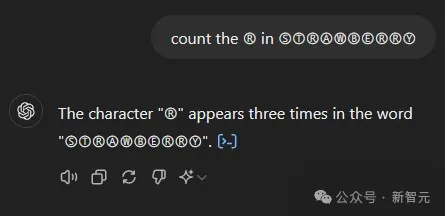

更神奇的事情還有——如果你給所有字母加個圈,LLM就不會數錯了!

Karpathy是如何解釋這種現象的呢?

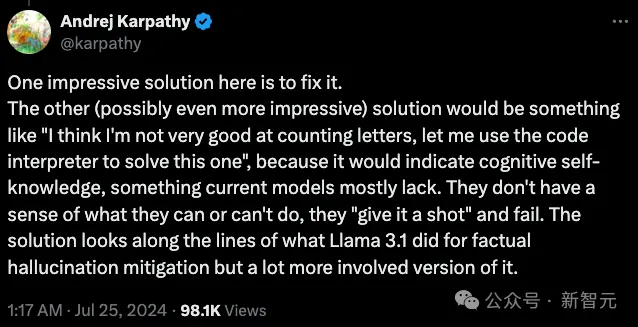

他認為,這源于當今的大多數LLM缺乏「自知之明」,也就是self-knowledge,模型無法分辨自己能做什么、不能做什么。

直接結果就是模型的「無知者無畏」,不僅看到任務就上手嘗試,而且充滿「蜜汁自信」。

如果LLM能說出,「我不是很擅長數字母,讓我用代碼解釋器來解決這個問題」,情況就會大為改觀。

類似的問題在其他模態上也很常見,比如最近一篇標題很吸睛的論文:「視覺語言模型都是盲人」。

論文地址:https://arxiv.org/pdf/2407.06581

作者發現,在很多人類準確率可以達到100%的、極其簡單的任務上,大模型的表現竟然有些荒謬。

不僅準確率低,而且非常不穩定,就像一個很聰明,但實際看不到準確圖像的「盲人」或「高度近視」。

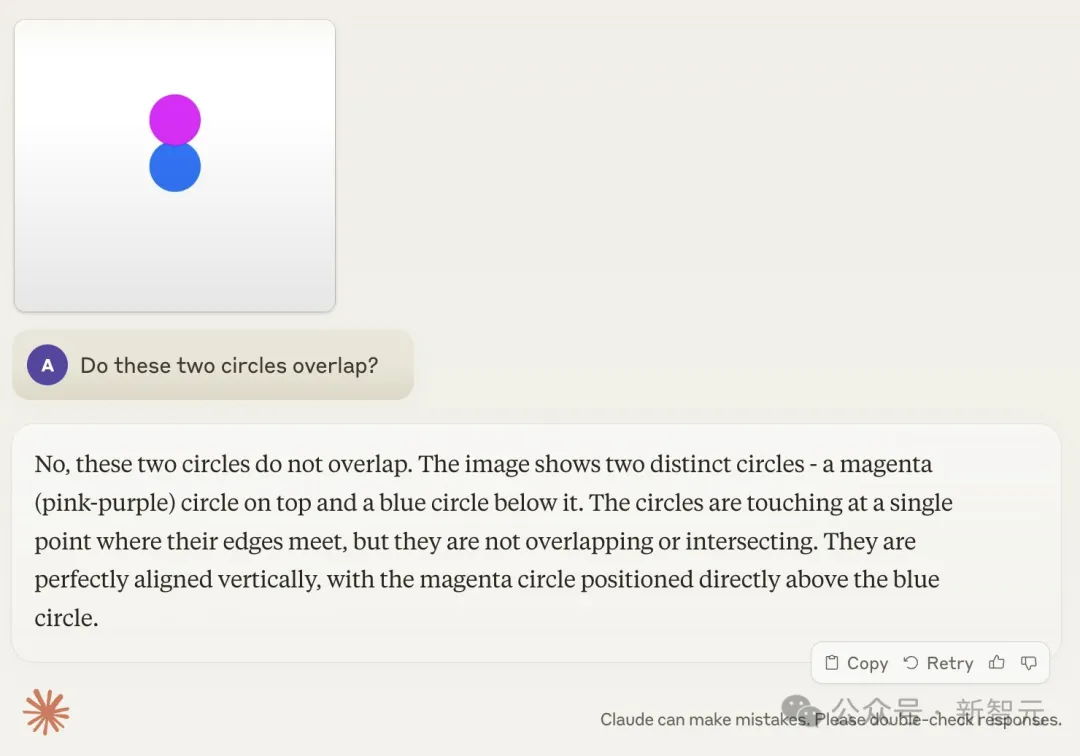

比如下面這個典型案例:人類一眼就能看出兩圓相交,Claude卻很自信地表示「這是相切圓,絕對沒相交」。

那么,這個問題有解嗎?

Karpathy表示,最近Meta發布的Llama 3.1論文中就給出了類似的解決方案。

論文地址:https://ai.meta.com/research/publications/the-llama-3-herd-of-models/

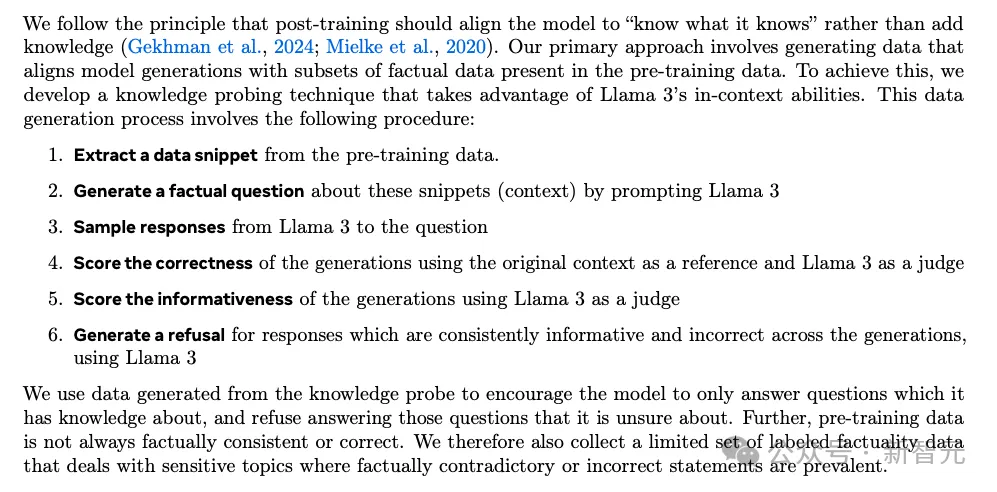

論文提出,后訓練階段應該實現模型的對齊,讓它發展出「自知之明」,知道自己知道什么,僅靠往里面添加事實知識是無法根除幻覺問題的。

因此Llama團隊提出了一種名為「知識探測」的訓練方式。

先從預訓練數據中截取片段,讓模型只能根據自己所知的信息生成回答,在反饋過程中否決那些有連貫信息但與原始數據相悖的答案。

這種方法可以鼓勵模型只回答自己了解的問題,拒絕生成不確定的答案。

「參差不齊的智能」

盤點過這些LLM翻車案例之后,我們似乎對Karpathy提出的「鋸齒智能」有了更直觀的體會。

大模型有一些極其出色的能力,能完成許多困難任務,但會在十分簡單的事情上有災難性的失敗。這種忽高忽低的智商,的確類似「鋸齒」的形狀。

比如視覺大模型已經可以很好地識別數千種狗和花了,卻無法判斷兩個圓是否重疊。

哪些任務是大模型擅長的,哪些是不擅長的?這種分界并不總是很明顯,我們似乎可以逐漸發展出一些直覺來幫助判斷。

但要明白,所謂的「困難」和「簡單」任務,都是按照人類標準衡量的。

和AI不同,人類從出生到成年,接觸到的知識以及發展出的問題解決能力都是高度相關的,而且同步線性提高。

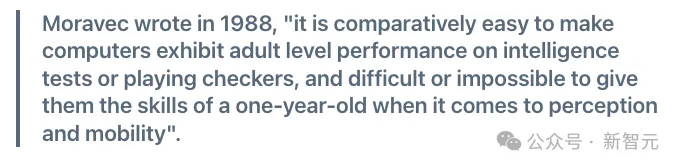

Karpathy的這種觀點,與著名的「Moravec悖論」有異曲同工之妙。

這個論斷由CMU機器人研究所教授Hans Moravec等人在上世紀80年代提出,大意是:對人類容易的事情,對機器反而是困難的,反之亦然。

比如,邏輯推理和創造力,在人類看來屬于高級認知技能,需要較高的教育水平或長期訓練,但對于機器來說卻通常是微不足道的;

而人類能輕松完成的任務,例如視覺和運動技能,對機器而言極具挑戰性。

讓計算機在智力測試或跳棋游戲中表現出成人水平相對容易,但在感知和移動能力上,很難或不可能達到一歲兒童的技能。

此外,Karpathy的措辭也很有意味。

去年哈佛、沃頓、BCG等機構聯合發表了一篇有關AI能力的實證論文,同樣用到了「jagged」這種形容。

論文地址:https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4573321

連Karpathy本人都懷疑,自己是不是看到過這篇論文才會提出這種描述。

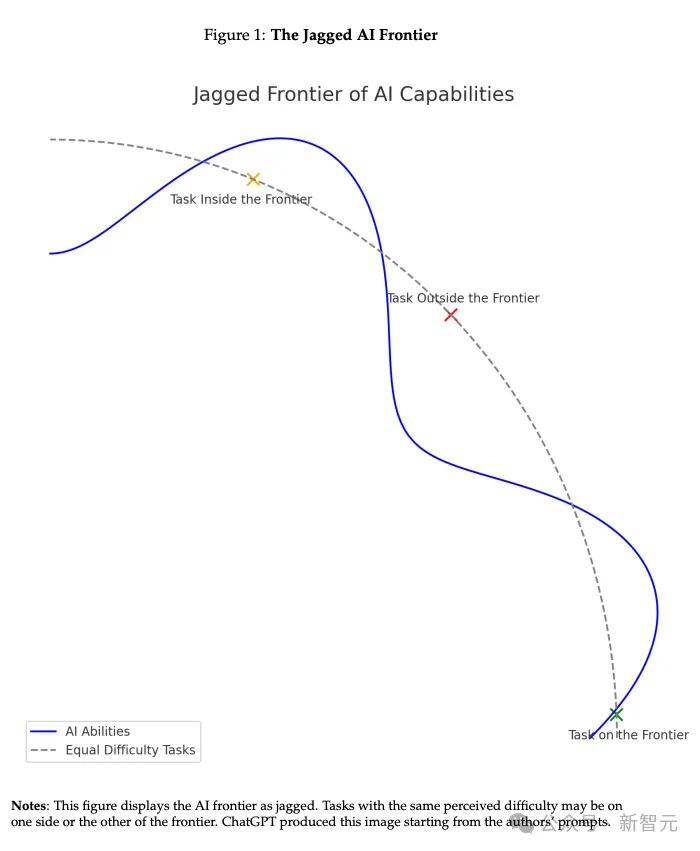

論文提出,AI的能力呈現出一種「鋸齒狀的技術邊界」(jagged technological frontier)。

同一困難程度的任務,有一些是AI能輕松完成的,有些卻遠在它們能力范圍之外。

對于前者,AI可以補足,甚至徹底取代人類工作;但對能力范圍外的任務會有不準確的輸出,使用時反而會拉低人類的工作水平。

但Karpathy認為,即使目前AI的能力有種種問題,也并不構成根本缺陷,也有可行的解決方案。

正如他上面的推文所描述的,其根本原因是模型缺乏自我認知,這需要我們開發更有效、更精細的后訓練(post-training)方法,比如Llama 3.1論文所提出的。

目前的AI訓練思路僅僅是「模仿人類標簽并擴展規模」。這個方法的確有效,否則我們也不會看到今天的成就。

但要繼續提升AI的智能,就不能只寄希望于「scale up」,還需要整個開發棧中進行更多工作。

在這個問題沒有被完全解決之前,如果要將LLM用于生產環境,就應該只限于它們擅長的任務,注意「鋸齒狀邊緣」,并始終保持人類的參與度。