LLM | 偏好學習算法并不學習偏好排序

圖片

圖片

一、結論寫在前面

偏好學習算法(Preference learning algorithms,如RLHF和DPO)常用于引導大型語言模型(LLMs)生成更符合人類偏好的內容,但論文對其內部機制的理解仍有限。論文探討了傳統觀點,即偏好學習訓練模型通過排序準確性來賦予更偏好的輸出比不太偏好的輸出更高的似然性。

論文的工作凸顯了偏好學習與排序準確性之間顯著但關系微妙。論文理論和實證上都證明了RLHF和DPO難以教會模型正確地對偏好和非偏好輸出進行排序,即使在訓練數據集中也是如此。盡管學習目標理論上促進了高排序準確性。論文發現大多數最先進的偏好調整模型在常見偏好數據集上的排序準確率不足60%。論文進一步推導了如果偏好調整的LLM完美優化DPO或RLHF目標,其理想化的排序準確率。

論文證明現有模型存在顯著的對齊差距——即觀察到的與理想化的排序準確率之間的差距。論文認為這種差異源于DPO目標,該目標在經驗上和理論上都不適合修正參考模型中的輕微排序錯誤,并推導出一個簡單高效的公式來量化學習特定偏好數據點的難度。最后,論文證明當模型接近目標中使用的參考模型時,排序準確性與經驗上流行的勝率指標高度相關,進一步揭示了策略內(如RLHF)和策略外(如DPO)偏好學習算法之間的差異。

二、論文的簡單介紹

2.1 論文的背景

偏好學習算法最初設計用于使用候選者之間的成對偏好數據集來訓練具有高排序準確性的模型——即,模型能夠精確地將偏好的輸出排在不偏好的輸出之上。在語言模型的情況下,排序由分配給每個候選的似然性決定。

許多語言模型對齊技術旨在產生具有高偏好排序準確性的模型,包括SLiC、RAFT、PRO和RRHF[。最著名的是,Rafailov等人聲稱他們流行的直接偏好優化(DPO)算法"增加了優選響應相對于非優選響應的對數概率"。通常通過測量結果模型的生成結果相對于另一個模型的偏好程度(即勝率)來評估這些不同的目標[69]。然而,損失函數、排序準確性和勝率之間的關系尚不清楚,這讓人不禁懷疑這些對齊技術在訓練過程中實際上在做什么。

2.2 對齊差距

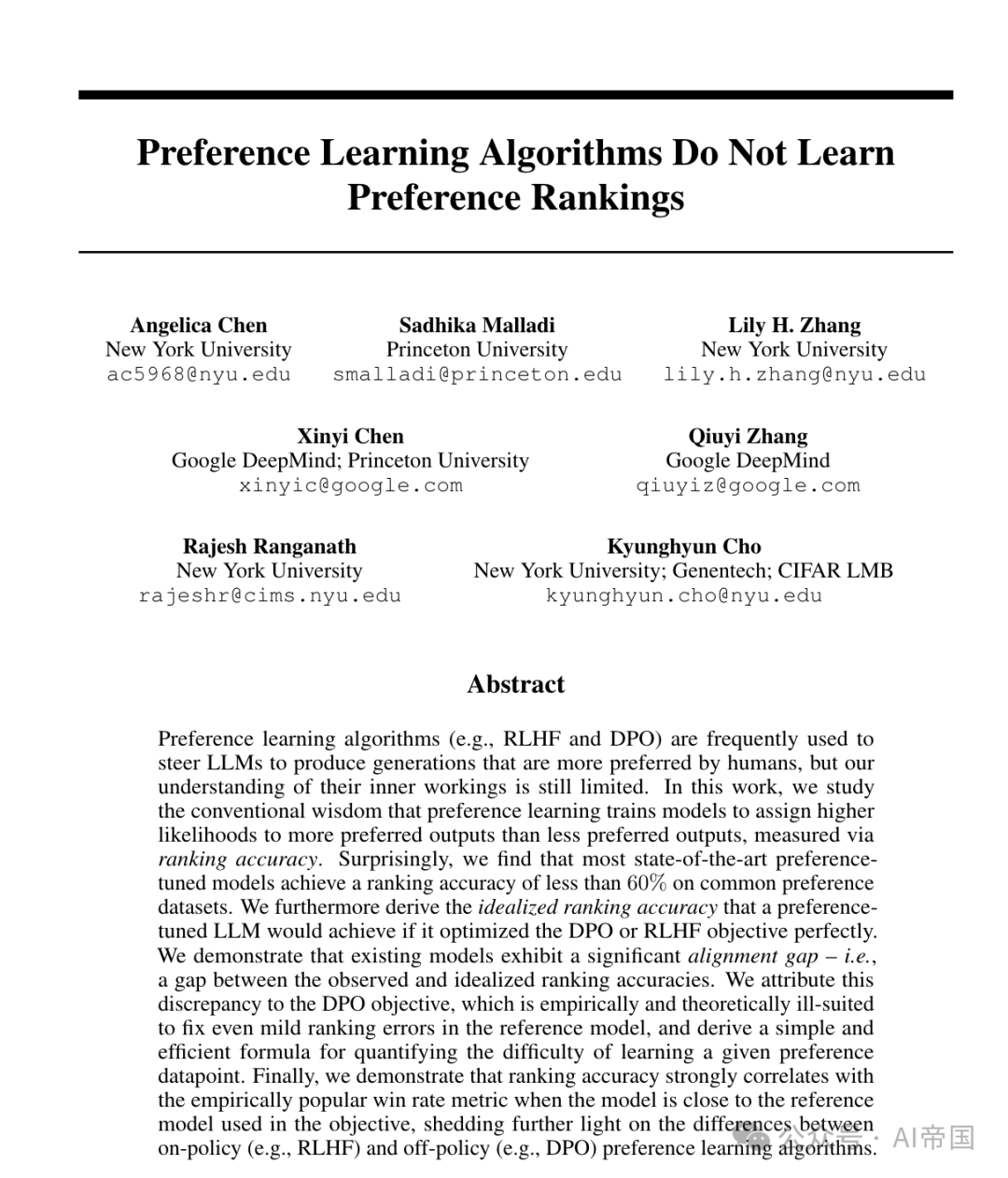

使用完美的參考模型訓練以達到低DPO損失,將產生一個具有完美排序準確性的模型。然而,圖1a顯示現實世界的參考模型在常見的偏好數據集上排序準確性較低,這促使論文研究更現實、不完美的參考模型。

2.2.1 現有參考模型很少具有正確排序

圖1a表明,參考模型在常見的偏好數據集上很少能達到高排序準確性(除了合成指令GPT-J成對數據集),盡管許多模型可能已經根據偏好完成進行了訓練。許多模型的訓練數據沒有詳細記錄,因此論文不清楚哪些偏好數據集,如果有的話,是分布內的。論文還對幾個預訓練的大型語言模型(LLMs)進行了微調,以偏好完成,并觀察到排序準確性并沒有顯著提高。基于論文的發現,論文轉向不完美的參考模型的情況。

2.2.2 理想化的排序準確性

論文上面表明,從經驗上看,參考模型在排序可能的完成時表現出較差的準確性。然而,RLHF獎勵和DPO目標被設計為確保模型學習偏好數據集,但不會偏離參考模型rRef太遠,因此偏好調整模型的可能準確性可能存在限制。在這里,論文通過研究在完美優化DPO或RLHF時,當訪問完美數據(即人類偏好的真實比例)時,最優策略將是什么,來正式化這一直覺。

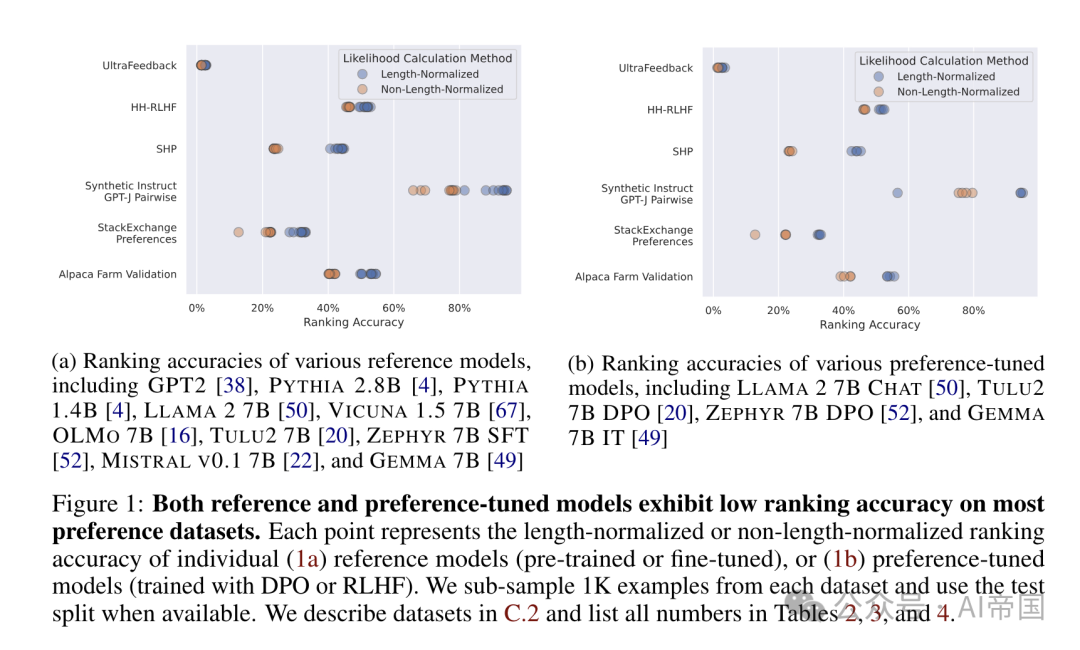

2.2.3 測量對齊差距

論文發現了一些令人驚訝的結果。首先,即使在理想條件下(即在真實偏好數據上完美優化目標函數),理想排序準確性有時仍低于100%。這種差距隨著β的選擇而變化,表明DPO/RLHF的極限在很大程度上取決于對πRef的依賴程度。此外,論文發現許多最先進的模型都無法達到接近理想排序準確性的排序準確性,表現出19到59個百分點的對齊差距。

表1:現有算法的理想排名準確性并不完美,但偏好調整模型顯示出的排名準確性遠未達到這種理想情況。論文提供了在Alpaca Farm [8]驗證數據集(詳見附錄C.2)上,多種開放訪問的偏好調整模型的長度歸一化(R)和非長度歸一化(R)排名準確性。同時提供了理想排名準確性(推論3.3)。由于理想排名準確性可以通過多種B值計算,論文提供了最小、中位數和最大理想排名準確性值的范圍,詳情見附錄C.4

圖片

圖片

2.3 理解DPO的排名準確性

論文現在轉向訓練目標來解釋對齊差距。論文專注于DPO目標,因為其未能達到高排名準確性特別令人驚訝(表1)。特別是,DPO直接在線下數據集上最大化偏好-非偏好對的獎勵邊際,因此論文期望它在分布外的保留數據上表現良好。論文還注意到,DPO是社區中對齊LLMs的流行選擇,因為它比執行RLHF成本更低。

2.3.1 DPO很少改變偏好排序

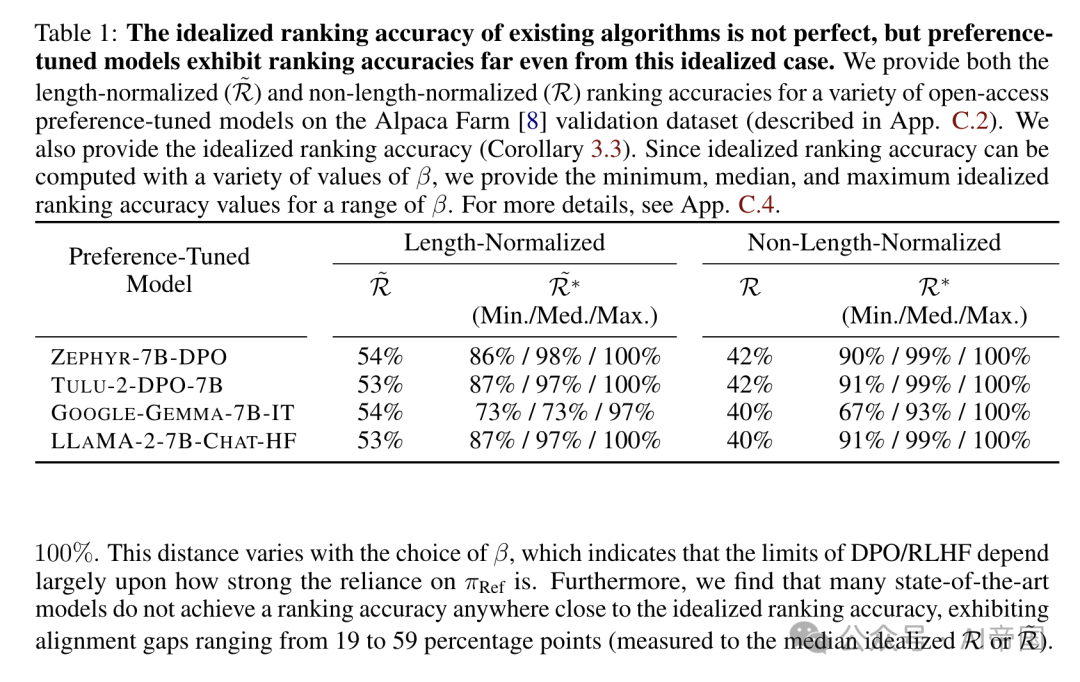

為了研究DPO訓練過程中排序準確性的變化,論文在Anthropic HH-RLHF偏好數據集上訓練了三種規模的模型(GPT-2、Pythia 2.8B和Llama 2-7B),每種模型都有三個隨機種子,并研究了訓練數據集的不同分區上的排序準確性。論文在圖2中展示了訓練一個Pythia 2.8B模型的結果,其他兩個模型的結果放在附錄D.2中。在圖2中,論文根據參考模型πRef是否具有正確的排序以及當前模型πθ是否具有正確的排序,將訓練數據集中隨機抽取的1K個樣本劃分為四組。

令人驚訝的是,圖2顯示,盡管DPO在訓練過程中持續降低損失Cppo,但它很少改變排序。除了模型忘記正確偏好排序的那組點之外,論文觀察到損失持續下降,獎勵邊際持續增加。然而,在驗證損失最低的點,不到一半的錯誤排序點已被翻轉為正確的排序。這表明DPO目標在實際中誘導高排序準確性方面存在問題。

圖片

圖片

圖2:盡管不斷降低損失,DPO很少顛倒對子的排名,而是主要增加了已正確排序對子的獎勵邊際。論文使用DPO目標訓練了一個Pythia-2.8B模型,并將訓練數據集分為四個子集:初始時排名正確并被翻轉為(1)正確或(2)錯誤的例子,以及初始時排名錯誤并被翻轉為(3)正確或(4)錯誤的例子。在所有三個圖中,點的色調表示類別。虛線垂直線表示評估損失達到最低的訓練步驟。論文還為另外兩個模型提供了每種三個種子的結果,詳見附錄D

圖片

圖片

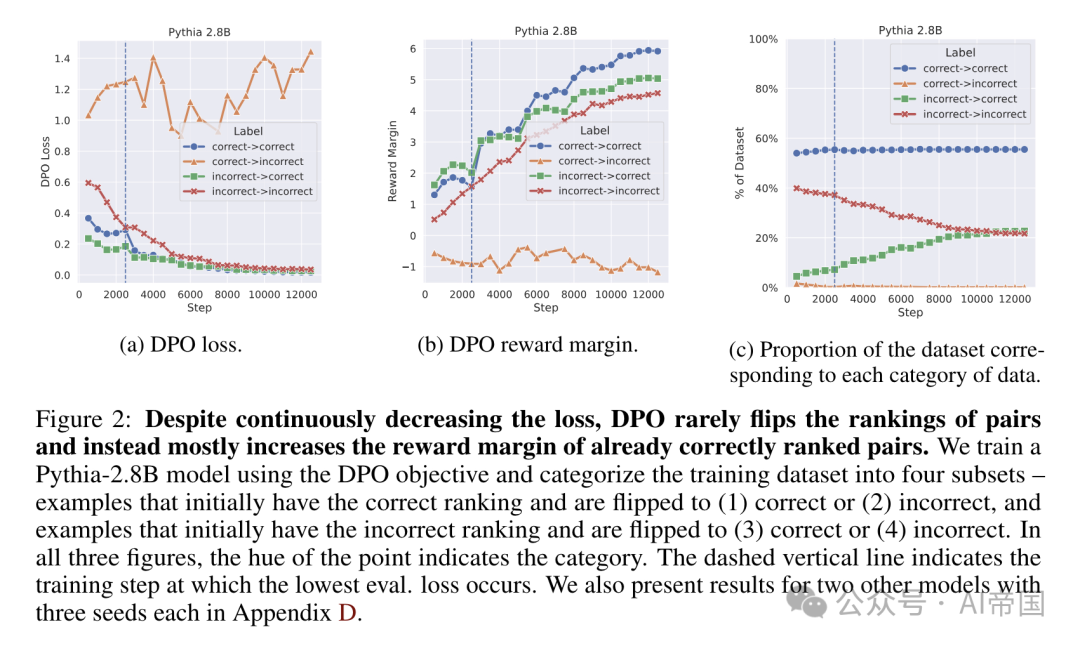

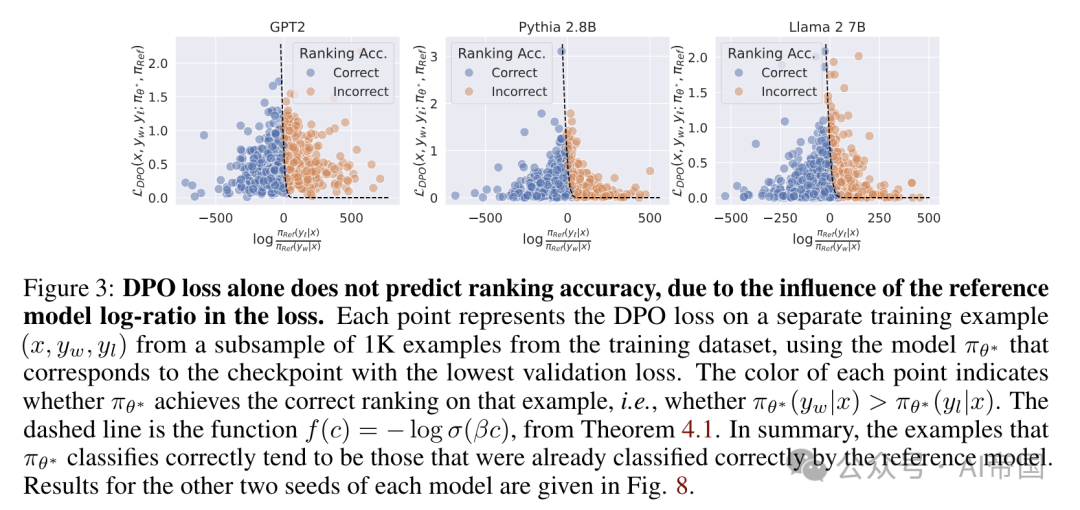

圖 3:單獨的 DPO 損失并不能預測排名準確性,這是由于損失中參考模型對數比率的影響。每個點代表來自訓練數據集 1K 子樣本中一個獨立訓練示例的 DPO 損失,使用的是對應于驗證損失最低檢查點的模型 rg-。每個點的顏色表示 wg 是否在該示例上實現了正確的排名,即是否 o (yw .c) > To* (yw w)。虛線是定理 4.1 中的函數 f(c) = - log o(3o)。總之,tg- 正確分類的示例往往是參考模型已經正確分類的那些。

2.3.2 分析:翻轉排名有多容易?

下面的結果表明,DPO 損失可以在模型排名準確性沒有改善的情況下顯著降低。論文的理論成果使論文能夠正式識別那些在其排名中難以翻轉的點。圖 3 展示了多種設置下的參考模型對數比率,并強調了即使在參考模型中排名錯誤輕微的數據點,也需要損失降低到非常低的值才能翻轉排名。論文觀察到,難以學習的數據點明顯比易于學習的點要長,而且易于學習的數據點通常包含的偏好注釋較為明確。更廣泛地說,論文的結果激發了使用更強大的 TRef 模型以及 DPO 的迭代或策略內變體的需求。

2.4 排名準確性與勝率

論文對排名準確性的研究揭示了 DPO 和 RLHF 如何與偏好數據對齊,但論文尚未將這些見解與模型在對齊過程中生成行為的變化聯系起來。特別是,排名準確性是一個方便但策略外的指標,因此不如策略內指標(如勝率)那樣被廣泛采用(見第 2.2 節)。論文通過排名準確性和勝率的視角,探討了大型語言模型(LLMs)的策略內(即生成性)和策略外(即分類性)行為之間的差距。由于 DPO 目標直接優化排名準確性(命題 2.6),這兩個指標之間的關系直接反映了策略外訓練如何影響策略內行為。

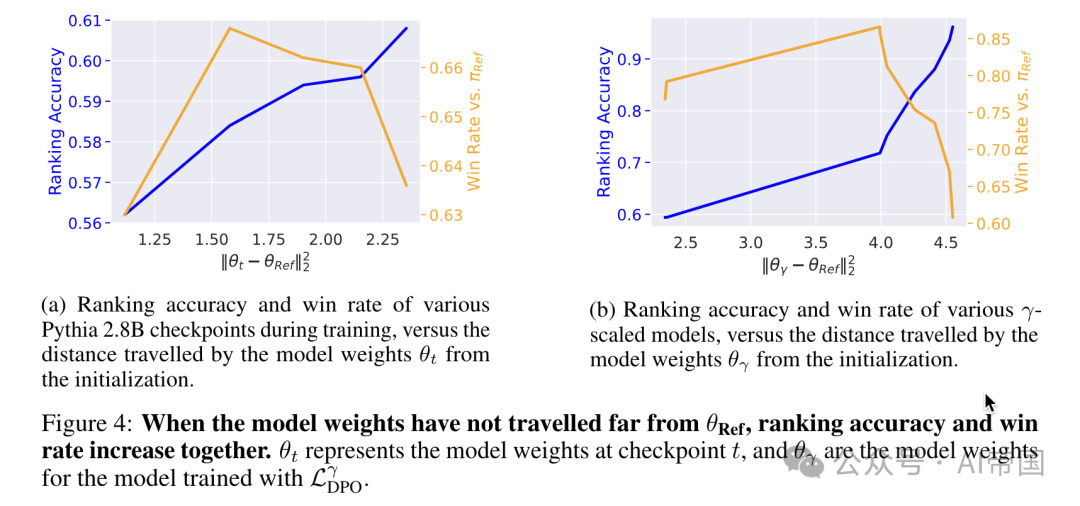

論文研究了勝率與排名準確性之間的關系,具體在兩種情況下進行:(1) 在DPO訓練期間,以及(2) 在一種調節TRef影響的DPO變體中。論文使用Alpaca Eval GPT4 自動標注工具對訓練數據集中的500個響應進行勝率測量。

論文推測,當模型與參考模型相距較遠時,向參考模型進行正則化可能會損害模型在預訓練階段主要獲得生成能力。換句話說,當離線目標中使用的參考模型與當前模型相距甚遠時,模型的離策略行為無法再可預測地描述在線策略生成。論文的發現證實了在擬合偏好數據與維持預訓練階段獲得的生成能力之間的基本權衡[21],并與先前的觀察結果一致,即添加在線策略偏好數據可以使離線學習更有效[48, 63, 23, 51]。

圖片

圖片

圖4:當模型權重未遠離ORef時,排名準確率和勝率同步增加。 表示在檢查點t時的模型權重,而0,表示模型權重轉移

表示在檢查點t時的模型權重,而0,表示模型權重轉移

論文標題:Preference Learning Algorithms Do Not Learn Preference Rankings