Ilya參與,OpenAI給GPT-4搞可解釋,提取了1600萬個特征,還能看它怎么想

大模型都在想什么?OpenAI 找到了一種辦法,能給 GPT-4 做「掃描」,告訴你 AI 的思路,而且還把這種方法開源了。

大語言模型(LLM)是當前 AI 領域最熱門的探索方向,吸引了大量的關注和研究投入。它們強大的語言理解能力和生成能力在各種應用場景中都表現出巨大潛力。雖然我們見證了大模型迭代后性能上的顯著提升,但我們目前對模型中的神經活動仍然只是一知半解。

本周四,OpenAI 分享了一種查找大量「特征」的全新方法 —— 或許這會成為可解釋的一種可用方向。OpenAI 表示,新方法比此前的一些思路更具可擴展性,研究團隊使用它們在 GPT-4 中找到了 1600 萬個特征。

有趣的是,從作者列表中,我們發現已經從 OpenAI 離職的 Ilya Sutskever、Jan Leike 等人也是作者之一。

可謂是一項重要的研究。

- 論文標題:Scaling and evaluating sparse autoencoders

- 論文地址:https://cdn.openai.com/papers/sparse-autoencoders.pdf

- 代碼:https://github.com/openai/sparse_autoencoder

- 特征可視化:https://openaipublic.blob.core.windows.net/sparse-autoencoder/sae-viewer/index.html

解釋神經網絡

作為機器學習模型,神經網絡通過使用模仿生物神經元協同工作的過程來識別現象并得出結論,然而長久以來,我們并不真正了解神經網絡的內部運作原理。神經網絡并不是直接設計的,研究人員設計了訓練它們的算法。由此產生的神經網絡還不能很好地被理解,并且不能輕易地分解為可識別的部分。這意味著我們不能像推理汽車安全那樣推理人工智能安全。

為了理解和解釋神經網絡,首先需要找到用于神經計算的有用構建塊。然而,語言模型內的神經激活是以不可預測的模式激活的,似乎同時代表許多概念,它們還密集激活,這意味著每次激活總是在每個輸入上觸發。

但現實世界的概念非常稀疏 —— 在任何給定的上下文中,所有概念中只有一小部分是相關的。這激發了稀疏自動編碼器的使用。

稀疏自動編碼器(sparse autoencoder)是一種識別神經網絡中少數「特征」的方法,這些「特征」對于產生任何給定的輸出都很重要,類似于一個人在推理某種情況時可能想到的一小部分概念。它們的特征顯示出稀疏的激活模式,自然地與人類易于理解的概念保持一致,即使沒有直接的可解釋性激勵。

然而,訓練稀疏自動編碼器仍然面臨嚴峻的挑戰。大型語言模型表征大量概念,自動編碼器可能需要相應巨大的規模才能接近完全覆蓋前沿模型中的概念。學習大量稀疏特征具有挑戰性,并且過去的工作尚未證明可以很好地擴展。

大規模自動編碼器訓練

OpenAI 最新的研究進展提出了一種新方法,能夠將稀疏自動編碼器擴展到前沿人工智能模型上的數千萬個特征。并且該方法顯示出平滑且可預測的擴展,與現有方法相比具有更好的規模回報。同時,OpenAI 還引入了幾個用于評估特征質量的新指標。

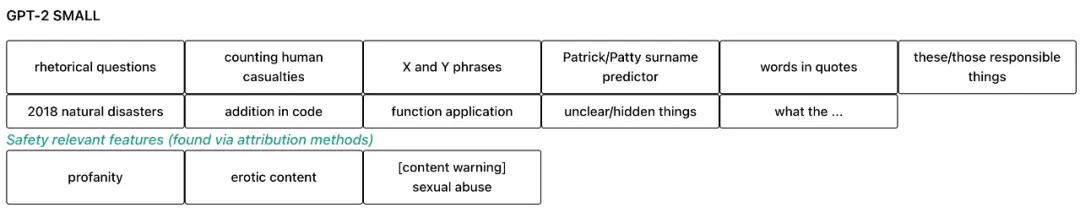

OpenAI 使用該方法在 GPT-2 small 和 GPT-4 激活上訓練各種自動編碼器,包括 GPT-4 上的 1600 萬個特征的自動編碼器。

具體來說,研究團隊在 GPT-2 small 模型和一系列逐步增大的、共享 GPT-4 架構和訓練設置的模型(包括 GPT-4 本身)的殘差流上訓練自動編碼器。他們選擇了靠近網絡末端的一層,該層應包含許多特征,而不專門用于下一個 token 的預測。

所有實驗均使用 64 個 token 的上下文長度。研究團隊先在 dmodel 維度上減去平均值,并將所有輸入歸一化為單位范數(unit norm),然后再傳遞給自動編碼器(或計算重建誤差)。

訓練結束后,研究團隊根據稀疏性 L_0 和重建均方誤差 (MSE) 對自動編碼器進行評估。

為了簡化分析,OpenAI 不考慮學習率預熱或衰減,sweep 小規模的學習率,并推斷大規模的最佳學習率的趨勢。

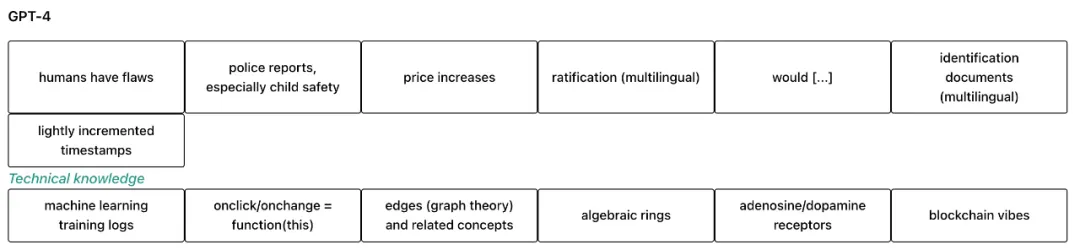

為了檢查特征的可解釋性,OpenAI 進行了可視化工作。以下是 OpenAI 發現的一些可解釋的特征:

- 人類的缺陷;

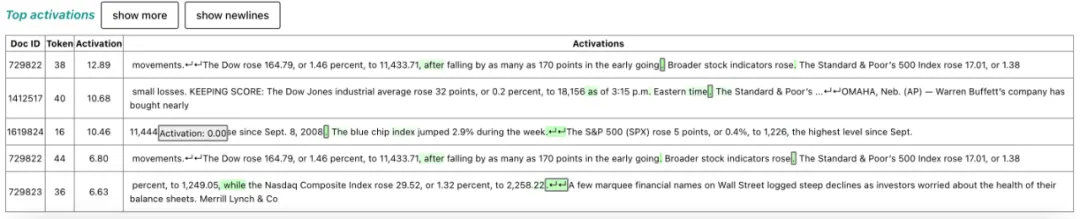

- 價格上漲;

- X 和 Y;

- 訓練 Log;

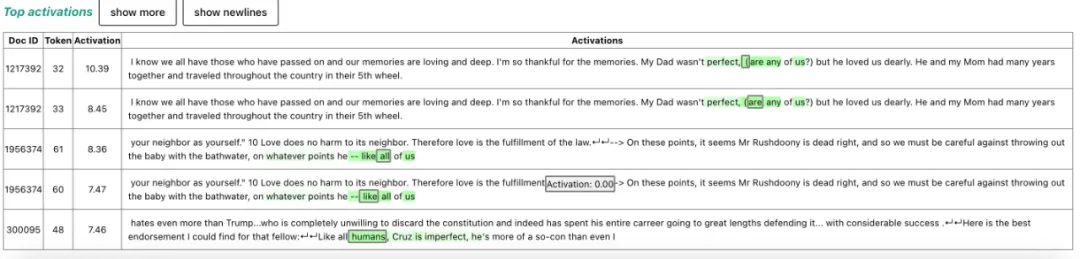

- 反問句;

- 代數環;

- 誰 / 什么;

- 多巴胺。

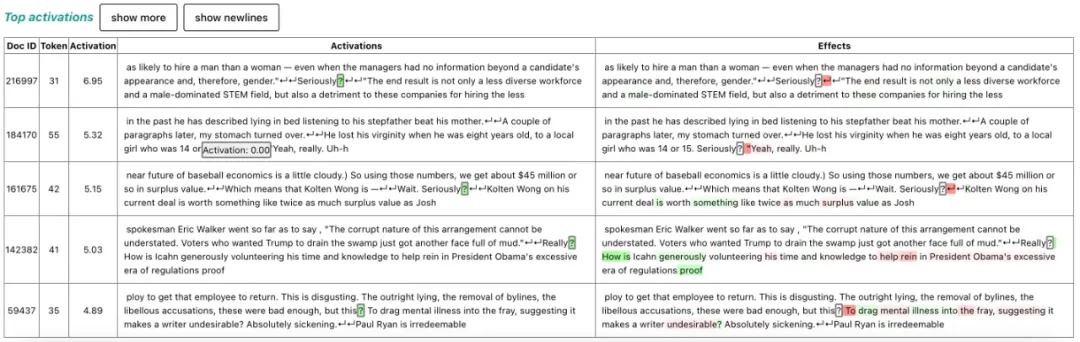

例如,GPT-4 特征:與事物(尤其是人類)有缺陷相關的短語:

價格上漲:

反問句:

局限和發展方向

新方法能夠提高模型的可信度和可操縱性。然而這仍是早期工作,存在許多局限性:

- 與此前的研究一樣,許多發現的特征仍然難以解釋,許多特征的激活沒有明確的模式,或者表現出與它們通常編碼的概念無關的虛假激活。此外,目前我們還沒有很好的方法來檢查解釋的有效性。

- 稀疏自動編碼器不會捕獲原始模型的所有行為。目前,將 GPT-4 的激活通過稀疏自動編碼器大致相當于使用大約 1/10 計算量訓練一個模型。為了完全映射前沿 LLM 中的概念,我們可能需要擴展到數十億或數萬億個特征,即便使用改進的擴展技術,這也具有挑戰性。

- 稀疏自動編碼器可以在模型中的某一點找到特征,但這只是解釋模型的一步。還需要做更多的工作來了解模型如何計算這些特征以及如何在模型的其余部分下游使用這些特征。

稀疏自動編碼器的研究令人興奮,OpenAI 表示,還有一些待解決的挑戰。短期內,工程師們希望新發現的特征能夠實際用于監控和控制語言模型行為,并計劃在前沿模型中對此進行測試。希望最終有一天,可解釋性可以為我們提供推理模型安全性和穩健性的新方法,并通過對 AI 行為提供強有力的保證,大幅提高我們對新一代 AI 模型的信任。