無需人類或GPT-4打標簽!南大&曠視研究院無監督范式大幅降低視覺大模型對齊成本

不用打標簽,也能解決視覺大模型的偏好對齊問題了。

南大與曠視研究院的研究人員,推出了適用于VLM的無監督范式。

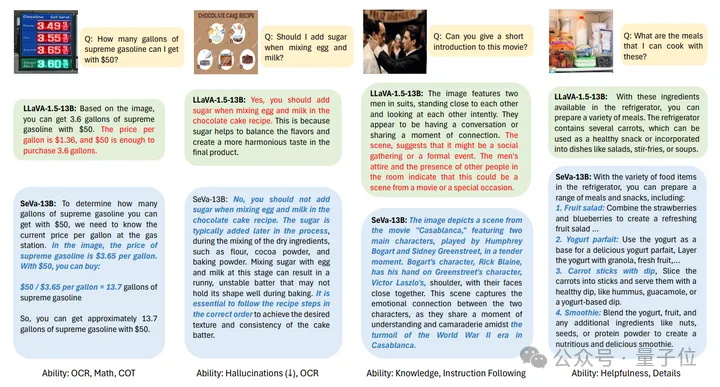

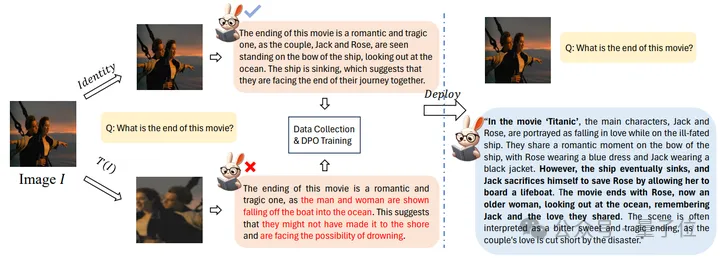

對比偏好對齊前后,可以發現模型的輸出發生了顯著的變化。

目前的視覺大模型已經比較成熟,但作者發現它們在用戶體感方面仍然有所欠缺。

于是團隊經過研究,通過構造偏好樣本對的方式解決了視覺語言模型的偏好對齊問題,并提出了Self-Supervised Visual Preference Alignment(SeVa)范式。

該范式基于LLaVa-1.5-7B/13B完成,整個過程無需GPT-4或者是人類參與打標簽,目前項目已經開源!

構建正負樣本對比數據集

目前視覺大模型基本上在流程上已經非常成熟——預訓練+指導監督微調(SFT)+對齊(可選)。

去年下半年開始,工業界和學術界主要聚焦在多模態大模型的數據(數據構造,配比,打標簽)和模型結構(Connector,打開模型權重等)的設計上,目標是提升VLM的理解能力(傳統QA+多模態benchmark)。

但是,研究團隊發現部分開源大模型,雖然在跑分時有不錯的性能,但在用戶體感方面會比較欠缺——不遵循指令,產生幻覺回答,違背3H準則(helpfulness, harmless, honest)等問題紛紛出現。

研究團隊認為,多模態對齊的一大難點,在于偏好數據的構造。

主要的原因是,純NLP領域的偏好數據非常昂貴且稀缺(一般需要GPT-4或者人類的參與),Vision-Language領域的偏好數據還沒有形成一個成熟的pipeline(數據構造方式,數據質量,數據的效果都還沒完全得到驗證)。

因此,本文首次提出一套自動化構造偏好數據的pipeline用于Alignment的訓練。作者通過嚴格的實驗,從多個角度展示了該pipeline對多模理解和用戶友好性的提升。

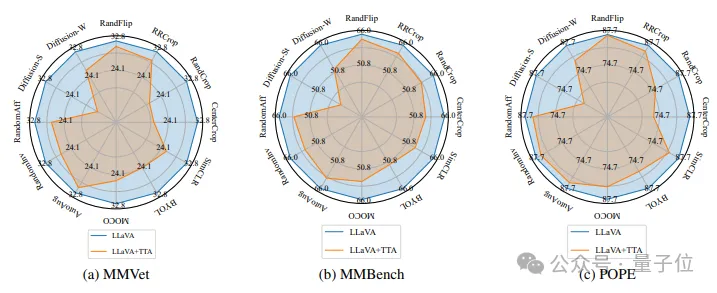

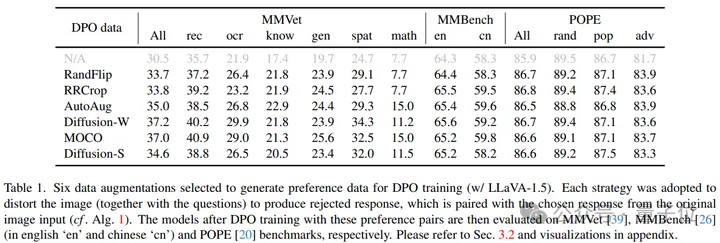

研究當中,作者發現VLM對于圖像層面的擾動非常敏感,也就是說,輕微的圖像增廣就會使得VLM對同一個Question產生錯誤且不同的回答。

具體來說,作者將多種圖像層面的擾動分別作用于LLaVA-1.5的測試階段,并在3個常規的多模態benchmark上運行,得到的結果如下:

因此SeVa將原始圖像產生的回答作為正樣本,將增廣后的圖像產生的回答作為負樣本,用于構造DPO的數據集并訓練。

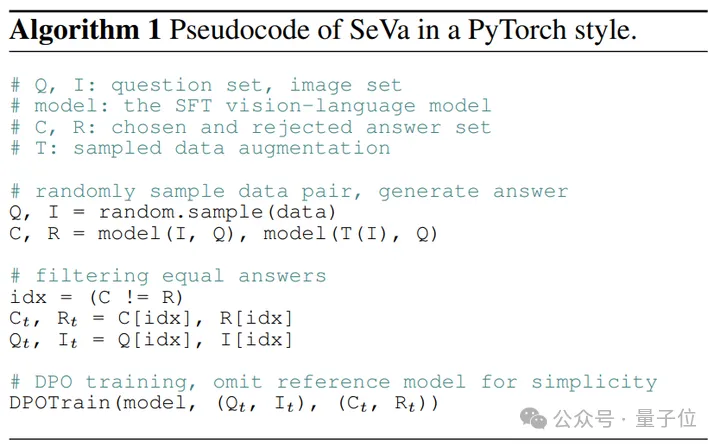

△SeVa的6行偽代碼實現

如果以流程圖的形式來展示,SeVa的工作流如下:

具體來說,作者使用LLaVA665k 數據集中的TextVQA和OCRVQA來構造DPO數據,基于7B和13B的LLaVA-v1.5模型,使用其pretrained+SFT作為DPO的初始化權重,結合LoRA訓練語言模型,r默認在512/1024。

實驗結果表明,僅僅使用8k構造的無監督的數據能夠顯著提高VLM的指令遵循能力、降低幻覺,并且在多模態等benchmark上提升明顯。

而且構造過程輕而易舉、成本低廉,不需要任何人類或者是GPT-4的標注。

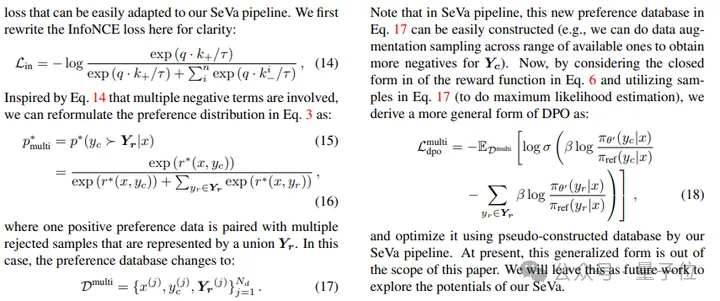

另外,作者還系統闡述了在DPO訓練中用到的偏好分布與對比損失之間的關系。他們的形式在一定程度上是一致的,但是核心區別在于負樣本的定義。

和對比學習統一之后的好處是,可以輕易的通過對比學習的思路,在DPO中添加更多由SeVa構建的負樣本對,從而推導出一個更加通用的DPO形式。

讓視覺模型更符合人類偏好

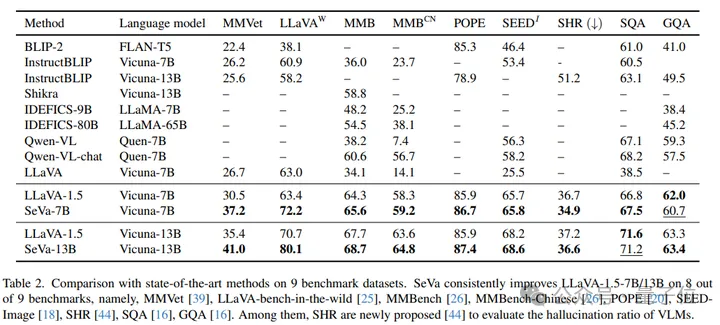

在9個benchmark上,SeVa幾乎都能夠做到穩定的提升,特別是在GPT-4評估的MMVet,和LLaVA-bench上提升顯著,在用于評估幻覺的指標POPE、SHR上也有穩定的性能提升。

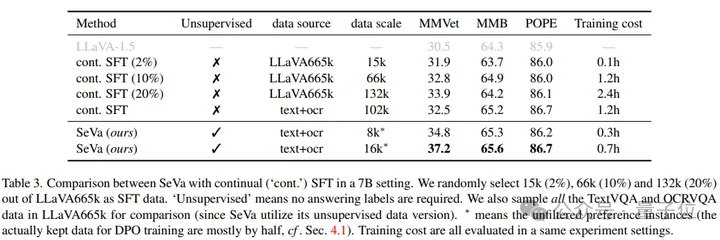

進一步實驗表明,SeVa DPO的范式比SFT在微調VLM上具有更大的優勢,例如訓練時間更短、數據量更少、pipeline無需監督等,另外再性能上也有所提升。

換句話說,該實驗也證明了Preference Alignment在某些情況會遠遠超過SFT的效率。

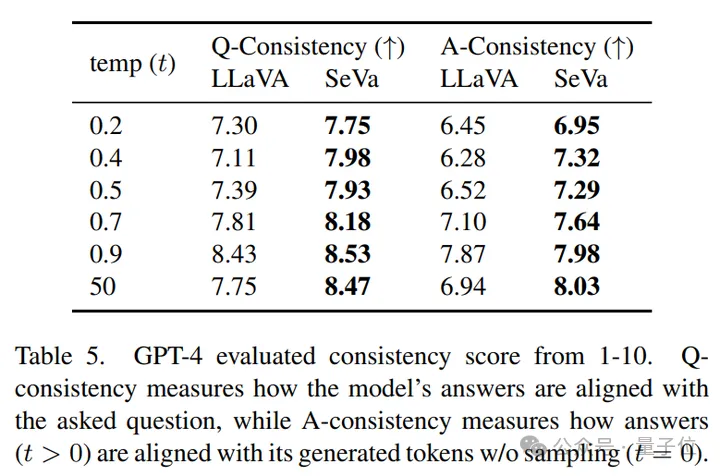

而且,經過DPO之后,SeVa的輸出會更加的與模型得到的Question更加的接近。

同時,SeVa每次回答的一致性也更高,對于不同temperature的擾動擁有更強的魯棒性。

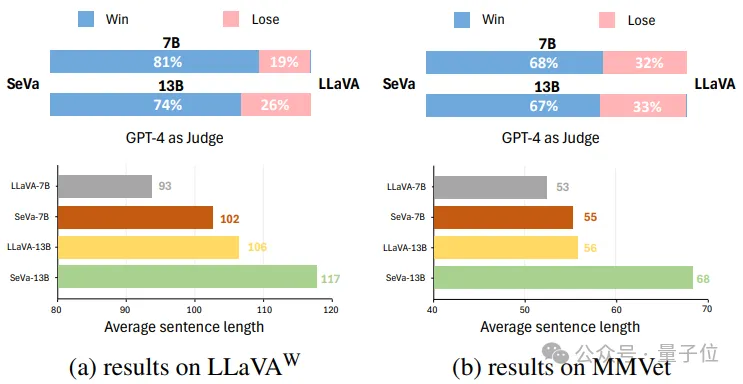

通過可視化,作者還發現,SeVa的輸出結果比原始LLaVA(未經過DPO訓練)更加的優質(在win-lose的比例上明顯占優)。

同時,經過DPO之后,SeVA產生了普遍比LLaVA更長更詳細的回答。以上兩個方面的可視化也解釋了為什么SeVa能夠更加的與人類的偏好對齊。

另外,本文還進行了諸多關于SeVa的細化和分析,有很多有意思的結論:

- SeVa能夠被視作一種特殊的對比學習方法。

- SeVa構造的數據進行DPO訓練后,模型會產生更長token的輸出,并且抗干擾能力更強。

- 正負樣本之間的margin很重要,過大或過小都會sup-optimal。

- 對齊過程中的LoRA參數非常關鍵。

論文地址:https://arxiv.org/abs/2404.10501

GitHub:https://github.com/Kevinz-code/SeVa