拋棄視覺編碼器,這個(gè)「原生版」多模態(tài)大模型也能媲美主流方法

一作刁海文,是大連理工大學(xué)博士生,導(dǎo)師是盧湖川教授。目前在北京智源人工智能研究院實(shí)習(xí),指導(dǎo)老師是王鑫龍博士。他的研究興趣是視覺與語言,大模型高效遷移,多模態(tài)大模型等。共同一作崔玉峰,畢業(yè)于北京航空航天大學(xué),是北京智源人工智能研究院視覺中心算法研究員。他的研究興趣是多模態(tài)模型、生成模型和計(jì)算機(jī)視覺,主要工作有 Emu 系列。

近期,關(guān)于多模態(tài)大模型的研究如火如荼,工業(yè)界對此的投入也越來越多。國外相繼推出了炙手可熱的模型,例如 GPT-4o (OpenAI)、Gemini(Google)、Phi-3V (Microsoft)、Claude-3V(Anthropic),以及 Grok-1.5V(xAI)等。與此同時(shí),國內(nèi)的 GLM-4V(智譜 AI)、Step-1.5V(階躍星辰)、Emu2(北京智源)、Intern-VL(上海 AI 實(shí)驗(yàn)室)、Qwen-VL(阿里巴巴)等模型百花齊放。

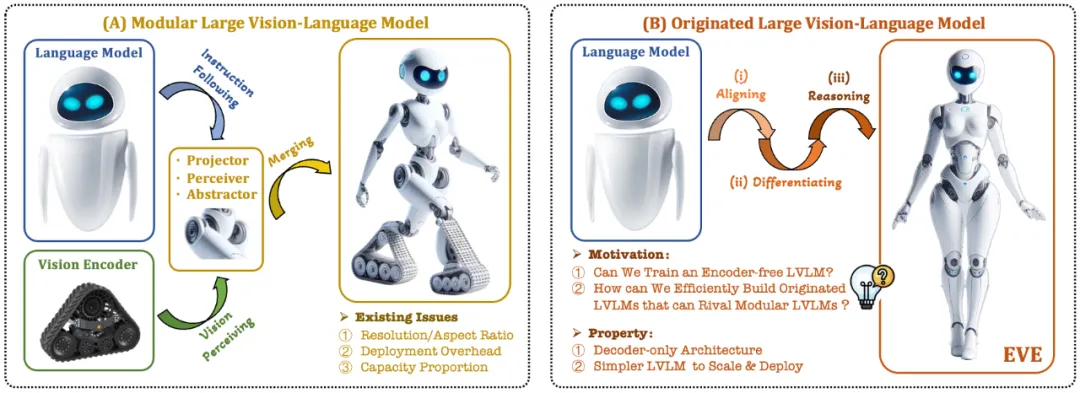

當(dāng)前的視覺語言模型(VLM)通常依賴視覺編碼器(Vision Encoder, VE)來提取視覺特征,再結(jié)合用戶指令傳入大語言模型(LLM)進(jìn)行處理和回答,主要挑戰(zhàn)在于視覺編碼器和大語言模型的訓(xùn)練分離。這種分離導(dǎo)致視覺編碼器在與大語言模型對接時(shí)引入了視覺歸納偏置問題,例如受限的圖像分辨率和縱橫比,以及強(qiáng)烈的視覺語義先驗(yàn)。隨著視覺編碼器容量的不斷擴(kuò)大,多模態(tài)大模型在處理視覺信號時(shí)的部署效率也受到極大限制。此外,如何找到視覺編碼器和大語言模型的最佳容量配置,也變得越來越具有復(fù)雜性和挑戰(zhàn)性。

在此背景下,一些更加前沿的構(gòu)想迅速浮現(xiàn):

- 能否去除視覺編碼器,即直接構(gòu)建無視覺編碼器的原生多模態(tài)大模型?

- 如何高效且絲滑地將大語言模型演變?yōu)闊o視覺編碼器的原生多模態(tài)大模型?

- 如何彌合無編碼器的原生多模態(tài)框架和基于編碼器的主流多模態(tài)范式的性能差距?

Adept AI 在 2023 年末發(fā)布了 Fuyu 系列模型并做出了一些相關(guān)嘗試,但在訓(xùn)練策略、數(shù)據(jù)資源和設(shè)備信息方面沒有任何披露。同時(shí),F(xiàn)uyu 模型在公開的視覺文本評測指標(biāo)上與主流算法存在顯著的性能差距。同期,我們進(jìn)行的一些先導(dǎo)試驗(yàn)顯示,即使大規(guī)模拉升預(yù)訓(xùn)練數(shù)據(jù)規(guī)模,無編碼器的原生多模態(tài)大模型仍面臨收斂速度慢和性能表現(xiàn)差等棘手問題。

針對這些挑戰(zhàn),智源研究院視覺團(tuán)隊(duì)聯(lián)合大連理工大學(xué)、北京大學(xué)等國內(nèi)高校,推出了新一代無編碼器的視覺語言模型 EVE。通過精細(xì)化的訓(xùn)練策略和額外的視覺監(jiān)督,EVE 將視覺 - 語言表征、對齊和推理整合到統(tǒng)一的純解碼器架構(gòu)中。使用公開數(shù)據(jù),EVE 在多個(gè)視覺 - 語言基準(zhǔn)測試中表現(xiàn)出色,與類似容量的基于編碼器的主流多模態(tài)方法相媲美,并顯著優(yōu)于同類型 Fuyu-8B。EVE 的提出旨在為純解碼器的原生多模態(tài)架構(gòu)發(fā)展提供一條透明且高效的路徑。

- 論文地址: https://arxiv.org/abs/2406.11832

- 項(xiàng)目代碼: https://github.com/baaivision/EVE

- 模型地址: https://huggingface.co/BAAI/EVE-7B-HD-v1.0

1. 技術(shù)亮點(diǎn)

- 原生視覺語言模型:打破了主流的多模態(tài)模型的固定范式,去除視覺編碼器,可處理任意圖像長寬比。在多個(gè)視覺語言基準(zhǔn)測試中顯著優(yōu)于同類型的 Fuyu-8B 模型,并接近主流的基于視覺編碼器的視覺語言架構(gòu)。

- 數(shù)據(jù)和訓(xùn)練代價(jià)少: EVE 模型的預(yù)訓(xùn)練僅篩選了來自 OpenImages、SAM 和 LAION 的公開數(shù)據(jù),并利用了 66.5 萬條 LLaVA 指令數(shù)據(jù)和額外的 120 萬條視覺對話數(shù)據(jù),分別構(gòu)建了常規(guī)版本和高分辨版本的 EVE-7B。訓(xùn)練在兩個(gè) 8-A100 (40G) 節(jié)點(diǎn)上約需 9 天完成,或者在四個(gè) 8-A100 節(jié)點(diǎn)上約需 5 天完成。

- 透明和高效的探索: EVE 嘗試探索一條高效、透明且實(shí)用的路徑通往原生視覺語言模型,為開發(fā)新一代純解碼器的視覺語言模型架構(gòu)提供全新的思路和寶貴的經(jīng)驗(yàn),為未來多模態(tài)模型的發(fā)展開辟新的探索方向。

2. 模型結(jié)構(gòu)

首先,通過 Vicuna-7B 語言模型進(jìn)行初始化,使其具備豐富的語言知識和強(qiáng)大的指令跟隨能力。在此基礎(chǔ)上,去除深度視覺編碼器,構(gòu)建輕量級視覺編碼層,高效無損地編碼圖像輸入,并將其與用戶語言命令輸入到統(tǒng)一的解碼器中。此外,通過視覺對齊層與通用的視覺編碼器進(jìn)行特征對齊,強(qiáng)化細(xì)粒度的視覺信息編碼和表征。

2.1 Patch Embedding Layer

- 首先使用單層卷積層來獲取圖像的 2D 特征圖,然后通過平均池化層進(jìn)行下采樣;

- 使用交叉注意力模塊(CA1)在限定感受野中交互,增強(qiáng)每個(gè) patch 的局部特征;

- 使用 < CLS> token 并結(jié)合交叉注意力模塊(CA2),為后續(xù)每個(gè) patch 特征提供全局信息;

- 在每個(gè) patch 特征行的末尾插入了一個(gè)可學(xué)習(xí)的 < SPL> token,幫助網(wǎng)絡(luò)理解圖像的二維空間結(jié)構(gòu)。

2.2 Patch Aligning Layer

- 記錄有效 patch 的二維形狀;丟棄 < CLS>/<PAD> tokens,并利用自適應(yīng)池化層還原到原始的二維形狀;

- 通過層級交叉注意力模塊(CA3),整合多層網(wǎng)絡(luò)視覺特征,從而實(shí)現(xiàn)與視覺編碼器輸出的細(xì)粒度對齊。

3. 訓(xùn)練策略

- 大語言模型引導(dǎo)的預(yù)訓(xùn)練階段:建立視覺和語言之間的初步聯(lián)系,為后續(xù)穩(wěn)定高效的大規(guī)模預(yù)訓(xùn)練打下基礎(chǔ);

- 生成式預(yù)訓(xùn)練階段:進(jìn)一步提高模型對視覺 - 語言內(nèi)容的理解能力,實(shí)現(xiàn)純語言模型到多模態(tài)模型的絲滑轉(zhuǎn)變;

- 監(jiān)督式的微調(diào)階段:進(jìn)一步規(guī)范模型遵循語言指令和學(xué)習(xí)對話模式的能力,滿足各種視覺語言基準(zhǔn)測試的要求。

- 在預(yù)訓(xùn)練階段,篩選了來自 SA-1B、OpenImages 和 LAION 等 3300 萬公開數(shù)據(jù),僅保留分辨率高于 448×448 的圖像樣本。特別地,針對 LAION 圖像冗余度高的問題,通過在 EVA-CLIP 提取的圖像特征上應(yīng)用 K-means 聚類,生成 50,000 個(gè)聚類,并從中挑選出最接近每個(gè)聚類中心的 300 張圖像,最終選出 1500 萬張 LAION 圖像樣本。隨后,利用 Emu2 (17B)和 LLaVA-1.5 (13B)重新生成高質(zhì)量圖像描述。

- 在監(jiān)督微調(diào)階段,使用 LLaVA-mix-665K 微調(diào)數(shù)據(jù)集來訓(xùn)練得到標(biāo)準(zhǔn)版的 EVE-7B,并整合 AI2D、Synthdog、DVQA、ChartQA、DocVQA、Vision-Flan 和 Bunny-695K 等混合數(shù)據(jù)集來訓(xùn)練得到高分辨率版本的 EVE-7B。

4. 定量分析

EVE 模型在多個(gè)視覺語言基準(zhǔn)測試中明顯優(yōu)于同類型的 Fuyu-8B 模型,并且與多種主流的基于編碼器的視覺語言模型表現(xiàn)相當(dāng)。然而,由于使用大量視覺語言數(shù)據(jù)訓(xùn)練,其在準(zhǔn)確響應(yīng)特定指令方面存在挑戰(zhàn),在部分基準(zhǔn)測試中表現(xiàn)有待提高。令人興奮的是,通過高效的訓(xùn)練策略,可以實(shí)現(xiàn)無編碼器的 EVE 與帶編碼器基礎(chǔ)的視覺語言模型取得相當(dāng)?shù)男阅埽瑥母旧辖鉀Q主流模型在輸入尺寸靈活性、部署效率和模態(tài)容量匹配方面的問題。

相較于帶編碼器的模型易受到語言結(jié)構(gòu)簡化和豐富知識丟失等問題困擾,EVE 表現(xiàn)出隨著數(shù)據(jù)規(guī)模的增加而逐步穩(wěn)定地提升性能,逐漸逼近基于編碼器模型的性能水平。這可能是因?yàn)樵诮y(tǒng)一網(wǎng)絡(luò)中編碼和對齊視覺和語言模態(tài)更具挑戰(zhàn)性,使得無編碼器模型相對于帶編碼器的模型更不容易過擬合。

5. 同行怎么看?

英偉達(dá)高級研究員 Ali Hatamizadeh 表示,EVE 令人耳目一新,嘗試提出全新的敘事,區(qū)別于構(gòu)建繁雜的評測標(biāo)準(zhǔn)和漸進(jìn)式的視覺語言模型改進(jìn)。

谷歌 Deepmind 首席研究員 Armand Joulin 表示,構(gòu)建純解碼器的視覺語言模型令人興奮。

蘋果機(jī)器學(xué)習(xí)工程師 Prince Canuma 表示,EVE 架構(gòu)非常有趣,對 MLX VLM 項(xiàng)目集是一個(gè)很好的補(bǔ)充。

6.未來展望

作為無編碼器的原生視覺語言模型,目前 EVE 取得了令人鼓舞的結(jié)果。沿著這條路徑,未來還有一些有趣的方向值得探索嘗試:

- 進(jìn)一步的性能提升:實(shí)驗(yàn)發(fā)現(xiàn),僅使用視覺 - 語言數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練顯著地降低了模型的語言能力(SQA 得分從 65.3% 降至 63.0%),但逐步提升了模型的多模態(tài)性能。這表明在大語言模型更新時(shí),內(nèi)部存在語言知識的災(zāi)難性遺忘。建議適當(dāng)融合純語言的預(yù)訓(xùn)練數(shù)據(jù),或采用專家混合(MoE)策略來減少視覺與語言模態(tài)間干擾。

- 無編碼器架構(gòu)的暢想:通過恰當(dāng)策略和高質(zhì)量數(shù)據(jù)的訓(xùn)練,無編碼器視覺語言模型可以與帶編碼器的模型相匹敵。那么在相同的模型容量和海量的訓(xùn)練數(shù)據(jù)下,二者性能如何?我們推定通過擴(kuò)大模型容量和訓(xùn)練數(shù)據(jù)量,無編碼器架構(gòu)是能夠達(dá)到甚至超越基于編碼器架構(gòu),因?yàn)榍罢邘缀鯚o損地輸入圖像,避開了視覺編碼器的先驗(yàn)偏置。

- 原生多模態(tài)的構(gòu)建: EVE 完整地展現(xiàn)了如何高效穩(wěn)定地構(gòu)建原生多模態(tài)模型,這為之后整合更多模態(tài)(如音頻、視頻、熱成像、深度等)開辟了透明和切實(shí)可行的道路。核心思想是在引入大規(guī)模統(tǒng)一訓(xùn)練之前,先通過凍結(jié)的大語言模型對這些模態(tài)進(jìn)行預(yù)對齊,并利用相應(yīng)的單模態(tài)編碼器和語言概念對齊進(jìn)行監(jiān)督。