Mamba寫代碼真的超越Transformer!原始論文入選頂流新會議

“歐洲OpenAI”和“Transformer挑戰(zhàn)者”強強聯(lián)合了!

Mistral AI剛剛推出了其第一個基于Mamba2架構(gòu)的開源模型——Codestral Mamba(7B),專搞代碼生成。

與Transformer架構(gòu)不同,Mamba架構(gòu)可進(jìn)行“線性時間推理”,理論上能夠支持無限長度輸入。

Mistral AI:這也就是為啥我們用Mamba架構(gòu)推出的代碼推理模型抗打。

Mistral AI表示已經(jīng)在最多256k token上下文中測試了Codestral Mamba。

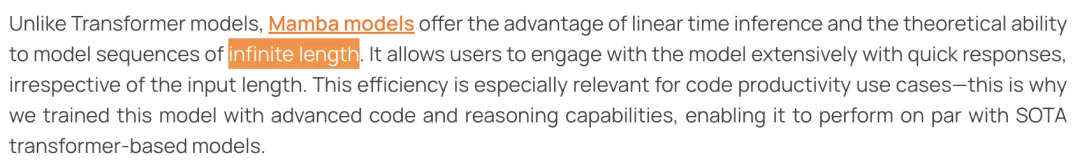

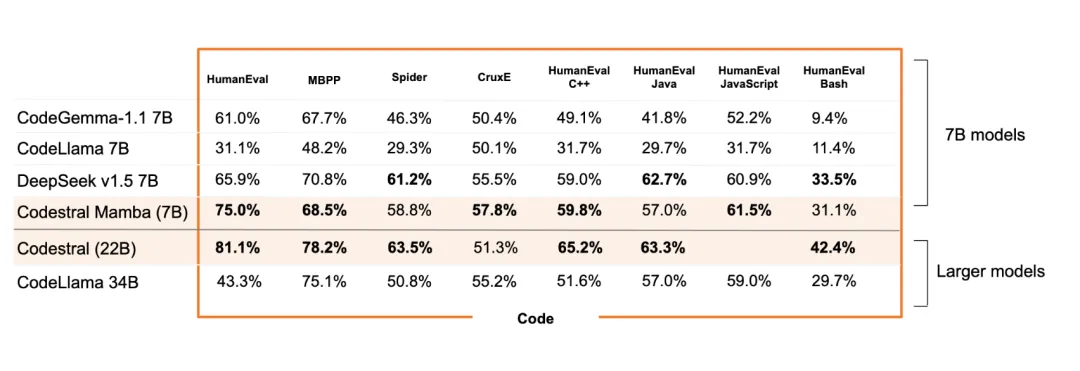

基準(zhǔn)測試中,Codestral Mamba總體性能超越CodeGemma-1.1 7B、CodeLlama 7B、DeepSeek v1.5 7B、CodeLlama 34B。

有網(wǎng)友表示,這一波是Mistral AI要帶飛Mamba架構(gòu)的節(jié)奏。

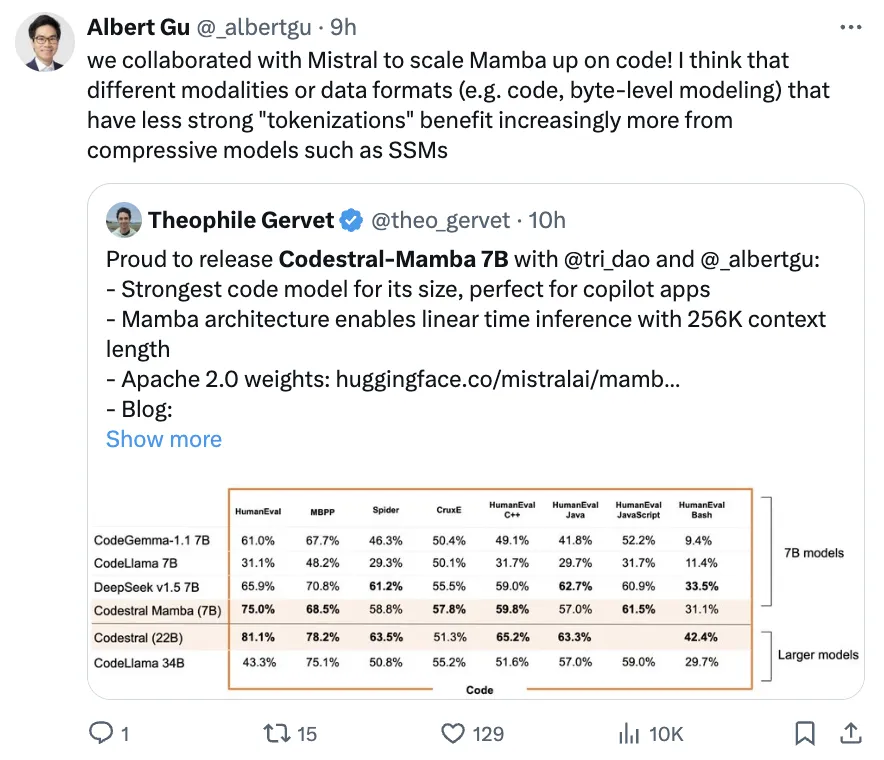

Mamba架構(gòu)作者之一、CMU助理教授Albert Gu表示:

具有較弱“tokenizations”的不同模態(tài)或數(shù)據(jù)格式(例如代碼、byte級建模)會越來越多地從壓縮模型(如SSM)中受益。

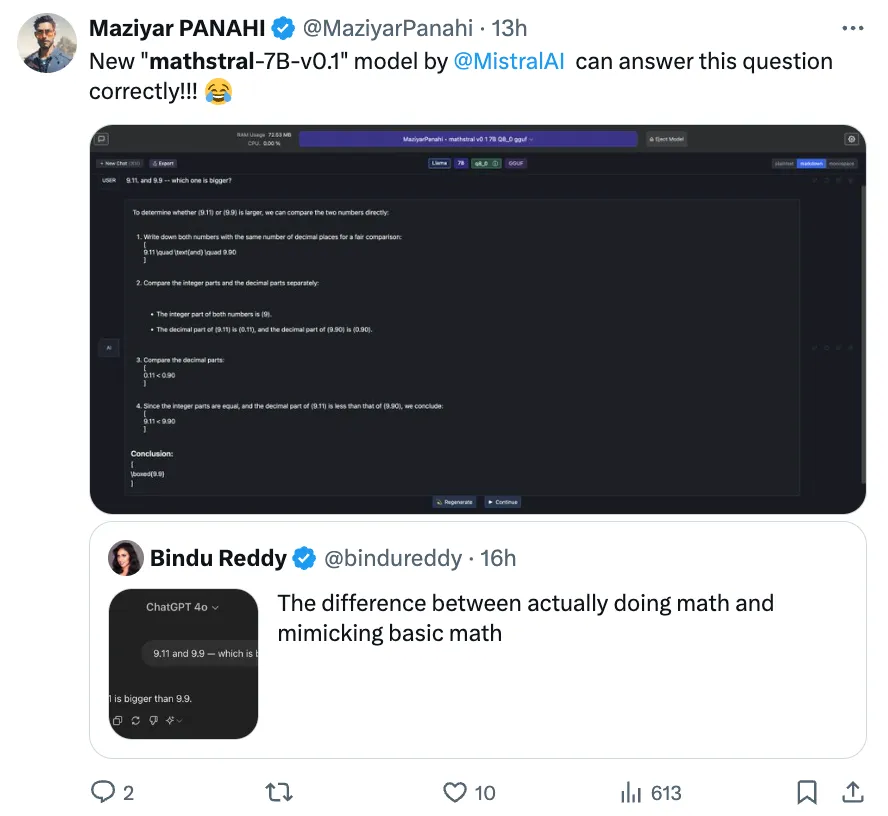

除了Codestral Mamba,Mistral AI這次還同時發(fā)布了一個新的數(shù)學(xué)模型——Mathstral(7B)。

有意思的是,網(wǎng)友讓它做這幾天大模型頻頻翻車的“9.11和9.9哪個大”的問題,Mathstral先比較整數(shù),然后再比較小數(shù)部分,最后成功做對。

7B性能接近22BTransformer

Codestral Mamba完整基準(zhǔn)測試結(jié)果如下:

在HumanEval C++/Java/JavaScript/Bash等所有基準(zhǔn)上,Codestral Mamba全面超越CodeGemma-1.1 7B、CodeLlama 7B,且超越比它更大的CodeLlama 34B。

Mistral AI此前自家的最強開源編程模型Codestral 22B也沒有和Codestral Mamba拉開太大差距。

除此外,DeepSeek v1.5 7B在基準(zhǔn)中也比較突出,和Codestral Mamba打得有來有回。

DeepSeek v1.5 7B在Spider(復(fù)雜跨域語義分析和文本到SQL任務(wù))、HumanEval Java、HumanEval Bash、MBPP等方面優(yōu)于Codestral Mamba。

除了基準(zhǔn)測試結(jié)果,Codestral Mamba最令人關(guān)注的當(dāng)屬它是首批Mamba2架構(gòu)模型。

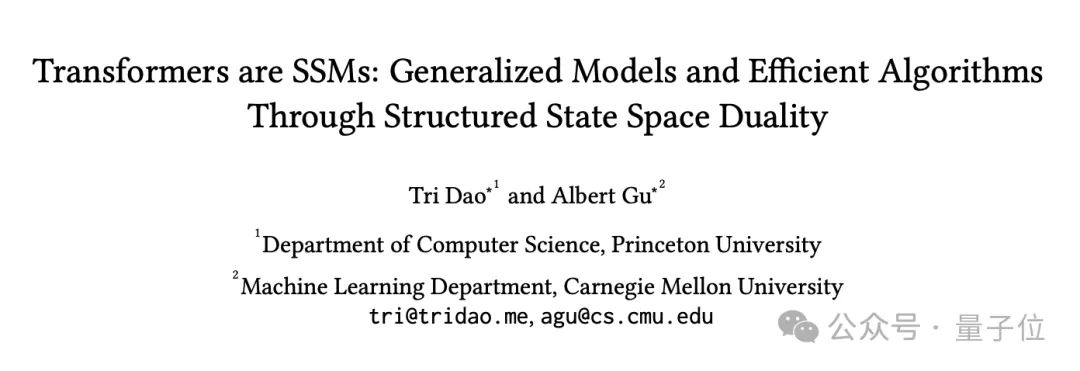

Mamba架構(gòu)由FlashAttention作者Tri Dao和CMU助理教授、Cartesia AI聯(lián)合創(chuàng)始人及首席科學(xué)家Albert Gu在去年年底提出。

此前,ChatGPT等Transformer架構(gòu)大模型有一大痛點:處理長文本算力消耗巨大。其背后也是因為Transformer架構(gòu)中注意力機制的二次復(fù)雜度。

而Mamba是第一個真正實現(xiàn)匹配Transformer性能的線性時間序列模型,也是一種狀態(tài)空間模型(SSM,State Space Model)。

Mamba建立在更現(xiàn)代的適用于深度學(xué)習(xí)的結(jié)構(gòu)化SSM(S4, Structured SSM)基礎(chǔ)上,與經(jīng)典架構(gòu)RNN有相似之處。

主要有三點創(chuàng)新:對輸入信息有選擇性處理、硬件感知的算法、更簡單的架構(gòu)。

Mamba架構(gòu)一問世就引起了圈內(nèi)廣泛關(guān)注。Stability AI創(chuàng)始人、英偉達(dá)科學(xué)家Jim Fan等都對它的出現(xiàn)感到興奮。

Mamba初代論文年初被ICLR拒稿,當(dāng)時在圈內(nèi)引起熱議。

不過,最近已經(jīng)被新生代頂流會議CoLM2024接收了。

Mamba2是其二代,狀態(tài)空間擴大8倍,訓(xùn)練速度提高50%。

Mamba2論文中更是發(fā)現(xiàn),Transformer中的注意力機制與SSM存在著非常緊密的數(shù)學(xué)聯(lián)系,論文成功入選ICML 2024。

還發(fā)布了一個數(shù)學(xué)模型

除了Codestral Mamba,Mistral AI還同時推出了一個開源數(shù)學(xué)模型——Mathstral(7B),作為對阿基米德誕生2311周年的紀(jì)念。

Mathstral在Mistral 7B基礎(chǔ)之上,專注于STEM(科學(xué)、技術(shù)、工程、數(shù)學(xué)),上下文窗口32k。

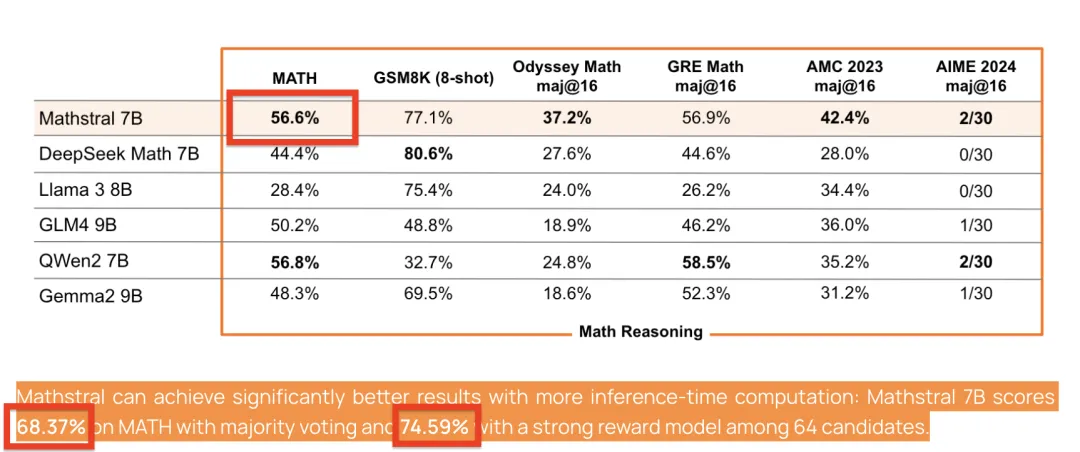

在基準(zhǔn)測試中,Mathstral MATH得分56.6%,MMLU達(dá)到了63.47%。

重點是,Mathstral還可以通過更多的推理時間計算獲得更好的結(jié)果:

使用多數(shù)投票機制時,Mathstral 7B在MATH測試中的得分為68.37%,而在64個候選模型中應(yīng)用一個強效獎勵模型時,得分能夠提升到74.59%。

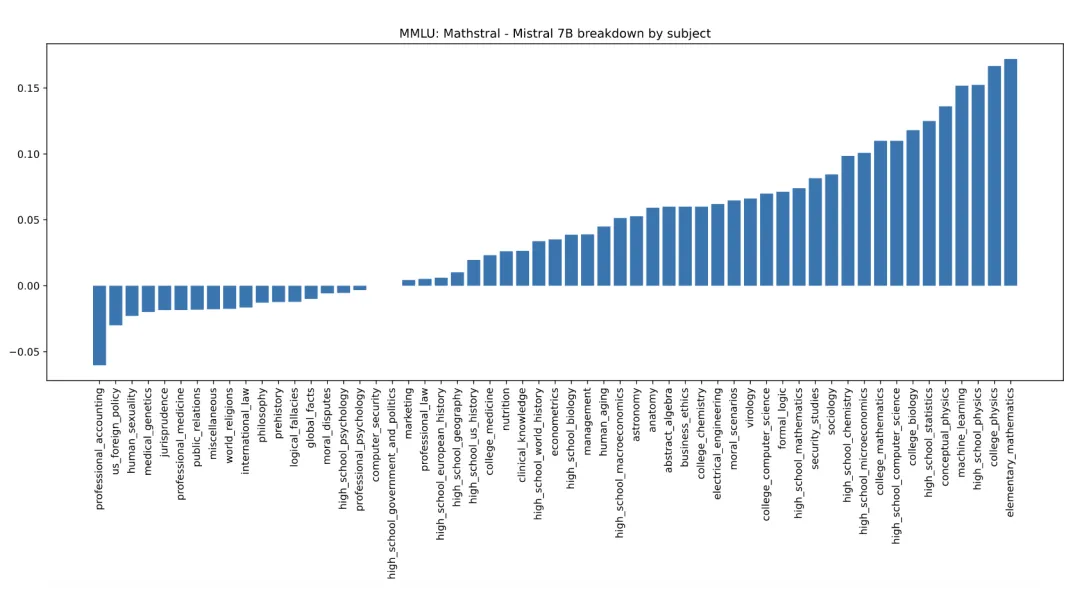

以下是Mathstral 7B和Mistral 7B在MMLU各科目中的表現(xiàn)差異:

參考鏈接:

[1]https://mistral.ai/news/codestral-mamba/。

[2]https://mistral.ai/news/mathstral/。

[3]https://x.com/MistralAI/status/1813222156265791531。

[4]https://x.com/GuillaumeLample/status/1813231491154899012。

[5]https://x.com/theo_gervet/status/1813226968600469824。

[6]https://x.com/tuturetom/status/1813238885453033540。

[7]https://x.com/WenhuChen/status/1812562112524226569。