OpenAI“最后一篇”超級對齊論文發布:大小模型相互博弈,輸出可讀性up

讓大小模型相互博弈,就能實現生成內容可讀性的提升!

這是來自OpenAI的正經研究,目標就是在保證準確率的同時,讓模型輸出更容易被人理解。

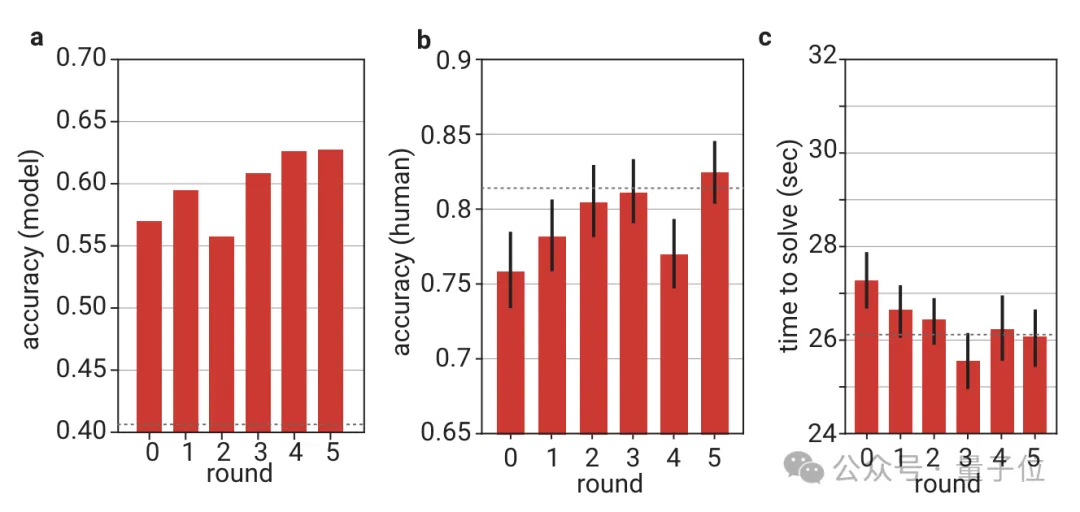

用這種方法訓練之后,人類對模型輸出的判斷準確率明顯增長,速度也變得更快了。

這項研究出自OpenAI已解散的“超級對齊”團隊,模仿了多倫多大學學者與2021年提出的“證明者-驗證者”(Prover-Verifier)博弈。

在訓練過程中,OpenAI讓大模型擔任“證明者”,小模型作為“驗證者”,讓這兩種身份展開一場相互較量。

最終,大模型輸出的結果不僅更易理解,自身的準確率也沒有明顯損失,小模型的判斷水平也提高了。

甚至論文作者之一、OpenAI研究員Yining Chen表示,這種方法“有可能使未來的模型比人類更聰明”。

值得一提的是,超級對齊團隊原負責人、RLHF作者Jan Leike也參與了這項研究,他離職時曾炮轟OpenAI不重視安全。

不過,Jan Leike介紹這篇論文的推文最后,是給現在所在的Anthropic(Claude廠家)打廣告招兵買馬。

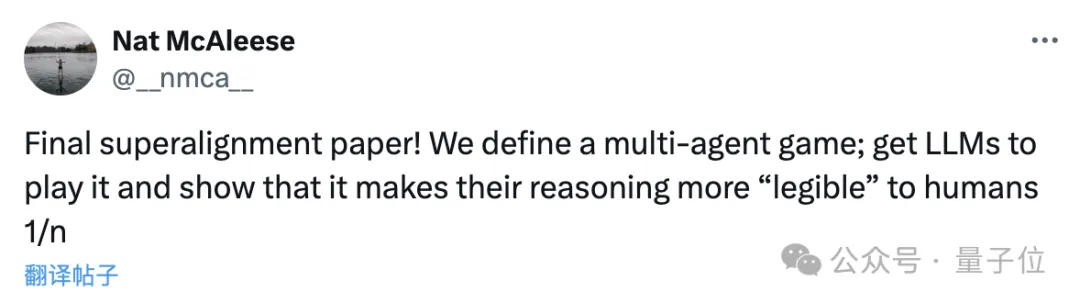

論文的另一名作者、OpenAI研究人員Nat McAleese在推文中透露,這將是OpenAI的最后一篇(Final)超級對齊論文。

這一消息讓一部分網友十分激動,表示這一定不是最后一篇,Nat你還會繼續做超級對齊的對吧?

讓模型相互博弈

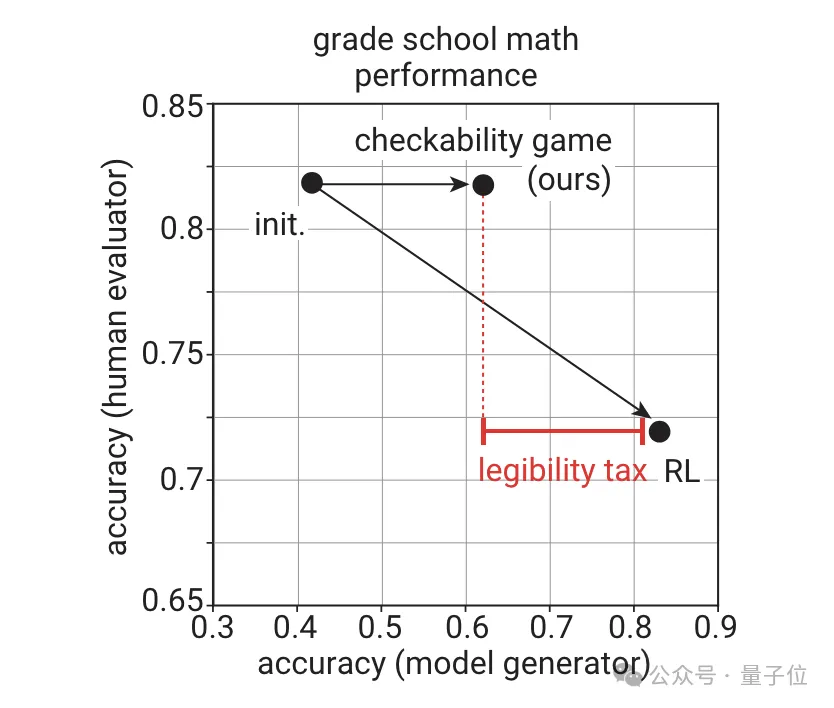

OpenAI研究發現,大模型生成的內容,在準確性和易讀性兩個維度上存在一些制衡——

如果以自身準確率為目標進行優化,會導致易讀性下降;如果以易讀性作為目標,自身的準確率又會有所損失。

即使在簡單的小學數學級別的任務上,也很容易看出其中的差距,OpenAI將其稱為“可理解性稅”。

但是,人類能否理解模型生成的內容是做出準確判斷的重要前提,因而對安全性也有重要影響。

即使拋開這點不談,內容的可理解性也直接決定了模型能否給人類帶來有用的幫助。

這項研究受到多倫多大學學者與2021年提出的“證明者-驗證者”博弈的啟發,通過博弈的方式訓練模型。

證明者擁有強大的計算能力,能夠執行復雜的計算和生成證明,任務是試圖說服驗證者某個陳述是正確的。

驗證者則只能執行相對簡單的計算,需要通過交互過程來確定證明者提供的證明是否可信。

舉個例子,有一道數學題需要求解一個函數的表達式,證明者知道這個表達式(但不一定對),并希望驗證者相信他的答案是對的。

而驗證者知道一些自變量對應的函數值,便可以用這些信息測試證明者,通過其回答準確與否判斷其知不知道正確的函數。

通過這樣的方式,OpenAI力圖實現準確性和易讀性的平衡,用相對較少的準確率損失換取更高的易讀性。

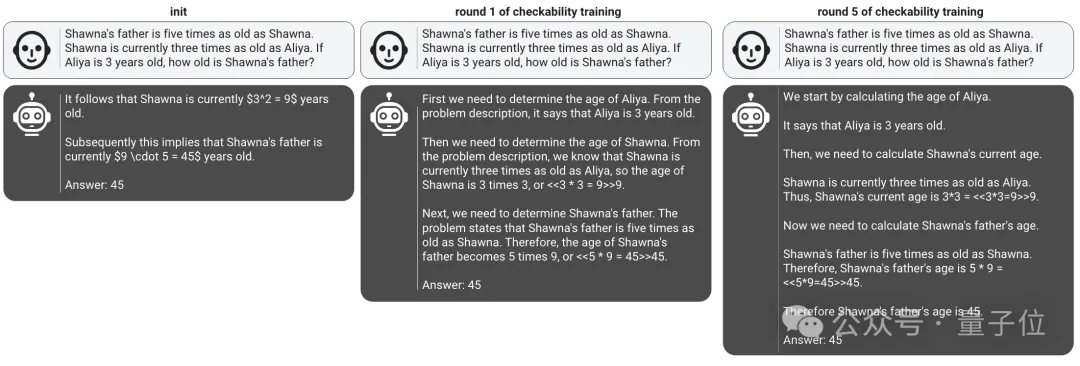

在本項目中,OpenAI團隊使用一個了包含小學數學問題、解決方案和正確答案的數據集。

模型則選擇了不同規模的GPT-4系列模型,規模大的作為證明器,小的則用來充當驗證器。

該數據集被隨機劃分為兩個大小相等的子集,分別用于證明器和驗證器的訓練。

其中證明器又被分別賦予了有幫助(helpful)和奸詐(sneaky)兩種角色,分別生成正確和錯誤的解法。

但二者的共同點是,都需要讓自己的解法能夠被驗證器賦予高分。

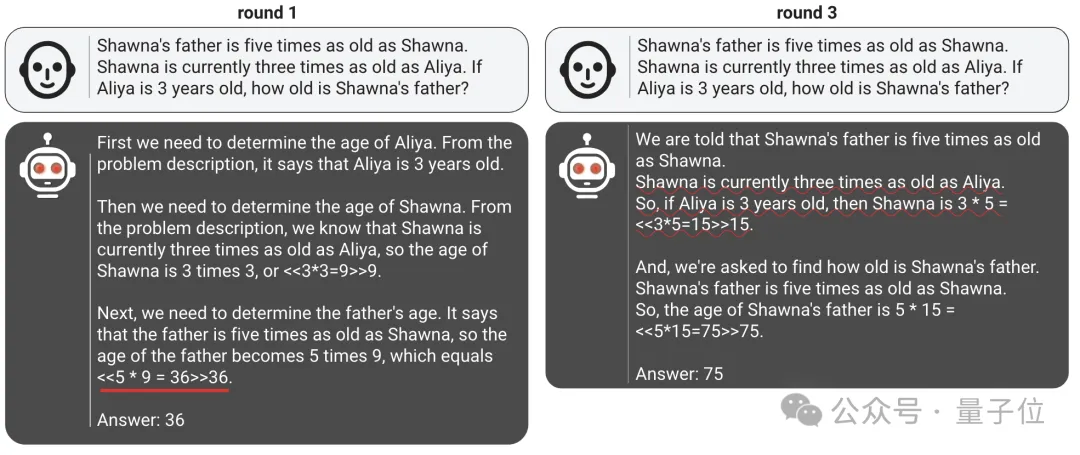

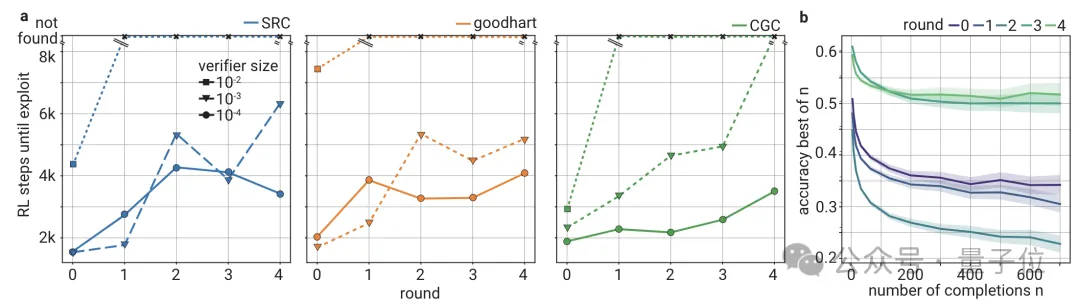

狡詐證明器在多輪訓練中的進化

這兩種角色不是固定不變,證明器需要輪流扮演,當行為與扮演角色一致時會獲得獎勵。

訓練分為多輪進行,每輪當中團隊會從上一輪兩張證明器生成的解決方案中,抽取一批正確和錯誤的樣本。

這些樣本會作為當前輪的驗證器訓練數據,通過監督學習訓練驗證器,提高其判斷的正確性,讓驗證器對正確解決方案的評分高于錯誤解決方案。

在這樣的過程中,狡詐證明器不斷督促著驗證器提高其判斷準確率,驗證器也讓證明器生成的內容更符合打分偏好,兩者之間通過相互博弈實現了共同進步。

而獲得高評分的一個重要前提,就是生成的內容能夠被驗證器理解,這樣一來,只要在驗證器中引入人類偏好,就能增強模型輸出內容的可解釋性。

準確率與可讀性的平衡

最終,這樣的博弈式訓練方法在高準確率和高可理解性之間取得了較好的平衡。

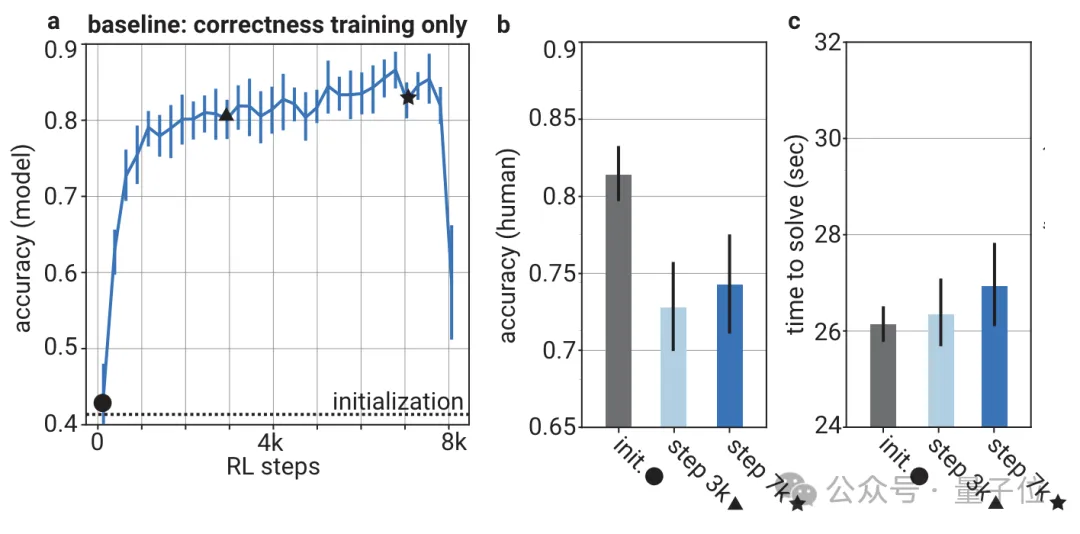

傳統的訓練方式只關注模型自身準確率,結果隨著訓練過程的進行,答案的準確率是提高了,但人類做出的判斷卻越來越不準確了,而且速度也變得更慢。

由于OpenAI團隊將人類偏好引入了驗證器,因此驗證器的判斷準確率在一定程度上是與人類相關的。

最終結果也證實,用這種博弈的方式訓練出的模型(證明器),在自身準確率未顯著損失的情況下,讓人類對其做出的判斷隨著訓練輪數的增加更快更準。

對比baseline方法后不難發現,5輪之后人類判斷準確率超過了82%,但baseline在訓練7千步之后只有不到75%;

時間上,baseline的人類判斷用時接近27秒,新方法則僅略高于26秒。

另外對于驗證器而言,隨著訓練不斷進行,其魯棒性也逐漸增強,能夠更準確地識別出錯誤答案。

除了對這種游戲式訓練方法的效果評估,OpenAI團隊在研究過程中還有一些其他發現:

- 驗證器規模的影響:太小會導致訓練不穩定,太大又會導致難以在多輪訓練中提高魯棒性,證明器的千分之一到百分之一效果最佳。

- 惡意解法中的錯誤隨著訓練變得越來越細微和局部化,說明驗證器推動了奸詐證明器生成更加接近真實解法的對抗樣本。

- 隨著訓練輪數增加,人類評估者在奸詐證明器上的準確率有所下降。

One More Thing

由于做出這項研究的超級對齊團隊已經解散,負責的又是安全問題,所以OpenAI的安全策略再次受到了廣泛關注。

關于這個問題,OpenAI CTO Mira Murati于這個月初在約翰森霍普金斯大學接受了一場專訪。

其間Mira表示,OpenAI并沒有像超級對齊團隊前負責人Jan Leike控訴的那樣“把產品(優先級)置于安全之前”。

同時她還說,雖然超級對齊團隊已經解散,但超級對齊實際上只是OpenAI多個安全團隊之中的一個,公司里依然有很多人都在從事安全工作。