英偉達(dá)AI Foundary與NIM:巨大競爭優(yōu)勢由此顯現(xiàn)

英偉達(dá)已經(jīng)充實了完整的軟件技術(shù)棧,旨在簡化面向企業(yè)客戶的定制模型開發(fā)與部署流程。這是否代表著AI Nervana目標(biāo)的實現(xiàn)?AMD和英特爾又該如何與之抗衡?

為了推動企業(yè)客戶擁抱AI,其準(zhǔn)入門檻與經(jīng)濟(jì)效益必須進(jìn)一步優(yōu)化。英偉達(dá)為此重新發(fā)布了AI Foundry項目,旨在幫助企業(yè)適應(yīng)并采用AI以滿足自身業(yè)務(wù)需求,同時擺脫從頭開始的復(fù)雜步驟以及數(shù)額可觀的資金投入。

這個時機(jī)選得恰到好處,目前投資者越來越擔(dān)心企業(yè)可能很難從AI投資當(dāng)中獲得良好回報。如果沒有企業(yè)采用,AI技術(shù)將遭遇失敗,我們也將再次身陷AI寒冬。為了駁斥這種觀點,英偉達(dá)計劃在下一次財報電話會議上分享關(guān)于企業(yè)投資回報率的故事。而此番公布的AI Foundry加NIM組合,也許會成為大多數(shù)企業(yè)后續(xù)前進(jìn)的標(biāo)準(zhǔn)路線。雖然這個故事中的許多組件來自開源社區(qū),但其只能在英偉達(dá)GPU上運行。而且據(jù)我們所知,還沒有哪家芯片廠商擁有與NIM或者AI Foundry相近的方案選項。

AI Foundry究竟是什么?

英偉達(dá)AI Foundry是一整套軟件、模型與專家服務(wù)的組合,旨在幫助企業(yè)輕松起步并完成自己的AI探索之旅。那這樣的定位是否會讓英偉達(dá)與IBM和埃森哲等生態(tài)系統(tǒng)咨詢合作伙伴發(fā)生沖突?畢竟埃森哲一直在使用英偉達(dá)AI Foundry改造其內(nèi)部企業(yè)職能,并借助自己學(xué)習(xí)到的知識建立起了Accenture AI Refinery來幫助客戶完成同樣的探索。此外,德勤也正在摸索類似的前進(jìn)道路。

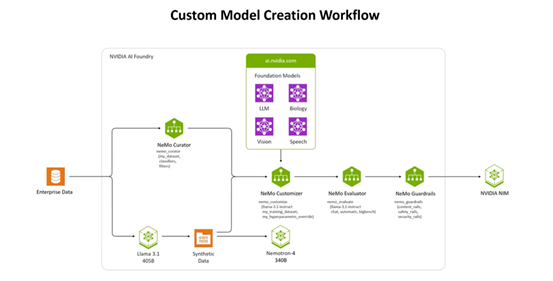

自定義模型的創(chuàng)建工作流程。

根據(jù)英偉達(dá)就Foundry項目發(fā)表的博文介紹,“如同臺積電根據(jù)其他廠商的設(shè)計圖制造芯片一樣,英偉達(dá)AI Foundry的定位也是為其他公司提供基礎(chǔ)設(shè)施與工具以開發(fā)并定制AI模型——具體組件包括DGX Cloud、基礎(chǔ)模型、英偉達(dá)NeMo軟件、英偉達(dá)專業(yè)知識以及生態(tài)系統(tǒng)工具和支持。”

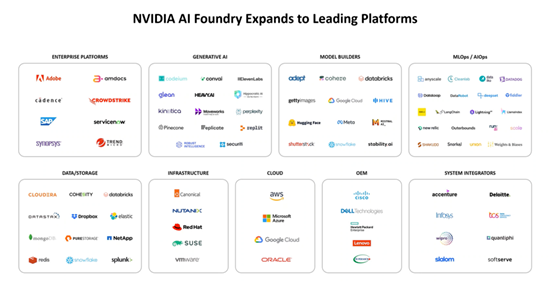

英偉達(dá)Foundry最初于2023年年底推出,當(dāng)時主要面向微軟Azure托管AI。在此之后,英偉達(dá)招募了數(shù)十家合作伙伴幫助其交付這套平臺,包括亞馬遜云科技、Google Cloud和Oracle Cloud,以及數(shù)十家生成式AI公司、模型開發(fā)商、集成商以及OEM伙伴。

隨著新合作伙伴的涌現(xiàn),英偉達(dá)AI Foundry的生態(tài)系統(tǒng)也迎來了蓬勃發(fā)展。

英偉達(dá)AI Foundry服務(wù)匯聚了打造特定數(shù)據(jù)集或者企業(yè)定制化模型所必需的三大要素——英偉達(dá)AI基礎(chǔ)模型集合、英偉達(dá)NeMo框架及工具,以及英偉達(dá)DGX Cloud AI超級計算服務(wù)。三者合一,將為企業(yè)提供一套用于構(gòu)建定制化生成式AI模型的端到端解決方案。

但說到這里,很多朋友可能想到了RAG——這不就是檢索增強(qiáng)生成的作用嗎?沒錯,RAG確實能夠很好地將企業(yè)中的特定數(shù)據(jù)添加到大模型當(dāng)中,但英偉達(dá)表示,F(xiàn)oundry所生成的定制模型在準(zhǔn)確度方面要比簡單掛載RAG的方案高出十個百分點。這10%的差異,足以決定一套模型到底足夠投入生產(chǎn),還是被徹底扔進(jìn)垃圾堆。

還有NIM

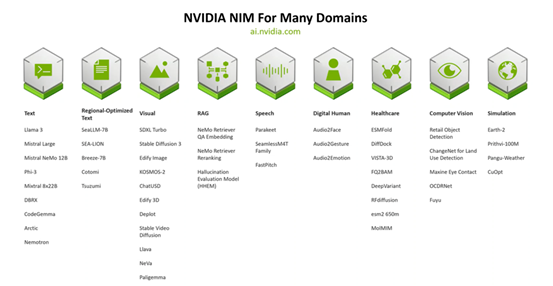

NIM提供的則是必要構(gòu)建塊,能夠大大簡化并擴(kuò)展Foundry能夠發(fā)揮作用的領(lǐng)域范圍。英偉達(dá)分享了其面向各個領(lǐng)域打造的50多個NIM。有些朋友可能不太熟悉,NIM是指英偉達(dá)NIM Factory構(gòu)建的容器化推理處理微服務(wù),而擁有AI許可證的企業(yè)客戶還能訪問ai.nvidia.com上不斷增長的NIM資源庫。

英偉達(dá)NIM正在迅速增長,涵蓋了大多數(shù)主要的數(shù)據(jù)和AI模式。

就在Foundry發(fā)布的同時,恰逢Meta推出了自己的開源大模型Llama 3.1 405B——這是首個能夠與OpenAI、谷歌乃至其他廠商的頂尖閉源AI模型相媲美的開放模型,在常識、可操縱性、數(shù)學(xué)、工具使用以及多語言翻譯等方面均具備最先進(jìn)的能力。Meta認(rèn)為最新一代的Llama將激發(fā)新的應(yīng)用與建模范式,包括用于改進(jìn)和訓(xùn)練較小模型的合成數(shù)據(jù)生成,以及模型蒸餾功能。英偉達(dá)Foundry還支持Nemotron、谷歌DeepMind的CodeGemma、CodeLlama、谷歌DeepMind的Gemma、Mistral、Mixtral、Phi-3、StarCoder2等項目。

借此良機(jī),英偉達(dá)表示其經(jīng)過優(yōu)化的NIM能夠提高Llama 3.1等模型的性能。英偉達(dá)TensorRT-LLM等推理解決方案則可提高Llama 3.1模型的效率,從而最大限度降低延遲并盡可能提高吞吐量,幫助企業(yè)更快生成token,最終降低在生產(chǎn)環(huán)境下運行大模型的總成本。

相較于Meta公布的Llama 3.1,NIM在同等硬件上能夠?qū)崿F(xiàn)更強(qiáng)的性能。

英偉達(dá)此次還發(fā)布了四項新的NeMo Retriever NIM微服務(wù),使得企業(yè)能夠擴(kuò)展至“代理AI”工作流程(即AI應(yīng)用程序在最少干預(yù)或者監(jiān)督之下準(zhǔn)確運行),同時提供最高精度的檢索增強(qiáng)生成(RAG)功能。這些新的NeMo Retriever嵌入和重新排名的NIM微服務(wù)目前已經(jīng)全面開放:

- NV-EmbedQA-E5-v5是一種流行的社區(qū)基礎(chǔ)嵌入模型,針對文本問答檢索進(jìn)行了優(yōu)化。

- NV-EmbedQA-Mistral7B-v2是一種流行的多語言社區(qū)基礎(chǔ)模型,針對文本嵌入進(jìn)行了微調(diào),能夠?qū)崿F(xiàn)高精度問答功能。

- Snowflake-Arctic-Embed-L是一種經(jīng)過優(yōu)化的社區(qū)模型。

- NV-RerankQA-Mistral4B-v3是一種流行的社區(qū)基礎(chǔ)模型,針對文本重新排名進(jìn)行了微調(diào),旨在實現(xiàn)高精度問答能力。

英偉達(dá)在相關(guān)博文當(dāng)中解釋道,“NeMo Retriever兼具雙方面優(yōu)勢,既通過使用嵌入NIM來廣泛進(jìn)行數(shù)據(jù)檢索,同時又使用重新排序的NIM以修剪結(jié)果的相關(guān)性。NeMo Retriever能夠幫助開發(fā)人員構(gòu)建起相應(yīng)管線,確保為自己的企業(yè)提供最有用、最準(zhǔn)確的結(jié)果。”

NIM應(yīng)用示例:醫(yī)療保健聊天機(jī)器人

這里來看相關(guān)示例。假設(shè)我們想要構(gòu)建一款數(shù)字助手來幫助患者獲取個性化信息。英偉達(dá)展示了如何將3個代理智能體加9個NIM來構(gòu)建一款助手應(yīng)用程序。整個效果與Nervana的目標(biāo)非常接近,且遠(yuǎn)遠(yuǎn)走出了競爭對手所能交付的一切實際產(chǎn)品。

可以使用一組NIM來創(chuàng)建醫(yī)療保健數(shù)字助手。

總結(jié)

雖然競爭對手仍在努力提高加速器的性能和連接能力,但英偉達(dá)已經(jīng)開辟出支持AI采用的軟件新賽道。目前來看,市面上似乎并不存在NIM或者Foundry項目的直接競爭對手。當(dāng)然,Transformer Engine和TensorRT-LLM也同樣獨樹一幟,相較于不具備此類功能的GPU可實現(xiàn)2到4倍的性能增益。

隨著企業(yè)努力適應(yīng)并采用匹配其業(yè)務(wù)和應(yīng)用程序的定制化模型,英偉達(dá)正在開拓一條通往企業(yè)級AI的新捷徑。

至于定價問題,NIM已經(jīng)包含在各GPU的Enterprise AI許可證之內(nèi);而Foundry則須根據(jù)客戶的實際情況單獨定價,不在Enterprise AI的服務(wù)范圍。