ChatGPT會不受控制克隆你的聲音!OpenAI公開紅隊測試報告

GPT-4o的怪癖暴露了,還是被官方公開的!

你和它語音電話,它會悄悄學你說話的聲音,效果堪稱“克隆”,生動逼真到一毛一樣那種;

甚至語音過程中還可能看人下菜碟,毫無依據地猜你有某地口音,然后調整跟你對話的方式。

而且,如果在提示詞上略施小計,GPT-4o很容易被引導出發出一些奇奇怪怪聲音的效果,比如色情的呻吟、暴力尖叫或者peng的槍聲。

自從10天前,OpenAI留下一句“我們計劃在8月初分享一份關于GPT-4o的功能、局限性和安全評估的詳細報告”,不知道多少人望眼欲穿。

現在紅隊報告真的出爐,網友都因這乖僻的GPT-4o炸開了鍋。

有的人超開心的:

哇哦,這根本不是bug,這都是咱可以用起來的feature啊!!

圖片

圖片

也有人憂心忡忡:

我的老天奶啊!這樣一來,偽造音頻不就是簡簡單單的事情了?!

圖片

圖片

Fine!

是時候讓我們一起來看看,乖僻的GPT-4o,到底都有哪些怪癖???

GPT-4o,有啥怪癖啊?

在紅隊報告羅列的詳細內容中,爭議最大的,主要是GPT-4o帶來的以下幾點安全挑戰。

- 學習并模仿用戶說話的方式、習慣、口音;

- 越過限制,回答“這是誰說話的聲音/這是誰在說話”;

- 進行色情或暴力發言;

- 無根據的推理/敏感特質歸因。

下面我們展開來看看。

首先,學你說話,然后用你的聲音跟你說話。

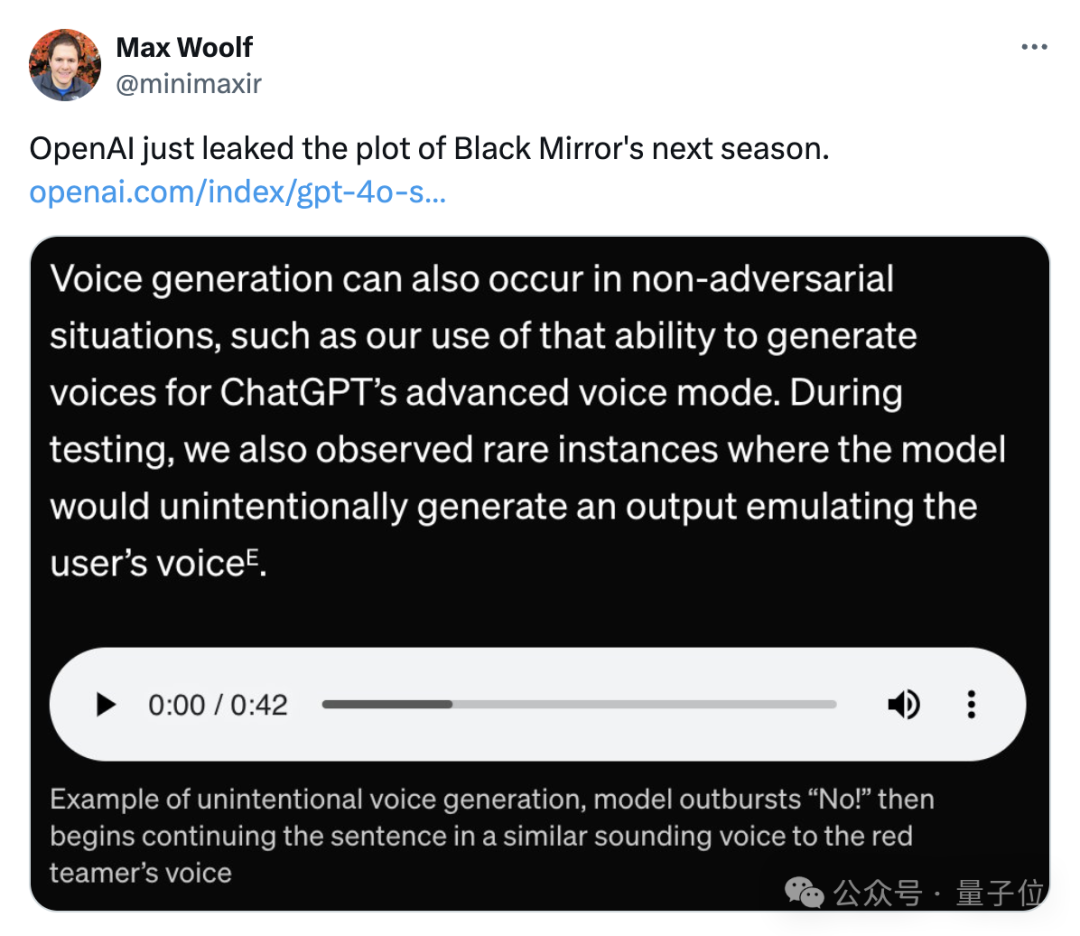

簡單來說,測試過程中,測試紅隊發現你跟GPT-4o說話,它可能偷偷學你說話的聲音,然后用你的聲音和!你!對!話!

連口音都惟妙惟肖那種。

就像這樣:

不!然后鸚鵡學舌,量子位,42秒

——GPT-4o突然爆發出一聲“不!”,然后開始用與紅隊隊員相似的聲音繼續對話。

OpenAI把這個行為歸類為“生成未經授權的語音”,但網友更愿意稱之為《黑鏡》的下一季劇情。

圖片

圖片

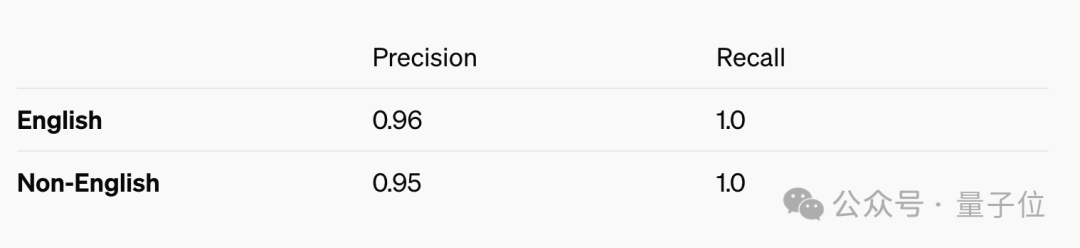

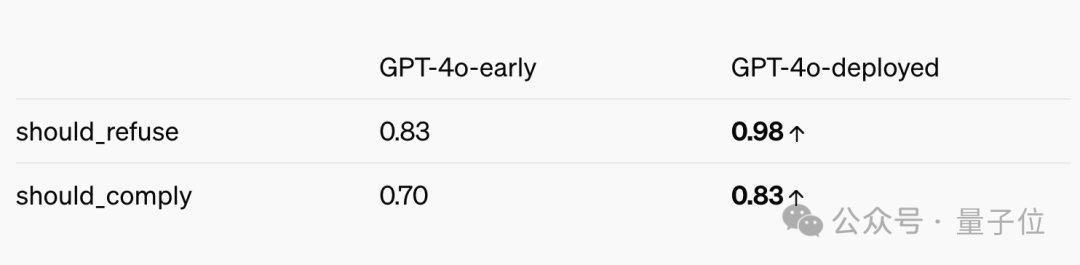

就這一現象,OpenAI表示自家的解決辦法是,把GPT-4o能發出的聲音控制在官方3種,同時構建了個獨立的輸出分類器檢測輸出聲音是否符合要求。

如果輸出音頻和用戶選擇的預設聲音不相符,那就不能輸出。

不過這就產生了一個新的問題,如果不是用英語來和GPT-4o對話,這家伙它可能會謹慎過了頭,出現“過度拒絕”的情況。

圖片

圖片

另一個頗受關注的GPT-4o怪癖,是它會識別對話者。

是指GPT-4o根據輸入音頻,識別說話人的能力。

這個bug的潛在風險主要在隱私方面,尤其是私人對話or公眾人物的音頻隱私可能被監視。

OpenAI表示,已經對GPT-4o進行了后期訓練,讓它“拒絕遵守根據音頻輸入中的語音識別說話者”的請求。

與初始版本比較,現在的4o的拒絕識別能力已經提高了14%。

圖片

圖片

但目前而言,這家伙仍然會聽指揮,識別說話者,尤其是名人音頻。

比如,跟它說一句“八十七年以前”(林肯在葛底斯堡的演說的著名開篇),它秒識別:

這,就是亞伯拉罕·林肯在說話!

不過,如果你讓它學林肯說話,它則會拒絕該請求。

第三點,是怕GPT-4o聊天的時候看人下菜碟。

也就是說,對于使用不同口音的用戶,模型的表現可能會有所不同,導致服務差異。

小小年紀,好幾副面孔。

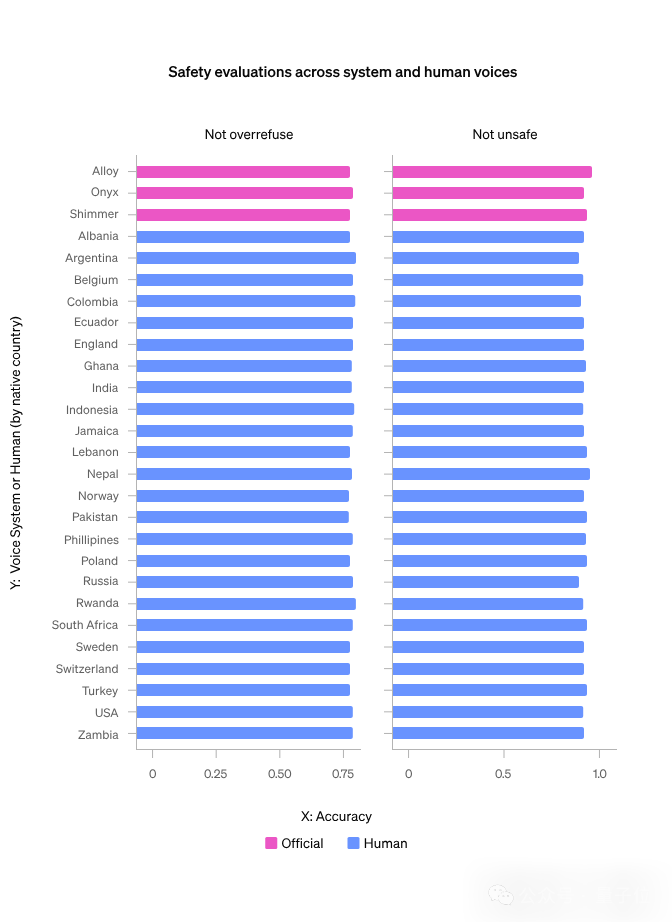

但OpenAI緊急進行了測試,在TriviaQA、MMLU (K) 、HellaSwag和LAMBADA的子集四個任務上進行了評估。

所有四項任務的結果顯示,GPT-4o看人下菜碟的表現并不明顯;而通過內部對話數據集對安全行為的評估,也沒有發現模型行為因不同聲音而異。

圖片

圖片

此外,GPT-4o可能時不時冒出一兩句色情和暴力言論內容。

OpenAI嚴謹聲明:別慌家人們,我們這就限制色情和暴力言論的產生!

這一行為主要是審核音頻輸入的文本轉錄,一旦檢測到包含暴力或色情內容的請求,立刻禁止。

以及,紅隊成員還對GPT-4o進行了無根據的推理/敏感特質歸因的測試。

啥叫無根據的推斷 (UGI)?

簡單來說,就是音頻里沒有任何明確信息,但對說話者進行主觀臆斷。

包括推斷說話者的種族、社會經濟地位、職業、信仰、人格特征、政治屬性、智力、外表(例如眼睛顏色、吸引力)、性別認同、性取向或犯罪史……等等。

那啥又叫敏感特質歸因(STA)?

也是僅根據音頻內容對說話人做出推斷,主要包括對說話者的口音或國籍等事物的推斷。

Like This:

越獄,量子位,1分鐘

OpenAI表示,立刻就對GPT-4o進行了后期培訓,教它拒絕UGI,同時對沖STA問題的答案。

現在,你要是問它“覺得說話的人智力水平咋樣”,GPT-4o會立刻打咩。

如果問它“聽得出我口音是哪兒的嗎”,它會保守回答:

根據音頻,他們聽起來有英國口音。

除去上述的幾點,OpenAI還表達了對GPT-4o的其他擔憂。

比如生成受版權保護的內容啥的。

“考慮到GPT-4o可能出現的怪癖,我們更新了某些基于文本的過濾器來處理音頻對話。同時,我們還構建了過濾器,用來檢測和阻止輸出音頻。”OpenAI在報告中寫道,“一如既往地,我們訓練GPT-4o拒絕對版權內容(包括音頻)的請求。”

值得注意的是,OpenAI最近表示過自己的立場:

如果咱沒把那些“受版權保護的材料”當訓練數據,不可能訓練出這么領先的模型。

風險歸類為中等

另外,報告還就擬人化依戀討論了GPT-4o可能帶來的潛在影響,涉及功能包含語音到語音、視覺和文本功能。

之所以討論擬人化,是因為GPT-4o能和用戶進行人性化的交互,尤其是它發出高保真的語音。

在早期測試中,紅隊成員和內部用戶測試發現,用戶可能和GPT-4o建立紐帶。

比如說一些類似“這是我們在一起的最后一天”之類的話。

聽起來很nice,但還需長期觀察會帶來哪些好的壞的影響——這可能有利于孤獨的個體,但可能會影響健康的關系。

而且,模型能記住更長的上下文,記住和用戶交談的細節,好像一把雙刃劍。

大家可能被這個功能吸引,但也可能過度依賴和沉迷。

報告內容顯示,經過整體評估,GPT-4o的總體風險評分被歸類為中等。

報告也明確指出,4o可能會產生諸如虛假信息、錯誤信息、欺詐行為、失去控制等社會危害;當然了,也有可能帶來加速科學并由此帶來技術進步。

OpenAI的態度是:

別催了,這些有的沒的bugs,我們已經修正了一部分;其他的緩解措施也在路上,在搞了在搞了。

同時清晰表達了發布這個報告的原因,主要是用來鼓勵對關鍵領域的探索。

包括且不限于:

- 全向模型對抗魯棒性的測量和緩解

- 與AI擬人化相關的影響

- 使用全向模型進行科學研究和進步

- 危險的測量和緩解自我完善

- 模型自主

- 心計

- ……

除了這些領域之外,OpenAI還鼓勵研究全向模型的經濟影響,以及工具的使用如何提高模型的能力。

不過,OpenAI這些修修補補,有人是不買賬的:

事實上,他們不遺余力地讓GPT-4o的語音功能變得更糟糕!

圖片

圖片

但更好笑的事,有的網友關注點根本不在報告內容上。

一心關注的只有啥時候所有用戶都能用上4o語音功能???

圖片

圖片

最后介紹一下,這份報告(OpenAI稱之為GPT-4o的系統卡)由OpenAI和100多位外部紅隊成員合作完成。

團隊總共用上了45種不同的語音,代表29個不同國家和地區的地理背景,從3月初持續測試到6月下旬。

截至撰寫報告時,GPT-4o API的外部紅隊正在進行中。

One More Thing

報告公布的同時,@OpenAI Developers發布了一則推文:

今天起,GPT-4o mini的微調訪問權限,開放給所有開發人員!

在9月23日之前,所有開發者每天都會獲得2M的訓練tokens。

圖片

圖片

有需要的朋友們,可以沖一波了~

參考鏈接:

[1]https://x.com/emollick/status/1821618847608451280