譯者 | 李睿

審校 | 重樓

Meta公司發布的對象分割模型SAM 2可以執行實時圖像和視頻分割,并且可以應用于許多領域,而無需對特定數據進行微調。

Meta公司日前發布了其新的Segment Anything Model 2 (SAM 2),由于目前人們主要關注的是大型語言模型(LLM),因此并沒有得到應有的關注。SAM 2可以進行實時圖像和視頻分割,并且可以應用于許多領域,而無需對特定數據進行微調。

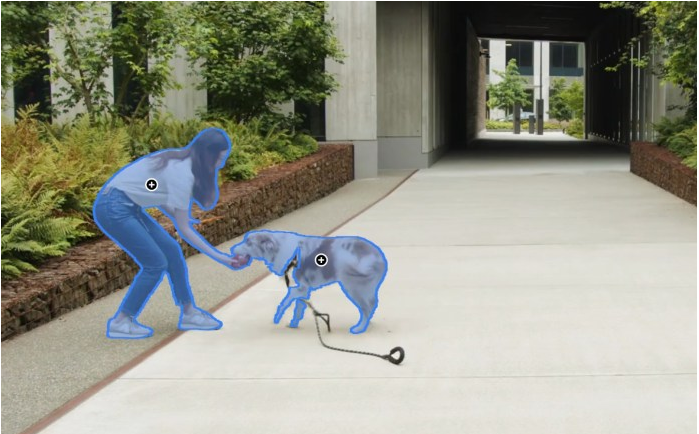

圖1使用Meta的SAM 2模型進行對象分割

Meta公司已經發布了模型權重、代碼和用于訓練它的數據集,這將對研究和開發社區非常有用。以下是SAM 2的工作原理及其對許多工業應用程序(包括未來幾代LLM)可能產生的影響。

從SAM到SAM 2

對象分割是一項復雜的任務,需要識別圖像中屬于對象的所有像素。傳統上,創建對象分割模型是一項非常復雜的任務,需要專業技術知識、目標應用程序的大量注釋數據以及成本昂貴的機器學習訓練基礎設施。

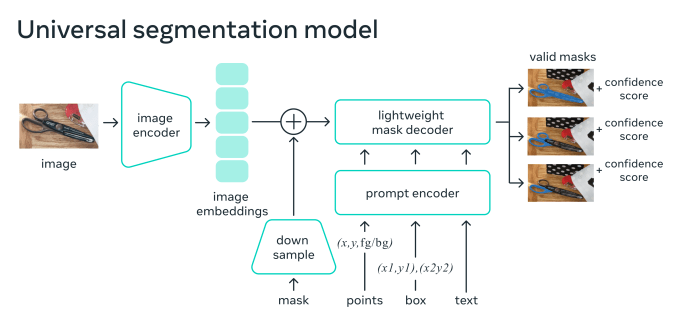

Meta公司于2023年發布的SAM改變了這一現狀,它提提供了一種可以開箱即用的模型來處理許多用例。SAM可以接受“提示”,提示可以包括點、邊界框或文本,并檢測哪些像素屬于與提示對應的對象。這相當于LLM的對象分割,它可以在不進行再訓練的情況下完成許多任務。

SAM的工作原理是學習匹配輸入圖像的編碼,并為每個對象提示轉換為彩色像素。該模型在SA-1B上進行訓練,SA-1B是一個包含10億張注釋圖像的數據集。關于數據注釋過程的一個有趣的事實是,研究人員使用了一個迭代過程。

他們首先在一組帶注釋的示例上訓練了初始版本的SAM。然后,使用該模型來幫助注釋者加快下一組示例的注釋過程。他們利用新的數據對SAM進行微調,提高其性能,并以更快的速度重復這個循環。

圖2 SAM架構

SAM已經被用于各種用途,從Instagram等消費者應用程序到科學和醫學應用程序。SAM也成為圖像標記過程的重要組成部分,幫助機器學習團隊加快為其專業分割模型創建訓練示例的過程。

SAM 2通過添加一些組件來改進SAM,使其更適合檢測視頻中的同一對象。視頻中對象分割的挑戰在于對象可能會變形、遮擋或在不同幀中從不同角度顯示。SAM 2添加了內存組件,使模型能夠確保跨幀的一致性。

記憶機制由記憶編碼器、記憶庫和記憶注意力模塊組成。當應用于靜止圖像時,內存組件是空的,模型的行為類似于SAM。當模型用于視頻時,內存組件存儲有關對象和用戶先前提示的信息。用戶可以在視頻的不同部分添加或刪除提示,以改進模型的輸出。在每一幀中,記憶信息都會根據前一幀的信息來調整模型的預測。

圖3 Meta SAM 2架構

SAM 2還附帶了SA-V,這是一個全新的數據集,具有更大、更豐富的訓練示例集。SA-V在大約51,000個視頻中包含60多萬個注釋圖像。這些視頻展示了從全球47個國家收集的真實場景。注釋包括整個對象、對象部分以及具有挑戰性的場景,例如對象部分被遮擋的實例。

與其前身一樣,SA-V在模型本身的幫助下進行了注釋。注釋者使用SAM 2的早期版本來注釋示例,然后人工糾正注釋并重新訓練模型。通過重復這個過程,他們改進了模型,提高了自動注釋的速度和質量。

Meta公司表示,“使用我們的工具和循環中的SAM 2的注釋大約比每幀使用SAM快8.4倍,也比將SAM與現成的跟蹤器結合起來快得多。”

SAM – 2的實際應用

根據Meta公司研究團隊發布的報告,在17個零樣本視頻數據集上,SAM 2在交互式視頻分割方面明顯優于以前的方法,并且需要的人機交互減少了大約三倍。SAM 2還提供每秒約44幀的近實時推理。

研究人員已經根據Apache 2.0許可證提供了SAM 2的代碼和權重,這意味著用戶可以免費將其用于商業目的。他們還發布了SA-V數據集。此舉是Meta公司最近推動將其人工智能研究、模型和工具開源的一部分,以應對OpenAI、Anthropic和谷歌等公司的封閉發布。

很多開發人員和研究人員將這種模型重新用于專門的用例。該模型已經非常高效,有39兆字節到224兆字節四種大小,足以在筆記本電腦和智能手機等許多邊緣設備上運行。但是,通用模型將在非常專業的應用程序或內存和計算受限的設備上遇到障礙。SAM 2和SA-V將如何幫助企業為特定工廠生產線上的對象檢測等專門應用創建微小對象分割模型令人感興趣。它對自動駕駛行業也非常有用,因為自動駕駛行業需要大量的注釋數據,而注釋速度的任何百分比的提高都是明顯的勝利。

同樣有趣的是,如何將SAM 2等模型與語言模型相結合以用于更復雜的應用程序。目前,大多數視覺語言模型(VLM)都是用于處理原始像素數據和文本。而了解可以用基于對象分割模型輸出或原始像素和粒度對象分割組合的VLM來實現什么,這將是一件有趣的事情。這可能對機器人技術尤其有用,因為視覺語言模型(VLM)和更新的視覺-語言-行動(VLA)模型正在這一領域取得進展。

至于Meta公司,可以期待SAM 2、Llama 3和下一代人工智能創新將在該公司一些最雄心勃勃的項目中找到自己的方式,包括增強現實眼鏡。

原文標題:Meta SAM 2 is the most impressive object segmentation model,作者:Ben Dickson