YOLC:空中圖像中的微小物體檢測新突破

本文經計算機視覺研究院公眾號授權轉載,轉載請聯系出處。

PART/1 概述

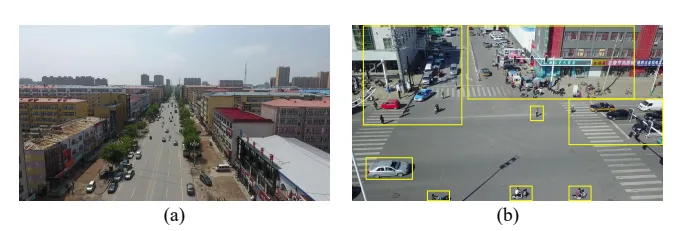

目前航拍圖像中檢測物體有著一下幾項重大挑戰:

1)航拍圖像通常具有非常大的尺寸,通常有數百萬甚至數億像素,而計算資源有限。

2) 物體尺寸小會導致有效檢測的信息不足。

3) 不均勻的對象分布會導致計算資源的浪費。

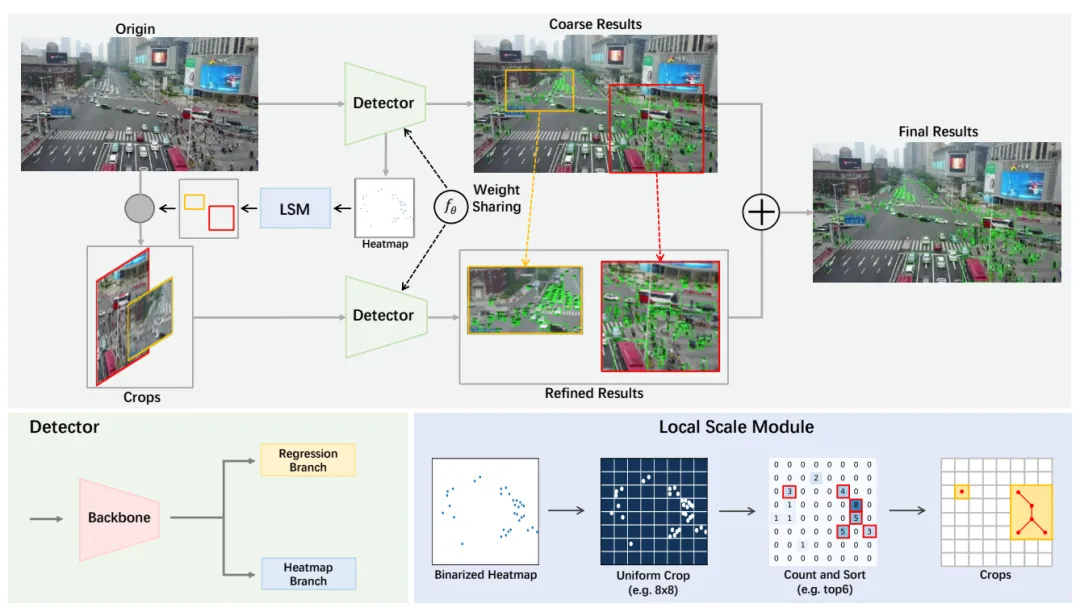

為了解決這些問題,研究者提出了YOLC(You Only Look Clusters),這是一個基于無錨目標檢測器CenterNet的高效框架。為了克服大規模圖像和非均勻對象分布帶來的挑戰,引入了一種局部尺度模塊(LSM),該模塊自適應地搜索聚類區域以放大以進行精確檢測。此外,研究者還使用Gaussian Wasserstein distance(GWD)修改回歸損失,以獲得高質量的邊界框。檢測頭采用可變形卷積和細化方法來增強對小物體的檢測。對包括Vi sdrone2019和UAVDT在內的兩個航空圖像數據集進行了廣泛的實驗,以證明新提出的方法的有效性和優越性。

PART/2 背景

早期的研究提出了新的多尺度訓練策略,如圖像金字塔的尺度歸一化(SNIP)及其改進版本。這些方法可以有效地提高小對象的檢測性能,而多尺度訓練對計算資源和內存容量都有很大的要求。另一種方法是提高圖像分辨率或特征分辨率。例如,生成對抗網絡(GAN)可用于補償小對象的信息丟失。因此,可以縮小小對象和大對象的特征表示之間的差距;但是計算成本將是昂貴的。最近,一些基于標簽分配的方法旨在改進罕見小對象樣本的樣本分配策略。它們提高了小物體的檢測性能,但在準確性或效率方面仍有改進的潛力。

高分辨率航空圖像中小物體的不均勻分布對探測器提出了重大挑戰,導致大規模航空圖像的效率或精度降低。為了解決這些問題,一種簡單的方法是將圖像分成幾個部分并放大,如均勻裁剪所示。然而,這種方法無法解釋物體的非均勻分布,檢測所有作物仍然需要大量時間。

為了應對上述挑戰,已經提出了主流解決方案,包括設計專用方案來定位集群區域,這些方案可以隨后用于檢測。ClusSet采用集群檢測網絡來檢測目標集群。DMNet對目標分布進行建模,并通過密度圖生成聚類區域。這些策略顯示出有希望的結果,因為聚類區域被保留,背景被盡可能地抑制。然而,對每種作物的獨立檢測降低了推理速度。此外,雖然上述方法生成了集群區域,但某些集群中的對象分布很稀疏,對最終性能的貢獻很小。因此,在精度和效率之間實現最佳折衷是航空圖像中目標檢測的關鍵問題。

PART/3 新算法框架

- 準備工作

CenterNet是一個強大而高效的無錨目標象檢測框架。與使用錨點預測邊界框的傳統方法不同,CenterNet從對象的中心點回歸對象的大小、方向、姿勢和關鍵點。這是通過一個全卷積網絡實現的,該網絡生成對象中心的熱圖(密度圖),然后通過在熱圖中找到局部最大值來定位中心。使用這些峰值位置的特征,可以推斷出物體的大小。由于其簡單性,CenterNet在不依賴復雜特征工程的情況下實現了非凡的性能。它是一種快速有效的對象檢測方法,已被研究界廣泛采用。CenterNet作為一種代表性的無錨探測器,采用高分辨率特征圖進行預測,使其對小物體特別友好和高效。密度貼圖是提供圖像中對象分布信息的強大工具。在CenterNet中,密度圖用于定位對象。為了提高檢測器檢測小物體的性能,我們使用轉置卷積層對特征圖進行上采樣,以匹配輸入圖像的大小。此外,我們提出了一種局部尺度模塊,該模塊利用熱圖自適應地搜索聚類區域并調整其大小以適應檢測器,這可以進一步提高檢測精度。

- You Only Look Clusters

提出的YOLC遵循與Center-Net類似的管道,但它與CenterNet的區別在于使用了不同的主干、檢測頭、回歸方式和損失函數。特別是,HRNet被用作生成高分辨率熱圖的骨干,這些熱圖更擅長檢測小物體。此外,由于航空圖像中物體的分布不平衡,設計了一種局部尺度模塊(LSM)來自適應地搜索聚類區域。在檢測到原始圖像和裁剪后,在密集區域中,精確的結果直接替換為原始圖像的結果。

- 高分辨率熱圖

為了提高在充滿小物體的密集區域進行物體檢測的準確性,YOLC使用了更高分辨率的熱圖。在CenterNet中,每個對象都被建模為其邊界框中心的一個點,由熱圖中的高斯斑點表示。然而,相對于輸入圖像,熱圖被降采樣了4倍。這種下采樣可能會導致小物體在熱圖中只折疊成幾個甚至一個點,從而難以準確定位它們的中心。為了解決這個問題,YOLC采用了一種經過修改的管道,該管道使用了更高分辨率的熱圖。具體來說,我們添加了一個卷積層和兩個轉置卷積層,以將熱圖放大到與輸入圖像相同的大小。這使我們能夠捕獲有關小物體的更詳細信息,從而在密集區域中實現更準確的物體檢測。在解碼之前應用高斯濾波器有助于減少CenterNet中的假陽性預測。過濾器平滑熱圖并抑制對象周圍的多個峰值。這種方法有助于提高對象的定位精度,并減少誤分類的機會。

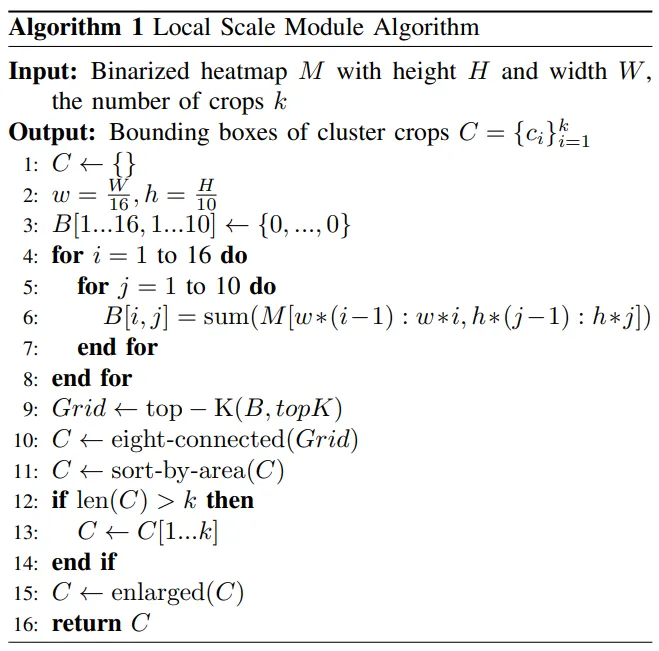

- Local Scale Module

興趣區域建議方法是基于裁剪的目標檢測模型的關鍵組成部分。然而,在航拍圖像中,車輛和行人等物體往往聚集在幾個聚集的區域。圖像中的大多數區域都是背景,不需要檢測。此外,密集區域的有限分辨率可能會導致檢測性能顯著下降。現有的基于裁剪的方法,如DMNet,會產生許多作物或使用像ClusSet這樣的額外網絡,導致檢測速度低和模型參數增加。為了解決這些問題,研究者提出了一種局部尺度模塊(LSM),可以自適應地定位聚類區域。LSM受到AutoScale的啟發,但研究者進行了一些修改,使其適用于航空圖像。首先,LSM不是只搜索單個最大聚類區域,而是通過對每個網格中的密度進行排序來定位前K個密集區域。這很重要,因為航空圖像通常有多個聚類區域。其次,AutoScale是為人群計數和定位而設計的,它只適用于具有單類目標的場景。然而,在航空圖像中,有多個目標類別。研究者還注意到,UCGNet使用DBSCAN和K-Means等聚類方法從密集區域生成圖像裁剪。然而,UCGNet產生的作物仍然很大,沒有考慮不同作物之間的密度差異。

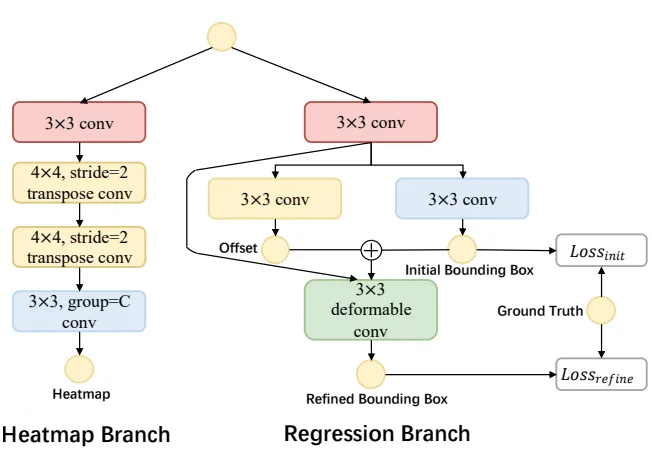

- Improved Detection Head

為了提高對航空圖像中小目標的檢測,回歸分支通過可變形卷積進行了增強,因為它可以自適應地調整卷積操作中的采樣位置,以更好地捕捉小細節。此外,為了更好地捕捉不同類別目標的精細細節,熱圖分支被解耦為多個子分支,每個子分支負責預測特定對象類別的熱圖。這不僅減輕了同時預測所有熱圖的計算負擔,而且使網絡能夠專注于學習每個類別的不同特征,從而提高了探測器的整體性能。下圖展示了經過這些改進的檢測頭的結構。

PART/4 實驗及可視化

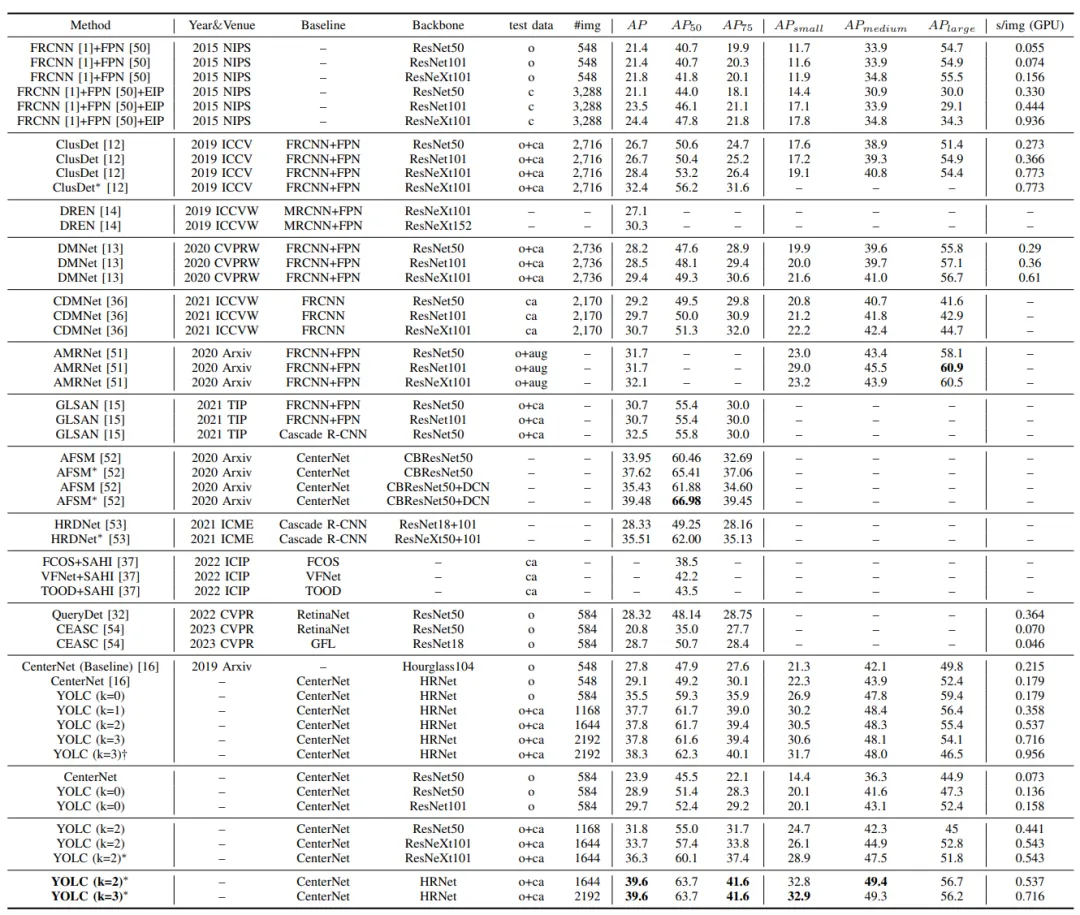

性能比較。“O”、“C”、“CA”和“AUG”分別代表原始驗證集、均勻圖像分割(EIP)裁剪圖像、集群裁剪圖像和增強圖像。“*”表示多尺度推理。“?”表示通過超參數調整進行優化。

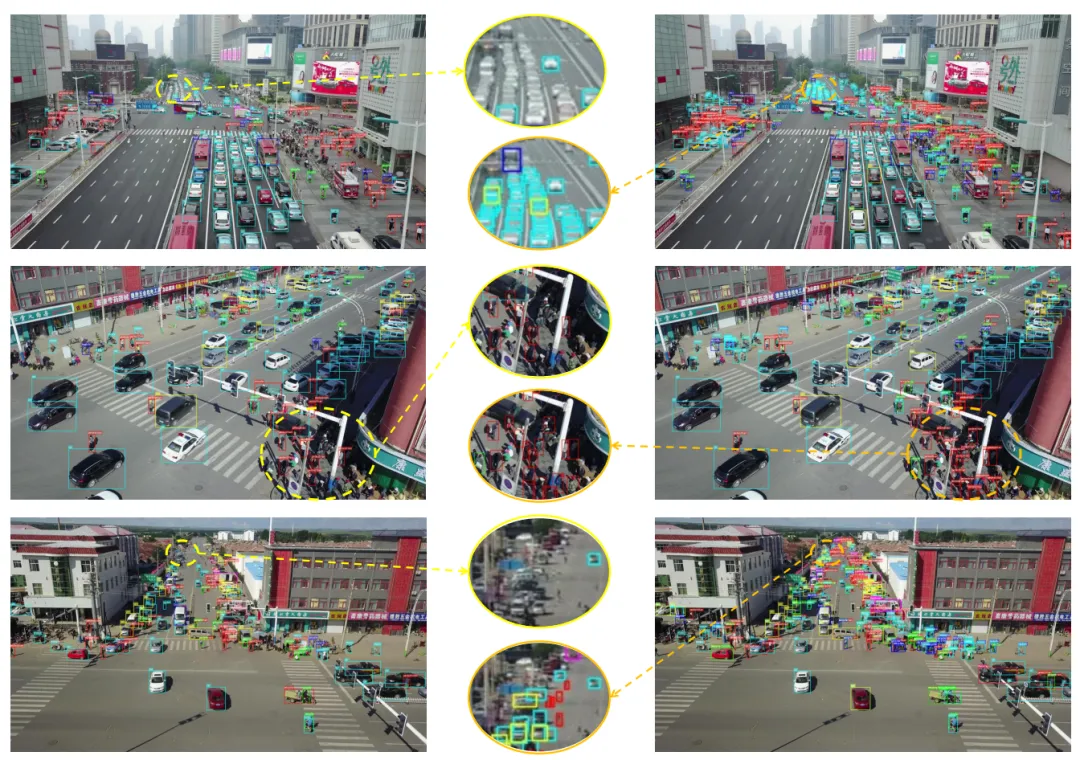

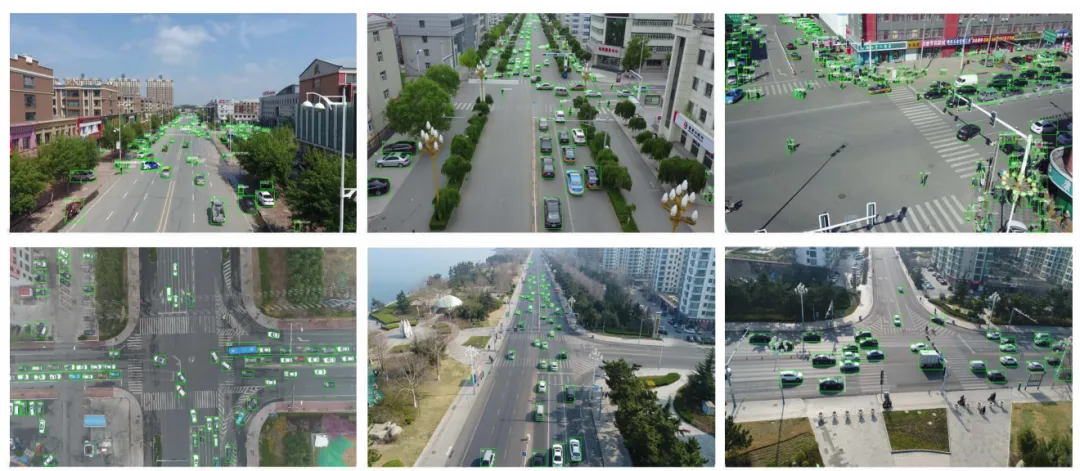

在VisDrone(第一行)和UAVDT(第二行)上可視化YOLC檢測結果:

在VisDrone上可視化YOLC(右)和CenterNet(左)檢測結果: