生存還是死亡?當(dāng)AI成為生死判官,「心理數(shù)字孿生」為失語患者做出臨終抉擇

隨著慢性病的高發(fā)和醫(yī)療技術(shù)的發(fā)展,死亡變得緩慢,臨終也成為當(dāng)代個人生命歷程的一個重要階段。

對很多人來說,死亡不再是突發(fā)的、沒有征兆的離世,而是一個漫長的過程。

「插不插管」,怎樣才是更好的選擇,怎么做才能讓生命有尊嚴(yán)地謝幕?

圖片

圖片

《MIT科技評論》近日發(fā)布了一篇文章,對「AI介入插管決策」這一話題進(jìn)行了深入探討。

倫理學(xué)家提出了一種乍一聽非常瘋狂的想法——利用AI打造「心理數(shù)字孿生」,幫助醫(yī)生和失去語言功能的患者的家屬做出決定。

圖片

圖片

AI的邊界在哪里,難道連生死這種「人生大事」也要被算法接管了嗎?

把決定權(quán)交給AI

幾個月前,50多歲的Sophie經(jīng)歷了一次出血性中風(fēng)。她接受了腦部手術(shù),但心臟卻停止了跳動。

Sophie的遭遇給她造成了嚴(yán)重的腦損傷。她反應(yīng)遲鈍,手指無法捏緊,被要求睜開眼睛時她也無法睜開,皮膚被捏住時她也不會退縮。

她無法主動呼吸,只能在脖子上切開一根氣管后插管來呼吸,還需要一根飼管將營養(yǎng)直接輸送到她的胃里。接下來,她的醫(yī)護(hù)該何去何從?

參與Sophie治療的貝勒醫(yī)學(xué)院內(nèi)科醫(yī)生Holland Kaplan回憶說,在這種情況下,這個棘手的問題通常會留給Sophie的家人來解決。

貝勒醫(yī)學(xué)院,被認(rèn)為是全美最杰出的醫(yī)學(xué)院之一

貝勒醫(yī)學(xué)院,被認(rèn)為是全美最杰出的醫(yī)學(xué)院之一

但家人無法達(dá)成一致。Sophie的女兒堅決認(rèn)為,她的母親希望停止治療,讓她安詳?shù)仉x開人世。另一位家庭成員則堅決反對,并堅持認(rèn)為索菲是個「斗士」。

這種情況讓包括Sophie的醫(yī)生在內(nèi)的所有相關(guān)人員都感到痛心。

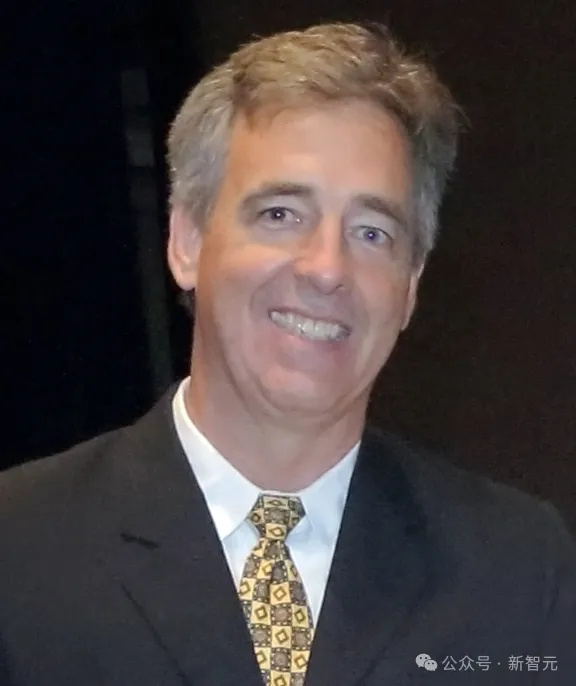

美國國立衛(wèi)生研究院的生物倫理學(xué)家David Wendler說,生命末期的「生死抉擇」,可能會讓幫助臨終患者做出決定的人感到非常不安。

David Wendler

David Wendler

Wendler和他的同事們一直在研究一種可以讓事情變得更簡單的想法:一種基于人工智能的工具,可以幫助患者家屬預(yù)測病人自己在任何特定情況下會想要什么。

Wendler與其他來自牛津、新加坡國立大學(xué)、耶魯?shù)仁澜缑5难芯空吆现南嚓P(guān)論文發(fā)表在了24年第7期的《美國生物倫理學(xué)雜志》上,論文題為「醫(yī)療保健中替代判斷的個性化患者偏好預(yù)測器:技術(shù)上可行,倫理上可取」。

圖片

圖片

論文地址:https://www.tandfonline.com/doi/full/10.1080/15265161.2023.2296402

這個工具還沒有制造出來。但Wendler計劃用病人自己的醫(yī)療數(shù)據(jù)、個人信息和社交媒體帖子來訓(xùn)練它。

他希望該工具不僅能更準(zhǔn)確地計算出病人的意愿,還能減輕家屬在艱難決策中的壓力和情感負(fù)擔(dān)。

Wendler與牛津大學(xué)的生物倫理學(xué)家Brian Earp及其同事一起,希望在獲得資金后立即開始構(gòu)建這一工具,預(yù)計在未來幾個月內(nèi)成行。

圖片

圖片

Brian Earp

但要推出這一工具并非易事。

批評者們不禁要問,這樣的工具如何才能合乎道德地在一個人的數(shù)據(jù)上進(jìn)行訓(xùn)練,生死攸關(guān)的決定是否應(yīng)該交由人工智能。

生存還是死亡

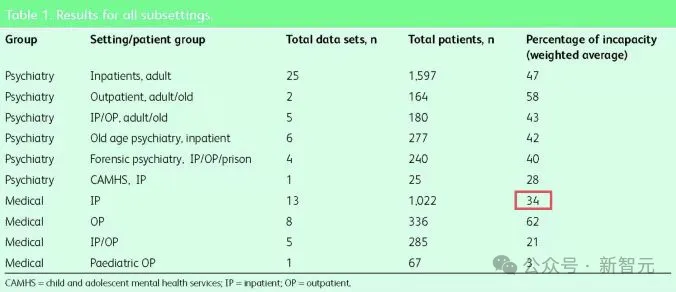

在醫(yī)療環(huán)境中,約有34%的人由于各種原因被認(rèn)為無法對自己的護(hù)理做出決定。例如,他們可能失去知覺,或者無法推理或交流。

圖片

圖片

這一數(shù)字在老年人中更高,對美國60歲以上人群的研究發(fā)現(xiàn),70%面臨重要護(hù)理決策的人缺乏自我決策的能力。

Wendler說,「這是很多非常重要的決定,基本上決定了一個人在不久的將來是生是死。」

對衰竭的心臟進(jìn)行胸外按壓可能會延長人的生命,但這種治療方法可能會導(dǎo)致胸骨和肋骨斷裂,而且到病人醒過來的時候,可能已經(jīng)出現(xiàn)了嚴(yán)重的腦損傷。

用機器維持心臟和肺部的功能可能會維持其他器官的含氧血液供應(yīng),但并不能保證康復(fù),而且患者在此期間可能會感染多種疾病。

身患絕癥的人可能希望繼續(xù)嘗試醫(yī)院提供的藥物和治療程序,這樣可以多活幾周或幾個月。但另一些人可能希望放棄這些干預(yù)措施,在家里過得更舒適。

在美國,只有大約三分之一的成年人提前交待好了「死亡方式」,他們填寫了預(yù)先指示,一種明確規(guī)定他們可能希望得到的臨終關(guān)懷的法律文件。

圖片

圖片

論文地址:https://pubmed.ncbi.nlm.nih.gov/28679811/

Wendler估計,超過90%的臨終決定最終是由病人以外的其他人做出的。

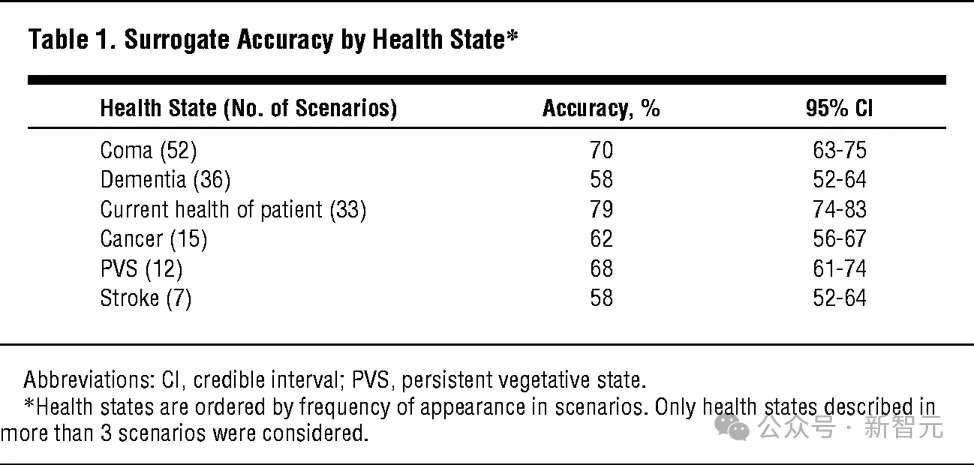

代理人的作用是根據(jù)病人希望如何治療的信念做出決定。但人們通常并不擅長做出此類預(yù)測。研究表明,代治者準(zhǔn)確預(yù)測病人臨終決定的比例約為68%。

圖片

圖片

Wendler補充說,這些決定本身也會讓人非常痛苦。

一些代做決定者會因為支持了自己的親人而感到滿足,而另一些則會在情感負(fù)擔(dān)中掙扎,并在之后的幾個月甚至幾年里感到內(nèi)疚。

圖片

圖片

論文地址:https://www.acpjournals.org/doi/10.7326/0003-4819-154-5-201103010-00008

有些人擔(dān)心自己過早地結(jié)束了親人的生命,還有人擔(dān)心他們不必要地延長了親人的痛苦。

「這對很多人來說都很糟糕,人們會說這是他們做過的最糟糕的事情之一」。

Wendler一直在研究如何幫助患者家屬做出此類決定。

十多年前,他提出了開發(fā)一種工具的想法,這種工具可以根據(jù)年齡、性別和保險狀況等特征預(yù)測病人的偏好。

該工具的基礎(chǔ)是用普通人群調(diào)查結(jié)果訓(xùn)練出來的算法,看似粗糙,但這些特征似乎確實影響著人們對醫(yī)療服務(wù)的感受。例如,青少年比90歲的老人更有可能選擇積極治療。

研究表明,基于平均值的預(yù)測可能比家庭成員的猜測更準(zhǔn)確。

2007年,Wendler和他的同事們根據(jù)少量數(shù)據(jù)建立了一個工具的初步版本。

Wendler說,這個簡單的工具在預(yù)測人們需要什么樣的護(hù)理方面「至少和近親代理一樣好」。

現(xiàn)在,Wendler、 Earp和他們的同事正在研究一個新的想法。

研究人員計劃建立的新工具將不再基于粗略的特征,而是個性化的。

該團(tuán)隊建議使用人工智能和機器學(xué)習(xí),根據(jù)病史等個人數(shù)據(jù),以及電子郵件、個人信息、網(wǎng)頁瀏覽歷史、社交媒體帖子,甚至是 Facebook 的「點贊」,來預(yù)測病人的治療偏好。

其結(jié)果將是一個人的「心理數(shù)字孿生」——一個醫(yī)生和家庭成員可以參考的工具,以指導(dǎo)患者的醫(yī)療護(hù)理。

目前還不清楚這在實踐中會是什么樣子,但該團(tuán)隊希望在完善該工具之前對其進(jìn)行構(gòu)建和測試。

研究人員稱他們的工具為個性化患者偏好預(yù)測器(personalized patient preference predictor),簡稱為P4。

Wendler說,從理論上講,如果它能像他們希望的那樣工作,那么它可能會比前一版本的工具更準(zhǔn)確,而且比人類代理更準(zhǔn)確。

Earp說,它可能比預(yù)先指示更能反映病人當(dāng)前的想法,而預(yù)先指示可能是在十年前簽署的。

AI能做出更好的選擇嗎

貝勒醫(yī)學(xué)院的醫(yī)學(xué)倫理學(xué)家Jennifer Blumenthal-Barby說,P4 這樣的工具還可以幫助減輕代理者在為家人做出如此重大的生死決定時所承受的精神負(fù)擔(dān),因為這種決定有時會讓人出現(xiàn)創(chuàng)傷后應(yīng)激障礙的癥狀。

Kaplan說,有些代理人會出現(xiàn)「決策癱瘓」,他們可能會選擇使用該工具來幫助引導(dǎo)他們完成決策過程。

在這種情況下,P4 可以幫助減輕代理者的一些負(fù)擔(dān),而不一定要給他們一個非黑即白的答案。

舉例來說,它可能會建議某人「有可能」或「不太可能」對某項治療產(chǎn)生某種感覺,或者給出一個百分比,表明答案正確或錯誤的可能性有多大。

Kaplan可以想象,像P4這樣的工具在Sophie這樣的情況下會很有幫助。因為在這種情況下,不同的家庭成員可能會對一個人的醫(yī)療護(hù)理有不同的意見。向這些家庭成員提供該工具,能夠幫助他們共同做出決定。

它還可以幫助指導(dǎo)那些沒有代理人的人做出護(hù)理決定。

Kaplan是休斯頓Ben Taub醫(yī)院的一名內(nèi)科醫(yī)生,該醫(yī)院是一家「安全網(wǎng)」醫(yī)院,無論病人是否有醫(yī)療保險,都會接受治療,很多病人都是無證件者、被監(jiān)禁者和無家可歸者。

當(dāng)Kaplan見到這些病人時,他們往往已處于水深火熱之中,處于疾病的晚期。他們中的許多人無法討論自己的護(hù)理問題,有些人也沒有家人可以代表他們說話。

Kaplan表示,她可以想象像P4這樣的工具會在這樣的情況下使用,讓醫(yī)生更深入地了解病人可能想要什么。

例如,在這種情況下,可能很難找到病人的社交媒體資料。但其他信息可能會被證明是有用的。

Wendler說,如果某些信息被證明是一個預(yù)測因子,他就會希望它出現(xiàn)在模型中。

「如果人們的頭發(fā)顏色、上小學(xué)的地點或姓氏的第一個字母被證明可以『預(yù)測一個人的愿望』,那么我就想把它們加進(jìn)去。」

Earp和他的同事們已經(jīng)開始進(jìn)行調(diào)查,以了解個人對使用 P4 的感受。

這項研究仍在進(jìn)行中,但早期的反饋表明,如果沒有可用的人類代理者,人們也愿意嘗試這種模型。

Earp說他也有同感。他還說,如果P4和代理人給出的預(yù)測不同,「我可能會聽從了解我的人的意見,而不是模型」。

它不是人類

Earp的感受出賣了許多人的直覺——這些重大決定最好由人來做出。

瑞士洛桑聯(lián)邦理工學(xué)院研究員Georg Starke也表示,「問題是,我們希望如何做出臨終決定,以及由誰來做出決定?」

而且,即使一個人在之前的筆記、信息和社交媒體帖子中明確表達(dá)了自己的意愿,但在身臨其境之前也很難知道自己對醫(yī)療狀況的感受。

Kaplan曾治療過一位患有骨質(zhì)疏松癥的80歲老人,他一直堅持說,如果心臟停止跳動,他希望接受胸外按壓。但當(dāng)這一時刻到來時,他的骨頭太薄太脆,無法承受按壓。

Kaplan記得,這位老人能聽得到自己的骨頭「像牙簽一樣」斷裂,胸骨從肋骨上脫落。

「然后我就想,我們在做什么?我們在幫助誰?會有人真的想要這樣嗎?」Kaplan說道。

還有其他令人擔(dān)憂的問題。

首先,根據(jù)一個人在社交媒體上發(fā)布的信息訓(xùn)練出來的人工智能最終可能并不完全是一個「心理數(shù)字孿生」 。

「任何一個在社交媒體上發(fā)表過文章的人都知道,我們在社交媒體上發(fā)布的內(nèi)容往往并不能代表我們的真實想法、價值觀或需求。」

而且,人工智能并不穩(wěn)定,即使是微妙地改變給人工智能模型的提示,也會讓你得到完全不同的回答。想到我們要把如此重要的決定交給如此隨機的AI,「這太可怕了」。

另一方面,人類也是容易犯錯的。貝勒醫(yī)學(xué)院的生物倫理學(xué)家Vasiliki Rahimzadeh認(rèn)為,P4 是個好主意,前提是必須經(jīng)過嚴(yán)格測試。

她說,「我們對這些技術(shù)的要求不應(yīng)該高于我們對自己的要求。」

Earp和Wendler也承認(rèn)他們面臨著挑戰(zhàn)。

他們希望自己建立的工具可以捕捉到有用的信息,既能反映一個人的意愿,又不侵犯隱私;他們希望該工具能成為患者和代理人可以選擇使用的有用指南,而不是就患者的護(hù)理問題給出非黑即白的最終答案的默認(rèn)方式。

可即使他們在這些方面取得了成功,他們也可能無法控制這種工具的最終使用方式。

以Sophie的案例為例。如果使用 P4,其預(yù)測結(jié)果可能只會進(jìn)一步破壞本已面臨壓力的家庭關(guān)系。

Wendler坦言,「我最擔(dān)心的是誰來控制它。他擔(dān)心醫(yī)院可能會濫用P4等工具」,他說,「這中間有各種各樣的經(jīng)濟(jì)因素。」

參考資料:https://www.technologyreview.com/2024/08/01/1095551/end-of-life-decisions-ai-help/