仿真迎來終局?上交&英偉達提出OmniRe:性能直接拉爆StreetGS四個點!!!

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

自動駕駛仿真重建的終局???上交和英偉達等團隊最新的工作OmniRe,性能直接拉爆了一眾算法,PSNR超越StreetGS四個多點!!!可謂是3DGS的集大成者。具體來說,OmniRe將動態目標分為剛體和非剛體,車輛和行人/騎行人的步態重建的性能非常驚艷!背景是比較常見的background+sky。靜態要素的重建效果也非常棒,像紅綠燈,車道線等等。

寫在前面&筆者的個人理解

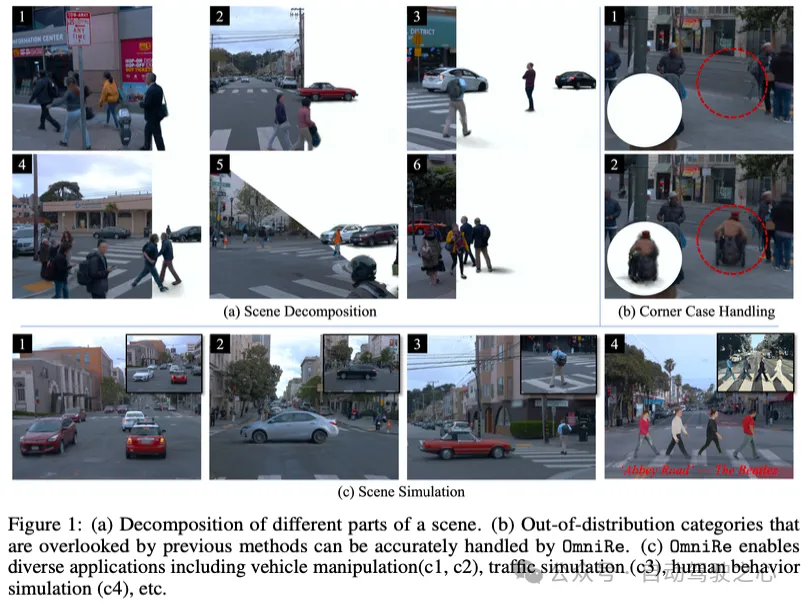

本文介紹了OmniRe,這是一種高效重建高保真動態城市場景的整體方法。最近使用神經輻射場或高斯splatting對駕駛序列進行建模的方法已經證明了重建具有挑戰性的動態場景的潛力,但往往忽視了行人和其他非車輛動態參與者,阻礙了動態城市場景重建的完整流程。為此,我們提出了一種用于駕駛場景的全面3DGS框架,稱為OmniRe,它允許對駕駛過程中的各種動態目標進行準確、完整的重建。OmniRe基于高斯表示構建動態神經場景圖,并構建多個局部規范空間,對各種動態參與者進行建模,包括車輛、行人和騎行人等。這種能力是現有方法無法比擬的。OmniRe允許我們全面重建場景中存在的不同目標,隨后能夠實時模擬所有參與者參與的重建場景(~60 Hz)。對Waymo數據集的廣泛評估表明,我們的方法在定量和定性上都大大優于先前最先進的方法。我們相信,我們的工作填補了推動重建的關鍵空白。

項目主頁:https://ziyc.github.io/omnire/

文章簡介

隨著自動駕駛越來越多地采用端到端模型,對可擴展且無域差異的仿真環境的需求變得更加明顯,這些環境可以在閉環仿真中評估這些系統。盡管使用藝術家生成資源的傳統方法在規模、多樣性和逼真度方面達到了極限,但數據驅動方法在生成數字孿生體方面的進展,通過從設備日志中重建仿真環境,提供了強有力的替代方案。確實,神經輻射場(NeRFs)和高斯點云(GS)已經成為重建具有高視覺和幾何保真度的3D場景的強大工具。然而,準確且全面地重建動態駕駛場景仍然是一個重大挑戰,特別是由于現實環境中多樣化的參與者和運動類型的復雜性。

已經有若干工作嘗試解決這一挑戰。早期的方法通常忽略動態參與者,僅專注于重建場景的靜態部分。后續的工作則旨在通過以下兩種方式之一來重建動態場景:(i) 將場景建模為靜態和時間依賴的神經場的組合,其中不同場景部分的分解是一種自發屬性,或者(ii) 構建一個場景圖,其中動態參與者和靜態背景被表示為節點,并在其標準框架中重建和表示。場景圖的節點通過編碼相對變換參數的邊連接,這些參數表示每個參與者隨時間的運動。盡管前者是一種更通用的公式化方法,后者提供了更高的可編輯性,并且可以直接用經典行為模型進行控制。然而,場景圖方法仍然主要關注可以表示為剛體的車輛,從而在很大程度上忽略了其他在駕駛仿真中至關重要的易受傷害的道路使用者(VRUs),如行人和騎自行車者。

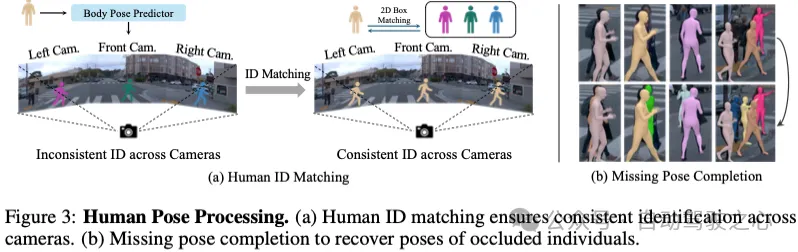

為了填補這一關鍵空白,本文的工作旨在對所有動態參與者進行建模,包括車輛、行人和騎自行車者等。與在工作室中使用多視角系統建模目標不同,從室外場景中重建動態參與者極具挑戰性。以人類為例,從部分觀察中重建人類本身就是一個具有挑戰性的問題,在駕駛場景中,由于傳感器觀察分布不利、環境復雜且頻繁遮擋,這一問題變得更加復雜。事實上,即使是最先進的人體姿態預測模型,也常常難以預測出準確的姿態,特別是對于那些距離較遠或被其他物體遮擋的行人(例如圖3)。此外,還有其他動態參與者,如輪椅上的個人或推嬰兒車的人,這些都無法簡單地用參數化模型來進行建模。

為了應對這些相互強化的挑戰,本文提出了一個能夠處理多樣化參與者的“全景”系統。本文的方法OmniRe高效地重建了包含靜態背景、駕駛車輛和非剛性運動動態參與者的高保真動態駕駛場景(見圖1)。具體來說,本文基于高斯點云表示構建了一個動態神經場景圖,并為不同的動態參與者構建了專用的局部標準空間。遵循“因材施教”的原則,OmniRe利用了不同表示方法的集體優勢:(i) 車輛被建模為靜態高斯,通過剛體變換模擬其隨時間的運動;(ii) 近距離行走的行人使用基于模板的SMPL模型進行擬合,通過線性混合蒙皮權重(linear blend skinning weights)實現關節級控制;(iii) 遠距離和其他無模板的動態參與者則使用自監督變形場(deformation fields)進行重建。這種組合允許對場景中大多數感興趣的目標進行準確表示和可控重建。更重要的是,本文的表示方法可以直接適用于自動駕駛仿真中常用的行為和動畫模型(例如圖1-(c))。

總結來說,本文的主要貢獻如下:

- 本文提出了OmniRe,這是一種動態駕駛場景重建的整體框架,在參與者覆蓋和表示靈活性方面體現了“全景”原則。OmniRe利用基于高斯表示的動態神經場景圖來統一重建靜態背景、駕駛車輛和非剛性運動的動態參與者(第4節)。它能夠實現高保真的場景重建,從新視角進行傳感器仿真,以及實時可控的場景編輯。

- 本文解決了從駕駛日志中建模人類和其他動態參與者所面臨的挑戰,例如遮擋、復雜環境以及現有人體姿態預測模型的局限性。本文的研究結果基于自動駕駛場景,但可以推廣到其他領域。

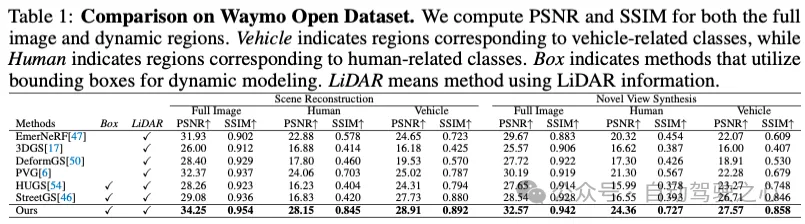

- 本文進行了大量實驗和消融研究,以展示本文整體表示方法的優勢。OmniRe在場景重建和新視點合成(NVS)方面達到了最先進的性能,在完整圖像指標上顯著超越了以往的方法(重建提高了1.88的PSNR,NVS提高了2.38的PSNR)。對于動態參與者,如車輛(提高了1.18的PSNR)和人類(重建提高了4.09的PSNR,NVS提高了3.06的PSNR),差異尤為顯著。

相關工作回顧

動態場景重建。神經表征是主導的新視角合成。這些已經以不同的方式進行了擴展,以實現動態場景重建。基于變形的方法和最近的DeformableGS提出使用規范空間的3D神經表示來對動態場景進行建模,并結合將時間依賴觀測值映射到規范變形的變形網絡。這些通常僅限于運動受限的小場景,不足以應對具有挑戰性的城市動態場景。基于調制的技術通過直接將圖像時間戳(或潛碼)作為神經表示的額外輸入來操作。然而,這通常會導致公式構建不足,因此需要額外的監督,例如深度和光流(Video NeRF和NSFF),或從同步相機捕獲的多視圖輸入(DyNeRF和Dynamic3DGS)。D2NeRF提出通過將場景劃分為靜態和動態場來擴展這一公式。在此之后,SUDS和EmerNeRF在動態自動駕駛場景中表現出了令人印象深刻的重建能力。然而,它們使用單個動態場對所有動態元素進行建模,而不是分別建模,因此它們缺乏可控性,限制了它們作為傳感器模擬器的實用性。將場景顯式分解為單獨的代理可以單獨控制它們。這些代理可以表示為場景圖中的邊界框,如神經場景圖(NSG),該圖在UniSim、MARS、NeuRAD、ML-NSG和最近的基于高斯的作品StreetGaussians、DrivingGaussians和HUGS中被廣泛采用。然而,由于時間無關表示的限制或基于變形的技術的限制,這些方法僅處理剛性目標。為了解決這些問題,OmniRe提出了一種高斯場景圖,該圖結合了剛性和非剛性目標的各種高斯表示,為各種參與者提供了額外的靈活性和可控性。

人體重建。人體具有可變的外觀和復雜的運動,需要專門的建模技術。NeuMan建議使用SMPL身體模型將射線點扭曲到規范空間。這種方法能夠重建非剛性人體,并保證精細控制。同樣,最近的研究,如GART、GauHuman和HumanGaussians,將高斯表示和SMPL模型相結合。然而,這些方法在野外并不直接適用。然而,這些方法僅關注形狀和姿態估計,在外觀建模方面存在局限性。相比之下,我們的方法不僅對人體外觀進行建模,還將這種建模整合到一個整體的場景框架中,以實現全面的解決方案。城市場景通常涉及眾多行人,觀察稀少,通常伴隨著嚴重的遮擋。

OmniRe方法詳解

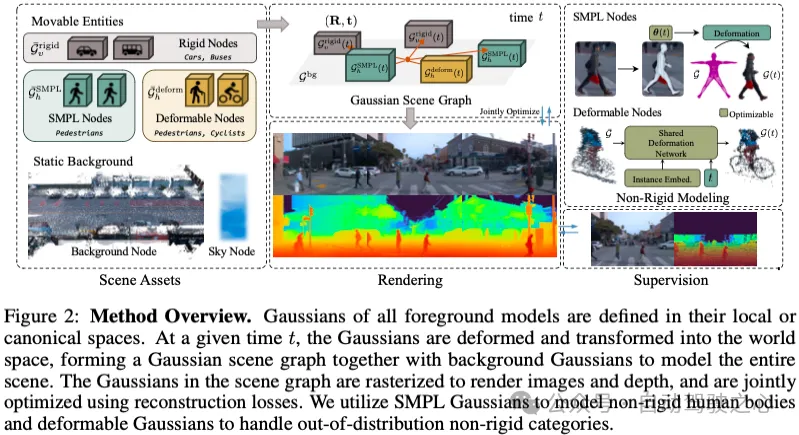

如圖2所示,OmniRe構建了一個高斯場景圖表示,它全面覆蓋了靜態背景和各種可移動實體。

Dynamic Gaussian Scene Graph Modeling

Gaussian Scene Graph:為了在不犧牲重建質量的情況下靈活控制場景中的各種可移動目標,本文選擇高斯場景圖表示。我們的場景圖由以下節點組成:(1)一個表示遠離自車的天空的天空節點,(2)一個代表建筑物、道路和植被等靜態場景背景的背景節點,(3)一組剛性節點,每個節點代表一個可剛性移動的物體,如車輛,(4)一組模擬行人或騎行人的非剛性節點。類型為(2,3,4)的節點可以直接轉換為世界空間高斯分布。這些高斯分布被連接起來,并使用[17]中提出的光柵化器進行渲染。天空節點由一個優化的環境紋理貼圖表示,單獨渲染,并與具有簡單阿爾法混合的光柵化高斯圖像組成。

Background Node:背景節點由一組靜態高斯表示。這些高斯是通過累積激光雷達點和隨機生成的額外點來初始化的。

Rigid Nodes:剛性目標由該目標的局部空間和車輛位姿表示。

Non-Rigid Nodes:與剛性車輛不同,行人和騎行人等非剛性動態類都與人類有關,需要額外考慮他們在世界空間中的全局運動和在局部空間中的連續變形,以準確重建他們的動態。為了能夠完全解釋底層幾何結構的重建,我們將非剛性節點進一步細分為兩類:用于步行或跑步行人的SMPL節點,具有支持關節水平控制的SMPL模板,以及用于分布外的非剛性實例(如騎自行車者和其他無模板的動態實體)的可變形節點。

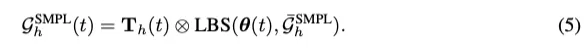

Non-Rigid SMPL Nodes:SMPL提供了一種表示人體姿態和變形的參數化方法,因此我們使用模型參數來驅動節點內的3D高斯分布。

Non-Rigid Deformable Nodes:這些節點充當分布外非剛性實例的回退選項,例如,即使是最先進的SMPL預測器也無法提供準確估計的極其遙遠的行人;或長尾模板較少的非剛性實例。因此,我們建議使用通用的變形網絡來擬合節點內的非剛性運動。具體來說,對于節點h,世界空間高斯分布定義為:

Sky Node:同[6,47]一樣,本文使用單獨的環境地圖來適應觀察方向的天空顏色。我們得到的最終渲染結果如下:

Reconstructing In-the-Wild Humans

為了初始化非剛性SMPL節點的參數,我們擴展了一個現成的預測器4D Humans,該預測器根據原始視頻輸入估計人體姿勢。然而它存在幾個實際限制,阻礙了它在我們的環境中的可用性。我們通過以下模塊討論并解決這些挑戰,以在頻繁遮擋的情況下,從野外拍攝的多視圖圖像中預測準確且時間一致的人體姿勢。

- Human ID Matching:4D Humans僅設計用于處理單目視頻。在我們的環視設置中,這種限制導致同一個人在不同視圖之間失去聯系(圖3(a))。為了解決這個問題,我們使用檢測和GT框之間的mIoU將檢測到的人的估計姿態與數據集中的GT ID進行匹配,確保在環視中一致地識別出每個行人。

- Missing Pose Completion:4D Humans很難預測被占用個體的SMPL姿勢,這在自動駕駛場景中很常見,導致預測缺失。我們通過從相鄰幀中插值姿勢來恢復丟失的姿勢。如圖3(b)所示,該過程能夠為被占用的個體恢復準確的姿勢,從而實現暫時完整的姿勢序列。

- Scene-Pose Alignment:作為一個與相機無關的通用模型,4D Humans假設一個虛擬相機的所有視頻輸入參數都是固定的。相比之下,真實的相機具有不同的參數。這會導致預測姿勢的比例和位置與現實世界坐標系之間的錯位。我們使用每個人可用的box大小和位置數據來校正預測姿勢的比例和位置。

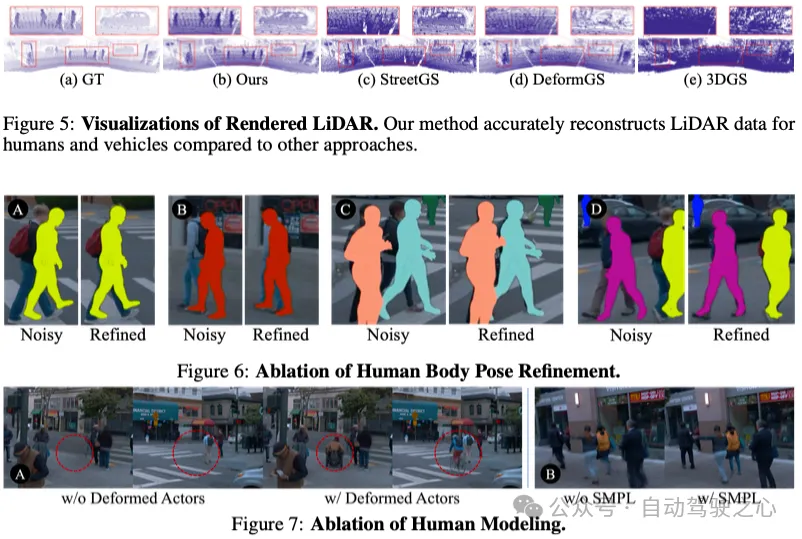

- Pose Refinement:姿態預測器、插值和對齊估計的誤差會導致人體姿態噪聲。我們利用這些嘈雜的姿態來初始化SMPL節點的動態,并在訓練過程中通過優化重建損失來聯合細化每個個體的每幀姿態。我們的消融研究表明,人體姿態細化對于提高重建質量和姿態精度至關重要。

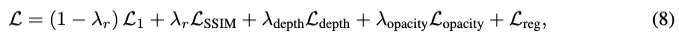

整體的訓練損失如下:

實驗結果

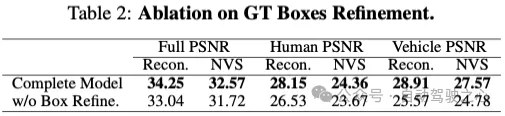

我們使用每10幀作為NVS的測試集,在場景重建和新視圖合成(NVS)任務中評估我們的方法。我們報告了完整圖像以及與人類和車輛相關區域的PSNR和SSIM評分,以評估動態重建能力。表1中的定量結果表明,OmniRe優于所有其他方法,在與人類相關的區域有顯著的優勢,驗證了我們對動態參與者的整體建模。此外,雖然StreetGS和我們的方法以類似的方式對車輛進行建模,但我們觀察到,即使在車輛區域,OmniRe也略優于StreetGS。這是由于StreetGS中缺乏人體建模,這使得來自人體區域的監控信號(如顏色、激光雷達深度)會錯誤地影響車輛建模。StreetGS面臨的問題是我們對場景中幾乎所有內容進行整體建模的動機之一,旨在消除錯誤的監督和意外的梯度傳播。

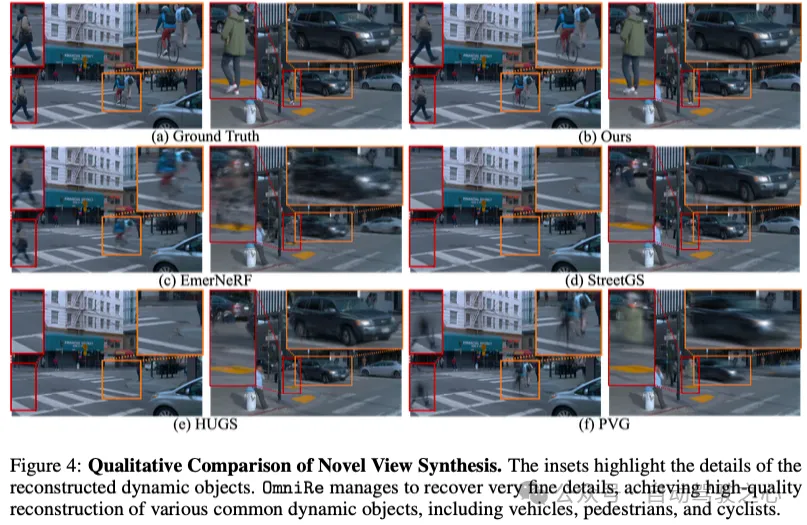

此外,我們在圖4中顯示了可視化,以定性評估模型性能。盡管PVG在場景重建任務中表現良好,但在高度動態的場景中,它難以完成新穎的視圖合成任務,導致新穎視圖中的動態目標模糊(圖4-f)。HUGS(圖4-e)、StreetGS(圖4-d)和3DGS(圖10-h)無法恢復行人,因為它們無法對非剛性物體進行建模。DeformableGS(圖10-g)在具有快速運動的室外動態場景中會出現極端運動模糊,盡管在室內場景和小運動的情況下取得了合理的性能。EmerNeRF在一定程度上重建了移動的人類和車輛的粗略結構,但難以處理精細的細節(圖4-c)。與所有這些方法相比,我們的方法忠真實地重建了場景中任何目標的精細細節,處理了遮擋、變形和極端運動。我們建議讀者查看我們的項目頁面,了解這些方法的視頻比較。

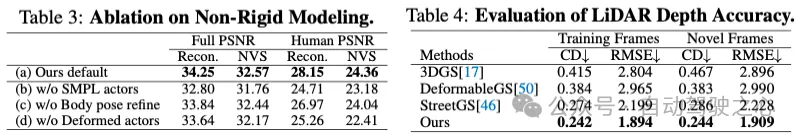

幾何形狀。除了外觀,我們還研究了OmniRe是否可以重建城市場景的精細幾何。我們評估了訓練幀和新幀上激光雷達深度重建的均方根誤差RMSE和CD。附錄中提供了評估程序的詳細信息。表4報告了結果。我們的方法遠遠優于其他方法。圖5顯示了與其他方法相比,我們的方法實現的動態參與者的精確重建。

結論

我們的方法OmniRe使用高斯場景圖進行全面的城市場景建模。它實現了快速、高質量的重建和渲染,為自動駕駛和機器人模擬帶來了希望。我們還為復雜環境中的人體建模提供了解決方案。未來的工作包括自我監督學習、改進的場景表示和安全/隱私考慮。

更廣泛的影響。我們的方法旨在解決自動駕駛模擬中的一個重要問題。這種方法有可能加強自動駕駛汽車的開發和測試,從而可能帶來更安全、更高效的自動駕駛系統。以安全可控的方式進行模擬仍然是一個開放且具有挑戰性的研究問題。

道德與隱私。我們的工作不包括收集或注釋新數據。我們使用符合嚴格道德準則的成熟公共數據集。這些數據集確保敏感信息(包括可識別的人類特征)被模糊或匿名化,以保護個人隱私。我們致力于確保我們的方法以及未來的應用程序以負責任和道德的方式使用,以維護安全和隱私。

限制。OmniRe仍然存在一些局限性。首先,我們的方法沒有明確地模擬光照效果,這可能會導致模擬過程中的視覺和諧問題,特別是在組合在不同光照條件下重建的元素時。應對這一不平凡的挑戰需要我們在當前工作范圍之外做出不懈的努力。對光效建模和增強模擬真實感的進一步研究對于實現更令人信服和和諧的結果仍然至關重要。其次,與其他每場景優化方法類似,當相機明顯偏離訓練軌跡時,OmniRe會產生不太令人滿意的新視圖。我們認為,整合數據驅動的先驗,如圖像或視頻生成模型,是未來探索的一個有前景的方向。