GPT-4結合SAM2:免訓練多模態分割的全新解決方案!| 已開源

免訓練多模態分割領域有了新突破!

中科院信工所、北航、合工大、美團等單位聯合提出了一種名為AL-Ref-SAM 2的方法。

這種方法利用GPT-4和SAM-2來統一多模態分割,讓系統在免訓練的情況下,也能擁有不亞于全監督微調的性能!

≥ 全監督方法

多模態分割主要有兩種方法:一種是依據文字描述找到視頻中特定對象的分割方法(RVOS),另一種是通過聲音識別視頻中發聲對象的方法(AVS)。

免訓練的多模態視頻指代分割雖然在數據和訓練成本上有較大優勢,卻由于缺乏在特定任務數據上針對性的模型參數調整,導致性能與全監督方法有較大差距。

而研究團隊要解決的就是這個問題。

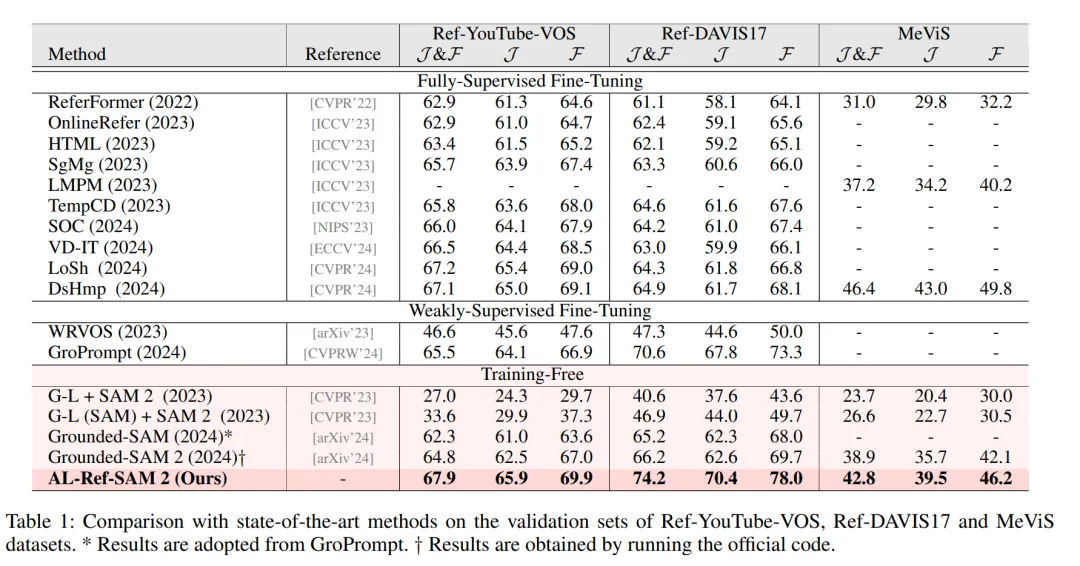

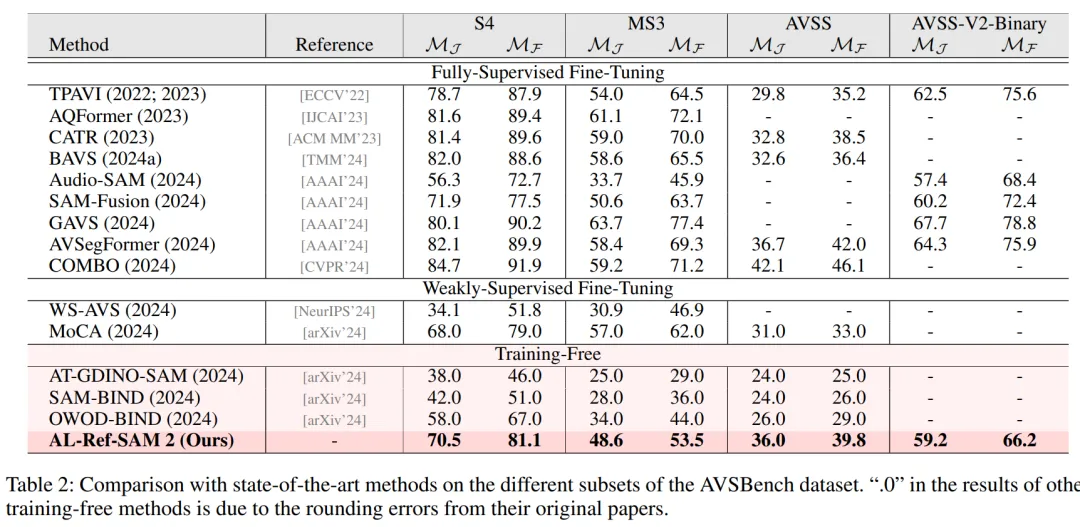

實驗中,他們對多個RVOS基準數據集進行了廣泛驗證,包括Ref-YouTube-VOS、Ref-DAVIS17和MeViS,同時在AVSBench的多個子集上也進行了測試。

最后的實驗結果顯示,AL-Ref-SAL 2在這些數據集上的表現不僅優于其他無需訓練和弱監督的方法,并且甚至在一定情況下,系統的性能可以與全監督方法相媲美。

特別是在Ref-YouTube-VOS和Ref-DAVIS17這兩個數據集上,AL-Ref-SAM 2的表現甚至超過了大多數全監督方法。

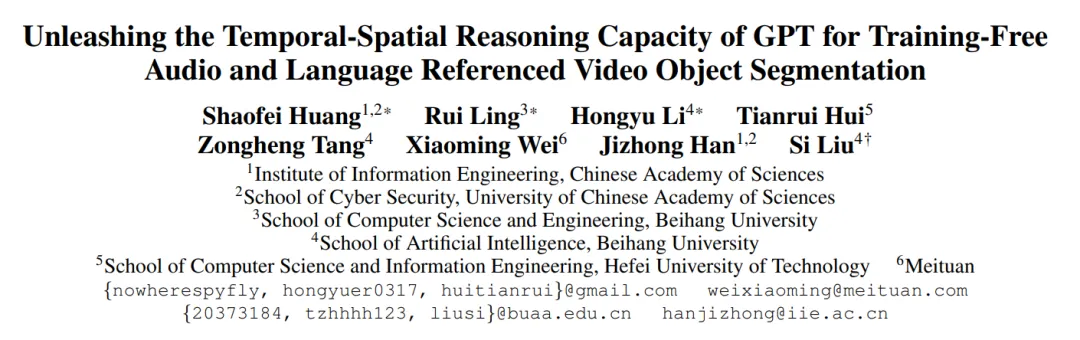

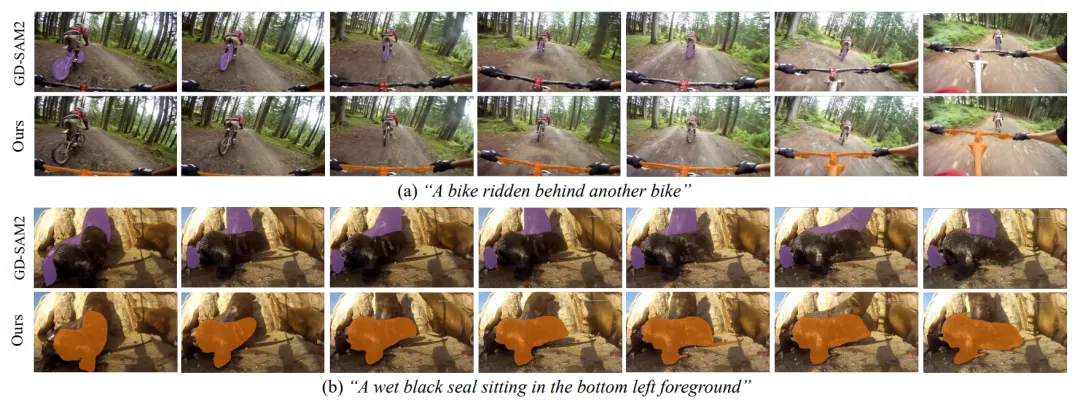

△ 免訓練設置下三階段分割基線方法(a)與本文方法(b)的比較

具體咋實現的?

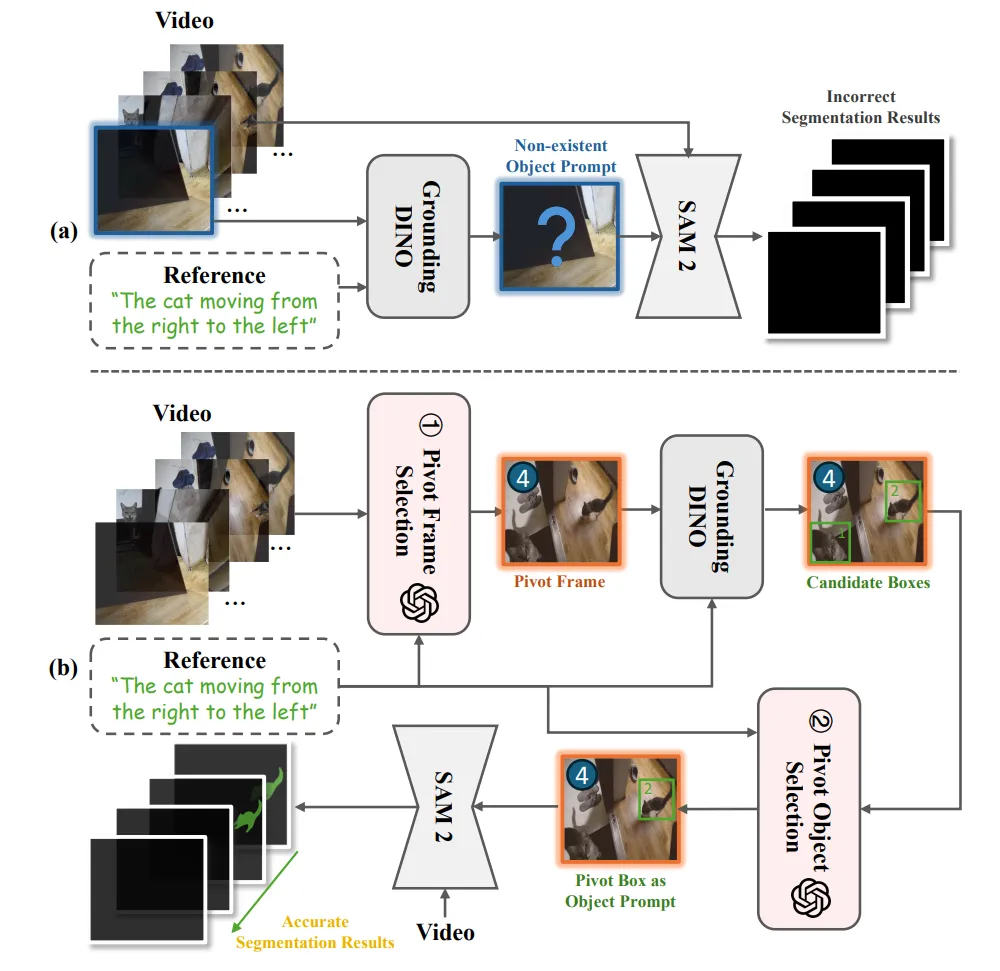

研究團隊把AL-Ref-SAM 2的算法分成了三個階段:

第一階段:獲取形式統一的指代信息,對于RVOS任務,指代信息是輸入的文本描述本身,而對于AVS任務,研究人員們利用LBRU模塊將音頻轉化為對發聲對象的語言形式描述。

第二階段:根據語言指代和視頻內容,利用GPT-4進行兩階段時空推理,從視頻中逐步選出關鍵幀和關鍵框。

第三階段:以關鍵幀為分割起點,關鍵框為初始提示,利用SAM 2獲得目標對象在整段視頻中的分割掩碼序列。

△ AL-Ref-SAM 2的整體流程

具體實驗細節,請看下文展開~

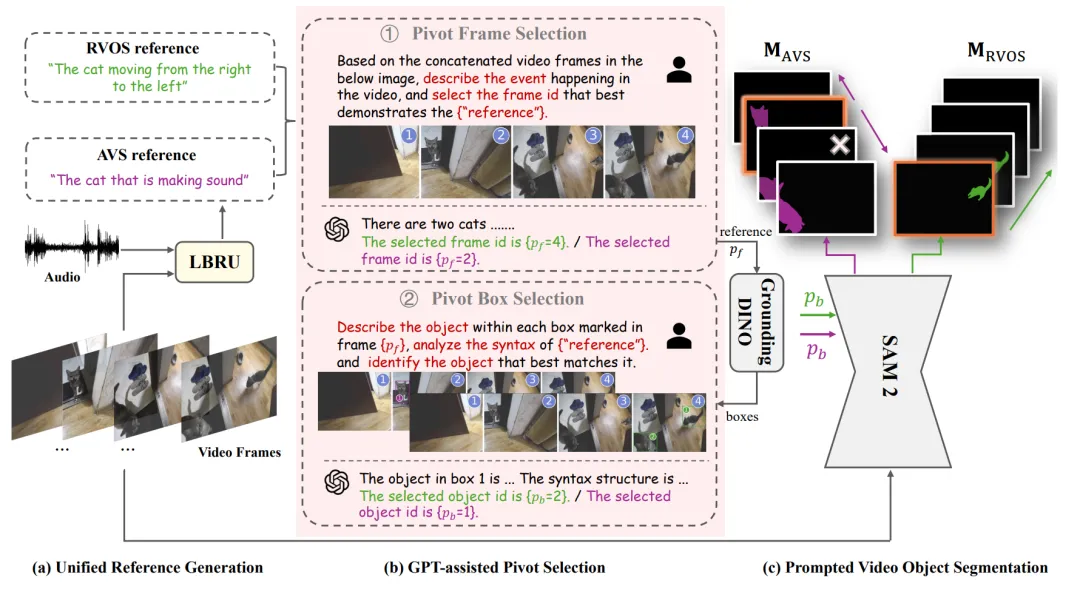

語言綁定的音頻指代轉換(LBRU)

LBRU將音頻信號轉換為與語言描述統一的格式(例如“[CLS] that is making sound”,其中[CLS]代表了具體的發聲對象類別),以減少音頻信息中的語義模糊性和冗余性。

為了獲取發聲對象的準確類別,LBRU利用了一個預訓練音頻分類器,如BEATs,對音頻進行分類,并保留置信度前k高的類別文本。

由于這些類別中可能包含了重復類別或背景聲類別,LBRU進一步引入了視頻作為視覺上下文,利用GPT-4根據視頻內容對音頻類別進行過濾、合并,并將保留的音頻類別轉化為發出該聲音的對象類別。

△ 語言綁定的音頻指代轉換模塊

GPT輔助的關鍵幀/框選擇(GPT-PS)

GPT-PS利用GPT-4分別進行時序推理選出關鍵幀,以及空間推理選出關鍵框。

在時序推理階段,為了使GPT可以處理視頻格式的內容,研究團隊首先對視頻幀進行采樣,將采樣后的若干幀拼接為一張圖并在圖上標出幀號。

為了顯式引導GPT在理解視頻內容的基礎上選擇關鍵幀,他們還針對性地設計了關鍵幀思維鏈提示模板,要求GPT首先描述整段視頻的場景,再根據語言指代選出關鍵幀。

之后,研究人員將語言指代信息和關鍵幀輸入GroundingDINO模型中,獲得多個可能的候選框。

在空間推理階段,首先將候選框畫在關鍵幀上,并且依舊將其與其他采樣幀順序拼接作為視覺信號輸入GPT。

類似地,他們也設計了關鍵框思維鏈提示模板,要求GPT描述每個候選框中對象的特征和不同對象之間的關系,并對指代信息進行語法分析確定真正的指代主體,最后再根據語言指代選出包含目標對象的候選框作為關鍵框。

以下是研究團隊得出的相關數據:

論文鏈接:https://arxiv.org/pdf/2408.15876

代碼鏈接:https://github.com/appletea233/AL-Ref-SAM2