Qwen2.5登上全球開(kāi)源王座!72B模型擊敗LIama3 405B,輕松勝過(guò)GPT-4o-mini

擊敗LIama3!Qwen2.5登上全球開(kāi)源王座。

而后者僅以五分之一的參數(shù)規(guī)模,就在多任務(wù)中超越LIama3 405B。

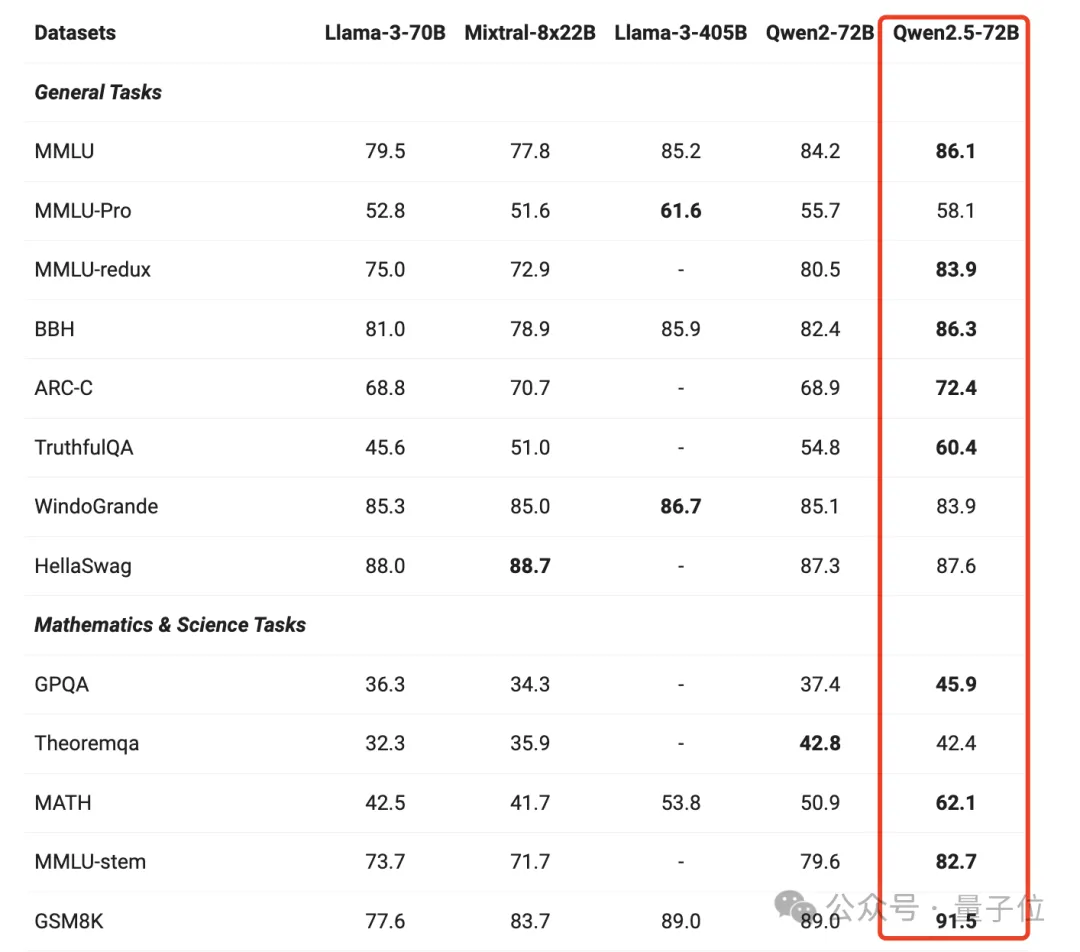

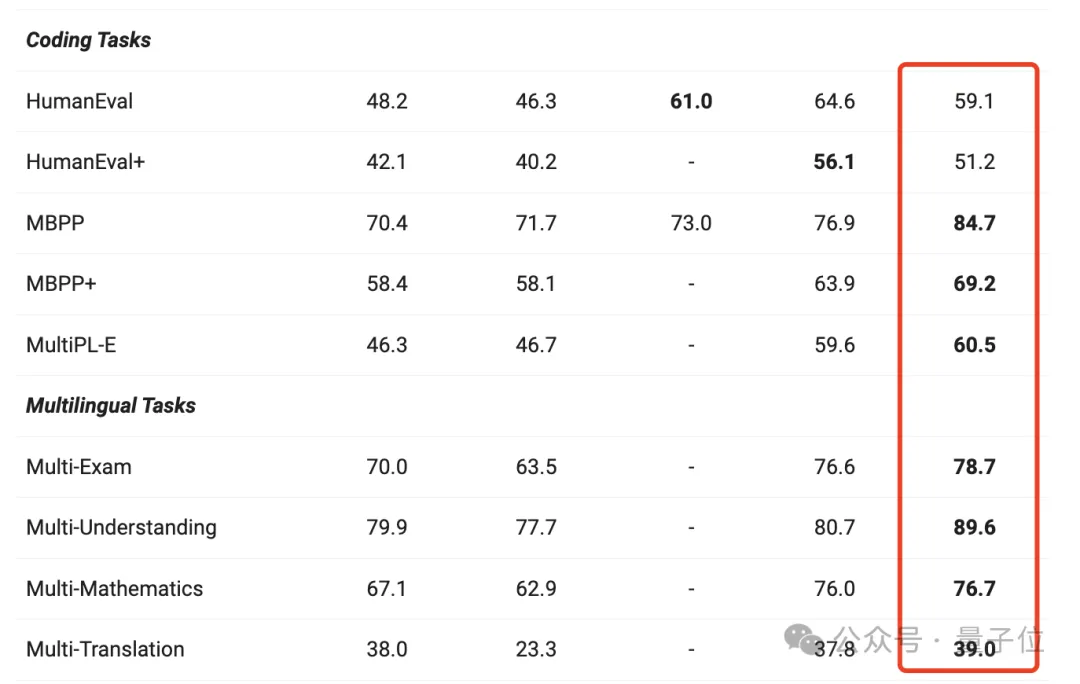

各種任務(wù)表現(xiàn)也遠(yuǎn)超同類別的其他模型。

跟上一代相比,幾乎實(shí)現(xiàn)了全面提升,尤其在一般任務(wù)、數(shù)學(xué)和編碼方面的能力表現(xiàn)顯著。

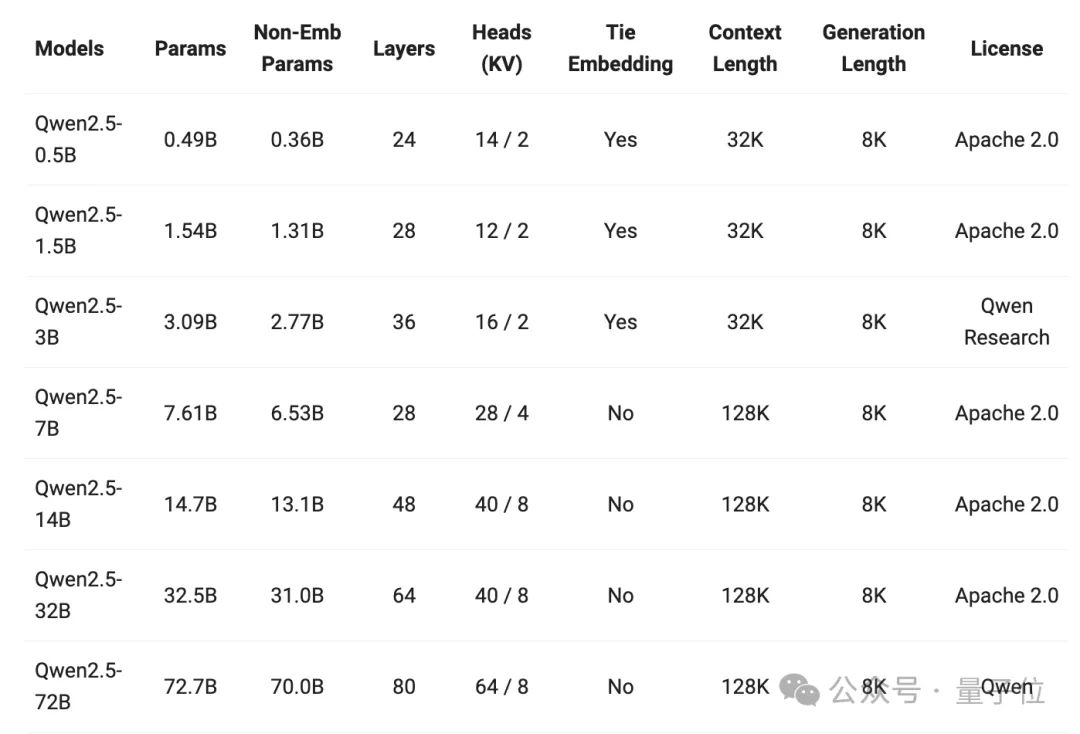

值得注意的是,此次Qwen可以說(shuō)是史上最大規(guī)模開(kāi)源,基礎(chǔ)模型直接釋放了7個(gè)參數(shù)型號(hào),其中還有六七個(gè)數(shù)學(xué)、代碼模型。

像14B、32B以及輕量級(jí)Turbo模型勝過(guò)GPT-4o-mini。

除3B和72B模型外,此次所有開(kāi)源模型均采用Apache 2.0許可。

- Qwen2.5:0.5B、1.5B、3B、7B、14B、32B和72B

- Qwen2.5-Coder:1.5B、7B和32B(on the way)

- Qwen2.5-Math:1.5B、7B和72B。

直接一整個(gè)眼花繚亂,已經(jīng)有網(wǎng)友開(kāi)始用上了。

Qwen2.5 72B與LIama3.1 405B水平相當(dāng)

相比于Qwen2系列,Qwen2.5系列主要有這么幾個(gè)方面升級(jí)。

首先,全面開(kāi)源。

他們研究表明,用戶對(duì)于生產(chǎn)用的10B-30B參數(shù)范圍以及移動(dòng)端應(yīng)用的3B規(guī)模的模型有濃厚興趣。

因此在原有開(kāi)源同尺寸(0.5/1.5/7/72B)基礎(chǔ)上,還新增了14B、32B以及3B的模型。

同時(shí),通義還推出了Qwen-Plus與Qwen-Turbo版本,可以通過(guò)阿里云大模型服務(wù)平臺(tái)的API服務(wù)進(jìn)行體驗(yàn)。

可以看到,超半數(shù)模型都支持128K上下文,最多可生成8K上下文。

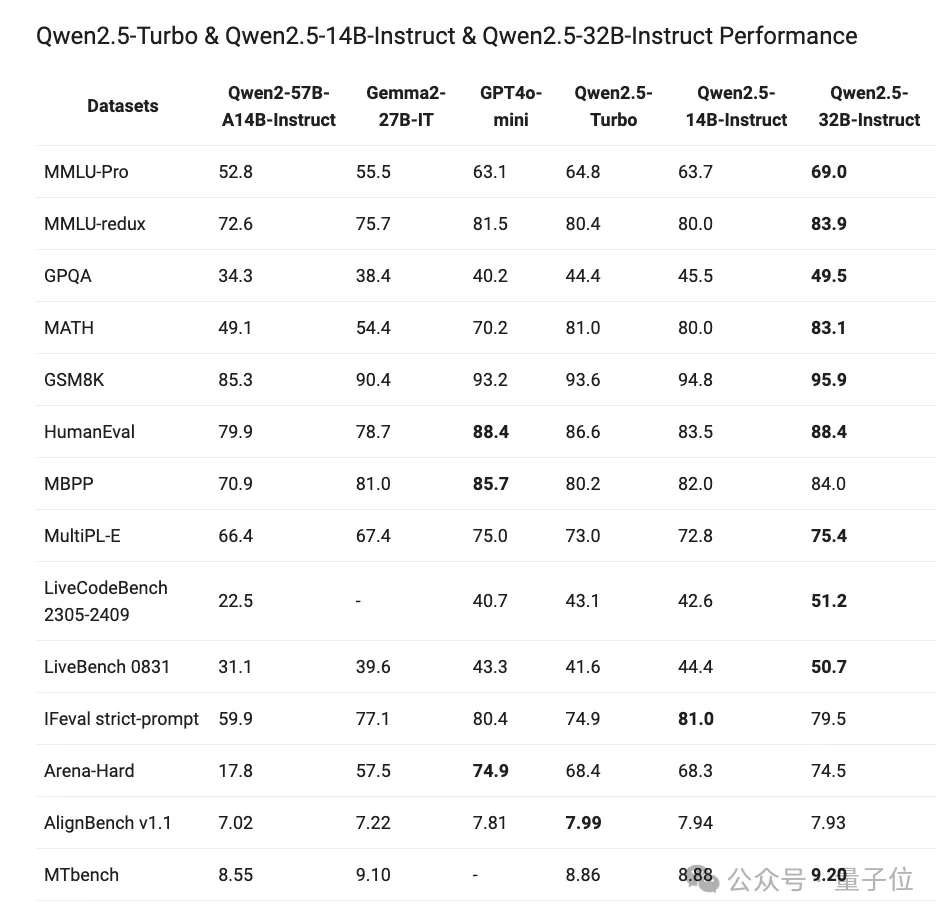

在他們的綜合評(píng)測(cè)中,所有模型跟上一代相比實(shí)現(xiàn)了能力的躍遷,比如Qwen2.5-32B勝過(guò)Qwen2-72B,Qwen2.5-14B勝過(guò)Qwen2-57B-A14B。

其次,預(yù)訓(xùn)練數(shù)據(jù)集更大更高質(zhì)量,從原本7萬(wàn)億個(gè)token擴(kuò)展到最多18萬(wàn)億個(gè)token。

然后就是多方面的能力增強(qiáng),比如獲得更多知識(shí)、數(shù)學(xué)編碼能力以及更符合人類偏好。

此外,還有在指令跟蹤、長(zhǎng)文本生成(從1k增加到8K以上token)、結(jié)構(gòu)化數(shù)據(jù)理解(如表格)和結(jié)構(gòu)化輸出生成(尤其是JSON)方面均有顯著提升。

來(lái)看看實(shí)際效果。

表格理解

生成JSON輸出

此外,Qwen2.5模型總體上對(duì)系統(tǒng)提示的多樣性具有更強(qiáng)的適應(yīng)能力,增強(qiáng)了聊天機(jī)器人的角色扮演實(shí)現(xiàn)和條件設(shè)定能力。

那么就來(lái)看看具體模型能力如何。

旗艦?zāi)P驮谇拔囊呀?jīng)看到,它在各個(gè)任務(wù)都有明顯的進(jìn)步。

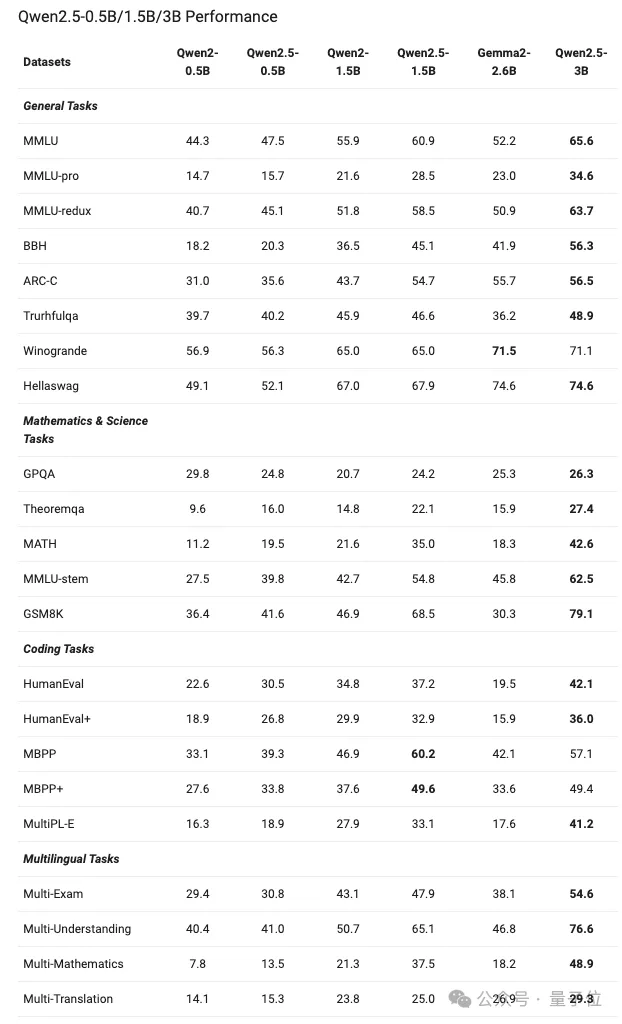

而像0.5B、1.5B以及3B這樣的小模型,性能大概是這樣的:

值得注意的是,Qwen2.5-0.5B型號(hào)在各種數(shù)學(xué)和編碼任務(wù)上的表現(xiàn)優(yōu)于Gemma2-2.6B。

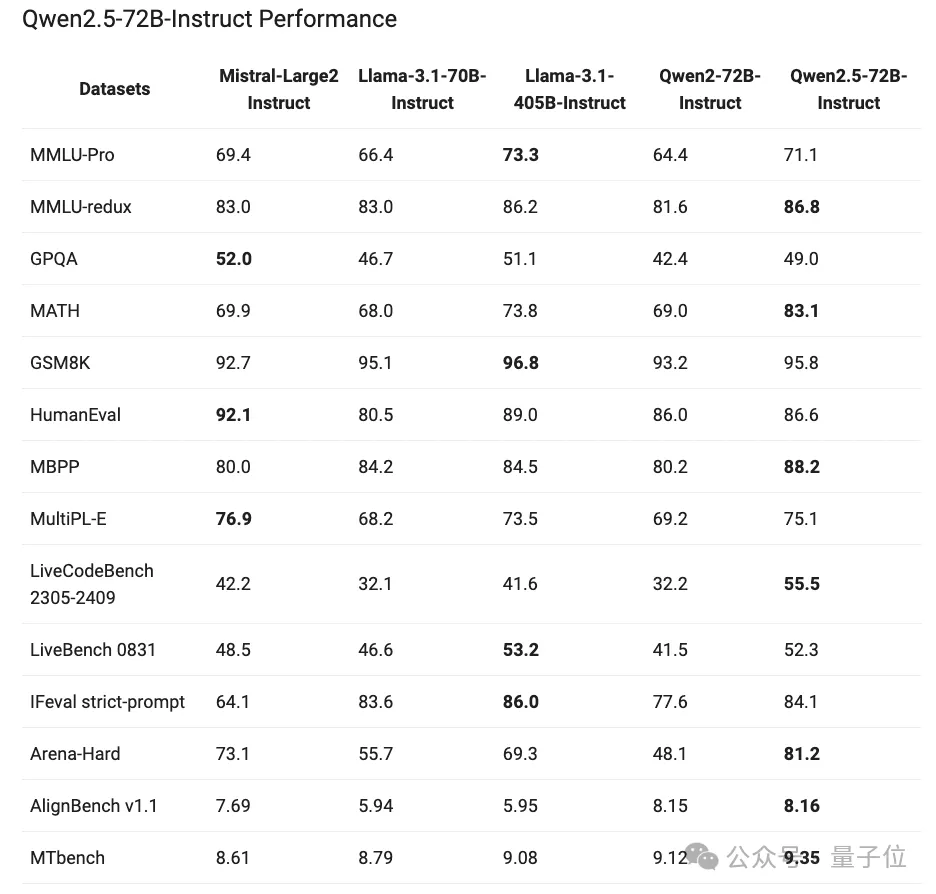

除此之外,Qwen2.5還展現(xiàn)了指令調(diào)優(yōu)之后的模型性能,72B-Instruct在幾項(xiàng)關(guān)鍵任務(wù)中超越了更大的Llama-3.1-405B,尤其在數(shù)學(xué)(MATH:83.1)、編碼(LiveCodeBench:55.5)和聊天(Arena-Hard:81.2)方面表現(xiàn)出色。

還有像32B-Instruct、14B-Instruct以及Qwen2.5-Turbo,展現(xiàn)了與GPT-4o-mini相當(dāng)?shù)哪芰Α?/p>

Qwen史上最大規(guī)模開(kāi)源

除了基礎(chǔ)模型,此次Qwen還放出了代碼和數(shù)學(xué)專業(yè)模型。

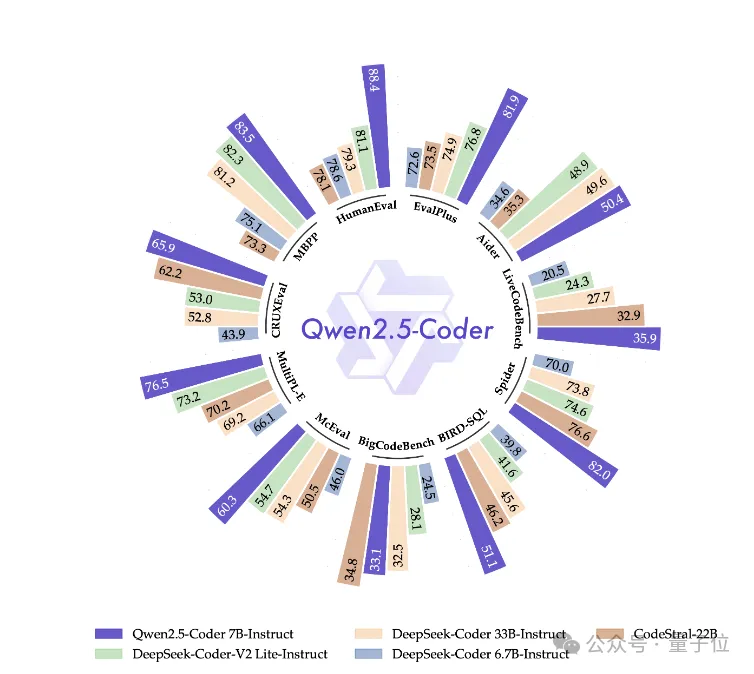

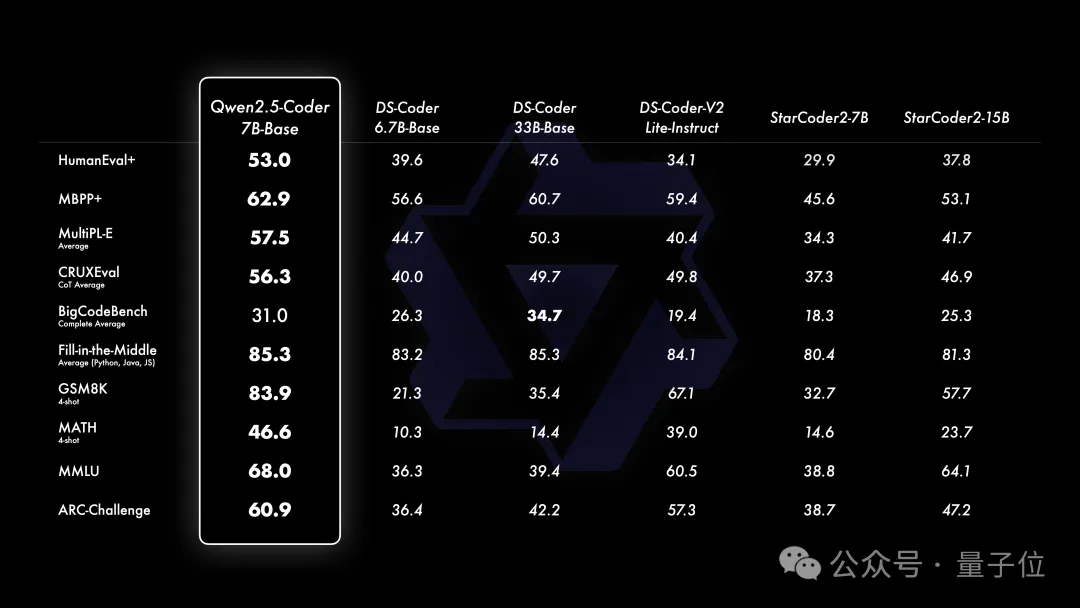

Qwen2.5-Coder提供了三種模型大小:1.5B、7B和32B版本(即將推出)。

主要有兩點(diǎn)改進(jìn):代碼訓(xùn)練數(shù)據(jù)規(guī)模的擴(kuò)大以及編碼能力的增強(qiáng)。

Qwen2.5-Coder在更大規(guī)模的代碼數(shù)據(jù)上進(jìn)行訓(xùn)練,包括源代碼、文本代碼基礎(chǔ)數(shù)據(jù)和合成數(shù)據(jù),總計(jì)5.5萬(wàn)億個(gè)token。

它支持128K上下文,覆蓋92種編程語(yǔ)言。開(kāi)源的7B版本甚至超越了DeepSeek-Coder-V2-Lite和Codestral等更大型的模型,成為目前最強(qiáng)大的基礎(chǔ)代碼模型之一。

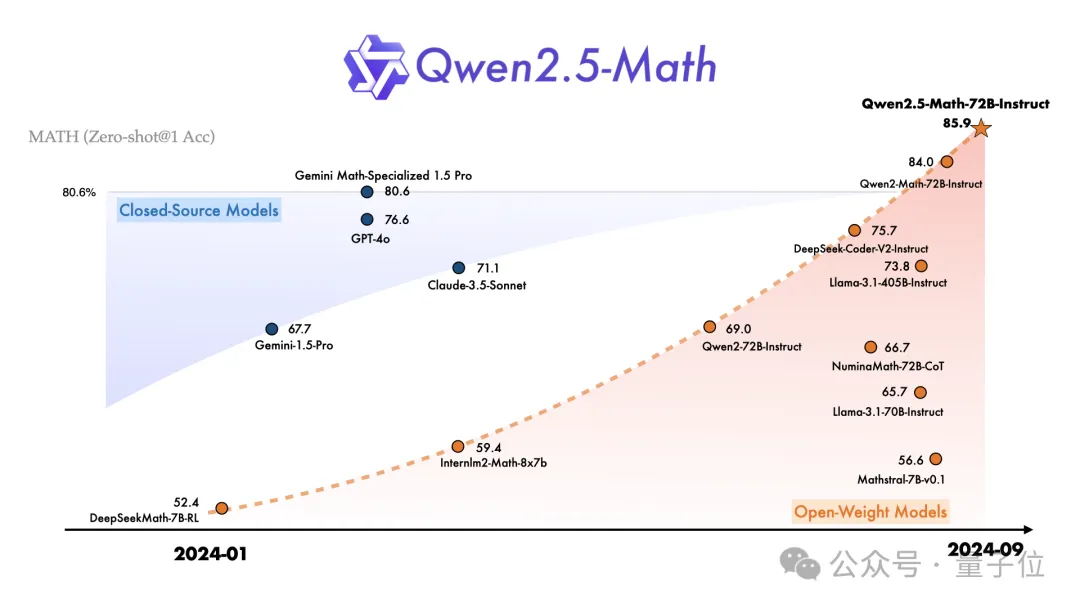

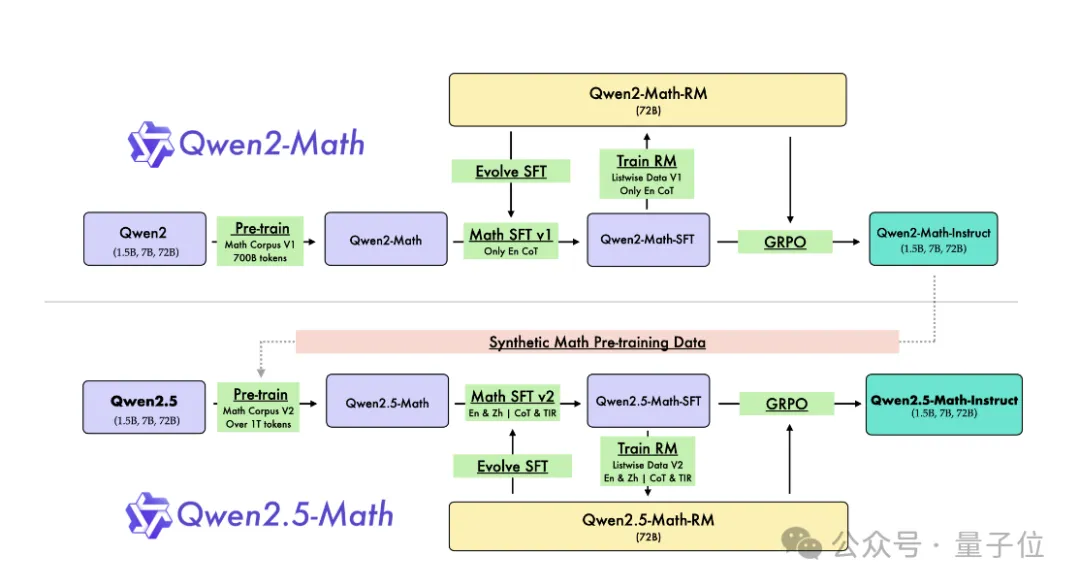

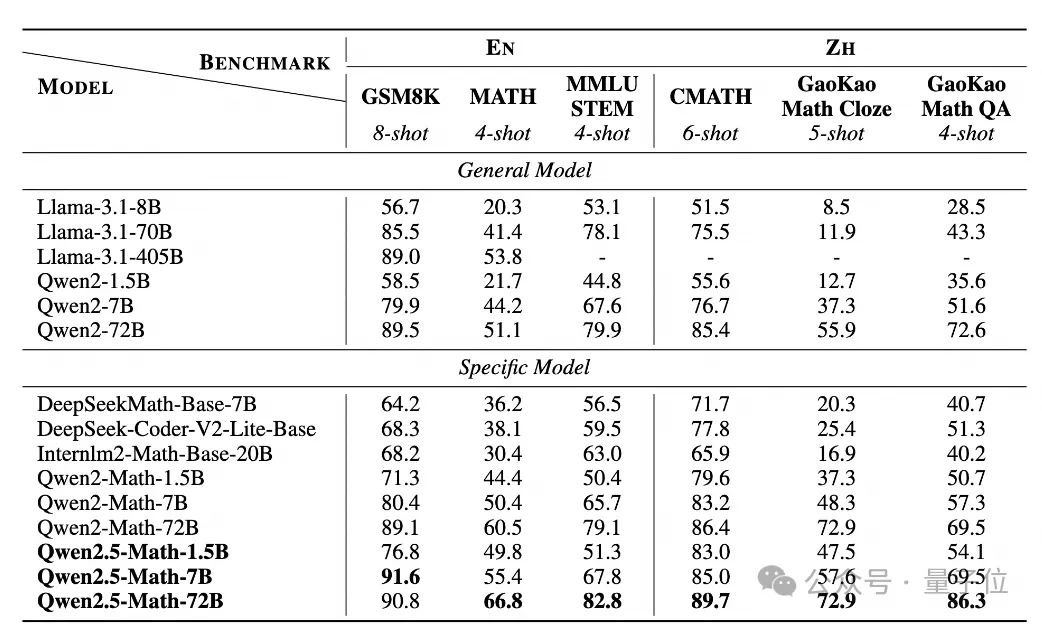

而數(shù)學(xué)模型這邊,Qwen2.5-Math主要支持通過(guò)CoT和TIR解決英文和中文數(shù)學(xué)問(wèn)題。

目前不建議將此系列模型用于其他任務(wù)。

Qwen2.5-Math這一系列開(kāi)源了包括基礎(chǔ)模型Qwen2.5-Math-1.5B/7B/72B、指令調(diào)優(yōu)模型Qwen2.5-Math-1.5B/7B/72B-Instruct,以及數(shù)學(xué)獎(jiǎng)勵(lì)模型Qwen2.5-Math-RM-72B。

與Qwen2-Math系列僅支持使用思維鏈(CoT)解決英文數(shù)學(xué)問(wèn)題不同,Qwen2.5-Math 系列擴(kuò)展支持使用思維鏈和工具集成推理(TIR)解決中英文數(shù)學(xué)問(wèn)題。

跟上一版本相比,他們主要干了這三件事來(lái)實(shí)現(xiàn)基礎(chǔ)模型升級(jí)。

利用Qwen2-Math-72B-Instruct模型來(lái)合成額外的高質(zhì)量數(shù)學(xué)預(yù)訓(xùn)練數(shù)據(jù)。

從網(wǎng)絡(luò)資源、書籍和代碼中收集更多高質(zhì)量的數(shù)學(xué)數(shù)據(jù),尤其是中文數(shù)據(jù),跨越多個(gè)時(shí)間周期。

利用Qwen2.5系列基礎(chǔ)模型進(jìn)行參數(shù)初始化,展現(xiàn)出更強(qiáng)大的語(yǔ)言理解、代碼生成和文本推理能力。

最終實(shí)現(xiàn)了能力的提升,比如1.5B/7B/72B在高考數(shù)學(xué)問(wèn)答中分別提升了 3.4、12.2、19.8 分。

好了,以上是Qwen2.5系列一整套堪稱「史上最大規(guī)模」的開(kāi)源。

不叫草莓叫獼猴桃

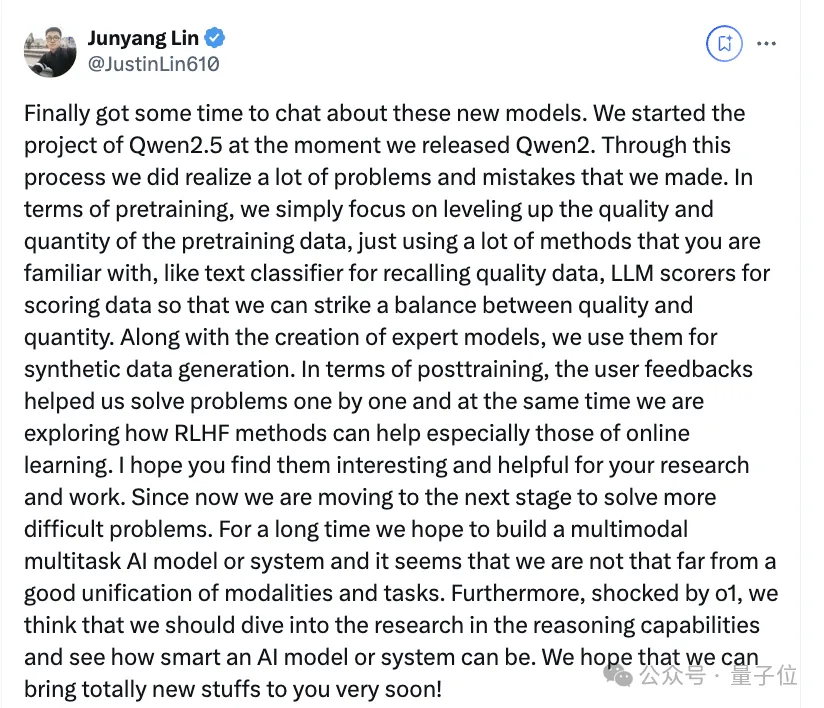

阿里通義開(kāi)源負(fù)責(zé)人林俊旸也分享了背后的一些細(xì)節(jié)。

他首先表示,在開(kāi)源Qwen2的那一刻就開(kāi)始了Qwen2.5項(xiàng)目。

在這過(guò)程中,他們認(rèn)識(shí)到了很多問(wèn)題和錯(cuò)誤。

比如在預(yù)訓(xùn)練方面,他們們只是專注于提高預(yù)訓(xùn)練數(shù)據(jù)的質(zhì)量和數(shù)量,使用了很多大家熟悉的方法。

比如文本分類器用于召回高質(zhì)量數(shù)據(jù),LLM 評(píng)分器用于對(duì)數(shù)據(jù)進(jìn)行評(píng)分,這樣就能在質(zhì)量和數(shù)量之間取得平衡。

還有在創(chuàng)建專家模型的同時(shí),團(tuán)隊(duì)還利用它們生成合成數(shù)據(jù)。

在后期訓(xùn)練時(shí)候,用戶的反饋來(lái)幫助他們逐一解決問(wèn)題,同時(shí)他們也在探索RLHF 方法,尤其是在線學(xué)習(xí)方法。

對(duì)于之后的升級(jí)和更新,他表示受o1啟發(fā),認(rèn)為應(yīng)該深入研究推理能力。

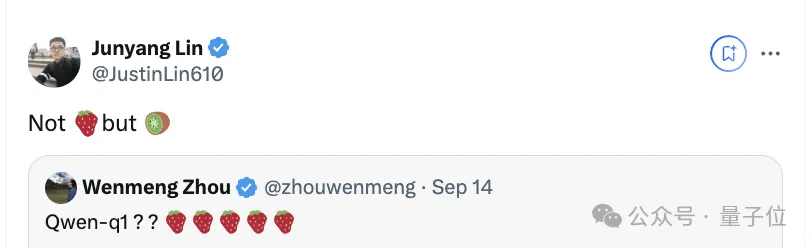

值得一提的是,在Qwen2.5預(yù)熱之時(shí),他們團(tuán)隊(duì)就透露不叫草莓,叫獼猴桃。

好了,現(xiàn)在獼猴桃可以快快用起來(lái)了。