長(zhǎng)短大小樣樣精通!原始分辨率、超長(zhǎng)視頻輸入:更靈活的全開(kāi)源多模態(tài)架構(gòu)Oryx

本文的主要作者來(lái)自清華大學(xué)智能視覺(jué)實(shí)驗(yàn)室(i-Vision Group)、騰訊公司和南洋理工大學(xué) S-Lab。本文的共同第一作者為清華大學(xué)自動(dòng)化系博士生劉祖炎和南洋理工大學(xué)博士生董宇昊,主要研究方向?yàn)槎嗄B(tài)模型。本文的通訊作者為騰訊高級(jí)研究員饒永銘和清華大學(xué)自動(dòng)化系魯繼文教授。

視覺(jué)數(shù)據(jù)的種類極其多樣,囊括像素級(jí)別的圖標(biāo)到數(shù)小時(shí)的視頻。現(xiàn)有的多模態(tài)大語(yǔ)言模型(MLLM)通常將視覺(jué)輸入進(jìn)行分辨率的標(biāo)準(zhǔn)化或進(jìn)行動(dòng)態(tài)切分等操作,以便視覺(jué)編碼器處理。然而,這些方法對(duì)多模態(tài)理解并不理想,在處理不同長(zhǎng)度的視覺(jué)輸入時(shí)效率較低。

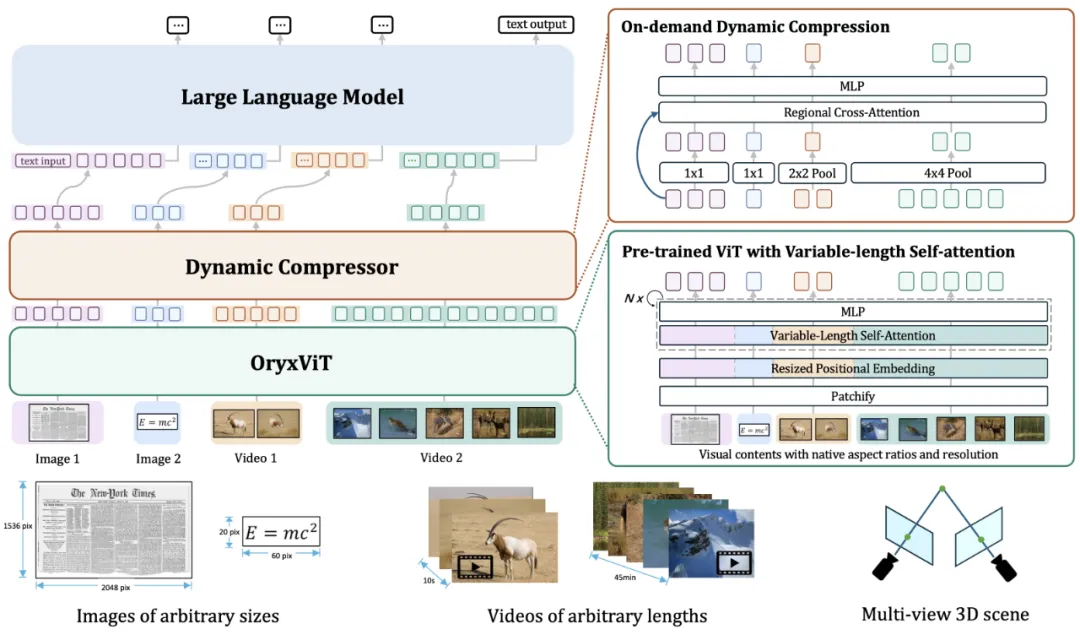

為了解決上述問(wèn)題,來(lái)自清華大學(xué)、騰訊、南洋理工大學(xué)的研究者們提出一種更靈活的多模態(tài)模型 Oryx。Oryx 是一種統(tǒng)一的多模態(tài)架構(gòu),能夠處理圖像、視頻和多視角 3D 場(chǎng)景,提供了一種能夠按照需求處理任意空間大小和時(shí)間長(zhǎng)度視覺(jué)輸入的解決方案。

Oryx 的核心創(chuàng)新點(diǎn)包括:一個(gè)預(yù)訓(xùn)練的 OryxViT 模型,能夠?qū)?strong>任意原始分辨率的圖像編碼為視覺(jué) token;一個(gè)動(dòng)態(tài)壓縮模塊,支持按需對(duì)視覺(jué) token 進(jìn)行 1 倍到 16 倍的壓縮。上述設(shè)計(jì)使 Oryx 能夠在處理不同需求下的任務(wù)時(shí)保持更高的效率和精度。此外,Oryx 通過(guò)增強(qiáng)的混合數(shù)據(jù)和針對(duì)上下文檢索、空間感知數(shù)據(jù)的訓(xùn)練,在多模態(tài)融合上取得了更強(qiáng)的能力。

- 項(xiàng)目地址:https://oryx-mllm.github.io/

- 論文:https://arxiv.org/abs/2409.12961

- 代碼:https://github.com/Oryx-mllm/Oryx

- Demo:https://huggingface.co/spaces/THUdyh/Oryx

1. 介紹

現(xiàn)有方法簡(jiǎn)單地將各種視覺(jué)輸入統(tǒng)一處理,忽略了視覺(jué)內(nèi)容的差異和不同應(yīng)用的具體需求。例如,早期的 MLLM 將視覺(jué)輸入轉(zhuǎn)化為固定分辨率;近期的 MLLM 通過(guò)動(dòng)態(tài)切分方式生成高分辨率的視覺(jué)表示。然而,由于缺乏支持原始分辨率輸入的高質(zhì)量視覺(jué)編碼器,這些解決方案仍然是一種妥協(xié)。我們認(rèn)為,提供原始分辨率的視覺(jué)輸入具有以下優(yōu)勢(shì):利用整個(gè)圖像輸入以防止信息丟失;解決邊緣情況;提高效率和自然性;具有更高的性能等。

圖 1:按需求理解的概念。

如圖 1 所示,在分辨率和壓縮比上的優(yōu)化可以提高效率,滿足實(shí)際需求。例如,高分辨率對(duì)于與文本相關(guān)的任務(wù)更重要,而對(duì)象層次的任務(wù)只需要簡(jiǎn)單的圖像,部分應(yīng)用場(chǎng)景需要總結(jié)極長(zhǎng)的視頻,其他應(yīng)用場(chǎng)景需要對(duì)每一幀保持高精度。因此,支持時(shí)空上的任意分辨率是一種更通用和高效的方案。

為了解決以上挑戰(zhàn),本文提出了一個(gè)統(tǒng)一的時(shí)空理解 MLLM 框架 Oryx,能夠在按需方式下處理任意視覺(jué)分辨率、不同時(shí)間長(zhǎng)度和多樣化的任務(wù)。Oryx 的主要貢獻(xiàn)包括:

- 預(yù)訓(xùn)練視覺(jué)編碼器 OryxViT。通過(guò)自適應(yīng)位置嵌入層和變長(zhǎng)自注意力機(jī)制,能夠并行處理原始分辨率的視覺(jué)表示,更加適合語(yǔ)言模型。

- 動(dòng)態(tài)壓縮模塊。能夠任意調(diào)整下采樣比例,支持 1 倍到 16 倍壓縮的無(wú)縫切換,保持精度和長(zhǎng)度上的取舍。

- 更好的數(shù)據(jù)和訓(xùn)練策略,能夠在圖像、視頻和 3D 數(shù)據(jù)理解上取得優(yōu)異的性能。

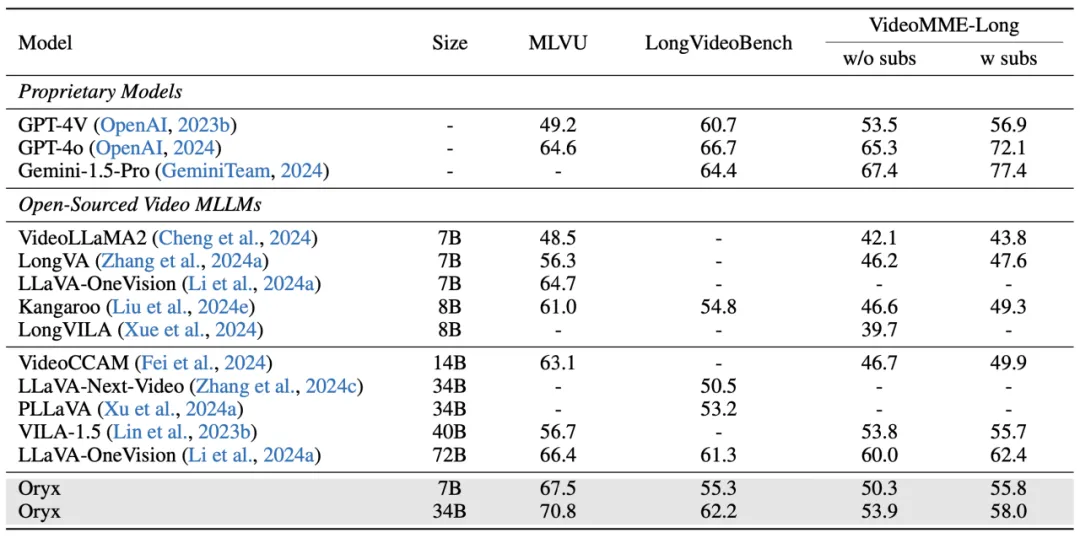

我們提供了 7B/34B 兩種尺度的 Oryx 模型,在視頻、圖像和 3D 理解任務(wù)上表現(xiàn)出色,在 7B 規(guī)模下取得了綜合最好的結(jié)果,34B 模型超越了部分 72B 模型的性能,在部分?jǐn)?shù)據(jù)集超過(guò) GPT-4o、GPT-4V 等模型,成為開(kāi)源模型的新標(biāo)桿。

2. 方法概覽

圖 2:Oryx 方法總覽圖。

原始分辨率表示

此前在圖像理解上的工作證明,保持視覺(jué)內(nèi)容的原始形式具有更高的有效性。然而,原始分辨率在 MLLM 上的應(yīng)用還未得到探索。我們認(rèn)為,MLLM 實(shí)際上是一個(gè)應(yīng)用原始分辨率的最好環(huán)境:視覺(jué)輸入的來(lái)源更加多樣,具有不同的需求和格式;語(yǔ)言 token 長(zhǎng)度本質(zhì)是動(dòng)態(tài)的,因此視覺(jué)的動(dòng)態(tài)表示可以無(wú)縫與后續(xù)階段對(duì)接。

現(xiàn)有的解決方案證明,傳統(tǒng)的視覺(jué)編碼器無(wú)法處理原始分辨率輸入。因此,我們基于 SigLIP 模型提出 OryxViT 視覺(jué)編碼器。OryxViT 通過(guò)將位置嵌入矩陣進(jìn)行縮放插值適應(yīng)輸入內(nèi)容。我們通過(guò)輕量級(jí)的語(yǔ)言模型作為接口,訓(xùn)練視覺(jué)編碼器的參數(shù),從多個(gè)多模態(tài)任務(wù)下獲取數(shù)據(jù)進(jìn)行訓(xùn)練,得到 OryxViT 模型。

為了解決批處理過(guò)程中動(dòng)態(tài)的序列長(zhǎng)度問(wèn)題,我們?cè)谕ǖ谰S度上對(duì)不同長(zhǎng)度的序列進(jìn)行拼接,通過(guò)可變長(zhǎng)自注意力操作,獨(dú)立計(jì)算每個(gè)視覺(jué)輸入的注意力矩陣,因此 OryxViT 可以高效處理不同縱橫比的視覺(jué)信號(hào),并保持與固定分辨率編碼器相同的推理速度。

動(dòng)態(tài)壓縮模塊

在處理不同長(zhǎng)度的視覺(jué)輸入時(shí),對(duì)所有輸入一視同仁會(huì)降低總體計(jì)算效率。我們通過(guò)動(dòng)態(tài)壓縮模塊實(shí)現(xiàn)更高比例的壓縮,并將不同壓縮比的視覺(jué)內(nèi)容統(tǒng)一成一致的模式,從而能夠按需控制視覺(jué)序列的長(zhǎng)度。我們對(duì)圖像、視頻和長(zhǎng)視頻應(yīng)用不同壓縮比的下采樣層,并設(shè)置下采樣倍率為 1 倍、4 倍、16 倍,從而實(shí)現(xiàn)可變和極高的壓縮比。

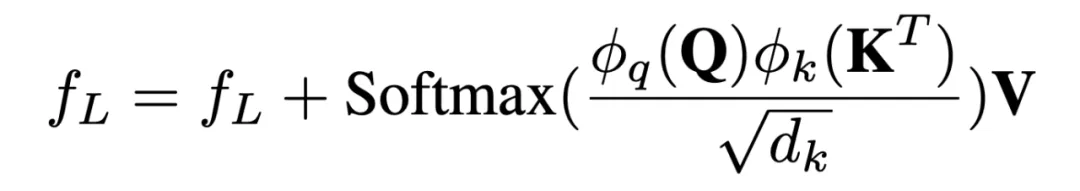

為了減輕下采樣的影響,我們采用區(qū)域注意力操作對(duì)高分辨率、低分辨率特征圖進(jìn)行交互。低分辨率的圖像塊作為查詢向量,通過(guò)交叉注意力操作與高分辨率鄰近小塊進(jìn)行交互

其中,我們通過(guò)投影層將 Q、K 向量投影到更低的維度,并省略了 V 向量和輸出層的投影以保持原始視覺(jué)特征。我們通過(guò)共享的 MLP 處理不同壓縮比的視覺(jué)輸入,以保持不同視覺(jué)輸入的一致性。最終的視覺(jué)表示被展平后輸入到語(yǔ)言模型進(jìn)行上下文預(yù)測(cè)。

全能模型:圖像、視頻、三維理解

我們進(jìn)一步擴(kuò)展了此前多任務(wù) MLLM 的能力,處理更多樣化的情境、不同長(zhǎng)度的內(nèi)容和更廣泛的任務(wù)。

視頻大海撈針訓(xùn)練。我們認(rèn)為,處理長(zhǎng)視頻的關(guān)鍵在于從廣泛的上下文中找到特定信息。因此,我們從 MovieNet 數(shù)據(jù)集中獲取視頻樣本,并通過(guò)單幀標(biāo)題生成和兩幀差異識(shí)別兩個(gè)任務(wù)對(duì)模型進(jìn)行強(qiáng)化訓(xùn)練。

通過(guò)粗略空間關(guān)系學(xué)習(xí) 3D 知識(shí)。3D 環(huán)境相關(guān)的多視圖圖像缺乏時(shí)間或軌跡線索,因此以往的方法在 3D 任務(wù)中難以實(shí)現(xiàn)正確的空間理解。我們通過(guò)粗略空間關(guān)系對(duì)應(yīng)的方法,使得模型在多視角中能夠跟隨和捕捉空間關(guān)聯(lián)。

訓(xùn)練策略、數(shù)據(jù)組成

Oryx 的訓(xùn)練策略輕量且直接。模型初始化包括視覺(jué)編碼器 OryxViT 和大語(yǔ)言模型。第一階段訓(xùn)練僅涉及圖像數(shù)據(jù),首先在 LLaVA-1.5-558k 圖文對(duì)中進(jìn)行簡(jiǎn)單的對(duì)齊預(yù)訓(xùn)練,訓(xùn)練動(dòng)態(tài)壓縮模塊。此后在 4M 高質(zhì)量圖文對(duì)中進(jìn)行有監(jiān)督微調(diào),這些數(shù)據(jù)從各種開(kāi)源學(xué)術(shù)數(shù)據(jù)集中獲取。需要注意的是,我們沒(méi)有進(jìn)行大規(guī)模的預(yù)訓(xùn)練,也沒(méi)有使用私有的有監(jiān)督微調(diào)數(shù)據(jù)以獲取更好的性能,我們的主要目標(biāo)是驗(yàn)證架構(gòu)的有效性。

在第二階段,我們通過(guò)圖像、視頻和 3D 理解的多種視覺(jué)輸入聯(lián)合訓(xùn)練 Oryx 模型,微調(diào)策略與第一階段類似。我們從第一階段中抽樣 600k 圖像數(shù)據(jù),并從開(kāi)源視頻數(shù)據(jù)集中選取多個(gè)視頻數(shù)據(jù)集進(jìn)行混合。此外,我們包含了所提出的視頻大海撈針樣本、具有粗略空間關(guān)系的 3D 樣本。這部分引入的視頻和多視角數(shù)據(jù)共 650k。

我們的訓(xùn)練數(shù)據(jù)均來(lái)源于開(kāi)源數(shù)據(jù)集,因此確保了 Oryx 的可復(fù)現(xiàn)性,并提供了較大的進(jìn)一步改進(jìn)空間。

3. 實(shí)驗(yàn)結(jié)果

通用視頻理解

我們選取 4 個(gè)選擇題評(píng)測(cè)標(biāo)準(zhǔn)和 3 個(gè)回答生成評(píng)測(cè)標(biāo)準(zhǔn)進(jìn)行通用視頻理解能力的測(cè)試。Oryx 在不同尺度的模型下均取得了有競(jìng)爭(zhēng)力的表現(xiàn)。在帶字幕的 VideoMME 數(shù)據(jù)集中,Oryx 取得 62.6% 和 67.4% 的平均準(zhǔn)確率。在 NextQA 和 Perception Test 數(shù)據(jù)集分別超越此前的 SOTA 結(jié)果 3.3% 和 5.4%。在 GPT 評(píng)測(cè)的標(biāo)準(zhǔn)下,Oryx 表現(xiàn)出色,取得了 1.49、3.53 和 3.76 的平均得分。

長(zhǎng)視頻理解

為了專門測(cè)試在長(zhǎng)視頻輸入下的能力,我們選取了 3 個(gè)主流且具代表性的長(zhǎng)視頻理解基準(zhǔn),包括 MLVU、LongVideoBench 和 VideoMME 長(zhǎng)視頻子集。Oryx 在理解長(zhǎng)視頻內(nèi)容表現(xiàn)出顯著的能力,超越了所有現(xiàn)有的 7B 模型系列,34B 模型在 MLVU 和 LongVideoBench 上相比之前最先進(jìn)的 72B 模型提升了 4.4% 和 0.9% 平均準(zhǔn)確率。在 MLVU 測(cè)試集下,Oryx-34B 相比 GPT-4o 高出 6.2%。

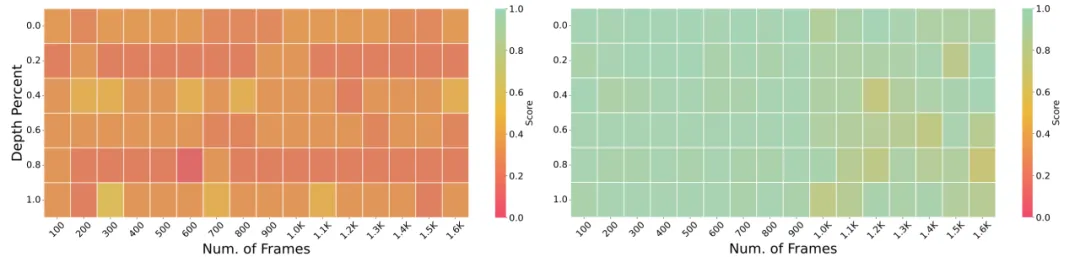

視頻大海撈針

為了測(cè)試模型的長(zhǎng)視頻檢索能力,我們進(jìn)行了視頻大海撈針實(shí)驗(yàn)。基線模型顯示出嚴(yán)重的信息丟失,相比之下,我們的方法在 1.6k 幀輸入的情況下仍然能夠準(zhǔn)確回答問(wèn)題。

圖像理解

Oryx 模型在多種有代表性的圖像評(píng)測(cè)基準(zhǔn)下保持了開(kāi)源模型中第一梯隊(duì)的水平。

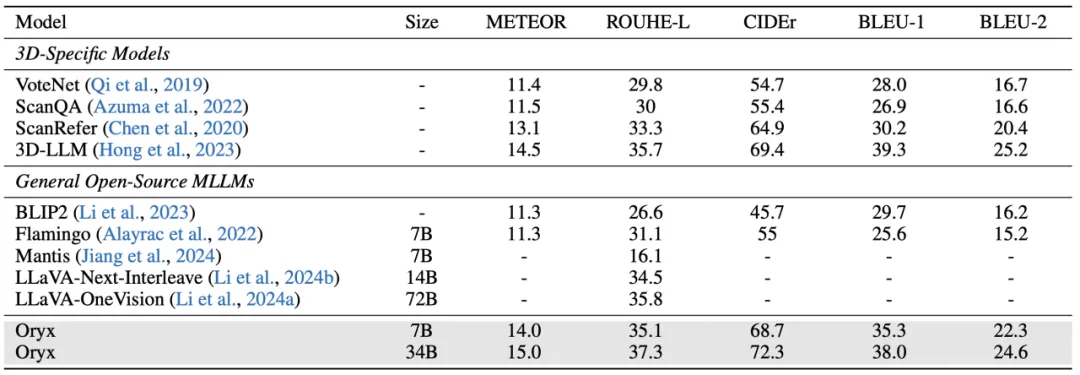

三維空間理解

Oryx 在性能上超越此前為 3D 理解設(shè)計(jì)的專有模型,也超過(guò)最近更新的基于大語(yǔ)言模型的 3D 模型。

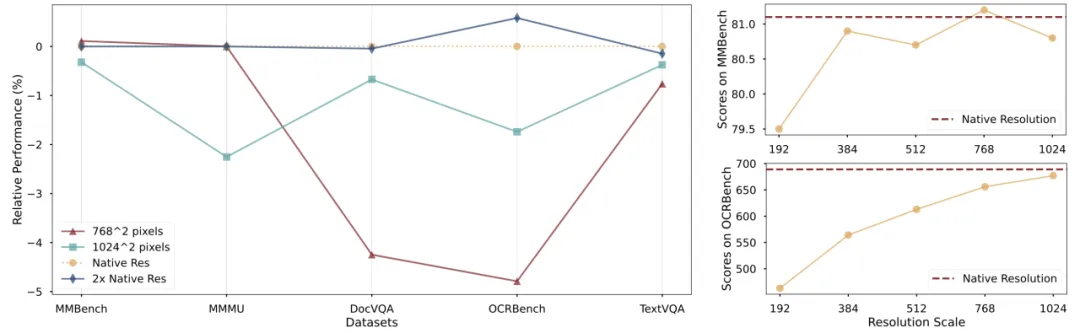

分析實(shí)驗(yàn)

分辨率和縮放策略的影響。原始分辨率輸入明顯好于固定尺寸(保持長(zhǎng)寬比不變)圖像輸入,尤其在特定任務(wù)下的數(shù)據(jù)集。在不同視覺(jué)輸入分辨率下,MMBench 和 OCRBench 性能均有提升,但原始分辨率是相較而言更簡(jiǎn)單且有效的策略。

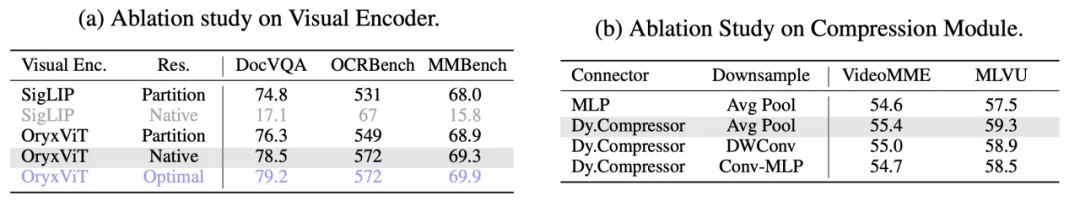

Oryx 結(jié)構(gòu)的消融實(shí)驗(yàn)。在視覺(jué)編碼器維度,OryxViT 相比 SigLIP 具有更優(yōu)異的圖像 - 語(yǔ)言對(duì)齊性能。通過(guò)對(duì)原始分辨率和動(dòng)態(tài)切分方法的公平比較,此前的視覺(jué)編碼器無(wú)法處理原始分辨率輸入,而基于 OryxViT,原始分辨率方法明顯優(yōu)于動(dòng)態(tài)切分方法。在我們的訓(xùn)練和測(cè)試過(guò)程中,我們始終保持原始分辨率輸入。

對(duì)于連接模塊,動(dòng)態(tài)壓縮模塊在視頻測(cè)試集中表現(xiàn)出更優(yōu)越的性能,且平均池化具有更好的結(jié)果,這可能是由于無(wú)參數(shù)降采樣能夠更好地保留視覺(jué)特征分布,并減輕訓(xùn)練的優(yōu)化壓力。

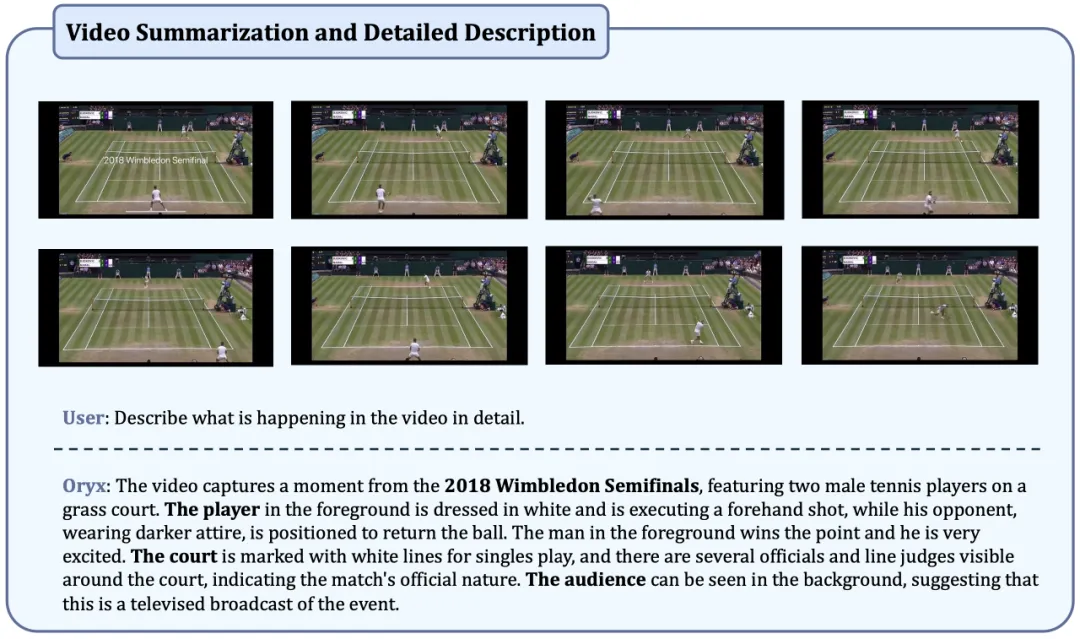

4. 案例分析

視頻描述和總結(jié)任務(wù)

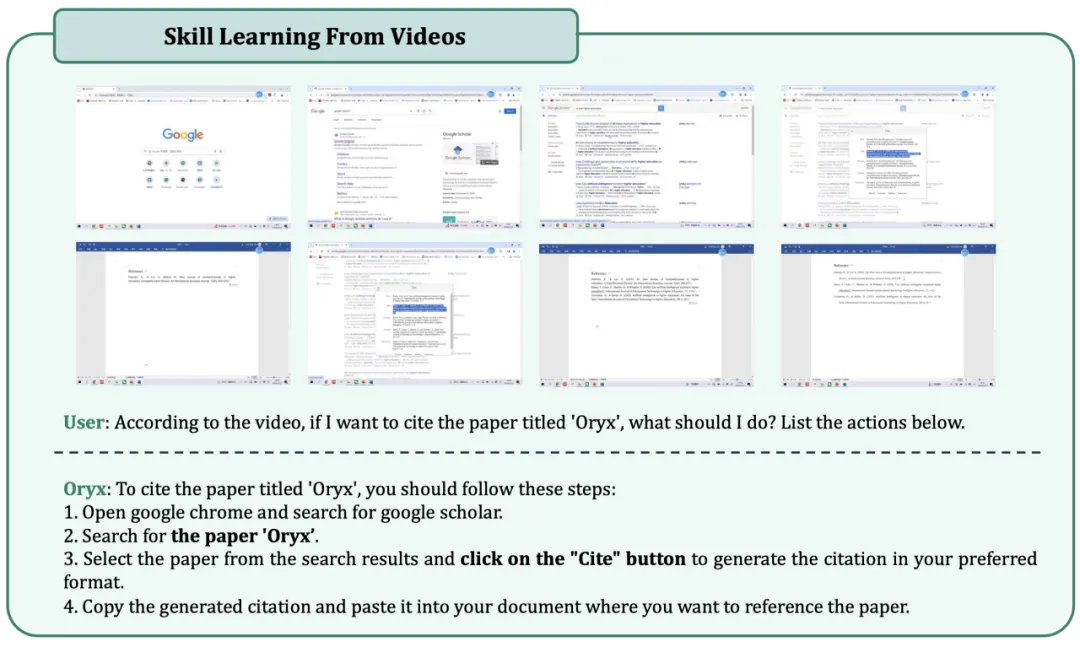

基于視頻內(nèi)容的推理和學(xué)習(xí)

5. 總結(jié)

我們提出了 Oryx 系列,一種能夠按需處理不同任務(wù)、時(shí)間長(zhǎng)度、視覺(jué)分辨率輸入的新架構(gòu)。Oryx 在時(shí)空理解上有突出表現(xiàn),利用 OryxViT 創(chuàng)新地處理原始分辨率,采用動(dòng)態(tài)壓縮模塊進(jìn)行高效的數(shù)據(jù)壓縮,并應(yīng)用了更好的訓(xùn)練策略。Oryx 在各種主流圖像、視頻和 3D 測(cè)試基準(zhǔn)中均表現(xiàn)出色。我們希望本工作能夠?yàn)槎嗄B(tài)學(xué)習(xí)提供一個(gè)新視角。