AIGC大模型應用的推理場景優化

在大模型和AIGC的新紀元,我們正見證一個前所未有的技術革命。從更自然的人機對話,到圖片、視頻生成,AIGC技術正在徹底改變我們創造、學習和交流的方式。

然而,這一切進步的背后,是對存儲技術的極端要求。舉個例子,一家致力于開發AIGC應用的公司,如何高效地處理和存儲大量的數據,以不斷訓練和優化其AI大模型。這不僅要求存儲系統能夠處理PB級的數據量,還要求在數據采集、清洗、訓練及推理的每一個環節,都能提供高速、可靠的數據訪問。

隨著大模型參數規模的持續擴大,對計算基礎設施三大件——算力、網絡、存儲,都提出了新的要求。目前,支撐大模型的算力、網絡在快速迭代。算力方面,英偉達用了兩年的時間從H100升級到了H200,讓模型訓練性能提升了5倍;在網絡方面,已經從以前的25G、50G、100G,逐步發展到200G的網絡,帶寬提升了超過6倍。

那么,對于存儲而言,包含了數據采集與清洗、模型訓練、以及推理三大關鍵環節,每一個環節都對存儲系統提出了新的要求和挑戰。

數據采集與清洗的挑戰:數據量和多樣性、多協議支持的需求、高性能和大帶寬的要求。

在AIGC技術的實施過程中,數據采集與清洗階段是基礎。這一階段的核心任務是收集來自不同源的數據,進行預處理和清洗,以確保數據的質量和可用性。這一任務面臨著幾個主要問題:數據量巨大、類型多樣化、需要多協議支持,以及對高性能和大帶寬的需求。不同類型的數據往往需要通過不同的協議進行收集和訪問,高效的數據處理不僅需要大容量存儲,還需要高性能和大帶寬以支持快速的數據讀寫和傳輸。

模型訓練的挑戰:頻繁的checkpoint保存、高并發讀寫的需求。

大模型訓練過程中,為了防止數據丟失并能夠從最近的進度恢復,需要定期保存模型的狀態,即checkpoint。這些checkpoint包含了模型的參數、超參數以及優化器的狀態等信息,對于維持訓練的連續性至關重要。然而,隨著模型規模的不斷增大,這些checkpoint的體積也隨之增加,導致保存操作消耗大量時間和存儲資源,特別是在使用分布式訓練時,多個節點同時對存儲系統進行訪問,對存儲系統的并發處理能力和響應時間提出了極高的要求。

推理與數據治理的挑戰:數據安全與可追溯性、內容審核與合規性。

在AIGC應用的推理階段,企業面臨著數據安全、可追溯性、內容審核和合規性等一系列挑戰。這些挑戰不僅關乎技術的有效實施,還直接影響到企業的信譽和合法運營。隨著數據泄露事件的頻繁發生,確保敏感信息的安全變得尤為重要。同時,數據的可追溯性也至關重要,這不僅有助于追蹤數據流向和處理過程,以評估數據安全性,還能在發生安全事件時迅速定位問題。

以一個基于AIGC技術的新聞自動生成平臺為例,該平臺能夠自動采集網絡上的新聞資訊,結合用戶的閱讀偏好生成個性化新聞內容。存儲系統不僅需要對存儲的數據進行加密,還要記錄詳細的數據處理日志,以實現數據的可追溯性。在新聞內容生成后,平臺還需要對內容進行審核,確保不含有誤導性信息、侵權內容或違反法律法規的信息。這就要求存儲系統能夠支持與內容審核工具的高效集成,快速篩查和過濾內容,同時還要有能力處理大量的內容審核請求,保證審核的實時性和準確性。

正如上面所分析的那樣,在大模型、AIGC技術快速發展的背景下,數據存儲面臨著前所未有的挑戰。巨大的數據量、多樣化的數據類型、以及對高速訪問的迫切需求,都在推動存儲技術的創新和進步。為了應對這些挑戰,業界從多個方面進行創新探索,主要集中在以下幾個方向:

高性能分布式存儲

為了應對PB級別數據量的處理需求,采用可擴展的分布式存儲系統成為了行業的共識。這類系統通過分散數據到多個節點上,不僅能夠提高存儲容量,還能通過并行處理提升數據訪問速度。這種存儲方案的核心優勢在于其彈性擴展能力,可以根據需要動態調整資源,以應對數據量的不斷增長。

并行文件存儲

并行文件存儲系統通過允許多個進程同時對文件系統進行讀寫,大幅提高了數據處理的效率。這對于大模型訓練尤為關鍵,因為它能顯著縮短模型訓練的時間,加快迭代速度。

數據加速與緩存

數據加速器和緩存技術的應用,進一步提升了數據訪問速度,實現了快速數據加載和亞毫秒級的低延遲。通過將頻繁訪問的數據存放在更快的存儲介質上,如SSD或內存中,系統可以迅速響應數據請求,大幅提高AIGC應用的響應速度和用戶體驗。

多模態數據檢索分析

AIGC技術的一大特點是處理多模態數據,如文本、圖片、視頻等。為此,提供多模態數據檢索和分析工具變得尤為重要。這些工具能夠幫助用戶快速找到所需數據,優化數據管理,提高數據的可用性和價值。

數據安全與合規工具

在AIGC領域,數據安全和合規性是不容忽視的重要問題。集成的內容審核、數據加密和合規性工具能夠確保數據在整個生命周期中的安全性,同時滿足不同地區和行業的法律法規要求。這不僅保護了用戶隱私,也為企業的合法運營提供了保障。

這些方案的共同目標是構建一個既能夠處理海量數據,又能滿足高速訪問需求,同時確保數據安全和合規性的存儲基礎設施。

解除存儲瓶頸,AIGC應用才能騰飛

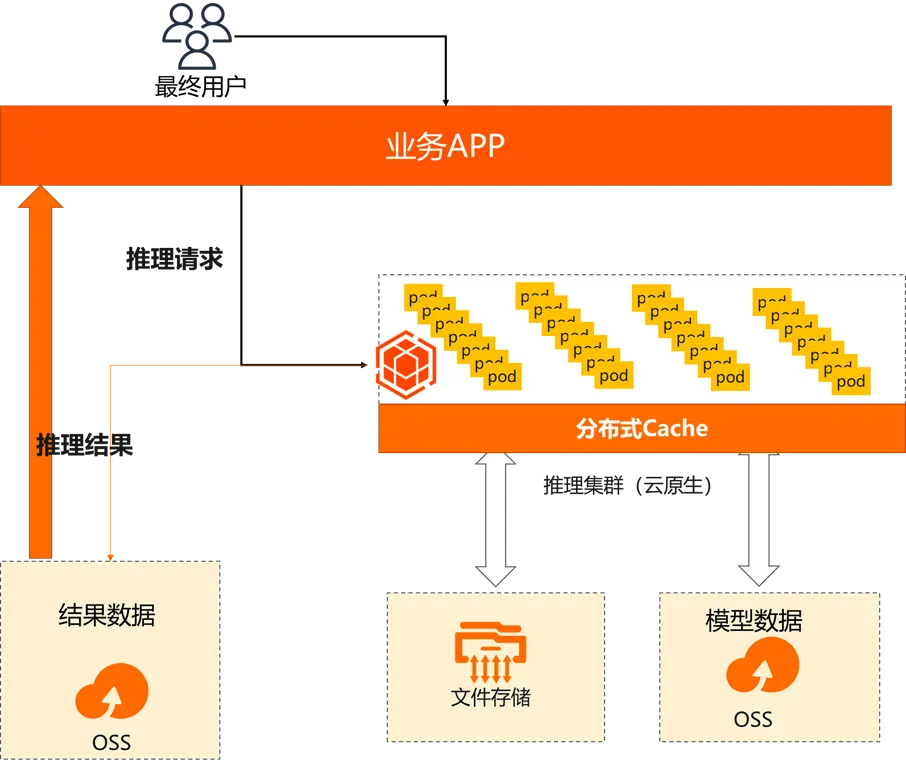

傳統推理

GPT-175B 模型約有 1750 億參數,以半精度(FP16)格式計算,總計至少占 320GB(計算 1024 的倍數)的存儲空間,所以需要至少 5 個 A100 GPU,且在推理時,每個 GPU 都起碼需要有 80GB 的內存。大多數的實際推理部署會進行相關的模型精簡,業界常見的優化方向包括量化、減枝、蒸餾等。

在經典的AIGC場景,推理業務對于基礎平臺的關鍵需求從讀取變成了啟動。

- 高吞吐:通過啟上千個POD,并行對不同需求進行計算,單個POD的模型在10~100GB,一般需要數秒鐘啟動。對源存儲下載帶寬需求在100Gbps左右,性能密度達2Gbps/TiB

- 高彈性:訪問請求是由用戶觸發,日常任務具有隨機性(峰值1~100K POD),對于killer app推理開銷遠大于訓練。

- Posix兼容性:大部分仿真軟件均采用posix協議并發訪問原始數據集

- 數據緩存:推理階段加載數據全部為模型數據,緩存價值大

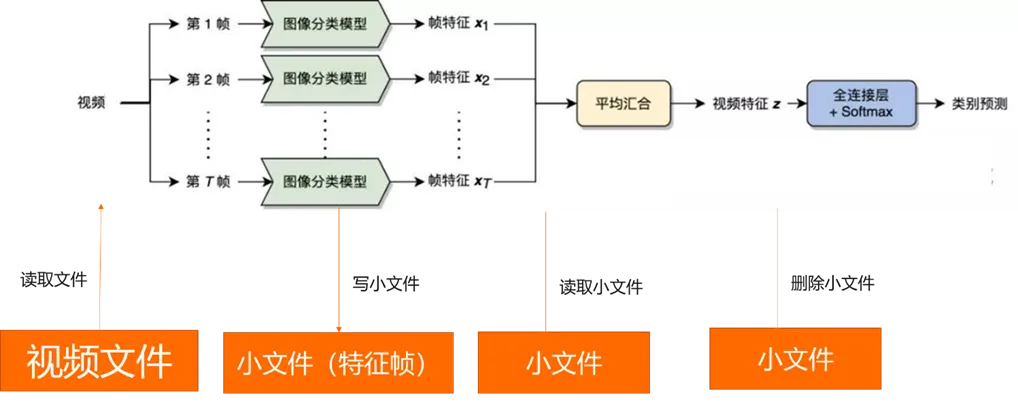

如果是多模態場景,可能會有一些存儲性能的需求。

在該場景,核心瓶頸是小文件大量寫入和刪除(mkdir、rmdir、create、remove):建議使用GPFS類文件存儲。

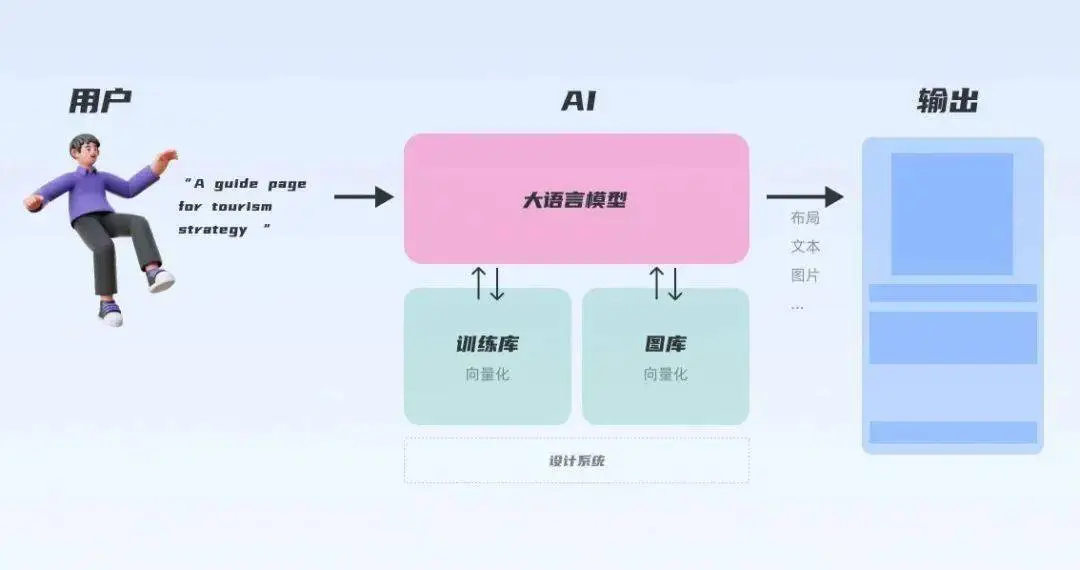

構建AI應用的變化

構建 AI 應用遠不只是調用模型 API,還有很多問題需要解決:

- 大模型只有“腦子”沒有“手臂”,無法在外部世界行動:搜索網頁、調用 API 還是查找數據庫,這些能力都無法被 大模型的 API 提供;

- 它的“腦子”也不完美,OpenAI 的訓練數據截止至 2021 年,并且沒有任何企業和個人的私有數據,這讓模型只能根據自己的“記憶”回答問題,并且經常給出與事實相悖的答案(幻覺)。一個解決方法是在 Prompt 中將知識告訴模型,但是這往往受限于 token 數量,在 GPT-4 之前一般是 4000 個字的限制。

- 私域的知識如何使用,意大利數據保護局Garante以涉嫌違反隱私規則為由,暫時禁止了ChatGPT。自三星電子允許部分半導體業務員工使用ChatGPT開始,短短20天有三起機密資料外泄事件。

- 黑盒大模型無法更新知識和修改,大模型本身對外是一個黑盒的模型,無法對部分數據進行修改或者刪除,如果需要更新知識和修改大模型的知識需要重新訓練,成本巨大。

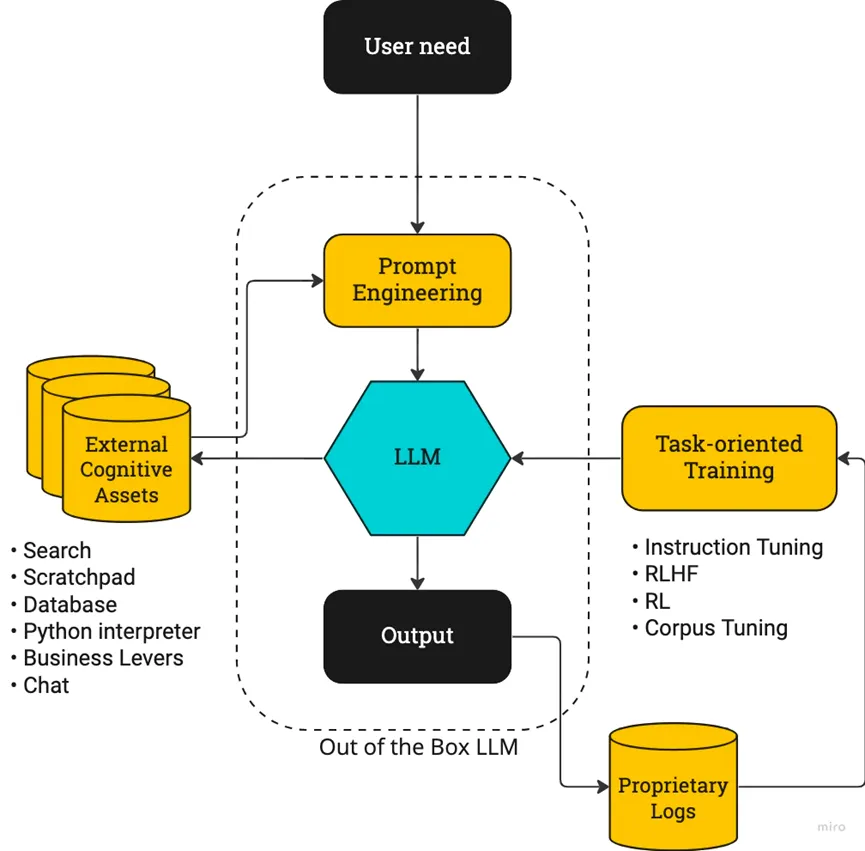

當前最需要解決的是如何將大模型應用到各行各業的私域知識,這個需求帶火了向量數據庫這個領域,一夜之間所有的數據庫都變成了向量數據庫(優勢熟悉的配方)。

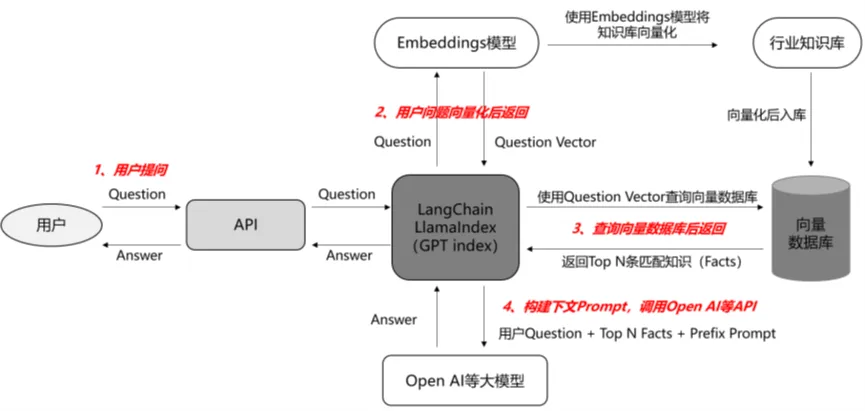

Step 1——語料庫準備:

將與行業相關的大量知識或語料上傳至向量數據庫,儲存為向量化文本;

Step 2 ——問題輸入:

輸入的問題被Embedding引擎變成帶有向量的提問;

Step 3 ——向量搜索:

向量化問題進入提前準備好的向量數據庫中,通過向量搜索引擎計算向量相似度,匹配出Top N條語義最相關的Facts(向量數據庫是模糊匹配,輸出的是概率上最近似的答案)

Step 4 ——Prompt優化:

輸出的Top N條Facts,和用戶的問題一起作為prompt輸入給模型。

Step 5、結果返回:

有記憶交互下得到的生成內容更精準且緩解了幻覺問題。有記憶交互:當模型需要記憶大量的聊天記錄或行業知識庫時,可將其儲存在向量數據庫中,后續在提問時將問題向量化,送入向量數據庫中匹配相似的語料作為prompt,向量數據庫通過提供記憶能力使prompt更精簡和精準,從而使返回結果更精準。

大模型的向量數據庫市場

時間回轉到今年的Q1季度,2023.3.21,NVIDIA創始人兼CEO黃仁勛在2023 GPU技術大會(2023 GTC)上發表演講。并表示今年將推出新的向量數據庫RAFT。RAFT在此基礎上,還具有加速索引、數據加載和近鄰檢索等功能。黃仁勛認為:“對于自研大型語言模型的組織而言,向量數據庫至關重要。”他總結:“初創公司競相構建具有顛覆性的產品和商業模式,而老牌公司則在尋求應對之法——生成式AI引發了全球企業制定AI戰略的緊迫感。”

在OpenAI ChatGPT plugins 發布的官方文章中,Milvus 和 Zilliz Cloud 同時作為首批插件合作伙伴被提及成為唯一一家開源項目與商業化云產品同時入選的向量數據庫公司。而在近一個月之內,向量數據庫迎來了融資潮。Qdrant 、Chroma 和 Weaviate 紛紛獲得融資;而 Pinecone 也正式官宣了新的 1 億美金 B 輪融資,估值達到了 7.5 億美元。

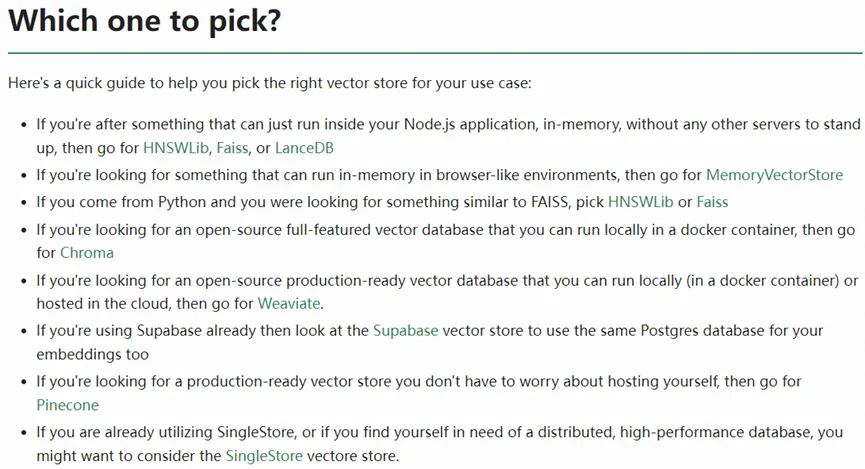

從langchain的推薦可以看出,現在這個市場還是一個諸侯混戰,百花齊放的市場,到底該把賭注押寶到哪個生態才是重中之重。

再回頭看中國區這個大市場,基礎模型一定是以云廠商提供,或者少量大模型云下私有化部署,如何適配其實顯而易見:配套自己的云上大模型,其次,適配一些國家科研機構的大模型線下輸出。