CoAT:基于蒙特卡洛樹搜索和關聯記憶的大模型推理能力優化框架

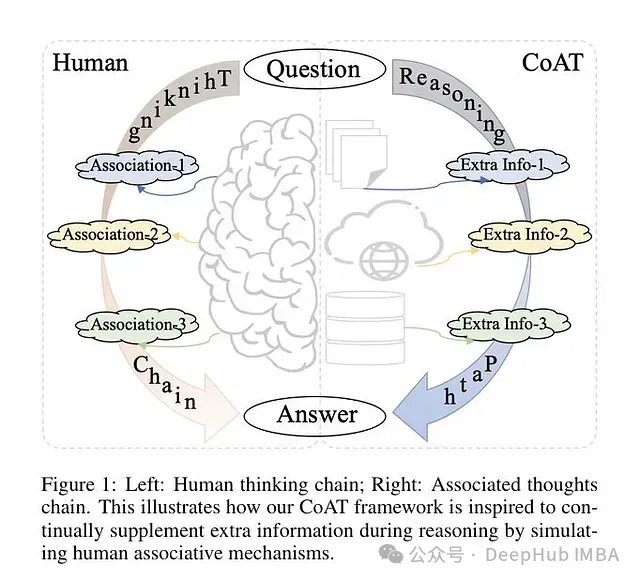

研究者提出了一種新的關聯思維鏈(Chain-of-Associated-Thoughts, CoAT)方法,該方法通過整合蒙特卡洛樹搜索(Monte Carlo Tree Search, MCTS)和關聯記憶機制來提升大語言模型(LLMs)的推理能力。區別于傳統的單步推理方法,CoAT致力于增強LLM的結構化推理能力和自適應優化能力,實現動態知識整合。

主要技術創新

CoAT框架的技術特點

- 基于優化的MCTS算法擴展LLM推理空間,實現推理路徑的結構化探索

- 引入關聯記憶機制,使模型具備類人認知的動態知識補充能力

關聯記憶機制的實現

- 采用動態知識整合策略,在推理過程中實時補充關鍵信息

- 通過上下文相關性控制和冗余度最小化來降低幻覺產生的風險

MCTS優化策略

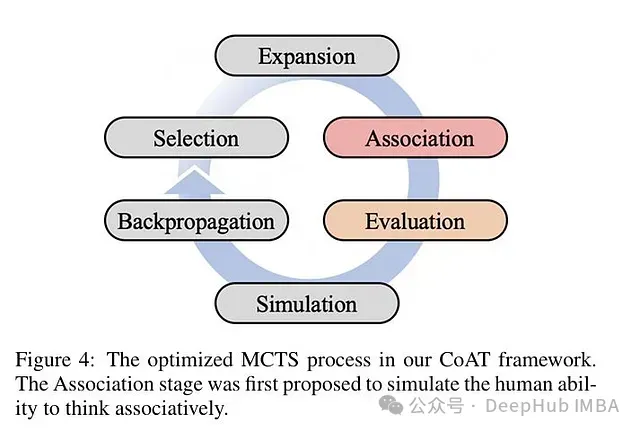

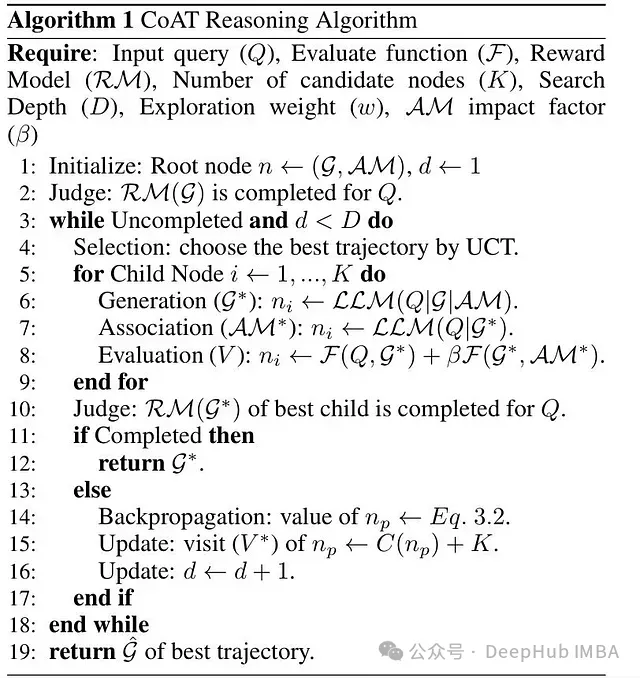

- 對傳統MCTS的選擇、擴展、模擬和反向傳播四個階段進行優化

- 設計關聯階段以實現節點級別的關聯信息注入

- 引入評估函數對生成內容和關聯內容進行質量評估

搜索算法改進

- 集成獎勵模型(RM)以實現最優終止判斷

- 引入深度約束參數(D)以避免過度搜索帶來的計算效率損失

實驗驗證

- 在復雜推理和檢索增強生成(RAG)任務中進行系統評估

- 在多跳問答和代碼生成等任務上與現有方法(如CoT、ToT、IRCoT、LATS和KAG)進行對比測試

技術方法與實現細節

關聯記憶機制的技術實現

- 構建實時信息檢索與整合系統

- 實現內容相關性、冗余性和簡潔性的多目標優化

- 支持多源知識檢索,包括知識圖譜、向量數據庫、LLM代理和搜索引擎等外部知識源

MCTS算法優化設計

- 在擴展和評估環節間增設關聯階段以強化推理能力

- 關鍵組件包括:

評估函數設計

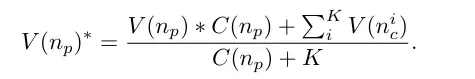

反向傳播策略優化

終止條件設計

- 基于獎勵模型(RM)的最優狀態判斷

- 引入最大深度參數(D)控制搜索深度

實驗結果分析

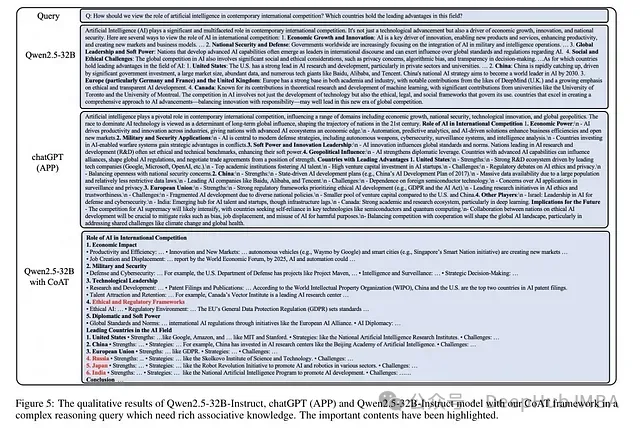

定性評估結果

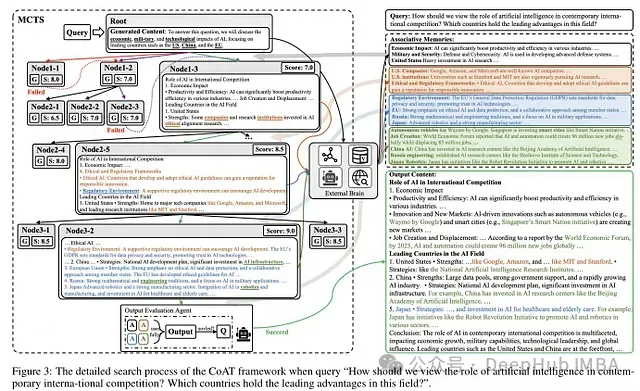

- 針對需要廣泛知識支持的復雜查詢場景進行測試

- 在內容完整性和知識覆蓋度方面超越GPT-4、ChatGPT和Qwen2.5-32B等基線模型

- 在全球AI競爭等復雜問題上,相比基準模型能提供更全面的倫理和監管維度分析

RAG問答任務性能

- 在HotpotQA和2WikiMultiHopQA數據集上與NativeRAG、IRCoT、HippoRAG等方法進行對比

- 在精確匹配(EM)和F1分數上取得較好表現,展現出優秀的多跳推理能力

代碼生成任務評估

- 在HumanEval、MBPP和HumanEval-X等數據集上評估CoAT增強的Qwen2.5-7B/14B模型

- 性能達到或超過專門微調的編碼器模型(Qwen2.5-Coder-7B/14B),驗證了方法在結構化推理任務上的適用性

技術優勢分析

推理能力增強

- 突破傳統CoT或ToT方法的局限,實現知識的主動迭代優化

- 通過結構化搜索提供比自回歸方法更可靠的推理路徑

知識整合機制

- 關聯記憶實現動態知識補充,克服靜態RAG方法的限制

- 具備跨任務域的通用性,適用于問答、推理和代碼生成等多種場景

技術局限性

計算資源消耗

- MCTS搜索和關聯記憶檢索增加了額外的計算開銷

- 實時推理速度相比標準LLM有所降低

知識質量控制

- 需要平衡動態知識注入與事實準確性

- 外部知識源的質量對系統性能有顯著影響

參數敏感性

- 系統性能對關聯權重(β)、候選節點數(K)和搜索深度(D)等超參數敏感

- 不同應用場景需要專門的參數調優

應用范圍限制

- 當前框架主要針對文本推理任務

- 在多模態任務上的應用效果有待驗證

研究意義與發展方向

對LLM推理研究的影響

- 擴展了傳統CoT推理的邊界

- 為構建具備迭代思維能力的高級LLM架構提供了新思路

技術融合創新

- 將MCTS在AI規劃領域的成功經驗遷移至LLM領域

- 實現了語言生成與結構化搜索的有效結合

未來研究展望

- 探索與多模態AI系統的集成方案

- 研究高級知識檢索方法與CoAT的融合

- 優化MCTS算法以提升計算效率

總結

CoAT框架在LLM推理能力增強方面提供了一種新的技術范式,通過結合結構化搜索和自適應記憶機制,在復雜推理任務中展現出顯著優勢。盡管在計算效率和知識管理方面仍存在優化空間,但該方法為發展更智能的AI系統提供了重要的技術參考。